En matemáticas , el determinante es una función escalar de los elementos de una matriz cuadrada . El determinante de una matriz A se denota comúnmente como det( A ) , det A o | A | . Su valor caracteriza algunas propiedades de la matriz y la función lineal representada, sobre una base dada , por la matriz. En particular, el determinante es distinto de cero si y solo si la matriz es invertible y la función lineal correspondiente es un isomorfismo .

El determinante está completamente determinado por las dos propiedades siguientes: el determinante de un producto de matrices es el producto de sus determinantes, y el determinante de una matriz triangular es el producto de sus entradas diagonales.

El determinante de una matriz 2 × 2 es

y el determinante de una matriz de 3 × 3 es

El determinante de una matriz n × n se puede definir de varias formas equivalentes, siendo la más común la fórmula de Leibniz , que expresa el determinante como una suma de (el factorial de n ) productos con signo de las entradas de la matriz. Se puede calcular mediante la expansión de Laplace , que expresa el determinante como una combinación lineal de determinantes de submatrices, o con eliminación gaussiana , que permite calcular una forma escalonada por filas con el mismo determinante, igual al producto de las entradas diagonales de la forma escalonada por filas.

Los determinantes también se pueden definir por algunas de sus propiedades. Es decir, el determinante es la única función definida en las matrices n × n que tiene las cuatro propiedades siguientes:

Las propiedades anteriores relacionadas con las filas (propiedades 2 a 4) pueden reemplazarse por las declaraciones correspondientes con respecto a las columnas.

El determinante es invariante bajo semejanza matricial . Esto implica que, dado un endomorfismo lineal de un espacio vectorial de dimensión finita , el determinante de la matriz que lo representa sobre una base no depende de la base elegida. Esto permite definir el determinante de un endomorfismo lineal, que no depende de la elección de un sistema de coordenadas .

Los determinantes aparecen en todas las matemáticas. Por ejemplo, una matriz se utiliza a menudo para representar los coeficientes en un sistema de ecuaciones lineales , y los determinantes se pueden utilizar para resolver estas ecuaciones ( regla de Cramer ), aunque otros métodos de solución son computacionalmente mucho más eficientes. Los determinantes se utilizan para definir el polinomio característico de una matriz cuadrada, cuyas raíces son los valores propios . En geometría , el volumen n -dimensional con signo de un paralelepípedo n -dimensional se expresa mediante un determinante, y el determinante de un endomorfismo lineal determina cómo se transforman la orientación y el volumen n -dimensional bajo el endomorfismo. Esto se utiliza en cálculo con formas diferenciales externas y el determinante jacobiano , en particular para cambios de variables en integrales múltiples .

El determinante de una matriz 2 × 2 se denota mediante " det " o mediante barras verticales alrededor de la matriz y se define como

Por ejemplo,

El determinante tiene varias propiedades clave que pueden demostrarse mediante la evaluación directa de la definición de matrices y que siguen siendo válidas para determinantes de matrices mayores. Son las siguientes: [1] en primer lugar, el determinante de la matriz identidad es 1. En segundo lugar, el determinante es cero si dos filas son iguales:

Esto se aplica de manera similar si las dos columnas son iguales. Además,

Finalmente, si alguna columna se multiplica por algún número (es decir, todas las entradas en esa columna se multiplican por ese número), el determinante también se multiplica por ese número:

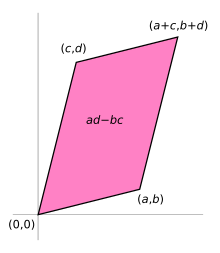

Si las entradas de la matriz son números reales, la matriz A puede utilizarse para representar dos aplicaciones lineales : una que asigna los vectores base estándar a las filas de A y otra que los asigna a las columnas de A. En cualquier caso, las imágenes de los vectores base forman un paralelogramo que representa la imagen del cuadrado unitario bajo la aplicación. El paralelogramo definido por las filas de la matriz anterior es el que tiene vértices en (0, 0) , ( a , b ) , ( a + c , b + d ) y ( c , d ) , como se muestra en el diagrama adjunto.

El valor absoluto de ad − bc es el área del paralelogramo y, por lo tanto, representa el factor de escala por el cual las áreas son transformadas por A . (El paralelogramo formado por las columnas de A es en general un paralelogramo diferente, pero como el determinante es simétrico con respecto a filas y columnas, el área será la misma).

El valor absoluto del determinante junto con el signo se convierte en el área con signo del paralelogramo. El área con signo es la misma que el área habitual , excepto que es negativa cuando el ángulo entre el primer y el segundo vector que define el paralelogramo gira en el sentido de las agujas del reloj (que es opuesto a la dirección que se obtendría para la matriz identidad ).

Para demostrar que ad − bc es el área con signo, se puede considerar una matriz que contiene dos vectores u ≡ ( a , b ) y v ≡ ( c , d ) que representan los lados del paralelogramo. El área con signo se puede expresar como | u | | v | sen θ para el ángulo θ entre los vectores, que es simplemente la base por la altura, la longitud de un vector por el componente perpendicular del otro. Debido al seno , esta ya es el área con signo, pero se puede expresar de manera más conveniente utilizando el coseno del ángulo complementario a un vector perpendicular, por ejemplo, u ⊥ = (− b , a ) , de modo que | u ⊥ | | v | cos θ′ se convierte en el área con signo en cuestión, que se puede determinar por el patrón del producto escalar como igual a ad − bc de acuerdo con las siguientes ecuaciones:

Por lo tanto, el determinante proporciona el factor de escala y la orientación inducida por la aplicación representada por A. Cuando el determinante es igual a uno, la aplicación lineal definida por la matriz es equiárea y preserva la orientación.

El objeto conocido como bivector está relacionado con estas ideas. En 2D, se puede interpretar como un segmento plano orientado formado al imaginar dos vectores, cada uno con origen (0, 0) y coordenadas ( a , b ) y ( c , d ) . La magnitud del bivector (denotada por ( a , b ) ∧ ( c , d ) ) es el área con signo , que también es el determinante ad − bc . [2]

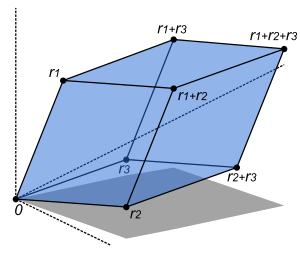

Si una matriz real A de n × n se escribe en términos de sus vectores columna , entonces

Esto significa que asigna el cubo unitario n al paralelotopo n -dimensional definido por los vectores de la región

El determinante da el volumen n -dimensional con signo de este paraleletopo, y por lo tanto describe de manera más general el factor de escala del volumen n -dimensional de la transformación lineal producida por A . [3] (El signo muestra si la transformación conserva o invierte la orientación .) En particular, si el determinante es cero, entonces este paraleletopo tiene volumen cero y no es completamente n -dimensional, lo que indica que la dimensión de la imagen de A es menor que n . Esto significa que A produce una transformación lineal que no es ni sobre ni biunívoca , y por lo tanto no es invertible.

Sea A una matriz cuadrada con n filas y n columnas, de modo que pueda escribirse como

Las entradas, etc., son, para muchos propósitos, números reales o complejos. Como se analiza a continuación, el determinante también se define para matrices cuyas entradas están en un anillo conmutativo .

El determinante de A se denota por det( A ), o puede denotarse directamente en términos de las entradas de la matriz escribiendo barras envolventes en lugar de corchetes:

Existen varias formas equivalentes de definir el determinante de una matriz cuadrada A , es decir, una con el mismo número de filas y columnas: el determinante se puede definir mediante la fórmula de Leibniz , una fórmula explícita que implica sumas de productos de ciertas entradas de la matriz. El determinante también se puede caracterizar como la función única que depende de las entradas de la matriz que satisfacen ciertas propiedades. Este enfoque también se puede utilizar para calcular determinantes simplificando las matrices en cuestión.

La fórmula de Leibniz para el determinante de una matriz de 3 × 3 es la siguiente:

En esta expresión, cada término tiene un factor de cada fila, todos en diferentes columnas, dispuestos en orden creciente de fila. Por ejemplo, bdi tiene b de la primera fila segunda columna, d de la segunda fila primera columna, e i de la tercera fila tercera columna. Los signos están determinados por cuántas transposiciones de factores son necesarias para organizar los factores en orden creciente de sus columnas (dado que los términos están ordenados de izquierda a derecha en orden creciente de fila): positivo para un número par de transposiciones y negativo para un número impar. Para el ejemplo de bdi , la transposición simple de bd a db da dbi, cuyos tres factores son de la primera, segunda y tercera columnas respectivamente; este es un número impar de transposiciones, por lo que el término aparece con signo negativo.

La regla de Sarrus es una regla mnemotécnica para la forma expandida de este determinante: la suma de los productos de tres líneas diagonales de elementos de la matriz en dirección noroeste a sureste, menos la suma de los productos de tres líneas diagonales de elementos en dirección suroeste a noreste, cuando las copias de las dos primeras columnas de la matriz se escriben al lado, como en la ilustración. Este esquema para calcular el determinante de una matriz de 3 × 3 no se traslada a dimensiones superiores.

Generalizando lo anterior a dimensiones superiores, el determinante de una matriz es una expresión que involucra permutaciones y sus signaturas . Una permutación del conjunto es una función biyectiva de este conjunto a sí mismo, con valores que agotan todo el conjunto. El conjunto de todas esas permutaciones, llamado grupo simétrico , se denota comúnmente como . La signatura de una permutación es si la permutación se puede obtener con un número par de transposiciones (intercambios de dos entradas); de lo contrario, es

Dada una matriz

La fórmula de Leibniz para su determinante es, utilizando la notación sigma para la suma,

Usando la notación pi para el producto, esto se puede abreviar en

El símbolo de Levi-Civita se define en las n - tuplas de números enteros como 0 si dos de los números enteros son iguales, y en caso contrario como la firma de la permutación definida por la n -tupla de números enteros. Con el símbolo de Levi-Civita, la fórmula de Leibniz se convierte en

donde la suma se toma sobre todas las n -tuplas de números enteros en [4] [5]

El determinante se puede caracterizar por las tres propiedades clave siguientes. Para expresarlas, es conveniente considerar que una matriz A está compuesta por sus columnas, denotadas así:

donde el vector columna (para cada i ) está compuesto por las entradas de la matriz en la i -ésima columna.

Si el determinante se define utilizando la fórmula de Leibniz como se ha indicado anteriormente, estas tres propiedades se pueden demostrar mediante la inspección directa de dicha fórmula. Algunos autores también abordan el determinante directamente utilizando estas tres propiedades: se puede demostrar que existe exactamente una función que asigna a cualquier matriz A un número que satisface estas tres propiedades. [6] Esto también demuestra que este enfoque más abstracto del determinante produce la misma definición que el que utiliza la fórmula de Leibniz.

Para comprobarlo basta con expandir el determinante por multilinealidad en las columnas hasta obtener una (enorme) combinación lineal de determinantes de matrices en la que cada columna es un vector base estándar . Estos determinantes son o bien 0 (por la propiedad 9) o bien ±1 (por las propiedades 1 y 12 que aparecen a continuación), de modo que la combinación lineal da la expresión anterior en términos del símbolo de Levi-Civita. Aunque tiene un aspecto menos técnico, esta caracterización no puede sustituir por completo a la fórmula de Leibniz para definir el determinante, ya que sin ella no está clara la existencia de una función apropiada. [ cita requerida ]

Estas reglas tienen varias consecuencias adicionales:

Estas propiedades características y sus consecuencias enumeradas anteriormente son teóricamente significativas, pero también se pueden utilizar para calcular determinantes de matrices concretas. De hecho, la eliminación gaussiana se puede aplicar para convertir cualquier matriz en forma triangular superior, y los pasos de este algoritmo afectan al determinante de una manera controlada. El siguiente ejemplo concreto ilustra el cálculo del determinante de la matriz utilizando ese método:

Combinando estas igualdades obtenemos

El determinante de la transpuesta de es igual al determinante de A :

Esto se puede demostrar examinando la fórmula de Leibniz. [7] Esto implica que en todas las propiedades mencionadas anteriormente, la palabra "columna" se puede reemplazar por "fila" en todas partes. Por ejemplo, si consideramos una matriz n × n como compuesta de n filas, el determinante es una función n -lineal.

El determinante es una función multiplicativa , es decir, para matrices cuadradas y de igual tamaño, el determinante de un producto matricial es igual al producto de sus determinantes:

Este hecho clave se puede demostrar observando que, para una matriz fija , ambos lados de la ecuación son alternados y multilineales en función de las columnas de . Además, ambos toman el valor cuando es la matriz identidad. La caracterización única mencionada anteriormente de los mapas multilineales alternados demuestra, por lo tanto, esta afirmación. [8]

Una matriz con entradas en un campo es invertible precisamente si su determinante es distinto de cero. Esto se deduce de la multiplicidad del determinante y de la fórmula para la inversa que involucra a la matriz adjunta mencionada a continuación. En este caso, el determinante de la matriz inversa está dado por

En particular, los productos e inversos de matrices con determinante distinto de cero (respectivamente, determinante uno) aún tienen esta propiedad. Por lo tanto, el conjunto de tales matrices (de tamaño fijo sobre un cuerpo ) forma un grupo conocido como el grupo lineal general (respectivamente, un subgrupo llamado el grupo lineal especial . De manera más general, la palabra "especial" indica el subgrupo de otro grupo matricial de matrices de determinante uno. Los ejemplos incluyen el grupo ortogonal especial (que si n es 2 o 3 consiste en todas las matrices de rotación ), y el grupo unitario especial .

Como el determinante respeta la multiplicación y las inversas, es de hecho un homomorfismo de grupo de en el grupo multiplicativo de elementos distintos de cero de . Este homomorfismo es sobreyectivo y su núcleo es (las matrices con determinante uno). Por lo tanto, por el primer teorema de isomorfismo , esto demuestra que es un subgrupo normal de , y que el grupo cociente es isomorfo a .

La fórmula de Cauchy-Binet es una generalización de esa fórmula del producto para matrices rectangulares . Esta fórmula también puede reformularse como una fórmula multiplicativa para matrices compuestas cuyos elementos son los determinantes de todas las submatrices cuadráticas de una matriz dada. [9] [10]

La expansión de Laplace expresa el determinante de una matriz recursivamente en términos de determinantes de matrices más pequeñas, conocidas como sus menores . El menor se define como el determinante de la matriz que resulta de eliminar la fila -ésima y la columna -ésima. La expresión se conoce como cofactor . Para cada , se tiene la igualdad

que se denomina expansión de Laplace a lo largo de la fila i . Por ejemplo, la expansión de Laplace a lo largo de la primera fila ( ) da la siguiente fórmula:

Al desenrollar los determinantes de estas matrices se obtiene la fórmula de Leibniz mencionada anteriormente. De manera similar, la expansión de Laplace a lo largo de la columna -ésima es la igualdad

La expansión de Laplace se puede utilizar iterativamente para calcular determinantes, pero este enfoque es ineficiente para matrices grandes. Sin embargo, es útil para calcular los determinantes de matrices altamente simétricas como la matriz de Vandermonde. La expansión de Laplace de n términos a lo largo de una fila o columna se puede generalizar para escribir un determinante n x n como una suma de términos , cada uno el producto del determinante de una submatriz k x k y el determinante de la submatriz complementaria ( n−k ) x ( n−k ).

La matriz adjunta es la transpuesta de la matriz de los cofactores, es decir,

Para cada matriz, se tiene [11]

Por tanto, la matriz adjunta se puede utilizar para expresar la inversa de una matriz no singular :

La fórmula para el determinante de una matriz -descrita anteriormente sigue siendo válida, bajo supuestos adicionales apropiados, para una matriz de bloques , es decir, una matriz compuesta por cuatro submatrices de dimensión , , y , respectivamente. La fórmula más sencilla de este tipo, que se puede demostrar utilizando la fórmula de Leibniz o una factorización que involucre el complemento de Schur , es

Si es invertible , entonces se deduce con los resultados de la sección sobre multiplicidad que

lo cual se simplifica a cuando es una matriz.

Un resultado similar se cumple cuando es invertible, es decir

Ambos resultados pueden combinarse para derivar el teorema del determinante de Sylvester , que también se enuncia a continuación.

Si los bloques son matrices cuadradas del mismo tamaño, se aplican otras fórmulas. Por ejemplo, si y conmutan (es decir, ), entonces [12]

Esta fórmula se ha generalizado a matrices compuestas de más de bloques, nuevamente bajo condiciones de conmutatividad apropiadas entre los bloques individuales. [13]

Para y , se cumple la siguiente fórmula (incluso si y no conmutan) [ cita requerida ]

El teorema del determinante de Sylvester establece que para A , una matriz m × n , y B , una matriz n × m (de modo que A y B tienen dimensiones que permiten multiplicarlos en cualquier orden formando una matriz cuadrada):

donde I m e I n son las matrices identidad m × m y n × n , respectivamente.

De este resultado general se desprenden varias consecuencias.

El determinante de la suma de dos matrices cuadradas del mismo tamaño no es en general expresable en términos de los determinantes de A y de B.

Sin embargo, para matrices semidefinidas positivas y de igual tamaño, con el corolario [15] [ 16]

El teorema de Brunn-Minkowski implica que la raíz n- ésima del determinante es una función cóncava , cuando se restringe a matrices hermíticas definidas positivas . [17] Por lo tanto, si A y B son matrices hermíticas definidas positivas , se tiene ya que la raíz n- ésima del determinante es una función homogénea .

Para el caso especial de matrices con entradas complejas, el determinante de la suma se puede escribir en términos de determinantes y trazas en la siguiente identidad:

Esto se puede demostrar escribiendo cada término en componentes . El lado izquierdo es

La expansión da

Se ve que los términos que son cuadráticos en son , y de manera similar para , por lo que la expresión se puede escribir

Podemos entonces escribir los términos cruzados como

que puede reconocerse como

lo que completa la prueba.

Esto tiene una aplicación en las álgebras matriciales. Por ejemplo, considere los números complejos como un álgebra matricial. Los números complejos tienen una representación como matrices de la forma con y reales. Como , tomando y en la identidad anterior da

Este resultado se dedujo simplemente de y .

El determinante está estrechamente relacionado con otros dos conceptos centrales del álgebra lineal, los valores propios y el polinomio característico de una matriz. Sea una matriz con elementos complejos . Entonces, por el Teorema Fundamental del Álgebra, debe tener exactamente n valores propios . (Aquí se entiende que un valor propio con multiplicidad algebraica μ aparece μ veces en esta lista). Entonces, resulta que el determinante de A es igual al producto de estos valores propios,

El producto de todos los valores propios distintos de cero se denomina pseudodeterminante .

De esto se desprende inmediatamente que el determinante de una matriz es cero si y solo si es un valor propio de . En otras palabras, es invertible si y solo si no es un valor propio de .

El polinomio característico se define como [18]

Aquí, es la indeterminada del polinomio y es la matriz identidad del mismo tamaño que . Mediante este polinomio, se pueden utilizar los determinantes para hallar los valores propios de la matriz : son precisamente las raíces de este polinomio, es decir, aquellos números complejos tales que

Una matriz hermítica es definida positiva si todos sus valores propios son positivos. El criterio de Sylvester afirma que esto es equivalente a los determinantes de las submatrices.

siendo positivo, para todos entre y . [19]

La traza tr( A ) es por definición la suma de las entradas diagonales de A y también es igual a la suma de los valores propios. Por lo tanto, para matrices complejas A ,

o, para matrices reales A ,

Aquí exp( A ) denota la matriz exponencial de A , porque cada valor propio λ de A corresponde al valor propio exp( λ ) de exp( A ). En particular, dado cualquier logaritmo de A , es decir, cualquier matriz L que satisfaga

El determinante de A viene dado por

Por ejemplo, para n = 2 , n = 3 y n = 4 , respectivamente,

cf. Teorema de Cayley-Hamilton . Tales expresiones son deducibles a partir de argumentos combinatorios, identidades de Newton o el algoritmo de Faddeev–LeVerrier . Es decir, para n genérico , det A = (−1) n c 0 el término constante con signo del polinomio característico , determinado recursivamente a partir de

En el caso general, esto también se puede obtener de [20].

donde la suma se toma sobre el conjunto de todos los números enteros k l ≥ 0 que satisfacen la ecuación

La fórmula se puede expresar en términos del polinomio de Bell exponencial completo de n argumentos s l = −( l – 1)! tr( A l ) como

Esta fórmula también se puede utilizar para hallar el determinante de una matriz A I J con índices multidimensionales I = ( i 1 , i 2 , ..., i r ) y J = ( j 1 , j 2 , ..., j r ) . El producto y la traza de dichas matrices se definen de forma natural como

Se puede obtener una identidad n de dimensión arbitraria importante a partir de la expansión en serie de Mercator del logaritmo cuando la expansión converge. Si cada valor propio de A es menor que 1 en valor absoluto,

donde I es la matriz identidad. De manera más general, si

se expande como una serie de potencia formal en s, entonces todos los coeficientes de s m para m > n son cero y el polinomio restante es det( I + sA ) .

Para una matriz definida positiva A , el operador de traza proporciona los siguientes límites inferior y superior estrictos en el determinante logarítmico

con igualdad si y sólo si A = I . Esta relación se puede derivar mediante la fórmula para la divergencia de Kullback-Leibler entre dos distribuciones normales multivariadas .

También,

Estas desigualdades se pueden demostrar expresando las trazas y el determinante en términos de los valores propios. Como tales, representan el hecho bien conocido de que la media armónica es menor que la media geométrica , que es menor que la media aritmética , que es, a su vez, menor que la raíz cuadrada media .

La fórmula de Leibniz muestra que el determinante de matrices cuadradas reales (o análogamente para matrices complejas) es una función polinómica de a . En particular, es diferenciable en todas partes . Su derivada puede expresarse utilizando la fórmula de Jacobi : [21]

donde denota el adjutor de . En particular, si es invertible, tenemos

Expresados en términos de las entradas de , estos son

Otra formulación equivalente es

utilizando la notación O grande . El caso especial donde , la matriz identidad, produce

Esta identidad se utiliza para describir álgebras de Lie asociadas a ciertos grupos de Lie de matrices . Por ejemplo, el grupo lineal especial se define mediante la ecuación . La fórmula anterior muestra que su álgebra de Lie es el álgebra de Lie lineal especial que consiste en aquellas matrices que tienen traza cero.

Al escribir una matriz como donde son vectores columna de longitud 3, entonces el gradiente sobre uno de los tres vectores puede escribirse como el producto vectorial de los otros dos:

Históricamente, los determinantes se utilizaron mucho antes que las matrices: un determinante se definió originalmente como una propiedad de un sistema de ecuaciones lineales . El determinante "determina" si el sistema tiene una solución única (lo que ocurre precisamente si el determinante no es cero). En este sentido, los determinantes se utilizaron por primera vez en el libro de texto de matemáticas chino Los nueve capítulos sobre el arte matemático (九章算術, eruditos chinos, alrededor del siglo III a. C.). En Europa, las soluciones de sistemas lineales de dos ecuaciones fueron expresadas por Cardano en 1545 mediante una entidad similar a un determinante. [22]

Los determinantes propiamente dichos se originaron por separado a partir del trabajo de Seki Takakazu en 1683 en Japón y paralelamente de Leibniz en 1693. [23] [24] [25] [26] Cramer (1750) enunció, sin prueba, la regla de Cramer. [27] Tanto Cramer como Bézout (1779) fueron llevados a los determinantes por la cuestión de las curvas planas que pasan por un conjunto dado de puntos. [28]

Vandermonde (1771) fue el primero en reconocer los determinantes como funciones independientes. [24] Laplace (1772) dio el método general para desarrollar un determinante en términos de sus menores complementarios : Vandermonde ya había dado un caso especial. [29] Inmediatamente después, Lagrange (1773) trató los determinantes de segundo y tercer orden y los aplicó a cuestiones de teoría de eliminación ; demostró muchos casos especiales de identidades generales.

Gauss (1801) realizó el siguiente avance. Al igual que Lagrange, hizo un gran uso de los determinantes en la teoría de números . Introdujo la palabra "determinante" (Laplace había usado "resultante"), aunque no en el significado actual, sino más bien como se aplica al discriminante de un cuanto . [30] Gauss también llegó a la noción de determinantes recíprocos (inversos) y se acercó mucho al teorema de la multiplicación. [ aclaración necesaria ]

El siguiente autor de importancia fue Binet (1811, 1812), quien enunció formalmente el teorema relativo al producto de dos matrices de m columnas y n filas, que para el caso especial de m = n se reduce al teorema de la multiplicación. El mismo día (30 de noviembre de 1812) en que Binet presentó su trabajo en la Academia, Cauchy también presentó uno sobre el tema (véase la fórmula de Cauchy-Binet ). En él utilizó la palabra "determinante" en su sentido actual, [31] [32] resumió y simplificó lo que se sabía entonces sobre el tema, mejoró la notación y presentó el teorema de la multiplicación con una prueba más satisfactoria que la de Binet. [24] [33] Con él comienza la teoría en su generalidad.

Jacobi (1841) utilizó el determinante funcional que Sylvester más tarde llamó jacobiano . [34] En sus memorias en el Crelle's Journal de 1841, trata especialmente este tema, así como la clase de funciones alternantes que Sylvester ha llamado alternantes . En la época de las últimas memorias de Jacobi, Sylvester (1839) y Cayley comenzaron su trabajo. Cayley en 1841 introdujo la notación moderna para el determinante utilizando barras verticales. [35] [36]

El estudio de las formas especiales de los determinantes ha sido el resultado natural de la finalización de la teoría general. Los determinantes axisimétricos han sido estudiados por Lebesgue , Hesse y Sylvester; los determinantes persimétricos por Sylvester y Hankel ; los circulantes por Catalan , Spottiswoode , Glaisher y Scott; los determinantes oblicuos y pfaffianos , en conexión con la teoría de la transformación ortogonal , por Cayley; los continuantes por Sylvester; los wronskianos (así llamados por Muir ) por Christoffel y Frobenius ; los determinantes compuestos por Sylvester, Reiss y Picquet; los jacobianos y hessianos por Sylvester; y los determinantes simétricos gauche por Trudi . De los libros de texto sobre el tema, el de Spottiswoode fue el primero. En Estados Unidos, Hanus (1886), Weld (1893) y Muir/Metzler (1933) publicaron tratados.

Los determinantes se pueden utilizar para describir las soluciones de un sistema lineal de ecuaciones , escrito en forma matricial como . Esta ecuación tiene una solución única si y solo si es distinto de cero. En este caso, la solución viene dada por la regla de Cramer :

donde es la matriz formada al reemplazar la -ésima columna de por el vector columna . Esto sigue inmediatamente por la expansión en columna del determinante, es decir

donde los vectores son las columnas de A . La regla también está implícita en la identidad

La regla de Cramer se puede implementar en el tiempo, lo que es comparable a los métodos más comunes de resolución de sistemas de ecuaciones lineales, como LU , QR o la descomposición en valores singulares . [37]

Los determinantes se pueden utilizar para caracterizar vectores linealmente dependientes : es cero si y solo si los vectores columna (o, equivalentemente, los vectores fila) de la matriz son linealmente dependientes. [38] Por ejemplo, dados dos vectores linealmente independientes , un tercer vector se encuentra en el plano generado por los dos vectores anteriores exactamente si el determinante de la matriz - que consiste en los tres vectores es cero. La misma idea también se utiliza en la teoría de ecuaciones diferenciales : dadas funciones (supuestamente diferenciables ), el wronskiano se define como

Es distinto de cero (para algún ) en un intervalo especificado si y solo si las funciones dadas y todas sus derivadas hasta el orden son linealmente independientes. Si se puede demostrar que el wronskiano es cero en todas partes en un intervalo, entonces, en el caso de funciones analíticas , esto implica que las funciones dadas son linealmente dependientes. Véase el wronskiano y la independencia lineal . Otro uso similar del determinante es la resultante , que da un criterio cuando dos polinomios tienen una raíz común . [39]

El determinante puede considerarse como la asignación de un número a cada secuencia de n vectores en R n , utilizando la matriz cuadrada cuyas columnas son los vectores dados. El determinante será distinto de cero si y solo si la secuencia de vectores es una base para R n . En ese caso, el signo del determinante determina si la orientación de la base es consistente con o opuesta a la orientación de la base estándar . En el caso de una base ortogonal, la magnitud del determinante es igual al producto de las longitudes de los vectores de la base. Por ejemplo, una matriz ortogonal con entradas en R n representa una base ortonormal en el espacio euclidiano , y por lo tanto tiene un determinante de ±1 (ya que todos los vectores tienen una longitud de 1). El determinante es +1 si y solo si la base tiene la misma orientación. Es −1 si y solo si la base tiene la orientación opuesta.

De manera más general, si el determinante de A es positivo, A representa una transformación lineal que preserva la orientación (si A es una matriz ortogonal 2 × 2 o 3 × 3 , esto es una rotación ), mientras que si es negativo, A cambia la orientación de la base.

Como se señaló anteriormente, el valor absoluto del determinante de los vectores reales es igual al volumen del paralelepípedo abarcado por esos vectores. En consecuencia, si es la función lineal dada por la multiplicación con una matriz , y es cualquier subconjunto medible , entonces el volumen de está dado por multiplicado por el volumen de . [40] De manera más general, si la función lineal está representada por la matriz - , entonces el volumen - dimensional de está dado por:

Calculando el volumen del tetraedro acotado por cuatro puntos, se pueden utilizar para identificar líneas oblicuas . El volumen de cualquier tetraedro, dados sus vértices , , o cualquier otra combinación de pares de vértices que formen un árbol de expansión sobre los vértices.

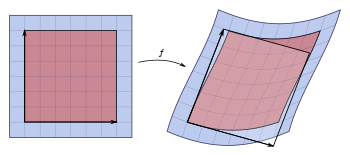

Para una función diferenciable general , gran parte de lo anterior se aplica considerando la matriz jacobiana de f .

La matriz jacobiana es la matriz n × n cuyas entradas están dadas por las derivadas parciales

Su determinante, el determinante jacobiano , aparece en la versión de dimensión superior de la integración por sustitución : para funciones adecuadas f y un subconjunto abierto U de R n (el dominio de f ), la integral sobre f ( U ) de alguna otra función φ : R n → R m está dada por

El jacobiano también aparece en el teorema de la función inversa .

Cuando se aplica al campo de la cartografía , el determinante se puede utilizar para medir la tasa de expansión de un mapa cerca de los polos. [41]

Las identidades anteriores relativas al determinante de productos e inversas de matrices implican que matrices similares tienen el mismo determinante: dos matrices A y B son similares, si existe una matriz invertible X tal que A = X −1 BX . De hecho, al aplicar repetidamente las identidades anteriores se obtiene

Por lo tanto, el determinante también se denomina invariante de semejanza . El determinante de una transformación lineal

para un espacio vectorial de dimensión finita, V se define como el determinante de la matriz que lo describe, con respecto a una elección arbitraria de base en V. Por la invariancia de similitud, este determinante es independiente de la elección de la base para V y, por lo tanto , solo depende del endomorfismo T.

La definición anterior del determinante utilizando la regla de Leibniz funciona de manera más general cuando las entradas de la matriz son elementos de un anillo conmutativo , como los números enteros , en oposición al cuerpo de números reales o complejos. Además, la caracterización del determinante como la única función multilineal alternada que satisface sigue siendo válida, al igual que todas las propiedades que resultan de esa caracterización. [42]

Una matriz es invertible (en el sentido de que existe una matriz inversa cuyas entradas están en ) si y solo si su determinante es un elemento invertible en . [43] Para , esto significa que el determinante es +1 o −1. Una matriz de este tipo se denomina unimodular .

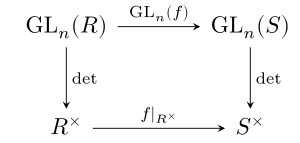

El determinante es multiplicativo, por lo que define un homomorfismo de grupo.

entre el grupo lineal general (el grupo de matrices invertibles con entradas en ) y el grupo multiplicativo de unidades en . Dado que respeta la multiplicación en ambos grupos, esta función es un homomorfismo de grupo .

Dado un homomorfismo de anillo , existe una función dada al reemplazar todas las entradas en por sus imágenes bajo . El determinante respeta estas funciones, es decir, la identidad

se cumple. En otras palabras, el diagrama conmutativo mostrado conmuta.

Por ejemplo, el determinante del conjugado complejo de una matriz compleja (que también es el determinante de su transpuesta conjugada) es el conjugado complejo de su determinante, y para matrices enteras: el módulo de reducción del determinante de dicha matriz es igual al determinante de la matriz módulo reducido (el último determinante se calcula utilizando aritmética modular ). En el lenguaje de la teoría de categorías , el determinante es una transformación natural entre los dos funtores y . [44] Añadiendo otra capa de abstracción, esto se captura diciendo que el determinante es un morfismo de grupos algebraicos , desde el grupo lineal general hasta el grupo multiplicativo ,

El determinante de una transformación lineal de un espacio vectorial de dimensión - o, más generalmente, un módulo libre de rango (finito) sobre un anillo conmutativo se puede formular de manera libre de coordenadas considerando la -ésima potencia exterior de . [45] La función induce una función lineal

Como es unidimensional, la función se obtiene multiplicando por algún escalar, es decir, un elemento de . Algunos autores como (Bourbaki 1998) utilizan este hecho para definir el determinante como el elemento de que satisface la siguiente identidad (para todo ):

Esta definición concuerda con la definición más concreta dependiente de coordenadas. Esto se puede demostrar utilizando la unicidad de una forma alternada multilineal en -tuplas de vectores en . Por esta razón, la potencia exterior no nula más alta (a diferencia del determinante asociado a un endomorfismo) a veces también se denomina determinante de y de manera similar para objetos más complejos como fibrados vectoriales o complejos en cadena de espacios vectoriales. Los menores de una matriz también se pueden convertir en este contexto, considerando formas alternadas inferiores con . [46]

Los determinantes tratados anteriormente admiten varias variantes: el permanente de una matriz se define como determinante, excepto que se omiten los factores que aparecen en la regla de Leibniz. El inmanente generaliza ambos introduciendo un carácter del grupo simétrico en la regla de Leibniz.

Para cualquier álgebra asociativa que sea de dimensión finita como un espacio vectorial sobre un cuerpo , existe un mapa determinante [47]

Esta definición parte del establecimiento del polinomio característico independientemente del determinante y define el determinante como el término de menor orden de este polinomio. Esta definición general recupera el determinante para el álgebra matricial , pero también incluye varios casos más, entre ellos el determinante de un cuaternión .

La norma de una extensión de campo , así como el Pfaffian de una matriz antisimétrica y la norma reducida de un álgebra central simple , también surgen como casos especiales de esta construcción.

En el caso de matrices con un número infinito de filas y columnas, las definiciones anteriores del determinante no se aplican directamente. Por ejemplo, en la fórmula de Leibniz, se debería calcular una suma infinita (cuyos términos son todos productos infinitos). El análisis funcional proporciona distintas extensiones del determinante para este tipo de situaciones de dimensión infinita, que, sin embargo, solo funcionan para determinados tipos de operadores.

El determinante de Fredholm define el determinante para los operadores conocidos como operadores de clase traza mediante una generalización apropiada de la fórmula

Otra noción de determinante de dimensión infinita es el determinante funcional .

Para los operadores en un factor finito , se puede definir un determinante positivo de valor real llamado determinante de Fuglede−Kadison utilizando la traza canónica. De hecho, para cada estado de la traza en un álgebra de von Neumann existe una noción de determinante de Fuglede−Kadison.

Para matrices sobre anillos no conmutativos, la multilinealidad y las propiedades alternas son incompatibles para n ≥ 2 , [48] por lo que no existe una buena definición del determinante en este contexto.

Para matrices cuadradas con entradas en un anillo no conmutativo, existen varias dificultades para definir determinantes de manera análoga a la de los anillos conmutativos. Se puede dar un significado a la fórmula de Leibniz siempre que se especifique el orden del producto, y de manera similar para otras definiciones del determinante, pero la no conmutatividad conduce entonces a la pérdida de muchas propiedades fundamentales del determinante, como la propiedad multiplicativa o que el determinante no cambia bajo la transposición de la matriz. Sobre anillos no conmutativos, no hay una noción razonable de una forma multilineal (la existencia de una forma bilineal distinta de cero [ aclarar ] con un elemento regular de R como valor en algún par de argumentos implica que R es conmutativo). Sin embargo, se han formulado varias nociones de determinante no conmutativo que preservan algunas de las propiedades de los determinantes, en particular los cuasideterminantes y el determinante de Dieudonné . Para algunas clases de matrices con elementos no conmutativos, se puede definir el determinante y demostrar teoremas de álgebra lineal que son muy similares a sus análogos conmutativos. Los ejemplos incluyen el determinante q en grupos cuánticos, el determinante de Capelli en matrices de Capelli y el bereziniano en supermatrices (es decir, matrices cuyas entradas son elementos de anillos graduados ) . [49] Las matrices de Manin forman la clase más cercana a las matrices con elementos conmutativos.

Los determinantes se utilizan principalmente como una herramienta teórica. Rara vez se calculan explícitamente en álgebra lineal numérica , donde para aplicaciones como la comprobación de la invertibilidad y la búsqueda de valores propios, el determinante ha sido reemplazado en gran medida por otras técnicas. [50] Sin embargo, la geometría computacional utiliza con frecuencia cálculos relacionados con los determinantes. [51]

Si bien el determinante se puede calcular directamente utilizando la regla de Leibniz, este enfoque es extremadamente ineficiente para matrices grandes, ya que esa fórmula requiere calcular productos ( factoriales ) para una matriz . Por lo tanto, el número de operaciones requeridas crece muy rápidamente: es del orden de . La expansión de Laplace es igualmente ineficiente. Por lo tanto, se han desarrollado técnicas más complejas para calcular determinantes.

La eliminación gaussiana consiste en multiplicar por la izquierda una matriz por matrices elementales para obtener una matriz en forma escalonada . Se puede restringir el cálculo a matrices elementales de determinante 1. En este caso, el determinante de la forma escalonada resultante es igual al determinante de la matriz inicial. Como una forma escalonada es una matriz triangular , su determinante es el producto de los elementos de su diagonal.

Por lo tanto, el determinante se puede calcular casi gratis a partir del resultado de una eliminación gaussiana.

Algunos métodos calculan escribiendo la matriz como un producto de matrices cuyos determinantes se pueden calcular más fácilmente. Dichas técnicas se conocen como métodos de descomposición. Algunos ejemplos incluyen la descomposición LU , la descomposición QR o la descomposición de Cholesky (para matrices definidas positivas ). Estos métodos son del orden de , lo que supone una mejora significativa con respecto a . [52]

Por ejemplo, la descomposición LU se expresa como un producto

de una matriz de permutación (que tiene exactamente un solo en cada columna y ceros en el resto), una matriz triangular inferior y una matriz triangular superior . Los determinantes de las dos matrices triangulares y se pueden calcular rápidamente, ya que son los productos de las entradas diagonales respectivas. El determinante de es simplemente el signo de la permutación correspondiente (que es para un número par de permutaciones y es para un número impar de permutaciones). Una vez que se conoce dicha descomposición LU para , su determinante se calcula fácilmente como

El orden alcanzado por los métodos de descomposición se ha mejorado mediante diferentes métodos. Si dos matrices de orden se pueden multiplicar en tiempo , donde para algún , entonces existe un algoritmo que calcula el determinante en tiempo . [53] Esto significa, por ejemplo, que existe un algoritmo para calcular el determinante basado en el algoritmo Coppersmith–Winograd . Este exponente se ha reducido aún más, a partir de 2016, a 2,373. [54]

Además de la complejidad del algoritmo, se pueden utilizar otros criterios para comparar algoritmos. Especialmente para aplicaciones relacionadas con matrices sobre anillos, existen algoritmos que calculan el determinante sin ninguna división. (Por el contrario, la eliminación de Gauss requiere divisiones). Uno de estos algoritmos, que tiene complejidad, se basa en la siguiente idea: uno reemplaza permutaciones (como en la regla de Leibniz) por los llamados paseos ordenados cerrados, en los que se pueden repetir varios elementos. La suma resultante tiene más términos que en la regla de Leibniz, pero en el proceso se pueden reutilizar varios de estos productos, lo que lo hace más eficiente que el cálculo ingenuo con la regla de Leibniz. [55] Los algoritmos también se pueden evaluar de acuerdo con su complejidad de bits , es decir, cuántos bits de precisión se necesitan para almacenar valores intermedios que ocurren en el cálculo. Por ejemplo, el método de eliminación gaussiana (o descomposición LU) es de orden , pero la longitud de bits de los valores intermedios puede llegar a ser exponencialmente larga. [56] En comparación, el algoritmo de Bareiss , es un método de división exacta (por lo que utiliza división, pero solo en casos donde estas divisiones se pueden realizar sin resto) es del mismo orden, pero la complejidad de bits es aproximadamente el tamaño de bits de las entradas originales en la matriz multiplicada por . [57]

Si ya se han calculado el determinante de A y la inversa de A , el lema del determinante matricial permite un cálculo rápido del determinante de A + uv T , donde u y v son vectores columna.

Charles Dodgson (es decir, Lewis Carroll, famoso por su libro Alicia en el país de las maravillas ) inventó un método para calcular determinantes llamado condensación de Dodgson . Lamentablemente, este interesante método no siempre funciona en su forma original. [58]

{{citation}}: CS1 maint: multiple names: authors list (link)