La historia del hardware informático cubre los desarrollos desde los primeros dispositivos simples para ayudar al cálculo hasta las computadoras modernas .

Las primeras ayudas para el cálculo fueron dispositivos puramente mecánicos que requerían que el operador estableciera los valores iniciales de una operación aritmética elemental y luego manipulara el dispositivo para obtener el resultado. Más tarde, las computadoras representaron números en forma continua (por ejemplo, la distancia a lo largo de una escala, la rotación de un eje o un voltaje ). Los números también podrían representarse en forma de dígitos, manipulados automáticamente mediante un mecanismo. Aunque este enfoque generalmente requería mecanismos más complejos, aumentó considerablemente la precisión de los resultados. El desarrollo de la tecnología de transistores y luego del chip de circuito integrado condujo a una serie de avances, comenzando con las computadoras con transistores y luego con las computadoras con circuitos integrados, lo que provocó que las computadoras digitales reemplazaran en gran medida a las computadoras analógicas . La integración a gran escala (LSI ) de semiconductores de óxido metálico (MOS ) permitió entonces la memoria semiconductora y el microprocesador , lo que condujo a otro avance clave, la computadora personal (PC) miniaturizada, en la década de 1970. El costo de las computadoras gradualmente se volvió tan bajo que las computadoras personales en la década de 1990, y luego las computadoras móviles ( teléfonos inteligentes y tabletas ) en la década de 2000, se volvieron omnipresentes.

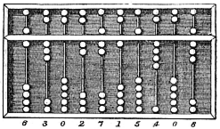

Se han utilizado dispositivos para ayudar en la computación durante miles de años, principalmente utilizando correspondencia uno a uno con los dedos . El primer dispositivo de conteo fue probablemente una especie de palo de conteo . El hueso Lebombo de las montañas entre Eswatini y Sudáfrica puede ser el artefacto matemático más antiguo conocido. [2] Data del 35.000 a. C. y consta de 29 muescas distintas que fueron cortadas deliberadamente en el peroné de un babuino . [3] [4] Las ayudas posteriores para el mantenimiento de registros en todo el Creciente Fértil incluyeron cálculos (esferas de arcilla, conos, etc.) que representaban recuentos de artículos, probablemente ganado o granos, sellados en recipientes huecos de arcilla sin cocer. [b] [6] [c] El uso de varillas para contar es un ejemplo. El ábaco se utilizó tempranamente para tareas aritméticas. Lo que hoy llamamos ábaco romano se utilizaba en Babilonia ya en c. 2700-2300 a.C. Desde entonces, se han inventado muchas otras formas de tableros o tablas de cómputo. En una casa de contabilidad medieval europea , se colocaba un paño a cuadros sobre una mesa y los marcadores se movían sobre él de acuerdo con ciertas reglas, como ayuda para calcular sumas de dinero.

En la época antigua y medieval se construyeron varias computadoras analógicas para realizar cálculos astronómicos. Estos incluían el astrolabio y el mecanismo de Antikythera del mundo helenístico (c. 150-100 a. C.). [8] En el Egipto romano , Héroe de Alejandría (c. 10-70 d.C.) fabricó dispositivos mecánicos, incluidos autómatas y un carro programable . [9] Otros dispositivos mecánicos tempranos utilizados para realizar uno u otro tipo de cálculos incluyen el planisferio y otros dispositivos informáticos mecánicos inventados por Al-Biruni (c. 1000 d.C.); el ecuador y el astrolabio universal independiente de la latitud de Al-Zarqali (c. 1015 d. C.); las computadoras astronómicas analógicas de otros astrónomos e ingenieros musulmanes medievales; y la torre del reloj astronómico de Su Song (1094) durante la dinastía Song . El reloj del castillo , un reloj astronómico mecánico de propulsión hidroeléctrica inventado por Ismail al-Jazari en 1206, fue la primera computadora analógica programable . [ disputado (por: la fuente citada no respalda la afirmación y la afirmación es engañosa.) ] [10] [11] [12] Ramon Llull inventó el Círculo Luliano: una máquina teórica para calcular respuestas a preguntas filosóficas (en este caso, que tiene que ver con el cristianismo) a través de la combinatoria lógica. Esta idea fue retomada por Leibniz siglos después, y es, por tanto, uno de los elementos fundacionales de la informática y las ciencias de la información .

El matemático y físico escocés John Napier descubrió que la multiplicación y división de números se podía realizar mediante la suma y resta, respectivamente, de los logaritmos de esos números. Mientras elaboraba las primeras tablas logarítmicas, Napier tuvo que realizar muchas multiplicaciones tediosas. Fue en este punto cuando diseñó sus ' huesos de Napier ', un dispositivo parecido a un ábaco que simplificaba enormemente los cálculos que implicaban multiplicación y división. [d]

Dado que los números reales se pueden representar como distancias o intervalos en una línea, la regla de cálculo se inventó en la década de 1620, poco después del trabajo de Napier, para permitir que las operaciones de multiplicación y división se llevaran a cabo significativamente más rápido de lo que era posible anteriormente. [13] Edmund Gunter construyó un dispositivo de cálculo con una escala logarítmica única en la Universidad de Oxford . Su dispositivo simplificó enormemente los cálculos aritméticos, incluidas la multiplicación y la división. William Oughtred mejoró enormemente esto en 1630 con su regla de cálculo circular. Siguió esto con la regla de cálculo moderna en 1632, esencialmente una combinación de dos reglas de Gunter , sostenidas con las manos. Las reglas de cálculo fueron utilizadas por generaciones de ingenieros y otros trabajadores profesionales involucrados en matemáticas, hasta la invención de la calculadora de bolsillo . [14]

En 1609 Guidobaldo del Monte fabricó un multiplicador mecánico para calcular fracciones de grado. Basado en un sistema de cuatro engranajes, la rotación de un índice en un cuadrante corresponde a 60 rotaciones de otro índice en el cuadrante opuesto. [15] Gracias a esta máquina se pueden evitar errores en el cálculo de primer, segundo, tercer y cuarto grado. Guidobaldo es el primero en documentar el uso de engranajes para el cálculo mecánico.

Wilhelm Schickard , un erudito alemán , diseñó una máquina calculadora en 1623 que combinaba una forma mecanizada de varillas de Napier con la primera máquina sumadora mecánica del mundo integrada en la base. Debido a que utilizaba un engranaje de un solo diente, había circunstancias en las que su mecanismo de transporte se atascaba. [16] Un incendio destruyó al menos una de las máquinas en 1624 y se cree que Schickard estaba demasiado desanimado para construir otra.

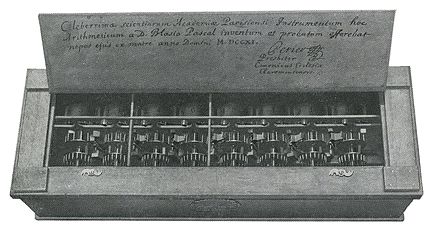

En 1642, cuando aún era un adolescente, Blaise Pascal inició un trabajo pionero sobre máquinas calculadoras y después de tres años de esfuerzo y 50 prototipos [17] inventó una calculadora mecánica . [18] [19] Construyó veinte de estas máquinas (llamadas calculadora de Pascal o Pascaline) en los diez años siguientes. [20] Han sobrevivido nueve Pascalines, la mayoría de los cuales se exhiben en museos europeos. [e] Existe un debate continuo sobre si Schickard o Pascal deben ser considerados como el "inventor de la calculadora mecánica" y la variedad de cuestiones a considerar se discuten en otra parte. [21]

Gottfried Wilhelm von Leibniz inventó el calculador escalonado y su famoso mecanismo de tambor escalonado alrededor de 1672. Intentó crear una máquina que pudiera usarse no solo para sumar y restar, sino que también usara un carro móvil para permitir la multiplicación y la división. Leibniz dijo una vez: "Es indigno de hombres excelentes perder horas como esclavos en el trabajo de cálculo que podría ser relegado a cualquier otra persona si se utilizaran máquinas". [22] Sin embargo, Leibniz no incorporó un mecanismo de acarreo completamente exitoso. Leibniz también describió el sistema numérico binario , [23] un ingrediente central de todas las computadoras modernas. Sin embargo, hasta la década de 1940, muchos diseños posteriores (incluidas las máquinas de Charles Babbage de 1822 e incluso la ENIAC de 1945) se basaron en el sistema decimal. [F]

Alrededor de 1820, Charles Xavier Thomas de Colmar creó lo que durante el resto del siglo se convertiría en la primera calculadora mecánica exitosa producida en masa: el aritmómetro Thomas . Podría usarse para sumar y restar, y con un carro móvil el operador también podría multiplicar y dividir mediante un proceso de multiplicación y división largas. [24] Utilizaba un tambor escalonado similar en concepción al inventado por Leibniz. Las calculadoras mecánicas permanecieron en uso hasta la década de 1970.

En 1804, el tejedor francés Joseph Marie Jacquard desarrolló un telar en el que el patrón que se tejía se controlaba mediante una cinta de papel construida con tarjetas perforadas . La cinta de papel podría cambiarse sin cambiar el diseño mecánico del telar. Este fue un logro histórico en programabilidad. Su máquina fue una mejora con respecto a telares similares. Las tarjetas perforadas iban precedidas de bandas perforadoras, como en la máquina propuesta por Basile Bouchon . Estas bandas inspirarían la grabación de información para pianos automáticos y, más recientemente, máquinas herramienta de control numérico .

A finales de la década de 1880, el estadounidense Herman Hollerith inventó el almacenamiento de datos en tarjetas perforadas que luego podían leerse mediante una máquina. [25] Para procesar estas tarjetas perforadas, inventó el tabulador y la perforadora de llaves . Sus máquinas utilizaban relés y contadores electromecánicos . [26] El método de Hollerith se utilizó en el censo de Estados Unidos de 1890 . Ese censo se procesó dos años más rápido que el censo anterior. [27] La empresa de Hollerith finalmente se convirtió en el núcleo de IBM .

En 1920, las máquinas tabuladoras electromecánicas podían sumar, restar e imprimir totales acumulados. [28] Las funciones de la máquina se dirigieron insertando docenas de puentes de cables en paneles de control extraíbles . Cuando Estados Unidos instituyó la Seguridad Social en 1935, se utilizaron los sistemas de tarjetas perforadas de IBM para procesar los registros de 26 millones de trabajadores. [29] Las tarjetas perforadas se volvieron omnipresentes en la industria y el gobierno para la contabilidad y la administración.

Los artículos de Leslie Comrie sobre métodos de tarjetas perforadas [30] y la publicación de WJ Eckert de Punched Card Methods in Scientific Computation en 1940, describieron técnicas de tarjetas perforadas lo suficientemente avanzadas como para resolver algunas ecuaciones diferenciales o realizar multiplicaciones y divisiones usando punto flotante. representaciones, todas ellas en tarjetas perforadas y máquinas de registro unitario . [31] Estas máquinas se utilizaron durante la Segunda Guerra Mundial para el procesamiento estadístico criptográfico, así como para una gran cantidad de usos administrativos. [ cita necesaria ] La Oficina de Computación Astronómica de la Universidad de Columbia , realizó cálculos astronómicos que representan el estado del arte en informática . [32] [33]

En el siglo XX, las calculadoras mecánicas, cajas registradoras, máquinas contables, etc. anteriores fueron rediseñadas para utilizar motores eléctricos, con la posición del engranaje como representación del estado de una variable. La palabra "computadora" era un título de trabajo asignado principalmente a mujeres que usaban estas calculadoras para realizar cálculos matemáticos. [34] En la década de 1920, el interés del científico británico Lewis Fry Richardson en la predicción del tiempo lo llevó a proponer computadoras humanas y análisis numéricos para modelar el clima; A día de hoy, se necesitan las computadoras más potentes de la Tierra para modelar adecuadamente su clima utilizando las ecuaciones de Navier-Stokes . [35]

Empresas como Friden , Marchant Calculator y Monroe fabricaron calculadoras mecánicas de escritorio a partir de la década de 1930 que podían sumar, restar, multiplicar y dividir. [36] En 1948, la Curta fue introducida por el inventor austriaco Curt Herzstark . Era una pequeña calculadora mecánica de manivela y, como tal, descendiente del Calculador escalonado de Gottfried Leibniz y del Aritmómetro de Thomas .

La primera calculadora de escritorio totalmente electrónica del mundo fue la británica Bell Punch ANITA , lanzada en 1961. [37] [38] Utilizaba tubos de vacío , tubos de cátodo frío y Dekatrons en sus circuitos, con 12 tubos "Nixie" de cátodo frío para su visualización. ANITA se vendió bien porque era la única calculadora electrónica de escritorio disponible y era silenciosa y rápida. La tecnología de tubos fue reemplazada en junio de 1963 por el Friden EC-130 fabricado en EE. UU., que tenía un diseño totalmente de transistores, una pila de cuatro números de 13 dígitos mostrados en un CRT de 5 pulgadas (13 cm) e introdujo la notación polaca inversa. (RPN).

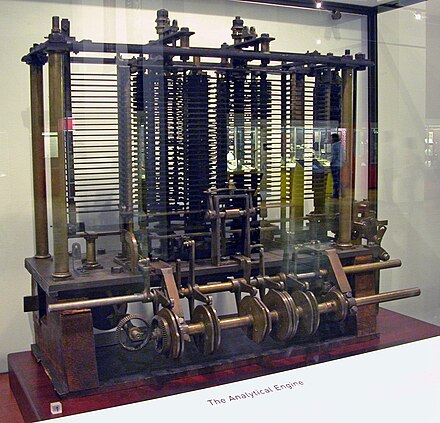

Charles Babbage , un ingeniero mecánico y erudito inglés , originó el concepto de computadora programable. A menudo considerado como el " padre de la computadora ", [39] conceptualizó e inventó la primera computadora mecánica a principios del siglo XIX. Después de trabajar en su revolucionario motor diferencial , diseñado para ayudar en los cálculos de navegación, en 1833 se dio cuenta de que era posible un diseño mucho más general, un motor analítico . La entrada de programas y datos debía realizarse a la máquina mediante tarjetas perforadas , método que se utilizaba en aquella época para dirigir telares mecánicos como el telar Jacquard . Para la salida, la máquina tendría una impresora, un trazador de curvas y una campana. La máquina también podría perforar números en tarjetas para leerlos más tarde. Empleaba aritmética ordinaria de punto fijo de base 10 .

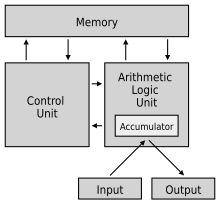

El motor incorporó una unidad lógica aritmética , flujo de control en forma de bifurcaciones y bucles condicionales y memoria integrada , lo que lo convirtió en el primer diseño de una computadora de propósito general que podría describirse en términos modernos como Turing completo . [40] [41]

Debía haber un almacén, o memoria, capaz de contener 1.000 números de 40 dígitos decimales cada uno (aproximadamente 16,7 kB ). Una unidad aritmética , llamada "molino", podría realizar las cuatro operaciones aritméticas , además de comparaciones y, opcionalmente, raíces cuadradas . Inicialmente se concibió como un motor diferenciado curvado hacia atrás sobre sí mismo, en un diseño generalmente circular, [42] con el largo almacén saliendo hacia un lado. (Los dibujos posteriores muestran un diseño de cuadrícula regularizado.) [43] Al igual que la unidad central de procesamiento (CPU) en una computadora moderna, la fábrica dependería de sus propios procedimientos internos, aproximadamente equivalentes al microcódigo en las CPU modernas, para almacenarse en la forma de clavijas insertadas en tambores giratorios llamados "barriles", para llevar a cabo algunas de las instrucciones más complejas que el programa del usuario pueda especificar. [44]

El lenguaje de programación que utilizarían los usuarios era similar a los lenguajes ensambladores modernos . Los bucles y las ramificaciones condicionales eran posibles, por lo que el lenguaje tal como se concibió habría sido Turing completo , tal como lo definió más tarde Alan Turing . Se utilizaron tres tipos diferentes de tarjetas perforadas: una para operaciones aritméticas, otra para constantes numéricas y otra para operaciones de carga y almacenamiento, transfiriendo números del almacén a la unidad aritmética o viceversa. Había tres lectores separados para los tres tipos de tarjetas.

La máquina se adelantó aproximadamente un siglo a su tiempo. Sin embargo, el proyecto se vio frenado por varios problemas, incluidas disputas con el jefe de maquinistas que fabricaba piezas. Todas las piezas de su máquina tenían que fabricarse a mano; este era un problema importante para una máquina con miles de piezas. Finalmente, el proyecto se disolvió con la decisión del gobierno británico de dejar de financiarlo. El fracaso de Babbage a la hora de completar el motor analítico puede atribuirse principalmente a dificultades no sólo políticas y financieras, sino también a su deseo de desarrollar una computadora cada vez más sofisticada y avanzar más rápido de lo que nadie podría seguir. Ada Lovelace tradujo y añadió notas al " Bosquejo de la máquina analítica " de Luigi Federico Menabrea . Esta parece ser la primera descripción publicada de la programación, por lo que Ada Lovelace es ampliamente considerada como la primera programadora de computadoras. [45]

Siguiendo a Babbage, aunque al principio desconocía su trabajo anterior, estaba Percy Ludgate , un empleado de un comerciante de maíz en Dublín, Irlanda. Diseñó de forma independiente una computadora mecánica programable, que describió en un trabajo publicado en 1909. [46] [47]

Otros dos inventores, Leonardo Torres Quevedo y Vannevar Bush , también siguieron la investigación basada en el trabajo de Babbage. En 1914, Torres publicó Ensayos sobre automática , donde escribió sobre los esfuerzos de Babbage por construir una máquina analítica mecánica y diseñó una máquina analítica electromecánica que debía ser controlada por un programa de sólo lectura. El artículo también introdujo la idea de la aritmética de punto flotante . [48] [49] [50] En 1920, presentó en una conferencia de París el aritmómetro electromecánico , una unidad aritmética que podía realizar operaciones automáticamente. [51] El artículo de Bush Análisis instrumental (1936) analiza el uso de máquinas de tarjetas perforadas de IBM existentes para implementar el diseño de Babbage. Ese mismo año inició el proyecto Máquina aritmética rápida para investigar los problemas de construcción de una computadora digital electrónica. [52]

En la primera mitad del siglo XX, muchos consideraban que las computadoras analógicas eran el futuro de la informática. Estos dispositivos utilizaban los aspectos continuamente cambiantes de fenómenos físicos como cantidades eléctricas , mecánicas o hidráulicas para modelar el problema que se estaba resolviendo, en contraste con las computadoras digitales que representaban cantidades variables simbólicamente, a medida que cambiaban sus valores numéricos. Como una computadora analógica no utiliza valores discretos, sino valores continuos, los procesos no se pueden repetir de manera confiable con equivalencia exacta, como ocurre con las máquinas de Turing . [53]

La primera computadora analógica moderna fue una máquina de predicción de mareas , inventada por Sir William Thomson , más tarde Lord Kelvin, en 1872. Utilizaba un sistema de poleas y cables para calcular automáticamente los niveles de marea previstos para un período determinado en un lugar particular y era de gran utilidad para la navegación en aguas poco profundas. Su dispositivo fue la base para futuros desarrollos en la informática analógica. [54]

El analizador diferencial , una computadora mecánica analógica diseñada para resolver ecuaciones diferenciales mediante integración utilizando mecanismos de rueda y disco, fue conceptualizado en 1876 por James Thomson , hermano del más famoso Lord Kelvin. Exploró la posible construcción de tales calculadoras, pero se vio obstaculizado por el par de salida limitado de los integradores de bolas y discos . [55] En un analizador diferencial, la salida de un integrador impulsó la entrada del siguiente integrador, o una salida gráfica.

Leonardo Torres Quevedo desarrolló una notable serie de máquinas calculadoras analógicas desde 1895, incluida una que podía calcular las raíces de polinomios arbitrarios de orden ocho, incluidos los complejos, con una precisión de hasta milésimas. [56] [57] [58]

Un avance importante en la informática analógica fue el desarrollo de los primeros sistemas de control de fuego para el tiroteo de barcos de largo alcance . Cuando los campos de tiro aumentaron dramáticamente a finales del siglo XIX, ya no era una simple cuestión de calcular el punto de mira adecuado, dados los tiempos de vuelo de los proyectiles. Varios observadores a bordo del barco transmitirían medidas de distancia y observaciones a una estación central de trazado. Allí, los equipos de dirección de fuego informaron la ubicación, velocidad y dirección del barco y su objetivo, así como varios ajustes para el efecto Coriolis , efectos climáticos en el aire y otros ajustes; Luego, la computadora generaría una solución de disparo, que se alimentaría a las torretas para su colocación. En 1912, el ingeniero británico Arthur Pollen desarrolló la primera computadora analógica mecánica alimentada eléctricamente (llamada en ese momento Reloj Argo). [ cita necesaria ] Fue utilizado por la Armada Imperial Rusa en la Primera Guerra Mundial . [ cita necesaria ] El sistema alternativo de control de incendios Dreyer Table se instaló en los buques capitales británicos a mediados de 1916.

También se utilizaron dispositivos mecánicos para mejorar la precisión de los bombardeos aéreos . Drift Sight fue la primera ayuda de este tipo, desarrollada por Harry Wimperis en 1916 para el Royal Naval Air Service ; midió la velocidad del viento desde el aire y utilizó esa medida para calcular los efectos del viento en la trayectoria de las bombas. El sistema se mejoró más tarde con el visor de bombas de ajuste de rumbo y alcanzó un clímax con los visores de bombas de la Segunda Guerra Mundial , el visor de bombas Mark XIV ( Comando de Bombarderos de la RAF ) y el Norden [59] ( Fuerzas Aéreas del Ejército de los Estados Unidos ).

El arte de la computación mecánica analógica alcanzó su cenit con el analizador diferencial , [60] construido por HL Hazen y Vannevar Bush en el MIT a partir de 1927, que se basó en los integradores mecánicos de James Thomson y los amplificadores de par inventados por HW Nieman. Se construyeron una docena de estos dispositivos antes de que su obsolescencia se hiciera evidente; el más potente se construyó en la Escuela Moore de Ingeniería Eléctrica de la Universidad de Pensilvania , donde se construyó el ENIAC .

Helmut Hölzer construyó una computadora analógica totalmente electrónica en 1942 en el Centro de Investigación del Ejército de Peenemünde . [61] [62] [63]

En la década de 1950, el éxito de las computadoras electrónicas digitales había significado el fin de la mayoría de las máquinas informáticas analógicas, pero las computadoras analógicas híbridas , controladas por electrónica digital, siguieron utilizándose sustancialmente durante las décadas de 1950 y 1960, y más tarde en algunas aplicaciones especializadas.

El principio de la computadora moderna fue descrito por primera vez por el científico informático Alan Turing , quien expuso la idea en su artículo fundamental de 1936, [64] Sobre números computables . Turing reformuló los resultados de Kurt Gödel de 1931 sobre los límites de la prueba y la computación, reemplazando el lenguaje formal universal basado en la aritmética de Gödel con los dispositivos hipotéticos formales y simples que se conocieron como máquinas de Turing . Demostró que una máquina de este tipo sería capaz de realizar cualquier cálculo matemático concebible si fuera representable como un algoritmo . Continuó demostrando que no había solución al problema de Entscheidungs mostrando primero que el problema de la detención de las máquinas de Turing es indecidible : en general, no es posible decidir algorítmicamente si una determinada máquina de Turing se detendrá alguna vez.

También introdujo la noción de una "máquina universal" (ahora conocida como máquina universal de Turing ), con la idea de que dicha máquina podría realizar las tareas de cualquier otra máquina, o en otras palabras, que es demostrablemente capaz de calcular cualquier cosa que es computable ejecutando un programa almacenado en cinta, lo que permite que la máquina sea programable. Von Neumann reconoció que el concepto central de la computadora moderna se debió a este artículo. [65] Las máquinas de Turing son hasta el día de hoy un objeto central de estudio en la teoría de la computación . Excepto por las limitaciones impuestas por sus almacenes de memoria finitos, se dice que las computadoras modernas son Turing-completas , es decir, tienen una capacidad de ejecución de algoritmos equivalente a una máquina de Turing universal .

La era de la informática moderna comenzó con una oleada de desarrollo antes y durante la Segunda Guerra Mundial. La mayoría de las computadoras digitales construidas en este período eran electromecánicas: los interruptores eléctricos accionaban relés mecánicos para realizar el cálculo. Estos dispositivos tenían una velocidad de funcionamiento baja y finalmente fueron reemplazados por computadoras totalmente eléctricas mucho más rápidas, que originalmente usaban tubos de vacío .

El Z2 fue uno de los primeros ejemplos de computadora de relé electromecánico y fue creado por el ingeniero alemán Konrad Zuse en 1940. Fue una mejora con respecto a su anterior Z1 ; aunque utilizaba la misma memoria mecánica , sustituyó la aritmética y la lógica de control por circuitos de relés eléctricos . [66]

Ese mismo año, los criptólogos británicos construyeron dispositivos electromecánicos llamados bombas para ayudar a descifrar los mensajes secretos cifrados por la máquina alemana Enigma durante la Segunda Guerra Mundial . El diseño inicial de la bomba fue creado en 1939 en la Escuela de Código y Cifrado del Gobierno del Reino Unido (GC&CS) en Bletchley Park por Alan Turing , [67] con un refinamiento importante ideado en 1940 por Gordon Welchman . [68] El diseño de ingeniería y la construcción fueron obra de Harold Keen de la British Tabulated Machine Company . Fue un desarrollo sustancial de un dispositivo que había sido diseñado en 1938 por el criptólogo polaco de la Oficina de Cifrado Marian Rejewski , y conocido como la " bomba criptológica " ( polaco : "bomba kryptologiczna" ).

En 1941, Zuse siguió su máquina anterior con la Z3 , [66] la primera computadora digital electromecánica , programable y totalmente automática en funcionamiento del mundo . [69] El Z3 se construyó con 2000 relés , implementando una longitud de palabra de 22 bits que operaba a una frecuencia de reloj de aproximadamente 5 a 10 Hz . [70] El código y los datos del programa se almacenaron en una película perforada . Era bastante similar a las máquinas modernas en algunos aspectos y fue pionera en numerosos avances, como los números de punto flotante . La sustitución del sistema decimal difícil de implementar (utilizado en el diseño anterior de Charles Babbage ) por el sistema binario más simple significó que las máquinas de Zuse eran más fáciles de construir y potencialmente más confiables, dadas las tecnologías disponibles en ese momento. [71] Raúl Rojas demostró en 1998 que la Z3 era una máquina Turing completa . [72] En dos solicitudes de patente de 1936 , Zuse también anticipó que las instrucciones de las máquinas podrían almacenarse en el mismo almacenamiento utilizado para los datos: la idea clave de lo que se conoció como la arquitectura von Neumann , implementada por primera vez en 1948 en Estados Unidos en el IBM SSEC electromecánico . y en Gran Bretaña en el Manchester Baby totalmente electrónico . [73]

Zuse sufrió reveses durante la Segunda Guerra Mundial cuando algunas de sus máquinas fueron destruidas en el curso de los bombardeos aliados . Aparentemente, su trabajo permaneció en gran medida desconocido para los ingenieros en el Reino Unido y Estados Unidos hasta mucho más tarde, aunque al menos IBM era consciente de ello, ya que financió su nueva empresa de posguerra en 1946 a cambio de una opción sobre las patentes de Zuse.

En 1944, se construyó el Harvard Mark I en los laboratorios Endicott de IBM. [74] Era una computadora electromecánica de propósito general similar a la Z3, pero no estaba completamente completa según Turing.

El término digital fue sugerido por primera vez por George Robert Stibitz y se refiere a que una señal, como un voltaje, no se utiliza para representar directamente un valor (como sería en una computadora analógica ), sino para codificarlo. En noviembre de 1937, Stibitz, que entonces trabajaba en los Laboratorios Bell (1930-1941), [75] completó una calculadora basada en relés que más tarde denominó " Modelo K " (por " mesa de cocina", en la que la había ensamblado). que se convirtió en el primer sumador binario . [76] Normalmente las señales tienen dos estados: bajo (normalmente representa 0) y alto (normalmente representa 1), pero a veces se utiliza lógica de tres valores , especialmente en memoria de alta densidad. Las computadoras modernas generalmente usan lógica binaria , pero muchas de las primeras máquinas eran computadoras decimales . En estas máquinas, la unidad básica de datos era el dígito decimal, codificado en uno de varios esquemas, incluido el código decimal codificado en binario o BCD, biquinario , exceso de 3 y dos de cinco .

La base matemática de la computación digital es el álgebra booleana , desarrollada por el matemático británico George Boole en su obra Las leyes del pensamiento , publicada en 1854. Su álgebra booleana fue refinada aún más en la década de 1860 por William Jevons y Charles Sanders Peirce , y fue presentada por primera vez. sistemáticamente por Ernst Schröder y AN Whitehead . [77] En 1879, Gottlob Frege desarrolla el enfoque formal de la lógica y propone el primer lenguaje lógico para ecuaciones lógicas. [78]

En la década de 1930, y trabajando de forma independiente, el ingeniero electrónico estadounidense Claude Shannon y el lógico soviético Victor Shestakov mostraron una correspondencia uno a uno entre los conceptos de la lógica booleana y ciertos circuitos eléctricos, ahora llamados puertas lógicas , que ahora son omnipresentes en las computadoras digitales. [79] Demostraron que los relés e interruptores electrónicos pueden realizar las expresiones del álgebra booleana . [80] Esta tesis fundamentó esencialmente el diseño práctico de circuitos digitales . Además, el artículo de Shannon proporciona un diagrama de circuito correcto para un sumador binario digital de 4 bits. [81]

Los elementos de circuitos puramente electrónicos pronto reemplazaron a sus equivalentes mecánicos y electromecánicos, al mismo tiempo que el cálculo digital reemplazó al analógico. Máquinas como la Z3 , la computadora Atanasoff-Berry , las computadoras Colossus y la ENIAC se construyeron a mano, utilizando circuitos que contenían relés o válvulas (tubos de vacío) y, a menudo, usaban tarjetas perforadas o cinta de papel perforada como entrada y como principal. medio de almacenamiento (no volátil). [82]

El ingeniero Tommy Flowers se unió a la rama de telecomunicaciones de la Oficina General de Correos en 1926. Mientras trabajaba en la estación de investigación de Dollis Hill en la década de 1930, comenzó a explorar el posible uso de la electrónica para la central telefónica . El equipo experimental que construyó en 1934 entró en funcionamiento 5 años después, convirtiendo una parte de la red telefónica en un sistema de procesamiento electrónico de datos, utilizando miles de tubos de vacío . [54]

En Estados Unidos, en 1940 Arthur Dickinson (IBM) inventó la primera computadora electrónica digital. [83] Este dispositivo de cálculo era completamente electrónico: control, cálculos y salida (la primera pantalla electrónica). [84] John Vincent Atanasoff y Clifford E. Berry de la Universidad Estatal de Iowa desarrollaron la computadora Atanasoff-Berry (ABC) en 1942, [85] el primer dispositivo de cálculo digital electrónico binario. [86] Este diseño era semielectrónico (control electromecánico y cálculos electrónicos) y utilizaba alrededor de 300 tubos de vacío, con condensadores fijados en un tambor giratorio mecánicamente para memoria. Sin embargo, su lector/escritor de tarjetas de papel no era confiable y el sistema de contacto del tambor regenerativo era mecánico. La naturaleza de propósito especial de la máquina y la falta de programas almacenados modificables la distinguen de las computadoras modernas. [87]

Las computadoras cuya lógica se construyó principalmente utilizando tubos de vacío se conocen ahora como computadoras de primera generación .

Durante la Segunda Guerra Mundial, los descifradores de códigos británicos en Bletchley Park , 40 millas (64 km) al norte de Londres, lograron varios éxitos al romper las comunicaciones militares enemigas cifradas. La máquina de cifrado alemana Enigma fue atacada primero con la ayuda de bombas electromecánicas . [88] Descartaron posibles configuraciones de Enigma realizando cadenas de deducciones lógicas implementadas eléctricamente. La mayoría de las posibilidades conducían a una contradicción, y las pocas que quedaban podían comprobarse manualmente.

Los alemanes también desarrollaron una serie de sistemas de cifrado de teleimpresores, bastante diferentes de Enigma. La máquina Lorenz SZ 40/42 se utilizó para las comunicaciones de alto nivel del ejército, con el nombre en código "Tunny" de los británicos. Las primeras interceptaciones de mensajes de Lorenz comenzaron en 1941. Como parte de un ataque a Tunny, Max Newman y sus colegas desarrollaron Heath Robinson , una máquina de función fija para ayudar a descifrar códigos. [89] Tommy Flowers , un ingeniero senior de la Estación de Investigación de Correos [90] fue recomendado a Max Newman por Alan Turing [91] y pasó once meses desde principios de febrero de 1943 diseñando y construyendo la computadora Colossus más flexible (que reemplazó a la Heath Robinson ). [92] [93] Después de una prueba funcional en diciembre de 1943, Colossus fue enviado a Bletchley Park, donde fue entregado el 18 de enero de 1944 [94] y atacó su primer mensaje el 5 de febrero. [95] Cuando Alemania se rindió en mayo de 1945, había diez colosos trabajando en Bletchley Park. [96]

Colossus fue la primera computadora electrónica digital programable del mundo . [54] Utilizaba una gran cantidad de válvulas (tubos de vacío). Tenía entrada de cinta de papel y podía configurarse para realizar una variedad de operaciones lógicas booleanas en sus datos, [97] pero no estaba completo en Turing . La entrada de datos a Colossus se realizó mediante lectura fotoeléctrica de una transcripción en cinta de papel del mensaje cifrado interceptado. Esto se organizó en un bucle continuo para que pudiera leerse y releerse varias veces, sin que existiera un almacenamiento interno para los datos. El mecanismo de lectura funcionaba a 5.000 caracteres por segundo y la cinta de papel se movía a 40 pies/s (12,2 m/s; 27,3 mph). Colossus Mark 1 contenía 1500 válvulas termoiónicas (tubos), pero Mark 2 con 2400 válvulas y cinco procesadores en paralelo era 5 veces más rápido y más sencillo de operar que Mark 1, lo que aceleró enormemente el proceso de decodificación. El Mark 2 se diseñó mientras se construía el Mark 1. Allen Coombs asumió el liderazgo del proyecto Colossus Mark 2 cuando Tommy Flowers pasó a otros proyectos. [98] El primer Mark 2 Colossus entró en funcionamiento el 1 de junio de 1944, justo a tiempo para la invasión aliada de Normandía el Día D.

La mayor parte del uso de Colossus fue determinar las posiciones iniciales de los rotores Tunny para un mensaje, que se denominó "ajuste de ruedas". Colossus incluyó el primer uso de registros de desplazamiento y matrices sistólicas , lo que permitió cinco pruebas simultáneas, cada una de las cuales implica hasta 100 cálculos booleanos . Esto permitió examinar cinco posibles posiciones iniciales diferentes para un solo paso de la cinta de papel. [99] Además del ajuste de las ruedas, algunos Colosos posteriores incluyeron mecanismos destinados a ayudar a determinar los patrones de pasadores conocidos como "rotura de ruedas". Ambos modelos eran programables mediante interruptores y paneles de enchufes de una manera que no lo habían sido sus predecesores.

Sin el uso de estas máquinas, los Aliados se habrían visto privados de la valiosa información de inteligencia que se obtenía al leer la gran cantidad de mensajes telegráficos cifrados de alto nivel entre el Alto Mando alemán (OKW) y sus mandos militares en toda la Europa ocupada. Los detalles de su existencia, diseño y uso se mantuvieron en secreto hasta bien entrada la década de 1970. Winston Churchill emitió personalmente una orden para su destrucción en pedazos no más grandes que la mano de un hombre, para mantener en secreto que los británicos eran capaces de descifrar cifrados Lorenz SZ (de máquinas de cifrado de flujo de rotor alemanas) durante la inminente Guerra Fría. Dos de las máquinas fueron transferidas al recién formado GCHQ y las demás fueron destruidas. Como resultado, las máquinas no fueron incluidas en muchas historias de la informática. [g] Una copia funcional reconstruida de una de las máquinas Colossus ahora se exhibe en Bletchley Park.

El ENIAC (Electronic Numerical Integrator and Computer) fue el primer ordenador electrónico programable construido en Estados Unidos. Aunque el ENIAC utilizó tecnología similar a la de los Colosos, era mucho más rápido y flexible y estaba completo en Turing. Al igual que los Colossi, un "programa" en el ENIAC estaba definido por los estados de sus cables de conexión e interruptores, muy lejos de las máquinas electrónicas con programas almacenados que vinieron después. Una vez que se escribía un programa, debía configurarse mecánicamente en la máquina con reinicio manual de enchufes e interruptores. Las programadoras de la ENIAC eran mujeres que se habían formado como matemáticas. [101]

Combinaba la alta velocidad de la electrónica con la capacidad de ser programado para muchos problemas complejos. Podía sumar o restar 5.000 veces por segundo, mil veces más rápido que cualquier otra máquina. También tenía módulos para multiplicar, dividir y raíz cuadrada. La memoria de alta velocidad estaba limitada a 20 palabras (equivalente a unos 80 bytes). Construida bajo la dirección de John Mauchly y J. Presper Eckert en la Universidad de Pensilvania, el desarrollo y la construcción de ENIAC duraron desde 1943 hasta su pleno funcionamiento a finales de 1945. La máquina era enorme, pesaba 30 toneladas y consumía 200 kilovatios de energía eléctrica y Contenía más de 18.000 tubos de vacío, 1.500 relés y cientos de miles de resistencias, condensadores e inductores. [102] Una de sus principales hazañas de ingeniería fue minimizar los efectos del desgaste de los tubos, que era un problema común en la confiabilidad de las máquinas en ese momento. La máquina estuvo en uso casi constante durante los siguientes diez años.

La base teórica de la computadora con programas almacenados fue propuesta por Alan Turing en su artículo de 1936 Sobre números computables . [64] Mientras Turing era un Princeton trabajando en su doctorado, John von Neumann llegó a conocerlo y quedó intrigado por su concepto de una máquina informática universal. [103]

Las primeras máquinas informáticas ejecutaban una secuencia establecida de pasos, conocida como " programa ", que podía modificarse cambiando las conexiones eléctricas mediante interruptores o un panel de conexiones (o tablero de enchufes ). Sin embargo, este proceso de "reprogramación" era a menudo difícil y requería mucho tiempo, lo que requería que los ingenieros crearan diagramas de flujo y reconectaran físicamente las máquinas. [104] Las computadoras con programas almacenados, por el contrario, fueron diseñadas para almacenar un conjunto de instrucciones (un programa ), en la memoria, generalmente la misma memoria que los datos almacenados.

Los inventores de ENIAC, John Mauchly y J. Presper Eckert, propusieron, en agosto de 1944, la construcción de una máquina llamada Computadora Automática Variable Discreta Electrónica ( EDVAC ) y el trabajo de diseño comenzó en la Escuela Moore de Ingeniería Eléctrica de la Universidad de Pensilvania , antes de la ENIAC estaba en pleno funcionamiento. El diseño implementó una serie de importantes mejoras arquitectónicas y lógicas concebidas durante la construcción del ENIAC, y una memoria de acceso en serie de alta velocidad . [105] Sin embargo, Eckert y Mauchly abandonaron el proyecto y su construcción fracasó.

En 1945 von Neumann visitó la Escuela Moore y escribió notas sobre lo que vio, que envió al proyecto. El enlace del ejército estadounidense allí los mecanografió y los hizo circular como primer borrador de un informe sobre el EDVAC . El borrador no mencionaba a Eckert y Mauchly y, a pesar de su naturaleza incompleta y de la cuestionable falta de atribución de las fuentes de algunas de las ideas, [54] la arquitectura informática que esbozaba llegó a ser conocida como la " arquitectura von Neumann ".

En 1945, Turing se unió al Laboratorio Nacional de Física del Reino Unido y comenzó a trabajar en el desarrollo de una computadora digital electrónica con programa almacenado. Su informe de finales de 1945, 'Calculadora electrónica propuesta', fue la primera especificación razonablemente detallada para un dispositivo de este tipo. Turing presentó un documento más detallado al Comité Ejecutivo del Laboratorio Nacional de Física (NPL) en marzo de 1946, dando el primer diseño sustancialmente completo de una computadora con programa almacenado , un dispositivo que se llamó Motor de Computación Automática (ACE).

Turing consideró que la velocidad y el tamaño de la memoria de la computadora eran elementos cruciales, [106] : p.4 por lo que propuso una memoria de alta velocidad de lo que hoy se llamaría 25 KB , a la que se accedía a una velocidad de 1 MHz . El ACE implementó llamadas a subrutinas , mientras que el EDVAC no, y el ACE también utilizó Instrucciones Abreviadas por Computadora, una de las primeras formas de lenguaje de programación .

La Manchester Baby (Small Scale Experimental Machine, SSEM) fue la primera computadora electrónica con programa almacenado del mundo . Fue construido en la Universidad Victoria de Manchester por Frederic C. Williams , Tom Kilburn y Geoff Tootill, y ejecutó su primer programa el 21 de junio de 1948. [107]

La máquina no estaba destinada a ser una computadora práctica, sino que fue diseñada como un banco de pruebas para el tubo Williams , el primer dispositivo de almacenamiento digital de acceso aleatorio . [108] Inventado por Freddie Williams y Tom Kilburn [109] [110] en la Universidad de Manchester en 1946 y 1947, era un tubo de rayos catódicos que utilizaba un efecto llamado emisión secundaria para almacenar temporalmente datos binarios electrónicos , y se utilizaba con éxito en varias de las primeras computadoras.

Descrito como pequeño y primitivo en una retrospectiva de 1998, el Baby fue la primera máquina funcional que contenía todos los elementos esenciales de una computadora electrónica moderna. [111] Tan pronto como demostró la viabilidad de su diseño, se inició un proyecto en la universidad para desarrollar el diseño en una computadora más utilizable, la Manchester Mark 1 . El Mark 1, a su vez, se convirtió rápidamente en el prototipo del Ferranti Mark 1 , el primer ordenador de uso general disponible comercialmente en el mundo. [112]

El Bebé tenía una longitud de palabra de 32 bits y una memoria de 32 palabras. Como fue diseñada para ser la computadora con programa almacenado más simple posible, las únicas operaciones aritméticas implementadas en el hardware fueron la resta y la negación ; otras operaciones aritméticas se implementaron en software. El primero de los tres programas escritos para la máquina encontró el divisor propio más alto de 2 18 (262,144), un cálculo que se sabía que llevaría mucho tiempo ejecutar (y así demostrar la confiabilidad de la computadora) al probar cada número entero de 2 18 − 1. hacia abajo, ya que la división se implementaba mediante restas repetidas del divisor. El programa constaba de 17 instrucciones y se ejecutó durante 52 minutos antes de llegar a la respuesta correcta de 131.072, después de que Baby hubiera realizado 3,5 millones de operaciones (para una velocidad efectiva de CPU de 1,1 kIPS ). Las sucesivas aproximaciones a la respuesta se mostraron como un patrón de puntos en el CRT de salida que reflejaba el patrón contenido en el tubo Williams utilizado para el almacenamiento.

El SSEM condujo al desarrollo del Manchester Mark 1 en la Universidad de Manchester. [113] El trabajo comenzó en agosto de 1948 y la primera versión estaba operativa en abril de 1949; un programa escrito para buscar números primos de Mersenne funcionó sin errores durante nueve horas en la noche del 16 al 17 de junio de 1949. La exitosa operación de la máquina fue ampliamente reportada en la prensa británica, que utilizó la frase "cerebro electrónico" para describirla a sus lectores.

La computadora es especialmente significativa históricamente debido a su inclusión pionera de registros de índice , una innovación que facilitó que un programa leyera secuencialmente una serie de palabras en la memoria. Treinta y cuatro patentes resultaron del desarrollo de la máquina, y muchas de las ideas detrás de su diseño se incorporaron en productos comerciales posteriores, como el IBM 701 y 702 , así como el Ferranti Mark 1. Los diseñadores jefe, Frederic C. Williams y Tom Kilburn , concluyeron a partir de sus experiencias con el Mark 1 que los ordenadores se utilizarían más en funciones científicas que en matemáticas puras. En 1951 comenzaron a trabajar en el desarrollo del Meg , el sucesor del Mark 1, que incluiría una unidad de punto flotante .

.jpg/440px-EDSAC_(19).jpg)

El otro candidato a ser el primer ordenador digital con programa almacenado reconociblemente moderno [114] fue el EDSAC , [115] diseñado y construido por Maurice Wilkes y su equipo en el Laboratorio de Matemáticas de la Universidad de Cambridge en Inglaterra en 1949. La máquina se inspiró en el primer borrador de un informe sobre el EDVAC de John von Neumann y fue una de las primeras computadoras electrónicas digitales con programa almacenado que funcionaron de manera útil . [h]

EDSAC ejecutó sus primeros programas el 6 de mayo de 1949, cuando calculó una tabla de cuadrados [118] y una lista de números primos . El EDSAC también sirvió como base para la primera computadora aplicada comercialmente, la LEO I , utilizada por una empresa de fabricación de alimentos. J. Lyons & Co. Ltd. EDSAC 1 se cerró finalmente el 11 de julio de 1958, habiendo sido reemplazado por EDSAC 2, que permaneció en uso hasta 1965. [119]

El "cerebro" [computadora] puede que algún día llegue a nuestro nivel [de la gente común] y nos ayude con nuestros cálculos de impuestos sobre la renta y contabilidad. Pero esto son especulaciones y hasta el momento no hay señales de ello.

— Periódico británico The Star en un artículo de junio de 1949 sobre la computadora EDSAC , mucho antes de la era de las computadoras personales. [120]

Los inventores de ENIAC, John Mauchly y J. Presper Eckert, propusieron la construcción del EDVAC en agosto de 1944, y el trabajo de diseño para el EDVAC comenzó en la Escuela Moore de Ingeniería Eléctrica de la Universidad de Pensilvania , antes de que el ENIAC estuviera en pleno funcionamiento. El diseño implementó una serie de importantes mejoras arquitectónicas y lógicas concebidas durante la construcción del ENIAC, y una memoria de acceso en serie de alta velocidad . [105] Sin embargo, Eckert y Mauchly abandonaron el proyecto y su construcción fracasó.

Finalmente fue entregado al Laboratorio de Investigación Balística del Ejército de los EE. UU. en el campo de pruebas de Aberdeen en agosto de 1949, pero debido a una serie de problemas, el ordenador no empezó a funcionar hasta 1951, y entonces sólo de forma limitada.

La primera computadora comercial fue la Ferranti Mark 1 , construida por Ferranti y entregada a la Universidad de Manchester en febrero de 1951. Estaba basada en la Manchester Mark 1 . Las principales mejoras con respecto al Manchester Mark 1 estaban en el tamaño del almacenamiento primario (usando tubos Williams de acceso aleatorio ), el almacenamiento secundario (usando un tambor magnético ), un multiplicador más rápido e instrucciones adicionales. El tiempo del ciclo básico era de 1,2 milisegundos y se podía completar una multiplicación en aproximadamente 2,16 milisegundos. El multiplicador utilizó casi una cuarta parte de los 4.050 tubos (válvulas) de vacío de la máquina. [121] La Universidad de Toronto compró una segunda máquina , antes de que el diseño fuera revisado y convertido en el Mark 1 Star . Al menos siete de estas últimas máquinas se entregaron entre 1953 y 1957, una de ellas a los laboratorios Shell de Ámsterdam. [122]

En octubre de 1947, los directores de J. Lyons & Company , una empresa de catering británica famosa por sus tiendas de té pero con un fuerte interés en las nuevas técnicas de gestión de oficinas, decidieron asumir un papel activo en la promoción del desarrollo comercial de las computadoras. La computadora LEO I (Oficina Electrónica de Lyon) entró en funcionamiento en abril de 1951 [123] y realizó el primer trabajo rutinario de computadora de oficina del mundo . El 17 de noviembre de 1951, la empresa J. Lyons inició la operación semanal de un trabajo de valoración de panadería en LEO, la primera aplicación empresarial que se puso en funcionamiento en una computadora con programa almacenado. [i]

En junio de 1951, la UNIVAC I (Computadora Automática Universal) fue entregada a la Oficina del Censo de Estados Unidos . Remington Rand finalmente vendió 46 máquinas a más de 1 millón de dólares cada una (11,3 millones de dólares en 2024). [124] UNIVAC fue la primera computadora "producida en masa". Usó 5.200 tubos de vacío y consumió125kW de potencia. Su almacenamiento principal eran líneas de retardo de mercurio de acceso en serie capaces de almacenar 1000 palabras de 11 dígitos decimales más signo (palabras de 72 bits).

En 1952, la Compagnie des Machines Bull lanzó la computadora Gamma 3 , que se convirtió en un gran éxito en Europa, vendiendo más de 1200 unidades y siendo la primera computadora producida en más de 1000 unidades. [125] El Gamma 3 tenía características innovadoras para su época, incluido un modo dual, conmutable por software, BCD y ALU binaria, así como una biblioteca de punto flotante cableada para computación científica. [125] En su configuración ET, la memoria del tambor Gamma 3 podía contener alrededor de 50.000 instrucciones para una capacidad de 16.384 palabras (alrededor de 100 kB), una gran cantidad para la época. [125]

En comparación con UNIVAC, IBM introdujo una computadora más pequeña y asequible en 1954 que resultó muy popular. [j] [127] El IBM 650 pesaba más900 kg , la fuente de alimentación adjunta pesaba alrededor1350 kg y ambos se guardaban en armarios separados de aproximadamente 1,5 × 0,9 × 1,8 metros . El sistema costó 500.000 dólares estadounidenses [128] (5,45 millones de dólares a partir de 2024) o podría alquilarse por 3.500 dólares estadounidenses al mes (40.000 dólares a partir de 2024). [124] Su memoria de batería era originalmente de 2.000 palabras de diez dígitos, y luego se amplió a 4.000 palabras. Limitaciones de memoria como ésta dominarían la programación durante décadas. Las instrucciones del programa se obtuvieron del tambor giratorio mientras se ejecutaba el código. La ejecución eficiente usando memoria de tambor fue proporcionada por una combinación de arquitectura de hardware (el formato de instrucción incluía la dirección de la siguiente instrucción) y software: el Programa de Ensamblaje Óptimo Simbólico , SOAP, [129] asignó instrucciones a las direcciones óptimas (en la medida de lo posible). mediante análisis estático del programa fuente). Por lo tanto, cuando era necesario, muchas instrucciones se ubicaban en la siguiente fila del tambor para ser leídas y se reducía el tiempo de espera adicional para la rotación del tambor.

En 1951, el científico británico Maurice Wilkes desarrolló el concepto de microprogramación a partir de la comprensión de que la unidad central de procesamiento de una computadora podía controlarse mediante un programa informático en miniatura, altamente especializado, en una ROM de alta velocidad . La microprogramación permite definir o ampliar el conjunto de instrucciones base mediante programas integrados (ahora llamados firmware o microcódigo ). [130] Este concepto simplificó enormemente el desarrollo de la CPU. Describió esto por primera vez en la Conferencia Inaugural de Computación de la Universidad de Manchester en 1951, luego lo publicó en forma ampliada en IEEE Spectrum en 1955. [ cita necesaria ]

Fue ampliamente utilizado en las CPU y unidades de punto flotante de mainframe y otras computadoras; se implementó por primera vez en EDSAC 2 , [131] que también utilizó múltiples "porciones de bits" idénticas para simplificar el diseño. Se utilizaron conjuntos de tubos intercambiables y reemplazables para cada bit del procesador. [k]

Las memorias de tambor magnético se desarrollaron para la Marina de los EE. UU. durante la Segunda Guerra Mundial y el trabajo continuó en Engineering Research Associates (ERA) en 1946 y 1947. ERA, entonces parte de Univac, incluyó una memoria de tambor en su 1103 , anunciada en febrero de 1953. La primera La computadora producida en masa, la IBM 650 , también anunciada en 1953, tenía alrededor de 8,5 kilobytes de memoria de tambor.

La memoria de núcleo magnético se patentó en 1949 [133] y su primer uso se demostró para la computadora Whirlwind en agosto de 1953. [134] La comercialización siguió rápidamente. El núcleo magnético se utilizó en los periféricos del IBM 702 entregado en julio de 1955, y posteriormente en el propio 702. El IBM 704 (1955) y el Ferranti Mercury (1957) utilizaron memoria de núcleo magnético. Pasó a dominar el campo hasta la década de 1970, cuando fue reemplazada por memorias semiconductoras. El núcleo magnético alcanzó su punto máximo en volumen alrededor de 1975 y posteriormente disminuyó en uso y participación de mercado. [135]

Todavía en 1980, las máquinas PDP-11/45 que usaban memoria principal de núcleo magnético y tambores para intercambio todavía estaban en uso en muchos de los sitios UNIX originales.

El transistor bipolar se inventó en 1947. A partir de 1955, los transistores reemplazaron a los tubos de vacío en los diseños de computadoras, [137] dando lugar a la "segunda generación" de computadoras. En comparación con las válvulas de vacío, los transistores tienen muchas ventajas: son más pequeños y requieren menos energía que las válvulas de vacío, por lo que desprenden menos calor. Los transistores de unión de silicio eran mucho más fiables que los tubos de vacío y tenían una vida útil más larga. Las computadoras transistorizadas podrían contener decenas de miles de circuitos lógicos binarios en un espacio relativamente compacto. Los transistores redujeron en gran medida el tamaño, el costo inicial y el costo operativo de las computadoras . Normalmente, las computadoras de segunda generación estaban compuestas por una gran cantidad de placas de circuito impreso , como el Sistema Modular Estándar de IBM , [138] cada una con una a cuatro puertas lógicas o flip-flops .

En la Universidad de Manchester , un equipo bajo el liderazgo de Tom Kilburn diseñó y construyó una máquina utilizando transistores recientemente desarrollados en lugar de válvulas. Inicialmente los únicos dispositivos disponibles eran transistores de contacto puntual de germanio , menos fiables que las válvulas que reemplazaban pero que consumían mucha menos energía. [139] Su primera computadora transistorizada , y la primera en el mundo, estuvo operativa en 1953 , [140] y una segunda versión se completó allí en abril de 1955. [140] La versión de 1955 utilizó 200 transistores, 1300 diodos de estado sólido , y tenía un consumo de energía de 150 vatios. Sin embargo, la máquina hizo uso de válvulas para generar sus formas de onda de reloj de 125 kHz y en los circuitos para leer y escribir en su memoria de tambor magnético, por lo que no fue la primera computadora completamente transistorizada.

Esa distinción corresponde al Harwell CADET de 1955, [141] construido por la división de electrónica del Atomic Energy Research Establishment de Harwell . El diseño presentaba un almacén de memoria de tambor magnético de 64 kilobytes con múltiples cabezales móviles que había sido diseñado en el Laboratorio Nacional de Física del Reino Unido . En 1953, este equipo tenía circuitos de transistores funcionando para leer y escribir en un tambor magnético más pequeño del Royal Radar Establishment . La máquina utilizó una velocidad de reloj baja de solo 58 kHz para evitar tener que usar válvulas para generar las formas de onda del reloj. [142] [141]

CADET utilizó transistores de contacto de 324 puntos proporcionados por la empresa británica Standard Telephones and Cables ; Se utilizaron 76 transistores de unión para los amplificadores de la primera etapa para la lectura de datos del tambor, ya que los transistores de contacto puntual eran demasiado ruidosos. Desde agosto de 1956, CADET ofrecía un servicio informático regular, durante el cual a menudo ejecutaba ejecuciones informáticas continuas de 80 horas o más. [143] [144] Los problemas con la confiabilidad de los primeros lotes de transistores de unión aleada y de contacto puntual significaron que el tiempo medio de la máquina entre fallas era de aproximadamente 90 minutos, pero esto mejoró una vez que los transistores de unión bipolar más confiables estuvieron disponibles. [145]

El diseño de la computadora de transistores de la Universidad de Manchester fue adoptado por la empresa de ingeniería local Metropolitan-Vickers en su Metrovick 950 , la primera computadora de transistores comercial del mundo. [146] Se construyeron seis Metrovick 950, el primero completado en 1956. Se implementaron con éxito en varios departamentos de la empresa y estuvieron en uso durante unos cinco años. [140] Una computadora de segunda generación, la IBM 1401 , capturó aproximadamente un tercio del mercado mundial. IBM instaló más de diez mil 1401 entre 1960 y 1964.

La electrónica transistorizada mejoró no sólo la CPU (Unidad Central de Procesamiento), sino también los dispositivos periféricos . Las unidades de almacenamiento de datos en disco de segunda generación podían almacenar decenas de millones de letras y dígitos. Junto a las unidades de almacenamiento en disco fijo , conectadas a la CPU mediante transmisión de datos de alta velocidad, había unidades de almacenamiento de datos en disco extraíbles. Un paquete de discos extraíbles se puede cambiar fácilmente por otro paquete en unos segundos. Aunque la capacidad de los discos extraíbles es menor que la de los discos fijos, su intercambiabilidad garantiza una cantidad casi ilimitada de datos al alcance de la mano. La cinta magnética proporcionó capacidad de archivo para estos datos, a un costo menor que el disco.

Muchas CPU de segunda generación delegaron las comunicaciones de los dispositivos periféricos a un procesador secundario. Por ejemplo, mientras el procesador de comunicaciones controlaba la lectura y perforación de tarjetas , la CPU principal ejecutaba cálculos e instrucciones de rama binaria . Un bus de datos transportaría datos entre la CPU principal y la memoria central a la velocidad del ciclo de recuperación-ejecución de la CPU , y otros buses de datos normalmente servirían a los dispositivos periféricos. En el PDP-1 , el tiempo de ciclo de la memoria central era de 5 microsegundos; en consecuencia, la mayoría de las instrucciones aritméticas tardaron 10 microsegundos (100.000 operaciones por segundo) porque la mayoría de las operaciones requirieron al menos dos ciclos de memoria; uno para la instrucción, otro para la búsqueda de datos del operando .

Durante la segunda generación, las unidades terminales remotas (a menudo en forma de teleimpresoras como Friden Flexowriter ) experimentaron un uso mucho mayor. [l] Las conexiones telefónicas proporcionaron suficiente velocidad para los primeros terminales remotos y permitieron cientos de kilómetros de separación entre los terminales remotos y el centro de computación. Con el tiempo, estas redes informáticas independientes se generalizarían en una red de redes interconectadas : Internet. [metro]

A principios de la década de 1960 se produjo la llegada de la supercomputación . El Atlas fue un desarrollo conjunto entre la Universidad de Manchester , Ferranti y Plessey , y se instaló por primera vez en la Universidad de Manchester y se puso en servicio oficialmente en 1962 como una de las primeras supercomputadoras del mundo , considerada la computadora más poderosa del mundo en ese momento. . [149] Se dijo que cada vez que Atlas se desconectaba, se perdía la mitad de la capacidad informática del Reino Unido. [150] Era una máquina de segunda generación, que utilizaba transistores de germanio discretos . Atlas también fue pionero en Atlas Supervisor , "considerado por muchos como el primer sistema operativo moderno reconocible ". [151]

En los EE. UU., Seymour Cray diseñó una serie de computadoras en Control Data Corporation (CDC) para utilizar diseños innovadores y paralelismo para lograr un rendimiento computacional máximo superior. [152] El CDC 6600 , lanzado en 1964, generalmente se considera el primer superordenador. [153] [154] El CDC 6600 superó a su predecesor, el IBM 7030 Stretch , por aproximadamente un factor de 3. Con un rendimiento de aproximadamente 1 megaFLOPS , el CDC 6600 fue la computadora más rápida del mundo desde 1964 hasta 1969, cuando renunció a ese estado. a su sucesor, el CDC 7600 .

La "tercera generación" de computadoras electrónicas digitales utilizó chips de circuitos integrados (CI) como base de su lógica.

La idea de un circuito integrado fue concebida por un científico de radar que trabaja para el Royal Radar Establishment del Ministerio de Defensa , Geoffrey WA Dummer .

Los primeros circuitos integrados en funcionamiento fueron inventados por Jack Kilby en Texas Instruments y Robert Noyce en Fairchild Semiconductor . [155] Kilby registró sus ideas iniciales sobre el circuito integrado en julio de 1958, demostrando con éxito el primer ejemplo integrado funcional el 12 de septiembre de 1958. [156] La invención de Kilby fue un circuito integrado híbrido (CI híbrido). [157] Tenía conexiones de cables externas, lo que dificultaba la producción en masa. [158]

A Noyce se le ocurrió su propia idea de un circuito integrado medio año después de Kilby. [159] La invención de Noyce fue un chip de circuito integrado (IC) monolítico . [160] [158] Su chip resolvió muchos problemas prácticos que Kilby no había resuelto. Producido en Fairchild Semiconductor, estaba hecho de silicio , mientras que el chip de Kilby estaba hecho de germanio . La base del circuito integrado monolítico de Noyce fue el proceso plano de Fairchild , que permitió diseñar circuitos integrados utilizando los mismos principios que los de los circuitos impresos . El proceso planar fue desarrollado por el colega de Noyce, Jean Hoerni , a principios de 1959, basándose en el trabajo de Mohamed M. Atalla sobre la pasivación de superficies semiconductoras mediante dióxido de silicio en los Laboratorios Bell a finales de los años cincuenta. [161] [162] [163]

Las computadoras de tercera generación (circuitos integrados) aparecieron por primera vez a principios de la década de 1960 en computadoras desarrolladas para fines gubernamentales y luego en computadoras comerciales a partir de mediados de la década de 1960. La primera computadora con circuitos integrados de silicio fue la Apollo Guidance Computer o AGC. [164] Aunque no fue la computadora más poderosa de su tiempo, las limitaciones extremas de tamaño, masa y potencia de la nave espacial Apolo requirieron que el AGC fuera mucho más pequeño y denso que cualquier computadora anterior, con un peso de solo 70 libras (32 kg). ). Cada misión de aterrizaje lunar llevaba dos AGC, uno en cada uno de los módulos de comando y de ascenso lunar.

El MOSFET (transistor de efecto de campo semiconductor de óxido metálico, o transistor MOS) fue inventado por Mohamed M. Atalla y Dawon Kahng en Bell Labs en 1959. [165] Además del procesamiento de datos, el MOSFET permitió el uso práctico de MOS transistores como elementos de almacenamiento de celdas de memoria , una función que anteriormente cumplían los núcleos magnéticos . La memoria semiconductora , también conocida como memoria MOS , era más barata y consumía menos energía que la memoria de núcleo magnético . [166] La memoria de acceso aleatorio (RAM) MOS , en forma de RAM estática (SRAM), fue desarrollada por John Schmidt en Fairchild Semiconductor en 1964. [166] [167] En 1966, Robert Dennard en IBM Thomas J. El Centro de Investigación Watson desarrolló la RAM dinámica MOS (DRAM). [168] En 1967, Dawon Kahng y Simon Sze en Bell Labs desarrollaron el MOSFET de puerta flotante , la base para la memoria no volátil MOS como EPROM , EEPROM y memoria flash . [169] [170]

La "cuarta generación" de computadoras electrónicas digitales utilizó microprocesadores como base de su lógica. El microprocesador tiene su origen en el chip de circuito integrado MOS (MOS IC). [171] Debido al rápido escalamiento de MOSFET , los chips MOS IC aumentaron rápidamente en complejidad a un ritmo predicho por la ley de Moore , lo que llevó a la integración a gran escala (LSI) con cientos de transistores en un solo chip MOS a fines de la década de 1960. La aplicación de los chips MOS LSI a la informática fue la base de los primeros microprocesadores, cuando los ingenieros comenzaron a reconocer que un solo chip MOS LSI podía contener un procesador de computadora completo. [171]

El tema de exactamente qué dispositivo fue el primer microprocesador es polémico, en parte debido a la falta de acuerdo sobre la definición exacta del término "microprocesador". Los primeros microprocesadores multichip fueron los Four-Phase Systems AL-1 en 1969 y Garrett AiResearch MP944 en 1970, desarrollados con múltiples chips MOS LSI. [171] El primer microprocesador de un solo chip fue el Intel 4004 , [172] desarrollado en un solo chip PMOS LSI. [171] Fue diseñado y realizado por Ted Hoff , Federico Faggin , Masatoshi Shima y Stanley Mazor en Intel , y lanzado en 1971. [n] Tadashi Sasaki y Masatoshi Shima en Busicom , un fabricante de calculadoras, tuvieron la idea inicial de que la CPU podría ser un único chip MOS LSI, suministrado por Intel. [174] [172]

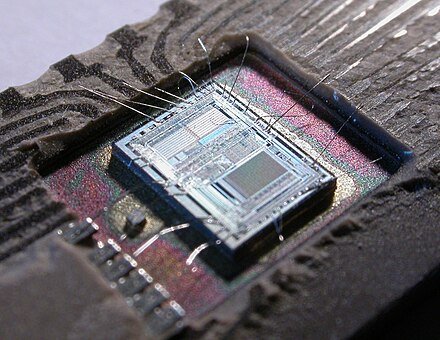

Si bien los primeros circuitos integrados de microprocesadores contenían literalmente sólo el procesador, es decir, la unidad central de procesamiento, de una computadora, su desarrollo progresivo condujo naturalmente a chips que contenían la mayoría o la totalidad de las partes electrónicas internas de una computadora. El circuito integrado de la imagen de la derecha, por ejemplo, un Intel 8742, es un microcontrolador de 8 bits que incluye una CPU que funciona a 12 MHz, 128 bytes de RAM , 2048 bytes de EPROM y E/S en el mismo chip. .

Durante la década de 1960 hubo una considerable superposición entre las tecnologías de segunda y tercera generación. [o] IBM implementó sus módulos IBM Solid Logic Technology en circuitos híbridos para IBM System/360 en 1964. Todavía en 1975, Sperry Univac continuó la fabricación de máquinas de segunda generación como la UNIVAC 494. Los grandes sistemas de Burroughs como Las B5000 eran máquinas apilables , lo que permitía una programación más sencilla. Estos autómatas pushdown también se implementaron posteriormente en minicomputadoras y microprocesadores, lo que influyó en el diseño del lenguaje de programación. Las minicomputadoras sirvieron como centros informáticos de bajo costo para la industria, las empresas y las universidades. [175] Se hizo posible simular circuitos analógicos con el programa de simulación con énfasis en circuitos integrados , o SPICE (1971) en minicomputadoras, uno de los programas para la automatización del diseño electrónico ( EDA ). El microprocesador propició el desarrollo de las microcomputadoras , pequeñas computadoras de bajo costo que podían ser propiedad de particulares y pequeñas empresas. Las microcomputadoras, las primeras de las cuales aparecieron en la década de 1970, se volvieron omnipresentes en la década de 1980 y después.

Si bien es un tema de debate qué producto específico se considera el primer sistema de microcomputadora, uno de los primeros es Micral N ( François Gernelle , André Truong ) de R2E, lanzado "a principios de 1973" utilizando el Intel 8008. [176] El primer kit de microcomputadora disponible comercialmente Fue el Altair 8800 basado en Intel 8080 , que fue anunciado en el artículo de portada de enero de 1975 de Popular Electronics . Sin embargo, el Altair 8800 era un sistema extremadamente limitado en sus etapas iniciales, con solo 256 bytes de DRAM en su paquete inicial y sin entrada-salida excepto sus interruptores de palanca y su pantalla de registro LED. A pesar de esto, al principio fue sorprendentemente popular, con varios cientos de ventas en el primer año, y la demanda superó rápidamente a la oferta. Varios de los primeros proveedores externos, como Cromemco y Processor Technology, pronto comenzaron a suministrar hardware de bus S-100 adicional para el Altair 8800.

En abril de 1975, en la Feria de Hannover , Olivetti presentó el P6060 , el primer sistema informático personal completo y premontado del mundo. La unidad central de procesamiento constaba de dos tarjetas, denominadas en código PUCE1 y PUCE2, y, a diferencia de la mayoría de las otras computadoras personales, estaba construida con componentes TTL en lugar de un microprocesador. Tenía una o dos unidades de disquete de 8", una pantalla de plasma de 32 caracteres , una impresora térmica gráfica de 80 columnas , 48 Kbytes de RAM y lenguaje BASIC . Pesaba 40 kg (88 lb). Como sistema completo, este era un paso significativo con respecto al Altair, aunque nunca logró el mismo éxito: competía con un producto similar de IBM que tenía una unidad de disquete externa.

De 1975 a 1977, la mayoría de las microcomputadoras, como la MOS Technology KIM-1 , la Altair 8800 y algunas versiones del Apple I , se vendieron como kits para aficionados al bricolaje. Los sistemas preensamblados no ganaron mucho terreno hasta 1977, con la introducción del Apple II , el Tandy TRS-80 , los primeros ordenadores SWTPC y el Commodore PET . La informática ha evolucionado con las arquitecturas de microcomputadoras, con características añadidas por sus hermanos más grandes, que ahora dominan la mayoría de los segmentos del mercado.

Tim Berners-Lee y Robert Cailliau en el CERN utilizaron una computadora NeXT y sus herramientas y bibliotecas de desarrollo orientadas a objetos para desarrollar el primer software de servidor web del mundo , CERN httpd , y también para escribir el primer navegador web , WorldWideWeb .

Sistemas tan complicados como las computadoras requieren una confiabilidad muy alta . ENIAC permaneció en funcionamiento continuo desde 1947 hasta 1955, durante ocho años antes de ser cerrado. Aunque un tubo de vacío podría fallar, sería reemplazado sin provocar la caída del sistema. Con la simple estrategia de no cerrar nunca ENIAC, las fallas se redujeron drásticamente. Las computadoras de defensa aérea SAGE con tubos de vacío se volvieron notablemente confiables: instaladas en pares, uno fuera de línea, los tubos que probablemente fallaban lo hacían cuando la computadora se hacía funcionar intencionalmente a potencia reducida para encontrarlos. Los discos duros conectables en caliente , al igual que los tubos de vacío conectables en caliente de antaño, continúan la tradición de reparación durante el funcionamiento continuo. Las memorias semiconductoras habitualmente no presentan errores cuando funcionan, aunque sistemas operativos como Unix han empleado pruebas de memoria en el inicio para detectar fallas en el hardware. Hoy en día, el requisito de un rendimiento confiable se vuelve aún más estricto cuando las granjas de servidores son la plataforma de entrega. [177] Google ha logrado esto mediante el uso de software tolerante a fallas para recuperarse de fallas de hardware, e incluso está trabajando en el concepto de reemplazar granjas de servidores enteras sobre la marcha, durante un evento de servicio. [178] [179]

En el siglo XXI, las CPU multinúcleo estuvieron disponibles comercialmente. [180] La memoria direccionable por contenido (CAM) [181] se ha vuelto lo suficientemente económica como para usarse en redes y se usa con frecuencia para la memoria caché en el chip en los microprocesadores modernos, aunque ningún sistema informático ha implementado todavía CAM de hardware para su uso en programación. idiomas. Actualmente, las CAM (o matrices asociativas) en el software son específicas del lenguaje de programación. Los conjuntos de celdas de memoria de semiconductores son estructuras muy regulares y los fabricantes prueban sus procesos en ellas; esto permite reducciones de precios en productos de memoria. Durante la década de 1980, las puertas lógicas CMOS se convirtieron en dispositivos que podían fabricarse tan rápidos como otros tipos de circuitos; Por lo tanto, el consumo de energía de la computadora podría reducirse drásticamente. A diferencia del consumo de corriente continuo de una puerta basada en otros tipos lógicos, una puerta CMOS solo consume una cantidad significativa de corriente, excepto las fugas, durante la "transición" entre estados lógicos. [182]

Los circuitos CMOS han permitido que la informática se convierta en un bien que ahora es omnipresente, integrado en muchas formas , desde tarjetas de felicitación y teléfonos hasta satélites . La potencia de diseño térmico que se disipa durante la operación se ha vuelto tan esencial como la velocidad de operación de cálculo. En 2006, los servidores consumieron el 1,5% del presupuesto energético total de EE.UU. [183] Se esperaba que el consumo de energía de los centros de datos informáticos se duplicara hasta el 3% del consumo mundial en 2011. El SoC (sistema en un chip) ha comprimido aún más de el circuito integrado en un solo chip; Los SoC están permitiendo que teléfonos y PC converjan en dispositivos móviles inalámbricos de mano únicos . [184]

La computación cuántica es una tecnología emergente en el campo de la informática. MIT Technology Review informó el 10 de noviembre de 2017 que IBM había creado una computadora de 50 qubit ; actualmente su estado cuántico dura 50 microsegundos. [185] Los investigadores de Google han podido ampliar el límite de tiempo de 50 microsegundos, como se informó el 14 de julio de 2021 en Nature ; [186] la estabilidad se ha ampliado 100 veces al distribuir un único qubit lógico en cadenas de qubits de datos para la corrección de errores cuánticos . [186] Physical Review X informó sobre una técnica para la 'detección de puerta única como método de lectura viable para qubits de espín' (un estado de espín singlete-triplete en silicio) el 26 de noviembre de 2018. [187] Un equipo de Google logró operar su chip modulador de pulsos de RF a 3 Kelvin, que simplifica la criogenia de su computadora de 72 qubits, que está configurada para funcionar a 0,3 Kelvin; pero aún falta llevar el circuito de lectura y otro controlador a la criogenia. [188] [p] Ver: Supremacía cuántica [190] [191] Los sistemas qubit de silicio han demostrado entrelazamiento a distancias no locales . [192]

El hardware informático y su software se han convertido incluso en una metáfora del funcionamiento del universo. [193]

Una indicación de la rapidez del desarrollo de este campo puede inferirse de la historia del artículo fundamental de 1947 de Burks, Goldstine y von Neumann. [194] Cuando alguien tuvo tiempo de escribir algo, ya estaba obsoleto. Después de 1945, otros leyeron el primer borrador de un informe sobre el EDVAC de John von Neumann e inmediatamente comenzaron a implementar sus propios sistemas. Hasta el día de hoy, el rápido ritmo de desarrollo ha continuado en todo el mundo. [q] [r]

los cálculos se utilizaban en Irak para sistemas de contabilidad primitivos ya en 3200-3000 a. C., con sistemas de representación de conteo específicos de productos básicos. La contabilidad equilibrada estaba en uso entre el 3000 y el 2350 a. C., y un sistema numérico sexagesimal estaba en uso entre el 2350 y el 2000 a.

{{citation}}: Mantenimiento CS1: nombres numéricos: lista de autores ( enlace )