En estadística y teoría de la probabilidad , la mediana es el valor que separa la mitad superior de la mitad inferior de una muestra de datos , una población o una distribución de probabilidad . Para un conjunto de datos , se puede considerar como el valor "medio". La característica básica de la mediana al describir datos comparados con la media (a menudo descrita simplemente como "promedio") es que no está sesgada por una pequeña proporción de valores extremadamente grandes o pequeños y, por lo tanto, proporciona una mejor representación del centro. El ingreso mediano , por ejemplo, puede ser una mejor manera de describir el centro de la distribución del ingreso porque los aumentos en los ingresos más altos por sí solos no tienen efecto sobre la mediana. Por esta razón, la mediana es de importancia central en las estadísticas sólidas .

La mediana de una lista finita de números es el número "medio", cuando esos números se enumeran en orden de menor a mayor.

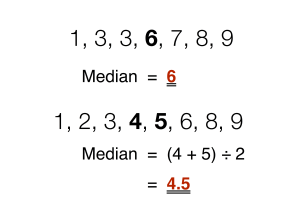

Si el conjunto de datos tiene un número impar de observaciones, se selecciona la del medio. Por ejemplo, la siguiente lista de siete números,

tiene la mediana de 6 , que es el cuarto valor.

Si el conjunto de datos tiene un número par de observaciones, no existe un valor medio distinto y la mediana generalmente se define como la media aritmética de los dos valores medios. [1] [2] Por ejemplo, este conjunto de datos de 8 números

tiene un valor mediano de 4,5 , es decir . (En términos más técnicos, esto interpreta la mediana como el rango medio completamente recortado ).

En general, con esta convención, la mediana se puede definir de la siguiente manera: Para un conjunto de datos de elementos, ordenados de menor a mayor,

Formalmente, una mediana de una población es cualquier valor tal que al menos la mitad de la población sea menor o igual a la mediana propuesta y al menos la mitad sea mayor o igual a la mediana propuesta. Como se vio anteriormente, las medianas pueden no ser únicas. Si cada conjunto contiene más de la mitad de la población, entonces parte de la población es exactamente igual a la mediana única.

La mediana está bien definida para cualquier dato ordenado (unidimensional) y es independiente de cualquier métrica de distancia . Por lo tanto, la mediana se puede aplicar a las clases escolares que están clasificadas pero no numéricamente (por ejemplo, calcular una calificación mediana cuando los puntajes de los exámenes de los estudiantes se califican de F a A), aunque el resultado podría estar a medio camino entre clases si hay un número par de clases. . (Para clases de números impares, se determina una clase específica como mediana).

Una mediana geométrica , por otra parte, se define en cualquier número de dimensiones. Un concepto relacionado, en el que se fuerza que el resultado corresponda a un miembro de la muestra, es el medoide .

No existe una notación estándar ampliamente aceptada para la mediana, pero algunos autores representan la mediana de una variable x como med( x ), x͂ , [3] como μ 1/2 , [1] o como M . [3] [4] En cualquiera de estos casos, el uso de estos u otros símbolos para la mediana debe definirse explícitamente cuando se introducen.

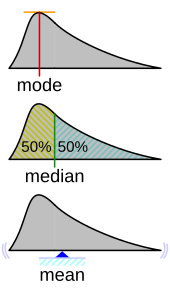

La mediana es un caso especial de otras formas de resumir los valores típicos asociados con una distribución estadística : es el segundo cuartil , el quinto decil y el percentil 50 .

La mediana se puede utilizar como medida de ubicación cuando se otorga poca importancia a los valores extremos, normalmente porque una distribución está sesgada , no se conocen los valores extremos o los valores atípicos no son dignos de confianza, es decir, pueden ser errores de medición/transcripción.

Por ejemplo, considere el conjunto múltiple

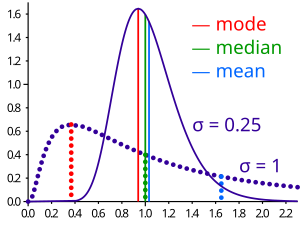

La mediana es 2 en este caso, al igual que la moda , y podría verse como una mejor indicación del centro que la media aritmética de 4, que es mayor que todos los valores menos uno. Sin embargo, la relación empírica ampliamente citada de que la media se desplaza "más hacia la cola" de una distribución que la mediana no es generalmente cierta. A lo sumo se puede decir que las dos estadísticas no pueden estar "demasiado alejadas"; ver § Desigualdad relativa a medias y medianas a continuación. [5]

Como la mediana se basa en los datos intermedios de un conjunto, no es necesario conocer el valor de los resultados extremos para calcularla. Por ejemplo, en una prueba de psicología que investiga el tiempo necesario para resolver un problema, si un pequeño número de personas no logró resolver el problema en el tiempo dado, aún se puede calcular una mediana. [6]

Debido a que la mediana es fácil de entender y calcular, además de ser una aproximación sólida a la media , la mediana es una estadística de resumen popular en la estadística descriptiva . En este contexto, existen varias opciones para una medida de variabilidad : el rango , el rango intercuartil , la desviación absoluta media y la desviación absoluta mediana .

Para fines prácticos, a menudo se comparan diferentes medidas de ubicación y dispersión en función de qué tan bien se pueden estimar los valores poblacionales correspondientes a partir de una muestra de datos. La mediana, estimada utilizando la mediana muestral, tiene buenas propiedades a este respecto. Si bien no suele ser óptimo si se supone una distribución poblacional determinada, sus propiedades siempre son razonablemente buenas. Por ejemplo, una comparación de la eficiencia de los estimadores candidatos muestra que la media muestral es más eficiente estadísticamente cuando (y sólo cuando) los datos no están contaminados por datos de distribuciones de colas pesadas o de mezclas de distribuciones. [ cita necesaria ] Incluso entonces, la mediana tiene una eficiencia del 64% en comparación con la media de varianza mínima (para muestras normales grandes), es decir, la varianza de la mediana será ~ 50% mayor que la varianza de la media. [7] [8]

Para cualquier distribución de probabilidad de valor real con función de distribución acumulativa F , una mediana se define como cualquier número real m que satisfaga las desigualdades

Una redacción equivalente utiliza una variable aleatoria X distribuida según F :

Tenga en cuenta que esta definición no requiere que X tenga una distribución absolutamente continua (que tiene una función de densidad de probabilidad f ), ni requiere una discreta . En el primer caso, las desigualdades pueden elevarse a igualdad: una mediana satisface

Cualquier distribución de probabilidad en el conjunto de números reales tiene al menos una mediana, pero en casos patológicos puede haber más de una mediana: si F es constante 1/2 en un intervalo (de modo que f = 0 allí), entonces cualquier valor de esa el intervalo es una mediana.

Las medianas de ciertos tipos de distribuciones se pueden calcular fácilmente a partir de sus parámetros; además, existen incluso para algunas distribuciones que carecen de una media bien definida, como la distribución de Cauchy :

El error absoluto medio de una variable real c con respecto a la variable aleatoria X es

Siempre que la distribución de probabilidad de X sea tal que exista la expectativa anterior, entonces m es una mediana de X si y solo si m es un minimizador del error absoluto medio con respecto a X. [11] En particular, si m es una mediana muestral, entonces minimiza la media aritmética de las desviaciones absolutas. [12] Tenga en cuenta, sin embargo, que en los casos en que la muestra contiene un número par de elementos, este minimizador no es único.

De manera más general, una mediana se define como un mínimo de

como se analiza más adelante en la sección sobre medianas multivariadas (específicamente, la mediana espacial ).

Esta definición de la mediana basada en optimización es útil en el análisis de datos estadísticos, por ejemplo, en la agrupación de k -medianas .

Si la distribución tiene varianza finita, entonces la distancia entre la mediana y la media está limitada por una desviación estándar .

Esta limitación fue demostrada por Book y Sher en 1979 para muestras discretas, [13] y más generalmente por Page y Murty en 1982. [14] En un comentario sobre una prueba posterior de O'Cinneide, [15] Mallows en 1991 presentó una prueba compacta que utiliza la desigualdad de Jensen dos veces, [16] de la siguiente manera. Usando |·| para el valor absoluto tenemos

La primera y la tercera desigualdad provienen de la desigualdad de Jensen aplicada a la función de valor absoluto y a la función cuadrada, ambas convexas. La segunda desigualdad proviene del hecho de que una mediana minimiza la función de desviación absoluta .

La prueba de Mallows se puede generalizar para obtener una versión multivariada de la desigualdad [17] simplemente reemplazando el valor absoluto con una norma :

donde m es una mediana espacial , es decir, un minimizador de la función. La mediana espacial es única cuando la dimensión del conjunto de datos es dos o más. [18] [19]

Una prueba alternativa utiliza la desigualdad unilateral de Chebyshev; aparece en una desigualdad sobre los parámetros de ubicación y escala . Esta fórmula también se deriva directamente de la desigualdad de Cantelli . [20]

Para el caso de distribuciones unimodales , se puede lograr un límite más definido en la distancia entre la mediana y la media:

Una relación similar se cumple entre la mediana y la moda:

La desigualdad de Jensen establece que para cualquier variable aleatoria X con una expectativa finita E [ X ] y para cualquier función convexa f

Esta desigualdad también se generaliza a la mediana. Decimos que una función f : R → R es una función C si, para cualquier t ,

es un intervalo cerrado (que permite los casos degenerados de un solo punto o un conjunto vacío ). Toda función convexa es una función C, pero lo contrario no se cumple. Si f es una función C, entonces

Si las medianas no son únicas, la afirmación es válida para la suprema correspondiente. [22]

Aunque la clasificación por comparación de n elementos requiere Ω ( n log n ) operaciones, los algoritmos de selección pueden calcular el k -ésimo más pequeño de n elementos con solo Θ( n ) operaciones. Esto incluye la mediana, que es lanorte/2estadístico de orden medio (o para un número par de muestras, la media aritmética de los dos estadísticos de orden medio). [23]

Los algoritmos de selección todavía tienen la desventaja de requerir memoria Ω( n ) , es decir, necesitan tener la muestra completa (o una porción de ella de tamaño lineal) en la memoria. Debido a que esto, así como el requisito de tiempo lineal, puede resultar prohibitivo, se han desarrollado varios procedimientos de estimación para la mediana. Una simple es la regla de la mediana de tres, que estima la mediana como la mediana de una submuestra de tres elementos; esto se usa comúnmente como una subrutina en el algoritmo de clasificación rápida , que utiliza una estimación de la mediana de su entrada. Un estimador más robusto es el noveno de Tukey , que es la mediana de tres reglas aplicadas con recursividad limitada: [24] si A es la muestra dispuesta como una matriz , y

entonces

La mediana es un estimador de la mediana que requiere tiempo lineal pero memoria sublineal, operando en un solo paso sobre la muestra. [25]

Laplace determinó las distribuciones tanto de la media muestral como de la mediana muestral . [26] La distribución de la mediana muestral de una población con una función de densidad es asintóticamente normal con media y varianza [27]

donde es la mediana y es el tamaño de la muestra:

A continuación se presenta una prueba moderna. El resultado de Laplace se entiende ahora como un caso especial de distribución asintótica de cuantiles arbitrarios .

Para muestras normales, la densidad es , por lo tanto, para muestras grandes, la varianza de la mediana es igual a [7] (consulte también la sección #Eficiencia a continuación).

Tomamos el tamaño de la muestra como un número impar y asumimos que nuestra variable es continua; La fórmula para el caso de variables discretas se proporciona a continuación en § Densidad local empírica. La muestra se puede resumir como "por debajo de la mediana", "en la mediana" y "por encima de la mediana", lo que corresponde a una distribución trinomial con probabilidades y . Para una variable continua, la probabilidad de que múltiples valores de muestra sean exactamente iguales a la mediana es 0, por lo que se puede calcular la densidad en el punto directamente a partir de la distribución trinomial:

Ahora presentamos la función beta. Para argumentos enteros y , esto se puede expresar como . Además, recuerda que . El uso de estas relaciones y el establecimiento de ambos y iguales a permite que la última expresión se escriba como

Por tanto, la función de densidad de la mediana es una distribución beta simétrica impulsada por . Su media, como era de esperar, es 0,5 y su varianza es . Según la regla de la cadena , la varianza correspondiente de la mediana muestral es

Los 2 adicionales son insignificantes en el límite .

En la práctica, las funciones y funciones anteriores a menudo no se conocen ni se asumen. Sin embargo, pueden estimarse a partir de una distribución de frecuencias observada. En esta sección damos un ejemplo. Considere la siguiente tabla, que representa una muestra de 3800 observaciones (de valores discretos):

Debido a que las observaciones tienen valores discretos, construir la distribución exacta de la mediana no es una traducción inmediata de la expresión anterior para ; uno puede (y normalmente tiene) tener múltiples instancias de la mediana en su muestra. Entonces debemos resumir todas estas posibilidades:

Aquí, i es el número de puntos estrictamente menor que la mediana y k el número estrictamente mayor.

Utilizando estos preliminares, es posible investigar el efecto del tamaño de la muestra sobre los errores estándar de la media y la mediana. La media observada es 3,16, la mediana bruta observada es 3 y la mediana interpolada observada es 3,174. La siguiente tabla ofrece algunas estadísticas comparativas.

El valor esperado de la mediana cae ligeramente a medida que aumenta el tamaño de la muestra mientras que, como era de esperar, los errores estándar tanto de la mediana como de la media son proporcionales a la raíz cuadrada inversa del tamaño de la muestra. La aproximación asintótica peca de cautelosa al sobreestimar el error estándar.

El valor de —el valor asintótico de dónde está la mediana poblacional— ha sido estudiado por varios autores. El método jackknife estándar de "eliminar uno" produce resultados inconsistentes . [28] Se ha demostrado que una alternativa, el método "eliminar k", donde crece con el tamaño de la muestra es asintóticamente consistente. [29] Este método puede resultar costoso desde el punto de vista computacional para grandes conjuntos de datos. Se sabe que una estimación bootstrap es consistente, [30] pero converge muy lentamente ( orden de ). [31] Se han propuesto otros métodos, pero su comportamiento puede diferir entre muestras grandes y pequeñas. [32]

La eficiencia de la mediana muestral, medida como la relación entre la varianza de la media y la varianza de la mediana, depende del tamaño de la muestra y de la distribución poblacional subyacente. Para una muestra de tamaño de la distribución normal , la eficiencia para N grande es

La eficiencia tiende a infinito.

En otras palabras, la varianza relativa de la mediana será o 57% mayor que la varianza de la media; el error estándar relativo de la mediana será o 25% mayor que el error estándar de la media ( ver también la sección #Distribución muestral arriba.). [33]

Para distribuciones univariadas que son simétricas con respecto a una mediana, el estimador de Hodges-Lehmann es un estimador robusto y muy eficiente de la mediana poblacional. [34]

Si los datos están representados por un modelo estadístico que especifica una familia particular de distribuciones de probabilidad , entonces se pueden obtener estimaciones de la mediana ajustando esa familia de distribuciones de probabilidad a los datos y calculando la mediana teórica de la distribución ajustada. [ cita necesaria ] La interpolación de Pareto es una aplicación de esto cuando se supone que la población tiene una distribución de Pareto .

Anteriormente, este artículo discutió la mediana univariada, cuando la muestra o población era unidimensional. Cuando la dimensión es dos o más, existen múltiples conceptos que amplían la definición de mediana univariante; cada una de estas medianas multivariadas concuerda con la mediana univariada cuando la dimensión es exactamente uno. [34] [35] [36] [37]

La mediana marginal se define para vectores definidos con respecto a un conjunto fijo de coordenadas. Una mediana marginal se define como el vector cuyos componentes son medianas univariadas. La mediana marginal es fácil de calcular y sus propiedades fueron estudiadas por Puri y Sen. [34] [38]

La mediana geométrica de un conjunto discreto de puntos muestrales en un espacio euclidiano es el punto [a] que minimiza la suma de distancias a los puntos muestrales.

A diferencia de la mediana marginal, la mediana geométrica es equivariante con respecto a transformaciones de similitud euclidianas como traslaciones y rotaciones .

Si las medianas marginales de todos los sistemas de coordenadas coinciden, entonces su ubicación común puede denominarse "mediana en todas las direcciones". [40] Este concepto es relevante para la teoría de la votación debido al teorema del votante mediano . Cuando existe, la mediana en todas las direcciones coincide con la mediana geométrica (al menos para distribuciones discretas).

Cuando se trata de una variable discreta, a veces resulta útil considerar los valores observados como puntos medios de intervalos continuos subyacentes. Un ejemplo de ello es la escala Likert , en la que se expresan opiniones o preferencias en una escala con un número determinado de respuestas posibles. Si la escala consta de números enteros positivos, se podría considerar que una observación de 3 representa el intervalo de 2,50 a 3,50. Es posible estimar la mediana de la variable subyacente. Si, digamos, el 22% de las observaciones tienen un valor de 2 o menos y el 55,0% son de 3 o menos (por lo que el 33% tiene el valor 3), entonces la mediana es 3 ya que la mediana es el valor más pequeño de para el cual es mayor. que la mitad. Pero la mediana interpolada está entre 2,50 y 3,50. Primero sumamos la mitad del ancho del intervalo a la mediana para obtener el límite superior del intervalo mediano. Luego restamos esa proporción del ancho del intervalo que es igual a la proporción del 33% que se encuentra por encima de la marca del 50%. En otras palabras, dividimos el ancho del intervalo proporcionalmente al número de observaciones. En este caso, el 33% se divide en 28% por debajo de la mediana y 5% por encima de ella, por lo que restamos 5/33 del ancho del intervalo del límite superior de 3,50 para obtener una mediana interpolada de 3,35. Más formalmente, si se conocen los valores, la mediana interpolada se puede calcular a partir de

Alternativamente, si en una muestra observada hay puntuaciones por encima de la categoría mediana, puntuaciones en ella y puntuaciones por debajo de ella, entonces la mediana interpolada viene dada por

Para distribuciones univariadas que son simétricas con respecto a una mediana, el estimador de Hodges-Lehmann es un estimador robusto y muy eficiente de la mediana poblacional; para distribuciones no simétricas, el estimador de Hodges-Lehmann es un estimador robusto y altamente eficiente de la pseudomediana poblacional , que es la mediana de una distribución simetrizada y que está cerca de la mediana poblacional. [41] El estimador de Hodges-Lehmann se ha generalizado a distribuciones multivariadas. [42]

El estimador de Theil-Sen es un método de regresión lineal robusta basado en la búsqueda de medianas de pendientes . [43]

El filtro mediano es una herramienta importante de procesamiento de imágenes , que puede eliminar eficazmente cualquier ruido de sal y pimienta de las imágenes en escala de grises .

En el análisis de conglomerados , el algoritmo de agrupación de k-medianas proporciona una forma de definir conglomerados, en el que el criterio de maximizar la distancia entre las medias de los conglomerados que se utiliza en la agrupación de k-medias se reemplaza por maximizar la distancia entre las medianas de los conglomerados.

Este es un método de regresión robusta. La idea se remonta a Wald en 1940, quien sugirió dividir un conjunto de datos bivariados en dos mitades dependiendo del valor del parámetro independiente : una mitad izquierda con valores menores que la mediana y una mitad derecha con valores mayores que la mediana. [44] Sugirió tomar las medias de las variables dependientes e independientes de las mitades izquierda y derecha y estimar la pendiente de la línea que une estos dos puntos. Luego, la línea podría ajustarse para que se ajuste a la mayoría de los puntos del conjunto de datos.

Nair y Shrivastava en 1942 sugirieron una idea similar, pero en cambio abogaron por dividir la muestra en tres partes iguales antes de calcular las medias de las submuestras. [45] Brown y Mood en 1951 propusieron la idea de utilizar las medianas de dos submuestras en lugar de las medias. [46] Tukey combinó estas ideas y recomendó dividir la muestra en tres submuestras de igual tamaño y estimar la línea en función de las medianas de las submuestras. [47]

Cualquier estimador insesgado de media minimiza el riesgo ( pérdida esperada ) con respecto a la función de pérdida de error al cuadrado , como lo observa Gauss . Un estimador insesgado de mediana minimiza el riesgo con respecto a la función de pérdida de desviación absoluta , como observó Laplace . Otras funciones de pérdida se utilizan en la teoría estadística , particularmente en estadísticas sólidas .

La teoría de los estimadores insesgados de la mediana fue revivida por George W. Brown en 1947: [48]

Se dirá que una estimación de un parámetro unidimensional θ es medianamente insesgada si, para θ fijo, la mediana de la distribución de la estimación está en el valor θ; es decir, la estimación subestima con tanta frecuencia como sobreestima. Para la mayoría de los propósitos, este requisito parece cumplir tanto como el requisito insesgado de media y tiene la propiedad adicional de que es invariante bajo transformación uno a uno.

— página 584

Se han informado otras propiedades de los estimadores insesgados de la mediana. [49] [50] [51] [52] Los estimadores insesgados de mediana son invariantes bajo transformaciones uno a uno .

Existen métodos para construir estimadores insesgados de mediana que son óptimos (en un sentido análogo a la propiedad de varianza mínima para estimadores insesgados de media). Tales construcciones existen para distribuciones de probabilidad que tienen funciones de probabilidad monótonas . [53] [54] Uno de esos procedimientos es un análogo del procedimiento de Rao-Blackwell para estimadores insesgados de media: el procedimiento es válido para una clase más pequeña de distribuciones de probabilidad que el procedimiento de Rao-Blackwell, pero para una clase más grande de funciones de pérdida . [55]

Los investigadores científicos del antiguo Cercano Oriente parecen no haber utilizado estadísticas resumidas en absoluto, sino que eligieron valores que ofrecían la máxima coherencia con una teoría más amplia que integraba una amplia variedad de fenómenos. [56] Dentro de la comunidad académica mediterránea (y, más tarde, europea), las estadísticas como la media son fundamentalmente un desarrollo medieval y moderno temprano. (La historia de la mediana fuera de Europa y sus predecesoras sigue estando relativamente poco estudiada).

La idea de mediana apareció en el siglo VI en el Talmud , con el fin de analizar con justicia valoraciones divergentes . [57] [58] Sin embargo, el concepto no se extendió a la comunidad científica en general.

En cambio, el ancestro más cercano de la mediana moderna es la de rango medio , inventada por Al-Biruni [59] : 31 [60] La transmisión de su trabajo a estudiosos posteriores no está clara. Aplicó su técnica al análisis de metales monetarios, pero, después de publicar su trabajo, la mayoría de los ensayadores todavía adoptaron el valor más desfavorable de sus resultados, para que no pareciera que estaban haciendo trampa . [59] : 35–8 [61] Sin embargo, el aumento de la navegación en el mar durante la Era de los Descubrimientos significó que los navegantes de los barcos tuvieran cada vez más que intentar determinar la latitud en condiciones climáticas desfavorables contra costas hostiles, lo que llevó a un renovado interés en las estadísticas resumidas. Ya sea redescubierto o inventado de forma independiente, el rango medio se recomienda a los navegantes náuticos en las "Instrucciones para el viaje de Raleigh a Guayana, 1595" de Harriot. [59] : 45-8

La idea de la mediana puede haber aparecido por primera vez en el libro de Edward Wright de 1599, Ciertos errores en la navegación, en una sección sobre navegación con brújula . [62] Wright se mostró reacio a descartar los valores medidos y pudo haber sentido que la mediana (que incorpora una mayor proporción del conjunto de datos que el rango medio ) tenía más probabilidades de ser correcta. Sin embargo, Wright no dio ejemplos del uso de su técnica, lo que dificulta verificar que describiera la noción moderna de mediana. [56] [60] [b] La mediana (en el contexto de la probabilidad) ciertamente apareció en la correspondencia de Christiaan Huygens , pero como un ejemplo de estadística que era inapropiada para la práctica actuarial . [56]

La primera recomendación de la mediana data de 1757, cuando Roger Joseph Boscovich desarrolló un método de regresión basado en la norma L 1 y, por tanto, implícitamente en la mediana. [56] [63] En 1774, Laplace hizo explícito este deseo: sugirió que se utilizara la mediana como estimador estándar del valor de una FDP posterior . El criterio específico fue minimizar la magnitud esperada del error; donde está la estimación y es el valor real. Con este fin, Laplace determinó las distribuciones tanto de la media muestral como de la mediana muestral a principios del siglo XIX. [26] [64] Sin embargo, una década después, Gauss y Legendre desarrollaron el método de mínimos cuadrados , que minimiza para obtener la media. En el contexto de la regresión, la innovación de Gauss y Legendre ofrece un cálculo mucho más sencillo. En consecuencia, la propuesta de Laplaces fue generalmente rechazada hasta el surgimiento de los dispositivos informáticos 150 años después (y sigue siendo un algoritmo relativamente poco común). [sesenta y cinco]

Antoine Augustin Cournot en 1843 fue el primero [66] en utilizar el término mediana ( valeur médiane ) para el valor que divide una distribución de probabilidad en dos mitades iguales. Gustav Theodor Fechner utilizó la mediana ( Centralwerth ) en fenómenos sociológicos y psicológicos. [67] Anteriormente se había utilizado sólo en astronomía y campos relacionados. Gustav Fechner popularizó la mediana en el análisis formal de datos, aunque ya había sido utilizada anteriormente por Laplace, [67] y la mediana apareció en un libro de texto de FY Edgeworth . [68] Francis Galton utilizó el término inglés mediana en 1881, [69] [70] habiendo utilizado anteriormente los términos valor medio en 1869 y medio en 1880. [71] [72]

Los estadísticos alentaron intensamente el uso de medianas durante todo el siglo XIX por su claridad intuitiva. Sin embargo, la noción de mediana no se presta a la teoría de momentos superiores tan bien como lo hace la media aritmética , y es mucho más difícil de calcular. Como resultado, la mediana fue suplantada constantemente como noción de promedio genérico por la media aritmética durante el siglo XX. [56] [60]

{{cite journal}}: CS1 maint: DOI inactive as of January 2024 (link)Este artículo incorpora material de Median de una distribución en PlanetMath , que tiene la licencia Creative Commons Attribution/Share-Alike License .