Las estadísticas sólidas son estadísticas que mantienen sus propiedades incluso si los supuestos distributivos subyacentes son incorrectos. Se han desarrollado métodos estadísticos sólidos para muchos problemas comunes, como la estimación de ubicación , escala y parámetros de regresión . Una motivación es producir métodos estadísticos que no se vean excesivamente afectados por valores atípicos . Otra motivación es proporcionar métodos con buen rendimiento cuando hay pequeñas desviaciones de una distribución paramétrica . Por ejemplo, los métodos robustos funcionan bien para mezclas de dos distribuciones normales con diferentes desviaciones estándar ; Según este modelo, los métodos no robustos como la prueba t funcionan mal. [ cita necesaria ]

Las estadísticas sólidas buscan proporcionar métodos que emulen los métodos estadísticos populares, pero que no se vean indebidamente afectados por valores atípicos u otras pequeñas desviaciones de los supuestos del modelo . En estadística, los métodos de estimación clásicos se basan en gran medida en supuestos que a menudo no se cumplen en la práctica. En particular, a menudo se supone que los errores de los datos se distribuyen normalmente, al menos aproximadamente, o que se puede confiar en que el teorema del límite central produce estimaciones distribuidas normalmente. Desafortunadamente, cuando hay valores atípicos en los datos, los estimadores clásicos a menudo tienen un desempeño muy pobre, cuando se los juzga utilizando el punto de ruptura y la función de influencia , que se describen a continuación.

El efecto práctico de los problemas observados en la función de influencia se puede estudiar empíricamente examinando la distribución muestral de los estimadores propuestos bajo un modelo de mezcla , donde se mezcla una pequeña cantidad (1 a 5% suele ser suficiente) de contaminación. Por ejemplo, se puede utilizar una combinación de 95% de distribución normal y 5% de distribución normal con la misma media pero una desviación estándar significativamente mayor (que representa valores atípicos).

Las estadísticas paramétricas robustas pueden proceder de dos maneras:

Se han estudiado estimaciones sólidas para los siguientes problemas:

Existen varias definiciones de " estadística robusta ". Estrictamente hablando, una estadística robusta es resistente a errores en los resultados, producidos por desviaciones de los supuestos [2] (por ejemplo, de normalidad). Esto significa que si los supuestos sólo se cumplen aproximadamente, el estimador robusto seguirá teniendo una eficiencia razonable y un sesgo razonablemente pequeño , además de ser asintóticamente insesgado , es decir, tener un sesgo que tiende hacia 0 a medida que el tamaño de la muestra tiende hacia el infinito.

Generalmente, el caso más importante es la solidez distributiva : solidez a la ruptura de los supuestos sobre la distribución subyacente de los datos. [2] Los procedimientos estadísticos clásicos suelen ser sensibles a la "cola larga" (por ejemplo, cuando la distribución de los datos tiene colas más largas que la distribución normal supuesta). Esto implica que se verán fuertemente afectados por la presencia de valores atípicos en los datos, y las estimaciones que producen pueden verse muy distorsionadas si hay valores atípicos extremos en los datos, en comparación con lo que serían si los valores atípicos no estuvieran incluidos en los datos. .

Por el contrario, los estimadores más robustos que no son tan sensibles a distorsiones distributivas como la cola larga también son resistentes a la presencia de valores atípicos. Por lo tanto, en el contexto de estadísticas sólidas, robustez distributiva y resistencia a valores atípicos son efectivamente sinónimos. [2] Para una perspectiva sobre la investigación en estadísticas sólidas hasta el año 2000, ver Portnoy & He (2000).

Algunos expertos prefieren el término estadística resistente para la robustez distributiva y reservan "robustez" para la robustez no distributiva, por ejemplo, robustez ante la violación de supuestos sobre el modelo o estimador de probabilidad, pero este es un uso minoritario. Es común que "robustez" signifique "robustez distributiva".

Al considerar qué tan robusto es un estimador ante la presencia de valores atípicos, es útil probar qué sucede cuando se agrega un valor atípico extremo al conjunto de datos y probar qué sucede cuando un valor atípico extremo reemplaza uno de los puntos de datos existentes, y luego considerar el efecto de múltiples adiciones o reemplazos.

La media no es una medida sólida de tendencia central . Si el conjunto de datos son, por ejemplo, los valores {2,3,5,6,9}, entonces si agregamos otro punto de datos con valor -1000 o +1000 a los datos, la media resultante será muy diferente a la media de los datos originales. . De manera similar, si reemplazamos uno de los valores con un punto de datos de valor -1000 o +1000, la media resultante será muy diferente a la media de los datos originales.

La mediana es una medida robusta de tendencia central . Tomando el mismo conjunto de datos {2,3,5,6,9}, si agregamos otro punto de datos con valor -1000 o +1000, la mediana cambiará ligeramente, pero seguirá siendo similar a la mediana de los datos originales. Si reemplazamos uno de los valores con un punto de datos de valor -1000 o +1000, la mediana resultante seguirá siendo similar a la mediana de los datos originales.

Descrita en términos de puntos de ruptura, la mediana tiene un punto de ruptura del 50%, lo que significa que la mitad de los puntos deben ser valores atípicos antes de que la mediana pueda moverse fuera del rango de los no valores atípicos, mientras que la media tiene un punto de ruptura de 0. ya que una sola observación importante puede desvirtuarlo.

La desviación absoluta de la mediana y el rango intercuartil son medidas sólidas de dispersión estadística , mientras que la desviación estándar y el rango no lo son.

Los estimadores recortados y los estimadores winsorizados son métodos generales para hacer que las estadísticas sean más sólidas. Los estimadores L son una clase general de estadísticas simples, a menudo robustas, mientras que los estimadores M son una clase general de estadísticas robustas y ahora son la solución preferida, aunque su cálculo puede ser bastante complicado.

Gelman et al. en Bayesian Data Analysis (2004) considera un conjunto de datos relacionados con las mediciones de la velocidad de la luz realizadas por Simon Newcomb . Los conjuntos de datos de ese libro se pueden encontrar a través de la página de conjuntos de datos clásicos y el sitio web del libro contiene más información sobre los datos.

Aunque la mayor parte de los datos parece tener una distribución más o menos normal, hay dos valores atípicos obvios. Estos valores atípicos tienen un gran efecto sobre la media, arrastrándola hacia ellos y alejándola del centro de la mayor parte de los datos. Por lo tanto, si la media pretende ser una medida de la ubicación del centro de los datos, en cierto sentido está sesgada cuando están presentes valores atípicos.

Además, se sabe que la distribución de la media es asintóticamente normal debido al teorema del límite central. Sin embargo, los valores atípicos pueden hacer que la distribución de la media no sea normal incluso para conjuntos de datos bastante grandes. Además de esta falta de normalidad, la media también es ineficiente en presencia de valores atípicos y se encuentran disponibles medidas de ubicación menos variables.

El siguiente gráfico muestra un gráfico de densidad de los datos de la velocidad de la luz, junto con un gráfico de alfombra (panel (a)). También se muestra un gráfico Q-Q normal (panel (b)). Los valores atípicos son visibles en estos gráficos.

Los paneles (c) y (d) del gráfico muestran la distribución bootstrap de la media (c) y la media recortada al 10% (d). La media recortada es un estimador robusto simple de ubicación que elimina un cierto porcentaje de observaciones (10% aquí) de cada extremo de los datos y luego calcula la media de la forma habitual. El análisis se realizó en R y se utilizaron 10.000 muestras bootstrap para cada una de las medias sin procesar y recortadas.

La distribución de la media es claramente mucho más amplia que la de la media recortada del 10% (las gráficas están en la misma escala). Además, mientras que la distribución de la media recortada parece cercana a la normal, la distribución de la media bruta está bastante sesgada hacia la izquierda. Entonces, en esta muestra de 66 observaciones, sólo 2 valores atípicos hacen que el teorema del límite central sea inaplicable.

Los métodos estadísticos robustos, de los cuales la media recortada es un ejemplo simple, buscan superar a los métodos estadísticos clásicos en presencia de valores atípicos o, más generalmente, cuando los supuestos paramétricos subyacentes no son del todo correctos.

Si bien la media recortada funciona bien en relación con la media en este ejemplo, se encuentran disponibles estimaciones más sólidas. De hecho, la media, la mediana y la media recortada son casos especiales de estimadores M. Los detalles aparecen en las secciones siguientes.

Los valores atípicos en los datos de la velocidad de la luz tienen más que un simple efecto adverso sobre la media; la estimación habitual de escala es la desviación estándar, y esta cantidad se ve aún más afectada por los valores atípicos porque los cuadrados de las desviaciones de la media entran en el cálculo, por lo que los efectos de los valores atípicos se exacerban.

Los gráficos a continuación muestran las distribuciones bootstrap de la desviación estándar, la desviación absoluta mediana (MAD) y el estimador de escala de Rousseeuw-Croux (Qn) . [3] Los gráficos se basan en 10.000 muestras de arranque para cada estimador, con algo de ruido gaussiano añadido a los datos remuestreados ( arranque suavizado ). El panel (a) muestra la distribución de la desviación estándar, (b) de la MAD y (c) de Qn.

La distribución de la desviación estándar es errática y amplia, como resultado de los valores atípicos. El MAD se comporta mejor y Qn es un poco más eficiente que el MAD. Este sencillo ejemplo demuestra que cuando hay valores atípicos, la desviación estándar no se puede recomendar como estimación de escala.

Tradicionalmente, los estadísticos examinaban manualmente los datos en busca de valores atípicos y los eliminaban, generalmente verificando la fuente de los datos para ver si los valores atípicos se registraron erróneamente. De hecho, en el ejemplo anterior de la velocidad de la luz, es fácil ver y eliminar los dos valores atípicos antes de continuar con cualquier análisis adicional. Sin embargo, en los tiempos modernos, los conjuntos de datos suelen consistir en un gran número de variables que se miden en un gran número de unidades experimentales. Por lo tanto, la detección manual de valores atípicos suele resultar poco práctica.

Los valores atípicos a menudo pueden interactuar de tal manera que se enmascaran entre sí. Como ejemplo sencillo, consideremos un pequeño conjunto de datos univariados que contiene un valor atípico modesto y otro grande. La desviación estándar estimada estará enormemente inflada por el gran valor atípico. El resultado es que el modesto valor atípico parece relativamente normal. Tan pronto como se elimina el valor atípico grande, la desviación estándar estimada se reduce y el valor atípico modesto ahora parece inusual.

Este problema de enmascaramiento empeora a medida que aumenta la complejidad de los datos. Por ejemplo, en problemas de regresión , se utilizan gráficos de diagnóstico para identificar valores atípicos. Sin embargo, es común que una vez que se eliminan algunos valores atípicos, otros se vuelven visibles. El problema es aún peor en dimensiones superiores.

Los métodos sólidos proporcionan formas automáticas de detectar, reducir (o eliminar) y señalar valores atípicos, eliminando en gran medida la necesidad de realizar una detección manual. Se debe tener cuidado; Los datos iniciales que mostraban que el agujero de ozono apareció por primera vez sobre la Antártida fueron rechazados como valores atípicos por exámenes no humanos. [4]

Aunque este artículo aborda los principios generales de los métodos estadísticos univariados, también existen métodos sólidos para problemas de regresión, modelos lineales generalizados y estimación de parámetros de diversas distribuciones.

Las herramientas básicas utilizadas para describir y medir la robustez son el punto de ruptura , la función de influencia y la curva de sensibilidad .

Intuitivamente, el punto de ruptura de un estimador es la proporción de observaciones incorrectas (por ejemplo, observaciones arbitrariamente grandes) que un estimador puede manejar antes de dar un resultado incorrecto (por ejemplo, arbitrariamente grande). Generalmente, el límite asintótico (muestra infinita) se cita como punto de ruptura, aunque el punto de ruptura de muestra finita puede ser más útil. [5] Por ejemplo, dadas las variables aleatorias independientes y las realizaciones correspondientes , podemos utilizarlas para estimar la media. Un estimador de este tipo tiene un punto de ruptura de 0 (o un punto de ruptura de muestra finita de ) porque podemos hacerlo arbitrariamente grande simplemente cambiando cualquiera de .

Cuanto mayor sea el punto de ruptura de un estimador, más robusto será. Intuitivamente, podemos entender que un punto de ruptura no puede exceder el 50% porque si más de la mitad de las observaciones están contaminadas, no es posible distinguir entre la distribución subyacente y la distribución contaminante Rousseeuw y Leroy (1987). Por tanto, el punto de ruptura máximo es 0,5 y hay estimadores que alcanzan ese punto de ruptura. Por ejemplo, la mediana tiene un punto de ruptura de 0,5. La media recortada de X% tiene un punto de ruptura de X%, para el nivel elegido por X. Huber (1981) y Maronna et al. (2019) contienen más detalles. El nivel y los puntos de ruptura de potencia de las pruebas se investigan en He, Simpson y Portnoy (1990).

Las estadísticas con puntos de ruptura elevados a veces se denominan estadísticas resistentes. [6]

En el ejemplo de la velocidad de la luz, eliminar las dos observaciones más bajas hace que la media cambie de 26,2 a 27,75, un cambio de 1,55. La estimación de escala producida por el método Qn es 6,3. Podemos dividir esto por la raíz cuadrada del tamaño de la muestra para obtener un error estándar robusto y encontramos que esta cantidad es 0,78. Por tanto, el cambio en la media resultante de eliminar dos valores atípicos es aproximadamente el doble del error estándar robusto.

La media recortada del 10% para los datos de la velocidad de la luz es 27,43. Eliminando las dos observaciones más bajas y volviendo a calcular se obtiene 27,67. La media recortada se ve menos afectada por los valores atípicos y tiene un punto de ruptura más alto.

Si reemplazamos la observación más baja, −44, por −1000, la media pasa a ser 11,73, mientras que la media recortada del 10 % sigue siendo 27,43. En muchas áreas de la estadística aplicada, es común que los datos se transformen logarítmicamente para hacerlos casi simétricos. Los valores muy pequeños se vuelven negativos cuando se transforman logarítmicamente, y los ceros se vuelven negativamente infinitos. Por tanto, este ejemplo es de interés práctico.

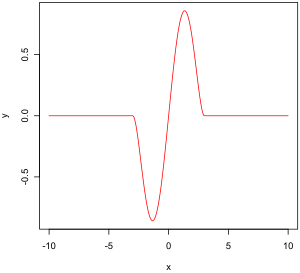

La función de influencia empírica es una medida de la dependencia del estimador del valor de cualquiera de los puntos de la muestra. Es una medida sin modelo en el sentido de que simplemente se basa en calcular nuevamente el estimador con una muestra diferente. A la derecha está la función biponderada de Tukey, que, como veremos más adelante, es un ejemplo de cómo debería ser una función de influencia empírica "buena" (en un sentido definido más adelante).

En términos matemáticos, una función de influencia se define como un vector en el espacio del estimador, que a su vez se define para una muestra que es un subconjunto de la población:

Por ejemplo,

La función de influencia empírica se define de la siguiente manera.

Sea y sea iid y es una muestra de estas variables. es un estimador. Dejar . La función de influencia empírica en la observación se define por:

Lo que esto significa es que estamos reemplazando el i -ésimo valor de la muestra por un valor arbitrario y observando la salida del estimador. Alternativamente, el EIF se define como el efecto, escalado por n+1 en lugar de n, sobre el estimador de agregar el punto a la muestra. [ cita necesaria ]

En lugar de confiar únicamente en los datos, podríamos utilizar la distribución de variables aleatorias. El enfoque es bastante diferente al del párrafo anterior. Lo que estamos tratando de hacer ahora es ver qué le sucede a un estimador cuando cambiamos ligeramente la distribución de los datos: asume una distribución y mide la sensibilidad al cambio en esta distribución. Por el contrario, la influencia empírica supone un conjunto de muestras y mide la sensibilidad al cambio en las muestras. [7]

Sea un subconjunto convexo del conjunto de todas las medidas finitas con signo en . Queremos estimar el parámetro de una distribución en . Sea el funcional el valor asintótico de alguna secuencia estimadora . Supondremos que este funcional es consistente con Fisher , es decir . Esto significa que en el modelo , la secuencia del estimador mide asintóticamente la cantidad correcta.

Sea alguna distribución en . ¿Qué sucede cuando los datos no siguen exactamente el modelo sino otro, ligeramente diferente, "hacia" ?

Estamos viendo:

que es la derivada unilateral de Gateaux de en , en la dirección de .

Dejar . es la medida de probabilidad que da masa 1 a . Nosotros elegimos . La función de influencia queda entonces definida por:

Describe el efecto de una contaminación infinitesimal en el punto sobre la estimación que buscamos, estandarizada por la masa de la contaminación (el sesgo asintótico causado por la contaminación en las observaciones). Para un estimador robusto, queremos una función de influencia acotada, es decir, una que no llegue al infinito cuando x se vuelve arbitrariamente grande.

Las propiedades de una función de influencia que le otorgan un desempeño deseable son:

Este valor, que se parece mucho a una constante de Lipschitz , representa el efecto de desplazar ligeramente una observación desde un punto vecino , es decir, agregar una observación en y eliminar otra en .

(El contexto matemático de este párrafo se proporciona en la sección sobre funciones de influencia empíricas).

Históricamente, se propusieron varios enfoques para la estimación robusta, incluidos los estimadores R y los estimadores L. Sin embargo, los estimadores M ahora parecen dominar el campo como resultado de su generalidad, su potencial para altos puntos de ruptura y su eficiencia comparativamente alta. Véase Huber (1981).

Los estimadores M no son inherentemente robustos. Sin embargo, se pueden diseñar para lograr propiedades favorables, incluida la robustez. El estimador M es una generalización de los estimadores de máxima verosimilitud (MLE) que se determina maximizando o, equivalentemente, minimizando . En 1964, Huber propuso generalizar esto a la minimización de , donde es alguna función. Los MLE son, por tanto, un caso especial de estimadores M (de ahí el nombre: estimadores de " tipo de máxima verosimilitud").

La minimización a menudo se puede hacer derivando y resolviendo , donde (si tiene una derivada).

Se han propuesto varias opciones de y . Las dos figuras siguientes muestran cuatro funciones y sus funciones correspondientes.

Para los errores cuadráticos, aumenta a un ritmo acelerado, mientras que para los errores absolutos, aumenta a un ritmo constante. Cuando se utiliza Winsorizing, se introduce una combinación de estos dos efectos: para valores pequeños de x, aumenta a la tasa al cuadrado, pero una vez que se alcanza el umbral elegido (1,5 en este ejemplo), la tasa de aumento se vuelve constante. Este estimador de Winsorised también se conoce como función de pérdida de Huber .

La función biweight de Tukey (también conocida como bicuadrado) se comporta de manera similar a la función de error al cuadrado al principio, pero para errores mayores, la función disminuye.

Los estimadores M no necesariamente se relacionan con una función de densidad de probabilidad. Por lo tanto, en general, no se pueden utilizar enfoques estándar de inferencia que surgen de la teoría de la probabilidad.

Se puede demostrar que los estimadores M tienen una distribución normal asintótica, de modo que siempre que se puedan calcular sus errores estándar, se dispone de un enfoque aproximado para la inferencia.

Dado que los estimadores M son normales sólo asintóticamente, para tamaños de muestra pequeños podría ser apropiado utilizar un enfoque alternativo a la inferencia, como el bootstrap. Sin embargo, las estimaciones M no son necesariamente únicas (es decir, puede haber más de una solución que satisfaga las ecuaciones). Además, es posible que cualquier muestra de arranque en particular pueda contener más valores atípicos que el punto de ruptura del estimador. Por lo tanto, es necesario tener cierto cuidado al diseñar esquemas de arranque.

Por supuesto, como vimos con el ejemplo de la velocidad de la luz, la media solo se distribuye normalmente de forma asintótica y cuando hay valores atípicos la aproximación puede ser muy pobre incluso para muestras bastante grandes. Sin embargo, las pruebas estadísticas clásicas, incluidas las basadas en la media, suelen estar limitadas por el tamaño nominal de la prueba. No ocurre lo mismo con los estimadores M y la tasa de error tipo I puede estar sustancialmente por encima del nivel nominal.

Estas consideraciones no "invalidan" la estimación M de ninguna manera. Simplemente dejan claro que es necesario cierto cuidado en su uso, como ocurre con cualquier otro método de estimación.

Se puede demostrar que la función de influencia de un estimador M es proporcional a , [8] lo que significa que podemos derivar las propiedades de dicho estimador (como su punto de rechazo, sensibilidad al error bruto o sensibilidad al desplazamiento local) cuando conocer su función.

con lo dado por:

En muchas situaciones prácticas, la elección de la función no es crítica para obtener una buena estimación robusta, y muchas opciones darán resultados similares que ofrecen grandes mejoras, en términos de eficiencia y sesgo, sobre las estimaciones clásicas en presencia de valores atípicos. [9]

En teoría, se prefieren las funciones, [ se necesita aclaración ] y la función biweight de Tukey (también conocida como bicuadrado) es una opción popular. Marona et al. (2019) recomiendan la función biweight con una eficiencia normal establecida en 85%.

Los estimadores M no necesariamente se relacionan con una función de densidad y, por lo tanto, no son completamente paramétricos. Los enfoques totalmente paramétricos para el modelado y la inferencia robustos, tanto los enfoques bayesianos como los de probabilidad, generalmente tratan con distribuciones de cola pesada, como la distribución t de Student .

Para la distribución t con grados de libertad, se puede demostrar que

Para , la distribución t es equivalente a la distribución de Cauchy. Los grados de libertad a veces se conocen como parámetro de curtosis . Es el parámetro que controla el peso de las colas. En principio, puede estimarse a partir de los datos del mismo modo que cualquier otro parámetro. En la práctica, es común que existan múltiples máximos locales cuando se permite variar. Como tal, es común fijarlo en un valor alrededor de 4 o 6. La siguiente figura muestra la función para 4 valores diferentes de .

Para los datos de la velocidad de la luz, permitiendo que el parámetro de curtosis varíe y maximizando la probabilidad, obtenemos

Fijar y maximizar la probabilidad da

Una cantidad fundamental es una función de datos, cuya distribución poblacional subyacente es miembro de una familia paramétrica, que no depende de los valores de los parámetros. Una estadística auxiliar es una función que también es una estadística, lo que significa que se calcula únicamente en términos de los datos. Tales funciones son robustas a los parámetros en el sentido de que son independientes de los valores de los parámetros, pero no robustas al modelo en el sentido de que suponen un modelo subyacente (familia paramétrica) y, de hecho, dichas funciones suelen ser muy sensibles. a violaciones de los supuestos del modelo. Por lo tanto, las estadísticas de prueba , frecuentemente construidas en términos de no ser sensibles a los supuestos sobre los parámetros, siguen siendo muy sensibles a los supuestos del modelo.

Reemplazar datos faltantes se llama imputación . Si faltan relativamente pocos puntos, existen algunos modelos que se pueden utilizar para estimar valores para completar la serie, como reemplazar los valores faltantes con la media o mediana de los datos. También se puede utilizar la regresión lineal simple para estimar los valores faltantes. [10] Además, a veces se pueden acomodar valores atípicos en los datos mediante el uso de medias recortadas, otros estimadores de escala además de la desviación estándar (por ejemplo, MAD) y Winsorización. [11] En los cálculos de una media recortada, se elimina un porcentaje fijo de datos de cada extremo de los datos ordenados, eliminando así los valores atípicos. Luego se calcula la media utilizando los datos restantes. Winsorizar implica acomodar un valor atípico reemplazándolo con el siguiente valor más alto o el siguiente más pequeño, según corresponda. [12]

Sin embargo, utilizar este tipo de modelos para predecir valores faltantes o valores atípicos en una serie temporal larga es difícil y, a menudo, poco confiable, particularmente si el número de valores a completar es relativamente alto en comparación con la longitud total del registro. La precisión de la estimación depende de qué tan bueno y representativo sea el modelo y de cuánto se extienda el período de valores faltantes. [13] Cuando se supone una evolución dinámica en una serie, el problema del punto de datos faltante se convierte en un ejercicio de análisis multivariado (en lugar del enfoque univariado de la mayoría de los métodos tradicionales para estimar valores faltantes y valores atípicos). En tales casos, un modelo multivariado será más representativo que uno univariado para predecir valores faltantes. El mapa autoorganizado de Kohonen (KSOM) ofrece un modelo multivariado simple y robusto para el análisis de datos, brindando así buenas posibilidades para estimar los valores faltantes, teniendo en cuenta su relación o correlación con otras variables pertinentes en el registro de datos. [12]

Los filtros de Kalman estándar no son resistentes a los valores atípicos. Con este fin, Ting, Theodorou y Schaal (2007) han demostrado recientemente que una modificación del teorema de Masreliez puede abordar valores atípicos.

Un enfoque común para manejar valores atípicos en el análisis de datos es realizar primero la detección de valores atípicos, seguido de un método de estimación eficiente (por ejemplo, los mínimos cuadrados). Si bien este enfoque suele ser útil, hay que tener en cuenta dos desafíos. En primer lugar, un método de detección de valores atípicos que se basa en un ajuste inicial no robusto puede sufrir el efecto de enmascaramiento, es decir, un grupo de valores atípicos pueden enmascararse entre sí y escapar a la detección. [14] En segundo lugar, si se utiliza un ajuste inicial de alto desglose para la detección de valores atípicos, el análisis de seguimiento podría heredar algunas de las ineficiencias del estimador inicial. [15]