En matemáticas , un sistema dinámico es un sistema en el que una función describe la dependencia temporal de un punto en un espacio ambiente , como en una curva paramétrica . Los ejemplos incluyen los modelos matemáticos que describen el balanceo de un péndulo de reloj , el flujo de agua en una tubería , el movimiento aleatorio de partículas en el aire y el número de peces cada primavera en un lago . La definición más general unifica varios conceptos en matemáticas, como las ecuaciones diferenciales ordinarias y la teoría ergódica, al permitir diferentes opciones del espacio y cómo se mide el tiempo. [ cita requerida ] El tiempo puede medirse con números enteros, reales o complejos o puede ser un objeto algebraico más general, perdiendo la memoria de su origen físico, y el espacio puede ser una variedad o simplemente un conjunto , sin la necesidad de una estructura espacio-temporal suave definida en él.

En cualquier momento dado, un sistema dinámico tiene un estado que representa un punto en un espacio de estados apropiado . Este estado a menudo viene dado por una tupla de números reales o por un vector en una variedad geométrica. La regla de evolución del sistema dinámico es una función que describe qué estados futuros se siguen del estado actual. A menudo, la función es determinista , es decir, para un intervalo de tiempo dado solo un estado futuro se sigue del estado actual. [1] [2] Sin embargo, algunos sistemas son estocásticos , en el sentido de que los eventos aleatorios también afectan la evolución de las variables de estado.

En física , un sistema dinámico se describe como una "partícula o conjunto de partículas cuyo estado varía con el tiempo y, por lo tanto, obedece a ecuaciones diferenciales que involucran derivadas temporales". [3] Para realizar una predicción sobre el comportamiento futuro del sistema, se realiza una solución analítica de dichas ecuaciones o su integración en el tiempo mediante simulación por computadora.

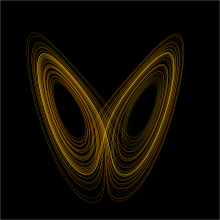

El estudio de los sistemas dinámicos es el foco de la teoría de sistemas dinámicos , que tiene aplicaciones en una amplia variedad de campos como las matemáticas, la física, [4] [5] la biología , [6] la química , la ingeniería , [7] la economía , [8] la historia y la medicina . Los sistemas dinámicos son una parte fundamental de la teoría del caos , la dinámica de mapas logísticos , la teoría de la bifurcación , los procesos de autoensamblaje y autoorganización y el concepto del borde del caos .

El concepto de sistema dinámico tiene su origen en la mecánica newtoniana . Allí, como en otras ciencias naturales y disciplinas de ingeniería, la regla de evolución de los sistemas dinámicos es una relación implícita que proporciona el estado del sistema solo para un corto período de tiempo en el futuro. (La relación es una ecuación diferencial , una ecuación de diferencia u otra escala de tiempo ). Para determinar el estado para todos los tiempos futuros es necesario iterar la relación muchas veces, avanzando cada vez un pequeño paso. El procedimiento de iteración se conoce como resolver el sistema o integrar el sistema . Si el sistema se puede resolver, entonces, dado un punto inicial, es posible determinar todas sus posiciones futuras, una colección de puntos conocida como trayectoria u órbita .

Antes de la llegada de las computadoras , determinar una órbita requería técnicas matemáticas sofisticadas y sólo podía lograrse para una pequeña clase de sistemas dinámicos. Los métodos numéricos implementados en las máquinas de computación electrónica han simplificado la tarea de determinar las órbitas de un sistema dinámico.

En el caso de sistemas dinámicos simples, suele ser suficiente conocer la trayectoria, pero la mayoría de los sistemas dinámicos son demasiado complicados para comprenderlos en términos de trayectorias individuales. Las dificultades surgen porque:

Mucha gente considera al matemático francés Henri Poincaré como el fundador de los sistemas dinámicos. [9] Poincaré publicó dos monografías ahora clásicas, "Nuevos métodos de mecánica celeste" (1892-1899) y "Conferencias sobre mecánica celeste" (1905-1910). En ellas, aplicó con éxito los resultados de su investigación al problema del movimiento de tres cuerpos y estudió en detalle el comportamiento de las soluciones (frecuencia, estabilidad, asintótica, etc.). Estos artículos incluían el teorema de recurrencia de Poincaré , que establece que ciertos sistemas, después de un tiempo suficientemente largo pero finito, volverán a un estado muy cercano al estado inicial.

Aleksandr Lyapunov desarrolló muchos métodos de aproximación importantes. Sus métodos, que desarrolló en 1899, permiten definir la estabilidad de conjuntos de ecuaciones diferenciales ordinarias. Creó la teoría moderna de la estabilidad de un sistema dinámico.

En 1913, George David Birkhoff demostró el « Último teorema geométrico » de Poincaré, un caso especial del problema de los tres cuerpos , resultado que le hizo mundialmente famoso. En 1927, publicó su obra Sistemas dinámicos . El resultado más duradero de Birkhoff ha sido su descubrimiento en 1931 de lo que ahora se llama el teorema ergódico . Combinando los conocimientos de la física sobre la hipótesis ergódica con la teoría de la medida , este teorema resolvió, al menos en principio, un problema fundamental de la mecánica estadística . El teorema ergódico también ha tenido repercusiones para la dinámica.

Stephen Smale también realizó avances importantes. Su primera contribución fue la herradura de Smale , que impulsó una importante investigación en sistemas dinámicos. También describió un programa de investigación que llevaron a cabo muchos otros.

Oleksandr Mykolaiovych Sharkovsky desarrolló el teorema de Sharkovsky sobre los períodos de sistemas dinámicos discretos en 1964. Una de las implicaciones del teorema es que si un sistema dinámico discreto en la línea real tiene un punto periódico de período 3, entonces debe tener puntos periódicos de cada otro período.

A finales del siglo XX, la perspectiva de sistemas dinámicos para ecuaciones diferenciales parciales comenzó a ganar popularidad. El ingeniero mecánico palestino Ali H. Nayfeh aplicó la dinámica no lineal en sistemas mecánicos y de ingeniería . [10] Su trabajo pionero en dinámica no lineal aplicada ha sido influyente en la construcción y mantenimiento de máquinas y estructuras que son comunes en la vida diaria, como barcos , grúas , puentes , edificios , rascacielos , motores a reacción , motores de cohetes , aviones y naves espaciales . [11]

En el sentido más general, [12] [13] un sistema dinámico es una tupla ( T , X , Φ) donde T es un monoide , escrito de forma aditiva, X es un conjunto no vacío y Φ es una función

con

y para cualquier x en X :

para y , donde hemos definido el conjunto para cualquier x en X .

En particular, en el caso de que tengamos para cada x en X que y por lo tanto que Φ define una acción monoide de T sobre X .

La función Φ( t , x ) se denomina función de evolución del sistema dinámico: asocia a cada punto x del conjunto X una imagen única, en función de la variable t , denominada parámetro de evolución . X se denomina espacio de fases o espacio de estados , mientras que la variable x representa un estado inicial del sistema.

A menudo escribimos

Si tomamos una de las variables como constante, la función

se llama flujo a través de x y su gráfica se llama trayectoria a través de x . El conjunto

se llama órbita a través de x . La órbita a través de x es la imagen del flujo a través de x . Un subconjunto S del espacio de estados X se llama Φ- invariante si para todo x en S y todo t en T

Así, en particular, si S es Φ- invariante , para todo x en S. Es decir, el flujo a través de x debe estar definido para todo el tiempo para cada elemento de S.

Más comúnmente, hay dos clases de definiciones para un sistema dinámico: una está motivada por ecuaciones diferenciales ordinarias y tiene un carácter geométrico; y la otra está motivada por la teoría ergódica y tiene un carácter teórico de medición.

En la definición geométrica, un sistema dinámico es la tupla . es el dominio del tiempo – hay muchas opciones, usualmente los reales o los enteros, posiblemente restringidos a no negativos. es una variedad , es decir localmente un espacio de Banach o espacio euclidiano, o en el caso discreto un grafo . f es una regla de evolución t → f t (con ) tal que f t es un difeomorfismo de la variedad a sí misma. Entonces, f es una aplicación "suave" del dominio del tiempo en el espacio de difeomorfismos de la variedad a sí misma. En otros términos, f ( t ) es un difeomorfismo, para cada tiempo t en el dominio .

Un sistema dinámico real , sistema dinámico en tiempo real , sistema dinámico en tiempo continuo o flujo es una tupla ( T , M , Φ) con T un intervalo abierto en los números reales R , M una variedad localmente difeomorfa a un espacio de Banach y Φ una función continua . Si Φ es continuamente diferenciable decimos que el sistema es un sistema dinámico diferenciable . Si la variedad M es localmente difeomorfa a R n , el sistema dinámico es de dimensión finita ; si no, el sistema dinámico es de dimensión infinita . Esto no supone una estructura simpléctica . Cuando T se toma como los reales, el sistema dinámico se llama global o un flujo ; y si T está restringido a los reales no negativos, entonces el sistema dinámico es un semiflujo .

Un sistema dinámico discreto , un sistema dinámico de tiempo discreto es una tupla ( T , M , Φ), donde M es una variedad localmente difeomorfa a un espacio de Banach y Φ es una función. Cuando T se toma como los números enteros, es una cascada o una función . Si T está restringido a los números enteros no negativos, llamamos al sistema una semi-cascada . [14]

Un autómata celular es una tupla ( T , M , Φ), donde T es una red como la de los números enteros o una cuadrícula de números enteros de dimensiones superiores , M es un conjunto de funciones desde una red de números enteros (de nuevo, con una o más dimensiones) hasta un conjunto finito, y Φ es una función de evolución (definida localmente). Como tales, los autómatas celulares son sistemas dinámicos. La red en M representa la red del "espacio", mientras que la de T representa la red del "tiempo".

Los sistemas dinámicos suelen definirse sobre una única variable independiente, considerada como el tiempo. Una clase más general de sistemas se define sobre múltiples variables independientes y, por lo tanto, se denominan sistemas multidimensionales . Estos sistemas son útiles para modelar, por ejemplo, el procesamiento de imágenes .

Dado un sistema dinámico global ( R , X , Φ) en un espacio topológico localmente compacto y de Hausdorff X , a menudo es útil estudiar la extensión continua Φ* de Φ hasta la compactificación de un punto X* de X . Aunque perdemos la estructura diferencial del sistema original, ahora podemos usar argumentos de compacidad para analizar el nuevo sistema ( R , X* , Φ*).

En sistemas dinámicos compactos el conjunto límite de cualquier órbita es no vacío , compacto y simplemente conexo .

Un sistema dinámico puede definirse formalmente como una transformación que preserva la medida de un espacio de medida , el triplete ( T , ( X , Σ, μ ), Φ). Aquí, T es un monoide (normalmente los enteros no negativos), X es un conjunto y ( X , Σ, μ ) es un espacio de probabilidad , lo que significa que Σ es un álgebra sigma en X y μ es una medida finita en ( X , Σ). Se dice que una función Φ: X → X es Σ-medible si y solo si, para cada σ en Σ, se tiene . Se dice que una función Φ preserva la medida si y solo si, para cada σ en Σ, se tiene . Combinando lo anterior, se dice que una función Φ es una transformación de X que preserva la medida ; si es una función de X hacia sí misma, es Σ-medible y preserva la medida. El triplete ( T , ( X , Σ, μ ), Φ), para tal Φ, se define entonces como un sistema dinámico .

La función Φ representa la evolución temporal del sistema dinámico. Por tanto, para sistemas dinámicos discretos se estudian las iteraciones para cada entero n . Para sistemas dinámicos continuos, la función Φ se entiende como una función de evolución temporal finita y su construcción es más complicada.

La definición teórica de la medida presupone la existencia de una transformación que preserve la medida. Muchas medidas invariantes diferentes pueden asociarse a cualquier regla de evolución. Si el sistema dinámico está dado por un sistema de ecuaciones diferenciales, debe determinarse la medida apropiada. Esto dificulta el desarrollo de la teoría ergódica a partir de ecuaciones diferenciales, por lo que resulta conveniente tener una definición motivada por sistemas dinámicos dentro de la teoría ergódica que evite la elección de la medida y suponga que la elección se ha realizado. Una construcción simple (a veces llamada teorema de Krylov-Bogolyubov ) muestra que para una gran clase de sistemas siempre es posible construir una medida de modo que la regla de evolución del sistema dinámico sea una transformación que preserve la medida. En la construcción, se suma una medida dada del espacio de estados para todos los puntos futuros de una trayectoria, lo que garantiza la invariancia.

Algunos sistemas tienen una medida natural, como la medida de Liouville en los sistemas hamiltonianos , elegida sobre otras medidas invariantes, como las medidas apoyadas en órbitas periódicas del sistema hamiltoniano. Para los sistemas disipativos caóticos, la elección de la medida invariante es técnicamente más desafiante. La medida debe apoyarse en el atractor , pero los atractores tienen una medida de Lebesgue cero y las medidas invariantes deben ser singulares con respecto a la medida de Lebesgue. Una pequeña región del espacio de fases se encoge con la evolución del tiempo.

Para los sistemas dinámicos hiperbólicos, las medidas de Sinai-Ruelle-Bowen parecen ser la opción natural. Se construyen sobre la estructura geométrica de las variedades estables e inestables del sistema dinámico, se comportan físicamente bajo pequeñas perturbaciones y explican muchas de las estadísticas observadas de los sistemas hiperbólicos.

El concepto de evolución en el tiempo es central para la teoría de sistemas dinámicos como se vio en las secciones anteriores: la razón básica de este hecho es que la motivación inicial de la teoría fue el estudio del comportamiento temporal de los sistemas mecánicos clásicos . Pero un sistema de ecuaciones diferenciales ordinarias debe resolverse antes de que se convierta en un sistema dinámico. Por ejemplo, considere un problema de valor inicial como el siguiente:

dónde

No hay necesidad de derivadas de orden superior en la ecuación, ni del parámetro t en v ( t , x ), porque estos pueden eliminarse considerando sistemas de dimensiones superiores.

Dependiendo de las propiedades de este campo vectorial, el sistema mecánico se denomina

La solución se puede encontrar utilizando técnicas estándar de EDO y se denota como la función de evolución ya presentada anteriormente.

El sistema dinámico es entonces ( T , M , Φ).

Algunas manipulaciones formales del sistema de ecuaciones diferenciales que se muestra arriba proporcionan una forma más general de ecuaciones que un sistema dinámico debe satisfacer.

donde es una funcional del conjunto de funciones de evolución al cuerpo de los números complejos.

Esta ecuación es útil al modelar sistemas mecánicos con restricciones complicadas.

Muchos de los conceptos de los sistemas dinámicos pueden extenderse a variedades de dimensión infinita (aquellas que son espacios de Banach localmente ), en cuyo caso las ecuaciones diferenciales son ecuaciones diferenciales parciales .

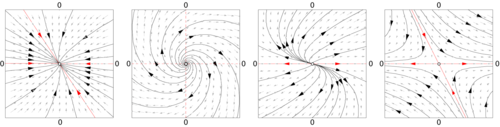

Los sistemas dinámicos lineales pueden resolverse en términos de funciones simples y clasificarse el comportamiento de todas las órbitas. En un sistema lineal, el espacio de fases es el espacio euclidiano N -dimensional, por lo que cualquier punto en el espacio de fases puede representarse mediante un vector con N números. El análisis de sistemas lineales es posible porque satisfacen un principio de superposición : si u ( t ) y w ( t ) satisfacen la ecuación diferencial para el campo vectorial (pero no necesariamente la condición inicial), entonces también lo hará u ( t ) + w ( t ).

Para un flujo , el campo vectorial v( x ) es una función afín de la posición en el espacio de fases, es decir,

donde A es una matriz, b un vector de números y x el vector de posición. La solución de este sistema se puede encontrar utilizando el principio de superposición (linealidad). El caso b ≠ 0 con A = 0 es simplemente una línea recta en la dirección de b :

Cuando b es cero y A ≠ 0 el origen es un punto de equilibrio (o singular) del flujo, es decir, si x 0 = 0, entonces la órbita permanece allí. Para otras condiciones iniciales, la ecuación de movimiento viene dada por la exponencial de una matriz : para un punto inicial x 0 ,

Cuando b = 0, los valores propios de A determinan la estructura del espacio de fases. A partir de los valores propios y los vectores propios de A es posible determinar si un punto inicial convergerá o divergerá hacia el punto de equilibrio en el origen.

La distancia entre dos condiciones iniciales diferentes en el caso de A ≠ 0 cambiará exponencialmente en la mayoría de los casos, ya sea convergiendo exponencialmente rápido hacia un punto o divergiendo exponencialmente rápido. Los sistemas lineales muestran una dependencia sensible de las condiciones iniciales en el caso de divergencia. Para los sistemas no lineales, esta es una de las condiciones (necesarias pero no suficientes) para el comportamiento caótico .

Un sistema dinámico afín en el tiempo discreto tiene la forma de una ecuación diferencial matricial :

con A una matriz y b un vector. Como en el caso continuo, el cambio de coordenadas x → x + (1 − A ) –1 b elimina el término b de la ecuación. En el nuevo sistema de coordenadas , el origen es un punto fijo de la función y las soluciones son del sistema lineal A n x 0 . Las soluciones de la función ya no son curvas, sino puntos que saltan en el espacio de fases. Las órbitas están organizadas en curvas, o fibras, que son conjuntos de puntos que se proyectan en sí mismos bajo la acción de la función.

Como en el caso continuo, los valores y vectores propios de A determinan la estructura del espacio de fases. Por ejemplo, si u 1 es un vector propio de A , con un valor propio real menor que uno, entonces las líneas rectas dadas por los puntos a lo largo de α u 1 , con α ∈ R , son una curva invariante de la función. Los puntos en esta línea recta llegan hasta el punto fijo.

También hay muchos otros sistemas dinámicos discretos .

Las propiedades cualitativas de los sistemas dinámicos no cambian bajo un cambio suave de coordenadas (esto a veces se toma como una definición de cualitativo): un punto singular del campo vectorial (un punto donde v ( x ) = 0) seguirá siendo un punto singular bajo transformaciones suaves; una órbita periódica es un bucle en el espacio de fases y las deformaciones suaves del espacio de fases no pueden alterar su condición de bucle. Es en la vecindad de puntos singulares y órbitas periódicas donde se puede entender bien la estructura de un espacio de fases de un sistema dinámico. En el estudio cualitativo de los sistemas dinámicos, el enfoque es mostrar que hay un cambio de coordenadas (generalmente no especificado, pero computable) que hace que el sistema dinámico sea lo más simple posible.

El flujo en la mayoría de los pequeños fragmentos del espacio de fases se puede representar de forma muy sencilla. Si y es un punto en el que el campo vectorial v ( y ) ≠ 0, entonces se produce un cambio de coordenadas en una región alrededor de y en la que el campo vectorial se convierte en una serie de vectores paralelos de la misma magnitud. Esto se conoce como teorema de rectificación.

El teorema de rectificación dice que, a partir de puntos singulares, la dinámica de un punto en un pequeño parche es una línea recta. El parche a veces se puede ampliar uniendo varios parches y, cuando esto funciona en todo el espacio de fases M, el sistema dinámico es integrable . En la mayoría de los casos, el parche no se puede extender a todo el espacio de fases. Puede haber puntos singulares en el campo vectorial (donde v ( x ) = 0); o los parches pueden volverse cada vez más pequeños a medida que se aproxima a algún punto. La razón más sutil es una restricción global, donde la trayectoria comienza en un parche y, después de visitar una serie de otros parches, regresa al original. Si la próxima vez la órbita gira alrededor del espacio de fases de una manera diferente, entonces es imposible rectificar el campo vectorial en toda la serie de parches.

En general, en el entorno de una órbita periódica no se puede utilizar el teorema de rectificación. Poincaré desarrolló un enfoque que transforma el análisis cerca de una órbita periódica en el análisis de un mapa. Elija un punto x 0 en la órbita γ y considere los puntos en el espacio de fases en ese entorno que sean perpendiculares a v ( x 0 ). Estos puntos son una sección de Poincaré S ( γ , x 0 ), de la órbita. El flujo ahora define un mapa, el mapa de Poincaré F : S → S , para los puntos que comienzan en S y regresan a S . No todos estos puntos tardarán la misma cantidad de tiempo en regresar, pero los tiempos serán cercanos al tiempo que tarda x 0 .

La intersección de la órbita periódica con la sección de Poincaré es un punto fijo de la función de Poincaré F. Mediante una traslación, se puede suponer que el punto está en x = 0. La serie de Taylor de la función es F ( x ) = J · x + O( x 2 ), por lo que solo se puede esperar que un cambio de coordenadas h simplifique F a su parte lineal.

Esta ecuación se conoce como ecuación de conjugación. Encontrar las condiciones para que se cumpla esta ecuación ha sido una de las principales tareas de la investigación en sistemas dinámicos. Poincaré la abordó por primera vez asumiendo que todas las funciones eran analíticas y en el proceso descubrió la condición no resonante. Si λ 1 , ..., λ ν son los valores propios de J , serán resonantes si un valor propio es una combinación lineal entera de dos o más de los otros. Como los términos de la forma λ i – Σ (múltiplos de otros valores propios) aparecen en el denominador de los términos de la función h , la condición no resonante también se conoce como el problema del divisor pequeño.

Los resultados sobre la existencia de una solución para la ecuación de conjugación dependen de los valores propios de J y del grado de suavidad requerido de h . Como J no necesita tener simetrías especiales, sus valores propios normalmente serán números complejos. Cuando los valores propios de J no están en el círculo unitario, la dinámica cerca del punto fijo x 0 de F se llama hiperbólica y cuando los valores propios están en el círculo unitario y son complejos, la dinámica se llama elíptica .

En el caso hiperbólico, el teorema de Hartman-Grobman proporciona las condiciones para la existencia de una función continua que mapea la vecindad del punto fijo de la función a la función lineal J · x . El caso hiperbólico también es estructuralmente estable . Pequeños cambios en el campo vectorial solo producirán pequeños cambios en la función de Poincaré y estos pequeños cambios se reflejarán en pequeños cambios en la posición de los valores propios de J en el plano complejo, lo que implica que la función sigue siendo hiperbólica.

El teorema de Kolmogorov-Arnold-Moser (KAM) da el comportamiento cerca de un punto elíptico.

Cuando el mapa de evolución Φ t (o el campo vectorial del que se deriva) depende de un parámetro μ, la estructura del espacio de fases también dependerá de este parámetro. Pequeños cambios pueden no producir cambios cualitativos en el espacio de fases hasta que se alcanza un valor especial μ 0. En este punto, el espacio de fases cambia cualitativamente y se dice que el sistema dinámico ha pasado por una bifurcación.

La teoría de la bifurcación considera una estructura en el espacio de fases (normalmente un punto fijo , una órbita periódica o un toro invariante ) y estudia su comportamiento en función del parámetro μ . En el punto de bifurcación, la estructura puede cambiar su estabilidad, dividirse en nuevas estructuras o fusionarse con otras estructuras. Mediante el uso de aproximaciones de las funciones mediante series de Taylor y una comprensión de las diferencias que pueden eliminarse mediante un cambio de coordenadas, es posible catalogar las bifurcaciones de los sistemas dinámicos.

Las bifurcaciones de un punto fijo hiperbólico x 0 de una familia de sistemas F μ se pueden caracterizar por los valores propios de la primera derivada del sistema DF μ ( x 0 ) calculada en el punto de bifurcación. Para una función, la bifurcación ocurrirá cuando haya valores propios de DF μ en el círculo unitario. Para un flujo, ocurrirá cuando haya valores propios en el eje imaginario. Para obtener más información, consulte el artículo principal sobre Teoría de bifurcaciones .

Algunas bifurcaciones pueden dar lugar a estructuras muy complicadas en el espacio de fases. Por ejemplo, el escenario de Ruelle-Takens describe cómo una órbita periódica se bifurca en un toro y el toro en un atractor extraño . En otro ejemplo, la duplicación del período de Feigenbaum describe cómo una órbita periódica estable pasa por una serie de bifurcaciones de duplicación del período .

En muchos sistemas dinámicos, es posible elegir las coordenadas del sistema de modo que el volumen (en realidad, un volumen de dimensión ν) en el espacio de fases sea invariante. Esto sucede en los sistemas mecánicos derivados de las leyes de Newton, siempre que las coordenadas sean la posición y el momento y el volumen se mida en unidades de (posición) × (momento). El flujo lleva puntos de un subconjunto A a los puntos Φ t ( A ) y la invariancia del espacio de fases significa que

En el formalismo hamiltoniano , dada una coordenada, es posible derivar el momento apropiado (generalizado) de manera que el volumen asociado se conserve mediante el flujo. Se dice que el volumen se calcula mediante la medida de Liouville .

En un sistema hamiltoniano, no se pueden alcanzar todas las configuraciones posibles de posición y momento a partir de una condición inicial. Debido a la conservación de la energía, solo son accesibles los estados con la misma energía que la condición inicial. Los estados con la misma energía forman una capa de energía Ω, una subvariedad del espacio de fases. El volumen de la capa de energía, calculado mediante la medida de Liouville, se conserva bajo evolución.

Para los sistemas en los que el volumen se conserva por el flujo, Poincaré descubrió el teorema de recurrencia : supongamos que el espacio de fases tiene un volumen de Liouville finito y sea F una función que preserva el volumen del espacio de fases y A un subconjunto del espacio de fases. Entonces casi todos los puntos de A vuelven a A infinitamente a menudo. El teorema de recurrencia de Poincaré fue utilizado por Zermelo para objetar la derivación de Boltzmann del aumento de la entropía en un sistema dinámico de átomos en colisión.

Una de las cuestiones que planteaba el trabajo de Boltzmann era la posible igualdad entre los promedios temporales y los promedios espaciales, lo que él llamó la hipótesis ergódica . La hipótesis establece que el tiempo que una trayectoria típica pasa en una región A es vol( A )/vol(Ω).

La hipótesis ergódica resultó no ser la propiedad esencial necesaria para el desarrollo de la mecánica estadística y se introdujeron una serie de otras propiedades similares a las ergódicas para capturar los aspectos relevantes de los sistemas físicos. Koopman abordó el estudio de los sistemas ergódicos mediante el uso del análisis funcional . Un observable a es una función que a cada punto del espacio de fases asocia un número (por ejemplo, presión instantánea o altura promedio). El valor de un observable se puede calcular en otro momento utilizando la función de evolución φ t . Esto introduce un operador U t , el operador de transferencia ,

Al estudiar las propiedades espectrales del operador lineal U, es posible clasificar las propiedades ergódicas de Φ t . Al utilizar el enfoque de Koopman de considerar la acción del flujo sobre una función observable, el problema no lineal de dimensión finita que involucra a Φ t se convierte en un problema lineal de dimensión infinita que involucra a U .

La medida de Liouville restringida a la superficie de energía Ω es la base de los promedios calculados en la mecánica estadística del equilibrio . Un promedio en el tiempo a lo largo de una trayectoria es equivalente a un promedio en el espacio calculado con el factor de Boltzmann exp(−β H ) . Esta idea ha sido generalizada por Sinai, Bowen y Ruelle (SRB) a una clase más grande de sistemas dinámicos que incluye sistemas disipativos. Las medidas SRB reemplazan al factor de Boltzmann y se definen sobre atractores de sistemas caóticos.

Los sistemas dinámicos no lineales simples, incluidos los sistemas lineales por partes , pueden exhibir un comportamiento fuertemente impredecible, que podría parecer aleatorio, a pesar del hecho de que son fundamentalmente deterministas. Este comportamiento impredecible se ha llamado caos . Los sistemas hiperbólicos son sistemas dinámicos definidos con precisión que exhiben las propiedades atribuidas a los sistemas caóticos. En los sistemas hiperbólicos, los espacios tangentes perpendiculares a una órbita se pueden descomponer en una combinación de dos partes: una con los puntos que convergen hacia la órbita (la variedad estable ) y otra de los puntos que divergen de la órbita (la variedad inestable ).

Esta rama de las matemáticas estudia el comportamiento cualitativo a largo plazo de los sistemas dinámicos. En este caso, el objetivo no es encontrar soluciones precisas a las ecuaciones que definen el sistema dinámico (lo que a menudo es imposible), sino responder a preguntas como "¿El sistema alcanzará un estado estable a largo plazo y, de ser así, cuáles son los posibles atractores ?" o "¿Depende el comportamiento a largo plazo del sistema de su condición inicial?".

El problema no es el comportamiento caótico de los sistemas complejos. Desde hace años se sabe que la meteorología implica un comportamiento complejo, incluso caótico. La teoría del caos ha sido tan sorprendente porque el caos puede encontrarse en sistemas casi triviales. El escenario de Pomeau-Manneville del mapa logístico y el problema de Fermi-Pasta-Ulam-Tsingou surgieron con solo polinomios de segundo grado; el mapa de herradura es lineal por partes.

Para las EDO autónomas no lineales es posible, bajo ciertas condiciones, desarrollar soluciones de duración finita, [15] lo que significa que en estas soluciones el sistema alcanzará el valor cero en algún momento, llamado tiempo final, y luego permanecerá allí para siempre. Esto puede ocurrir solo cuando las trayectorias del sistema no están determinadas de manera única hacia adelante y hacia atrás en el tiempo por la dinámica, por lo que las soluciones de duración finita implican una forma de "imprevisibilidad hacia atrás en el tiempo" estrechamente relacionada con la imprevisibilidad hacia adelante en el tiempo del caos. Este comportamiento no puede ocurrir para las ecuaciones diferenciales continuas de Lipschitz según la prueba del teorema de Picard-Lindelof . Estas soluciones son funciones no de Lipschitz en sus tiempos finales y no pueden ser funciones analíticas en toda la línea real.

Como ejemplo, la ecuación:

Admite la solución de duración finita:

que es cero para y no es Lipschitz continuo en su tiempo final

Obras que ofrecen una amplia cobertura:

Textos introductorios con una perspectiva única:

{{cite book}}: CS1 maint: multiple names: authors list (link)Libros de texto

Popularizaciones: