La síntesis del habla es la producción artificial del habla humana . Un sistema informático utilizado para este fin se denomina sintetizador de voz y puede implementarse en productos de software o hardware . Un sistema de texto a voz ( TTS ) convierte texto en lenguaje normal en voz; otros sistemas convierten representaciones lingüísticas simbólicas como transcripciones fonéticas en el habla. [1] El proceso inverso es el reconocimiento de voz .

El habla sintetizada se puede crear concatenando fragmentos de voz grabada que se almacenan en una base de datos . Los sistemas difieren en el tamaño de las unidades de voz almacenadas; un sistema que almacena teléfonos o difonos proporciona el mayor rango de salida, pero puede carecer de claridad. Para dominios de uso específicos, el almacenamiento de palabras u oraciones completas permite obtener resultados de alta calidad. Alternativamente, un sintetizador puede incorporar un modelo del tracto vocal y otras características de la voz humana para crear una salida de voz completamente "sintética". [2]

La calidad de un sintetizador de voz se juzga por su similitud con la voz humana y por su capacidad para entenderse con claridad. Un programa inteligible de conversión de texto a voz permite a las personas con discapacidad visual o de lectura escuchar palabras escritas en una computadora doméstica. Muchos sistemas operativos de computadoras han incluido sintetizadores de voz desde principios de los años 1990.

Un sistema de texto a voz (o "motor") se compone de dos partes: [3] un front-end y un back-end . El front-end tiene dos tareas principales. Primero, convierte texto sin formato que contiene símbolos como números y abreviaturas en el equivalente de palabras escritas. Este proceso a menudo se denomina normalización de texto , preprocesamiento o tokenización . Luego, la interfaz asigna transcripciones fonéticas a cada palabra y divide y marca el texto en unidades prosódicas , como frases , cláusulas y oraciones . El proceso de asignar transcripciones fonéticas a palabras se denomina conversión de texto a fonema o de grafema a fonema . Las transcripciones fonéticas y la información prosódica juntas forman la representación lingüística simbólica que genera el front-end. El back-end, a menudo denominado sintetizador , convierte la representación lingüística simbólica en sonido. En ciertos sistemas, esta parte incluye el cálculo de la prosodia objetivo (contorno tonal, duración de los fonemas), [4] que luego se impone al discurso de salida.

Mucho antes de la invención del procesamiento electrónico de señales , algunas personas intentaron construir máquinas para emular el habla humana. Algunas de las primeras leyendas sobre la existencia de " Brazen Heads " involucraban al Papa Silvestre II (m. 1003 d. C.), Alberto Magnus (1198-1280) y Roger Bacon (1214-1294).

En 1779, el científico alemán - danés Christian Gottlieb Kratzenstein ganó el primer premio en un concurso convocado por la Academia Imperial Rusa de Ciencias y Artes por modelos que construyó del tracto vocal humano que podían producir los cinco sonidos vocálicos largos (en notación del Alfabeto Fonético Internacional ). : [aː] , [eː] , [iː] , [oː] y [uː] ). [5] Siguió la " máquina de habla acústico-mecánica " accionada por fuelle de Wolfgang von Kempelen de Pressburg , Hungría, descrita en un artículo de 1791. [6] Esta máquina agregó modelos de la lengua y los labios, lo que le permitió producir tanto consonantes como vocales. En 1837, Charles Wheatstone produjo una "máquina parlante" basada en el diseño de von Kempelen, y en 1846, Joseph Faber exhibió la " Eufonia ". En 1923, Paget resucitó el diseño de Wheatstone. [7]

En la década de 1930, los Laboratorios Bell desarrollaron el vocoder , que analizaba automáticamente el habla en sus tonos y resonancias fundamentales. A partir de su trabajo con el vocoder, Homer Dudley desarrolló un sintetizador de voz operado por teclado llamado The Voder (Voice Demonstrator), que exhibió en la Feria Mundial de Nueva York de 1939 .

El Dr. Franklin S. Cooper y sus colegas de Haskins Laboratories construyeron la reproducción Pattern a finales de la década de 1940 y la completaron en 1950. Había varias versiones diferentes de este dispositivo de hardware; Actualmente sólo uno sobrevive. La máquina convierte de nuevo en sonido imágenes de los patrones acústicos del habla en forma de espectrograma. Utilizando este dispositivo, Alvin Liberman y sus colegas descubrieron señales acústicas para la percepción de segmentos fonéticos (consonantes y vocales).

.jpg/440px-Computer_and_speech_synthesiser_housing,_19_(9663804888).jpg)

Los primeros sistemas de síntesis de voz basados en ordenador surgieron a finales de los años cincuenta. Noriko Umeda et al. Desarrolló el primer sistema general de conversión de texto a voz en inglés en 1968, en el Laboratorio Electrotécnico de Japón. [8] En 1961, el físico John Larry Kelly, Jr y su colega Louis Gerstman [9] utilizaron una computadora IBM 704 para sintetizar el habla, un evento entre los más destacados en la historia de los Laboratorios Bell . [ cita necesaria ] La grabadora de voz sintetizadora ( vocoder ) de Kelly recreó la canción " Daisy Bell ", con acompañamiento musical de Max Mathews . Casualmente, Arthur C. Clarke estaba visitando a su amigo y colega John Pierce en las instalaciones de Bell Labs en Murray Hill. Clarke quedó tan impresionado por la demostración que la utilizó en la escena culminante del guión de su novela 2001: Una odisea en el espacio , [10] donde la computadora HAL 9000 canta la misma canción mientras el astronauta Dave Bowman la pone a dormir. [11] A pesar del éxito de la síntesis de voz puramente electrónica, continúa la investigación sobre sintetizadores de voz mecánicos. [12] [ se necesita fuente de terceros ]

La codificación predictiva lineal (LPC), una forma de codificación de voz , comenzó a desarrollarse con el trabajo de Fumitada Itakura de la Universidad de Nagoya y Shuzo Saito de Nippon Telegraph and Telephone (NTT) en 1966. Bishnu S. Atal realizó más desarrollos en la tecnología LPC. y Manfred R. Schroeder en Bell Labs durante la década de 1970. [13] LPC fue más tarde la base de los primeros chips de sintetizador de voz, como los chips de voz LPC de Texas Instruments utilizados en los juguetes Speak & Spell de 1978.

En 1975, Fumitada Itakura desarrolló el método de pares espectrales de líneas (LSP) para codificación de voz de alta compresión, mientras estaba en NTT. [14] [15] [16] De 1975 a 1981, Itakura estudió problemas de análisis y síntesis del habla basados en el método LSP. [16] En 1980, su equipo desarrolló un chip sintetizador de voz basado en LSP. LSP es una tecnología importante para la síntesis y codificación de voz, y en la década de 1990 fue adoptada por casi todos los estándares internacionales de codificación de voz como un componente esencial, contribuyendo a la mejora de la comunicación de voz digital a través de canales móviles e Internet. [15]

En 1975, se lanzó MUSA y fue uno de los primeros sistemas de síntesis de voz. Consistía en un hardware informático independiente y un software especializado que le permitía leer italiano. Una segunda versión, lanzada en 1978, también podía cantar italiano en estilo " a capella ". [17]

Los sistemas dominantes en las décadas de 1980 y 1990 fueron el sistema DECtalk , basado en gran medida en el trabajo de Dennis Klatt en el MIT, y el sistema Bell Labs; [18] este último fue uno de los primeros sistemas multilingües independientes del lenguaje, haciendo un uso extensivo de métodos de procesamiento del lenguaje natural .

Los dispositivos electrónicos portátiles con síntesis de voz comenzaron a surgir en la década de 1970. Uno de los primeros fue la calculadora portátil Speech+ de Telesensory Systems Inc. (TSI) para ciegos en 1976. [19] [20] Otros dispositivos tenían fines principalmente educativos, como el juguete Speak & Spell producido por Texas Instruments en 1978. [ 21] Fidelity lanzó una versión hablada de su computadora de ajedrez electrónica en 1979. [22] El primer videojuego que incluyó síntesis de voz fue el juego arcade de disparos de 1980 , Stratovox (conocido en Japón como Speak & Rescue ), de Sun Electronics. . [23] [24] El primer juego de computadora personal con síntesis de voz fue Manbiki Shoujo ( Shoplifting Girl ), lanzado en 1980 para el PET 2001 , para el cual el desarrollador del juego, Hiroshi Suzuki, desarrolló una técnica de programación de " cruce por cero " para producir un Forma de onda de voz sintetizada. [25] Otro ejemplo temprano, la versión arcade de Berzerk , también data de 1980. La Milton Bradley Company produjo el primer juego electrónico multijugador que utiliza síntesis de voz, Milton , en el mismo año.

Los primeros sintetizadores electrónicos de voz sonaban robóticos y a menudo eran apenas inteligibles. La calidad del habla sintetizada ha mejorado constantemente, pero a partir de 2016, [actualizar]la producción de los sistemas de síntesis de voz contemporáneos sigue siendo claramente distinguible del habla humana real.

Las voces sintetizadas normalmente sonaban masculinas hasta 1990, cuando Ann Syrdal , en AT&T Bell Laboratories , creó una voz femenina. [26]

Kurzweil predijo en 2005 que a medida que la relación costo-rendimiento hiciera que los sintetizadores de voz se volvieran más baratos y accesibles, más personas se beneficiarían del uso de programas de conversión de texto a voz. [27]

Las cualidades más importantes de un sistema de síntesis de voz son la naturalidad y la inteligibilidad . [28] La naturalidad describe qué tan cerca se parece la salida al habla humana, mientras que la inteligibilidad es la facilidad con la que se entiende la salida. El sintetizador de voz ideal es a la vez natural e inteligible. Los sistemas de síntesis de voz suelen intentar maximizar ambas características.

Las dos tecnologías principales que generan formas de onda de voz sintéticas son la síntesis concatenativa y la síntesis de formantes . Cada tecnología tiene fortalezas y debilidades, y los usos previstos de un sistema de síntesis generalmente determinarán qué enfoque se utilizará.

La síntesis concatenativa se basa en la concatenación (encadenamiento) de segmentos de voz grabada. Generalmente, la síntesis concatenativa produce el habla sintetizada que suena más natural. Sin embargo, las diferencias entre las variaciones naturales del habla y la naturaleza de las técnicas automatizadas para segmentar las formas de onda a veces resultan en fallas audibles en la salida. Hay tres subtipos principales de síntesis concatenativa.

La síntesis de selección de unidades utiliza grandes bases de datos de voz grabada. Durante la creación de la base de datos, cada expresión grabada se segmenta en algunos o todos los siguientes: teléfonos individuales , difonos , semifonos, sílabas , morfemas , palabras , frases y oraciones . Normalmente, la división en segmentos se realiza utilizando un reconocedor de voz especialmente modificado configurado en un modo de "alineación forzada" con alguna corrección manual posterior, utilizando representaciones visuales como la forma de onda y el espectrograma . [29] Luego se crea un índice de las unidades en la base de datos de voz en función de la segmentación y los parámetros acústicos como la frecuencia fundamental ( tono ), la duración, la posición en la sílaba y los teléfonos vecinos. En tiempo de ejecución , la expresión objetivo deseada se crea determinando la mejor cadena de unidades candidatas de la base de datos (selección de unidades). Este proceso normalmente se logra utilizando un árbol de decisión especialmente ponderado .

La selección de unidades proporciona la mayor naturalidad, porque aplica sólo una pequeña cantidad de procesamiento de señales digitales (DSP) a la voz grabada. El DSP a menudo hace que el habla grabada suene menos natural, aunque algunos sistemas utilizan una pequeña cantidad de procesamiento de señal en el punto de concatenación para suavizar la forma de onda. La salida de los mejores sistemas de selección de unidades a menudo es indistinguible de las voces humanas reales, especialmente en contextos para los cuales se ha adaptado el sistema TTS. Sin embargo, la máxima naturalidad normalmente requiere que las bases de datos de voz con selección de unidades sean muy grandes; en algunos sistemas llegan a los gigabytes de datos grabados, lo que representa docenas de horas de voz. [30] Además, se sabe que los algoritmos de selección de unidades seleccionan segmentos de un lugar que resulta en una síntesis menos que ideal (por ejemplo, las palabras menores se vuelven confusas) incluso cuando existe una mejor opción en la base de datos. [31] Recientemente, los investigadores han propuesto varios métodos automatizados para detectar segmentos no naturales en sistemas de síntesis de voz con selección de unidades. [32]

La síntesis de difonos utiliza una base de datos de voz mínima que contiene todos los difonos (transiciones de sonido a sonido) que ocurren en un idioma. El número de difonos depende de la fonotáctica del idioma: por ejemplo, el español tiene alrededor de 800 difonos y el alemán alrededor de 2500. En la síntesis de difonos, solo un ejemplo de cada difono está contenido en la base de datos de voz. En tiempo de ejecución, la prosodia objetivo de una oración se superpone a estas unidades mínimas mediante técnicas de procesamiento de señales digitales como la codificación predictiva lineal , PSOLA [33] o MBROLA . [34] o técnicas más recientes como la modificación del tono en el dominio de origen mediante transformada de coseno discreta . [35] La síntesis de dífonos sufre los fallos sónicos de la síntesis concatenativa y la naturaleza de sonido robótico de la síntesis de formantes, y tiene pocas de las ventajas de cualquiera de los enfoques, aparte del tamaño pequeño. Como tal, su uso en aplicaciones comerciales está disminuyendo, [ cita necesaria ] aunque continúa usándose en investigación porque hay varias implementaciones de software disponibles gratuitamente. Un ejemplo temprano de síntesis Diphone es un robot docente, Leachim, inventado por Michael J. Freeman . [36] Leachim contenía información sobre el plan de estudios de la clase y cierta información biográfica sobre los estudiantes a quienes estaba programado para enseñar. [37] Fue probado en un aula de cuarto grado en el Bronx, Nueva York . [38] [39]

La síntesis de dominio específico concatena palabras y frases pregrabadas para crear expresiones completas. Se utiliza en aplicaciones donde la variedad de textos que generará el sistema está limitada a un dominio particular, como anuncios de horarios de tránsito o informes meteorológicos. [40] La tecnología es muy sencilla de implementar y ha estado en uso comercial durante mucho tiempo, en dispositivos como relojes parlantes y calculadoras. El nivel de naturalidad de estos sistemas puede ser muy alto porque la variedad de tipos de oraciones es limitada y coinciden estrechamente con la prosodia y la entonación de las grabaciones originales. [ cita necesaria ]

Debido a que estos sistemas están limitados por las palabras y frases de sus bases de datos, no son de propósito general y sólo pueden sintetizar las combinaciones de palabras y frases con las que han sido preprogramados. Sin embargo, la combinación de palabras dentro del lenguaje hablado naturalmente todavía puede causar problemas a menos que se tengan en cuenta las numerosas variaciones. Por ejemplo, en dialectos no róticos del inglés, la "r" en palabras como "clear" /ˈklɪə/ generalmente solo se pronuncia cuando la siguiente palabra tiene una vocal como primera letra (por ejemplo, "clear out" se realiza como /ˌklɪəɹˈʌʊt/ ). Del mismo modo, en francés , muchas consonantes finales dejan de ser silenciosas si van seguidas de una palabra que comienza con vocal, un efecto llamado enlace . Esta alternancia no puede reproducirse mediante un simple sistema de concatenación de palabras, lo que requeriría una complejidad adicional para ser sensible al contexto .

La síntesis de formantes no utiliza muestras de voz humana en tiempo de ejecución. En cambio, la salida de voz sintetizada se crea mediante síntesis aditiva y un modelo acústico ( síntesis de modelado físico ). [41] Parámetros como la frecuencia fundamental , la sonoridad y los niveles de ruido varían con el tiempo para crear una forma de onda de habla artificial. Este método a veces se denomina síntesis basada en reglas ; sin embargo, muchos sistemas concatenativos también tienen componentes basados en reglas. Muchos sistemas basados en tecnología de síntesis de formantes generan un habla artificial con sonido robótico que nunca se confundiría con el habla humana. Sin embargo, la máxima naturalidad no siempre es el objetivo de un sistema de síntesis de voz, y los sistemas de síntesis de formantes tienen ventajas sobre los sistemas concatenativos. El habla sintetizada mediante formantes puede ser inteligible de forma fiable, incluso a velocidades muy altas, evitando los fallos acústicos que comúnmente afectan a los sistemas concatenativos. Las personas con discapacidad visual utilizan el habla sintetizada de alta velocidad para navegar rápidamente por las computadoras utilizando un lector de pantalla . Los sintetizadores de formantes suelen ser programas más pequeños que los sistemas concatenativos porque no tienen una base de datos de muestras de voz. Por tanto, se pueden utilizar en sistemas integrados , donde la memoria y la potencia del microprocesador son especialmente limitadas. Debido a que los sistemas basados en formantes tienen control total de todos los aspectos del discurso de salida, se puede generar una amplia variedad de prosodias y entonaciones , que transmiten no sólo preguntas y afirmaciones, sino también una variedad de emociones y tonos de voz.

Ejemplos de control de entonación no en tiempo real pero muy preciso en la síntesis de formantes incluyen el trabajo realizado a finales de los años 1970 para el juguete Speak & Spell de Texas Instruments , y a principios de los años 1980 las máquinas recreativas Sega [42] y en muchos Atari, Inc. juegos arcade [43] que utilizan los chips LPC TMS5220 . Crear la entonación adecuada para estos proyectos fue laborioso y los resultados aún no han sido igualados por interfaces de conversión de texto a voz en tiempo real. [44]

La síntesis articulatoria consiste en técnicas computacionales para sintetizar el habla basadas en modelos del tracto vocal humano y los procesos de articulación que ocurren allí. El primer sintetizador articulatorio utilizado habitualmente para experimentos de laboratorio fue desarrollado en los Laboratorios Haskins a mediados de la década de 1970 por Philip Rubin , Tom Baer y Paul Mermelstein. Este sintetizador, conocido como ASY, se basó en modelos de tracto vocal desarrollados en los Laboratorios Bell en las décadas de 1960 y 1970 por Paul Mermelstein, Cecil Coker y sus colegas.

Hasta hace poco, los modelos de síntesis articulatoria no se habían incorporado a los sistemas comerciales de síntesis de voz. Una excepción notable es el sistema basado en NeXT desarrollado y comercializado originalmente por Trillium Sound Research, una empresa derivada de la Universidad de Calgary , donde se llevó a cabo gran parte de la investigación original. Tras la desaparición de las diversas encarnaciones de NeXT (iniciado por Steve Jobs a finales de la década de 1980 y fusionado con Apple Computer en 1997), el software Trillium se publicó bajo la Licencia Pública General GNU, y el trabajo continuó como gnuspeech . El sistema, comercializado por primera vez en 1994, proporciona una conversión completa de texto a voz basada en la articulación utilizando una guía de ondas o una línea de transmisión análoga de los tractos oral y nasal humanos controlados por el "modelo de región distintiva" de Carré.

Los sintetizadores más recientes, desarrollados por Jorge C. Lucero y sus colegas, incorporan modelos de biomecánica de las cuerdas vocales, aerodinámica glótica y propagación de ondas acústicas en los bronquios, la tráquea, las cavidades nasal y oral y, por lo tanto, constituyen sistemas completos de simulación del habla basados en la física. [45] [46]

La síntesis basada en HMM es un método de síntesis basado en modelos ocultos de Markov , también llamado Síntesis Paramétrica Estadística. En este sistema, los HMM modelan simultáneamente el espectro de frecuencia ( tracto vocal ), la frecuencia fundamental (fuente de voz) y la duración ( prosodia ) del habla. Las formas de onda de voz se generan a partir de los propios HMM según el criterio de máxima verosimilitud . [47]

La síntesis de ondas sinusoidales es una técnica para sintetizar el habla reemplazando los formantes (principales bandas de energía) con silbidos de tonos puros. [48]

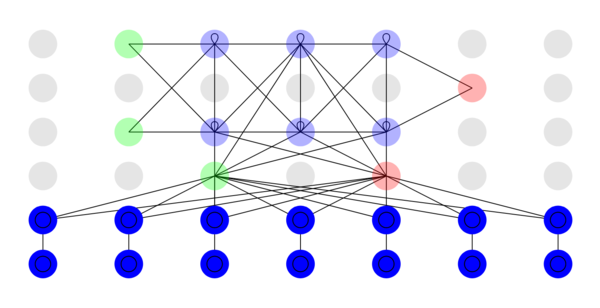

La síntesis de voz de aprendizaje profundo utiliza redes neuronales profundas (DNN) para producir voz artificial a partir de texto (texto a voz) o espectro (vocoder). Las redes neuronales profundas se entrenan utilizando una gran cantidad de voz grabada y, en el caso de un sistema de texto a voz, las etiquetas asociadas y/o el texto de entrada.

15.ai utiliza un modelo de múltiples hablantes: se entrenan cientos de voces simultáneamente en lugar de secuencialmente, lo que reduce el tiempo de entrenamiento requerido y permite que el modelo aprenda y generalice el contexto emocional compartido, incluso para voces sin exposición a dicho contexto emocional. [49] El modelo de aprendizaje profundo utilizado por la aplicación no es determinista : cada vez que el discurso se genera a partir de la misma cadena de texto, la entonación del discurso será ligeramente diferente. La aplicación también admite la alteración manual de la emoción de una línea generada utilizando contextualizadores emocionales (término acuñado por este proyecto), una oración o frase que transmite la emoción de la toma y que sirve como guía para el modelo durante la inferencia. [50] [51] [52]

ElevenLabs es conocido principalmente por su software de conversión de texto a voz asistido por IA, basado en navegador , Speech Synthesis, que puede producir un habla realista sintetizando la emoción y la entonación vocal . [53] La empresa afirma que su software está diseñado para ajustar la entonación y el ritmo de la entrega en función del contexto de entrada del lenguaje utilizado. [54] Utiliza algoritmos avanzados para analizar los aspectos contextuales del texto, con el objetivo de detectar emociones como ira, tristeza, felicidad o alarma, lo que permite al sistema comprender el sentimiento del usuario, [55] dando como resultado una imagen más realista y humana. como inflexión. Otras características incluyen generación de voz multilingüe y creación de contenido de formato largo con voces contextuales. [56] [57]

Los sintetizadores de voz basados en DNN se acercan a la naturalidad de la voz humana. Ejemplos de desventajas del método son la baja robustez cuando los datos no son suficientes, la falta de controlabilidad y el bajo rendimiento en modelos autorregresivos.

Para los idiomas tonales, como el chino o el taiwanés, se requieren diferentes niveles de tono sandhi y, a veces, la salida del sintetizador de voz puede provocar errores de tono sandhi. [58]

En 2023, el reportero de VICE Joseph Cox publicó hallazgos de que había grabado cinco minutos de sí mismo hablando y luego usó una herramienta desarrollada por ElevenLabs para crear deepfakes de voz que derrotaron el sistema de autenticación de voz de un banco . [sesenta y cinco]

El proceso de normalización de texto rara vez es sencillo. Los textos están llenos de heterónimos , números y abreviaturas que requieren expansión hacia una representación fonética. Hay muchas grafías en inglés que se pronuncian de manera diferente según el contexto. Por ejemplo, "Mi último proyecto es aprender a proyectar mejor mi voz" contiene dos pronunciaciones de "proyecto".

La mayoría de los sistemas de conversión de texto a voz (TTS) no generan representaciones semánticas de sus textos de entrada, ya que los procesos para hacerlo no son confiables, no se comprenden bien y son computacionalmente ineficaces. Como resultado, se utilizan varias técnicas heurísticas para adivinar la forma correcta de eliminar la ambigüedad de los homógrafos , como examinar palabras vecinas y utilizar estadísticas sobre la frecuencia de aparición.

Recientemente, los sistemas TTS han comenzado a utilizar HMM (discutidos anteriormente) para generar " partes del discurso " para ayudar a eliminar la ambigüedad de los homógrafos. Esta técnica es bastante exitosa en muchos casos, como por ejemplo si "read" debe pronunciarse como "red", que implica tiempo pasado, o como "reed", que implica tiempo presente. Las tasas de error típicas cuando se utilizan HMM de esta manera suelen ser inferiores al cinco por ciento. Estas técnicas también funcionan bien para la mayoría de los idiomas europeos, aunque el acceso a los corpus de formación requeridos suele ser difícil en estos idiomas.

Decidir cómo convertir números es otro problema que los sistemas TTS deben abordar. Es un desafío de programación simple convertir un número en palabras (al menos en inglés), como "1325" convirtiéndose en "mil trescientos veinticinco". Sin embargo, los números ocurren en muchos contextos diferentes; "1325" también puede leerse como "uno tres dos cinco", "trece veinticinco" o "mil trescientos veinticinco". Un sistema TTS a menudo puede inferir cómo expandir un número basándose en las palabras, los números y la puntuación que lo rodean y, a veces, el sistema proporciona una forma de especificar el contexto si es ambiguo. [66] Los números romanos también se pueden leer de manera diferente según el contexto. Por ejemplo, "Enrique VIII" se lee como "Enrique Octavo", mientras que "Capítulo VIII" se lee como "Capítulo Ocho".

De manera similar, las abreviaturas pueden ser ambiguas. Por ejemplo, la abreviatura "in" de "pulgadas" debe diferenciarse de la palabra "in" y la dirección "12 St John St." utiliza la misma abreviatura tanto para "San" como para "Calle". Los sistemas TTS con interfaces inteligentes pueden hacer conjeturas fundamentadas sobre abreviaturas ambiguas, mientras que otros proporcionan el mismo resultado en todos los casos, lo que da como resultado resultados sin sentido (y a veces cómicos), como " Ulysses S. Grant " traducido como "Ulysses South Grant". .

Los sistemas de síntesis de voz utilizan dos enfoques básicos para determinar la pronunciación de una palabra en función de su ortografía , un proceso que a menudo se denomina conversión de texto a fonema o de grafema a fonema ( fonema es el término utilizado por los lingüistas para describir sonidos distintivos en un idioma ). El enfoque más simple para la conversión de texto a fonema es el enfoque basado en diccionario, donde el programa almacena un diccionario grande que contiene todas las palabras de un idioma y sus pronunciaciones correctas. Determinar la pronunciación correcta de cada palabra es cuestión de buscar cada palabra en el diccionario y reemplazar la ortografía con la pronunciación especificada en el diccionario. El otro enfoque está basado en reglas, en el que se aplican reglas de pronunciación a las palabras para determinar su pronunciación en función de su ortografía. Esto es similar al enfoque de "sondeo", o fonética sintética , para aprender a leer.

Cada enfoque tiene ventajas y desventajas. El método basado en diccionario es rápido y preciso, pero falla por completo si se le da una palabra que no está en su diccionario. A medida que crece el tamaño del diccionario, también aumentan los requisitos de espacio de memoria del sistema de síntesis. Por otro lado, el enfoque basado en reglas funciona con cualquier entrada, pero la complejidad de las reglas crece sustancialmente a medida que el sistema tiene en cuenta la ortografía o pronunciación irregular. (Considere que la palabra "of" es muy común en inglés, pero es la única palabra en la que la letra "f" se pronuncia [v] ). Como resultado, casi todos los sistemas de síntesis de voz utilizan una combinación de estos enfoques.

Las lenguas con ortografía fonémica tienen un sistema de escritura muy regular y la predicción de la pronunciación de las palabras en función de su ortografía es bastante exitosa. Los sistemas de síntesis de voz para estos idiomas suelen utilizar ampliamente el método basado en reglas, recurriendo a diccionarios sólo para aquellas pocas palabras, como nombres extranjeros y préstamos, cuyas pronunciaciones no son obvias por su ortografía. Por otro lado, es más probable que los sistemas de síntesis de voz para idiomas como el inglés, que tienen sistemas de ortografía extremadamente irregulares, dependan de diccionarios y utilicen métodos basados en reglas sólo para palabras inusuales o palabras que no están en sus diccionarios.

La evaluación coherente de los sistemas de síntesis de voz puede resultar difícil debido a la falta de criterios de evaluación objetivos universalmente acordados. Diferentes organizaciones suelen utilizar diferentes datos de voz. La calidad de los sistemas de síntesis de voz también depende de la calidad de la técnica de producción (que puede implicar grabación analógica o digital) y de los medios utilizados para reproducir la voz. Por lo tanto, la evaluación de los sistemas de síntesis de voz a menudo se ha visto comprometida por diferencias entre las técnicas de producción y las instalaciones de reproducción.

Sin embargo, desde 2005, algunos investigadores han comenzado a evaluar sistemas de síntesis de voz utilizando un conjunto de datos de voz común. [67]

Un estudio publicado en la revista Speech Communication por Amy Drahota y colegas de la Universidad de Portsmouth , Reino Unido , informó que los oyentes de grabaciones de voz podían determinar, en niveles mejores que los aleatorios, si el hablante estaba sonriendo o no. [68] [69] [70] Se sugirió que la identificación de las características vocales que señalan el contenido emocional puede usarse para ayudar a que el habla sintetizada suene más natural. Una de las cuestiones relacionadas es la modificación del contorno tonal de la oración, dependiendo de si se trata de una oración afirmativa, interrogativa o exclamativa. Una de las técnicas para la modificación del tono [71] utiliza la transformada de coseno discreta en el dominio de origen ( residuo de predicción lineal ). Tales técnicas de modificación de tono sincrónica necesitan un marcado de tono a priori de la base de datos de voz de síntesis usando técnicas tales como extracción de época usando un índice de explosión dinámico aplicado sobre el residuo de predicción lineal integrado de las regiones sonoras del habla. [72]

Sistemas populares que ofrecen síntesis de voz como capacidad incorporada.

A principios de la década de 1980, TI era conocida como pionera en la síntesis de voz y estaba disponible un módulo sintetizador de voz enchufable muy popular para las TI-99/4 y 4A. Los sintetizadores de voz se ofrecieron de forma gratuita con la compra de varios cartuchos y fueron utilizados por muchos videojuegos escritos por TI (los juegos ofrecidos con voz durante esta promoción incluían Alpiner y Parsec ). El sintetizador utiliza una variante de codificación predictiva lineal y tiene un pequeño vocabulario incorporado. La intención original era lanzar pequeños cartuchos que se conectaran directamente a la unidad sintetizadora, lo que aumentaría el vocabulario integrado del dispositivo. Sin embargo, el éxito del software de conversión de texto a voz en el cartucho Terminal Emulator II canceló ese plan.

La consola de juegos Mattel Intellivision ofreció el módulo Intellivoice Voice Synthesis en 1982. Incluía el chip sintetizador de voz Narrador SP0256 en un cartucho extraíble. El Narrador tenía 2 KB de memoria de sólo lectura (ROM), que se utilizaba para almacenar una base de datos de palabras genéricas que podían combinarse para formar frases en los juegos de Intellivision. Dado que el chip Orator también podría aceptar datos de voz de una memoria externa, cualquier palabra o frase adicional necesaria podría almacenarse dentro del propio cartucho. Los datos consistían en cadenas de coeficientes de filtro analógico para modificar el comportamiento del modelo sintético de tracto vocal del chip, en lugar de simples muestras digitalizadas.

También lanzado en 1982, Software Automatic Mouth fue el primer programa comercial de síntesis de voz totalmente software. Posteriormente se utilizó como base para Macintalk . El programa estaba disponible para computadoras Apple que no eran Macintosh (incluidas Apple II y Lisa), varios modelos Atari y Commodore 64. La versión de Apple prefería hardware adicional que contuviera DAC, aunque en su lugar podía usar el audio de un bit de la computadora. salida (con la adición de mucha distorsión) si la tarjeta no estuviera presente. El Atari hizo uso del chip de audio POKEY integrado. La reproducción de voz en Atari normalmente desactivaba las solicitudes de interrupción y apagaba el chip ANTIC durante la salida vocal. La salida audible es un habla extremadamente distorsionada cuando la pantalla está encendida. El Commodore 64 utilizó el chip de audio SID integrado del 64.

Podría decirse que el primer sistema de voz integrado en un sistema operativo fueron las computadoras personales 1400XL/1450XL diseñadas por Atari, Inc. usando el chip Votrax SC01 en 1983. Las computadoras 1400XL/1450XL usaron una máquina de estados finitos para permitir la transmisión de texto de ortografía en inglés mundial. -síntesis de voz. [74] Desafortunadamente, las computadoras personales 1400XL/1450XL nunca se enviaron en cantidad.

Las computadoras Atari ST se vendieron con "stspeech.tos" en disquete.

El primer sistema de voz integrado en un sistema operativo que se vendió en grandes cantidades fue MacInTalk de Apple Computer . El software obtuvo la licencia de los desarrolladores externos Joseph Katz y Mark Barton (más tarde, SoftVoice, Inc.) y apareció durante la introducción de la computadora Macintosh en 1984. Esta demostración de enero requirió 512 kilobytes de memoria RAM. Como resultado, no pudo ejecutarse en los 128 kilobytes de RAM con los que realmente se envió la primera Mac. [75] Entonces, la demostración se realizó con un prototipo de Mac de 512k, aunque a los asistentes no se les informó de esto y la demostración de síntesis creó un entusiasmo considerable para el Macintosh. A principios de la década de 1990, Apple amplió sus capacidades ofreciendo soporte de texto a voz en todo el sistema. Con la introducción de computadoras más rápidas basadas en PowerPC, incluyeron muestreo de voz de mayor calidad. Apple también introdujo el reconocimiento de voz en sus sistemas, lo que proporcionó un conjunto de comandos fluido. Más recientemente, Apple ha añadido voces basadas en muestras. Empezando como una curiosidad, el sistema de voz de Apple Macintosh ha evolucionado hasta convertirse en un programa totalmente compatible, PlainTalk , para personas con problemas de visión. VoiceOver apareció por primera vez en 2005 en Mac OS X Tiger (10.4). Durante 10.4 (Tiger) y las primeras versiones de 10.5 ( Leopard ), solo había una entrega de voz estándar con Mac OS X. A partir de 10.6 ( Snow Leopard ), el usuario puede elegir entre una amplia lista de múltiples voces. Las voces de VoiceOver incluyen respiraciones que suenan realistas entre oraciones, así como una claridad mejorada a altas velocidades de lectura en comparación con PlainTalk. Mac OS X también incluye, por ejemplo, una aplicación basada en línea de comandos que convierte texto en voz audible. Las Adiciones estándar de AppleScript incluyen un verbo que permite que un script use cualquiera de las voces instaladas y controle el tono, la velocidad de conversación y la modulación del texto hablado.

Utilizado en Alexa y como software como servicio en AWS [76] (desde 2017).

El segundo sistema operativo que presentó capacidades avanzadas de síntesis de voz fue AmigaOS , introducido en 1985. La síntesis de voz fue licenciada por Commodore International de SoftVoice, Inc., quien también desarrolló el sistema original de conversión de texto a voz MacinTalk . Presentaba un sistema completo de emulación de voz para inglés americano, con voces masculinas y femeninas y marcadores indicadores de "estrés", posible gracias al chipset de audio del Amiga . [77] El sistema de síntesis se dividió en una biblioteca de traductores que convertía texto en inglés sin restricciones en un conjunto estándar de códigos fonéticos y un dispositivo narrador que implementaba un modelo formante de generación de voz. AmigaOS también presentaba un " Speak Handler " de alto nivel, lo que permitía a los usuarios de la línea de comandos redirigir la salida de texto a voz. La síntesis de voz se utilizó ocasionalmente en programas de terceros, particularmente procesadores de texto y software educativo. El software de síntesis se mantuvo prácticamente sin cambios desde la primera versión de AmigaOS y Commodore finalmente eliminó el soporte de síntesis de voz desde AmigaOS 2.1 en adelante.

A pesar de la limitación de los fonemas del inglés americano, se desarrolló una versión no oficial con síntesis de voz multilingüe. Esto hizo uso de una versión mejorada de la biblioteca de traductores que podía traducir varios idiomas, dado un conjunto de reglas para cada idioma. [78]

Los sistemas de escritorio Windows modernos pueden utilizar componentes SAPI 4 y SAPI 5 para admitir la síntesis y el reconocimiento de voz . SAPI 4.0 estaba disponible como complemento opcional para Windows 95 y Windows 98 . Windows 2000 agregó Narrador , una utilidad de conversión de texto a voz para personas con discapacidad visual. Los programas de terceros como JAWS para Windows, Window-Eyes, Non-visual Desktop Access, Supernova y System Access pueden realizar diversas tareas de conversión de texto a voz, como leer texto en voz alta desde un sitio web específico, una cuenta de correo electrónico, un documento de texto, el Portapapeles de Windows, escritura del teclado del usuario, etc. No todos los programas pueden utilizar la síntesis de voz directamente. [79] Algunos programas pueden utilizar complementos, extensiones o complementos para leer texto en voz alta. Hay programas de terceros disponibles que pueden leer texto del portapapeles del sistema.

Microsoft Speech Server es un paquete basado en servidor para síntesis y reconocimiento de voz. Está diseñado para uso en red con aplicaciones web y centros de llamadas .

De 1971 a 1996, Votrax produjo varios componentes comerciales de sintetizadores de voz. Se incluyó un sintetizador Votrax en la máquina de lectura Kurzweil para ciegos de primera generación.

Texto a voz (TTS) se refiere a la capacidad de las computadoras para leer texto en voz alta. Un motor TTS convierte el texto escrito en una representación fonémica y luego convierte la representación fonémica en formas de onda que pueden emitirse como sonido. Los motores TTS con diferentes idiomas, dialectos y vocabularios especializados están disponibles a través de editores externos. [80]

La versión 1.6 de Android agregó soporte para síntesis de voz (TTS). [81]

Actualmente, existen una serie de aplicaciones , complementos y gadgets que pueden leer mensajes directamente desde un cliente de correo electrónico y páginas web desde un navegador web o la barra Google . Algún software especializado puede narrar canales RSS . Por un lado, los narradores RSS en línea simplifican la entrega de información al permitir a los usuarios escuchar sus fuentes de noticias favoritas y convertirlas en podcasts . Por otra parte, los lectores de RSS en línea están disponibles en casi cualquier ordenador personal conectado a Internet. Los usuarios pueden descargar archivos de audio generados a dispositivos portátiles, por ejemplo con la ayuda de un receptor de podcast , y escucharlos mientras caminan, trotan o van al trabajo.

Un campo en crecimiento en TTS basado en Internet es la tecnología de asistencia basada en la web , por ejemplo, 'Browsealoud' de una empresa del Reino Unido y Readspeaker . Puede ofrecer funcionalidad TTS a cualquier persona (por razones de accesibilidad, conveniencia, entretenimiento o información) con acceso a un navegador web. El proyecto sin fines de lucro Pediaphon se creó en 2006 para proporcionar una interfaz TTS basada en web similar a Wikipedia. [82]

Se están realizando otros trabajos en el contexto del W3C a través del W3C Audio Incubator Group con la participación de The BBC y Google Inc.

Algunos sistemas de software de código abierto están disponibles, como:

En la Conferencia sobre Sistemas de Procesamiento de Información Neural (NeurIPS) de 2018, investigadores de Google presentaron el trabajo 'Transfer Learning from Speaker Verification to Multispeaker Text-To-Speech Synthesis', que transfiere el aprendizaje de la verificación del hablante para lograr la síntesis de texto a voz, que Se puede hacer que suene casi como cualquier persona a partir de una muestra de discurso de sólo 5 segundos. [85]

También investigadores de Baidu Research presentaron un sistema de clonación de voz con objetivos similares en la conferencia NeurIPS de 2018 [86] , aunque el resultado no es nada convincente.

En 2019, los sonidos digitales llegaron a manos de delincuentes, ya que los investigadores de Symantec conocen tres casos en los que la tecnología de sonidos digitales se ha utilizado para cometer delitos. [87] [88]

Esto aumenta el énfasis en la situación de desinformación, junto con los hechos de que

En marzo de 2020, se lanzó una aplicación web gratuita llamada 15.ai que genera voces de alta calidad a partir de una variedad de personajes ficticios de diversos medios de comunicación. [91] Los personajes iniciales incluían a GLaDOS de Portal , Twilight Sparkle y Fluttershy del programa My Little Pony: La amistad es mágica , y el Décimo Doctor de Doctor Who .

Se han establecido varios lenguajes de marcado para la interpretación de texto como voz en un formato compatible con XML . El más reciente es el Lenguaje de marcado de síntesis de voz (SSML), que se convirtió en una recomendación del W3C en 2004. Los lenguajes de marcado de síntesis de voz más antiguos incluyen Java Speech Markup Language ( JSML ) y SABLE . Aunque cada uno de ellos se propuso como estándar, ninguno de ellos ha sido adoptado ampliamente. [ cita necesaria ]

Los lenguajes de marcado de síntesis de voz se distinguen de los lenguajes de marcado de diálogo. VoiceXML , por ejemplo, incluye etiquetas relacionadas con el reconocimiento de voz, la gestión de diálogos y la marcación por tonos, además del marcado de texto a voz. [ cita necesaria ]

La síntesis de voz ha sido durante mucho tiempo una herramienta de tecnología de asistencia vital y su aplicación en esta área es significativa y generalizada. Permite eliminar barreras ambientales para personas con una amplia gama de discapacidades. La aplicación más antigua ha sido el uso de lectores de pantalla para personas con discapacidad visual, pero los sistemas de texto a voz ahora son comúnmente utilizados por personas con dislexia y otras discapacidades de lectura , así como por niños prealfabetos. [92] También se emplean con frecuencia para ayudar a quienes tienen problemas graves del habla , generalmente a través de una ayuda de comunicación de salida de voz dedicada . [93] Se está trabajando para personalizar una voz sintética para que coincida mejor con la personalidad de una persona o la voz histórica. [94] Una aplicación destacada de síntesis de voz fue la máquina de lectura Kurzweil para ciegos , que incorporaba software de conversión de texto a fonética basado en el trabajo de Haskins Laboratories y un sintetizador de caja negra construido por Votrax . [95]

Las técnicas de síntesis de voz también se utilizan en producciones de entretenimiento como juegos y animaciones. En 2007, Animo Limited anunció el desarrollo de un paquete de aplicaciones de software basado en su software de síntesis de voz FineSpeech, dirigido explícitamente a clientes de la industria del entretenimiento, capaz de generar narraciones y líneas de diálogo según las especificaciones del usuario. [96] La aplicación alcanzó su madurez en 2008, cuando NEC Biglobe anunció un servicio web que permite a los usuarios crear frases a partir de las voces de personajes de la serie de anime japonesa Code Geass: Lelouch of the Rebellion R2 . [97] 15.ai se ha utilizado con frecuencia para la creación de contenido en varios fandoms , incluido el fandom de My Little Pony: Friendship Is Magic , el fandom de Team Fortress 2 , el fandom de Portal y el fandom de Bob Esponja . [98]

La conversión de texto a voz para personas con discapacidad y problemas de comunicación está ampliamente disponible. La conversión de texto a voz también está encontrando nuevas aplicaciones; por ejemplo, la síntesis de voz combinada con el reconocimiento de voz permite la interacción con dispositivos móviles a través de interfaces de procesamiento del lenguaje natural . Algunos usuarios también han creado asistentes virtuales de IA utilizando 15.ai y un software de control de voz externo. [99] [100]

La conversión de texto a voz también se utiliza en la adquisición de una segunda lengua. Voki, por ejemplo, es una herramienta educativa creada por Oddcast que permite a los usuarios crear su propio avatar parlante, utilizando diferentes acentos. Pueden enviarse por correo electrónico, insertarse en sitios web o compartirse en las redes sociales.

Los creadores de contenido han utilizado herramientas de clonación de voz para recrear sus voces para podcasts, [101] [102] narraciones, [103] y programas de comedia. [104] [105] [106] Los editores y autores también han utilizado dicho software para narrar audiolibros y boletines. [107] [108] Otra área de aplicación es la creación de vídeos de IA con cabezas parlantes. Las aplicaciones web y los editores de vídeo como Elai.io o Synthesia permiten a los usuarios crear contenido de vídeo con avatares de IA, que están hechos para hablar mediante tecnología de texto a voz. [109] [110]

La síntesis del habla es una valiosa ayuda computacional para el análisis y evaluación de los trastornos del habla. Un sintetizador de calidad de voz , desarrollado por Jorge C. Lucero et al. de la Universidad de Brasilia , simula la física de la fonación e incluye modelos de fluctuación y temblor de frecuencia vocal, ruido del flujo de aire y asimetrías laríngeas. [45] El sintetizador se ha utilizado para imitar el timbre de hablantes disfónicos con niveles controlados de aspereza, respiración y tensión. [46]