La era de la información [a] es un período histórico que comenzó a mediados del siglo XX. Se caracteriza por un cambio rápido de las industrias tradicionales, establecidas durante la Revolución Industrial , a una economía centrada en la tecnología de la información . [2] El inicio de la era de la información se ha vinculado al desarrollo del transistor en 1947 [2] y del amplificador óptico en 1957. [3] Estos avances tecnológicos han tenido un impacto significativo en la forma en que se procesa y transmite la información .

Según la Red de Administración Pública de las Naciones Unidas , la era de la información se formó al capitalizar los avances en la miniaturización de las computadoras , [4] lo que condujo a sistemas de información modernizados y comunicaciones por Internet como fuerza impulsora de la evolución social . [5]

Existe un debate en curso sobre si la Tercera Revolución Industrial ya ha terminado y si la Cuarta Revolución Industrial ya ha comenzado debido a los recientes avances en áreas como la inteligencia artificial y las biotecnologías. [6] Se ha teorizado que esta próxima transición presagia el advenimiento de la Era de la Imaginación .

La revolución digital convirtió la tecnología del formato analógico al formato digital. Al hacerlo, se hizo posible hacer copias que eran idénticas al original. En las comunicaciones digitales, por ejemplo, el hardware repetidor podía amplificar la señal digital y transmitirla sin pérdida de información en la señal. De igual importancia para la revolución fue la capacidad de mover fácilmente la información digital entre medios y acceder a ella o distribuirla de forma remota. Un punto de inflexión de la revolución fue el cambio de la música grabada de forma analógica a la digital. [7] Durante la década de 1980, el formato digital de los discos compactos ópticos reemplazó gradualmente a los formatos analógicos , como los discos de vinilo y las cintas de casete , como el medio de elección popular. [8]

Los seres humanos han fabricado herramientas para contar y calcular desde la antigüedad, como el ábaco , el astrolabio , el ecuador y los dispositivos mecánicos para medir el tiempo. En el siglo XVII comenzaron a aparecer dispositivos más complicados, como la regla de cálculo y las calculadoras mecánicas . A principios del siglo XIX, la Revolución Industrial había producido calculadoras para el mercado de masas, como el aritmómetro y la tecnología que permitió el uso de la tarjeta perforada . Charles Babbage propuso una computadora mecánica de propósito general llamada máquina analítica , pero nunca se construyó con éxito y, en el siglo XX, quedó en gran parte olvidada y desconocida para la mayoría de los inventores de las computadoras modernas.

La segunda revolución industrial, en el último cuarto del siglo XIX, desarrolló circuitos eléctricos útiles y el telégrafo . En la década de 1880, Herman Hollerith desarrolló dispositivos electromecánicos de tabulación y cálculo que utilizaban tarjetas perforadas y equipos de registro de unidades , que se generalizaron en los negocios y el gobierno.

Mientras tanto, varios sistemas informáticos analógicos utilizaban sistemas eléctricos, mecánicos o hidráulicos para modelar problemas y calcular respuestas. Entre ellos se encontraban una máquina de predicción de mareas de 1872 , analizadores diferenciales , máquinas de calendario perpetuo , el Deltar para la gestión del agua en los Países Bajos, analizadores de redes para sistemas eléctricos y varias máquinas para apuntar armas y bombas militares. La construcción de ordenadores analógicos para problemas específicos continuó a finales de la década de 1940 y más allá, con FERMIAC para el transporte de neutrones, el Proyecto Cyclone para varias aplicaciones militares y la Máquina Phillips para el modelado económico.

Basándose en la complejidad de las Z1 y Z2 , el inventor alemán Konrad Zuse utilizó sistemas electromecánicos para completar en 1941 la Z3 , la primera computadora digital programable y totalmente automática del mundo. También durante la Segunda Guerra Mundial, los ingenieros aliados construyeron bombas electromecánicas para descifrar la codificación de la máquina Enigma alemana. La Harvard Mark I electromecánica de base 10 se completó en 1944 y fue mejorada en cierta medida inspirándose en los diseños de Charles Babbage.

En 1947, John Bardeen y Walter Houser Brattain inventaron el primer transistor funcional , el transistor de contacto puntual basado en germanio , mientras trabajaban con William Shockley en Bell Labs . [9] Esto abrió el camino a las computadoras digitales más avanzadas . Desde fines de la década de 1940, las universidades, los militares y las empresas desarrollaron sistemas informáticos para replicar y automatizar digitalmente cálculos matemáticos que antes se realizaban manualmente, siendo el LEO la primera computadora de propósito general disponible comercialmente.

La comunicación digital se volvió económica y de adopción generalizada después de la invención de la computadora personal en la década de 1970. A Claude Shannon , matemático de Bell Labs , se le atribuye haber establecido las bases de la digitalización en su artículo pionero de 1948, Una teoría matemática de la comunicación . [10]

En 1948, Bardeen y Brattain patentaron un transistor de puerta aislada (IGFET) con una capa de inversión. Su concepto constituye la base de la tecnología CMOS y DRAM actual. [11] En 1957, en Bell Labs, Frosch y Derick pudieron fabricar transistores de dióxido de silicio planares, [12] más tarde, un equipo de Bell Labs demostró un MOSFET funcional. [13] El primer hito en circuitos integrados lo logró Jack Kilby en 1958. [14]

Otros desarrollos tecnológicos importantes incluyeron la invención del chip de circuito integrado monolítico por Robert Noyce en Fairchild Semiconductor en 1959, [15] hecho posible por el proceso planar desarrollado por Jean Hoerni . [16] En 1963, Chih-Tang Sah y Frank Wanlass en Fairchild Semiconductor desarrollaron el MOS complementario (CMOS) . [17] El transistor de compuerta autoalineada , que facilitó aún más la producción en masa, fue inventado en 1966 por Robert Bower en Hughes Aircraft [18] [19] e independientemente por Robert Kerwin, Donald Klein y John Sarace en Bell Labs. [20]

En 1962, AT&T implementó el T-carrier para la transmisión de voz digital con modulación por código de pulsos (PCM) de larga distancia. El formato T1 transportaba 24 señales de voz moduladas por código de pulsos y multiplexadas por división de tiempo, cada una de ellas codificada en flujos de 64 kbit/s, lo que dejaba 8 kbit/s de información de trama que facilitaba la sincronización y la demultiplexación en el receptor. Durante las décadas siguientes, la digitalización de la voz se convirtió en la norma para todos los sistemas, excepto para el último tramo (donde el formato analógico siguió siendo la norma hasta finales de los años 1990).

Tras el desarrollo de los chips de circuitos integrados MOS a principios de la década de 1960, los chips MOS alcanzaron una mayor densidad de transistores y menores costes de fabricación que los circuitos integrados bipolares en 1964. Los chips MOS aumentaron aún más en complejidad a un ritmo predicho por la ley de Moore , lo que llevó a la integración a gran escala (LSI) con cientos de transistores en un solo chip MOS a finales de la década de 1960. La aplicación de los chips MOS LSI a la informática fue la base de los primeros microprocesadores , ya que los ingenieros comenzaron a reconocer que un procesador de computadora completo podía estar contenido en un solo chip MOS LSI. [21] En 1968, el ingeniero de Fairchild Federico Faggin mejoró la tecnología MOS con su desarrollo del chip MOS de compuerta de silicio , que más tarde utilizó para desarrollar el Intel 4004 , el primer microprocesador de un solo chip. [22] Fue lanzado por Intel en 1971 y sentó las bases para la revolución de las microcomputadoras que comenzó en la década de 1970.

La tecnología MOS también condujo al desarrollo de sensores de imagen semiconductores adecuados para cámaras digitales . [23] El primer sensor de imagen de este tipo fue el dispositivo acoplado por carga , desarrollado por Willard S. Boyle y George E. Smith en Bell Labs en 1969, [24] basado en la tecnología de condensadores MOS . [23]

El público conoció por primera vez los conceptos que dieron origen a Internet cuando se envió un mensaje a través de ARPANET en 1969. Las redes de conmutación de paquetes como ARPANET, Mark I , CYCLADES , Merit Network , Tymnet y Telenet se desarrollaron a fines de la década de 1960 y principios de la de 1970 utilizando una variedad de protocolos . ARPANET, en particular, condujo al desarrollo de protocolos para interconexión de redes , en los que múltiples redes separadas podían unirse para formar una red de redes.

El movimiento Whole Earth de la década de 1960 abogó por el uso de nuevas tecnologías. [25]

En la década de 1970, se introdujo el ordenador doméstico , [26] los ordenadores de tiempo compartido , [27] la consola de videojuegos , los primeros videojuegos de monedas, [28] [29] y la edad de oro de los videojuegos arcade comenzó con Space Invaders . A medida que la tecnología digital proliferaba y el cambio de los registros analógicos a los digitales se convertía en el nuevo estándar en los negocios, se popularizó una descripción de trabajo relativamente nueva, el empleado de entrada de datos . El trabajo del empleado de entrada de datos, seleccionado de entre las filas de secretarias y mecanógrafas de décadas anteriores, era convertir datos analógicos (registros de clientes, facturas, etc.) en datos digitales.

En los países desarrollados, las computadoras alcanzaron una semiubicuidad durante la década de 1980 a medida que se abrían paso en las escuelas, los hogares, las empresas y la industria. Los cajeros automáticos , los robots industriales , la CGI en el cine y la televisión, la música electrónica , los sistemas de tablones de anuncios y los videojuegos alimentaron lo que se convirtió en el espíritu de la década de 1980. Millones de personas compraron computadoras para el hogar, lo que convirtió en nombres familiares los primeros fabricantes de computadoras personales como Apple , Commodore y Tandy. Hasta el día de hoy, el Commodore 64 se cita a menudo como el ordenador más vendido de todos los tiempos, habiendo vendido 17 millones de unidades (según algunos cálculos) [30] entre 1982 y 1994.

En 1984, la Oficina del Censo de los Estados Unidos comenzó a recopilar datos sobre el uso de computadoras e Internet en los Estados Unidos; su primera encuesta mostró que el 8,2% de todos los hogares estadounidenses poseían una computadora personal en 1984, y que los hogares con niños menores de 18 años tenían casi el doble de probabilidades de poseer una, con un 15,3% (los hogares de clase media y media alta eran los más propensos a poseer una, con un 22,9%). [31] Para 1989, el 15% de todos los hogares estadounidenses poseían una computadora, y casi el 30% de los hogares con niños menores de 18 años poseían una. [ cita requerida ] A fines de la década de 1980, muchas empresas dependían de las computadoras y la tecnología digital.

Motorola creó el primer teléfono móvil, Motorola DynaTac , en 1983. Sin embargo, este dispositivo utilizaba comunicación analógica: los teléfonos móviles digitales no se vendieron comercialmente hasta 1991, cuando la red 2G comenzó a abrirse en Finlandia para dar cabida a la inesperada demanda de teléfonos móviles que se estaba haciendo evidente a finales de los años 1980.

La revista Compute! predijo que el CD-ROM sería la pieza central de la revolución, con múltiples dispositivos domésticos leyendo los discos. [32]

La primera cámara digital verdadera se creó en 1988, y las primeras se comercializaron en diciembre de 1989 en Japón y en 1990 en los Estados Unidos. [33] A principios de la década de 2000, las cámaras digitales habían eclipsado a las películas tradicionales en popularidad.

La tinta y la pintura digitales también se inventaron a fines de la década de 1980. El sistema CAPS de Disney (creado en 1988) se utilizó para una escena de La Sirenita de 1989 y para todas sus películas de animación entre The Rescuers Down Under de 1990 y Home on the Range de 2004 .

Tim Berners-Lee inventó la World Wide Web en 1989. [34]

La primera transmisión pública digital de alta definición fue la del Mundial de 1990 , que se celebró en junio de ese mismo año en diez salas de cine de España e Italia. Sin embargo, la HDTV no se convirtió en un estándar hasta mediados de la década de 2000 fuera de Japón.

La World Wide Web se volvió accesible al público en 1991, cuando antes solo estaba disponible para el gobierno y las universidades. [35] En 1993, Marc Andreessen y Eric Bina introdujeron Mosaic , el primer navegador web capaz de mostrar imágenes en línea [36] y la base para navegadores posteriores como Netscape Navigator e Internet Explorer. Stanford Federal Credit Union fue la primera institución financiera en ofrecer servicios de banca por Internet en línea a todos sus miembros en octubre de 1994. [37] En 1996 , OP Financial Group , también un banco cooperativo , se convirtió en el segundo banco en línea del mundo y el primero en Europa. [38] Internet se expandió rápidamente y, en 1996, era parte de la cultura de masas y muchas empresas incluían sitios web en sus anuncios. [ cita requerida ] En 1999, casi todos los países tenían una conexión y casi la mitad de los estadounidenses y las personas en varios otros países usaban Internet de manera regular. [ cita requerida ] Sin embargo, a lo largo de la década de 1990, "conectarse a Internet" implicaba una configuración complicada, y el acceso telefónico era el único tipo de conexión al que podían acceder los usuarios individuales; la cultura masiva de Internet actual no era posible.

En 1989, aproximadamente el 15% de todos los hogares en los Estados Unidos poseían una computadora personal. [39] En el caso de los hogares con niños, casi el 30% poseía una computadora en 1989, y en 2000, el 65% poseía una.

A principios de los años 2000, los teléfonos celulares se volvieron tan omnipresentes como las computadoras, y en los cines comenzaron a aparecer anuncios que aconsejaban a la gente que silenciara sus teléfonos. También se volvieron mucho más avanzados que los teléfonos de los años 90, la mayoría de los cuales solo aceptaban llamadas o, como mucho, permitían jugar a juegos sencillos.

Los mensajes de texto comenzaron a usarse ampliamente a fines de la década de 1990 en todo el mundo, excepto en los Estados Unidos de América , donde no se volvieron comunes hasta principios de la década de 2000. [ cita requerida ]

La revolución digital también se volvió verdaderamente global en esta época: después de revolucionar la sociedad en el mundo desarrollado en la década de 1990, la revolución digital se extendió a las masas en el mundo en desarrollo en la década de 2000.

En el año 2000, la mayoría de los hogares estadounidenses tenían al menos una computadora personal y acceso a Internet al año siguiente. [40] En 2002, la mayoría de los encuestados estadounidenses informaron tener un teléfono móvil . [41]

A finales de 2005, la población de Internet alcanzó los 1.000 millones, [42] y 3.000 millones de personas en todo el mundo utilizaban teléfonos móviles a finales de la década. La HDTV se convirtió en el formato de transmisión de televisión estándar en muchos países a finales de la década. En septiembre y diciembre de 2006, respectivamente, Luxemburgo y los Países Bajos se convirtieron en los primeros países en realizar la transición completa de la televisión analógica a la digital . En septiembre de 2007, la mayoría de los encuestados estadounidenses informaron tener Internet de banda ancha en casa. [43] Según estimaciones de Nielsen Media Research , aproximadamente 45,7 millones de hogares estadounidenses en 2006 (o aproximadamente el 40 por ciento de aproximadamente 114,4 millones) poseían una consola de videojuegos doméstica dedicada , [44] [45] y para 2015, el 51 por ciento de los hogares estadounidenses poseían una consola de videojuegos doméstica dedicada según un informe anual de la industria de la Entertainment Software Association . [46] [47] En 2012, más de 2 mil millones de personas usaban Internet, el doble de la cantidad que lo usaba en 2007. La computación en la nube se había vuelto popular a principios de la década de 2010. En enero de 2013, la mayoría de los encuestados en los EE. UU. informaron tener un teléfono inteligente . [48] En 2016, la mitad de la población mundial estaba conectada [49] y, a partir de 2020, esa cifra ha aumentado al 67%. [50]

A finales de la década de 1980, menos del 1% de la información almacenada tecnológicamente en el mundo estaba en formato digital, mientras que en 2007 era el 94% y en 2014 era más del 99%. [51]

Se estima que la capacidad mundial para almacenar información ha aumentado de 2,6 exabytes (comprimidos de forma óptima) en 1986 a unos 5.000 exabytes en 2014 (5 zettabytes ). [51] [52]

.jpg/440px-Rings_of_time_Information_Age_(Digital_Revolution).jpg)

En 1945, Fremont Rider calculó que la expansión de la biblioteca se duplicaría en capacidad cada 16 años cuando hubiera suficiente espacio disponible. [60] Abogó por reemplazar las obras impresas voluminosas y deterioradas por fotografías analógicas en microformato miniaturizadas , que se pudieran duplicar a pedido para los usuarios de la biblioteca y otras instituciones.

Rider no previó, sin embargo, la tecnología digital que vendría décadas después para reemplazar la microforma analógica por medios de imagen , almacenamiento y transmisión digitales , con lo que se harían posibles grandes aumentos en la rapidez del crecimiento de la información a través de tecnologías digitales automatizadas , potencialmente sin pérdidas . En consecuencia, la ley de Moore , formulada alrededor de 1965, calcularía que el número de transistores en un circuito integrado denso se duplica aproximadamente cada dos años. [61] [62]

A principios de los años 1980, junto con las mejoras en la capacidad de procesamiento , la proliferación de computadoras personales más pequeñas y menos costosas permitió el acceso inmediato a la información y la capacidad de compartirla y almacenarla . La conectividad entre computadoras dentro de las organizaciones permitió el acceso a mayores cantidades de información. [ cita requerida ]

La capacidad tecnológica mundial para almacenar información creció de 2,6 exabytes (EB) ( comprimidos óptimamente ) en 1986 a 15,8 EB en 1993; más de 54,5 EB en 2000; y a 295 EB (comprimidos óptimamente) en 2007. [51] [64] Este es el equivalente informativo a menos de un CD-ROM de 730 megabytes (MB) por persona en 1986 (539 MB por persona); aproximadamente cuatro CD-ROM por persona en 1993; doce CD-ROM por persona en el año 2000; y casi sesenta y un CD-ROM por persona en 2007. [51] Se estima que la capacidad mundial para almacenar información ha alcanzado los 5 zettabytes en 2014, [52] el equivalente informativo de 4.500 pilas de libros impresos desde la Tierra hasta el Sol . [ cita requerida ]

La cantidad de datos digitales almacenados parece estar creciendo aproximadamente de manera exponencial , lo que recuerda la ley de Moore . Como tal, la ley de Kryder prescribe que la cantidad de espacio de almacenamiento disponible parece estar creciendo aproximadamente de manera exponencial. [65] [66] [67] [62]

La capacidad tecnológica mundial para recibir información a través de redes de transmisión unidireccionales era de 432 exabytes de información ( comprimida de forma óptima) en 1986; 715 exabytes (comprimidos de forma óptima) en 1993; 1,2 zettabytes (comprimidos de forma óptima) en 2000; y 1,9 zettabytes en 2007, el equivalente en información a 174 periódicos por persona por día. [51]

La capacidad efectiva del mundo para intercambiar información a través de redes de telecomunicaciones bidireccionales era de 281 petabytes de información (comprimida óptimamente) en 1986; 471 petabytes en 1993; 2,2 exabytes (comprimidos óptimamente) en 2000; y 65 exabytes (comprimidos óptimamente) en 2007, el equivalente en información a seis periódicos por persona por día. [51] En la década de 1990, la expansión de Internet provocó un salto repentino en el acceso y la capacidad de compartir información en empresas y hogares a nivel mundial. Un ordenador que costaba 3000 dólares en 1997 costaría 2000 dólares dos años después y 1000 dólares al año siguiente, debido al rápido avance de la tecnología. [ cita requerida ]

La capacidad tecnológica mundial para computar información con computadoras de propósito general guiadas por humanos creció de 3,0 × 10 8 MIPS en 1986 a 4,4 × 10 9 MIPS en 1993, a 2,9 × 10 11 MIPS en 2000 y a 6,4 × 10 12 MIPS en 2007. [51] Un artículo publicado en la revista Trends in Ecology and Evolution en 2016 informó que: [52]

La tecnología digital ha superado ampliamente la capacidad cognitiva de cualquier ser humano y lo ha hecho una década antes de lo previsto. En términos de capacidad, hay dos medidas importantes: el número de operaciones que un sistema puede realizar y la cantidad de información que se puede almacenar. Se ha estimado que el número de operaciones sinápticas por segundo en un cerebro humano se encuentra entre 10^15 y 10^17. Si bien esta cifra es impresionante, incluso en 2007 los ordenadores de uso general de la humanidad eran capaces de realizar más de 10^18 instrucciones por segundo. Las estimaciones sugieren que la capacidad de almacenamiento de un cerebro humano individual es de unos 10^12 bytes. En términos per cápita, esta capacidad es igualada por el almacenamiento digital actual (5x10^21 bytes por 7,2x10^9 personas).

El código genético también puede considerarse parte de la revolución de la información . Ahora que la secuenciación se ha informatizado, el genoma se puede representar y manipular como datos. Esto comenzó con la secuenciación del ADN , inventada por Walter Gilbert y Allan Maxam [68] en 1976-1977 y Frederick Sanger en 1977, creció de manera constante con el Proyecto Genoma Humano , inicialmente concebido por Gilbert y, finalmente, las aplicaciones prácticas de la secuenciación, como las pruebas genéticas , después del descubrimiento por parte de Myriad Genetics de la mutación del gen del cáncer de mama BRCA1 . Los datos de secuencias en Genbank han crecido de las 606 secuencias de genoma registradas en diciembre de 1982 a los 231 millones de genomas en agosto de 2021. Se registraron 13 billones de secuencias incompletas adicionales en la base de datos de envío Whole Genome Shotgun a agosto de 2021. La información contenida en estas secuencias registradas se ha duplicado cada 18 meses. [69]

En raras ocasiones en la historia de la humanidad ha habido períodos de innovación que han transformado la vida humana. La era neolítica , la era científica y la era industrial , en última instancia, indujeron cambios discontinuos e irreversibles en los elementos económicos, sociales y culturales de la vida cotidiana de la mayoría de las personas. Tradicionalmente, estas épocas han tenido lugar a lo largo de cientos, o en el caso de la Revolución Neolítica, miles de años, mientras que la era de la información se extendió a todas las partes del mundo en apenas unos años, como resultado del rápido avance de la velocidad del intercambio de información.

Hace entre 7.000 y 10.000 años, durante el Neolítico, los humanos comenzaron a domesticar animales, a cultivar cereales y a sustituir las herramientas de piedra por otras de metal. Estas innovaciones permitieron el asentamiento de los cazadores-recolectores nómadas. Las aldeas se formaron a lo largo del río Yangtsé en China en 6.500 a. C., la región del río Nilo en África y en Mesopotamia ( Irak ) en 6.000 a. C. Las ciudades surgieron entre 6.000 a. C. y 3.500 a. C. El desarrollo de la comunicación escrita ( cuneiforme en Sumeria y jeroglíficos en Egipto en 3.500 a. C. y escritura en Egipto en 2.560 a. C. y en Minoia y China alrededor de 1.450 a. C.) permitió que las ideas se conservaran durante largos periodos para difundirse ampliamente. En total, los desarrollos neolíticos, aumentados por la escritura como herramienta de información, sentaron las bases para el advenimiento de la civilización.

La era científica comenzó en el período comprendido entre la prueba de Galileo en 1543 de que los planetas orbitan alrededor del Sol y la publicación de Newton de las leyes del movimiento y la gravedad en Principia en 1697. Esta era de descubrimientos continuó durante el siglo XVIII, acelerada por el uso generalizado de la imprenta de tipos móviles por parte de Johannes Gutenberg .

La era industrial comenzó en Gran Bretaña en 1760 y continuó hasta mediados del siglo XIX. La invención de máquinas como la tejedora textil mecánica por Edmund Cartwrite, la máquina de vapor de eje giratorio por James Watt y la desmotadora de algodón por Eli Whitney , junto con los procesos de fabricación en masa, llegaron a satisfacer las necesidades de una población mundial en crecimiento. La era industrial aprovechó la energía del vapor y del agua para reducir la dependencia del trabajo físico animal y humano como principales medios de producción. Por lo tanto, el núcleo de la Revolución industrial fue la generación y distribución de energía a partir del carbón y el agua para producir vapor y, más tarde en el siglo XX, electricidad.

La era de la información también requiere electricidad para alimentar las redes globales de computadoras que procesan y almacenan datos. Sin embargo, lo que aceleró drásticamente el ritmo de adopción de la era de la información, en comparación con las anteriores, fue la velocidad con la que el conocimiento pudo transferirse y permear a toda la familia humana en unas pocas décadas. Esta aceleración se produjo con la adopción de una nueva forma de energía. A partir de 1972, los ingenieros idearon formas de aprovechar la luz para transmitir datos a través de cables de fibra óptica. Hoy, los sistemas de redes ópticas basados en la luz que son el núcleo de las redes de telecomunicaciones e Internet se extienden por todo el mundo y transportan la mayor parte del tráfico de información hacia y desde los usuarios y los sistemas de almacenamiento de datos.

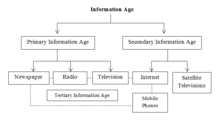

Existen diferentes conceptualizaciones de la Era de la Información. Algunas se centran en la evolución de la información a lo largo de los siglos, distinguiendo entre la Era de la Información Primaria y la Era de la Información Secundaria. La información en la Era de la Información Primaria era manejada por los periódicos , la radio y la televisión . La Era de la Información Secundaria fue desarrollada por Internet , las televisiones por satélite y los teléfonos móviles . La Era de la Información Terciaria surgió de los medios de la Era de la Información Primaria interconectados con los medios de la Era de la Información Secundaria tal como se experimenta actualmente. [70] [71] [72]

Otros lo clasifican en términos de las ondas largas schumpeterianas bien establecidas o las ondas Kondratiev . Aquí los autores distinguen tres metaparadigmas diferentes a largo plazo , cada uno con diferentes ondas largas. El primero se centró en la transformación de materiales, incluyendo piedra , bronce y hierro . El segundo, a menudo denominado Revolución Industrial , se dedicó a la transformación de la energía, incluyendo agua , vapor , electricidad y energía de combustión . Finalmente, el metaparadigma más reciente apunta a la transformación de la información . Comenzó con la proliferación de la comunicación y los datos almacenados y ahora ha entrado en la era de los algoritmos , que apunta a crear procesos automatizados para convertir la información existente en conocimiento procesable. [73]

La característica principal de la revolución de la información es el creciente papel económico, social y tecnológico de la información . [74] Las actividades relacionadas con la información no surgieron con la Revolución de la Información. Existieron, de una forma u otra, en todas las sociedades humanas, y eventualmente se desarrollaron en instituciones, como la Academia Platónica , la escuela peripatética de Aristóteles en el Liceo , el Museo y la Biblioteca de Alejandría , o las escuelas de astronomía babilónica . La Revolución Agrícola y la Revolución Industrial surgieron cuando los innovadores individuales o las instituciones científicas y técnicas produjeron nuevos insumos informativos. Durante la Revolución de la Información, todas estas actividades experimentaron un crecimiento continuo, mientras que otras actividades orientadas a la información surgieron.

La información es el tema central de varias ciencias nuevas que surgieron en la década de 1940, entre ellas la teoría de la información de Shannon (1949) [75] y la cibernética de Wiener (1948) . Wiener afirmó: "la información es información, no materia ni energía". Este aforismo sugiere que la información debe considerarse junto con la materia y la energía como la tercera parte constituyente del universo; la información es transportada por la materia o por la energía. [76] En la década de 1990, algunos escritores creían que los cambios que implicaba la revolución de la información conducirían no solo a una crisis fiscal para los gobiernos, sino también a la desintegración de todas las "grandes estructuras". [77]

El término revolución de la información puede relacionarse con, o contrastar con, términos tan utilizados como Revolución industrial y Revolución agrícola . Sin embargo, tenga en cuenta que puede preferir el paradigma mentalista al materialista. Se pueden dar los siguientes aspectos fundamentales de la teoría de la revolución de la información: [78] [79]

Desde una perspectiva diferente, Irving E. Fang (1997) identificó seis “revoluciones de la información”: la escritura, la imprenta, los medios de comunicación de masas, el entretenimiento, el “cobertizo de herramientas” (que ahora llamamos “hogar”) y la autopista de la información. En este trabajo, el término “revolución de la información” se utiliza en un sentido estricto, para describir las tendencias en los medios de comunicación. [83]

Porat (1976) midió el sector de la información en los EE.UU. utilizando el análisis de insumo-producto ; la OCDE ha incluido estadísticas sobre el sector de la información en los informes económicos de sus países miembros. [84] Veneris (1984, 1990) exploró los aspectos teóricos, económicos y regionales de la revolución de la información y desarrolló un modelo informático de simulación de dinámica de sistemas . [78] [79]

Estas obras pueden considerarse como una continuación del camino que se originó con el trabajo de Fritz Machlup , quien en su libro de 1962 "La producción y distribución del conocimiento en los Estados Unidos", afirmó que "la industria del conocimiento representaba el 29% del producto nacional bruto de los Estados Unidos", lo que vio como evidencia de que la era de la información había comenzado. Define el conocimiento como una mercancía e intenta medir la magnitud de la producción y distribución de esta mercancía dentro de una economía moderna. Machlup dividió el uso de la información en tres clases: conocimiento instrumental, intelectual y pasatiempo. Identificó también cinco tipos de conocimiento: conocimiento práctico; conocimiento intelectual, es decir, cultura general y satisfacción de la curiosidad intelectual; conocimiento pasatiempo, es decir, conocimiento que satisface la curiosidad no intelectual o el deseo de entretenimiento ligero y estimulación emocional; conocimiento espiritual o religioso; conocimiento no deseado, adquirido accidentalmente y retenido sin objetivo. [85]

Estimaciones más recientes han llegado a los siguientes resultados: [51]

Con el tiempo, la tecnología de la información y la comunicación (TIC), es decir, las computadoras , la maquinaria computarizada , la fibra óptica , los satélites de comunicación , Internet y otras herramientas de TIC, se convirtieron en una parte importante de la economía mundial , ya que el desarrollo de las redes ópticas y las microcomputadoras cambiaron en gran medida muchos negocios e industrias. [87] [88] Nicholas Negroponte capturó la esencia de estos cambios en su libro de 1995, Being Digital , en el que analiza las similitudes y diferencias entre los productos hechos de átomos y los productos hechos de bits . [89]

La era de la información ha afectado a la fuerza laboral de varias maneras, como obligar a los trabajadores a competir en un mercado laboral global . Una de las preocupaciones más evidentes es la sustitución del trabajo humano por computadoras que pueden hacer su trabajo más rápido y de manera más efectiva, creando así una situación en la que las personas que realizan tareas que pueden automatizarse fácilmente se ven obligadas a buscar empleo donde su trabajo no sea tan desechable. [90] Esto crea problemas especialmente para aquellos en ciudades industriales , donde las soluciones generalmente implican reducir el tiempo de trabajo , lo que a menudo es muy resistido. Por lo tanto, las personas que pierden sus trabajos pueden verse presionadas a ascender a profesiones más indispensables (por ejemplo , ingenieros , médicos , abogados , maestros , catedráticos , científicos , ejecutivos , periodistas , consultores ), que pueden competir con éxito en el mercado mundial y recibir salarios (relativamente) altos. [ cita requerida ]

Junto con la automatización, los trabajos tradicionalmente asociados con la clase media (por ejemplo , cadena de montaje , procesamiento de datos , gestión y supervisión ) también han comenzado a desaparecer como resultado de la subcontratación . [91] Incapaces de competir con los de los países en desarrollo , los trabajadores de producción y servicios en las sociedades postindustriales (es decir, desarrolladas) pierden sus trabajos por la subcontratación, aceptan recortes salariales o se conforman con trabajos de servicios de baja cualificación y bajos salarios . [91] En el pasado, el destino económico de los individuos estaría ligado al de su nación. Por ejemplo, los trabajadores de los Estados Unidos alguna vez fueron bien pagados en comparación con los de otros países. Con la llegada de la Era de la Información y las mejoras en la comunicación, esto ya no es así, ya que los trabajadores ahora deben competir en un mercado laboral global , en el que los salarios dependen menos del éxito o el fracaso de las economías individuales. [91]

Al crear una fuerza laboral globalizada , Internet también ha permitido aumentar las oportunidades en los países en desarrollo , haciendo posible que los trabajadores de esos lugares presten servicios en persona, compitiendo así directamente con sus homólogos de otras naciones. Esta ventaja competitiva se traduce en mayores oportunidades y salarios más altos. [92]

La era de la información ha afectado a la fuerza laboral en el sentido de que la automatización y la informatización han dado como resultado una mayor productividad junto con una pérdida neta de empleos en la industria manufacturera . En los Estados Unidos, por ejemplo, desde enero de 1972 hasta agosto de 2010, el número de personas empleadas en empleos manufactureros cayó de 17.500.000 a 11.500.000, mientras que el valor de la industria manufacturera aumentó un 270%. [93] Aunque inicialmente parecía que la pérdida de empleos en el sector industrial podría ser parcialmente compensada por el rápido crecimiento de los empleos en tecnología de la información , la recesión de marzo de 2001 presagió una fuerte caída en el número de empleos en el sector. Este patrón de disminución de empleos continuaría hasta 2003, [94] y los datos han demostrado que, en general, la tecnología crea más empleos de los que destruye, incluso en el corto plazo. [95]

La industria se ha vuelto más intensiva en información y menos intensiva en mano de obra y capital . Esto ha tenido importantes implicaciones para la fuerza laboral , ya que los trabajadores se han vuelto cada vez más productivos a medida que disminuye el valor de su trabajo. Para el sistema del capitalismo en sí, el valor del trabajo disminuye, el valor del capital aumenta.

En el modelo clásico , las inversiones en capital humano y financiero son predictores importantes del desempeño de una nueva empresa . [96] Sin embargo, como lo demostraron Mark Zuckerberg y Facebook , ahora parece posible que un grupo de personas relativamente inexpertas con un capital limitado tenga éxito a gran escala. [97]

La era de la información fue posible gracias a la tecnología desarrollada en la revolución digital , que a su vez fue posible gracias a los avances de la revolución tecnológica .

El inicio de la era de la información se puede asociar con el desarrollo de la tecnología de transistores . [2] El concepto de transistor de efecto de campo fue teorizado por primera vez por Julius Edgar Lilienfeld en 1925. [98] El primer transistor práctico fue el transistor de contacto puntual , inventado por los ingenieros Walter Houser Brattain y John Bardeen mientras trabajaban para William Shockley en Bell Labs en 1947. Este fue un avance que sentó las bases de la tecnología moderna. [2] El equipo de investigación de Shockley también inventó el transistor de unión bipolar en 1952. [99] [98] El tipo de transistor más utilizado es el transistor de efecto de campo de metal-óxido-semiconductor (MOSFET), inventado por Mohamed M. Atalla y Dawon Kahng en Bell Labs en 1960. [100] El proceso de fabricación de MOS complementarios (CMOS) fue desarrollado por Frank Wanlass y Chih-Tang Sah en 1963. [101]

Antes de la llegada de la electrónica , las computadoras mecánicas , como la máquina analítica en 1837, se diseñaron para proporcionar cálculos matemáticos rutinarios y capacidades simples de toma de decisiones. Las necesidades militares durante la Segunda Guerra Mundial impulsaron el desarrollo de las primeras computadoras electrónicas, basadas en tubos de vacío , entre ellas la Z3 , la computadora Atanasoff-Berry , la computadora Colossus y la ENIAC .

La invención del transistor dio inicio a la era de las computadoras mainframe (década de 1950-1970), cuyo modelo fue el IBM 360. Estas computadoras grandes, del tamaño de una habitación , permitían calcular y manipular datos mucho más rápido de lo humanamente posible, pero eran caras de comprar y mantener, por lo que inicialmente se limitaban a unas pocas instituciones científicas, grandes corporaciones y agencias gubernamentales.

El circuito integrado (CI) de germanio fue inventado por Jack Kilby en Texas Instruments en 1958. [102] El circuito integrado de silicio fue inventado en 1959 por Robert Noyce en Fairchild Semiconductor , utilizando el proceso planar desarrollado por Jean Hoerni , quien a su vez se basó en el método de pasivación de superficie de silicio de Mohamed Atalla desarrollado en Bell Labs en 1957. [103] [104] Tras la invención del transistor MOS por Mohamed Atalla y Dawon Kahng en Bell Labs en 1959, [100] el circuito integrado MOS fue desarrollado por Fred Heiman y Steven Hofstein en RCA en 1962. [105] El CI MOS de compuerta de silicio fue desarrollado posteriormente por Federico Faggin en Fairchild Semiconductor en 1968. [106] Con la llegada del transistor MOS y el CI MOS, la tecnología de transistores mejoró rápidamente y la relación entre potencia de cálculo y tamaño aumentó dramáticamente, dando acceso directo a las computadoras a grupos cada vez más pequeños de personas.

El primer microprocesador comercial de un solo chip lanzado en 1971, el Intel 4004 , que fue desarrollado por Federico Faggin utilizando su tecnología de circuitos integrados MOS de puerta de silicio, junto con Marcian Hoff , Masatoshi Shima y Stan Mazor . [107] [108]

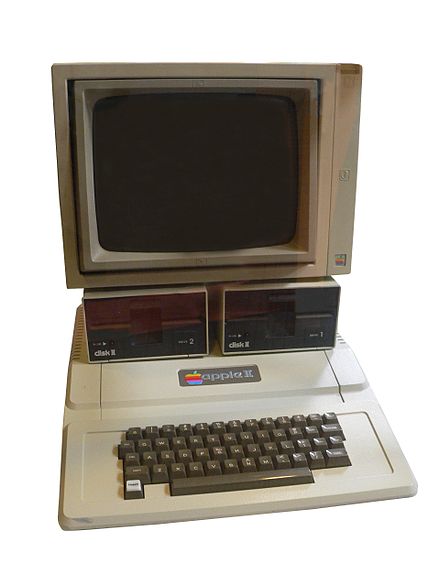

Junto con las máquinas recreativas electrónicas y las consolas de videojuegos para el hogar , desarrolladas por Nolan Bushnell en la década de 1970, el desarrollo de computadoras personales como Commodore PET y Apple II (ambas en 1977) les dio a las personas acceso a la computadora. Sin embargo, el intercambio de datos entre computadoras individuales era inexistente o en gran parte manual , al principio utilizando tarjetas perforadas y cintas magnéticas , y luego disquetes .

Los primeros avances en el almacenamiento de datos se basaron inicialmente en fotografías, comenzando con la microfotografía en 1851 y luego con la microforma en la década de 1920, con la capacidad de almacenar documentos en película, haciéndolos mucho más compactos. La teoría de la información temprana y los códigos de Hamming se desarrollaron alrededor de 1950, pero hubo que esperar a las innovaciones técnicas en la transmisión y el almacenamiento de datos para poder aprovecharlos al máximo.

La memoria de núcleo magnético fue desarrollada a partir de la investigación de Frederick W. Viehe en 1947 y An Wang en la Universidad de Harvard en 1949. [109] [110] Con la llegada del transistor MOS, la memoria semiconductora MOS fue desarrollada por John Schmidt en Fairchild Semiconductor en 1964. [111] [112] En 1967, Dawon Kahng y Simon Sze en Bell Labs describieron en 1967 cómo la puerta flotante de un dispositivo semiconductor MOS podría usarse para la celda de una ROM reprogramable. [113] Después de la invención de la memoria flash por Fujio Masuoka en Toshiba en 1980, [114] [115] Toshiba comercializó la memoria flash NAND en 1987. [116] [113]

Los cables de cobre que transmitían datos digitales conectaban terminales de computadora y periféricos a mainframes, y los sistemas especiales de intercambio de mensajes que condujeron al correo electrónico se desarrollaron por primera vez en la década de 1960. Las redes independientes de computadora a computadora comenzaron con ARPANET en 1969. Esto se expandió para convertirse en Internet (acuñado en 1974). El acceso a Internet mejoró con la invención de la World Wide Web en 1991. La expansión de la capacidad de multiplexación por división de onda densa , amplificación óptica y redes ópticas a mediados de la década de 1990 condujo a velocidades de transferencia de datos récord. Para 2018, las redes ópticas entregaban rutinariamente 30,4 terabits/s a través de un par de fibra óptica, el equivalente en datos de 1,2 millones de transmisiones simultáneas de video HD 4K. [117]

El escalamiento de los MOSFET , la rápida miniaturización de los MOSFET a una velocidad predicha por la ley de Moore , [118] llevó a que las computadoras se volvieran más pequeñas y más potentes, hasta el punto en que podían llevarse. Durante las décadas de 1980 y 1990, se desarrollaron computadoras portátiles como una forma de computadora portátil, y los asistentes digitales personales (PDA) podían usarse estando de pie o caminando. Los buscapersonas , ampliamente utilizados en la década de 1980, fueron reemplazados en gran medida por teléfonos móviles a partir de fines de la década de 1990, proporcionando funciones de red móvil a algunas computadoras. Ahora común, esta tecnología se extendió a las cámaras digitales y otros dispositivos portátiles. A partir de fines de la década de 1990, las tabletas y luego los teléfonos inteligentes combinaron y extendieron estas capacidades de computación, movilidad e intercambio de información. Los sensores de imagen de semiconductor de óxido de metal (MOS) , que comenzaron a aparecer a fines de la década de 1960, condujeron a la transición de la imagen analógica a la digital , y de las cámaras analógicas a las digitales, durante las décadas de 1980 y 1990. Los sensores de imagen más comunes son el sensor de dispositivo de carga acoplada (CCD) y el sensor de píxeles activos CMOS (MOS complementario) (sensor CMOS).

El papel electrónico , que tiene su origen en la década de 1970, permite que la información digital aparezca como documentos en papel.

En 1976, varias empresas compitieron para introducir las primeras computadoras personales comerciales verdaderamente exitosas. Tres máquinas, la Apple II , la Commodore PET 2001 y la TRS-80, fueron lanzadas en 1977, [119] convirtiéndose en la más popular a fines de 1978. [120] La revista Byte se refirió más tarde a Commodore, Apple y Tandy como la "Trinidad de 1977". [121] También en 1977, Sord Computer Corporation lanzó la computadora doméstica inteligente Sord M200 en Japón. [122]

Steve Wozniak (conocido como "Woz"), un visitante habitual de las reuniones del Homebrew Computer Club , diseñó el ordenador Apple I de placa única y lo demostró allí por primera vez. Con las especificaciones en la mano y un pedido de 100 máquinas a 500 dólares cada una de Byte Shop , Woz y su amigo Steve Jobs fundaron Apple Computer .

Se vendieron unas 200 máquinas antes de que la compañía anunciara el Apple II como un ordenador completo. Tenía gráficos en color , un teclado QWERTY completo y ranuras internas para expansión, que estaban montadas en una carcasa de plástico aerodinámica de alta calidad. El monitor y los dispositivos de E/S se vendían por separado. El sistema operativo original del Apple II era únicamente el intérprete BASIC integrado en la ROM. Se añadió Apple DOS para dar soporte a la unidad de disquete; la última versión fue "Apple DOS 3.3".

Su precio más elevado y la falta de BASIC de coma flotante , junto con la falta de sitios de distribución minorista, hicieron que quedara rezagada en ventas respecto de las otras máquinas Trinity hasta 1979, cuando superó a la PET. Volvió a quedar relegada al cuarto puesto cuando Atari, Inc. presentó sus ordenadores Atari de 8 bits . [123]

A pesar de las lentas ventas iniciales, la vida útil del Apple II fue aproximadamente ocho años más larga que la de otras máquinas, por lo que acumuló las mayores ventas totales. En 1985, se habían vendido 2,1 millones y, al final de su producción en 1993, se habían enviado más de 4 millones de Apple II. [124]

La comunicación óptica desempeña un papel crucial en las redes de comunicación . La comunicación óptica proporciona la columna vertebral de transmisión para las redes de telecomunicaciones y computadoras que sustentan Internet , la base de la revolución digital y la era de la información.

Las dos tecnologías principales son la fibra óptica y la amplificación de la luz (el amplificador óptico ). En 1953, Bram van Heel demostró la transmisión de imágenes a través de haces de fibras ópticas con un revestimiento transparente. El mismo año, Harold Hopkins y Narinder Singh Kapany , del Imperial College, lograron fabricar haces transmisores de imágenes con más de 10.000 fibras ópticas y, posteriormente, lograron la transmisión de imágenes a través de un haz de 75 cm de largo que combinaba varios miles de fibras.

Gordon Gould inventó el amplificador óptico y el láser , y también fundó la primera empresa de telecomunicaciones ópticas, Optelecom , para diseñar sistemas de comunicación. La firma fue cofundadora de Ciena Corp. , la empresa que popularizó el amplificador óptico con la introducción del primer sistema de multiplexación por división de onda densa . [125] Esta tecnología de comunicación a gran escala ha surgido como la base común de todas las redes de telecomunicaciones [3] y, por lo tanto, un fundamento de la Era de la Información. [126] [127]

Manuel Castells capta la importancia de la era de la información en La era de la información: economía, sociedad y cultura cuando habla de nuestra interdependencia global y de las nuevas relaciones entre la economía, el Estado y la sociedad, lo que él llama "una nueva sociedad en formación". Advierte que el hecho de que los humanos hayan dominado el mundo material no significa que la era de la información sea el fin de la historia:

"Es, en realidad, todo lo contrario: la historia está apenas comenzando, si por historia entendemos el momento en que, después de milenios de lucha prehistórica con la Naturaleza, primero para sobrevivir, luego para conquistarla, nuestra especie ha alcanzado el nivel de conocimiento y organización social que nos permitirá vivir en un mundo predominantemente social. Es el comienzo de una nueva existencia, y más aún, el comienzo de una nueva era, la Era de la Información, marcada por la autonomía de la cultura con respecto a la base material de nuestra existencia." [128]

Thomas Chatterton Williams escribió sobre los peligros del antiintelectualismo en la era de la información en un artículo para The Atlantic . Aunque el acceso a la información nunca ha sido mayor, la mayor parte de la información es irrelevante o insustancial. El énfasis de la era de la información en la velocidad por sobre la experiencia contribuye a una "cultura superficial en la que incluso la élite menospreciará abiertamente como inútiles nuestros principales depósitos de lo mejor que se ha pensado". [129]

{{cite web}}: CS1 maint: archived copy as title (link)Si la industria del CD-ROM sigue adelante, este producto ayudará a abrir la puerta a un nuevo y valiente mundo multimedia para las microcomputadoras, en el que la computadora está íntimamente vinculada con el resto de los aparatos electrónicos del hogar y todos los aparatos de la casa leen toneladas de datos de video, audio y texto de discos CD-ROM.

Moore también afirmó que nunca dijo que el número de transistores se duplicaría cada 18 meses, como se dice comúnmente. Inicialmente, dijo que los transistores en un chip se duplicarían cada año. Luego, en 1975, lo recalibre a cada dos años. David House, un ejecutivo de Intel en ese momento, señaló que los cambios harían que el rendimiento de la computadora se duplicara cada 18 meses.