Sistema de numeración decimal

Los dígitos cero después del separador decimal sirven para indicar la precisión de un valor.

Muchos sistemas numéricos de civilizaciones antiguas utilizan el diez y sus potencias para representar números, posiblemente porque hay diez dedos en las dos manos y las personas empezaron a contar utilizando los dedos.

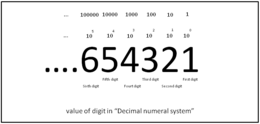

Para números enteros, comenzando de derecha a izquierda, el primer dígito le corresponde el lugar de las unidades, de manera que el dígito se multiplica por 100 (es decir 1) ; el siguiente dígito corresponde a las decenas (se multiplica por 101=10); el siguiente a las centenas (se multiplica por 102=100); el siguiente a las unidades de millar (se multiplica por 103=1000) y así sucesivamente, nombrándose este según su posición siguiendo la escala numérica correspondiente (larga o corta).

En algunas circunstancias puede ser útil tener uno o más 0 a la izquierda; esto no cambia el valor representado por el decimal: por ejemplo, 3,14 = 03,14 = 003,14.

Del mismo modo, si el último dígito a la derecha de la marca decimal es cero, es decir, si bn = 0, puede eliminarse; a la inversa, pueden añadirse ceros después de la marca decimal sin cambiar el número representado; A veces, los ceros adicionales se utilizan para indicar la exactitud de una medida.

Para representar un número negativo, se antepone un signo menos a am.

Se puede extender este método para los decimales, utilizando las potencias negativas de diez, y un separador decimal entre la parte entera y la parte fraccionaria, que queda a la derecha.

Así, las fracciones irreducibles cuyo denominador contiene factores primos que factorizan a 10 (2 y 5), tiene una representación finita.

Si contienen factores primos distintos de aquellos que factorizan a 10, no tienen representación finita: la parte fraccionaria presentará un período de recurrencia pura cuando no haya ningún factor primo en común con la base, y recurrencia mixta (aquella en la que hay dígitos al comienzo que no forman parte del período) cuando haya al menos un factor primo en común con la base.

Si contiene un desarrollo ilimitado no periódico, esta representación corresponde a un número irracional.

[3] Para uso externo de especialistas en informática, esta representación binaria se presenta a veces en los sistemas octal o hexadecimal relacionados.

Tanto el hardware como el software de los ordenadores utilizan también representaciones internas que son efectivamente decimales para almacenar valores decimales y realizar operaciones aritméticas.

A menudo esta aritmética se realiza sobre datos codificados utilizando alguna variante del decimal codificado en binario,[4][5] especialmente en implementaciones de bases de datos, pero hay otras representaciones decimales en uso (incluyendo coma flotante decimal como en las revisiones más recientes del IEEE 754 Standard for Floating-Point Arithmetic).

Esto es especialmente importante para los cálculos financieros, por ejemplo, que requieren en sus resultados múltiplos enteros de la unidad monetaria más pequeña a efectos contables.

no tienen representación fraccionaria binaria finita; y es generalmente imposible para la multiplicación (o división).

esto último hace su primera aparición en el 458 en el documento Lokavibhaga, un tratado de cosmología escrito en sánscrito.

Otras culturas de mesopotamia (Sumeria, Babilonia, ...) utilizaban un sistema posicional sexagesimal.