La historia de Internet tiene su origen en los esfuerzos de científicos e ingenieros por construir e interconectar redes de computadoras . El conjunto de protocolos de Internet , el conjunto de reglas utilizadas para comunicarse entre redes y dispositivos en Internet, surgió de la investigación y el desarrollo en los Estados Unidos e implicó una colaboración internacional, en particular con investigadores del Reino Unido y Francia . [1] [2] [3]

La informática fue una disciplina emergente a finales de los años 1950 que empezó a considerar la compartición del tiempo entre usuarios de ordenadores y, más tarde, la posibilidad de lograrlo a través de redes de área amplia . J. C. R. Licklider desarrolló la idea de una red universal en la Oficina de Técnicas de Procesamiento de la Información (IPTO) de la Agencia de Proyectos de Investigación Avanzada (ARPA ) del Departamento de Defensa (DoD ) de los Estados Unidos. De forma independiente, Paul Baran en la Corporación RAND propuso una red distribuida basada en datos en bloques de mensajes a principios de los años 1960, y Donald Davies concibió la conmutación de paquetes en 1965 en el Laboratorio Nacional de Física (NPL), proponiendo una red nacional de datos comerciales en el Reino Unido.

En 1969, ARPA adjudicó contratos para el desarrollo del proyecto ARPANET , dirigido por Robert Taylor y gestionado por Lawrence Roberts . ARPANET adoptó la tecnología de conmutación de paquetes propuesta por Davies y Baran. La red de procesadores de mensajes de interfaz (IMP) fue construida por un equipo de Bolt, Beranek y Newman , con el diseño y la especificación dirigidos por Bob Kahn . El protocolo host-to-host fue especificado por un grupo de estudiantes de posgrado de la UCLA , dirigido por Steve Crocker , junto con Jon Postel y Vint Cerf . ARPANET se expandió rápidamente por los Estados Unidos con conexiones al Reino Unido y Noruega.

En la década de 1970 surgieron varias redes de conmutación de paquetes tempranas que investigaban y proporcionaban redes de datos . Louis Pouzin y Hubert Zimmermann fueron pioneros en un enfoque simplificado de extremo a extremo para la interconexión de redes en el IRIA . Peter Kirstein puso en práctica la interconexión de redes en el University College de Londres en 1973. Bob Metcalfe desarrolló la teoría detrás de Ethernet y el PARC Universal Packet . Las iniciativas ARPA y el International Network Working Group desarrollaron y refinaron ideas para la interconexión de redes, en las que múltiples redes separadas podrían unirse en una red de redes . Vint Cerf, ahora en la Universidad de Stanford , y Bob Kahn, ahora en DARPA, publicaron su investigación sobre interconexión de redes en 1974. A través de la serie Internet Experiment Note y posteriores RFC, esto evolucionó hacia el Protocolo de control de transmisión (TCP) y el Protocolo de Internet (IP), dos protocolos de la suite de protocolos de Internet . El diseño incluía conceptos pioneros en el proyecto francés CYCLADES dirigido por Louis Pouzin. El desarrollo de redes de conmutación de paquetes estuvo respaldado por el trabajo matemático realizado en la década de 1970 por Leonard Kleinrock en la UCLA.

A finales de la década de 1970, surgieron redes públicas de datos nacionales e internacionales basadas en el protocolo X.25 , diseñado por Rémi Després y otros. En Estados Unidos, la National Science Foundation (NSF) financió centros nacionales de supercomputación en varias universidades de Estados Unidos y proporcionó interconectividad en 1986 con el proyecto NSFNET , creando así acceso en red a estos sitios de supercomputación para organizaciones académicas y de investigación en Estados Unidos. Las conexiones internacionales a NSFNET, el surgimiento de arquitecturas como el Sistema de nombres de dominio y la adopción de TCP/IP en redes existentes en Estados Unidos y en todo el mundo marcaron los inicios de Internet . [4] [5] [6] Los proveedores de servicios de Internet (ISP) comerciales surgieron en 1989 en Estados Unidos y Australia. [7] A finales de 1989 y 1990 surgieron en varias ciudades estadounidenses conexiones privadas limitadas a partes de Internet por parte de entidades oficialmente comerciales. [8] La red troncal óptica de la NSFNET se desmanteló en 1995, lo que eliminó las últimas restricciones al uso de Internet para transportar tráfico comercial, ya que el tráfico pasó a redes ópticas administradas por Sprint, MCI y AT&T en los Estados Unidos.

Las investigaciones realizadas en el CERN ( Suiza) por el informático británico Tim Berners-Lee en 1989-90 dieron como resultado la World Wide Web , que vincula documentos de hipertexto en un sistema de información, accesible desde cualquier nodo de la red. [9] La espectacular expansión de la capacidad de Internet, posibilitada por la llegada de la multiplexación por división de onda (WDM) y el despliegue de cables de fibra óptica a mediados de los años 1990, tuvo un impacto revolucionario en la cultura, el comercio y la tecnología. Esto hizo posible el surgimiento de la comunicación casi instantánea por correo electrónico , mensajería instantánea , llamadas telefónicas de voz sobre protocolo de Internet (VoIP), chat de video y la World Wide Web con sus foros de discusión , blogs , servicios de redes sociales y sitios de compras en línea . Cada vez se transmiten cantidades mayores de datos a velocidades cada vez mayores a través de redes de fibra óptica que operan a 1 Gbit/s , 10 Gbit/s y 800 Gbit/s en 2019. [10] La toma de control de Internet del panorama de las comunicaciones globales fue rápida en términos históricos: solo comunicó el 1% de la información que fluía a través de redes de telecomunicaciones bidireccionales en el año 1993, el 51% en 2000 y más del 97% de la información telecomunicada en 2007. [11] Internet continúa creciendo, impulsada por cantidades cada vez mayores de información en línea, comercio, entretenimiento y servicios de redes sociales . Sin embargo, el futuro de la red global puede estar determinado por las diferencias regionales. [12]

JCR Licklider, mientras trabajaba en BBN, propuso una red de computadoras en su artículo de marzo de 1960 Simbiosis hombre-computadora : [18]

Una red de dichos centros, conectados entre sí por líneas de comunicación de banda ancha [...] las funciones de las bibliotecas actuales junto con los avances previstos en el almacenamiento y recuperación de información y las funciones simbióticas sugeridas anteriormente en este artículo.

En agosto de 1962, Licklider y Welden Clark publicaron el artículo "Comunicación hombre-computadora en línea" [19] , que fue una de las primeras descripciones de un futuro en red.

En octubre de 1962, Licklider fue contratado por Jack Ruina como director de la recién creada Oficina de Técnicas de Procesamiento de Información (IPTO) dentro de ARPA, con el mandato de interconectar las principales computadoras del Departamento de Defensa de los Estados Unidos en Cheyenne Mountain , el Pentágono y la sede del SAC. Allí formó un grupo informal dentro de DARPA para promover la investigación informática. Comenzó escribiendo memorandos en 1963 describiendo una red distribuida para el personal de la IPTO, a quienes llamó "Miembros y Afiliados de la Red de Computadoras Intergalácticas ". [20]

Aunque dejó la IPTO en 1964, cinco años antes de que ARPANET entrara en funcionamiento, fue su visión de una red universal la que impulsó a uno de sus sucesores, Robert Taylor , a iniciar el desarrollo de ARPANET. Licklider volvió más tarde a dirigir la IPTO en 1973 durante dos años. [21]

La infraestructura de los sistemas telefónicos de la época se basaba en la conmutación de circuitos , que requiere la asignación previa de una línea de comunicación dedicada durante la duración de la llamada. Los servicios de telegramas habían desarrollado técnicas de telecomunicaciones de almacenamiento y reenvío . El Plan 55-A del Sistema de Conmutación Telegráfica Automática de Western Union se basaba en la conmutación de mensajes . La red AUTODIN del ejército estadounidense entró en funcionamiento en 1962. Estos sistemas, como SAGE y SBRE, aún requerían estructuras de enrutamiento rígidas que eran propensas a un único punto de fallo . [24]

La tecnología se consideraba vulnerable para uso estratégico y militar porque no había rutas alternativas para la comunicación en caso de que se interrumpiera un enlace. A principios de los años 1960, Paul Baran, de la Corporación RAND, elaboró un estudio sobre redes que podrían sobrevivir para el ejército estadounidense en caso de una guerra nuclear. [25] La información se transmitiría a través de una red "distribuida", dividida en lo que él llamó "bloques de mensajes". [26] [27] [28] [29] [30]

Además de ser propensas a un único punto de fallo, las técnicas telegráficas existentes eran ineficientes e inflexibles. A partir de 1965 Donald Davies , en el Laboratorio Nacional de Física del Reino Unido, desarrolló una propuesta más avanzada del concepto, diseñada para redes informáticas de alta velocidad , a la que llamó conmutación de paquetes , término que finalmente se adoptaría. [31] [32] [33] [34]

La conmutación de paquetes es una técnica para transmitir datos informáticos dividiéndolos en fragmentos estandarizados muy cortos, adjuntando información de enrutamiento a cada uno de estos fragmentos y transmitiéndolos de forma independiente a través de una red informática . Proporciona una mejor utilización del ancho de banda que la conmutación de circuitos tradicional utilizada para la telefonía y permite la conexión de computadoras con diferentes velocidades de transmisión y recepción. Es un concepto distinto de la conmutación de mensajes. [35]

Tras conversaciones con JCR Licklider en 1965, Donald Davies se interesó en las comunicaciones de datos para redes de ordenadores. [36] [37] Más tarde ese año, en el Laboratorio Nacional de Física (NPL) en el Reino Unido, Davies diseñó y propuso una red nacional de datos comerciales basada en la conmutación de paquetes. [38] Al año siguiente, describió el uso de "nodos de conmutación" para actuar como enrutadores en una red de comunicación digital. [39] [40] La propuesta no fue adoptada a nivel nacional, pero produjo un diseño para una red local para satisfacer las necesidades del NPL y demostrar la viabilidad de la conmutación de paquetes utilizando la transmisión de datos de alta velocidad. [41] [42] Para lidiar con las permutaciones de paquetes (debido a las preferencias de ruta actualizadas dinámicamente) y las pérdidas de datagramas (inevitables cuando las fuentes rápidas envían a destinos lentos), asumió que "todos los usuarios de la red se proporcionarán algún tipo de control de errores", [43] inventando así lo que llegó a conocerse como el principio de extremo a extremo . En 1967, él y su equipo fueron los primeros en utilizar el término "protocolo" en un contexto moderno de conmutación de datos. [44]

En 1968, [45] Davies comenzó a construir la red de conmutación de paquetes Mark I para satisfacer las necesidades de su laboratorio multidisciplinario y probar la tecnología en condiciones operativas. [46] [47] El desarrollo de la red se describió en una conferencia de 1968. [48] [49] Los elementos de la red se volvieron operativos a principios de 1969, [46] [50] la primera implementación de conmutación de paquetes, [51] [52] y la red NPL fue la primera en utilizar enlaces de alta velocidad. [53] Muchas otras redes de conmutación de paquetes construidas en la década de 1970 eran similares "en casi todos los aspectos" al diseño original de Davies de 1965. [36] La versión Mark II que funcionó a partir de 1973 utilizó una arquitectura de protocolo en capas. [53] En 1976, se conectaron 12 computadoras y 75 dispositivos terminales, [54] y se agregaron más. El equipo NPL llevó a cabo trabajos de simulación en redes de paquetes de área amplia, incluidos datagramas y congestión ; e investigaciones sobre interconexión de redes y comunicaciones seguras . [46] [55] [56] La red fue reemplazada en 1986. [53]

Robert Taylor fue ascendido a jefe de la Oficina de Técnicas de Procesamiento de Información (IPTO) en la Agencia de Proyectos de Investigación Avanzada de Defensa (DARPA) en 1966. Tenía la intención de hacer realidad las ideas de Licklider de un sistema de red interconectado. [57] Como parte del papel de la IPTO, se habían instalado tres terminales de red: una para la Corporación de Desarrollo de Sistemas en Santa Mónica , una para el Proyecto Genie en la Universidad de California, Berkeley , y una para el proyecto del Sistema de Tiempo Compartido Compatible en el Instituto Tecnológico de Massachusetts (MIT). [58] La necesidad identificada por Taylor de redes se hizo evidente a partir del desperdicio de recursos que le pareció evidente.

Para cada una de estas tres terminales, tenía tres conjuntos diferentes de comandos de usuario. De modo que si estaba hablando en línea con alguien del SDC y quería hablar con alguien que conocía en Berkeley o el MIT sobre esto, tenía que levantarme de la terminal del SDC, ir a la otra terminal y conectarme y ponerme en contacto con ellos... Me dije: "Oh, Dios, es obvio lo que hay que hacer: si tienes estas tres terminales, debería haber una terminal que vaya a cualquier lugar al que quieras ir donde haya computación interactiva. Esa idea es ARPAnet". [58]

En enero de 1967, Roberts contrató a Larry Roberts, del MIT, para que iniciara un proyecto para construir una red de este tipo. Roberts y Thomas Merrill habían estado investigando la compartición de tiempo de las computadoras en redes de área amplia (WAN). [59] Las redes de área amplia surgieron a fines de la década de 1950 y se establecieron durante la década de 1960. En el primer Simposio ACM sobre Principios de Sistemas Operativos en octubre de 1967, Roberts presentó una propuesta para la "red ARPA", basada en la idea de Wesley Clark de usar procesadores de mensajes de interfaz (IMP) para crear una red de conmutación de mensajes . [60] [61] [62] En la conferencia, Roger Scantlebury presentó el trabajo de Donald Davies sobre una red de comunicaciones digitales jerárquica que usa conmutación de paquetes e hizo referencia al trabajo de Paul Baran en RAND . Roberts incorporó los conceptos de conmutación de paquetes y enrutamiento de Davies y Baran al diseño de ARPANET y actualizó la velocidad de comunicaciones propuesta de 2,4 kbit/s a 50 kbit/s. [22] [63] [64] [65]

ARPA adjudicó el contrato para construir la red a Bolt Beranek & Newman . Los "chicos de IMP", liderados por Frank Heart y Bob Kahn , desarrollaron el enrutamiento, el control de flujo, el diseño del software y el control de la red. [36] [66] El primer enlace de ARPANET se estableció entre el Centro de Medición de Redes de la Escuela de Ingeniería y Ciencias Aplicadas Henry Samueli de la Universidad de California en Los Ángeles (UCLA) dirigido por Leonard Kleinrock , y el sistema NLS del Instituto de Investigación de Stanford (SRI) dirigido por Douglas Engelbart en Menlo Park , California a las 22:30 horas del 29 de octubre de 1969. [67]

"Establecimos una conexión telefónica entre nosotros y los chicos de SRI...", dijo Kleinrock... en una entrevista: "Escribimos la L y preguntamos por teléfono,

- "¿Ves la L?"

- "Sí, vemos la L", fue la respuesta.

- Escribimos la O y preguntamos: "¿Ves la O?"

- "Sí, vemos la O."

- Luego escribimos la G y el sistema se bloqueó...

Sin embargo, una revolución había comenzado"... [68] [69]

En diciembre de 1969, se conectó una red de cuatro nodos agregando el Centro de Matemáticas Interactivas Culler-Fried en la Universidad de California, Santa Bárbara, seguido por el Departamento de Gráficos de la Universidad de Utah . [70] En el mismo año, Taylor ayudó a financiar ALOHAnet , un sistema diseñado por el profesor Norman Abramson y otros en la Universidad de Hawái en Mānoa que transmitía datos por radio entre siete computadoras en cuatro islas de Hawái . [71]

En 1969, Steve Crocker formó el "Grupo de Trabajo de Redes" en la UCLA. Junto con Jon Postel y Vint Cerf , inició y gestionó el proceso de Solicitud de Comentarios (RFC), que todavía se utiliza hoy en día para proponer y distribuir contribuciones. La RFC 1, titulada "Host Software", fue escrita por Steve Crocker y publicada el 7 de abril de 1969. El protocolo para establecer enlaces entre sitios de red en ARPANET, el Programa de Control de Red (NCP), se completó en 1970. Estos primeros años se documentaron en la película de 1972 Computer Networks: The Heralds of Resource Sharing .

Roberts presentó la idea de la conmutación de paquetes a los profesionales de las comunicaciones y se enfrentó a la ira y la hostilidad. Antes de que ARPANET estuviera en funcionamiento, argumentaron que los buffers de los enrutadores se agotarían rápidamente. Después de que ARPANET estuvo en funcionamiento, argumentaron que la conmutación de paquetes nunca sería económica sin el subsidio del gobierno. Baran se enfrentó al mismo rechazo y, por lo tanto, no logró convencer a los militares para que construyeran una red de conmutación de paquetes. [72] [73]

Las primeras colaboraciones internacionales a través de ARPANET fueron escasas. En 1973 se realizaron conexiones con el Norwegian Seismic Array ( NORSAR ), [74] a través de un enlace satelital en la estación terrestre de Tanum en Suecia, y con el grupo de investigación de Peter Kirstein en el University College de Londres , que proporcionó una puerta de entrada a las redes académicas británicas , la primera red internacional heterogénea de intercambio de recursos . [75] A lo largo de la década de 1970, Leonard Kleinrock desarrolló la teoría matemática para modelar y medir el rendimiento de la tecnología de conmutación de paquetes, basándose en su trabajo anterior sobre la aplicación de la teoría de colas a los sistemas de conmutación de mensajes. [76] En 1981, el número de hosts había crecido a 213. [77] ARPANET se convirtió en el núcleo técnico de lo que se convertiría en Internet, y una herramienta principal en el desarrollo de las tecnologías utilizadas.

La Red Merit [78] se formó en 1966 como la Tríada de Información de Investigación Educativa de Michigan para explorar las redes de computadoras entre tres de las universidades públicas de Michigan como un medio para ayudar al desarrollo educativo y económico del estado. [79] Con el apoyo inicial del Estado de Michigan y la Fundación Nacional de Ciencias (NSF), la red de conmutación de paquetes se demostró por primera vez en diciembre de 1971 cuando se realizó una conexión interactiva de host a host entre los sistemas informáticos mainframe de IBM en la Universidad de Michigan en Ann Arbor y la Universidad Estatal de Wayne en Detroit . [80] En octubre de 1972, las conexiones al mainframe CDC en la Universidad Estatal de Michigan en East Lansing completaron la tríada. Durante los siguientes años, además de las conexiones interactivas de host a host, la red se mejoró para soportar conexiones de terminal a host, conexiones por lotes de host a host (envío de trabajos remotos, impresión remota, transferencia de archivos por lotes), transferencia interactiva de archivos, pasarelas a las redes públicas de datos Tymnet y Telenet , conexiones de host X.25 , pasarelas a redes de datos X.25, hosts conectados a Ethernet y, finalmente, TCP/IP y universidades públicas adicionales en Michigan se unen a la red. [80] [81] Todo esto preparó el escenario para el papel de Merit en el proyecto NSFNET a partir de mediados de la década de 1980.

La red de conmutación de paquetes CYCLADES fue una red de investigación francesa diseñada y dirigida por Louis Pouzin . [82] En 1972, comenzó a planificar la red para explorar alternativas al diseño inicial de ARPANET y para apoyar la investigación sobre interconexión de redes . Demostrada por primera vez en 1973, fue la primera red en implementar el principio de extremo a extremo concebido por Donald Davies y hacer que los hosts fueran responsables de la entrega confiable de datos, en lugar de la red en sí, utilizando datagramas no confiables . Los conceptos implementados en esta red influyeron en la arquitectura TCP/IP . [83] [84] [82]

Basándose en iniciativas de investigación internacionales, en particular las contribuciones de Rémi Després , el Comité Consultivo Internacional Telegráfico y Telefónico (UIT-T) desarrolló estándares de redes de conmutación de paquetes en forma de X.25 y estándares relacionados. [85] [86] X.25 se basa en el concepto de circuitos virtuales que emulan las conexiones telefónicas tradicionales. En 1974, X.25 formó la base de la red SERCnet entre sitios académicos y de investigación británicos, que más tarde se convirtió en JANET , la red nacional de investigación y educación de alta velocidad del Reino Unido (NREN). El estándar inicial de la UIT sobre X.25 se aprobó en marzo de 1976. [87] Las redes existentes, como Telenet en los Estados Unidos, adoptaron X.25, así como las nuevas redes públicas de datos , como DATAPAC en Canadá y TRANSPAC en Francia. [85] [86] X.25 se complementó con el protocolo X.75 que permitió la interconexión de redes entre redes PTT nacionales en Europa y redes comerciales en América del Norte. [88] [89] [90]

La Oficina Postal Británica , Western Union International y Tymnet colaboraron para crear la primera red internacional de conmutación de paquetes, conocida como el Servicio Internacional de Conmutación de Paquetes (IPSS), en 1978. Esta red creció desde Europa y los EE. UU. para cubrir Canadá, Hong Kong y Australia en 1981. En la década de 1990 proporcionó una infraestructura de red mundial. [91]

A diferencia de ARPANET, X.25 estaba disponible para uso comercial. Telenet ofrecía su servicio de correo electrónico Telemail, que también estaba orientado al uso empresarial, en lugar del sistema de correo electrónico general de ARPANET.

Las primeras redes públicas de acceso telefónico utilizaban protocolos de terminal de teleimpresora asíncrona (TTY) para llegar a un concentrador operado en la red pública. Algunas redes, como Telenet y CompuServe , utilizaban X.25 para multiplexar las sesiones de terminal en sus redes troncales de conmutación de paquetes, mientras que otras, como Tymnet , utilizaban protocolos propietarios. En 1979, CompuServe se convirtió en el primer servicio en ofrecer capacidades de correo electrónico y soporte técnico a los usuarios de computadoras personales. La compañía abrió nuevos caminos nuevamente en 1980 al ser la primera en ofrecer chat en tiempo real con su CB Simulator . Otras redes de acceso telefónico importantes fueron America Online (AOL) y Prodigy , que también proporcionaban funciones de comunicaciones, contenido y entretenimiento. [92] Muchas redes de sistema de tablón de anuncios (BBS) también proporcionaban acceso en línea, como FidoNet , que era popular entre los usuarios de computadoras aficionados, muchos de ellos piratas informáticos y operadores de radioaficionados . [ cita requerida ]

En 1979, dos estudiantes de la Universidad de Duke , Tom Truscott y Jim Ellis , idearon la idea de utilizar scripts de Bourne Shell para transferir noticias y mensajes en una conexión UUCP de línea serial con la cercana Universidad de Carolina del Norte en Chapel Hill . Tras el lanzamiento público del software en 1980, la red de hosts UUCP que reenviaban noticias de Usenet se expandió rápidamente. UUCPnet, como se llamaría más tarde, también creó pasarelas y enlaces entre FidoNet y hosts BBS de acceso telefónico. Las redes UUCP se extendieron rápidamente debido a los menores costos involucrados, la capacidad de usar líneas alquiladas existentes, enlaces X.25 o incluso conexiones ARPANET y la falta de políticas de uso estrictas en comparación con redes posteriores como CSNET y BITNET . Todas las conexiones eran locales. En 1981, el número de hosts UUCP había crecido a 550, casi duplicándose a 940 en 1984. [93]

Sublink Network , que opera desde 1987 y se fundó oficialmente en Italia en 1989, basó su interconectividad en UUCP para redistribuir mensajes de correo y grupos de noticias a través de sus nodos italianos (unos 100 en ese momento) que pertenecían tanto a particulares como a pequeñas empresas. Sublink Network se convirtió en uno de los primeros ejemplos de tecnología de Internet que se empezó a utilizar a través de la difusión popular.

Con tantos métodos de redes diferentes que buscaban interconectarse, se necesitaba un método para unificarlos. Louis Pouzin inició el proyecto CYCLADES en 1972, [94] basándose en el trabajo de Donald Davies y ARPANET. [95] En 1972 se formó un grupo de trabajo de redes internacionales ; entre los miembros activos se encontraban Vint Cerf de la Universidad de Stanford , Alex McKenzie de BBN , Donald Davies y Roger Scantlebury de NPL , y Louis Pouzin y Hubert Zimmermann de IRIA . [96] [97] [98] Pouzin acuñó el término catenet para red concatenada. Bob Metcalfe en Xerox PARC esbozó la idea de Ethernet y PARC Universal Packet (PUP) para interconexión de redes . Bob Kahn , ahora en DARPA , reclutó a Vint Cerf para trabajar con él en el problema. En 1973, estos grupos habían elaborado una reformulación fundamental, en la que las diferencias entre los protocolos de red se ocultaban mediante el uso de un protocolo de interconexión de redes común . En lugar de que la red fuera responsable de la fiabilidad, como en ARPANET, los hosts pasaron a ser responsables. [2] [99]

Cerf y Kahn publicaron sus ideas en mayo de 1974, [100] que incorporaron conceptos implementados por Louis Pouzin y Hubert Zimmermann en la red CYCLADES. [101] La especificación del protocolo resultante, el Programa de Control de Transmisión , fue publicada como RFC 675 por el Grupo de Trabajo de Redes en diciembre de 1974. [102] Contiene el primer uso atestiguado del término internet , como una abreviatura de interred. Este software era monolítico en diseño utilizando dos canales de comunicación simplex para cada sesión de usuario.

Con el papel de la red reducido a un núcleo de funcionalidad, se hizo posible intercambiar tráfico con otras redes independientemente de sus características detalladas, resolviendo así los problemas fundamentales de la interconexión de redes. DARPA aceptó financiar el desarrollo de un software prototipo. Las pruebas comenzaron en 1975 mediante implementaciones concurrentes en Stanford, BBN y University College London (UCL). [3] Después de varios años de trabajo, el Stanford Research Institute realizó la primera demostración de una pasarela entre la red de radio por paquetes (PRNET) en el área de la bahía de San Francisco y ARPANET . El 22 de noviembre de 1977, se realizó una demostración de tres redes que incluían ARPANET, Packet Radio Van del SRI en la red de radio por paquetes y la red satelital de paquetes del Atlántico (SATNET) que incluía un nodo en UCL. [103] [104]

El software fue rediseñado como una pila de protocolo modular, utilizando canales full-duplex; entre 1976 y 1977, Yogen Dalal y Robert Metcalfe, entre otros, propusieron separar las funciones de enrutamiento y control de transmisión de TCP en dos capas discretas, [105] [106] lo que llevó a la división del Programa de Control de Transmisión en el Protocolo de Control de Transmisión (TCP) y el Protocolo de Internet (IP) en la versión 3 en 1978. [106] [107] La versión 4 fue descrita en la publicación IETF RFC 791 (septiembre de 1981), 792 y 793. Fue instalada en SATNET en 1982 y en ARPANET en enero de 1983 después de que el Departamento de Defensa la convirtiera en estándar para todas las redes informáticas militares. [108] [109] Esto dio como resultado un modelo de red que se conoció informalmente como TCP/IP. También se le conoce como el modelo del Departamento de Defensa (DoD) o modelo DARPA. [110] Cerf atribuye a sus estudiantes de posgrado Yogen Dalal, Carl Sunshine, Judy Estrin , Richard Karp y Gérard Le Lann un trabajo importante en el diseño y las pruebas. [111] DARPA patrocinó o alentó el desarrollo de implementaciones de TCP/IP para muchos sistemas operativos.

Después de que ARPANET ya estuviera en funcionamiento durante varios años, ARPA buscó otra agencia a la que entregar la red; la misión principal de ARPA era financiar investigación y desarrollo de vanguardia, no administrar una utilidad de comunicaciones. En julio de 1975, la red fue entregada a la Agencia de Comunicaciones de Defensa , también parte del Departamento de Defensa . En 1983, la parte militar estadounidense de ARPANET se separó y se convirtió en una red separada, la MILNET . Posteriormente, MILNET se convirtió en la NIPRNET no clasificada pero solo para militares , en paralelo con la SIPRNET de nivel SECRET y JWICS para TOP SECRET y superiores. NIPRNET tiene puertas de enlace de seguridad controladas a Internet pública.

Las redes basadas en ARPANET estaban financiadas por el gobierno y, por lo tanto, estaban restringidas a usos no comerciales, como la investigación; el uso comercial no relacionado estaba estrictamente prohibido. [112] Esto inicialmente restringió las conexiones a sitios militares y universidades. Durante la década de 1980, las conexiones se expandieron a más instituciones educativas y a un número creciente de empresas como Digital Equipment Corporation y Hewlett-Packard , que participaban en proyectos de investigación o brindaban servicios a quienes lo hacían. Las velocidades de transmisión de datos dependían del tipo de conexión; las más lentas eran las líneas telefónicas analógicas y las más rápidas usaban tecnología de redes ópticas.

Varias otras ramas del gobierno de los EE. UU. , la Administración Nacional de Aeronáutica y del Espacio (NASA), la Fundación Nacional de Ciencias (NSF) y el Departamento de Energía (DOE) se involucraron activamente en la investigación de Internet y comenzaron a desarrollar un sucesor de ARPANET. A mediados de la década de 1980, estas tres ramas desarrollaron las primeras redes de área amplia basadas en TCP/IP. La NASA desarrolló la Red Científica de la NASA, la NSF desarrolló CSNET y el DOE desarrolló la Red de Ciencias de la Energía o ESNet.

A mediados de los años 80, la NASA desarrolló la Red Científica de la NASA (NSN, por sus siglas en inglés) basada en TCP/IP, que conectaba a los científicos espaciales con datos e información almacenados en cualquier parte del mundo. En 1989, la Red de Análisis de Física Espacial (SPAN, por sus siglas en inglés) basada en DECnet y la Red Científica de la NASA (NSN, por sus siglas en inglés) basada en TCP/IP se unieron en el Centro de Investigación Ames de la NASA, creando la primera red de área extensa multiprotocolo llamada Internet Científica de la NASA o NSI, por sus siglas en inglés. NSI se creó para proporcionar una infraestructura de comunicaciones totalmente integrada a la comunidad científica de la NASA para el avance de las ciencias de la Tierra, el espacio y la vida. Como red internacional multiprotocolo de alta velocidad, NSI proporcionó conectividad a más de 20.000 científicos en los siete continentes.

En 1981, la NSF apoyó el desarrollo de la Red de Ciencias de la Computación (CSNET). La CSNET se conectaba con ARPANET mediante TCP/IP y ejecutaba TCP/IP sobre X.25 , pero también daba soporte a departamentos sin conexiones de red sofisticadas, mediante el intercambio automático de correo por acceso telefónico. La CSNET desempeñó un papel central en la popularización de Internet fuera de ARPANET. [23]

En 1986, la NSF creó NSFNET , una red troncal de 56 kbit/s para dar soporte a los centros de supercomputación patrocinados por la NSF . La NSFNET también brindó soporte para la creación de redes regionales de investigación y educación en los Estados Unidos, y para la conexión de redes de campus universitarios y de escuelas superiores a las redes regionales. [113] El uso de NSFNET y las redes regionales no se limitó a los usuarios de supercomputadoras y la red de 56 kbit/s rápidamente se sobrecargó. NSFNET se actualizó a 1,5 Mbit/s en 1988 bajo un acuerdo de cooperación con Merit Network en asociación con IBM , MCI y el estado de Michigan . La existencia de NSFNET y la creación de los Intercambios Federales de Internet (FIXes) permitieron que ARPANET fuera desmantelada en 1990.

En 1991, la NSFNET se amplió y actualizó con sistemas de fibra óptica, láseres ópticos y amplificadores ópticos dedicados capaces de ofrecer velocidades iniciales de T3 o 45 Mbit/s. Sin embargo, la transición a T3 por parte de MCI llevó más tiempo de lo esperado, lo que permitió a Sprint establecer un servicio de Internet comercial de larga distancia de costa a costa. Cuando la NSFNET se desmanteló en 1995, sus redes troncales ópticas se entregaron a varios proveedores de servicios de Internet comerciales, incluidos MCI, PSI Net y Sprint. [114] Como resultado, cuando se completó la entrega, Sprint y sus puntos de acceso a la red de Washington DC comenzaron a transportar tráfico de Internet y, en 1996, Sprint era el mayor operador de tráfico de Internet del mundo. [115]

La comunidad investigadora y académica continúa desarrollando y utilizando redes avanzadas como Internet2 en los Estados Unidos y JANET en el Reino Unido.

El término "Internet" se reflejó en el primer RFC publicado sobre el protocolo TCP (RFC 675: [116] Internet Transmission Control Program, diciembre de 1974) como una forma abreviada de interconexión de redes , cuando los dos términos se usaban indistintamente. En general, una Internet era una colección de redes vinculadas por un protocolo común. En el período de tiempo en que ARPANET se conectó al recién formado proyecto NSFNET a fines de la década de 1980, el término se usó como el nombre de la red, Internet, siendo la gran red TCP/IP global. [117]

La apertura de Internet y de la red troncal de fibra óptica a las empresas y los consumidores aumentó la demanda de capacidad de red. El gasto y la demora en instalar nueva fibra llevaron a los proveedores a probar una alternativa de expansión del ancho de banda de fibra que había sido pionera a fines de la década de 1970 por Optelecom utilizando "interacciones entre luz y materia, como láseres y dispositivos ópticos utilizados para la amplificación óptica y la mezcla de ondas". [118] Esta tecnología se conoció como multiplexación por división de onda (WDM) . Bell Labs implementó un sistema WDM de 4 canales en 1995. [119] Para desarrollar un sistema WDM de gran capacidad (denso), Optelecom y su ex director de Light Systems Research, David R. Huber , formaron una nueva empresa, Ciena Corp. , que implementó el primer sistema WDM denso del mundo en la red de fibra Sprint en junio de 1996. [119] Esto se conoció como el verdadero comienzo de las redes ópticas. [120]

A medida que el interés por las redes creció debido a las necesidades de colaboración, intercambio de datos y acceso a recursos informáticos remotos, las tecnologías de Internet se extendieron por el resto del mundo. El enfoque independiente del hardware en TCP/IP respaldó el uso de la infraestructura de red existente, como la red X.25 del Servicio Internacional de Conmutación de Paquetes (IPSS), para transportar el tráfico de Internet.

Muchos sitios que no podían conectarse directamente a Internet crearon pasarelas simples para la transferencia de correo electrónico, la aplicación más importante de la época. Los sitios con conexiones intermitentes usaban UUCP o FidoNet y dependían de las pasarelas entre estas redes e Internet. Algunos servicios de pasarela iban más allá del simple intercambio de correo, como permitir el acceso a sitios de Protocolo de Transferencia de Archivos (FTP) a través de UUCP o correo. [121]

Finalmente, se desarrollaron tecnologías de enrutamiento para Internet con el fin de eliminar los aspectos de enrutamiento centralizado restantes. El Protocolo de Puerta de Enlace Exterior (EGP) fue reemplazado por un nuevo protocolo, el Protocolo de Puerta de Enlace Fronteriza (BGP). Esto proporcionó una topología en malla para Internet y redujo la arquitectura céntrica que ARPANET había enfatizado. En 1994, se introdujo el Enrutamiento Interdominio Sin Clases (CIDR) para respaldar una mejor conservación del espacio de direcciones, lo que permitió el uso de la agregación de rutas para reducir el tamaño de las tablas de enrutamiento . [122]

El transistor MOS fue la base del rápido crecimiento del ancho de banda de las telecomunicaciones durante la segunda mitad del siglo XX. [123] Para abordar la necesidad de capacidad de transmisión más allá de la proporcionada por la radio , el satélite y las líneas telefónicas analógicas de cobre, los ingenieros desarrollaron sistemas de comunicaciones ópticas basados en cables de fibra óptica alimentados por láseres y técnicas de amplificación óptica .

El concepto de láser surgió de un artículo de 1917 de Albert Einstein , "Sobre la teoría cuántica de la radiación". Einstein amplió un diálogo con Max Planck sobre cómo los átomos absorben y emiten luz , parte de un proceso de pensamiento que, con aportes de Erwin Schrödinger , Werner Heisenberg y otros, dio origen a la mecánica cuántica . Específicamente, en su teoría cuántica , Einstein determinó matemáticamente que la luz podía generarse no solo por emisión espontánea , como la luz emitida por una luz incandescente o el Sol, sino también por emisión estimulada .

Cuarenta años después, el 13 de noviembre de 1957, el estudiante de física de la Universidad de Columbia, Gordon Gould, fue el primero en darse cuenta de cómo producir luz mediante emisión estimulada a través de un proceso de amplificación óptica . Acuñó el término LASER para esta tecnología: Light Amplification by Stimulated Emission of Radiation (Amplificación de luz por emisión estimulada de radiación). [124] Utilizando el método de amplificación de luz de Gould (patentado como "Optically Bombed Laser Amplifier"), [125] Theodore Maiman fabricó el primer láser funcional el 16 de mayo de 1960. [126]

Gould cofundó Optelecom , Inc. en 1973 para comercializar sus inventos en telecomunicaciones por fibra óptica. [127] Justo cuando Corning Glass estaba produciendo el primer cable de fibra óptica comercial en pequeñas cantidades, Optelecom configuró sus propios láseres de fibra y amplificadores ópticos en los primeros sistemas de comunicación óptica comerciales que entregó a Chevron y al Departamento de Defensa de Misiles del Ejército de los EE. UU. [128] Tres años después, GTE implementó el primer sistema telefónico óptico en 1977 en Long Beach, California. [129] A principios de la década de 1980, las redes ópticas alimentadas por láseres, LED y equipos amplificadores ópticos suministrados por Bell Labs , NTT y Perelli fueron utilizadas por universidades seleccionadas y proveedores de telefonía de larga distancia.

En 1982, NORSAR / NDRE y el grupo de investigación de Peter Kirstein en el University College London (UCL) abandonaron ARPANET y comenzaron a utilizar TCP/IP sobre SATNET. [99] En 1975, había 40 grupos de investigación académica británicos que utilizaban el enlace de UCL a ARPANET. [75] [130]

Entre 1984 y 1988, el CERN comenzó a instalar y operar el protocolo TCP/IP para interconectar sus principales sistemas informáticos internos, estaciones de trabajo, PC y un sistema de control de aceleradores. El CERN continuó operando un sistema interno limitado de desarrollo propio (CERNET) y varios protocolos de red incompatibles (normalmente propietarios) externamente. En Europa hubo una resistencia considerable hacia un uso más generalizado del protocolo TCP/IP, y las intranets TCP/IP del CERN permanecieron aisladas de Internet hasta 1989, cuando se estableció una conexión transatlántica con la Universidad de Cornell. [131] [132] [133]

La Red de Ciencias de la Computación (CSNET) comenzó a funcionar en 1981 para proporcionar conexiones de red a instituciones que no podían conectarse directamente a ARPANET. Su primera conexión internacional fue con Israel en 1984. Poco después, se establecieron conexiones con departamentos de ciencias de la computación en Canadá, Francia y Alemania. [23]

En 1988, las primeras conexiones internacionales a NSFNET fueron establecidas por el INRIA de Francia , [134] [135] y Piet Beertema en el Centrum Wiskunde & Informatica (CWI) en los Países Bajos. [136] Daniel Karrenberg, del CWI, visitó a Ben Segal , coordinador de TCP/IP del CERN, en busca de asesoramiento sobre la transición de EUnet , la parte europea de la red UUCP Usenet (gran parte de la cual funcionaba sobre enlaces X.25), a TCP/IP. El año anterior, Segal se había reunido con Len Bosack de la entonces todavía pequeña empresa Cisco para la compra de algunos enrutadores TCP/IP para el CERN, y Segal pudo asesorar a Karrenberg y remitirlo a Cisco para el hardware adecuado. Esto expandió la parte europea de Internet a través de las redes UUCP existentes. La conexión de NORDUnet a NSFNET estuvo en funcionamiento poco después, proporcionando acceso abierto a estudiantes universitarios en Dinamarca, Finlandia, Islandia, Noruega y Suecia. [137] En enero de 1989, el CERN abrió sus primeras conexiones TCP/IP externas. [138] Esto coincidió con la creación de Réseaux IP Européens ( RIPE ), inicialmente un grupo de administradores de redes IP que se reunían regularmente para realizar trabajos de coordinación en conjunto. Más tarde, en 1992, RIPE se registró formalmente como cooperativa en Ámsterdam.

La red nacional de investigación y educación del Reino Unido (NREN), JANET , comenzó a funcionar en 1984 utilizando los protocolos Coloured Book del Reino Unido y se conectó a NSFNET en 1989. En 1991, JANET adoptó el Protocolo de Internet en la red existente. [139] [140] El mismo año, Dai Davies introdujo la tecnología de Internet en la NREN paneuropea, EuropaNet , que se construyó sobre el protocolo X.25. [141] [142] La Red Académica y de Investigación Europea (EARN) y RARE adoptaron IP casi al mismo tiempo, y la red troncal de Internet europea EBONE comenzó a funcionar en 1992. [131]

Sin embargo, durante un período a fines de la década de 1980 y principios de la década de 1990, los ingenieros, las organizaciones y las naciones estaban polarizados sobre la cuestión de qué estándar , el modelo OSI o el conjunto de protocolos de Internet, daría como resultado las mejores y más robustas redes de computadoras. [97] [143] [144]

Corea del Sur creó una red TCP/IP doméstica de dos nodos en 1982, la Red de Desarrollo de Sistemas (SDN), a la que se añadió un tercer nodo el año siguiente. La SDN se conectó al resto del mundo en agosto de 1983 utilizando UUCP (Unix-to-Unix-Copy); se conectó a CSNET en diciembre de 1984; [23] y se conectó formalmente a NSFNET en 1990. [145] [146] [147]

Japón, que había construido la red basada en UUCP JUNET en 1984, se conectó a CSNET [23] y más tarde a NSFNET en 1989, lo que marcó la expansión de Internet a Asia.

En Australia, a finales de los años 1980 se crearon redes ad hoc para ARPA y universidades australianas intermedias, basadas en diversas tecnologías como X.25, UUCP Net y a través de CSNET. [23] Estas redes tenían limitaciones en su conexión con las redes globales debido al costo de realizar conexiones internacionales individuales mediante acceso telefónico UUCP o X.25. En 1989, las universidades australianas se sumaron a la iniciativa de utilizar protocolos IP para unificar sus infraestructuras de redes. AARNet fue creada en 1989 por el Comité de Vicerrectores de Australia y proporcionó una red dedicada basada en IP para Australia.

Nueva Zelanda adoptó los protocolos Coloured Book del Reino Unido como estándar provisional y estableció su primera conexión IP internacional con los EE. UU. en 1989. [148]

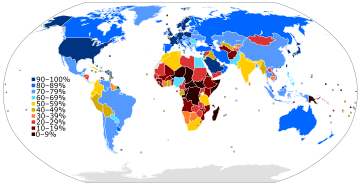

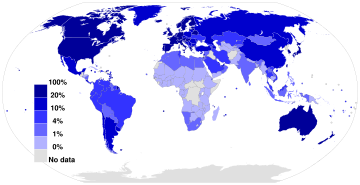

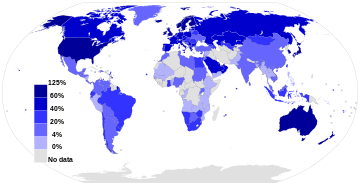

Mientras los países desarrollados con infraestructuras tecnológicas se incorporaban a Internet, los países en desarrollo comenzaron a experimentar una brecha digital que los separaba de Internet. A nivel fundamentalmente continental, crearon organizaciones para la administración de los recursos de Internet y para compartir experiencias operativas, lo que permitió la implementación de más facilidades de transmisión.

A principios de la década de 1990, los países africanos dependían de enlaces IPSS X.25 y UUCP de módem de 2400 baudios para las comunicaciones informáticas internacionales y entre redes.

En agosto de 1995, InfoMail Uganda, Ltd., una empresa privada de Kampala conocida actualmente como InfoCom, y NSN Network Services de Avon, Colorado, vendida en 1997 y conocida actualmente como Clear Channel Satellite, establecieron los primeros servicios de Internet satelital de alta velocidad TCP/IP nativos de África. La conexión de datos se transportaba originalmente mediante un satélite ruso RSCC de banda C que conectaba las oficinas de InfoMail en Kampala directamente con el punto de presencia MAE-West de NSN utilizando una red privada desde la estación terrestre alquilada de NSN en Nueva Jersey. La primera conexión satelital de InfoCom era de tan solo 64 kbit/s, y servía a un ordenador host Sun y a doce módems de acceso telefónico de US Robotics.

En 1996, un proyecto financiado por USAID , la Iniciativa Leland , comenzó a trabajar en el desarrollo de una conectividad total a Internet para el continente. Guinea , Mozambique, Madagascar y Ruanda obtuvieron estaciones terrestres satelitales en 1997, seguidos por Costa de Marfil y Benin en 1998.

África está construyendo una infraestructura de Internet. AFRINIC , con sede en Mauricio , gestiona la asignación de direcciones IP para el continente. Al igual que en otras regiones de Internet, existe un foro operativo, la Comunidad de Internet de Especialistas en Redes Operativas. [152]

Existen numerosos programas para proporcionar plantas de transmisión de alto rendimiento, y las costas occidental y meridional cuentan con cables ópticos submarinos. Los cables de alta velocidad unen el norte de África y el Cuerno de África con sistemas de cables intercontinentales. El desarrollo de los cables submarinos es más lento en África oriental; el esfuerzo conjunto original entre la Nueva Alianza para el Desarrollo de África (NEPAD) y el Sistema Submarino de África Oriental (EASY) se ha interrumpido y puede convertirse en dos esfuerzos. [153]

El Centro de Información de Redes de Asia y el Pacífico (APNIC) , con sede en Australia, gestiona la asignación de direcciones IP para el continente. APNIC patrocina un foro operativo, la Conferencia Regional de Internet de Asia y el Pacífico sobre Tecnologías Operativas (APRICOT). [154]

En Corea del Sur, VDSL, una tecnología de última milla desarrollada en la década de 1990 por NextLevel Communications, conectó líneas telefónicas de cobre de empresas y consumidores a Internet. [155]

La República Popular China estableció su primera red universitaria TCP/IP, TUNET de la Universidad de Tsinghua , en 1991. La RPC estableció su primera conexión global a Internet en 1994, entre la Colaboración Electroespectrómetro de Beijing y el Centro de Aceleradores Lineales de la Universidad de Stanford . Sin embargo, China continuó implementando su propia brecha digital al implementar un filtro de contenido a nivel nacional . [156]

Japón fue anfitrión de la reunión anual de la Internet Society , INET'92, en Kobe . Singapur desarrolló TECHNET en 1990, y Tailandia obtuvo una conexión global a Internet entre la Universidad de Chulalongkorn y UUNET en 1992. [157]

Al igual que en las demás regiones, el Registro de Direcciones de Internet de América Latina y el Caribe (LACNIC) administra el espacio de direcciones IP y otros recursos de su área. LACNIC, con sede en Uruguay, opera el DNS raíz, el DNS inverso y otros servicios clave.

Inicialmente, al igual que las redes que le precedieron, el sistema que luego se convertiría en Internet estaba destinado principalmente al gobierno y a los organismos gubernamentales. Aunque el uso comercial estaba prohibido, la definición exacta de uso comercial no estaba clara y era subjetiva. UUCP Net y el IPSS X.25 no tenían tales restricciones, lo que finalmente llevó a la prohibición oficial del uso de UUCPNet de las conexiones ARPANET y NSFNET .

Como resultado, a finales de los años 1980, se formaron las primeras empresas proveedoras de servicios de Internet (ISP). Se formaron empresas como PSINet , UUNET , Netcom y Portal Software para proporcionar servicio a las redes de investigación regionales y proporcionar acceso a redes alternativas, correo electrónico basado en UUCP y Usenet News al público. En 1989, MCI Mail se convirtió en el primer proveedor de correo electrónico comercial en obtener una puerta de enlace experimental a Internet. [159] El primer ISP de acceso telefónico comercial en los Estados Unidos fue The World , que abrió en 1989. [160]

En 1992, el Congreso de los Estados Unidos aprobó la Ley de Tecnología Científica y Avanzada, 42 USC § 1862(g), que permitió a la NSF apoyar el acceso de las comunidades de investigación y educación a redes informáticas que no se utilizaban exclusivamente para fines de investigación y educación, permitiendo así que NSFNET se interconectara con redes comerciales. [161] [162] Esto causó controversia dentro de la comunidad de investigación y educación, a quienes les preocupaba que el uso comercial de la red pudiera llevar a una Internet menos sensible a sus necesidades, y dentro de la comunidad de proveedores de redes comerciales, que sentían que los subsidios gubernamentales estaban dando una ventaja injusta a algunas organizaciones. [163]

En 1990, los objetivos de ARPANET se habían cumplido y las nuevas tecnologías de redes excedieron el alcance original y el proyecto llegó a su fin. Nuevos proveedores de servicios de red, incluidos PSINet , Alternet , CERFNet, ANS CO+RE y muchos otros, ofrecían acceso a la red a clientes comerciales. NSFNET ya no era la columna vertebral y el punto de intercambio de facto de Internet. El Commercial Internet eXchange (CIX), los Metropolitan Area Exchanges (MAE) y, más tarde, los Network Access Points (NAP) se estaban convirtiendo en las interconexiones principales entre muchas redes. Las restricciones finales para transportar tráfico comercial terminaron el 30 de abril de 1995, cuando la National Science Foundation finalizó su patrocinio del Servicio de Columna Vertebral NSFNET. [164] [165] La NSF brindó apoyo inicial para los NAP y apoyo provisorio para ayudar a las redes regionales de investigación y educación a realizar la transición a ISP comerciales. La NSF también patrocinó el Servicio de Red Troncal de muy alta velocidad (vBNS), que continuó brindando apoyo a los centros de supercomputación y a la investigación y educación en los Estados Unidos. [166]

Un evento celebrado el 11 de enero de 1994, la Cumbre de Superautopistas en el Royce Hall de la UCLA , fue la "primera conferencia pública que reunió a todos los principales líderes de la industria, el gobierno y el mundo académico en el campo [y] también inició el diálogo nacional sobre la Superautopista de la Información y sus implicaciones". [167]

La invención de la World Wide Web por Tim Berners-Lee en el CERN , como una aplicación en Internet, [168] trajo muchos usos sociales y comerciales a lo que era, en ese momento, una red de redes para instituciones académicas y de investigación. [169] [170] La Web se abrió al público en 1991 y comenzó a entrar en uso general en 1993-4, cuando los sitios web para uso cotidiano comenzaron a estar disponibles. [171]

Durante la primera década de la Internet pública, los inmensos cambios que finalmente permitiría en la década de 2000 todavía estaban en sus inicios. En términos de proporcionar contexto para este período, los dispositivos celulares móviles ("teléfonos inteligentes" y otros dispositivos celulares) que hoy brindan acceso casi universal, se usaban para negocios y no como un artículo doméstico rutinario propiedad de padres e hijos en todo el mundo. Las redes sociales en el sentido moderno aún no habían surgido, las computadoras portátiles eran voluminosas y la mayoría de los hogares no tenían computadoras. Las velocidades de datos eran lentas y la mayoría de las personas carecían de medios para grabar o digitalizar videos; el almacenamiento de medios estaba haciendo una transición lenta de la cinta analógica a los discos ópticos digitales ( DVD y, en cierta medida, todavía, disquete a CD ). Las tecnologías habilitadoras utilizadas desde principios de la década de 2000, como PHP , JavaScript y Java modernos , tecnologías como AJAX , HTML 4 (y su énfasis en CSS ) y varios marcos de software , que permitieron y simplificaron la velocidad del desarrollo web, aguardaban en gran medida su invención y su eventual adopción generalizada.

Internet se utilizó ampliamente para listas de correo , correos electrónicos , creación y distribución de mapas con herramientas como MapQuest , comercio electrónico y las primeras compras populares en línea ( Amazon y eBay , por ejemplo), foros y tablones de anuncios en línea, y sitios web y blogs personales , y su uso estaba creciendo rápidamente, pero según los estándares más modernos, los sistemas utilizados eran estáticos y carecían de una participación social generalizada. Tuvo que esperar una serie de eventos a principios de la década de 2000 para pasar de ser una tecnología de comunicaciones a convertirse gradualmente en una parte clave de la infraestructura de la sociedad global.

Los elementos de diseño típicos de estos sitios web de la era "Web 1.0" incluían: [172] páginas estáticas en lugar de HTML dinámico ; [173] contenido servido desde sistemas de archivos en lugar de bases de datos relacionales ; páginas creadas utilizando Server Side Includes o CGI en lugar de una aplicación web escrita en un lenguaje de programación dinámico ; estructuras de la era HTML 3.2 como marcos y tablas para crear diseños de página; libros de visitas en línea ; uso excesivo de botones GIF y pequeños gráficos similares que promocionan elementos particulares; [174] y formularios HTML enviados por correo electrónico . (El soporte para scripts del lado del servidor era poco común en servidores compartidos , por lo que el mecanismo de retroalimentación habitual era por correo electrónico, utilizando formularios mailto y su programa de correo electrónico . [175]

Durante el período de 1997 a 2001, se produjo la primera burbuja de inversión especulativa relacionada con Internet, en la que las empresas "punto-com" (en referencia al dominio de nivel superior " .com " utilizado por las empresas) alcanzaron valoraciones extremadamente altas a medida que los inversores avivaban rápidamente los valores de las acciones , seguido de un desplome del mercado ; la primera burbuja punto-com . Sin embargo, esto sólo desaceleró temporalmente el entusiasmo y el crecimiento, que se recuperó rápidamente y continuó creciendo.

La historia de la World Wide Web hasta aproximadamente el año 2004 fue denominada y descrita retrospectivamente por algunos como "Web 1.0". [176]

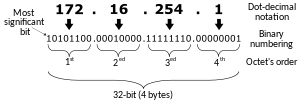

En la etapa final del agotamiento de direcciones IPv4 , el último bloque de direcciones IPv4 fue asignado en enero de 2011 a nivel de los registros regionales de Internet. [177] IPv4 utiliza direcciones de 32 bits que limitan el espacio de direcciones a 2 32 direcciones, es decir, 4 294 967 296 direcciones. [107] IPv4 está en proceso de reemplazo por IPv6 , su sucesor, que utiliza direcciones de 128 bits, proporcionando 2 128 direcciones, es decir, 340 282 366 920 938 463 463 374 607 431 768 211 456 , [178] un espacio de direcciones enormemente aumentado. Se espera que el cambio a IPv6 tome mucho tiempo para completarse. [177]

Los rápidos avances técnicos que catapultarían a Internet a su lugar como sistema social, que han transformado por completo la forma en que los seres humanos interactúan entre sí, tuvieron lugar durante un período relativamente corto, desde alrededor de 2005 hasta 2010, coincidiendo con el momento en que los dispositivos de IoT superaron la cantidad de seres humanos vivos en algún momento a fines de la década de 2000. Entre ellos se incluyen:

El término "Web 2.0" describe sitios web que enfatizan el contenido generado por el usuario (incluida la interacción entre usuarios), la usabilidad y la interoperabilidad . Apareció por primera vez en un artículo de enero de 1999 llamado "Fragmented Future" escrito por Darcy DiNucci , consultora en diseño de información electrónica , donde escribió: [179] [180] [181] [182]

El término resurgió durante 2002-2004, [183] [184] [185] [186] y ganó prominencia a fines de 2004 después de las presentaciones de Tim O'Reilly y Dale Dougherty en la primera Conferencia Web 2.0 . En sus comentarios de apertura, John Battelle y Tim O'Reilly describieron su definición de la "Web como plataforma", donde las aplicaciones de software se construyen en la Web en lugar de en el escritorio. El aspecto único de esta migración, argumentaron, es que "los clientes están construyendo su negocio para usted". [187] Argumentaron que las actividades de los usuarios que generan contenido (en forma de ideas, texto, videos o imágenes) podrían "aprovecharse" para crear valor.

La Web 2.0 no se refiere a una actualización de ninguna especificación técnica, sino más bien a cambios acumulativos en la forma en que se crean y utilizan las páginas web. La Web 2.0 describe un enfoque en el que los sitios se centran sustancialmente en permitir que los usuarios interactúen y colaboren entre sí en un diálogo de medios sociales como creadores de contenido generado por el usuario en una comunidad virtual , en contraste con los sitios web donde las personas se limitan a la visualización pasiva de contenido . Los ejemplos de la Web 2.0 incluyen servicios de redes sociales , blogs , wikis , folksonomías , sitios para compartir videos , servicios alojados , aplicaciones web y mashups . [188] Terry Flew , en su tercera edición de New Media, describió lo que creía que caracterizaba las diferencias entre la Web 1.0 y la Web 2.0:

En esta época, varios nombres conocidos ganaron prominencia a través de su funcionamiento orientado a la comunidad: YouTube , Twitter, Facebook, Reddit y Wikipedia son algunos ejemplos.

Los sistemas telefónicos han ido adoptando lentamente la tecnología de voz sobre IP desde 2003. Los primeros experimentos demostraron que la voz se puede convertir en paquetes digitales y enviar por Internet. Los paquetes se recogen y se convierten de nuevo en voz analógica. [190] [191] [192]

El proceso de cambio que en general coincidió con la "Web 2.0" se aceleró y transformó en gran medida poco tiempo después gracias al crecimiento creciente de los dispositivos móviles. Esta revolución móvil significó que los ordenadores en forma de teléfonos inteligentes se convirtieron en algo que mucha gente usaba, llevaban consigo a todas partes, con lo que se comunicaban, usaban para tomar fotografías y vídeos que compartían instantáneamente o para comprar o buscar información "sobre la marcha" y se usaban socialmente, en lugar de ser objetos que se colocaban sobre un escritorio en casa o que se usaban simplemente para trabajar. [ cita requerida ]

Los servicios basados en la ubicación, los servicios que utilizan la ubicación y otra información de sensores y el crowdsourcing (frecuentemente, pero no siempre, basada en la ubicación) se volvieron comunes, con publicaciones etiquetadas por ubicación o sitios web y servicios que se volvían conscientes de la ubicación. Los sitios web orientados a dispositivos móviles (como "m.website.com") se volvieron comunes, diseñados especialmente para los nuevos dispositivos utilizados. Los netbooks , ultrabooks , la amplia difusión de la tecnología 4G y Wi-Fi y los chips móviles capaces o que funcionaban con casi la misma potencia que los equipos de escritorio de no muchos años antes con un consumo de energía mucho menor, se convirtieron en facilitadores de esta etapa del desarrollo de Internet, y surgió el término " App " (abreviatura de "programa de aplicación" o "programa"), al igual que la " tienda de aplicaciones ".

Esta "revolución móvil" ha permitido a las personas disponer de una cantidad casi ilimitada de información en todo momento. Con la posibilidad de acceder a Internet desde los teléfonos móviles se produjo un cambio en la forma de consumir los medios de comunicación. Las estadísticas sobre el consumo de medios de comunicación muestran que más de la mitad de los consumidores de medios de comunicación entre los 18 y los 34 años de edad se realizaban a través de un teléfono inteligente. [193]

El primer enlace de Internet en la órbita baja terrestre se estableció el 22 de enero de 2010, cuando el astronauta TJ Creamer publicó la primera actualización sin asistencia en su cuenta de Twitter desde la Estación Espacial Internacional , lo que marcó la extensión de Internet al espacio. [194] (Los astronautas en la ISS habían usado el correo electrónico y Twitter antes, pero estos mensajes habían sido retransmitidos a la Tierra a través de un enlace de datos de la NASA antes de ser publicados por un proxy humano). Este acceso web personal, que la NASA llama Crew Support LAN, utiliza el enlace de microondas de banda Ku de alta velocidad de la estación espacial . Para navegar por la Web, los astronautas pueden usar una computadora portátil de la estación para controlar una computadora de escritorio en la Tierra, y pueden hablar con sus familiares y amigos en la Tierra usando equipos de Voz sobre IP . [195]

La comunicación con naves espaciales más allá de la órbita terrestre se ha realizado tradicionalmente a través de enlaces punto a punto a través de la Red del Espacio Profundo . Cada uno de estos enlaces de datos debe programarse y configurarse manualmente. A finales de la década de 1990, la NASA y Google comenzaron a trabajar en un nuevo protocolo de red, la red tolerante a retrasos (DTN), que automatiza este proceso, permite la conexión en red de nodos de transmisión a bordo del espacio y tiene en cuenta el hecho de que las naves espaciales pueden perder temporalmente el contacto porque se mueven detrás de la Luna o los planetas, o porque el clima espacial interrumpe la conexión. En tales condiciones, la DTN retransmite paquetes de datos en lugar de descartarlos, como lo hace el protocolo de Internet estándar TCP/IP. La NASA realizó la primera prueba de campo de lo que llama la "Internet del espacio profundo" en noviembre de 2008. [196] Las pruebas de comunicaciones basadas en DTN entre la Estación Espacial Internacional y la Tierra (ahora denominadas Redes Tolerantes a Interrupciones) han estado en curso desde marzo de 2009 y estaba previsto que continuaran hasta marzo de 2014. [197]

Se supone que esta tecnología de red permitirá en última instancia misiones que impliquen el uso de varias naves espaciales, en las que la comunicación fiable entre naves podría tener prioridad sobre los enlaces descendentes entre naves y la Tierra. Según una declaración de febrero de 2011 de Vint Cerf , de Google, los denominados "protocolos Bundle" se han cargado en la nave espacial de la misión EPOXI de la NASA (que está en órbita alrededor del Sol) y se ha probado la comunicación con la Tierra a una distancia de aproximadamente 80 segundos luz. [198]

Como red distribuida globalmente de redes autónomas interconectadas voluntariamente, Internet opera sin un organismo central de gobierno. Cada red constituyente elige las tecnologías y protocolos que implementa a partir de los estándares técnicos desarrollados por el Grupo de Trabajo de Ingeniería de Internet (IETF). [199] Sin embargo, la interoperación exitosa de muchas redes requiere ciertos parámetros que deben ser comunes en toda la red. Para gestionar dichos parámetros, la Autoridad de Números Asignados de Internet (IANA) supervisa la asignación y distribución de varios identificadores técnicos. [200] Además, la Corporación de Internet para la Asignación de Nombres y Números (ICANN) proporciona supervisión y coordinación para los dos espacios de nombres principales en Internet, el espacio de direcciones del Protocolo de Internet y el Sistema de Nombres de Dominio .

La función de la IANA fue desempeñada originalmente por el Instituto de Ciencias de la Información (ISI) de la USC, y delegó partes de esta responsabilidad con respecto a los identificadores numéricos de redes y sistemas autónomos al Centro de Información de Redes (NIC) del Instituto de Investigación de Stanford (SRI International) en Menlo Park, California . Jonathan Postel , del ISI , administró la IANA, se desempeñó como editor de RFC y desempeñó otras funciones clave hasta su muerte en 1998. [201]

A medida que ARPANET fue creciendo, se hacía referencia a los hosts por nombres y SRI International distribuía un archivo HOSTS.TXT a cada host de la red. A medida que la red crecía, esto se volvió engorroso. Una solución técnica llegó en forma del Sistema de nombres de dominio , creado por Paul Mockapetris de ISI en 1983. [202] La Red de datos de defensa—Centro de información de red (DDN-NIC) en SRI manejaba todos los servicios de registro, incluidos los dominios de nivel superior (TLD) de .mil , .gov , .edu , .org , .net , .com y .us , la administración del servidor de nombres raíz y las asignaciones de números de Internet según un contrato del Departamento de Defensa de los Estados Unidos . [200] En 1991, la Agencia de Sistemas de Información de Defensa (DISA) adjudicó la administración y el mantenimiento de DDN-NIC (gestionado por SRI hasta ese momento) a Government Systems, Inc., quien lo subcontrató a la pequeña empresa privada Network Solutions, Inc. [203] [204]

La creciente diversidad cultural de Internet también planteó desafíos administrativos para la gestión centralizada de las direcciones IP. En octubre de 1992, el Grupo de Trabajo de Ingeniería de Internet (IETF) publicó la RFC 1366, [205] que describía el "crecimiento de Internet y su creciente globalización" y sentaba las bases para una evolución del proceso de registro IP, basado en un modelo de registro distribuido regionalmente. Este documento destacaba la necesidad de que existiera un único registro de números de Internet en cada región geográfica del mundo (que tendría "dimensiones continentales"). Los registros serían "imparciales y ampliamente reconocidos por los proveedores de red y los suscriptores" dentro de su región. El Centro de Coordinación de Redes RIPE (RIPE NCC) se estableció como el primer RIR en mayo de 1992. El segundo RIR, el Centro de Información de Redes de Asia y el Pacífico (APNIC), se estableció en Tokio en 1993, como un proyecto piloto del Grupo de Redes de Asia y el Pacífico. [206]

Dado que en ese momento de la historia la mayor parte del crecimiento de Internet provenía de fuentes no militares, se decidió que el Departamento de Defensa ya no financiaría servicios de registro fuera del TLD .mil. En 1993, la Fundación Nacional de Ciencias de los Estados Unidos , después de un proceso de licitación competitivo en 1992, creó el InterNIC para gestionar las asignaciones de direcciones y la gestión de las bases de datos de direcciones, y adjudicó el contrato a tres organizaciones. Los servicios de registro serían proporcionados por Network Solutions ; los servicios de directorio y base de datos serían proporcionados por AT&T ; y los servicios de información serían proporcionados por General Atomics . [207]

Con el tiempo, después de consultar con la IANA, la IETF , RIPE NCC , APNIC y el Consejo Federal de Redes (FNC), se tomó la decisión de separar la gestión de los nombres de dominio de la gestión de los números IP. [206] Siguiendo los ejemplos de RIPE NCC y APNIC, se recomendó que la gestión del espacio de direcciones IP administrado entonces por el InterNIC debería estar bajo el control de quienes lo utilizan, específicamente los ISP, las organizaciones de usuarios finales, las entidades corporativas, las universidades y los individuos. Como resultado, el Registro Americano de Números de Internet (ARIN) se estableció en diciembre de 1997, como una corporación independiente, sin fines de lucro por dirección de la Fundación Nacional de Ciencias y se convirtió en el tercer Registro Regional de Internet. [208]

En 1998, tanto la IANA como las restantes funciones de InterNIC relacionadas con el DNS se reorganizaron bajo el control de la ICANN , una corporación sin fines de lucro de California contratada por el Departamento de Comercio de los Estados Unidos para gestionar una serie de tareas relacionadas con Internet. Como estas tareas implicaban la coordinación técnica de dos espacios de nombres principales de Internet (nombres DNS y direcciones IP) creados por el IETF, la ICANN también firmó un memorando de entendimiento con la IAB para definir el trabajo técnico que llevaría a cabo la Autoridad de Números Asignados de Internet. [209] La gestión del espacio de direcciones de Internet permaneció en manos de los registros regionales de Internet, que colectivamente se definieron como una organización de apoyo dentro de la estructura de la ICANN. [210] La ICANN proporciona una coordinación central para el sistema DNS, incluida la coordinación de políticas para el sistema dividido de registro/registrador, con competencia entre los proveedores de servicios de registro para servir a cada dominio de nivel superior y múltiples registradores en competencia que ofrecen servicios DNS a los usuarios finales.

El Grupo de Trabajo de Ingeniería de Internet (IETF) es el más grande y más visible de varios grupos ad hoc vagamente relacionados que brindan orientación técnica para Internet, incluidos el Consejo de Arquitectura de Internet (IAB), el Grupo Directivo de Ingeniería de Internet (IESG) y el Grupo de Trabajo de Investigación de Internet (IRTF).

El IETF es un grupo de voluntarios internacionales, poco organizados y que contribuyen a la ingeniería y evolución de las tecnologías de Internet. Es el principal organismo que se dedica al desarrollo de nuevas especificaciones estándar para Internet. Gran parte del trabajo del IETF está organizado en grupos de trabajo . Los esfuerzos de normalización de los grupos de trabajo suelen ser adoptados por la comunidad de Internet, pero el IETF no controla ni vigila Internet. [211] [212]

El IETF surgió de reuniones trimestrales con investigadores financiados por el gobierno de los EE. UU., a partir de enero de 1986. Se invitó a representantes no gubernamentales a la cuarta reunión del IETF en octubre de 1986. El concepto de grupos de trabajo se introdujo en la quinta reunión en febrero de 1987. La séptima reunión en julio de 1987 fue la primera reunión con más de cien asistentes. En 1992, se formó la Internet Society , una sociedad de membresía profesional, y el IETF comenzó a operar bajo ella como un organismo de estándares internacionales independiente. La primera reunión del IETF fuera de los Estados Unidos se celebró en Ámsterdam, Países Bajos, en julio de 1993. Hoy, el IETF se reúne tres veces al año y la asistencia ha sido tan alta como aproximadamente 2000 participantes. Por lo general, una de cada tres reuniones del IETF se celebran en Europa o Asia. El número de asistentes no estadounidenses suele ser de aproximadamente el 50%, incluso en reuniones celebradas en los Estados Unidos. [211]

El IETF no es una entidad legal, no tiene junta directiva, ni miembros, ni cuotas. El estatus más parecido a la membresía es estar en una lista de correo del IETF o de un grupo de trabajo. Los voluntarios del IETF provienen de todo el mundo y de diferentes partes de la comunidad de Internet. El IETF trabaja en estrecha colaboración con y bajo la supervisión del Internet Engineering Steering Group (IESG) [213] y el Internet Architecture Board (IAB). [214] El Internet Research Task Force (IRTF) y el Internet Research Steering Group (IRSG), actividades similares al IETF y al IESG bajo la supervisión general del IAB, se centran en cuestiones de investigación a largo plazo. [211] [215]

Los RFC son la documentación principal para el trabajo del IAB, IESG, IETF e IRTF. [216] Originalmente pensado como una solicitud de comentarios, el RFC 1, "Host Software", fue escrito por Steve Crocker en UCLA en abril de 1969. Estos memorandos técnicos documentaban aspectos del desarrollo de ARPANET. Fueron editados por Jon Postel , el primer editor de RFC . [211] [217]

Las RFC cubren una amplia gama de información, desde estándares propuestos, borradores de estándares, estándares completos, mejores prácticas, protocolos experimentales, historia y otros temas informativos. [218] Las RFC pueden ser escritas por individuos o grupos informales de individuos, pero muchas son el producto de un grupo de trabajo más formal. Los borradores son enviados al IESG por individuos o por el presidente del grupo de trabajo. Un editor de RFC, designado por el IAB, independiente de la IANA, y que trabaja en conjunto con el IESG, recibe los borradores del IESG y los edita, formatea y publica. Una vez que se publica una RFC, nunca se revisa. Si el estándar que describe cambia o su información se vuelve obsoleta, el estándar revisado o la información actualizada se volverá a publicar como una nueva RFC que "dejará obsoleto" al original. [211] [217]

La Internet Society (ISOC) es una organización internacional sin fines de lucro fundada en 1992 "para asegurar el desarrollo, la evolución y el uso abiertos de Internet para el beneficio de todas las personas en todo el mundo". Con oficinas cerca de Washington, DC, EE. UU., y en Ginebra, Suiza, la ISOC tiene una base de miembros que comprende más de 80 organizaciones y más de 50.000 miembros individuales. Los miembros también forman "capítulos" basados en la ubicación geográfica común o intereses especiales. Actualmente hay más de 90 capítulos en todo el mundo. [219]

La ISOC brinda apoyo financiero y organizativo a los organismos de normalización de los que es sede organizativa, y promueve su labor: el Grupo de Trabajo de Ingeniería de Internet (IETF), el Consejo de Arquitectura de Internet (IAB), el Grupo Directivo de Ingeniería de Internet (IESG) y el Grupo de Trabajo de Investigación de Internet (IRTF). La ISOC también promueve la comprensión y la valoración del modelo de Internet de procesos abiertos, transparentes y de toma de decisiones basada en el consenso. [220]

Desde los años 1990, la gobernanza y organización de Internet ha sido de importancia global para los gobiernos, el comercio, la sociedad civil y los individuos. Las organizaciones que tenían el control de ciertos aspectos técnicos de Internet eran las sucesoras de la antigua supervisión de ARPANET y las actuales encargadas de tomar decisiones en los aspectos técnicos cotidianos de la red. Si bien se las reconoce como administradores de ciertos aspectos de Internet, sus funciones y su autoridad para tomar decisiones son limitadas y están sujetas a un escrutinio internacional cada vez mayor y a objeciones cada vez mayores. Estas objeciones han llevado a la ICANN a retirarse de sus relaciones, primero con la Universidad del Sur de California en 2000 [221] y, en septiembre de 2009, a obtener autonomía respecto del gobierno de los EE. UU. al poner fin a sus acuerdos de larga data, aunque algunas obligaciones contractuales con el Departamento de Comercio de los EE. UU. continuaron. [222] [223] [224] Finalmente, el 1 de octubre de 2016, la ICANN finalizó su contrato con la Administración Nacional de Telecomunicaciones e Información ( NTIA ) del Departamento de Comercio de los Estados Unidos , lo que permitió que la supervisión pasara a la comunidad global de Internet. [225]

La IETF, con el apoyo financiero y organizativo de la Internet Society, continúa actuando como organismo de normalización ad hoc de Internet y emite Solicitudes de comentarios .

En noviembre de 2005, la Cumbre Mundial sobre la Sociedad de la Información , celebrada en Túnez , convocó a un Foro de Gobernanza de Internet (FGI), que sería convocado por el Secretario General de las Naciones Unidas . El FGI abrió un diálogo permanente y no vinculante entre las partes interesadas que representan a los gobiernos, el sector privado, la sociedad civil y las comunidades técnicas y académicas sobre el futuro de la gobernanza de Internet. La primera reunión del FGI se celebró en octubre/noviembre de 2006, y a partir de entonces se celebraron reuniones de seguimiento anuales. [226] Desde la CMSI, el término "gobernanza de Internet" se ha ampliado más allá de las estrechas preocupaciones técnicas para incluir una gama más amplia de cuestiones de política relacionadas con Internet. [227] [228]

Tim Berners-Lee , inventor de la web, se estaba preocupando por las amenazas al futuro de la web y en noviembre de 2009 en el IGF en Washington DC lanzó la World Wide Web Foundation (WWWF) para hacer campaña para hacer de la web una herramienta segura y empoderadora para el bien de la humanidad con acceso para todos. [229] [230] En noviembre de 2019 en el IGF en Berlín, Berners-Lee y la WWWF lanzaron el Contrato para la Web , una iniciativa de campaña para persuadir a los gobiernos, empresas y ciudadanos a comprometerse con nueve principios para detener el "mal uso" con la advertencia "Si no actuamos ahora - y actuamos juntos - para evitar que la web sea mal utilizada por aquellos que quieren explotar, dividir y socavar, corremos el riesgo de desperdiciar" (su potencial para el bien). [231]

Debido a su prominencia e inmediatez como medio eficaz de comunicación masiva, Internet también se ha politizado a medida que ha crecido, lo que a su vez ha llevado a que discursos y actividades que antes se habrían llevado a cabo de otras maneras pasen a estar mediados por Internet.

Los ejemplos incluyen actividades políticas como protestas públicas y búsqueda de apoyo y votos , pero también: