Un riesgo catastrófico global o un escenario apocalíptico es un evento hipotético que podría dañar el bienestar humano a escala global, [2] incluso poniendo en peligro o destruyendo la civilización moderna . [3] Un evento que podría causar la extinción humana o reducir permanente y drásticamente la existencia o el potencial de la humanidad se conoce como " riesgo existencial ". [4]

Durante las últimas dos décadas, [ ¿cuándo? ] Se han establecido varias organizaciones académicas y sin fines de lucro para investigar riesgos catastróficos y existenciales globales, formular posibles medidas de mitigación y defender o implementar estas medidas. [5] [6] [7] [8]

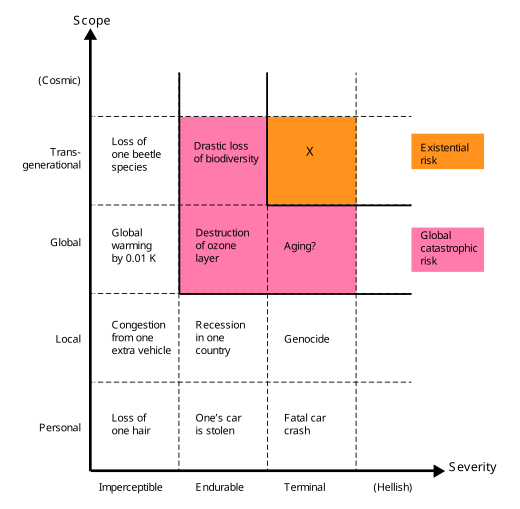

El término riesgo catastrófico global "carece de una definición clara" y generalmente se refiere (vagamente) a un riesgo que podría infligir "daños graves al bienestar humano a escala global". [10]

La humanidad ha sufrido grandes catástrofes antes. Algunos de ellos causaron graves daños, pero sólo tuvieron un alcance local; por ejemplo, la peste negra pudo haber causado la muerte de un tercio de la población europea, [11] el 10% de la población mundial en ese momento. [12] Algunas fueron globales, pero no tan graves; por ejemplo, la pandemia de gripe de 1918 mató a aproximadamente entre el 3% y el 6% de la población mundial. [13] La mayoría de los riesgos catastróficos globales no serían tan intensos como para matar a la mayor parte de la vida en la Tierra, pero incluso si uno lo hiciera, el ecosistema y la humanidad eventualmente se recuperarían (en contraste con los riesgos existenciales ).

De manera similar, en Catastrophe: Risk and Response , Richard Posner destaca y agrupa eventos que provocan "un derrocamiento o ruina total" a escala global, en lugar de "local o regional". Posner destaca estos acontecimientos como dignos de especial atención por razones de coste-beneficio porque podrían poner en peligro directa o indirectamente la supervivencia de la raza humana en su conjunto. [14]

Los riesgos existenciales se definen como "riesgos que amenazan con la destrucción del potencial a largo plazo de la humanidad". [15] La instanciación de un riesgo existencial (una catástrofe existencial [16] ) causaría la extinción total de la humanidad o bloquearía irreversiblemente un estado de cosas drásticamente inferior. [9] [17] Los riesgos existenciales son una subclase de riesgos catastróficos globales, donde el daño no es solo global sino también terminal y permanente, impidiendo la recuperación y, por lo tanto, afectando tanto a las generaciones actuales como a todas las futuras. [9]

Si bien la extinción es la forma más obvia en la que podría destruirse el potencial a largo plazo de la humanidad, existen otras, incluido el colapso irrecuperable y la distopía irrecuperable . [18] Un desastre lo suficientemente grave como para causar el colapso permanente e irreversible de la civilización humana constituiría una catástrofe existencial, incluso si no llegara a la extinción. [18] De manera similar, si la humanidad cayera bajo un régimen totalitario y no hubiera posibilidades de recuperación, entonces tal distopía también sería una catástrofe existencial. [19] Bryan Caplan escribe que "quizás una eternidad de totalitarismo sería peor que la extinción". [19] ( La novela Mil novecientos ochenta y cuatro de George Orwell sugiere [20] un ejemplo. [21] ) Un escenario distópico comparte las características clave de la extinción y el colapso irrecuperable de la civilización: antes de la catástrofe, la humanidad enfrentaba una amplia gama de futuros brillantes. Para escoger de; Después de la catástrofe, la humanidad queda encerrada para siempre en un estado terrible. [18]

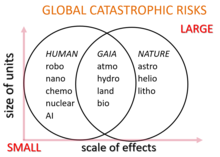

Los riesgos catastróficos globales potenciales se clasifican convencionalmente como peligros antropogénicos o no antropogénicos. Ejemplos de riesgos no antropogénicos son el impacto de un asteroide o cometa , una erupción supervolcánica , una pandemia natural , una explosión letal de rayos gamma , una tormenta geomagnética derivada de una eyección de masa coronal que destruya equipos electrónicos, un cambio climático natural a largo plazo , extraterrestres hostiles. vida , o que el Sol se transforme en una estrella gigante roja y engulla la Tierra miles de millones de años en el futuro . [22]

Los riesgos antropogénicos son aquellos causados por los humanos e incluyen aquellos relacionados con la tecnología, la gobernanza y el cambio climático. Los riesgos tecnológicos incluyen la creación de inteligencia artificial desalineada con los objetivos humanos, la biotecnología y la nanotecnología . Una gobernanza global insuficiente o maligna crea riesgos en el ámbito social y político, como la guerra global y el holocausto nuclear , [23] la guerra biológica y el bioterrorismo utilizando organismos genéticamente modificados , la guerra cibernética y el terrorismo cibernético que destruyen infraestructuras críticas como la red eléctrica , o la guerra radiológica utilizando armas. como grandes bombas de cobalto . Los riesgos catastróficos globales en el ámbito de la gobernanza del sistema terrestre incluyen el calentamiento global , la degradación ambiental , la extinción de especies , la hambruna como resultado de una distribución no equitativa de los recursos, la superpoblación humana , las malas cosechas y la agricultura no sostenible .

La investigación sobre la naturaleza y la mitigación de los riesgos catastróficos globales y los riesgos existenciales está sujeta a un conjunto único de desafíos y, como resultado, no es fácil sujetarla a los estándares habituales de rigor científico. [18] Por ejemplo, no es factible ni ético estudiar estos riesgos experimentalmente. Carl Sagan expresó esto con respecto a la guerra nuclear: "Comprender las consecuencias a largo plazo de la guerra nuclear no es un problema susceptible de verificación experimental". [24] Además, muchos riesgos catastróficos cambian rápidamente a medida que avanza la tecnología y cambian las condiciones de fondo, como las condiciones geopolíticas. Otro desafío es la dificultad general de predecir con precisión el futuro en escalas de tiempo largas, especialmente para los riesgos antropogénicos que dependen de sistemas humanos políticos, económicos y sociales complejos. [18] Además de los riesgos conocidos y tangibles, pueden ocurrir eventos imprevisibles de extinción del cisne negro , lo que presenta un problema metodológico adicional. [18] [25]

La humanidad nunca ha sufrido una catástrofe existencial y si ocurriera, sería necesariamente sin precedentes. [18] Por lo tanto, los riesgos existenciales plantean desafíos únicos para la predicción, incluso más que otros eventos a largo plazo, debido a los efectos de selección de observación . [26] A diferencia de la mayoría de los eventos, el hecho de que no haya ocurrido un evento de extinción completa en el pasado no es evidencia contra su probabilidad en el futuro, porque cada mundo que ha experimentado tal evento de extinción no tiene observadores, por lo que, independientemente de su frecuencia, Ninguna civilización observa riesgos existenciales en su historia. [26] Estos problemas antrópicos pueden evitarse en parte observando evidencia que no tenga tales efectos de selección, como los cráteres de impacto de asteroides en la Luna, o evaluando directamente el probable impacto de nueva tecnología. [9]

Para comprender la dinámica de un colapso civilizacional global irrecuperable y sin precedentes (un tipo de riesgo existencial), puede resultar instructivo estudiar los diversos colapsos civilizacionales locales que han ocurrido a lo largo de la historia humana. [27] Por ejemplo, civilizaciones como el Imperio Romano han terminado en una pérdida de gobierno centralizado y una pérdida importante de infraestructura y tecnología avanzada en toda la civilización. Sin embargo, estos ejemplos demuestran que las sociedades parecen ser bastante resilientes a las catástrofes; por ejemplo, la Europa medieval sobrevivió a la peste negra sin sufrir nada parecido al colapso de una civilización a pesar de perder entre el 25 y el 50 por ciento de su población. [28]

Hay razones económicas que pueden explicar por qué se están dedicando tan pocos esfuerzos a la reducción del riesgo existencial. Es un bien público global , por lo que deberíamos esperar que los mercados no lo ofrezcan en forma suficiente. [9] Incluso si una nación grande invierte en medidas de mitigación de riesgos, esa nación disfrutará sólo de una pequeña fracción del beneficio de hacerlo. Además, la reducción del riesgo existencial es un bien público global intergeneracional , ya que la mayoría de los beneficios de la reducción del riesgo existencial serían disfrutados por las generaciones futuras, y aunque estas personas futuras en teoría tal vez estarían dispuestas a pagar sumas sustanciales por la reducción del riesgo existencial, no existe ningún mecanismo. para tal transacción existe. [9]

Numerosos sesgos cognitivos pueden influir en el juicio de las personas sobre la importancia de los riesgos existenciales, incluida la insensibilidad al alcance , el descuento hiperbólico , la heurística de disponibilidad , la falacia de la conjunción , la heurística del afecto y el efecto de exceso de confianza . [29]

La insensibilidad al alcance influye en lo mala que la gente considera la extinción de la raza humana. Por ejemplo, cuando las personas están motivadas a donar dinero para causas altruistas, la cantidad que están dispuestas a donar no aumenta linealmente con la magnitud del problema: las personas están aproximadamente igual de dispuestas a evitar la muerte de 200.000 o 2.000 aves. [30] De manera similar, la gente suele estar más preocupada por las amenazas a individuos que a grupos más grandes. [29]

Eliezer Yudkowsky teoriza que la negligencia del alcance juega un papel en la percepción pública de los riesgos existenciales: [31] [32]

Cifras sustancialmente mayores, como 500 millones de muertes, y escenarios especialmente cualitativamente diferentes, como la extinción de toda la especie humana, parecen desencadenar un modo de pensar diferente... Personas que nunca soñarían con lastimar a un niño oyen hablar de riesgo existencial, y decir: "Bueno, tal vez la especie humana realmente no merece sobrevivir".

Todas las predicciones pasadas sobre la extinción humana han demostrado ser falsas. Para algunos, esto hace que las advertencias futuras parezcan menos creíbles. Nick Bostrom sostiene que la ausencia de extinción humana en el pasado es una evidencia débil de que no habrá extinción humana en el futuro, debido al sesgo de supervivencia y otros efectos antrópicos . [33]

El sociobiólogo E. O. Wilson argumentó que: "La razón de esta niebla miope, sostienen los biólogos evolutivos, es que en realidad fue ventajosa durante todos los milenios de los dos millones de años de existencia del género Homo , salvo los últimos pocos... mucha atención al futuro cercano y a la reproducción temprana, y poco más. Desastres de una magnitud que ocurre sólo una vez cada pocos siglos fueron olvidados o transmutados en mito." [34]

La defensa en profundidad es un marco útil para categorizar las medidas de mitigación de riesgos en tres capas de defensa: [35]

La extinción humana es más probable cuando las tres defensas son débiles, es decir, "por riesgos que es poco probable que podamos prevenir, a los que es poco probable que respondamos con éxito y que es poco probable que seamos resilientes". [35]

La naturaleza sin precedentes de los riesgos existenciales plantea un desafío especial en el diseño de medidas de mitigación de riesgos, ya que la humanidad no podrá aprender de un historial de eventos anteriores. [18]

Algunos investigadores sostienen que tanto la investigación como otras iniciativas relacionadas con el riesgo existencial carecen de financiación suficiente. Nick Bostrom afirma que se han realizado más investigaciones sobre Star Trek , el snowboard o los escarabajos peloteros que sobre los riesgos existenciales. Las comparaciones de Bostrom han sido criticadas como "prepotentes". [36] [37] A partir de 2020, la organización de la Convención sobre Armas Biológicas tenía un presupuesto anual de 1,4 millones de dólares estadounidenses. [38]

Algunos académicos proponen el establecimiento en la Tierra de uno o más asentamientos autosuficientes, remotos y permanentemente ocupados creados específicamente con el propósito de sobrevivir a un desastre global. [39] [40] [41] El economista Robin Hanson sostiene que un refugio que albergara permanentemente a tan solo 100 personas mejoraría significativamente las posibilidades de supervivencia humana durante una variedad de catástrofes globales. [39] [42]

El almacenamiento de alimentos se ha propuesto a nivel mundial, pero el costo monetario sería alto. Además, probablemente contribuiría a los actuales millones de muertes al año debido a la desnutrición . [43] En 2022, un equipo dirigido por David Denkenberger modeló la rentabilidad de los alimentos resilientes según la seguridad de la inteligencia artificial general (AGI) y encontró "~98-99% de confianza" para un mayor impacto marginal del trabajo sobre alimentos resilientes. [44] Algunos supervivientes abastecen los retiros de supervivencia con suministros de alimentos para varios años.

La Bóveda Global de Semillas de Svalbard está enterrada a 120 m (400 pies) dentro de una montaña en una isla en el Ártico . Está diseñado para contener 2.500 millones de semillas de más de 100 países como medida de precaución para preservar los cultivos del mundo. La roca circundante está a -6 °C (21 °F) (a partir de 2015), pero la bóveda se mantiene a -18 °C (0 °F) mediante refrigeradores que funcionan con carbón de origen local. [45] [46]

En términos más especulativos, si la sociedad continúa funcionando y la biosfera sigue siendo habitable, las necesidades calóricas de la población humana actual podrían, en teoría, satisfacerse durante una ausencia prolongada de luz solar, si se planifica con suficiente antelación. Las soluciones conjeturadas incluyen cultivar hongos en la biomasa de plantas muertas que quedó tras la catástrofe, convertir la celulosa en azúcar o alimentar con gas natural a las bacterias que digieren el metano. [47] [48]

Una gobernanza global insuficiente crea riesgos en el ámbito social y político, pero los mecanismos de gobernanza se desarrollan más lentamente que el cambio tecnológico y social. Los gobiernos, el sector privado y el público en general están preocupados por la falta de mecanismos de gobernanza para abordar de manera eficiente los riesgos, negociar y decidir entre intereses diversos y en conflicto. Esto se ve aún más subrayado por la comprensión de la interconexión de los riesgos sistémicos globales. [49] En ausencia o anticipación de una gobernanza global, los gobiernos nacionales pueden actuar individualmente para comprender, mitigar y prepararse mejor para las catástrofes globales. [50]

En 2018, el Club de Roma pidió una mayor acción contra el cambio climático y publicó su Plan de Emergencia Climática, que propone diez puntos de acción para limitar el aumento de la temperatura promedio global a 1,5 grados Celsius. [51] Además, en 2019, el Club publicó el Plan de Emergencia Planetaria más completo. [52]

Hay evidencia que sugiere que involucrarse colectivamente con las experiencias emocionales que surgen al contemplar la vulnerabilidad de la especie humana en el contexto del cambio climático permite que estas experiencias sean adaptativas. Cuando la participación colectiva y el procesamiento de experiencias emocionales brindan apoyo, esto puede conducir a un crecimiento en la resiliencia, la flexibilidad psicológica, la tolerancia de las experiencias emocionales y la participación comunitaria. [53]

La colonización espacial es una alternativa propuesta para mejorar las probabilidades de sobrevivir a un escenario de extinción. [54] Las soluciones de este alcance pueden requerir ingeniería a megaescala .

El astrofísico Stephen Hawking abogó por colonizar otros planetas dentro del Sistema Solar una vez que la tecnología progrese lo suficiente, con el fin de mejorar las posibilidades de supervivencia humana ante eventos planetarios como la guerra termonuclear global. [55] [56]

El multimillonario Elon Musk escribe que la humanidad debe convertirse en una especie multiplanetaria para evitar la extinción. [57] Musk está utilizando su empresa SpaceX para desarrollar tecnología que espera que se utilice en la colonización de Marte .

En unos pocos miles de millones de años, el Sol se expandirá hasta convertirse en una gigante roja y se tragará a la Tierra. Esto se puede evitar alejando la Tierra del Sol, manteniendo la temperatura aproximadamente constante. Esto se puede lograr modificando las órbitas de los cometas y asteroides para que pasen cerca de la Tierra de tal manera que agreguen energía a la órbita terrestre. [58] Dado que la expansión del Sol es lenta, aproximadamente un encuentro de este tipo cada 6.000 años sería suficiente. [ cita necesaria ]

El psicólogo Steven Pinker ha calificado el riesgo existencial como una "categoría inútil" que puede distraer la atención de amenazas reales como el cambio climático y la guerra nuclear. [36]

El Boletín de Científicos Atómicos (fundado en 1945) es una de las organizaciones de riesgo global más antiguas, fundada después de que el público se alarmara por el potencial de una guerra atómica después de la Segunda Guerra Mundial. Estudia los riesgos asociados con la guerra y la energía nucleares y mantiene el famoso Reloj del Juicio Final establecido en 1947. El Foresight Institute (fundado en 1986) examina los riesgos de la nanotecnología y sus beneficios. Fue una de las primeras organizaciones en estudiar las consecuencias no deseadas de una tecnología que de otro modo sería inofensiva se descontroló a escala global. Fue fundada por K. Eric Drexler , quien postuló la " goo gris ". [59] [60]

A partir del año 2000, un número creciente de científicos, filósofos y multimillonarios de la tecnología crearon organizaciones dedicadas a estudiar los riesgos globales tanto dentro como fuera del mundo académico. [61]

Las organizaciones no gubernamentales (ONG) independientes incluyen el Machine Intelligence Research Institute (fundado en 2000), cuyo objetivo es reducir el riesgo de una catástrofe causada por la inteligencia artificial, [62] con donantes como Peter Thiel y Jed McCaleb . [63] La Iniciativa sobre Amenaza Nuclear (est. 2001) busca reducir las amenazas globales provenientes de amenazas nucleares, biológicas y químicas, y la contención de daños después de un evento. [8] Mantiene un índice de seguridad del material nuclear. [64] La Lifeboat Foundation (fundada en 2009) financia investigaciones para prevenir una catástrofe tecnológica. [65] La mayor parte del dinero para investigación financia proyectos en universidades. [66] El Global Catastrophic Risk Institute (fundado en 2011) es un grupo de expertos no partidista y sin fines de lucro con sede en Estados Unidos fundado por Seth Baum y Tony Barrett. GCRI realiza trabajos de investigación y políticas sobre diversos riesgos, incluida la inteligencia artificial, la guerra nuclear, el cambio climático y los impactos de asteroides. [67] La Fundación Global Challenges (fundada en 2012), con sede en Estocolmo y fundada por Laszlo Szombatfalvy , publica un informe anual sobre el estado de los riesgos globales. [68] [69] El Future of Life Institute (est. 2014) trabaja para reducir los riesgos extremos a gran escala de las tecnologías transformadoras, así como para dirigir el desarrollo y el uso de estas tecnologías en beneficio de toda la vida, a través de la concesión de subvenciones y la promoción de políticas. en Estados Unidos, Unión Europea y Naciones Unidas, y extensión educativa. [7] Elon Musk , Vitalik Buterin y Jaan Tallinn son algunos de sus mayores donantes. [70] El Centro sobre Riesgos a Largo Plazo (est. 2016), anteriormente conocido como Foundational Research Institute, es una organización británica centrada en reducir los riesgos de sufrimiento astronómico ( s-riesgos ) de las tecnologías emergentes. [71]

Las organizaciones universitarias incluyen el Future of Humanity Institute (fundado en 2005), que investiga las cuestiones del futuro a largo plazo de la humanidad, en particular el riesgo existencial. [5] Fue fundada por Nick Bostrom y tiene su sede en la Universidad de Oxford. [5] El Centro para el Estudio del Riesgo Existencial (fundado en 2012) es una organización con sede en la Universidad de Cambridge que estudia cuatro riesgos tecnológicos principales: inteligencia artificial, biotecnología, calentamiento global y guerra. [6] Todos son riesgos creados por el hombre, como explicó Huw Price a la agencia de noticias AFP: "Parece una predicción razonable que en algún momento de este siglo o del próximo la inteligencia escapará de las limitaciones de la biología". Añadió que cuando esto suceda "ya no seremos los más inteligentes que existen" y correremos el riesgo de quedar a merced de "máquinas que no son maliciosas, pero sí máquinas cuyos intereses no nos incluyen a nosotros". [72] Stephen Hawking fue un asesor interino. La Alianza del Milenio para la Humanidad y la Biosfera es una organización con sede en la Universidad de Stanford que se centra en muchas cuestiones relacionadas con la catástrofe global reuniendo a miembros del mundo académico en humanidades. [73] [74] Fue fundada por Paul Ehrlich , entre otros. [75] La Universidad de Stanford también tiene el Centro para la Seguridad y la Cooperación Internacionales que se centra en la cooperación política para reducir el riesgo catastrófico global. [76] El Centro de Seguridad y Tecnología Emergente se estableció en enero de 2019 en la Escuela Walsh de Servicio Exterior de Georgetown y se centrará en la investigación de políticas de tecnologías emergentes con un énfasis inicial en la inteligencia artificial. [77] Recibieron una subvención de 55 millones de dólares de Good Ventures según lo sugerido por Open Philanthropy . [77]

Otros grupos de evaluación de riesgos tienen su sede o son parte de organizaciones gubernamentales. La Organización Mundial de la Salud (OMS) incluye una división llamada Alerta y Respuesta Global (GAR) que monitorea y responde a la crisis epidémica global. [78] GAR ayuda a los estados miembros con la capacitación y coordinación de la respuesta a las epidemias. [79] La Agencia de los Estados Unidos para el Desarrollo Internacional (USAID) tiene su Programa de Amenazas Pandémicas Emergentes cuyo objetivo es prevenir y contener las pandemias generadas naturalmente en su origen. [80] El Laboratorio Nacional Lawrence Livermore tiene una división llamada Dirección Principal de Seguridad Global que investiga en nombre del gobierno cuestiones como la bioseguridad y el contraterrorismo. [81]

Ésta es una afirmación equivalente, aunque más nítida, de la definición de Nick Bostrom : "Un riesgo existencial es aquel que amenaza con la extinción prematura de la vida inteligente originada en la Tierra o con la destrucción permanente y drástica de su potencial para un desarrollo futuro deseable". Fuente: Bostrom, Nick (2013). "La Prevención de Riesgos Existenciales como Prioridad Global". Política global. 4:15-31.

El creador de Winston, George Orwell, creía que la libertad acabaría por derrotar al totalitarismo distorsionador de la verdad retratado en 1984.

Europa sobrevivió a la pérdida del 25 al 50 por ciento de su población a la peste negra, manteniendo la civilización firmemente intacta.

El organismo internacional responsable de la continua prohibición de las armas biológicas (la Convención sobre Armas Biológicas) tiene un presupuesto anual de 1,4 millones de dólares, menos que el promedio de un restaurante McDonald's.

El Instituto de Investigación de Inteligencia de Máquinas tiene como objetivo reducir el riesgo de una catástrofe, en caso de que finalmente se produzca un evento de este tipo.

Actualmente nos centramos en los esfuerzos para reducir los peores riesgos de sufrimiento astronómico (riesgos s) derivados de las tecnologías emergentes, con especial atención en la inteligencia artificial transformadora.

Ya sea que estés buscando una cura para el cáncer, o siguiendo una carrera académica o artística, o comprometidos en establecer instituciones más justas, una amenaza al futuro de la humanidad es también una amenaza a la importancia de lo que haces.