La entropía es un concepto científico que se asocia más comúnmente con un estado de desorden, aleatoriedad o incertidumbre. El término y el concepto se utilizan en diversos campos, desde la termodinámica clásica , donde se reconoció por primera vez, hasta la descripción microscópica de la naturaleza en la física estadística y los principios de la teoría de la información . Ha encontrado aplicaciones de amplio alcance en la química y la física , en los sistemas biológicos y su relación con la vida, en la cosmología , la economía , la sociología , la ciencia meteorológica , el cambio climático y los sistemas de información , incluida la transmisión de información en las telecomunicaciones . [1]

La entropía es fundamental para la segunda ley de la termodinámica , que establece que la entropía de un sistema aislado que evoluciona espontáneamente no puede disminuir con el tiempo. Como resultado, los sistemas aislados evolucionan hacia el equilibrio termodinámico , donde la entropía es máxima. Una consecuencia de la segunda ley de la termodinámica es que ciertos procesos son irreversibles .

El concepto de termodinámica fue mencionado por el científico e ingeniero escocés William Rankine en 1850 con los nombres de función termodinámica y potencial calorífico . [2] En 1865, el físico alemán Rudolf Clausius , uno de los principales fundadores del campo de la termodinámica, lo definió como el cociente de una cantidad infinitesimal de calor por la temperatura instantánea. Inicialmente lo describió como contenido de transformación , en alemán Verwandlungsinhalt , y más tarde acuñó el término entropía a partir de una palabra griega para transformación . [3]

El físico austríaco Ludwig Boltzmann explicó la entropía como la medida del número de posibles disposiciones o estados microscópicos de átomos y moléculas individuales de un sistema que cumplen con la condición macroscópica del sistema. Con ello introdujo el concepto de desorden estadístico y distribuciones de probabilidad en un nuevo campo de la termodinámica, llamado mecánica estadística , y encontró el vínculo entre las interacciones microscópicas, que fluctúan alrededor de una configuración media, y el comportamiento observable macroscópicamente, en forma de una simple ley logarítmica , con una constante de proporcionalidad , la constante de Boltzmann , que se ha convertido en una de las constantes universales definitorias del moderno Sistema Internacional de Unidades (SI).

En su artículo de 1803 Principios fundamentales del equilibrio y del movimiento , el matemático francés Lazare Carnot propuso que en cualquier máquina, las aceleraciones y los choques de las partes móviles representan pérdidas de momento de actividad ; en cualquier proceso natural existe una tendencia inherente a la disipación de energía útil. En 1824, basándose en ese trabajo, el hijo de Lazare, Sadi Carnot , publicó Reflexiones sobre la fuerza motriz del fuego , que postuló que en todas las máquinas térmicas, siempre que el " calórico " (lo que ahora se conoce como calor) cae a través de una diferencia de temperatura, se puede producir trabajo o fuerza motriz a partir de las acciones de su caída de un cuerpo caliente a uno frío. Utilizó una analogía con la forma en que cae el agua en una rueda hidráulica . Esa fue una idea temprana de la segunda ley de la termodinámica . [4] Carnot basó sus puntos de vista sobre el calor parcialmente en la "hipótesis newtoniana" de principios del siglo XVIII de que tanto el calor como la luz eran tipos de formas indestructibles de materia, que son atraídas y repelidas por otra materia, y parcialmente en las opiniones contemporáneas del conde Rumford , quien demostró en 1789 que el calor podía crearse por fricción, como cuando se mecanizan los cañones. [5] Carnot razonó que si el cuerpo de la sustancia activa, como un cuerpo de vapor, vuelve a su estado original al final de un ciclo completo del motor , "no se produce ningún cambio en la condición del cuerpo activo".

La primera ley de la termodinámica , deducida de los experimentos de calor-fricción de James Joule en 1843, expresa el concepto de energía y su conservación en todos los procesos; la primera ley, sin embargo, no es adecuada para cuantificar por separado los efectos de la fricción y la disipación . [ cita requerida ]

En las décadas de 1850 y 1860, el físico alemán Rudolf Clausius se opuso a la suposición de que no se produce ningún cambio en el cuerpo de trabajo, y dio a ese cambio una interpretación matemática, al cuestionar la naturaleza de la pérdida inherente de calor utilizable cuando se realiza el trabajo, por ejemplo, el calor producido por la fricción. [6] Describió sus observaciones como un uso disipativo de energía, que resulta en un contenido de transformación ( Verwandlungsinhalt en alemán), de un sistema termodinámico o cuerpo de trabajo de especies químicas durante un cambio de estado . [6] Esto contrastaba con puntos de vista anteriores, basados en las teorías de Isaac Newton , de que el calor era una partícula indestructible que tenía masa. Clausius descubrió que la energía no utilizable aumenta a medida que el vapor pasa de la entrada al escape en una máquina de vapor. Del prefijo en- , como en 'energía', y de la palabra griega τροπή [tropē], que se traduce en un léxico establecido como giro o cambio [7] y que él tradujo en alemán como Verwandlung , una palabra a menudo traducida al inglés como transformación , en 1865 Clausius acuñó el nombre de esa propiedad como entropía . [8] La palabra fue adoptada en el idioma inglés en 1868.

Posteriormente, científicos como Ludwig Boltzmann , Josiah Willard Gibbs y James Clerk Maxwell dieron a la entropía una base estadística. En 1877, Boltzmann visualizó una forma probabilística de medir la entropía de un conjunto de partículas de gas ideal , en la que definió la entropía como proporcional al logaritmo natural del número de microestados que podría ocupar dicho gas. La constante de proporcionalidad en esta definición, llamada constante de Boltzmann , se ha convertido en una de las constantes universales definitorias del moderno Sistema Internacional de Unidades (SI). De ahí en adelante, el problema esencial de la termodinámica estadística ha sido determinar la distribución de una cantidad dada de energía E sobre N sistemas idénticos. Constantin Carathéodory , un matemático griego, relacionó la entropía con una definición matemática de irreversibilidad, en términos de trayectorias e integrabilidad.

En 1865, Clausius nombró al concepto de "la diferencial de una cantidad que depende de la configuración del sistema", entropía ( Entropie ) a partir de la palabra griega para 'transformación'. [9] Dio "contenido transformacional" ( Verwandlungsinhalt ) como sinónimo, en paralelo a su "contenido térmico y ergonal" ( Wärme- und Werkinhalt ) como el nombre de U , pero prefiriendo el término entropía como un paralelo cercano de la palabra energía , ya que encontró los conceptos casi "análogos en su significado físico". [9] Este término se formó reemplazando la raíz de ἔργον ('ergon', 'trabajo') por la de τροπή ('tropía', 'transformación'). [8]

Con más detalle, Clausius explicó su elección del nombre "entropía" de la siguiente manera: [10]

Prefiero recurrir a las lenguas antiguas para encontrar los nombres de magnitudes científicas importantes, de modo que signifiquen lo mismo en todas las lenguas vivas. Propongo, por tanto, llamar S a la entropía de un cuerpo, a partir de la palabra griega "transformación". He acuñado deliberadamente la palabra entropía para que sea similar a energía, ya que estas dos magnitudes son tan análogas en su significado físico que una analogía de denominaciones me parece útil.

Leon Cooper añadió que de esta manera «logró acuñar una palabra que significaba lo mismo para todos: nada». [10]

Cualquier método que implique la noción de entropía, cuya existencia depende de la segunda ley de la termodinámica, sin duda parecerá inverosímil a muchos y puede repeler a los principiantes por considerarlo oscuro y difícil de comprender.

Willard Gibbs , Métodos gráficos en la termodinámica de fluidos [11]

El concepto de entropía se describe mediante dos enfoques principales: la perspectiva macroscópica de la termodinámica clásica y la descripción microscópica, fundamental para la mecánica estadística . El enfoque clásico define la entropía en términos de propiedades físicas mensurables macroscópicamente, como la masa, el volumen, la presión y la temperatura. La definición estadística de la entropía la define en términos de las estadísticas de los movimientos de los constituyentes microscópicos de un sistema, modelados al principio de manera clásica, por ejemplo, las partículas newtonianas que constituyen un gas, y más tarde de manera cuántica (fotones, fonones , espines, etc.). Los dos enfoques forman una visión consistente y unificada del mismo fenómeno, tal como se expresa en la segunda ley de la termodinámica, que ha encontrado una aplicabilidad universal a los procesos físicos.

Muchas propiedades termodinámicas se definen por variables físicas que definen un estado de equilibrio termodinámico , que esencialmente son variables de estado . Las variables de estado dependen solo de la condición de equilibrio, no de la evolución del camino hacia ese estado. Las variables de estado pueden ser funciones de estado, también llamadas funciones de estado , en el sentido de que una variable de estado es una función matemática de otras variables de estado. A menudo, si se determinan algunas propiedades de un sistema, son suficientes para determinar el estado del sistema y, por lo tanto, los valores de otras propiedades. Por ejemplo, la temperatura y la presión de una cantidad dada de gas determinan su estado y, por lo tanto, también su volumen a través de la ley de los gases ideales . Un sistema compuesto por una sustancia pura de una sola fase a una temperatura y presión uniformes particulares está determinado y, por lo tanto, es un estado particular y tiene un volumen particular. El hecho de que la entropía sea una función del estado la hace útil. En el ciclo de Carnot , el fluido de trabajo regresa al mismo estado que tenía al comienzo del ciclo, por lo tanto, el cambio o la integral de línea de cualquier función de estado, como la entropía, a lo largo de este ciclo reversible es cero.

El cambio de entropía de un sistema excluyendo sus alrededores puede definirse bien como una pequeña porción de calor transferido al sistema durante el proceso reversible dividido por la temperatura del sistema durante esta transferencia de calor : El proceso reversible es cuasiestático (es decir, ocurre sin ninguna disipación, desviándose solo infinitesimalmente del equilibrio termodinámico), y puede conservar la entropía total. Por ejemplo, en el ciclo de Carnot , mientras que el flujo de calor de un depósito caliente a un depósito frío representa el aumento de la entropía en un depósito frío, el trabajo de salida, si se almacena de forma reversible y perfecta, representa la disminución de la entropía que podría usarse para operar el motor térmico en reversa, volviendo al estado inicial; por lo tanto, el cambio de entropía total todavía puede ser cero en todo momento si todo el proceso es reversible.

Por el contrario, un proceso irreversible aumenta la entropía total del sistema y sus alrededores. [12] Cualquier proceso que ocurre lo suficientemente rápido como para desviarse del equilibrio térmico no puede ser reversible, la entropía total aumenta y se pierde el potencial para que se realice el máximo trabajo durante el proceso. [13]

El concepto de entropía surgió del estudio de Rudolf Clausius del ciclo de Carnot , que es un ciclo termodinámico realizado por un motor térmico de Carnot como un motor térmico reversible. [14] En un ciclo de Carnot, el calor se transfiere de un depósito caliente a un gas de trabajo a temperatura constante durante la etapa de expansión isotérmica y el calor se transfiere de un gas de trabajo a un depósito frío a temperatura constante durante la etapa de compresión isotérmica . Según el teorema de Carnot , un motor térmico con dos depósitos térmicos puede producir un trabajo si y solo si hay una diferencia de temperatura entre los depósitos. Originalmente, Carnot no distinguía entre calores y , ya que suponía que la teoría calórica era válida y, por lo tanto, que el calor total en el sistema se conservaba. Pero, de hecho, la magnitud del calor es mayor que la magnitud del calor . [15] [16] Gracias a los esfuerzos de Clausius y Kelvin , se descubrió que el trabajo realizado por un motor térmico reversible era el producto de la eficiencia de Carnot (es decir, la eficiencia de todos los motores térmicos reversibles con el mismo par de depósitos térmicos) y el calor absorbido por un cuerpo de trabajo del motor durante la expansión isotérmica: Para derivar la eficiencia de Carnot, Kelvin tuvo que evaluar la relación entre el trabajo realizado y el calor absorbido durante la expansión isotérmica con la ayuda de la ecuación de Carnot-Clapeyron, que contenía una función desconocida llamada función de Carnot. La posibilidad de que la función de Carnot pudiera ser la temperatura medida desde un punto cero de temperatura fue sugerida por Joule en una carta a Kelvin. Esto le permitió a Kelvin establecer su escala de temperatura absoluta. [17]

Se sabe que un trabajo producido por un motor durante un ciclo es igual a un calor neto absorbido durante un ciclo. [18] Por lo tanto, con la convención de signos para un calor transferido en un proceso termodinámico ( para una absorción y para una disipación) obtenemos: Dado que esta igualdad se cumple durante un ciclo de Carnot completo, le dio a Clausius la pista de que en cada etapa del ciclo se conservaría la diferencia entre un trabajo y un calor neto, en lugar del calor neto en sí. Lo que significa que existe una función de estado con un cambio de . Se llama energía interna y forma un concepto central para la primera ley de la termodinámica . [19]

Finalmente, la comparación de ambas representaciones de una salida de trabajo en un ciclo de Carnot nos da: [18] [20] De manera similar a la derivación de la energía interna, esta igualdad implica la existencia de una función de estado con un cambio de y que se conserva durante un ciclo completo. Clausius llamó a esta función de estado entropía .

Además, el cambio total de entropía en ambos depósitos térmicos durante el ciclo de Carnot también es cero, ya que la inversión de la dirección de transferencia de calor significa una inversión de signo para el calor transferido durante las etapas isotérmicas: Aquí denotamos el cambio de entropía para un depósito térmico por , donde es para un depósito caliente o para uno frío.

Si consideramos un motor térmico que es menos efectivo que el ciclo de Carnot (es decir, el trabajo producido por este motor es menor que el máximo predicho por el teorema de Carnot), su producción de trabajo está limitada por la eficiencia de Carnot como: La sustitución del trabajo como calor neto en la desigualdad anterior nos da: o en términos del cambio de entropía : Un ciclo de Carnot y una entropía como la que se muestra arriba resultan útiles en el estudio de cualquier motor térmico termodinámico clásico: otros ciclos, como un ciclo Otto , Diesel o Brayton , podrían analizarse desde el mismo punto de vista. En particular, cualquier máquina o proceso cíclico que convierta calor en trabajo (es decir, motor térmico) que se afirma que produce una eficiencia mayor que la de Carnot no es viable, debido a la violación de la segunda ley de la termodinámica .

Para un análisis más detallado de sistemas suficientemente discretos, como un conjunto de partículas, se debe utilizar la termodinámica estadística . Además, la descripción de dispositivos que funcionan cerca del límite de las ondas de De Broglie , por ejemplo, las células fotovoltaicas , deben ser coherentes con la estadística cuántica .

La definición termodinámica de entropía fue desarrollada a principios de la década de 1850 por Rudolf Clausius y describe esencialmente cómo medir la entropía de un sistema aislado en equilibrio termodinámico con sus partes. Clausius creó el término entropía como una variable termodinámica extensa que demostró ser útil para caracterizar el ciclo de Carnot . Se descubrió que la transferencia de calor en los pasos isotérmicos (expansión isotérmica y compresión isotérmica) del ciclo de Carnot era proporcional a la temperatura de un sistema (conocida como su temperatura absoluta ). Esta relación se expresó en un incremento de entropía que es igual a la transferencia de calor incremental dividida por la temperatura. Se descubrió que la entropía variaba en el ciclo termodinámico pero eventualmente regresaba al mismo valor al final de cada ciclo. Por lo tanto, se descubrió que era una función del estado , específicamente un estado termodinámico del sistema.

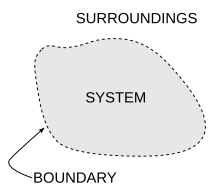

Aunque Clausius basó su definición en un proceso reversible, también existen procesos irreversibles que modifican la entropía. Siguiendo la segunda ley de la termodinámica , la entropía de un sistema aislado siempre aumenta para los procesos irreversibles. La diferencia entre un sistema aislado y un sistema cerrado es que la energía no puede fluir hacia y desde un sistema aislado, pero sí es posible que fluya hacia y desde un sistema cerrado. Sin embargo, tanto en sistemas cerrados como aislados y, de hecho, también en sistemas abiertos, pueden producirse procesos termodinámicos irreversibles.

Según la igualdad de Clausius , para un proceso termodinámico cíclico reversible: lo que significa que la integral de línea es independiente de la trayectoria . Por lo tanto, podemos definir una función de estado , llamada entropía : Por lo tanto, la entropía termodinámica tiene la dimensión de energía dividida por la temperatura y la unidad julio por kelvin (J/K) en el Sistema Internacional de Unidades (SI).

Para encontrar la diferencia de entropía entre dos estados cualesquiera del sistema, la integral debe evaluarse para algún camino reversible entre los estados inicial y final. [21] Dado que la entropía es una función de estado, el cambio de entropía del sistema para un camino irreversible es el mismo que para un camino reversible entre los mismos dos estados. [22] Sin embargo, el calor transferido hacia o desde los alrededores es diferente, así como su cambio de entropía.

Podemos calcular el cambio de entropía solo integrando la fórmula anterior. Para obtener el valor absoluto de la entropía, consideramos la tercera ley de la termodinámica : los cristales perfectos en el cero absoluto tienen una entropía .

Desde una perspectiva macroscópica, en la termodinámica clásica la entropía se interpreta como una función de estado de un sistema termodinámico : es decir, una propiedad que depende únicamente del estado actual del sistema, independientemente de cómo se haya alcanzado ese estado. En cualquier proceso en el que el sistema ceda energía al entorno a la temperatura , su entropía disminuye y al menos de esa energía debe cederse al entorno del sistema en forma de calor. De lo contrario, este proceso no puede seguir adelante. En la termodinámica clásica, la entropía de un sistema se define si y solo si se encuentra en equilibrio termodinámico (aunque no se requiere un equilibrio químico : por ejemplo, la entropía de una mezcla de dos moles de hidrógeno y un mol de oxígeno en condiciones estándar está bien definida).

La definición estadística fue desarrollada por Ludwig Boltzmann en la década de 1870 mediante el análisis del comportamiento estadístico de los componentes microscópicos del sistema. Boltzmann demostró que esta definición de entropía era equivalente a la entropía termodinámica dentro de un factor constante, conocido como la constante de Boltzmann . En resumen, la definición termodinámica de la entropía proporciona la verificación experimental de la entropía, mientras que la definición estadística de la entropía amplía el concepto, proporcionando una explicación y una comprensión más profunda de su naturaleza.

La interpretación de la entropía en mecánica estadística es la medida de incertidumbre, desorden o confusión en la frase de Gibbs , que permanece sobre un sistema después de que se han tomado en cuenta sus propiedades macroscópicas observables, como la temperatura, la presión y el volumen. Para un conjunto dado de variables macroscópicas, la entropía mide el grado en que la probabilidad del sistema se distribuye entre diferentes microestados posibles . En contraste con el macroestado, que caracteriza cantidades promedio claramente observables, un microestado especifica todos los detalles moleculares sobre el sistema, incluida la posición y el momento de cada molécula. Cuantos más estados de este tipo estén disponibles para el sistema con una probabilidad apreciable, mayor será la entropía. En mecánica estadística, la entropía es una medida del número de formas en que se puede organizar un sistema, a menudo considerada como una medida de "desorden" (cuanto mayor es la entropía, mayor es el desorden). [23] [24] [25] Esta definición describe la entropía como proporcional al logaritmo natural del número de posibles configuraciones microscópicas de los átomos y moléculas individuales del sistema ( microestados ) que podrían causar el estado macroscópico observado ( macroestado ) del sistema. La constante de proporcionalidad es la constante de Boltzmann .

La constante de Boltzmann, y por lo tanto la entropía, tienen dimensiones de energía dividida por la temperatura, que tiene una unidad de julios por kelvin (J⋅K −1 ) en el Sistema Internacional de Unidades (o kg⋅m 2 ⋅s −2 ⋅K −1 en términos de unidades básicas). La entropía de una sustancia generalmente se da como una propiedad intensiva , ya sea entropía por unidad de masa (unidad SI: J⋅K −1 ⋅kg −1 ) o entropía por unidad de cantidad de sustancia (unidad SI: J⋅K −1 ⋅mol −1 ).

Específicamente, la entropía es una medida logarítmica para el sistema con un número de estados, cada uno con una probabilidad de estar ocupado (generalmente dada por la distribución de Boltzmann ): donde es la constante de Boltzmann y la suma se realiza sobre todos los microestados posibles del sistema. [26]

En caso de que los estados se definan de manera continua, la suma se reemplaza por una integral sobre todos los estados posibles, o equivalentemente podemos considerar el valor esperado del logaritmo de la probabilidad de que un microestado esté ocupado: Esta definición supone que los estados base se eligen de manera que no haya información sobre sus fases relativas. En un caso general, la expresión es: donde es una matriz de densidad , es un operador de traza y es un logaritmo matricial . El formalismo de la matriz de densidad no es necesario si el sistema está en equilibrio térmico siempre que los estados base se elijan como estados propios de Hamiltoniano . Para la mayoría de los propósitos prácticos, se puede tomar como la definición fundamental de entropía ya que todas las demás fórmulas para se pueden derivar de ella, pero no al revés.

En lo que se ha llamado el postulado fundamental en mecánica estadística , entre microestados del sistema de la misma energía (es decir, microestados degenerados ) se supone que cada microestado está poblado con igual probabilidad , donde es el número de microestados cuya energía es igual a la del sistema. Por lo general, esta suposición se justifica para un sistema aislado en un equilibrio termodinámico. [27] Entonces, en el caso de un sistema aislado, la fórmula anterior se reduce a: En termodinámica, un sistema de este tipo es uno con un volumen, número de moléculas y energía interna fijos, llamado conjunto microcanónico .

La interpretación más general de la entropía es la de una medida del grado de incertidumbre de un sistema. El estado de equilibrio de un sistema maximiza la entropía porque no refleja toda la información sobre las condiciones iniciales, excepto las variables conservadas. Esta incertidumbre no es del tipo subjetivo cotidiano, sino más bien la incertidumbre inherente al método experimental y al modelo interpretativo. [28]

El modelo interpretativo tiene un papel central en la determinación de la entropía. El calificativo "para un conjunto dado de variables macroscópicas" mencionado anteriormente tiene profundas implicaciones cuando dos observadores utilizan diferentes conjuntos de variables macroscópicas. Por ejemplo, considere al observador A utilizando las variables , , y al observador B utilizando las variables , , , . Si el observador B cambia la variable , entonces el observador A verá una violación de la segunda ley de la termodinámica, ya que no posee información sobre la variable y su influencia en el sistema. En otras palabras, uno debe elegir un conjunto completo de variables macroscópicas para describir el sistema, es decir, cada parámetro independiente que pueda cambiar durante el experimento. [29]

La entropía también se puede definir para cualquier proceso de Markov con dinámica reversible y la propiedad de equilibrio detallada .

En sus Conferencias sobre teoría de los gases de 1896 , Boltzmann demostró que esta expresión da una medida de la entropía para sistemas de átomos y moléculas en fase gaseosa, proporcionando así una medida de la entropía de la termodinámica clásica.

La entropía surge directamente del ciclo de Carnot . También se puede describir como el calor reversible dividido por la temperatura. La entropía es una función fundamental del estado.

En un sistema termodinámico , la presión y la temperatura tienden a uniformizarse con el tiempo porque el estado de equilibrio tiene mayor probabilidad (más combinaciones posibles de microestados ) que cualquier otro estado.

Por ejemplo, en el caso de un vaso de agua helada en el aire a temperatura ambiente , la diferencia de temperatura entre la habitación cálida (el entorno) y el vaso frío de hielo y agua (el sistema y no parte de la habitación) disminuye a medida que partes de la energía térmica del entorno cálido se propagan al sistema más frío de hielo y agua. Con el tiempo, la temperatura del vaso y su contenido y la temperatura de la habitación se igualan. En otras palabras, la entropía de la habitación ha disminuido a medida que parte de su energía se ha dispersado al hielo y al agua, cuya entropía ha aumentado.

Sin embargo, como se calcula en el ejemplo, la entropía del sistema de hielo y agua ha aumentado más de lo que ha disminuido la entropía de la habitación circundante. En un sistema aislado como la habitación y el agua helada tomados en conjunto, la dispersión de energía desde el punto más cálido al más frío siempre da como resultado un aumento neto de la entropía. Por lo tanto, cuando el "universo" de la habitación y el sistema de agua helada ha alcanzado un equilibrio de temperatura, el cambio de entropía desde el estado inicial es máximo. La entropía del sistema termodinámico es una medida de cuánto ha progresado la ecualización.

La entropía termodinámica es una función de estado no conservada que es de gran importancia en las ciencias de la física y la química . [23] [30] Históricamente, el concepto de entropía evolucionó para explicar por qué algunos procesos (permitidos por las leyes de conservación) ocurren espontáneamente mientras que sus inversiones temporales (también permitidas por las leyes de conservación) no lo hacen; los sistemas tienden a progresar en la dirección de aumento de la entropía. [31] [32] Para sistemas aislados , la entropía nunca disminuye. [30] Este hecho tiene varias consecuencias importantes en la ciencia: primero, prohíbe las máquinas de " movimiento perpetuo "; y segundo, implica que la flecha de la entropía tiene la misma dirección que la flecha del tiempo . Los aumentos en la entropía total del sistema y sus alrededores corresponden a cambios irreversibles, porque algo de energía se gasta como calor residual, lo que limita la cantidad de trabajo que un sistema puede hacer. [23] [24] [33] [34]

A diferencia de muchas otras funciones de estado, la entropía no se puede observar directamente, sino que debe calcularse. La entropía molar estándar absoluta de una sustancia se puede calcular a partir de la dependencia de la temperatura medida de su capacidad calorífica . La entropía molar de los iones se obtiene como una diferencia de entropía a partir de un estado de referencia definido como entropía cero. La segunda ley de la termodinámica establece que la entropía de un sistema aislado debe aumentar o permanecer constante. Por lo tanto, la entropía no es una cantidad conservada: por ejemplo, en un sistema aislado con temperatura no uniforme, el calor podría fluir irreversiblemente y la temperatura se volvería más uniforme de modo que la entropía aumentara. [35] Las reacciones químicas causan cambios en la entropía y la entropía del sistema, junto con la entalpía , juega un papel importante a la hora de determinar en qué dirección procede espontáneamente una reacción química.

Una definición de entropía que aparece en un diccionario es que es "una medida de energía térmica por unidad de temperatura que no está disponible para trabajo útil" en un proceso cíclico. Por ejemplo, una sustancia a temperatura uniforme tiene una entropía máxima y no puede hacer funcionar un motor térmico. Una sustancia a temperatura no uniforme tiene una entropía menor (que si se permite que la distribución del calor se equilibre) y parte de la energía térmica puede hacer funcionar un motor térmico.

Un caso especial de aumento de entropía, la entropía de mezcla , ocurre cuando se mezclan dos o más sustancias diferentes. Si las sustancias están a la misma temperatura y presión, no hay intercambio neto de calor o trabajo: el cambio de entropía se debe enteramente a la mezcla de las diferentes sustancias. A nivel mecánico estadístico, esto se debe al cambio en el volumen disponible por partícula con la mezcla. [36]

Se conocen pruebas de equivalencia entre la entropía en mecánica estadística —la fórmula de la entropía de Gibbs : y la entropía en termodinámica clásica: junto con la relación termodinámica fundamental para el conjunto microcanónico , el conjunto canónico , el conjunto gran canónico y el conjunto isotérmico-isobárico . Estas pruebas se basan en la densidad de probabilidad de los microestados de la distribución generalizada de Boltzmann y la identificación de la energía interna termodinámica como el promedio del conjunto . [37] Luego se emplean relaciones termodinámicas para derivar la conocida fórmula de la entropía de Gibbs . Sin embargo, la equivalencia entre la fórmula de la entropía de Gibbs y la definición termodinámica de la entropía no es una relación termodinámica fundamental sino más bien una consecuencia de la forma de la distribución generalizada de Boltzmann . [38]

Además, se ha demostrado que las definiciones de entropía en mecánica estadística son la única entropía que es equivalente a la entropía de la termodinámica clásica bajo los siguientes postulados: [39]

La segunda ley de la termodinámica exige que, en general, la entropía total de cualquier sistema no disminuya, salvo que aumente la entropía de algún otro sistema. Por lo tanto, en un sistema aislado de su entorno, la entropía de ese sistema tiende a no disminuir. De ello se deduce que el calor no puede fluir de un cuerpo más frío a un cuerpo más caliente sin la aplicación de trabajo al cuerpo más frío. En segundo lugar, es imposible que cualquier dispositivo que funcione en un ciclo produzca trabajo neto a partir de un único depósito de temperatura; la producción de trabajo neto requiere un flujo de calor de un depósito más caliente a un depósito más frío, o un único depósito en expansión sometido a un enfriamiento adiabático , que realiza un trabajo adiabático . Como resultado, no hay posibilidad de una máquina de movimiento perpetuo . De ello se deduce que una reducción en el aumento de la entropía en un proceso específico, como una reacción química , significa que es energéticamente más eficiente.

De la segunda ley de la termodinámica se desprende que la entropía de un sistema que no está aislado puede disminuir. Un aparato de aire acondicionado , por ejemplo, puede enfriar el aire de una habitación, reduciendo así la entropía del aire de ese sistema. El calor expulsado de la habitación (el sistema), que el aparato de aire acondicionado transporta y descarga al aire exterior, siempre contribuye más a la entropía del ambiente que la disminución de la entropía del aire de ese sistema. Por lo tanto, la suma de la entropía de la habitación más la entropía del ambiente aumenta, de acuerdo con la segunda ley de la termodinámica.

En mecánica, la segunda ley, junto con la relación termodinámica fundamental, impone límites a la capacidad de un sistema para realizar trabajo útil . [40] El cambio de entropía de un sistema a una temperatura que absorbe una cantidad infinitesimal de calor de manera reversible, está dado por . Más explícitamente, una energía no está disponible para realizar trabajo útil, donde es la temperatura del depósito o disipador de calor accesible más frío externo al sistema. Para más información, consulte Exergía .

La mecánica estadística demuestra que la entropía está regida por la probabilidad, lo que permite una disminución del desorden incluso en un sistema aislado. Aunque esto es posible, un evento de este tipo tiene una pequeña probabilidad de ocurrir, lo que lo hace improbable. [41]

La aplicabilidad de una segunda ley de la termodinámica está limitada a sistemas en estado de equilibrio o suficientemente cerca de él , de modo que tengan entropía definida. [42] Algunos sistemas no homogéneos fuera del equilibrio termodinámico aún satisfacen la hipótesis del equilibrio termodinámico local , de modo que la densidad de entropía se define localmente como una cantidad intensiva. Para tales sistemas, puede aplicarse un principio de tasa máxima temporal de producción de entropía. [43] [44] Afirma que un sistema de este tipo puede evolucionar a un estado estacionario que maximice su tasa temporal de producción de entropía. Esto no significa que un sistema de este tipo esté necesariamente siempre en una condición de tasa máxima temporal de producción de entropía; significa que puede evolucionar a dicho estado estacionario. [45] [46]

La entropía de un sistema depende de su energía interna y de sus parámetros externos, como su volumen. En el límite termodinámico, este hecho conduce a una ecuación que relaciona el cambio en la energía interna con los cambios en la entropía y los parámetros externos. Esta relación se conoce como la relación termodinámica fundamental . Si la presión externa afecta al volumen como único parámetro externo, esta relación es: Dado que tanto la energía interna como la entropía son funciones monótonas de la temperatura , lo que implica que la energía interna es fija cuando se especifica la entropía y el volumen, esta relación es válida incluso si el cambio de un estado de equilibrio térmico a otro con entropía y volumen infinitesimalmente mayores ocurre de manera no cuasiestática (por lo que durante este cambio el sistema puede estar muy fuera del equilibrio térmico y entonces la entropía, la presión y la temperatura del sistema completo pueden no existir).

La relación termodinámica fundamental implica muchas identidades termodinámicas que son válidas en general, independientemente de los detalles microscópicos del sistema. Ejemplos importantes son las relaciones de Maxwell y las relaciones entre capacidades térmicas .

La entropía termodinámica es fundamental en la termodinámica química , ya que permite cuantificar los cambios y predecir el resultado de las reacciones. La segunda ley de la termodinámica establece que la entropía en un sistema aislado (la combinación de un subsistema en estudio y su entorno) aumenta durante todos los procesos químicos y físicos espontáneos. La ecuación de Clausius introduce la medición del cambio de entropía que describe la dirección y cuantifica la magnitud de cambios simples como la transferencia de calor entre sistemas, siempre de un cuerpo más caliente a uno más frío de manera espontánea.

La entropía termodinámica es una propiedad extensiva , lo que significa que varía con el tamaño o la extensión de un sistema. En muchos procesos es útil especificar la entropía como una propiedad intensiva independiente del tamaño, como una entropía específica característica del tipo de sistema estudiado. La entropía específica puede expresarse en relación con una unidad de masa, normalmente el kilogramo (unidad: J⋅kg −1 ⋅K −1 ). Alternativamente, en química, también se hace referencia a un mol de sustancia, en cuyo caso se denomina entropía molar con una unidad de J⋅mol −1 ⋅K −1 .

Por lo tanto, cuando un mol de sustancia a aproximadamente0 K se calienta por su entorno a298 K , la suma de los valores incrementales de constituye la entropía molar estándar de cada elemento o compuesto, un indicador de la cantidad de energía almacenada por una sustancia en298 K . [47] [48] El cambio de entropía también mide la mezcla de sustancias como una suma de sus cantidades relativas en la mezcla final. [49]

La entropía es igualmente esencial para predecir la extensión y la dirección de reacciones químicas complejas. Para tales aplicaciones, debe incorporarse en una expresión que incluya tanto al sistema como a sus alrededores: Mediante pasos adicionales, esta expresión se convierte en la ecuación de cambio de energía libre de Gibbs para reactivos y productos en el sistema a presión y temperatura constantes : donde es el cambio de entalpía y es el cambio de entropía. [47]

Un estudio de 2011 en Science estimó la capacidad tecnológica mundial para almacenar y comunicar información comprimida de manera óptima normalizada en los algoritmos de compresión más efectivos disponibles en el año 2007, estimando así la entropía de las fuentes tecnológicamente disponibles. [50] La estimación del autor de que la capacidad tecnológica de la humanidad para almacenar información creció de 2,6 exabytes (comprimidos entrópicamente) en 1986 a 295 exabytes (comprimidos entrópicamente) en 2007. La capacidad tecnológica mundial para recibir información a través de redes de transmisión unidireccionales fue de 432 exabytes de información (comprimida entrópicamente) en 1986, a 1,9 zettabytes en 2007. La capacidad efectiva mundial para intercambiar información a través de redes de telecomunicaciones bidireccionales fue de 281 petabytes de información (comprimida entrópicamente) en 1986, a 65 exabytes (comprimidos entrópicamente) en 2007. [50]

En ingeniería química , los principios de la termodinámica se aplican comúnmente a " sistemas abiertos ", es decir, aquellos en los que el calor, el trabajo y la masa fluyen a través de los límites del sistema. En general, el flujo de calor , el flujo de trabajo de eje y el trabajo de presión-volumen a través de los límites del sistema causan cambios en la entropía del sistema. La transferencia de calor implica transferencia de entropía , donde es la temperatura termodinámica absoluta del sistema en el punto del flujo de calor. Si hay flujos de masa a través de los límites del sistema, también influyen en la entropía total del sistema. Esta explicación, en términos de calor y trabajo, es válida solo para los casos en los que las transferencias de trabajo y calor se realizan por caminos físicamente distintos de los caminos de entrada y salida de materia del sistema. [51] [52]

Para derivar una ecuación generalizada de equilibrio de entropía, comenzamos con la ecuación de equilibrio general para el cambio en cualquier cantidad extensiva en un sistema termodinámico , una cantidad que puede conservarse, como la energía, o no conservarse, como la entropía. La expresión de equilibrio genérica básica establece que , es decir, la tasa de cambio de en el sistema, es igual a la tasa a la que entra al sistema en los límites, menos la tasa a la que sale del sistema a través de los límites del sistema, más la tasa a la que se genera dentro del sistema. Para un sistema termodinámico abierto en el que el calor y el trabajo se transfieren por caminos separados de los caminos de transferencia de materia, utilizando esta ecuación de equilibrio genérica, con respecto a la tasa de cambio con el tiempo de la cantidad extensiva entropía , la ecuación de balance de entropía es: [53] [54] [nota 1] donde es la tasa neta de flujo de entropía debido a los flujos de masa dentro y fuera del sistema con entropía por unidad de masa , es la tasa de flujo de entropía debido al flujo de calor a través del límite del sistema y es la tasa de generación de entropía dentro del sistema, por ejemplo, por reacciones químicas , transiciones de fase , transferencia de calor interna o efectos de fricción como la viscosidad .

En el caso de flujos de calor múltiples, el término se reemplaza por , donde es el flujo de calor a través del puerto -ésimo hacia el sistema y es la temperatura en el puerto -ésimo.

La nomenclatura "balance de entropía" es engañosa y a menudo se considera inadecuada porque la entropía no es una cantidad conservada. En otras palabras, el término nunca es una cantidad conocida, sino siempre una cantidad derivada basada en la expresión anterior. Por lo tanto, la versión de sistema abierto de la segunda ley se describe más apropiadamente como la "ecuación de generación de entropía", ya que especifica que: con cero para un proceso reversible y valores positivos para uno irreversible.

Para ciertas transformaciones simples en sistemas de composición constante, los cambios de entropía se dan mediante fórmulas simples. [55]

Para la expansión (o compresión) de un gas ideal desde un volumen y presión iniciales hasta un volumen y presión finales a cualquier temperatura constante, el cambio en la entropía viene dado por: Aquí es la cantidad de gas (en moles ) y es la constante del gas ideal . Estas ecuaciones también se aplican para la expansión en un vacío finito o un proceso de estrangulamiento , donde la temperatura, la energía interna y la entalpía de un gas ideal permanecen constantes.

Para el calentamiento o enfriamiento puro de cualquier sistema (gas, líquido o sólido) a presión constante desde una temperatura inicial hasta una temperatura final , el cambio de entropía es:

siempre que la capacidad calorífica molar a presión constante (o calor específico) sea constante y que no se produzca ninguna transición de fase en este intervalo de temperatura.

De manera similar, a volumen constante, el cambio de entropía es: donde la capacidad calorífica molar a volumen constante es constante y no hay cambio de fase.

A bajas temperaturas cercanas al cero absoluto, las capacidades térmicas de los sólidos caen rápidamente hasta casi cero , por lo que el supuesto de capacidad térmica constante no se aplica. [56]

Como la entropía es una función de estado , el cambio de entropía de cualquier proceso en el que varíen tanto la temperatura como el volumen es el mismo que para un camino dividido en dos pasos: calentamiento a volumen constante y expansión a temperatura constante. Para un gas ideal, el cambio de entropía total es: [57] De manera similar, si tanto la temperatura como la presión de un gas ideal varían:

Las transiciones de fase reversibles ocurren a temperatura y presión constantes. El calor reversible es el cambio de entalpía para la transición, y el cambio de entropía es el cambio de entalpía dividido por la temperatura termodinámica. [58] Para la fusión (es decir, la fusión ) de un sólido a un líquido en el punto de fusión , la entropía de fusión es: De manera similar, para la vaporización de un líquido a un gas en el punto de ebullición , la entropía de vaporización es:

Como aspecto fundamental de la termodinámica y la física, son válidos varios enfoques diferentes de la entropía además de los de Clausius y Boltzmann.

La siguiente es una lista de definiciones adicionales de entropía de una colección de libros de texto:

En el análisis de Boltzmann en términos de partículas constituyentes, la entropía es una medida del número de posibles estados microscópicos (o microestados) de un sistema en equilibrio termodinámico.

La entropía se asocia a menudo vagamente con la cantidad de orden o desorden , o de caos , en un sistema termodinámico . La descripción cualitativa tradicional de la entropía es que se refiere a los cambios en el estado del sistema y es una medida del "desorden molecular" y la cantidad de energía desperdiciada en una transformación dinámica de energía de un estado o forma a otro. En esta dirección, varios autores recientes han derivado fórmulas de entropía exactas para explicar y medir el desorden y el orden en conjuntos atómicos y moleculares. [61] [62] [63] Una de las fórmulas de orden/desorden de entropía más simples es la derivada en 1984 por el físico termodinámico Peter Landsberg, basada en una combinación de argumentos de la termodinámica y la teoría de la información . Sostiene que cuando las restricciones operan sobre un sistema, de tal manera que se le impide entrar en uno o más de sus estados posibles o permitidos, en contraste con sus estados prohibidos, la medida de la cantidad total de "desorden" en el sistema está dada por: [62] [63] De manera similar, la cantidad total de "orden" en el sistema está dada por: En donde es la capacidad de "desorden" del sistema, que es la entropía de las partes contenidas en el conjunto permitido, es la capacidad de "información" del sistema, una expresión similar a la capacidad del canal de Shannon , y es la capacidad de "orden" del sistema. [61]

El concepto de entropía puede describirse cualitativamente como una medida de dispersión de energía a una temperatura específica. [64] Se han utilizado términos similares desde los inicios de la historia de la termodinámica clásica y, con el desarrollo de la termodinámica estadística y la teoría cuántica , los cambios de entropía se han descrito en términos de la mezcla o "extensión" de la energía total de cada constituyente de un sistema sobre sus niveles particulares de energía cuantificada.

Las ambigüedades en los términos desorden y caos , que por lo general tienen significados directamente opuestos al equilibrio, contribuyen a una confusión generalizada y dificultan la comprensión de la entropía para la mayoría de los estudiantes. [65] Como muestra la segunda ley de la termodinámica , en un sistema aislado, las partes internas a diferentes temperaturas tienden a ajustarse a una única temperatura uniforme y, por lo tanto, producen equilibrio. Un enfoque educativo desarrollado recientemente evita los términos ambiguos y describe dicha dispersión de energía como dispersión, que conduce a la pérdida de los diferenciales necesarios para el trabajo aunque la energía total permanezca constante de acuerdo con la primera ley de la termodinámica [66] (compare la discusión en la siguiente sección). El químico físico Peter Atkins , en su libro de texto Química física , introduce la entropía con la afirmación de que "los cambios espontáneos siempre van acompañados de una dispersión de energía o materia y, a menudo, de ambas". [67]

Es posible (en un contexto térmico) considerar una entropía más baja como una medida de la eficacia o utilidad de una cantidad particular de energía. [68] La energía suministrada a una temperatura más alta (es decir, con una entropía baja) tiende a ser más útil que la misma cantidad de energía disponible a una temperatura más baja. Mezclar una porción caliente de un fluido con una fría produce una porción de temperatura intermedia, en la que el aumento general de entropía representa una "pérdida" que nunca se puede reemplazar.

A medida que la entropía del universo aumenta de forma constante, su energía total se vuelve menos útil. Se cree que, con el tiempo, esto conducirá a la muerte térmica del universo . [69]

Una definición de entropía basada completamente en la relación de accesibilidad adiabática entre estados de equilibrio fue dada por E. H. Lieb y J. Yngvason en 1999. [70] Este enfoque tiene varios predecesores, incluyendo el trabajo pionero de Constantin Carathéodory de 1909 [71] y la monografía de R. Giles. [72] En el contexto de Lieb y Yngvason, uno comienza eligiendo, para una cantidad unitaria de la sustancia en consideración, dos estados de referencia y tales que el último es adiabáticamente accesible desde el primero pero no a la inversa. Definiendo las entropías de los estados de referencia como 0 y 1 respectivamente, la entropía de un estado se define como el número más grande tal que es adiabáticamente accesible desde un estado compuesto que consiste en una cantidad en el estado y una cantidad complementaria, , en el estado . Un resultado simple pero importante dentro de este contexto es que la entropía está determinada únicamente, además de una elección de unidad y una constante aditiva para cada elemento químico, por las siguientes propiedades: es monótona con respecto a la relación de accesibilidad adiabática, aditiva en sistemas compuestos y extensa subescalabilidad.

En mecánica estadística cuántica , el concepto de entropía fue desarrollado por John von Neumann y generalmente se lo conoce como " entropía de von Neumann ": donde es la matriz de densidad , es el operador de traza y es la constante de Boltzmann .

Esto confirma el principio de correspondencia , porque en el límite clásico , cuando las fases entre los estados base son puramente aleatorias, esta expresión es equivalente a la definición clásica familiar de entropía para estados con probabilidades clásicas : es decir, en dicha base la matriz de densidad es diagonal.

Von Neumann estableció un marco matemático riguroso para la mecánica cuántica con su obra Mathematische Grundlagen der Quantenmechanik . En esta obra, presentó una teoría de la medición, en la que la noción habitual de colapso de la función de onda se describe como un proceso irreversible (la llamada medición de von Neumann o proyectiva ). Utilizando este concepto, en conjunción con la matriz de densidad, extendió el concepto clásico de entropía al dominio cuántico.

Pensé en llamarlo "información", pero se usó demasiado la palabra, así que decidí llamarlo "incertidumbre". [...] Von Neumann me dijo: "Deberías llamarlo entropía, por dos razones. En primer lugar, tu función de incertidumbre se ha utilizado en mecánica estadística con ese nombre, por lo que ya tiene un nombre. En segundo lugar, y más importante, nadie sabe qué es realmente la entropía, por lo que en un debate siempre tendrás la ventaja.

Conversación entre Claude Shannon y John von Neumann sobre qué nombre dar a la atenuación en las señales de las líneas telefónicas [73]

Cuando se ve en términos de la teoría de la información , la función de estado de entropía es la cantidad de información en el sistema que se necesita para especificar completamente el microestado del sistema. La entropía es la medida de la cantidad de información faltante antes de la recepción. [74] A menudo llamada entropía de Shannon , fue ideada originalmente por Claude Shannon en 1948 para estudiar el tamaño de la información de un mensaje transmitido. La definición de entropía de información se expresa en términos de un conjunto discreto de probabilidades de modo que: donde la base del logaritmo determina las unidades (por ejemplo, el logaritmo binario corresponde a bits ).

En el caso de los mensajes transmitidos, estas probabilidades eran las probabilidades de que un mensaje en particular fuera realmente transmitido, y la entropía del sistema de mensajes era una medida del tamaño promedio de la información de un mensaje. Para el caso de probabilidades iguales (es decir, cada mensaje es igualmente probable), la entropía de Shannon (en bits) es simplemente el número de preguntas binarias necesarias para determinar el contenido del mensaje. [26]

La mayoría de los investigadores consideran que la entropía de la información y la entropía termodinámica están directamente vinculadas al mismo concepto, [75] [76] [77] [78] [79] mientras que otros sostienen que son distintas. [80] Ambas expresiones son matemáticamente similares. Si es el número de microestados que pueden producir un macroestado dado, y cada microestado tiene la misma probabilidad a priori , entonces esa probabilidad es . La entropía de Shannon (en nats ) es: y si la entropía se mide en unidades de por nat, entonces la entropía viene dada por: que es la fórmula de la entropía de Boltzmann , donde es la constante de Boltzmann, que puede interpretarse como la entropía termodinámica por nat. Algunos autores abogan por eliminar la palabra entropía para la función de la teoría de la información y utilizar en su lugar el otro término de Shannon, "incertidumbre". [81]

La entropía de una sustancia se puede medir, aunque de forma indirecta. La medición, conocida como entropimetría, [82] se realiza sobre un sistema cerrado con número constante de partículas y volumen constante , y utiliza la definición de temperatura [83] en términos de entropía, mientras que limita el intercambio de energía al calor : La relación resultante describe cómo cambia la entropía cuando se introduce una pequeña cantidad de energía en el sistema a una determinada temperatura .

El proceso de medición es el siguiente. Primero, se enfría una muestra de la sustancia lo más cerca posible del cero absoluto. A tales temperaturas, la entropía se acerca a cero, debido a la definición de temperatura. Luego, se introducen pequeñas cantidades de calor en la muestra y se registra el cambio de temperatura, hasta que la temperatura alcanza un valor deseado (generalmente 25 °C). Los datos obtenidos permiten al usuario integrar la ecuación anterior, obteniendo el valor absoluto de la entropía de la sustancia a la temperatura final. Este valor de entropía se llama entropía calorimétrica. [84]

Aunque el concepto de entropía fue originalmente un concepto termodinámico, se ha adaptado en otros campos de estudio, [53] incluyendo la teoría de la información , la psicodinámica , la termoeconomía / economía ecológica y la evolución . [61] [85] [86] [87] [88]

La entropía es la única magnitud en las ciencias físicas que parece implicar una dirección particular de progreso, a veces llamada flecha del tiempo . A medida que avanza el tiempo, la segunda ley de la termodinámica establece que la entropía de un sistema aislado nunca disminuye en sistemas grandes durante períodos de tiempo significativos. Por lo tanto, desde esta perspectiva, la medición de la entropía se considera como un reloj en estas condiciones. [89]

Chiavazzo et al. propusieron que el lugar donde las arañas de cueva deciden poner sus huevos se puede explicar a través de la minimización de la entropía. [90]

Se ha demostrado que la entropía es útil en el análisis de secuencias de pares de bases en el ADN. Se ha demostrado que muchas medidas basadas en la entropía permiten distinguir entre diferentes regiones estructurales del genoma, diferenciar entre regiones codificantes y no codificantes del ADN y también pueden aplicarse para la recreación de árboles evolutivos al determinar la distancia evolutiva entre diferentes especies. [91]

Suponiendo que un universo finito es un sistema aislado, la segunda ley de la termodinámica establece que su entropía total aumenta continuamente. Desde el siglo XIX se ha especulado con que el universo está destinado a una muerte térmica en la que toda la energía termina en una distribución homogénea de energía térmica, de modo que no se puede extraer más trabajo de ninguna fuente.

Si se puede considerar que el universo tiene una entropía en aumento general, entonces –como ha señalado Roger Penrose– la gravedad juega un papel importante en el aumento porque la gravedad hace que la materia dispersa se acumule en estrellas, que finalmente colapsan en agujeros negros . La entropía de un agujero negro es proporcional al área de superficie del horizonte de sucesos del agujero negro . [92] [93] [94] Jacob Bekenstein y Stephen Hawking han demostrado que los agujeros negros tienen la máxima entropía posible de cualquier objeto de igual tamaño. Esto los convierte en puntos finales probables de todos los procesos de aumento de entropía, si son trampas de materia y energía totalmente efectivas. [95] Sin embargo, el escape de energía de los agujeros negros podría ser posible debido a la actividad cuántica (véase la radiación de Hawking ).

El papel de la entropía en la cosmología sigue siendo un tema controvertido desde la época de Ludwig Boltzmann . Trabajos recientes han puesto en duda la hipótesis de la muerte térmica y la aplicabilidad de cualquier modelo termodinámico simple al universo en general. Aunque la entropía aumenta en el modelo de un universo en expansión, la entropía máxima posible aumenta mucho más rápidamente, alejando al universo de la muerte térmica con el tiempo, no acercándolo. [96] [97] [98] Esto da como resultado una "brecha de entropía" que aleja al sistema del equilibrio de muerte térmica postulado. [99] Otros factores que complican la situación, como la densidad de energía del vacío y los efectos cuánticos macroscópicos , son difíciles de conciliar con los modelos termodinámicos, lo que hace que cualquier predicción de la termodinámica a gran escala sea extremadamente difícil. [100]

Las teorías actuales sugieren que la brecha de entropía se abrió originalmente con la rápida expansión exponencial temprana del universo. [101]

El economista rumano-estadounidense Nicholas Georgescu-Roegen , un progenitor de la economía y fundador del paradigma de la economía ecológica , hizo un uso extensivo del concepto de entropía en su obra magna La ley de la entropía y el proceso económico . [76] Debido al trabajo de Georgescu-Roegen, las leyes de la termodinámica forman una parte integral de la escuela de economía ecológica . [102] : 204f [103] : 29–35 Aunque su trabajo estuvo algo manchado por errores , un capítulo completo sobre la economía de Georgescu-Roegen ha sido incluido con aprobación en un libro de texto de física elemental sobre el desarrollo histórico de la termodinámica. [104] : 95–112

En economía, el trabajo de Georgescu-Roegen ha generado el término "pesimismo de entropía" . [105] : 116 Desde la década de 1990, el destacado economista ecológico y teórico del estado estacionario Herman Daly –un estudiante de Georgescu-Roegen– ha sido el defensor más influyente de la posición del pesimismo de entropía en la profesión económica. [106] : 545f [107]

{{cite book}}: CS1 maint: multiple names: authors list (link)Sucht man für

Seinen

bezeichnenden Namen, so könnte man, ähnlich wie von der Gröſse

U

gesagt ist, sie sey der

Wärme- und Werkinhalt

des Körpers, von der Gröſse

S

sagen, sie sey der

Verwandlungsinhalt

des Körpers. Da ich es aber für besser halte, die Namen derartiger für die Wissenschaft wichtiger Gröſsen aus den alten Sprachen zu entnehmen, damit sie unverändert in allen neuen Sprachen angewandt werden können, so schlage ich vor, die Gröſse

S

nach dem griechischen Worte ἡ τροπή, morir Verwandlung, die

Entropie

des Körpers zu nennen. Das Wort

Entropie

habei ich absichtlich dem Worte

Energie

möglichst ähnlich gebildet, denn die beiden Gröſsen, welche durch diese Worte benannt werden sollen, sind ihren physikalischen Bedeutungen nach einander so nahe verwandt, daſs eine gewisse Gleichartigkeit in der Benennung mir z weckmäſsig zu seyn scheint.

acuñó la palabra entropía para : "Prefiero recurrir a las lenguas antiguas para encontrar los nombres de las magnitudes científicas importantes, de modo que puedan significar lo mismo en todas las lenguas vivas. Propongo, en consecuencia, llamar a la entropía de un cuerpo, a partir de la palabra griega 'transformación'. He acuñado deliberadamente la palabra entropía para que sea similar a 'energía', ya que estas dos magnitudes son tan análogas en su significado físico, que una analogía de denominación me pareció útil".

ecuaciones (39), (40) y (65)..

ecuación (64)..

{{cite book}}: CS1 maint: location missing publisher (link){{cite book}}: CS1 maint: multiple names: authors list (link)La página entintada forma un patrón con información → entropía de la página < página de diferencias con letras aleatorias. La entropía reducida es trivial en comparación con la entropía del papel entintado. Si se quema el papel, en un contexto termodinámico no importa si el texto contiene el significado de la vida o solo jerigonza [ sic ].

{{cite book}}: CS1 maint: multiple names: authors list (link){{cite book}}: CS1 maint: multiple names: authors list (link){{cite book}}: CS1 maint: multiple names: authors list (link){{cite book}}: CS1 maint: multiple names: authors list (link){{cite book}}: CS1 maint: multiple names: authors list (link)