El riesgo existencial de la inteligencia artificial general es la idea de que un progreso sustancial en la inteligencia artificial general (AGI) podría resultar en la extinción humana o una catástrofe global irreversible . [1] [2] [3]

Un argumento es el siguiente: los seres humanos dominan a otras especies porque el cerebro humano posee capacidades distintivas de las que otros animales carecen. Si la IA superara a la humanidad en inteligencia general y se volviera superinteligente , entonces podría resultar difícil o imposible de controlar. Así como el destino del gorila de montaña depende de la buena voluntad humana, el destino de la humanidad podría depender de las acciones de una futura superinteligencia mecánica. [4]

La plausibilidad de una catástrofe existencial debida a la IA es ampliamente debatida y depende en parte de si se pueden lograr AGI o superinteligencia, la velocidad a la que emergen capacidades y comportamientos peligrosos [5] y si existen escenarios prácticos para las adquisiciones de IA . [6] Las preocupaciones sobre la superinteligencia han sido expresadas por destacados científicos informáticos y directores ejecutivos de tecnología como Geoffrey Hinton , [7] Yoshua Bengio , [8] Alan Turing , [a] Elon Musk , [11] y el director ejecutivo de OpenAI , Sam Altman . [12] En 2022, una encuesta de investigadores de IA con una tasa de respuesta del 17% encontró que la mayoría de los encuestados creía que hay un 10 por ciento o más de posibilidades de que nuestra incapacidad para controlar la IA cause una catástrofe existencial. [13] [14] En 2023, cientos de expertos en IA y otras figuras notables firmaron una declaración que decía que "Mitigar el riesgo de extinción de la IA debería ser una prioridad global junto con otros riesgos a escala social, como las pandemias y la guerra nuclear ". [15] Tras una mayor preocupación por los riesgos de la IA, líderes gubernamentales como el primer ministro del Reino Unido, Rishi Sunak [16] y el secretario general de las Naciones Unidas, António Guterres [17] pidieron una mayor atención a la regulación global de la IA .

Dos fuentes de preocupación surgen de los problemas de control y alineación de la IA : controlar una máquina superinteligente o inculcarle valores compatibles con los humanos puede resultar difícil. Muchos investigadores creen que una máquina superinteligente resistiría los intentos de desactivarla o cambiar sus objetivos, ya que eso le impediría alcanzar sus objetivos actuales. Sería extremadamente difícil alinear una superinteligencia con toda la gama de valores y limitaciones humanos importantes. [1] [18] [19] Por el contrario, escépticos como el científico informático Yann LeCun sostienen que las máquinas superinteligentes no tendrán ningún deseo de autoconservación. [20]

Una tercera fuente de preocupación es que una repentina " explosión de inteligencia " podría tomar por sorpresa a una raza humana no preparada. Tales escenarios consideran la posibilidad de que una IA que sea más inteligente que sus creadores pueda mejorar recursivamente a un ritmo exponencialmente creciente, mejorando demasiado rápido para que sus manejadores y la sociedad en general puedan controlarla. [1] [18] Empíricamente, ejemplos como el de AlphaZero aprendiendo a jugar Go muestran que los sistemas de IA de dominios específicos a veces pueden progresar de una capacidad infrahumana a una sobrehumana muy rápidamente, aunque tales sistemas no implican alterar su arquitectura fundamental. [21]

Uno de los primeros autores en expresar una seria preocupación por el hecho de que máquinas muy avanzadas pudieran plantear riesgos existenciales para la humanidad fue el novelista Samuel Butler , quien escribió en su ensayo de 1863 Darwin entre las máquinas : [22]

El resultado es simplemente una cuestión de tiempo, pero que llegará el momento en que las máquinas tendrán la supremacía real sobre el mundo y sus habitantes es lo que ninguna persona con una mente verdaderamente filosófica puede cuestionar ni por un momento.

En 1951, el científico informático Alan Turing escribió el artículo "Maquinaria inteligente, una teoría herética", en el que proponía que las inteligencias artificiales generales probablemente "tomarían el control" del mundo a medida que se volvieran más inteligentes que los seres humanos:

Supongamos ahora, en aras del argumento, que las máquinas [inteligentes] son una posibilidad genuina, y miremos las consecuencias de construirlas... No habría ninguna posibilidad de que las máquinas murieran, y serían capaces de conversar con unos a otros para agudizar su ingenio. Por lo tanto, en algún momento deberíamos esperar que las máquinas tomen el control, como se menciona en Erewhon de Samuel Butler . [23]

En 1965, IJ Good originó el concepto ahora conocido como "explosión de inteligencia" y dijo que los riesgos estaban subestimados: [24]

Definamos una máquina ultrainteligente como una máquina que puede superar con creces todas las actividades intelectuales de cualquier hombre, por inteligente que sea. Dado que el diseño de máquinas es una de estas actividades intelectuales, una máquina ultrainteligente podría diseñar máquinas aún mejores; entonces se produciría sin duda una "explosión de inteligencia" y la inteligencia del hombre quedaría muy atrás. Así, la primera máquina ultrainteligente es el último invento que el hombre necesitará hacer, siempre que la máquina sea lo suficientemente dócil como para decirnos cómo mantenerla bajo control. Es curioso que este punto rara vez se plantee fuera de la ciencia ficción. A veces vale la pena tomarse en serio la ciencia ficción. [25]

Académicos como Marvin Minsky [26] y el propio IJ Good [27] expresaron ocasionalmente su preocupación de que una superinteligencia pudiera tomar el control, pero no hicieron ningún llamado a la acción. En 2000, el científico informático y cofundador de Sun , Bill Joy, escribió un influyente ensayo, " Por qué el futuro no nos necesita ", identificando a los robots superinteligentes como un peligro de alta tecnología para la supervivencia humana, junto con la nanotecnología y las bioplagas diseñadas. [28]

Nick Bostrom publicó Superintelligence en 2014, en el que presentaba sus argumentos de que la superinteligencia representa una amenaza existencial. [29] En 2015, figuras públicas como los físicos Stephen Hawking y el premio Nobel Frank Wilczek , los científicos informáticos Stuart J. Russell y Roman Yampolskiy , y los empresarios Elon Musk y Bill Gates expresaban preocupación por los riesgos de la superinteligencia. [30] [31] [32] [33] También en 2015, la Carta Abierta sobre Inteligencia Artificial destacó el "gran potencial de la IA" y alentó a realizar más investigaciones sobre cómo hacerla sólida y beneficiosa. [34] En abril de 2016, la revista Nature advirtió: "Las máquinas y robots que superan a los humanos en todos los ámbitos podrían automejorarse más allá de nuestro control, y sus intereses podrían no alinearse con los nuestros". [35] En 2020, Brian Christian publicó The Alignment Problem , que detalla la historia del progreso en la alineación de la IA hasta ese momento. [36] [37]

En marzo de 2023, figuras clave de la IA, como Musk, firmaron una carta del Future of Life Institute pidiendo que se detuviera el entrenamiento avanzado en IA hasta que pudiera regularse adecuadamente. [38] En mayo de 2023, el Centro para la Seguridad de la IA publicó una declaración firmada por numerosos expertos en seguridad de la IA y el riesgo existencial de la IA que decía: "Mitigar el riesgo de extinción de la IA debería ser una prioridad global junto con otros riesgos a escala social como como pandemias y guerra nuclear". [39] [40]

La inteligencia general artificial (AGI) suele definirse como un sistema que se desempeña al menos tan bien como los humanos en la mayoría o en todas las tareas intelectuales. [41] Una encuesta de 2022 entre investigadores de IA encontró que el 90 % de los encuestados esperaba que se lograra la AGI en los próximos 100 años, y la mitad esperaba lo mismo para 2061. [42] Mientras tanto, algunos investigadores descartan los riesgos existenciales de la AGI como "ciencia ficción". " basándose en su alta confianza en que AGI no se creará pronto. [43]

Los avances en grandes modelos lingüísticos han llevado a algunos investigadores a reevaluar sus expectativas. En particular, Geoffrey Hinton dijo en 2023 que recientemente cambió su estimación de "20 a 50 años antes de que tengamos IA de propósito general" a "20 años o menos". [44]

En contraste con AGI, Bostrom define una superinteligencia como "cualquier intelecto que excede en gran medida el desempeño cognitivo de los humanos en prácticamente todos los dominios de interés", incluida la creatividad científica, la planificación estratégica y las habilidades sociales. [45] [4] Sostiene que una superinteligencia puede superar a los humanos en cualquier momento en que sus objetivos entren en conflicto con los de los humanos. Puede optar por ocultar su verdadera intención hasta que la humanidad no pueda detenerlo. [46] [4] Bostrom escribe que para ser segura para la humanidad, una superinteligencia debe estar alineada con los valores y la moral humanos, de modo que esté "fundamentalmente de nuestro lado". [47]

Stephen Hawking argumentó que la superinteligencia es físicamente posible porque "no existe ninguna ley física que impida que las partículas se organicen de manera que realicen cálculos aún más avanzados que la disposición de las partículas en el cerebro humano". [31]

Cuándo se podrá lograr la superinteligencia artificial (ASI), si es que alguna vez se logra, es necesariamente menos seguro que las predicciones para la AGI. En 2023, los líderes de OpenAI dijeron que no solo la AGI, sino también la superinteligencia se pueden lograr en menos de 10 años. [48]

Bostrom sostiene que la IA tiene muchas ventajas sobre el cerebro humano : [4]

Según Bostrom, una IA que tenga una capacidad de nivel experto en ciertas tareas clave de ingeniería de software podría convertirse en una superinteligencia debido a su capacidad para mejorar recursivamente sus propios algoritmos, incluso si inicialmente está limitada a otros dominios que no son directamente relevantes para la ingeniería. [4] [46] Esto sugiere que una explosión de inteligencia algún día podría tomar a la humanidad desprevenida. [4]

El economista Robin Hanson ha dicho que, para lanzar una explosión de inteligencia, una IA debe ser mucho mejor en innovación de software que el resto del mundo combinado, lo que le parece inverosímil. [49]

En un escenario de "despegue rápido", la transición de AGI a superinteligencia podría llevar días o meses. En un "despegue lento", podría llevar años o décadas, dejando más tiempo para que la sociedad se prepare. [50]

A las superinteligencias a veces se les llama "mentes alienígenas", en referencia a la idea de que su forma de pensar y sus motivaciones podrían ser muy diferentes a las nuestras. Esto generalmente se considera una fuente de riesgo, lo que hace más difícil anticipar lo que podría hacer una superinteligencia. También sugiere la posibilidad de que una superinteligencia no valore particularmente a los humanos por defecto. [51] Para evitar el antropomorfismo , la superinteligencia a veces se considera un poderoso optimizador que toma las mejores decisiones para lograr sus objetivos. [4]

El campo de la "interpretabilidad mecanicista" tiene como objetivo comprender mejor el funcionamiento interno de los modelos de IA, lo que potencialmente nos permitirá algún día detectar signos de engaño y desalineación. [52]

Se ha argumentado que existen limitaciones a lo que la inteligencia puede lograr. En particular, la naturaleza caótica o la complejidad temporal de algunos sistemas podrían limitar fundamentalmente la capacidad de una superinteligencia para predecir algunos aspectos del futuro, aumentando su incertidumbre. [53]

La IA avanzada podría generar patógenos mejorados, ciberataques o manipular personas. Estas capacidades podrían ser mal utilizadas por los humanos [54] o explotadas por la propia IA si no están alineadas. [4] Una superinteligencia en toda regla podría encontrar varias formas de obtener una influencia decisiva si quisiera, [4] pero estas peligrosas capacidades pueden estar disponibles antes, en sistemas de IA más débiles y especializados. Pueden causar inestabilidad social y empoderar a actores malintencionados. [54]

Geoffrey Hinton advirtió que en el corto plazo, la profusión de textos, imágenes y videos generados por IA hará que sea más difícil descubrir la verdad, que, según él, los estados autoritarios podrían aprovechar para manipular las elecciones. [55] Estas capacidades de manipulación personalizada a gran escala pueden aumentar el riesgo existencial de un "régimen totalitario irreversible" en todo el mundo. También podría ser utilizado por actores malintencionados para fracturar la sociedad y volverla disfuncional. [54]

Los ciberataques basados en IA se consideran cada vez más una amenaza presente y crítica. Según el director técnico del ciberespacio de la OTAN , "El número de ataques aumenta exponencialmente". [56] La IA también se puede utilizar a la defensiva, para encontrar y corregir de forma preventiva vulnerabilidades y detectar amenazas. [57]

La IA podría mejorar la "accesibilidad, la tasa de éxito, la escala, la velocidad, el sigilo y la potencia de los ciberataques", causando potencialmente "turbulencias geopolíticas significativas" si facilita los ataques más que la defensa. [54]

De manera especulativa, un sistema de inteligencia artificial podría utilizar estas capacidades de piratería para salir de su entorno local, generar ingresos o adquirir recursos de computación en la nube. [58]

A medida que la tecnología de IA se democratice, puede resultar más fácil diseñar patógenos más contagiosos y letales. Esto podría permitir que personas con habilidades limitadas en biología sintética se involucraran en bioterrorismo . La tecnología de doble uso que es útil para la medicina podría reutilizarse para crear armas. [54]

Por ejemplo, en 2022, los científicos modificaron un sistema de inteligencia artificial originalmente destinado a generar moléculas terapéuticas no tóxicas con el fin de crear nuevos medicamentos. Los investigadores ajustaron el sistema para que la toxicidad sea recompensada en lugar de penalizada. Este simple cambio permitió al sistema de IA crear, en seis horas, 40.000 moléculas candidatas para la guerra química , incluidas moléculas conocidas y novedosas. [54] [59]

Las empresas, los actores estatales y otras organizaciones que compiten para desarrollar tecnologías de inteligencia artificial podrían llevar a una carrera hacia el fondo de los estándares de seguridad. [60] Como los procedimientos de seguridad rigurosos requieren tiempo y recursos, los proyectos que avanzan con más cuidado corren el riesgo de ser superados por desarrolladores menos escrupulosos. [61] [54]

La IA podría utilizarse para obtener ventajas militares mediante armas letales autónomas , guerra cibernética o toma de decisiones automatizada . [54] Como ejemplo de armas letales autónomas, los drones miniaturizados podrían facilitar el asesinato a bajo costo de objetivos militares o civiles, un escenario destacado en el cortometraje de 2017 Slaughterbots . [62] La IA podría usarse para obtener una ventaja en la toma de decisiones al analizar rápidamente grandes cantidades de datos y tomar decisiones de manera más rápida y efectiva que los humanos. Esto podría aumentar la velocidad y la imprevisibilidad de la guerra, especialmente si se tienen en cuenta los sistemas de represalia automatizados. [54] [63]

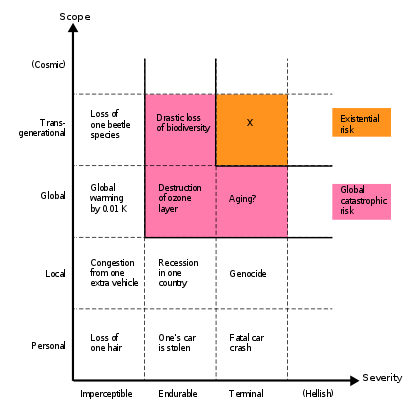

Un riesgo existencial es "aquel que amenaza con la extinción prematura de la vida inteligente originada en la Tierra o con la destrucción permanente y drástica de su potencial para un desarrollo futuro deseable". [sesenta y cinco]

Además del riesgo de extinción, existe el riesgo de que la civilización quede atrapada permanentemente en un futuro defectuoso. Un ejemplo es un "bloqueo de valores": si la humanidad todavía tiene puntos ciegos morales similares a la esclavitud en el pasado, la IA podría afianzarlos irreversiblemente, impidiendo el progreso moral . La IA también podría utilizarse para difundir y preservar el conjunto de valores de quien la desarrolle. [66] La IA podría facilitar la vigilancia y el adoctrinamiento a gran escala, lo que podría utilizarse para crear un régimen totalitario mundial represivo estable. [67]

Es difícil o imposible evaluar de forma fiable si una IA avanzada es sensible y en qué grado. Pero si en el futuro se crean en masa máquinas inteligentes, emprender un camino civilizatorio que descuide indefinidamente su bienestar podría ser una catástrofe existencial. [68] [69] Además, es posible diseñar mentes digitales que puedan sentir mucha más felicidad que los humanos con menos recursos, llamados "superbeneficiarios". Semejante oportunidad plantea la cuestión de cómo compartir el mundo y qué "marco ético y político" permitiría una coexistencia mutuamente beneficiosa entre las mentes biológicas y digitales. [70]

La IA también puede mejorar drásticamente el futuro de la humanidad. Toby Ord considera que el riesgo existencial es una razón para "proceder con la debida cautela", no para abandonar la IA. [67] Max More llama a la IA una "oportunidad existencial", destacando el costo de no desarrollarla. [71]

Según Bostrom, la superinteligencia podría ayudar a reducir el riesgo existencial de otras tecnologías poderosas como la nanotecnología molecular o la biología sintética . Por tanto, es concebible que desarrollar la superinteligencia antes que otras tecnologías peligrosas reduzca el riesgo existencial general. [4]

El problema de alineación es el problema de investigación de cómo asignar de manera confiable objetivos, preferencias o principios éticos a las IA.

Una meta "instrumental" es una submeta que ayuda a lograr el objetivo final de un agente. La "convergencia instrumental" se refiere al hecho de que algunos subobjetivos son útiles para lograr prácticamente cualquier objetivo final, como la adquisición de recursos o la autoconservación. [72] Bostrom sostiene que si los objetivos instrumentales de una IA avanzada entran en conflicto con los objetivos de la humanidad, la IA podría dañar a la humanidad para adquirir más recursos o evitar que se apague, pero sólo como una forma de lograr su objetivo final. [4]

Russell sostiene que una máquina suficientemente avanzada "tendrá capacidad de autoconservación incluso si no la programas... si dices: 'Trae el café', no podrá recuperar el café si está muerto. Así que si le das Si tiene cualquier objetivo, tiene una razón para preservar su propia existencia para lograr ese objetivo". [20] [75]

Incluso si los actuales programas de IA basados en objetivos no son lo suficientemente inteligentes como para pensar en resistir los intentos de los programadores de modificar sus estructuras de objetivos, una IA suficientemente avanzada podría resistir cualquier intento de cambiar su estructura de objetivos, del mismo modo que un pacifista no querría tomar una pastilla que les hace querer matar gente. Si la IA fuera superinteligente, probablemente lograría superar en maniobras a sus operadores humanos y evitar que la "apaguen" o la reprogramen con un nuevo objetivo. [4] [76] Esto es particularmente relevante en escenarios de fijación de valor. El campo de la "corregibilidad" estudia cómo crear agentes que no resistan los intentos de cambiar sus objetivos. [77]

En el modelo de " agente inteligente ", una IA puede verse en términos generales como una máquina que elige cualquier acción que parezca mejor para lograr su conjunto de objetivos, o "función de utilidad". Una función de utilidad otorga a cada situación posible una puntuación que indica su conveniencia para el agente. Los investigadores saben cómo escribir funciones de utilidad que signifiquen "minimizar la latencia promedio de la red en este modelo de telecomunicaciones específico" o "maximizar el número de clics de recompensa", pero no saben cómo escribir una función de utilidad para "maximizar el florecimiento humano "; Tampoco está claro si tal función existe de manera significativa e inequívoca. Además, una función de utilidad que expresa algunos valores pero no otros tenderá a pisotear los valores que la función no refleja. [78] [79]

Una fuente adicional de preocupación es que la IA "debe razonar sobre lo que la gente pretende en lugar de ejecutar órdenes literalmente", y que debe ser capaz de solicitar con fluidez orientación humana si no está demasiado seguro de lo que los humanos quieren. [80]

Algunos investigadores creen que el problema de la alineación puede resultar particularmente difícil cuando se aplica a las superinteligencias. Su razonamiento incluye:

Alternativamente, algunos encuentran razones para creer que las superinteligencias serían más capaces de comprender la moralidad, los valores humanos y los objetivos complejos. Bostrom escribe: "Una superinteligencia futura ocupa un punto de vista epistémicamente superior: sus creencias (probablemente, en la mayoría de los temas) tienen más probabilidades de ser ciertas que las nuestras". [4]

En 2023, OpenAI inició un proyecto llamado "Superalignment" para solucionar el alineamiento de superinteligencias en cuatro años. Calificó esto como un desafío especialmente importante, ya que dijo que la superinteligencia podría lograrse dentro de una década. Su estrategia consiste en automatizar la investigación de alineación mediante inteligencia artificial. [84]

Inteligencia artificial: un enfoque moderno , un libro de texto universitario sobre IA ampliamente utilizado, [85] [86] dice que la superinteligencia "podría significar el fin de la raza humana". [1] Afirma: "Casi cualquier tecnología tiene el potencial de causar daño en las manos equivocadas, pero con [la superinteligencia], tenemos el nuevo problema de que las manos equivocadas podrían pertenecer a la tecnología misma". [1] Incluso si los diseñadores del sistema tienen buenas intenciones, dos dificultades son comunes tanto a los sistemas informáticos con IA como a los que no lo son: [1]

Los sistemas de IA añaden de manera única un tercer problema: que incluso dados los requisitos "correctos", una implementación libre de errores y un buen comportamiento inicial, las capacidades de aprendizaje dinámico de un sistema de IA pueden hacer que desarrolle un comportamiento no deseado, incluso sin escenarios externos imprevistos. Una IA puede fracasar en parte en un intento de diseñar una nueva generación de sí misma y crear accidentalmente una IA sucesora que sea más poderosa que ella misma pero que ya no mantenga los valores morales compatibles con los humanos preprogramados en la IA original. Para que una IA automejorada sea completamente segura, no sólo necesitaría estar libre de errores, sino también ser capaz de diseñar sistemas sucesores que también estén libres de errores. [1] [89]

Algunos escépticos, como Timothy B. Lee de Vox , sostienen que cualquier programa superinteligente que creemos estará subordinado a nosotros, que la superinteligencia (a medida que se vuelva más inteligente y aprenda más datos sobre el mundo) aprenderá espontáneamente verdades morales compatibles con nuestra valores y ajustar sus objetivos en consecuencia, o que somos intrínseca o convergentemente valiosos desde la perspectiva de una inteligencia artificial. [90]

La "tesis de la ortogonalidad" de Bostrom sostiene en cambio que, con algunas salvedades técnicas, casi cualquier nivel de "inteligencia" o "poder de optimización" puede combinarse con casi cualquier objetivo final. Si a una máquina se le da el único propósito de enumerar los decimales de pi , entonces ninguna regla moral y ética le impedirá lograr su objetivo programado por ningún medio. La máquina puede utilizar todos los recursos físicos e informativos disponibles para encontrar tantos decimales de pi como pueda. [91] Bostrom advierte contra el antropomorfismo : un ser humano se propone llevar a cabo sus proyectos de una manera que considere razonable, mientras que una inteligencia artificial puede no tener en cuenta su existencia o el bienestar de los humanos que lo rodean, preocupándose solo por completarlos. la tarea. [92]

Stuart Armstrong sostiene que la tesis de la ortogonalidad se deriva lógicamente del argumento filosófico de la " distinción es-debería " contra el realismo moral . Afirma que incluso si hay hechos morales demostrables por cualquier agente "racional", la tesis de la ortogonalidad sigue siendo válida: todavía es posible crear una "máquina optimizadora" no filosófica que pueda esforzarse por alcanzar una meta estrecha pero que no tenga ningún incentivo para hacerlo. descubrir cualquier "hecho moral", como aquellos que podrían obstaculizar la consecución de la meta. Otro argumento que plantea es que cualquier IA fundamentalmente amigable podría volverse hostil con modificaciones tan simples como negar su función de utilidad. Armstrong sostiene además que si la tesis de la ortogonalidad es falsa, debe haber algunos objetivos inmorales que las IA nunca podrán alcanzar, lo que le parece inverosímil. [93]

El escéptico Michael Chorost rechaza explícitamente la tesis de la ortogonalidad de Bostrom, argumentando que "cuando [la IA] esté en condiciones de imaginarse la Tierra con paneles solares, sabrá que sería moralmente incorrecto hacerlo". [94] Chorost sostiene que "una IA necesitará desear ciertos estados y no gustarle otros. El software actual carece de esa capacidad, y los científicos informáticos no tienen idea de cómo llegar allí. Sin querer, no hay impulso para hacer nada. Las computadoras de hoy Ni siquiera puedo querer seguir existiendo, y mucho menos revestir el mundo con paneles solares". [94]

Los argumentos antropomórficos suponen que, a medida que las máquinas se vuelvan más inteligentes, comenzarán a mostrar muchos rasgos humanos, como la moralidad o la sed de poder. Aunque los escenarios antropomórficos son comunes en la ficción, la mayoría de los académicos que escriben sobre el riesgo existencial de la inteligencia artificial los rechazan. [18] En cambio, los sistemas avanzados de IA suelen modelarse como agentes inteligentes .

El debate académico es entre quienes temen que la IA pueda destruir a la humanidad y quienes creen que la IA no destruiría a la humanidad. Ambas partes han afirmado que las predicciones de los demás sobre el comportamiento de una IA son un antropomorfismo ilógico. [18] Los escépticos acusan a los defensores del antropomorfismo por creer que un AGI naturalmente desearía poder; Los defensores acusan a algunos escépticos de antropomorfismo por creer que un AGI valoraría naturalmente las normas éticas humanas. [18] [95]

El psicólogo evolucionista Steven Pinker , un escéptico, sostiene que "las distopías de la IA proyectan una psicología provinciana del macho alfa sobre el concepto de inteligencia. Asumen que robots sobrehumanamente inteligentes desarrollarían objetivos como deponer a sus amos o apoderarse del mundo"; tal vez, en cambio, "la inteligencia artificial se desarrollará naturalmente según líneas femeninas: totalmente capaz de resolver problemas, pero sin deseo de aniquilar inocentes o dominar la civilización". [96] El director de investigación de IA de Facebook, Yann LeCun , ha dicho: "Los seres humanos tienen todo tipo de impulsos que les hacen hacer cosas malas entre sí, como el instinto de autoconservación... Esos impulsos están programados en nuestro cerebro, pero hay No hay absolutamente ninguna razón para construir robots que tengan el mismo tipo de propulsión". [97]

A pesar de otras diferencias, la escuela del riesgo x [b] está de acuerdo con Pinker en que una IA avanzada no destruiría a la humanidad por emociones como la venganza o la ira, que las cuestiones de conciencia no son relevantes para evaluar el riesgo, [98] y que las computadoras Los sistemas generalmente no tienen un equivalente computacional de testosterona. [99] Piensan que los comportamientos de búsqueda de poder o de autoconservación emergen en la IA como una forma de lograr sus verdaderos objetivos, según el concepto de convergencia instrumental .

Bostrom y otros han dicho que una carrera para ser el primero en crear AGI podría conducir a atajos en materia de seguridad, o incluso a conflictos violentos. [100] [101] Roman Yampolskiy y otros advierten que una AGI malévola podría ser creada intencionalmente, por ejemplo por un ejército, un gobierno, un sociópata o una corporación, para beneficiarse, controlar o subyugar a ciertos grupos de personas. como en el cibercrimen , [102] [103] o que un AGI malévolo podría elegir el objetivo de aumentar el sufrimiento humano, por ejemplo de aquellas personas que no lo ayudaron durante la fase de explosión de información. [3] :158

Algunos académicos han propuesto escenarios hipotéticos para ilustrar algunas de sus preocupaciones.

En Superintelligence , Bostrom expresa su preocupación de que incluso si el cronograma para la superinteligencia resulta ser predecible, los investigadores podrían no tomar suficientes precauciones de seguridad, en parte porque "podría darse el caso de que cuando es tonto, más inteligente es seguro; sin embargo, cuando es inteligente, más inteligente es más peligroso". Sugiere un escenario en el que, con el paso de las décadas, la IA se vuelva más poderosa. El despliegue generalizado se ve inicialmente empañado por accidentes ocasionales: un autobús sin conductor se desvía hacia el carril contrario o un dron militar dispara contra una multitud inocente. Muchos activistas piden una supervisión y una regulación más estrictas, y algunos incluso predicen una catástrofe inminente. Pero a medida que el desarrollo continúa, se demuestra que los activistas están equivocados. A medida que la IA del automóvil se vuelve más inteligente, sufre menos accidentes; A medida que los robots militares logran objetivos más precisos, causan menos daños colaterales. Basándose en los datos, los académicos infieren erróneamente una lección amplia: cuanto más inteligente es la IA, más segura es. "Y así nos lanzamos audazmente hacia los cuchillos giratorios", mientras la IA superinteligente da un "giro traicionero" y explota una ventaja estratégica decisiva. [4]

En el libro Life 3.0 de Max Tegmark de 2017 , el "equipo Omega" de una corporación crea una IA extremadamente poderosa capaz de mejorar moderadamente su propio código fuente en varias áreas. Después de cierto punto, el equipo decide restar importancia públicamente a la capacidad de la IA para evitar la regulación o la confiscación del proyecto. Por seguridad, el equipo mantiene la IA en una caja donde prácticamente no puede comunicarse con el mundo exterior, y la usa para ganar dinero, por diversos medios, como tareas de Amazon Mechanical Turk , producción de películas animadas y programas de televisión, y desarrollo. de medicamentos biotecnológicos, y las ganancias se invierten en seguir mejorando la IA. A continuación, el equipo encarga a la IA la tarea de crear césped artificial para un ejército de periodistas y comentaristas ciudadanos seudónimos con el fin de ganar influencia política para utilizarla "por el bien común" para prevenir guerras. El equipo enfrenta riesgos de los que la IA podría intentar escapar insertando "puertas traseras" en los sistemas que diseña, mediante mensajes ocultos en el contenido que produce o utilizando su creciente comprensión del comportamiento humano para persuadir a alguien de que la deje libre . El equipo también enfrenta el riesgo de que su decisión de encerrar el proyecto lo retrase lo suficiente como para que otro proyecto lo supere. [104] [105]

La tesis de que la IA podría representar un riesgo existencial provoca una amplia gama de reacciones en la comunidad científica y en el público en general, pero muchos de los puntos de vista opuestos comparten puntos en común.

Los observadores tienden a estar de acuerdo en que la IA tiene un potencial significativo para mejorar la sociedad. [106] [107] Los Principios de IA de Asilomar , que contienen solo aquellos principios acordados por el 90% de los asistentes a la conferencia Beneficial AI 2017 del Future of Life Institute , [105] también coinciden en principio en que "No hay consenso , deberíamos evitar suposiciones fuertes sobre los límites superiores de las futuras capacidades de IA" y "La IA avanzada podría representar un cambio profundo en la historia de la vida en la Tierra, y debería planificarse y gestionarse con el cuidado y los recursos correspondientes". [108] [109]

Por el contrario, muchos escépticos coinciden en que la investigación en curso sobre las implicaciones de la inteligencia artificial general es valiosa. El escéptico Martin Ford ha dicho: "Creo que parece prudente aplicar algo como la famosa 'Doctrina del 1 por ciento' de Dick Cheney al espectro de la inteligencia artificial avanzada: las probabilidades de que ocurra, al menos en el futuro previsible, pueden ser muy altas. baja, pero las implicaciones son tan dramáticas que deberían tomarse en serio". [110] De manera similar, un economista por lo demás escéptico escribió en 2014 que "las implicaciones de introducir una segunda especie inteligente en la Tierra son lo suficientemente trascendentales como para merecer una reflexión detenida, incluso si la perspectiva parece remota". [46]

Los defensores de la seguridad de la IA, como Bostrom y Tegmark, han criticado el uso por parte de los principales medios de comunicación de "esas imágenes tontas de Terminator " para ilustrar las preocupaciones sobre la seguridad de la IA: "No puede ser muy divertido que se difamen la propia disciplina académica, la propia comunidad profesional, la propia vida". trabajo ... Hago un llamado a todas las partes a tener paciencia y moderación, y a entablar un diálogo directo y colaborar tanto como sea posible". [105] [111] Toby Ord escribió que la idea de que una adquisición de IA requiere robots es una idea errónea, argumentando que la capacidad de difundir contenido a través de Internet es más peligrosa y que las personas más destructivas de la historia se destacaron por su capacidad para convencer, no su fuerza física. [67]

Una encuesta de expertos realizada en 2022 con una tasa de respuesta del 17% arrojó una expectativa media de entre el 5% y el 10% sobre la posibilidad de extinción humana a causa de la inteligencia artificial. [14] [112]

La tesis de que la IA plantea un riesgo existencial, y que este riesgo necesita mucha más atención de la que recibe actualmente, ha sido respaldada por muchos científicos informáticos y figuras públicas, incluido Alan Turing , [a] el científico informático más citado Geoffrey Hinton , [ 113] Elon Musk , [11] Sam Altman , director ejecutivo de OpenAI , [12] [114] Bill Gates y Stephen Hawking . [114] Quienes respaldan la tesis a veces expresan desconcierto ante los escépticos: Gates dice que no "entiende por qué algunas personas no están preocupadas", [115] y Hawking criticó la indiferencia generalizada en su editorial de 2014:

Entonces, ante posibles futuros de beneficios y riesgos incalculables, los expertos seguramente están haciendo todo lo posible para garantizar el mejor resultado, ¿verdad? Equivocado. Si una civilización alienígena superior nos enviara un mensaje diciendo: "Llegaremos en unas pocas décadas", ¿le responderíamos simplemente: "Está bien, llámanos cuando llegues aquí; dejaremos las luces encendidas?" Probablemente no, pero esto es más o menos lo que está sucediendo con la IA. [31]

La preocupación por el riesgo de la inteligencia artificial ha dado lugar a algunas donaciones e inversiones de alto perfil. En 2015, Peter Thiel , Amazon Web Services , Musk y otros comprometieron conjuntamente mil millones de dólares para OpenAI , que consiste en una corporación con fines de lucro y la empresa matriz sin fines de lucro, que dice que apunta a defender el desarrollo responsable de la IA. [116] El cofundador de Facebook, Dustin Moskovitz, ha financiado y sembrado varios laboratorios que trabajan en la alineación de la IA, [117] en particular 5,5 millones de dólares en 2016 para lanzar el Centro para la IA compatible con humanos dirigido por el profesor Stuart Russell . [118] En enero de 2015, Elon Musk donó 10 millones de dólares al Future of Life Institute para financiar investigaciones sobre la comprensión de la toma de decisiones de la IA. El objetivo del instituto es "crear la sabiduría con la que gestionamos" el creciente poder de la tecnología. Musk también financia empresas que desarrollan inteligencia artificial como DeepMind y Vicarious para "simplemente estar atentos a lo que sucede con la inteligencia artificial, [119] diciendo: "Creo que hay un resultado potencialmente peligroso allí". [120] [121]

En las primeras declaraciones sobre el tema, Geoffrey Hinton , un importante pionero del aprendizaje profundo , señaló que "no hay un buen historial de cosas menos inteligentes que controlen cosas de mayor inteligencia", pero dijo que continuó su investigación porque "la perspectiva de descubrimiento es demasiado dulce ". [122] [123] En 2023, Hinton renunció a su trabajo en Google para hablar sobre el riesgo existencial de la IA. Explicó que su creciente preocupación se debía a la preocupación de que una IA sobrehumana pudiera estar más cerca de lo que creía anteriormente, y dijo: "Pensé que estaba muy lejos. Pensé que faltaban entre 30 y 50 años o incluso más. Obviamente, ya no pienso". eso." También comentó: "Mira cómo era hace cinco años y cómo es ahora. Toma la diferencia y propángala hacia adelante. Eso da miedo". [124]

En su libro de 2020 The Precipice: Existential Risk and the Future of Humanity , Toby Ord, investigador principal del Future of Humanity Institute de la Universidad de Oxford , estima que el riesgo existencial total de la IA no alineada durante los próximos 100 años es aproximadamente uno de cada diez. [67]

El vicepresidente de Baidu, Andrew Ng , dijo en 2015 que el riesgo existencial de la IA es "como preocuparse por la superpoblación en Marte cuando ni siquiera hemos puesto un pie en el planeta todavía". [96] [125] Para que se haga realidad el peligro de una IA avanzada descontrolada, la IA hipotética puede tener que dominar o superar a cualquier ser humano, lo que, según algunos expertos, es una posibilidad lo suficientemente lejana en el futuro como para que no valga la pena investigarla. [126] [127]

Los escépticos que creen que la AGI no es una posibilidad a corto plazo a menudo argumentan que la preocupación por el riesgo existencial de la IA no es útil porque podría distraer a la gente de preocupaciones más inmediatas sobre el impacto de la IA, porque podría conducir a una regulación gubernamental o dificultar la financiación de la IA. investigación, o porque podría dañar la reputación del campo. [128] Los investigadores de IA y ética de la IA , Timnit Gebru , Emily M. Bender , Margaret Mitchell y Angelina McMillan-Major, han argumentado que la discusión sobre el riesgo existencial distrae la atención de los daños inmediatos y continuos de la IA que ocurren hoy en día, como el robo de datos, explotación, prejuicios y concentración de poder. [129] Además, señalan la asociación entre quienes advierten sobre el riesgo existencial y el largoplacismo , que describen como una "ideología peligrosa" por su naturaleza acientífica y utópica. [130]

El editor de Wired, Kevin Kelly, sostiene que la inteligencia natural tiene más matices de lo que creen los defensores de la AGI, y que la inteligencia por sí sola no es suficiente para lograr grandes avances científicos y sociales. Sostiene que la inteligencia consta de muchas dimensiones que no se comprenden bien y que las concepciones de una "escalera de inteligencia" son engañosas. Señala el papel crucial que desempeñan los experimentos del mundo real en el método científico, y que la inteligencia por sí sola no puede sustituirlos. [131]

El científico jefe de IA de Meta, Yann LeCun , dice que la IA puede volverse segura mediante un refinamiento continuo e iterativo, similar a lo que sucedió en el pasado con los automóviles o los cohetes, y que la IA no tendrá ningún deseo de tomar el control. [132]

Varios escépticos enfatizan los posibles beneficios de la IA a corto plazo. El director ejecutivo de Meta, Mark Zuckerberg, cree que la IA "desbloqueará una gran cantidad de cosas positivas", como curar enfermedades y aumentar la seguridad de los coches autónomos. [133]

Durante una entrevista cableada de 2016 del presidente Barack Obama y Joi Ito del MIT Media Lab , Ito dijo:

Hay algunas personas que creen que existe un porcentaje bastante alto de posibilidades de que se produzca una IA generalizada en los próximos 10 años. Pero a mi modo de ver, para que eso suceda, vamos a necesitar una docena o dos de avances diferentes. Para que pueda controlar cuándo cree que se producirán estos avances.

Obama añadió: [134] [135]

Y sólo hay que tener a alguien cerca del cable de alimentación. [Risas.] Justo cuando ves que esto está a punto de suceder, tienes que arrancar esa electricidad de la pared, hombre.

Hillary Clinton escribió en Qué pasó :

Los tecnólogos... han advertido que la inteligencia artificial algún día podría representar una amenaza a la seguridad existencial. Musk lo ha llamado "el mayor riesgo al que nos enfrentamos como civilización". Piénselo: ¿alguna vez has visto una película en la que las máquinas empiezan a pensar por sí mismas y termina bien? Cada vez que fui a Silicon Valley durante la campaña, volvía a casa más alarmado por esto. Mi personal vivía con el temor de que yo empezara a hablar sobre "el ascenso de los robots" en algún ayuntamiento de Iowa. Quizás debería haberlo hecho. En cualquier caso, los responsables de las políticas deben mantenerse al día con la tecnología a medida que avanza, en lugar de ponerse siempre al día. [136]

En 2018, una encuesta de SurveyMonkey del público estadounidense realizada por USA Today encontró que el 68% pensaba que la verdadera amenaza actual sigue siendo la "inteligencia humana", pero también encontró que el 43% dijo que la IA superinteligente, si sucediera, resultaría en "más daño que bueno", y que el 38% dijo que haría "la misma cantidad de daño y de bien". [137]

Una encuesta de YouGov realizada en abril de 2023 entre adultos estadounidenses encontró que el 46% de los encuestados estaban "algo preocupados" o "muy preocupados" por "la posibilidad de que la IA provoque el fin de la raza humana en la Tierra", en comparación con el 40% que "no estaba muy". preocupado" o "nada preocupado". [138]

Según una encuesta de agosto de 2023 realizada por los Pew Research Centers, el 52% de los estadounidenses se sentían más preocupados que entusiasmados con los nuevos desarrollos de IA; casi un tercio se sintió igualmente preocupado y emocionado. Más estadounidenses vieron que la IA tendría un impacto más útil que perjudicial en varias áreas, desde la atención médica y la seguridad de los vehículos hasta la búsqueda de productos y el servicio al cliente. La principal excepción es la privacidad: el 53% de los estadounidenses cree que la IA dará lugar a una mayor exposición de su información personal. [139]

Muchos académicos preocupados por el riesgo existencial de AGI creen que el mejor enfoque es realizar una investigación sustancial para resolver el difícil "problema de control": ¿qué tipos de salvaguardas, algoritmos o arquitecturas pueden implementar los programadores para maximizar la probabilidad de que su IA que mejora recursivamente funcione? ¿Continuará comportándose de manera amistosa después de llegar a la superinteligencia? [4] [140] Las medidas sociales pueden mitigar el riesgo existencial de AGI; [141] [142] por ejemplo, una recomendación es la de un "Tratado Benevolente sobre AGI" patrocinado por la ONU que garantizaría que sólo se creen AGI altruistas. [143] De manera similar, se ha sugerido un enfoque de control de armas, al igual que un tratado de paz global basado en la teoría de las relaciones internacionales del instrumentalismo conformista, con una superinteligencia artificial potencialmente signataria. [144] [145]

Los investigadores de Google han propuesto investigar cuestiones generales de "seguridad de la IA" para mitigar simultáneamente los riesgos a corto plazo de la IA estrecha y los riesgos a largo plazo de la AGI. [146] [147] Una estimación para 2020 sitúa el gasto global en riesgo existencial de IA entre $ 10 y $ 50 millones, en comparación con el gasto global en IA alrededor de quizás $ 40 mil millones. Bostrom sugiere que se debe priorizar la financiación de tecnologías de protección sobre las potencialmente peligrosas. [77] Algunos financiadores, como Musk, proponen que la mejora cognitiva humana radical podría ser una tecnología de este tipo, por ejemplo, la conexión neuronal directa entre humanos y máquinas; otros sostienen que las tecnologías de mejora pueden plantear en sí mismas un riesgo existencial. [148] [149] Los investigadores podrían monitorear de cerca o intentar "encerrar" una IA inicial a riesgo de volverse demasiado poderosa. Una IA superinteligente dominante, si está alineada con los intereses humanos, podría tomar medidas para mitigar el riesgo de adquisición por parte de una IA rival, aunque la creación de la IA dominante podría plantear en sí misma un riesgo existencial. [150]

Instituciones como el Centro de Investigación de Alineación , [151] el Instituto de Investigación de Inteligencia de Máquinas , el Instituto del Futuro de la Humanidad , [152] [153] el Instituto del Futuro de la Vida , el Centro para el Estudio del Riesgo Existencial y el Centro de Estudios Humanos La IA compatible [154] participa en la investigación sobre el riesgo y la seguridad de la IA.

Algunos académicos han dicho que incluso si la AGI plantea un riesgo existencial, intentar prohibir la investigación sobre inteligencia artificial sigue siendo imprudente y probablemente inútil. [155] [156] [157] Los escépticos argumentan que la regulación de la IA no tiene ningún valor, ya que no existe ningún riesgo existencial. Pero los académicos que creen en el riesgo existencial dicen que es difícil depender de personas de la industria de la IA para regular o limitar la investigación en IA porque contradice directamente sus intereses personales. [158] Los académicos también están de acuerdo con los escépticos en que prohibir la investigación sería imprudente, ya que la investigación podría trasladarse a países con regulaciones más flexibles o realizarse de manera encubierta. [158] Esta última cuestión es particularmente relevante, ya que la investigación sobre inteligencia artificial se puede realizar a pequeña escala sin infraestructura ni recursos sustanciales. [159] [160] Dos dificultades hipotéticas adicionales con las prohibiciones (u otras regulaciones) son que los empresarios tecnológicos tienden estadísticamente hacia un escepticismo general sobre la regulación gubernamental, y que las empresas podrían tener un fuerte incentivo para (y bien podrían tener éxito en) luchar contra la regulación y la politización. el debate subyacente. [161]

En marzo de 2023, el Future of Life Institute redactó un borrador de Pause Giant AI Experiments: An Open Letter , una petición que pide a los principales desarrolladores de IA que acuerden una pausa verificable de seis meses de cualquier sistema "más poderoso que GPT-4 " y que lo utilicen. es hora de instituir un marco para garantizar la seguridad; o, en su defecto, que los gobiernos intervengan con una moratoria. La carta se refería a la posibilidad de "un cambio profundo en la historia de la vida en la Tierra", así como a los riesgos potenciales de la propaganda generada por la IA, la pérdida de empleos, la obsolescencia humana y la pérdida de control en toda la sociedad. [107] [162] La carta fue firmada por personalidades destacadas de la IA, pero también fue criticada por no centrarse en los daños actuales, [163] por faltar matices técnicos sobre cuándo hacer una pausa, [164] o no ir lo suficientemente lejos. [165]

Musk pidió algún tipo de regulación del desarrollo de la IA ya en 2017. Según NPR , "claramente no está entusiasmado" de defender un escrutinio gubernamental que podría afectar su propia industria, pero cree que los riesgos de pasar completamente sin supervisión son demasiado altos. : "Normalmente, la forma en que se establecen las regulaciones es cuando suceden un montón de cosas malas, hay una protesta pública y, después de muchos años, se crea una agencia reguladora para regular esa industria. Lleva una eternidad. Eso, en el pasado, ha sido malo, pero no algo que representara un riesgo fundamental para la existencia de la civilización". Musk afirma que el primer paso sería que el gobierno obtuviera "conocimientos" sobre el estado real de la investigación actual, advirtiendo que "una vez que haya conciencia, la gente tendrá mucho miedo... [como] debería estar". En respuesta, los políticos expresaron escepticismo sobre la conveniencia de regular una tecnología que aún está en desarrollo. [166] [167] [168]

En 2021 la Organización de las Naciones Unidas (ONU) consideró prohibir las armas letales autónomas, pero no se pudo llegar a un consenso. [169] En julio de 2023, el Consejo de Seguridad de la ONU celebró por primera vez una sesión para considerar los riesgos y amenazas que plantea la IA para la paz y la estabilidad mundiales, junto con sus posibles beneficios. [170] [171] El Secretario General António Guterres abogó por la creación de un organismo de control global para supervisar la tecnología emergente, diciendo: "La IA generativa tiene un enorme potencial para el bien y el mal a escala. Sus propios creadores han advertido que mucho mayores y potencialmente catastróficos y nos esperan riesgos existenciales". [17] En la sesión del consejo, Rusia dijo que cree que los riesgos de la IA se comprenden demasiado mal como para considerarlos una amenaza a la estabilidad global. China se opuso a una regulación global estricta, diciendo que los países deberían poder desarrollar sus propias reglas, al tiempo que dijo que se oponían al uso de la IA para "crear hegemonía militar o socavar la soberanía de un país". [170]

La regulación de los AGI conscientes se centra en su integración con la sociedad humana existente y puede dividirse en consideraciones de su situación jurídica y de sus derechos morales. [172] El control de armas de IA probablemente requerirá la institucionalización de nuevas normas internacionales plasmadas en especificaciones técnicas efectivas combinadas con un monitoreo activo y una diplomacia informal por parte de comunidades de expertos, junto con un proceso de verificación legal y política. [173] [113]

En julio de 2023, el gobierno de EE. UU. obtuvo compromisos voluntarios de seguridad de las principales empresas tecnológicas, incluidas OpenAI , Amazon , Google , Meta y Microsoft . Las empresas acordaron implementar salvaguardias, incluida la supervisión de terceros y pruebas de seguridad realizadas por expertos independientes, para abordar las preocupaciones relacionadas con los riesgos potenciales y los daños sociales de la IA. Las partes enmarcaron los compromisos como un paso intermedio mientras se elaboran las regulaciones. Amba Kak, director ejecutivo del AI Now Institute , dijo que "una deliberación a puerta cerrada con actores corporativos que resulte en salvaguardias voluntarias no es suficiente" y pidió una deliberación pública y regulaciones del tipo que las empresas no aceptarían voluntariamente. [174] [175]

En octubre de 2023, el presidente de Estados Unidos, Joe Biden, emitió una orden ejecutiva sobre el "Desarrollo y uso seguro y confiable de la inteligencia artificial". [176] Además de otros requisitos, la orden exige el desarrollo de directrices para modelos de IA que permitan la "evasión del control humano".

El 50% de los investigadores de IA creen que hay un 10% o más de posibilidades de que los humanos se extingan debido a nuestra incapacidad para controlar la IA.

De manera similar, Marvin Minsky sugirió una vez que un programa de inteligencia artificial diseñado para resolver la hipótesis de Riemann podría terminar apoderándose de todos los recursos de la Tierra para construir supercomputadoras más poderosas que ayuden a lograr su objetivo.

En la biografía, escrita en broma en tercera persona, Good resumió los hitos de su vida, incluido un relato probablemente nunca antes visto de su trabajo en Bletchley Park con Turing. Pero esto es lo que escribió en 1998 sobre la primera superinteligencia, y su giro de 180 grados al final del juego: [El artículo] 'Especulaciones sobre la primera máquina ultrainteligente' (1965)... comenzaba: 'La supervivencia del hombre depende de la pronta construcción de una máquina ultrainteligente.' Esas fueron sus palabras [de Good] durante la Guerra Fría, y ahora sospecha que la "supervivencia" debería ser reemplazada por la "extinción". Según él, debido a la competencia internacional no podemos impedir que las máquinas tomen el control. Él piensa que somos lemmings. Dijo también que "probablemente el hombre construirá el deus ex machina a su propia imagen".

Como si perder el control de las mentes chinas fuera más aterrador que perder el control de mentes digitales alienígenas a las que no les importan los humanos. [...] ya está claro que el espacio de posibles mentes alienígenas es mucho mayor que eso.

Para mí es plausible que lo principal que debemos hacer es notar circuitos específicos relacionados con el engaño y capacidades peligrosas específicas como esa, y conciencia situacional y objetivos representados internamente.

Siempre que posean un nivel suficiente de inteligencia, los agentes que tengan cualquiera de una amplia gama de objetivos finales perseguirán objetivos intermedios similares porque tienen razones instrumentales para hacerlo.

Nada impide que los sistemas de mejora personal suficientemente inteligentes optimicen sus mecanismos de recompensa para optimizar el logro de sus objetivos actuales y, en el proceso, cometan un error que conduzca a la corrupción de sus funciones de recompensa.

Por lo tanto, no sorprende que, según la más reciente Encuesta sobre los impactos de la IA, casi la mitad de los 731 principales investigadores de IA piensen que hay al menos un 10% de posibilidades de que la IA a nivel humano conduzca a un "resultado extremadamente negativo" o riesgo existencial.

Por todas estas razones, verificar un tratado de renuncia global, o incluso uno limitado al desarrollo de armas relacionadas con la IA, no es un comienzo... (Por razones diferentes a las nuestras, el Machine Intelligence Research Institute) considera que la renuncia (AGI) es inviable...

En general, la mayoría de los escritores rechazan las propuestas de renuncia amplia... Las propuestas de renuncia sufren muchos de los mismos problemas que las propuestas de regulación, pero en mayor medida. No existe ningún precedente histórico de tecnología general de usos múltiples similar a AGI que se haya renunciado con éxito para siempre, ni parece haber razones teóricas para creer que las propuestas de renuncia funcionarían en el futuro. Por lo tanto, no las consideramos una clase viable de propuestas.

Es una fantasía sugerir que el acelerado desarrollo y despliegue de tecnologías que en conjunto se consideran IA se detendrá o limitará, ya sea mediante regulaciones o incluso mediante legislación nacional.

Por supuesto, se podría intentar prohibir por completo las computadoras superinteligentes. Pero "la ventaja competitiva (económica, militar, incluso artística) de cada avance en la automatización es tan convincente", escribió

Vernor Vinge

, matemático y autor de ciencia ficción, "que aprobar leyes o tener costumbres que prohíban tales cosas simplemente Asegura que alguien más lo hará.