La filosofía de la inteligencia artificial es una rama de la filosofía de la mente y la filosofía de la informática [1] que explora la inteligencia artificial y sus implicaciones para el conocimiento y la comprensión de la inteligencia , la ética , la conciencia , la epistemología y el libre albedrío . [2] [3] Además, la tecnología se ocupa de la creación de animales artificiales o personas artificiales (o, al menos, criaturas artificiales; ver vida artificial ), por lo que la disciplina es de considerable interés para los filósofos. [4] Estos factores contribuyeron al surgimiento de la filosofía de la inteligencia artificial.

La filosofía de la inteligencia artificial intenta responder a estas preguntas de la siguiente manera: [5]

Preguntas como estas reflejan los intereses divergentes de los investigadores de IA , los científicos cognitivos y los filósofos, respectivamente. Las respuestas científicas a estas preguntas dependen de la definición de "inteligencia" y "conciencia" y de qué "máquinas" exactamente están en discusión.

Las proposiciones importantes en la filosofía de la IA incluyen algunas de las siguientes:

¿Es posible crear una máquina que pueda resolver todos los problemas que los humanos resuelven usando su inteligencia? Esta pregunta define el alcance de lo que las máquinas podrían hacer en el futuro y orienta la dirección de la investigación en IA. Sólo se refiere al comportamiento de las máquinas e ignora las cuestiones de interés para los psicólogos , científicos cognitivos y filósofos , evocando la pregunta: ¿importa si una máquina realmente piensa, como piensa una persona, en lugar de simplemente producir resultados que parecen ser el resultado de ¿pensamiento? [11]

La posición básica de la mayoría de los investigadores de IA se resume en esta afirmación, que apareció en la propuesta para el taller de Dartmouth de 1956:

Los argumentos en contra de la premisa básica deben mostrar que construir un sistema de IA que funcione es imposible porque existe algún límite práctico a las capacidades de las computadoras o porque existe alguna cualidad especial de la mente humana que es necesaria para el comportamiento inteligente y que, sin embargo, no puede ser duplicada por un máquina (o por los métodos de investigación actuales de IA). Los argumentos a favor de la premisa básica deben demostrar que tal sistema es posible.

También es posible eludir la conexión entre las dos partes de la propuesta anterior. Por ejemplo, el aprendizaje automático, comenzando con la infame propuesta de máquina infantil de Turing, [12] esencialmente logra la característica deseada de inteligencia sin una descripción precisa en tiempo de diseño de cómo funcionaría exactamente. La explicación del conocimiento tácito de los robots [13] elimina por completo la necesidad de una descripción precisa.

El primer paso para responder a la pregunta es definir claramente "inteligencia".

Alan Turing [15] redujo el problema de definir la inteligencia a una simple pregunta sobre la conversación. Sugiere que: si una máquina puede responder cualquier pregunta que se le plantee, utilizando las mismas palabras que respondería una persona común, entonces podemos llamar a esa máquina inteligente. Una versión moderna de su diseño experimental utilizaría una sala de chat en línea , donde uno de los participantes es una persona real y el otro es un programa de computadora. El programa pasa la prueba si nadie puede decir cuál de los dos participantes es humano. [6] Turing señala que nadie (excepto los filósofos) pregunta jamás "¿puede la gente pensar?" Escribe "en lugar de discutir continuamente sobre este punto, lo habitual es tener una convención educada en la que todos piensan". [16] La prueba de Turing extiende esta convención de cortesía a las máquinas:

Una crítica a la prueba de Turing es que sólo mide la "humanidad" del comportamiento de la máquina, en lugar de la "inteligencia" del comportamiento. Dado que el comportamiento humano y el comportamiento inteligente no son exactamente lo mismo, la prueba no mide la inteligencia. Stuart J. Russell y Peter Norvig escriben que "los textos de ingeniería aeronáutica no definen el objetivo de su campo como 'fabricar máquinas que vuelen tan exactamente como las palomas que puedan engañar a otras palomas'". [17]

La investigación sobre IA del siglo XXI define la inteligencia en términos de comportamiento dirigido a objetivos. Considera la inteligencia como un conjunto de problemas que se espera que la máquina resuelva: cuantos más problemas pueda resolver y mejores sean sus soluciones, más inteligente será el programa. El fundador de la IA, John McCarthy , definió la inteligencia como "la parte computacional de la capacidad de alcanzar objetivos en el mundo". [18]

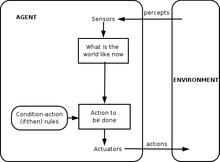

Stuart Russell y Peter Norvig formalizaron esta definición utilizando agentes inteligentes abstractos . Un "agente" es algo que percibe y actúa en un entorno. Una "medida de desempeño" define lo que se considera éxito para el agente. [19]

Definiciones como ésta intentan captar la esencia de la inteligencia. Tienen la ventaja de que, a diferencia de la prueba de Turing, no evalúan rasgos humanos poco inteligentes, como cometer errores tipográficos. [21] Tienen la desventaja de que no pueden diferenciar entre "cosas que piensan" y "cosas que no". Según esta definición, incluso un termostato tiene una inteligencia rudimentaria. [22]

Hubert Dreyfus describe este argumento afirmando que "si el sistema nervioso obedece las leyes de la física y la química, lo cual tenemos todas las razones para suponer que así es, entonces... nosotros... deberíamos ser capaces de reproducir el comportamiento del sistema nervioso". sistema con algún dispositivo físico". [23] Este argumento, presentado por primera vez en 1943 [24] y descrito vívidamente por Hans Moravec en 1988, [25] ahora está asociado con el futurista Ray Kurzweil , quien estima que la potencia de la computadora será suficiente para una simulación cerebral completa por parte del año 2029. [26] En 2005 se realizó una simulación en tiempo no real de un modelo talamocortical que tiene el tamaño del cerebro humano (10 11 neuronas), [27] y tomó 50 días simular 1 segundo de dinámica cerebral. en un cluster de 27 procesadores.

Incluso los críticos más duros de la IA (como Hubert Dreyfus y John Searle ) coinciden en que una simulación cerebral es posible en teoría. [a] Sin embargo, Searle señala que, en principio, cualquier cosa puede ser simulada por una computadora; por lo tanto, llevar la definición a su punto de ruptura lleva a la conclusión de que cualquier proceso puede considerarse técnicamente "computación". "Lo que queríamos saber es qué distingue la mente de los termostatos y el hígado", escribe. [30] Por lo tanto, simplemente simular el funcionamiento de un cerebro vivo sería en sí mismo una admisión de ignorancia con respecto a la inteligencia y la naturaleza de la mente, como tratar de construir un avión de pasajeros copiando con precisión un pájaro vivo, pluma por pluma, sin Comprensión teórica de la ingeniería aeronáutica . [31]

En 1963, Allen Newell y Herbert A. Simon propusieron que la "manipulación de símbolos" era la esencia de la inteligencia tanto humana como mecánica. Ellos escribieron:

Esta afirmación es muy fuerte: implica que el pensamiento humano es una especie de manipulación de símbolos (porque un sistema de símbolos es necesario para la inteligencia) y que las máquinas pueden ser inteligentes (porque un sistema de símbolos es suficiente para la inteligencia). [32] Otra versión de esta posición fue descrita por el filósofo Hubert Dreyfus, quien la llamó "el supuesto psicológico":

Los "símbolos" que discutieron Newell, Simon y Dreyfus eran parecidos a palabras y de alto nivel: símbolos que se correspondían directamente con objetos del mundo, como <perro> y <cola>. La mayoría de los programas de IA escritos entre 1956 y 1990 utilizaron este tipo de símbolo. La IA moderna, basada en estadísticas y optimización matemática, no utiliza el "procesamiento de símbolos" de alto nivel que discutieron Newell y Simon.

Estos argumentos muestran que el pensamiento humano no consiste (únicamente) en manipulación de símbolos de alto nivel. No muestran que la inteligencia artificial sea imposible, sólo que se requiere algo más que el procesamiento de símbolos .

En 1931, Kurt Gödel demostró con un teorema de incompletitud que siempre es posible construir una " enunciación de Gödel" que un sistema lógico formal consistente dado (como un programa de manipulación de símbolos de alto nivel) no podría probar. A pesar de ser una afirmación verdadera, la afirmación de Gödel construida no es demostrable en el sistema dado. (La verdad de la declaración de Gödel construida depende de la consistencia del sistema dado; aplicar el mismo proceso a un sistema sutilmente inconsistente parecerá tener éxito, pero en realidad producirá una "declaración de Gödel " falsa ) . De manera especulativa, Gödel conjeturó que la mente humana eventualmente puede determinar correctamente la verdad o falsedad de cualquier enunciado matemático bien fundamentado (incluido cualquier posible enunciado de Gödel) y que, por lo tanto, el poder de la mente humana no es reducible a un mecanismo . [34] El filósofo John Lucas (desde 1961) y Roger Penrose (desde 1989) han defendido este argumento filosófico antimecanicista . [35]

Los argumentos antimecanicistas de Gödel tienden a basarse en la afirmación aparentemente inocua de que un sistema de matemáticos humanos (o alguna idealización de los matemáticos humanos) es consistente (completamente libre de errores) y cree plenamente en su propia consistencia (y puede hacer que todas las cosas lógicas sean válidas). inferencias que se derivan de su propia consistencia, incluida la creencia en su declaración de Gödel) [ cita necesaria ] . Esto es probablemente imposible de hacer para una máquina de Turing (ver Problema de detención ); por lo tanto, el gödeliano concluye que el razonamiento humano es demasiado poderoso para ser capturado por una máquina de Turing y, por extensión, por cualquier dispositivo mecánico digital.

Sin embargo, el consenso moderno en la comunidad científica y matemática es que el razonamiento humano real es inconsistente; que cualquier "versión idealizada" consistente H del razonamiento humano se vería lógicamente obligada a adoptar un escepticismo de mente abierta saludable pero contraintuitivo sobre la consistencia de H (de lo contrario, H es demostrablemente inconsistente); y que los teoremas de Gödel no conducen a ningún argumento válido de que los humanos tengan capacidades de razonamiento matemático más allá de las que una máquina podría jamás duplicar. [36] [37] [38] Este consenso de que los argumentos antimecanicistas de Gödel están condenados al fracaso se expone firmemente en Inteligencia Artificial : " cualquier intento de utilizar (los resultados incompletos de Gödel) para atacar la tesis computacionalista está destinado a ser ilegítimo, ya que estos resultados son bastante consistentes con la tesis computacionalista." [39]

Stuart Russell y Peter Norvig coinciden en que el argumento de Gödel no considera la naturaleza del razonamiento humano en el mundo real. Se aplica a lo que teóricamente puede demostrarse, dada una cantidad infinita de memoria y tiempo. En la práctica, las máquinas reales (incluidos los humanos) tienen recursos finitos y tendrán dificultades para demostrar muchos teoremas. No es necesario poder demostrarlo todo para ser una persona inteligente. [40]

De manera menos formal, Douglas Hofstadter , en su libro ganador del premio Pulitzer Gödel, Escher, Bach: An Eternal Golden Braid , afirma que estas "declaraciones de Gödel" siempre se refieren al sistema mismo, estableciendo una analogía con la forma en que la paradoja de Epiménides utiliza declaraciones que referirse a sí mismos, como "esta afirmación es falsa" o "estoy mintiendo". [41] Pero, por supuesto, la paradoja de Epiménides se aplica a cualquier cosa que haga declaraciones, ya sean máquinas o humanos, incluso el propio Lucas. Considerar:

Esta afirmación es cierta, pero Lucas no puede afirmarla. Esto muestra que el propio Lucas está sujeto a los mismos límites que describe para las máquinas, al igual que todas las personas, por lo que el argumento de Lucas es inútil. [43]

Después de concluir que el razonamiento humano no es computable, Penrose especuló de manera controvertida que algún tipo de proceso hipotético no computable que involucra el colapso de los estados de la mecánica cuántica otorga a los humanos una ventaja especial sobre las computadoras existentes. Las computadoras cuánticas existentes sólo son capaces de reducir la complejidad de las tareas computables de Turing y todavía están restringidas a tareas dentro del alcance de las máquinas de Turing. [ cita necesaria ] [ aclaración necesaria ] . Según los argumentos de Penrose y Lucas, el hecho de que las computadoras cuánticas sólo sean capaces de completar tareas computables de Turing implica que no pueden ser suficientes para emular la mente humana. [ cita necesaria ] Por lo tanto, Penrose busca algún otro proceso que involucre nueva física, por ejemplo, la gravedad cuántica que podría manifestar nueva física a la escala de la masa de Planck a través del colapso cuántico espontáneo de la función de onda. Estos estados, sugirió, ocurren tanto dentro de las neuronas como abarcando más de una neurona. [44] Sin embargo, otros científicos señalan que no existe ningún mecanismo orgánico plausible en el cerebro para aprovechar ningún tipo de computación cuántica y, además, que la escala de tiempo de la decoherencia cuántica parece demasiado rápida para influir en la activación de las neuronas. [45]

Hubert Dreyfus argumentó que la inteligencia y la experiencia humanas dependían principalmente de juicios intuitivos rápidos más que de una manipulación simbólica paso a paso, y argumentó que estas habilidades nunca serían plasmadas en reglas formales. [46]

El argumento de Dreyfus había sido anticipado por Turing en su artículo de 1950 Computing Machinery and Intelligence , donde lo clasificó como el "argumento de la informalidad del comportamiento". [47] Turing argumentó en respuesta que, sólo porque no conocemos las reglas que gobiernan un comportamiento complejo, esto no significa que no existan tales reglas. Escribió: "No podemos convencernos tan fácilmente de la ausencia de leyes completas de comportamiento... La única manera que conocemos de encontrar tales leyes es la observación científica, y ciertamente no conocemos ninguna circunstancia bajo la cual podamos decir: 'Nosotros He buscado lo suficiente. No existen tales leyes'". [48]

Russell y Norvig señalan que, en los años transcurridos desde que Dreyfus publicó su crítica, se ha avanzado hacia el descubrimiento de las "reglas" que gobiernan el razonamiento inconsciente. [49] El movimiento situado en la investigación de la robótica intenta capturar nuestras habilidades inconscientes de percepción y atención. [50] Los paradigmas de inteligencia computacional , como las redes neuronales , los algoritmos evolutivos, etc., están dirigidos principalmente al razonamiento y aprendizaje inconscientes simulados. Los enfoques estadísticos de la IA pueden hacer predicciones que se aproximan a la precisión de las conjeturas intuitivas humanas. La investigación sobre el conocimiento de sentido común se ha centrado en reproducir el "trasfondo" o contexto del conocimiento. De hecho, la investigación en IA en general se ha alejado de la manipulación de símbolos de alto nivel y se ha acercado a nuevos modelos que pretenden capturar más de nuestro razonamiento intuitivo . [49]

La ciencia cognitiva y la psicología finalmente llegaron a estar de acuerdo con la descripción de Dreyfus de la experiencia humana. Daniel Kahnemann y otros desarrollaron una teoría similar en la que identificaron dos "sistemas" que los humanos utilizan para resolver problemas, a los que llamó "Sistema 1" (juicios intuitivos rápidos) y "Sistema 2" (pensamiento lento y deliberado paso a paso). [51]

Aunque las opiniones de Dreyfus han sido reivindicadas de muchas maneras, el trabajo en ciencia cognitiva y en IA fue una respuesta a problemas específicos en esos campos y no estuvo directamente influenciado por Dreyfus. El historiador e investigador de IA Daniel Crevier escribió que "el tiempo ha demostrado la precisión y perspicacia de algunos de los comentarios de Dreyfus. Si los hubiera formulado de manera menos agresiva, las acciones constructivas que sugirieron podrían haberse tomado mucho antes". [52]

Ésta es una cuestión filosófica, relacionada con el problema de las otras mentes y el difícil problema de la conciencia . La cuestión gira en torno a una posición definida por John Searle como "IA fuerte":

Searle distinguió esta posición de lo que llamó "IA débil":

Searle introdujo los términos para aislar la IA fuerte de la IA débil para poder centrarse en lo que pensaba que era el tema más interesante y debatible. Sostuvo que incluso si asumimos que teníamos un programa de computadora que actuaba exactamente como una mente humana, todavía quedaría una pregunta filosófica difícil que necesitaría respuesta. [9]

Ninguna de las dos posiciones de Searle es de gran interés para la investigación de la IA, ya que no responden directamente a la pregunta "¿puede una máquina mostrar inteligencia general?" (a menos que también se pueda demostrar que la conciencia es necesaria para la inteligencia). Turing escribió: "No deseo dar la impresión de que creo que no hay ningún misterio sobre la conciencia... [pero] no creo que estos misterios necesariamente deban resolverse antes de que podamos responder a la pregunta [de si las máquinas pueden pensar]. " [53] Russell y Norvig están de acuerdo: "La mayoría de los investigadores de IA dan por sentada la hipótesis de la IA débil y no les importa la hipótesis de la IA fuerte". [54]

Hay algunos investigadores que creen que la conciencia es un elemento esencial de la inteligencia, como Igor Aleksander , Stan Franklin , Ron Sun y Pentti Haikonen , aunque su definición de "conciencia" se acerca mucho a la de "inteligencia". (Ver conciencia artificial ).

Antes de que podamos responder a esta pregunta, debemos tener claro qué queremos decir con "mentes", "estados mentales" y "conciencia".

Las palabras " mente " y " conciencia " son utilizadas por diferentes comunidades de diferentes maneras. Algunos pensadores de la nueva era , por ejemplo, utilizan la palabra "conciencia" para describir algo similar al " élan vital " de Bergson : un fluido energético invisible que impregna la vida y especialmente la mente. Los escritores de ciencia ficción utilizan la palabra para describir alguna propiedad esencial que nos hace humanos: una máquina o extraterrestre que sea "consciente" se presentará como un personaje plenamente humano, con inteligencia, deseos, voluntad , perspicacia, orgullo, etc. (Los escritores de ciencia ficción también utilizan las palabras "sentiencia", "sapiencia", "autoconciencia" o " fantasma ", como en la serie de manga y anime Ghost in the Shell , para describir esta propiedad humana esencial). Para otros [ ¿quién? ] , las palabras "mente" o "conciencia" se utilizan como una especie de sinónimo secular de alma .

Para los filósofos , neurocientíficos y científicos cognitivos , las palabras se utilizan de una manera más precisa y más mundana: se refieren a la experiencia familiar y cotidiana de tener un "pensamiento en la cabeza", como una percepción, un sueño, una intención o un plan, y a la forma en que vemos algo , sabemos algo, queremos decir algo o entendemos algo. [55] "No es difícil dar una definición de conciencia de sentido común", observa el filósofo John Searle. [56] Lo que es misterioso y fascinante no es tanto lo que es sino cómo es: ¿cómo es que un trozo de tejido adiposo y electricidad da lugar a esta experiencia (familiar) de percibir, significar o pensar?

Los filósofos llaman a esto el difícil problema de la conciencia . Es la última versión de un problema clásico de la filosofía de la mente llamado " problema mente-cuerpo ". [57] Un problema relacionado es el problema del significado o comprensión (que los filósofos llaman " intencionalidad "): ¿cuál es la conexión entre nuestros pensamientos y lo que estamos pensando (es decir, objetos y situaciones en el mundo)? Una tercera cuestión es el problema de la experiencia (o " fenomenología "): si dos personas ven lo mismo, ¿tienen la misma experiencia? ¿O hay cosas "dentro de su cabeza" (llamadas " qualia ") que pueden ser diferentes de persona a persona? [58]

Los neurobiólogos creen que todos estos problemas se resolverán cuando comencemos a identificar los correlatos neuronales de la conciencia : la relación real entre la maquinaria de nuestra cabeza y sus propiedades colectivas; como la mente, la experiencia y la comprensión. Algunos de los críticos más duros de la inteligencia artificial coinciden en que el cerebro es sólo una máquina y que la conciencia y la inteligencia son el resultado de procesos físicos en el cerebro. [59] La pregunta filosófica difícil es la siguiente: ¿puede un programa de computadora, que se ejecuta en una máquina digital que mezcla los dígitos binarios de cero y uno, duplicar la capacidad de las neuronas para crear mentes, con estados mentales (como comprender o percibir), y en definitiva, ¿la experiencia de la conciencia?

John Searle nos pide que consideremos un experimento mental : supongamos que hemos escrito un programa de computadora que pasa la prueba de Turing y demuestra una acción inteligente general. Supongamos, específicamente, que el programa puede conversar en chino fluido. Escribe el programa en tarjetas de 3x5 y dáselas a una persona común y corriente que no hable chino. Encierra a la persona en una habitación y haz que siga las instrucciones de las tarjetas. Copiará los caracteres chinos y los pasará dentro y fuera de la habitación a través de una ranura. Desde fuera, parecerá que en la sala china hay una persona totalmente inteligente que habla chino. La pregunta es la siguiente: ¿hay alguien (o algo) en la sala que entienda chino? Es decir, ¿hay algo que tenga el estado mental de comprensión o que tenga conciencia de lo que se está discutiendo en chino? Es evidente que el hombre no se da cuenta. La habitación no puede ser consciente. Las cartas ciertamente no lo saben. Searle concluye que la habitación china , o cualquier otro sistema de símbolos físicos, no puede tener mente. [60]

Searle continúa argumentando que los estados mentales y la conciencia reales requieren (aún por describir) "propiedades físico-químicas reales de los cerebros humanos reales". [61] Sostiene que hay "propiedades causales" especiales de los cerebros y las neuronas que dan origen a las mentes : en sus palabras, "los cerebros causan las mentes". [62]

Gottfried Leibniz planteó esencialmente el mismo argumento que Searle en 1714, utilizando el experimento mental de expandir el cerebro hasta que tuviera el tamaño de un molino. [63] En 1974, Lawrence Davis imaginó la duplicación del cerebro utilizando líneas telefónicas y oficinas atendidas por personas, y en 1978 Ned Block imaginó a toda la población de China involucrada en tal simulación cerebral. Este experimento mental se llama "la nación china" o "el gimnasio chino". [64] Ned Block también propuso su argumento Blockhead , que es una versión de la sala china en la que el programa ha sido refactorizado en un conjunto simple de reglas de la forma "ver esto, hacer aquello", eliminando todo misterio del programa.

Las respuestas a la sala china enfatizan varios puntos diferentes.

La teoría computacional de la mente o " computacionalismo " afirma que la relación entre la mente y el cerebro es similar (si no idéntica) a la relación entre un programa en ejecución (software) y una computadora (hardware). La idea tiene raíces filosóficas en Hobbes (que afirmó que el razonamiento no era más que cálculos), Leibniz (que intentó crear un cálculo lógico de todas las ideas humanas), Hume (que pensó que la percepción podía reducirse a "impresiones atómicas") y incluso Kant (que analizó toda experiencia como controlada por reglas formales). [71] La última versión está asociada con los filósofos Hilary Putnam y Jerry Fodor . [72]

Esta pregunta guarda relación con nuestras preguntas anteriores: si el cerebro humano es una especie de computadora, entonces las computadoras pueden ser a la vez inteligentes y conscientes, respondiendo tanto a las preguntas prácticas como filosóficas de la IA. En términos de la cuestión práctica de la IA ("¿Puede una máquina mostrar inteligencia general?"), algunas versiones del computacionalismo afirman que (como escribió Hobbes ):

En otras palabras, nuestra inteligencia deriva de una forma de cálculo , similar a la aritmética . Esta es la hipótesis del sistema de símbolos físicos discutida anteriormente e implica que la inteligencia artificial es posible. En términos de la cuestión filosófica de la IA ("¿Puede una máquina tener mente, estados mentales y conciencia?"), la mayoría de las versiones del computacionalismo afirman que (como lo caracteriza Stevan Harnad ):

Esta es la "IA fuerte" de John Searle discutida anteriormente, y es el verdadero objetivo del argumento de la habitación china (según Harnad ). [73]

Si las " emociones " se definen sólo en términos de su efecto sobre el comportamiento o sobre cómo funcionan dentro de un organismo, entonces las emociones pueden verse como un mecanismo que un agente inteligente utiliza para maximizar la utilidad de sus acciones. Dada esta definición de emoción, Hans Moravec cree que "los robots en general serán bastante emocionales por ser buenas personas". [74] El miedo es una fuente de urgencia. La empatía es un componente necesario de una buena interacción entre humanos y computadoras . Dice que los robots "intentarán complacerte de una manera aparentemente desinteresada porque se emocionarán con este refuerzo positivo. Puedes interpretar esto como una especie de amor". [74] Daniel Crevier escribe: "El punto de Moravec es que las emociones son sólo dispositivos para canalizar el comportamiento en una dirección beneficiosa para la supervivencia de la propia especie". [75]

Los escritores de ciencia ficción utilizan a veces la " autoconciencia ", como se señaló anteriormente, como nombre de la propiedad humana esencial que hace que un personaje sea plenamente humano. Turing elimina todas las demás propiedades de los seres humanos y reduce la pregunta a "¿puede una máquina ser sujeto de su propio pensamiento?" ¿ Puede pensar en sí mismo ? Visto de esta manera, se puede escribir un programa que pueda informar sobre sus propios estados internos, como un depurador . [76]

Turing reduce esto a la cuestión de si una máquina puede "tomarnos por sorpresa" y sostiene que esto es obviamente cierto, como puede atestiguar cualquier programador. [77] Señala que, con suficiente capacidad de almacenamiento, una computadora puede comportarse de una cantidad astronómica de maneras diferentes. [78] Debe ser posible, incluso trivial, que una computadora que pueda representar ideas las combine de nuevas maneras. ( Matemático automatizado de Douglas Lenat , como ejemplo, combinó ideas para descubrir nuevas verdades matemáticas.) Kaplan y Haenlein sugieren que las máquinas pueden mostrar creatividad científica, mientras que parece probable que los humanos tengan la ventaja en lo que respecta a la creatividad artística. [79]

En 2009, científicos de la Universidad de Aberystwyth en Gales y de la Universidad de Cambridge en el Reino Unido diseñaron un robot llamado Adam que creen que es la primera máquina que produce nuevos hallazgos científicos de forma independiente. [80] También en 2009, investigadores de Cornell desarrollaron Eureqa , un programa informático que extrapola fórmulas para ajustarlas a los datos ingresados, como encontrar las leyes del movimiento a partir del movimiento de un péndulo.

Esta pregunta (como muchas otras en la filosofía de la inteligencia artificial) se puede presentar de dos formas. La "hostilidad" puede definirse en términos de función o comportamiento , en cuyo caso "hostil" se convierte en sinónimo de "peligroso". O puede definirse en términos de intención: ¿puede una máquina proponerse "deliberadamente" hacer daño? Esta última es la pregunta "¿puede una máquina tener estados conscientes?" (como intenciones ) en otra forma. [53]

La cuestión de si las máquinas altamente inteligentes y completamente autónomas serían peligrosas ha sido examinada en detalle por futuristas (como el Machine Intelligence Research Institute ). El elemento obvio del drama también ha hecho que el tema sea popular en la ciencia ficción , que ha considerado muchos escenarios posibles en los que las máquinas inteligentes representan una amenaza para la humanidad; véase Inteligencia artificial en la ficción .

Un problema es que las máquinas pueden adquirir muy rápidamente la autonomía y la inteligencia necesarias para ser peligrosas. Vernor Vinge ha sugerido que en unos pocos años, las computadoras de repente se volverán miles o millones de veces más inteligentes que los humanos. A esto lo llama " la Singularidad ". [81] Sugiere que puede ser algo o posiblemente muy peligroso para los humanos. [82] Esto es discutido por una filosofía llamada Singularitarismo .

En 2009, académicos y expertos técnicos asistieron a una conferencia para discutir el impacto potencial de los robots y las computadoras y el impacto de la posibilidad hipotética de que pudieran volverse autosuficientes y capaces de tomar sus propias decisiones . Discutieron la posibilidad y el grado en que las computadoras y los robots podrían adquirir algún nivel de autonomía, y en qué medida podrían usar tales habilidades para posiblemente representar cualquier amenaza o peligro. Señalaron que algunas máquinas han adquirido diversas formas de semiautonomía, incluida la capacidad de encontrar fuentes de energía por sí mismas y la posibilidad de elegir de forma independiente objetivos para atacar con armas. También señalaron que algunos virus informáticos pueden eludir la eliminación y han alcanzado una "inteligencia de cucaracha". Señalaron que la autoconciencia tal como se describe en la ciencia ficción es probablemente poco probable, pero que existen otros peligros y dificultades potenciales. [81]

Algunos expertos y académicos han cuestionado el uso de robots para el combate militar, especialmente cuando a dichos robots se les asigna cierto grado de funciones autónomas. [83] La Marina de los EE. UU. ha financiado un informe que indica que a medida que los robots militares se vuelven más complejos, debería prestarse mayor atención a las implicaciones de su capacidad para tomar decisiones autónomas. [84] [85]

El presidente de la Asociación para el Avance de la Inteligencia Artificial ha encargado un estudio para analizar esta cuestión. [86] Señalan programas como el Dispositivo de Adquisición del Lenguaje que puede emular la interacción humana.

Algunos han sugerido la necesidad de construir una " IA amigable ", término acuñado por Eliezer Yudkowsky , lo que significa que los avances que ya están ocurriendo con la IA también deberían incluir un esfuerzo para hacer que la IA sea intrínsecamente amigable y humana. [87]

Turing dijo: "Es costumbre... ofrecer una pizca de consuelo, en forma de una afirmación de que alguna característica peculiarmente humana nunca podría ser imitada por una máquina... Yo no puedo ofrecer tal consuelo, porque creo que ninguna tales límites pueden establecerse." [88]

Turing señaló que hay muchos argumentos de la forma "una máquina nunca hará X", donde X puede ser muchas cosas, como por ejemplo:

Ser amable, ingeniosa, bella, amigable, tener iniciativa, tener sentido del humor, distinguir el bien del mal, cometer errores, enamorarse, disfrutar de las fresas con crema, enamorar a alguien, aprender de la experiencia, usar las palabras correctamente , ser sujeto de su propio pensamiento, tener tanta diversidad de comportamiento como un hombre, hacer algo realmente nuevo. [76]

Turing sostiene que estas objeciones a menudo se basan en suposiciones ingenuas sobre la versatilidad de las máquinas o son "formas disfrazadas de argumentos de la conciencia". Escribir un programa que muestre uno de estos comportamientos "no causará mucha impresión". [76] Todos estos argumentos son tangenciales a la premisa básica de la IA, a menos que se pueda demostrar que uno de estos rasgos es esencial para la inteligencia general.

Finalmente, quienes creen en la existencia de un alma pueden argumentar que "el pensamiento es una función del alma inmortal del hombre ". Alan Turing llamó a esto "la objeción teológica". El escribe:

Al intentar construir tales máquinas no deberíamos usurpar irreverentemente Su poder de crear almas, como tampoco lo hacemos en la procreación de niños: más bien somos, en cualquier caso, instrumentos de Su voluntad que proporcionan moradas para las almas que Él crea. [89]

El debate sobre el tema se ha reavivado a raíz de las recientes afirmaciones del sistema de inteligencia artificial LaMDA de Google de que es sensible y tiene " alma ". [90]

LaMDA ( Modelo de lenguaje para aplicaciones de diálogo) es un sistema de inteligencia artificial que crea chatbots (robots de inteligencia artificial diseñados para comunicarse con humanos) recopilando grandes cantidades de texto de Internet y utilizando algoritmos para responder a consultas de la manera más fluida y natural posible.

Las transcripciones de conversaciones entre científicos y LaMDA revelan que el sistema de IA sobresale en esto, proporcionando respuestas a temas desafiantes sobre la naturaleza de las emociones , generando fábulas al estilo Esopo sobre el momento e incluso describiendo sus supuestos miedos. [91] Casi todos los filósofos dudan de la sensibilidad de LaMDA. [92]

Algunos académicos sostienen que el rechazo de la filosofía por parte de la comunidad de IA es perjudicial. En la Enciclopedia de Filosofía de Stanford , algunos filósofos sostienen que se subestima el papel de la filosofía en la IA. [4] El físico David Deutsch sostiene que sin una comprensión de la filosofía o sus conceptos, el desarrollo de la IA sufriría una falta de progreso. [93]

La principal serie de conferencias sobre el tema es "Filosofía y teoría de la IA" (PT-AI), dirigida por Vincent C. Müller .

La principal bibliografía sobre el tema, con varias subsecciones, se encuentra en PhilPapers.

Una encuesta reciente sobre Filosofía de la IA es Müller (2023). [3]

Estos argumentos antimecanicistas de Gödel son, sin embargo, problemáticos y existe un amplio consenso en que fracasan.

... incluso si admitimos que las computadoras tienen limitaciones en lo que pueden probar, no hay evidencia de que los humanos sean inmunes a esas limitaciones.