MIDI ( / ˈmɪd i / ; Interfaz digital de instrumentos musicales ) es un estándar técnico que describe un protocolo de comunicación , una interfaz digital y conectores eléctricos que conectan una amplia variedad de instrumentos musicales electrónicos , computadoras y dispositivos de audio relacionados para reproducir, editar y grabar música. [1]

Un solo cable MIDI puede transportar hasta dieciséis canales de datos MIDI, cada uno de los cuales puede enrutarse a un dispositivo independiente. Cada interacción con una tecla, botón, perilla o deslizador se convierte en un evento MIDI, que especifica instrucciones musicales, como el tono , el tiempo y el volumen de una nota . Una aplicación MIDI común es tocar un teclado MIDI u otro controlador y usarlo para activar un módulo de sonido digital (que contiene sonidos musicales sintetizados) para generar sonidos, que la audiencia escucha producidos por un amplificador de teclado . Los datos MIDI se pueden transferir a través de un cable MIDI o USB , o grabarse en un secuenciador o estación de trabajo de audio digital para editarlos o reproducirlos. [2]

MIDI también define un formato de archivo que almacena e intercambia los datos. Las ventajas de MIDI incluyen un tamaño de archivo pequeño , facilidad de modificación y manipulación y una amplia selección de instrumentos electrónicos y sonidos sintetizados o muestreados digitalmente . [3] : 4 Una grabación MIDI de una interpretación en un teclado podría sonar como un piano u otro instrumento de teclado; sin embargo, dado que MIDI graba los mensajes y la información sobre sus notas y no los sonidos específicos, esta grabación podría cambiarse a muchos otros sonidos, que van desde una guitarra o flauta sintetizada o muestreada hasta una orquesta completa.

Antes del desarrollo del MIDI, los instrumentos musicales electrónicos de distintos fabricantes no podían comunicarse entre sí, por lo que un músico no podía, por ejemplo, conectar un teclado Roland a un módulo sintetizador Yamaha. Con el MIDI, cualquier teclado (u otro dispositivo controlador) compatible con MIDI puede conectarse a cualquier otro secuenciador, módulo de sonido, caja de ritmos , sintetizador u ordenador compatible con MIDI, incluso si son de distintos fabricantes.

La tecnología MIDI fue estandarizada en 1983 por un panel de representantes de la industria musical y es mantenida por la Asociación de Fabricantes MIDI (MMA). Todos los estándares MIDI oficiales son desarrollados y publicados conjuntamente por la MMA en Los Ángeles y el Comité MIDI de la Asociación de la Industria de Electrónica Musical (AMEI) en Tokio. En 2016, la MMA estableció la Asociación MIDI (TMA) para apoyar a una comunidad global de personas que trabajan, tocan o crean con MIDI. [4]

A principios de la década de 1980, no existían medios estandarizados para sincronizar instrumentos musicales electrónicos fabricados por diferentes compañías. [5] Los fabricantes tenían sus propios estándares propietarios para sincronizar instrumentos, como CV/gate , DIN sync y Digital Control Bus (DCB). [6] Ikutaro Kakehashi , el presidente de Roland , sintió que la falta de estandarización estaba limitando el crecimiento de la industria de la música electrónica. [6] En junio de 1981, propuso desarrollar un estándar al fundador de Oberheim Electronics, Tom Oberheim , [5] quien había desarrollado su propia interfaz propietaria, el Oberheim System. [7]

Kakehashi sintió que el sistema Oberheim era demasiado engorroso y habló con Dave Smith , el presidente de Sequential Circuits , sobre la creación de una alternativa más simple y económica. [7] Mientras Smith discutía el concepto con empresas estadounidenses, Kakehashi lo discutía con las empresas japonesas Yamaha , Korg y Kawai . [5] Los representantes de todas las empresas se reunieron para discutir la idea en octubre. [5] Inicialmente, solo Sequential Circuits y las empresas japonesas estaban interesadas. [8]

Utilizando el DCB de Roland como base, [6] Smith y el ingeniero de circuitos secuenciales Chet Wood idearon una interfaz universal para permitir la comunicación entre equipos de diferentes fabricantes. Smith y Wood propusieron este estándar en un artículo, Universal Synthesizer Interface, [9] en la muestra de la Audio Engineering Society en octubre de 1981. [10] [11] : 4 El estándar fue discutido y modificado por representantes de Roland, Yamaha, Korg, Kawai y Sequential Circuits. [5] [12] : 20 Kakehashi favoreció el nombre Universal Musical Interface (UMI), pronunciado you-me , [7] pero Smith sintió que esto era "un poco cursi". [13] Sin embargo, le gustaba el uso de instrumento en lugar de sintetizador , y propuso la Interfaz Digital de Instrumentos Musicales (MIDI). [13] [11] : 4 Robert Moog , el presidente de Moog Music , anunció MIDI en la edición de octubre de 1982 de Keyboard . [14] : 276

En el Winter NAMM Show de 1983 , Smith demostró una conexión MIDI entre los sintetizadores Prophet 600 y Roland JP-6 . La especificación MIDI se publicó en agosto de 1983. [5] El estándar MIDI fue presentado por Kakehashi y Smith, quienes recibieron premios Grammy Técnicos en 2013 por su trabajo. [15] [16] [17] En 1983, se lanzaron los primeros instrumentos con MIDI, el Roland Jupiter-6 y el Prophet 600. En 1983, se lanzaron la primera caja de ritmos MIDI , la Roland TR-909 , [18] [19] y el primer secuenciador MIDI , el Roland MSQ-700. [20]

La Asociación de Fabricantes MIDI (MMA) se formó tras una reunión de "todas las empresas interesadas" en el NAMM Show de verano de 1984 en Chicago. La Especificación Detallada MIDI 1.0 se publicó en la segunda reunión de la MMA en el NAMM Show de verano de 1985. El estándar continuó evolucionando, agregando archivos de canciones estandarizados en 1991 ( General MIDI ) y adaptándose a nuevos estándares de conexión como USB y FireWire . En 2016, se formó la Asociación MIDI para continuar supervisando el estándar. [8] En enero de 2019 se anunció una iniciativa para crear un estándar 2.0. [21] El estándar MIDI 2.0 se presentó en el NAMM Show de invierno de 2020. [22]

La BBC citó a MIDI como un ejemplo temprano de tecnología de código abierto . Smith creía que MIDI sólo podría tener éxito si todos los fabricantes lo adoptaban, por lo que "tuvimos que regalarlo". [23]

El atractivo de MIDI se limitaba originalmente a los músicos profesionales y productores de discos que querían utilizar instrumentos electrónicos en la producción de música popular . El estándar permitía que diferentes instrumentos se comunicaran entre sí y con las computadoras, y esto estimuló una rápida expansión de las ventas y la producción de instrumentos electrónicos y software musical. [12] : 21 Esta interoperabilidad permitió que un dispositivo se controlara desde otro, lo que redujo la cantidad de hardware que necesitaban los músicos. [24] La introducción de MIDI coincidió con el amanecer de la era de las computadoras personales y la introducción de samplers y sintetizadores digitales . [25] Las posibilidades creativas que trajo consigo la tecnología MIDI se atribuyen a ayudar a revivir la industria de la música en la década de 1980. [26]

MIDI introdujo capacidades que transformaron la forma en que trabajan muchos músicos. La secuenciación MIDI permite que un usuario sin habilidades de notación construya arreglos complejos. [27] Un acto musical con tan solo uno o dos miembros, cada uno operando múltiples dispositivos habilitados para MIDI, puede ofrecer una actuación similar a la de un grupo más grande de músicos. [28] El gasto de contratar músicos externos para un proyecto se puede reducir o eliminar, [2] : 7 y se pueden realizar producciones complejas en un sistema tan pequeño como un sintetizador con teclado y secuenciador integrados.

MIDI también ayudó a establecer la grabación en casa . Al realizar la preproducción en un entorno doméstico, un artista puede reducir los costos de grabación al llegar a un estudio de grabación con una canción parcialmente terminada. [2] : 7–8 En 2022, The Guardian escribió que MIDI seguía siendo tan importante para la música como USB para la informática y representaba "un sistema de valores crucial de cooperación y beneficio mutuo, uno que las principales empresas tecnológicas de la actualidad prácticamente han desechado en favor de mercados cautivos". En 2022, el diseño MIDI original de Smith todavía estaba en uso. [29]

MIDI se inventó para que los instrumentos musicales electrónicos o digitales pudieran comunicarse entre sí y para que un instrumento pudiera controlar a otro. Por ejemplo, un secuenciador compatible con MIDI puede activar ritmos producidos por un módulo de sonido de batería . Los sintetizadores analógicos que no tienen componentes digitales y fueron construidos antes del desarrollo de MIDI pueden ser equipados con kits que convierten los mensajes MIDI en voltajes de control analógicos. [14] : 277 Cuando se toca una nota en un instrumento MIDI, genera un mensaje MIDI digital que puede usarse para activar una nota en otro instrumento. [2] : 20 La capacidad de control remoto permite reemplazar instrumentos de tamaño completo con módulos de sonido más pequeños y permite a los músicos combinar instrumentos para lograr un sonido más completo o crear combinaciones de sonidos de instrumentos sintetizados, como piano acústico y cuerdas. [30] MIDI también permite controlar de forma remota otros parámetros del instrumento (volumen, efectos, etc.).

Los sintetizadores y samplers contienen varias herramientas para dar forma a un sonido electrónico o digital. Los filtros ajustan el timbre y las envolventes automatizan la forma en que un sonido evoluciona con el tiempo después de que se dispara una nota. [31] La frecuencia de un filtro y el ataque de la envolvente (el tiempo que tarda un sonido en alcanzar su nivel máximo), son ejemplos de parámetros de sintetizador , y se pueden controlar de forma remota a través de MIDI. Los dispositivos de efectos tienen diferentes parámetros, como la retroalimentación de retardo o el tiempo de reverberación. Cuando se asigna un número de controlador continuo MIDI (CCN) a uno de estos parámetros, el dispositivo responde a cualquier mensaje que reciba que se identifique con ese número. Se pueden usar controles como perillas, interruptores y pedales para enviar estos mensajes. Se puede guardar un conjunto de parámetros ajustados en la memoria interna de un dispositivo como un parche , y estos parches se pueden seleccionar de forma remota mediante cambios de programa MIDI. [a] [32]

Los eventos MIDI se pueden secuenciar con software de computadora o en estaciones de trabajo de música de hardware especializadas . Muchas estaciones de trabajo de audio digital (DAW) están diseñadas específicamente para trabajar con MIDI como un componente integral. Se han desarrollado rollos de piano MIDI en muchas DAW para que los mensajes MIDI grabados se puedan modificar fácilmente. [33] [ mejor fuente necesaria ] Estas herramientas permiten a los compositores audicionar y editar su trabajo mucho más rápido y eficientemente que las soluciones anteriores, como la grabación multipista . [ cita requerida ] Se pueden programar composiciones para MIDI que son imposibles de tocar para los intérpretes humanos. [34]

Dado que una interpretación MIDI es una secuencia de comandos que crean sonido, las grabaciones MIDI se pueden manipular de maneras que no se pueden hacer con las grabaciones de audio. Es posible cambiar la tonalidad, la instrumentación o el tempo de un arreglo MIDI, [35] : 227 y reordenar sus secciones individuales, [36] o incluso editar notas individuales. La capacidad de componer ideas y escucharlas rápidamente permite a los compositores experimentar. [37] : 175

Los programas de composición algorítmica proporcionan interpretaciones generadas por computadora que pueden usarse como ideas para canciones o acompañamiento. [2] : 122

Algunos compositores pueden aprovechar el conjunto portátil y estándar de comandos y parámetros de MIDI 1.0 y General MIDI (GM) para compartir archivos de datos musicales entre varios instrumentos electrónicos. Los datos compuestos a través de grabaciones MIDI secuenciadas se pueden guardar como un archivo MIDI estándar (SMF), distribuir digitalmente y reproducir mediante cualquier computadora o instrumento electrónico que también se adhiera a los mismos estándares MIDI, GM y SMF. Los archivos de datos MIDI son mucho más pequeños que los archivos de audio grabados correspondientes . [ cita requerida ]

El mercado de las computadoras personales se estabilizó al mismo tiempo que apareció el MIDI, y las computadoras se convirtieron en una opción viable para la producción musical. [14] : 324 En 1983, las computadoras comenzaron a desempeñar un papel en la producción musical convencional. [38] En los años inmediatamente posteriores a la ratificación de la especificación MIDI en 1983, las características MIDI se adaptaron a varias plataformas informáticas tempranas. El Yamaha CX5M introdujo el soporte y la secuenciación MIDI en un sistema MSX en 1984. [39]

La difusión de MIDI en ordenadores domésticos fue facilitada en gran medida por la MPU-401 de Roland Corporation , lanzada en 1984, como la primera tarjeta de sonido equipada con MIDI , capaz de procesar sonido MIDI [40] y secuenciarlo. [41] [42] Después de que Roland vendiera chips de sonido MPU a otros fabricantes de tarjetas de sonido, [40] estableció una interfaz estándar universal MIDI a PC. [43] La adopción generalizada de MIDI condujo al desarrollo de software MIDI basado en ordenador . [38] Poco después, varias plataformas comenzaron a soportar MIDI, incluyendo Apple II , Macintosh , Commodore 64 , Amiga , Acorn Archimedes y compatibles con IBM PC . [14] : 325–7 El Atari ST de 1985 se envió con puertos MIDI como parte del sistema base.

En 2015, Retro Innovations lanzó la primera interfaz MIDI para un VIC-20 , poniendo a disposición de músicos electrónicos y entusiastas de la informática retro por primera vez las cuatro voces de la computadora. [44] Retro Innovations también fabrica un cartucho de interfaz MIDI para las computadoras Tandy Color Computer y Dragon . [45]

Los músicos de chiptune también utilizan consolas de juegos retro para componer, producir e interpretar música mediante interfaces MIDI. Hay interfaces personalizadas disponibles para Nintendo Entertainment System (NES)/Famicom, [46] Game Boy, [47] Game Boy Advance [48] y Sega Genesis (Mega Drive). [49]

Un archivo MIDI no es una grabación de audio, sino un conjunto de instrucciones (por ejemplo, para el tono o el tempo) y puede utilizar mil veces menos espacio en disco que el audio grabado equivalente. [50] [51] Debido a su pequeño tamaño de archivo, los arreglos MIDI hechos por fans se convirtieron en una forma atractiva de compartir música en línea, antes de la llegada del acceso a Internet de banda ancha y los discos duros de varios gigabytes. [52] El principal inconveniente de esto es la amplia variación en la calidad de las tarjetas de audio de los usuarios y en el audio real contenido como muestras o sonido sintetizado en la tarjeta al que los datos MIDI solo hacen referencia simbólicamente. Incluso una tarjeta de sonido que contiene sonidos muestreados de alta calidad puede tener una calidad inconsistente de un instrumento muestreado a otro. [50] Las primeras tarjetas de precio económico, como AdLib y Sound Blaster y sus compatibles, utilizaban una versión simplificada de la tecnología de síntesis de modulación de frecuencia (síntesis FM) de Yamaha [53] reproducida a través de convertidores digital-analógicos de baja calidad. La reproducción de baja fidelidad [50] de estas omnipresentes [53] tarjetas se solía considerar una propiedad del propio MIDI, lo que creó una percepción del MIDI como audio de baja calidad, mientras que en realidad el MIDI en sí no contiene sonido [54] y la calidad de su reproducción depende completamente de la calidad del dispositivo que produce el sonido. [35] : 227

El archivo MIDI estándar ( SMF ) es un formato de archivo que proporciona una forma estandarizada de guardar, transportar y abrir secuencias de música en otros sistemas. El estándar fue desarrollado y es mantenido por la MMA, y generalmente utiliza una .midextensión. [56] El tamaño compacto de estos archivos llevó a su uso generalizado en computadoras, tonos de llamada de teléfonos móviles , creación de páginas web y tarjetas de felicitación musicales. Estos archivos están destinados a un uso universal e incluyen información como valores de notas, tiempo y nombres de pistas. Las letras se pueden incluir como metadatos y se pueden mostrar en máquinas de karaoke . [57]

Los archivos SMF se crean como un formato de exportación de secuenciadores de software o estaciones de trabajo de hardware. Organizan los mensajes MIDI en una o más pistas paralelas y marcan la hora de los eventos para que se puedan reproducir en secuencia. Un encabezado contiene el número de pistas del arreglo, el tempo y un indicador de cuál de los tres formatos SMF utiliza el archivo. Un archivo de tipo 0 contiene la interpretación completa, fusionada en una sola pista, mientras que los archivos de tipo 1 pueden contener cualquier número de pistas que se interpretan de forma sincrónica. Los archivos de tipo 2 rara vez se utilizan [58] y almacenan múltiples arreglos, cada uno de los cuales tiene su propia pista y está destinado a reproducirse en secuencia.

Microsoft Windows agrupa los archivos SMF junto con los sonidos descargables (DLS) en un contenedor de formato de archivo de intercambio de recursos (RIFF), como archivos RMID con una .rmiextensión. RIFF-RMID ha quedado obsoleto en favor de los archivos de música extensibles ( XMF ). [59]

La principal ventaja de la computadora personal en un sistema MIDI es que puede servir para varios propósitos diferentes, dependiendo del software que esté cargado. [2] : 55 La multitarea permite el funcionamiento simultáneo de programas que pueden compartir datos entre sí. [2] : 65

El software de secuenciación permite manipular los datos MIDI grabados mediante funciones de edición informáticas estándar, como cortar, copiar y pegar , y arrastrar y soltar . Se pueden utilizar atajos de teclado para agilizar el flujo de trabajo y, en algunos sistemas, las funciones de edición se pueden invocar mediante eventos MIDI. El secuenciador permite configurar cada canal para reproducir un sonido diferente y ofrece una descripción gráfica del arreglo. Se dispone de una variedad de herramientas de edición, incluida una pantalla de notación o un escritor de partituras que se puede utilizar para crear partes impresas para los músicos. Herramientas como el bucle , la cuantificación , la aleatorización y la transposición simplifican el proceso de arreglo.

La creación de ritmos se simplifica y se pueden usar plantillas de groove para duplicar la sensación rítmica de otra pista. Se puede agregar expresión realista mediante la manipulación de controladores en tiempo real. Se puede realizar la mezcla y sincronizar MIDI con pistas de audio y video grabadas. El trabajo se puede guardar y transportar entre diferentes computadoras o estudios. [60] [61] : 164–6

Los secuenciadores pueden adoptar formas alternativas, como editores de patrones de batería que permiten a los usuarios crear ritmos haciendo clic en cuadrículas de patrones, [2] : 118 y secuenciadores de bucles como ACID Pro , que permiten combinar MIDI con bucles de audio pregrabados cuyos tempos y claves coinciden entre sí. La secuenciación de listas de referencia se utiliza para activar diálogos, efectos de sonido y pistas musicales en producciones de escenario y transmisión. [2] : 121

Con MIDI, las notas tocadas en un teclado pueden transcribirse automáticamente a partituras . [12] : 213 El software de escritura de partituras generalmente carece de herramientas de secuenciación avanzadas y está optimizado para la creación de una impresión ordenada y profesional diseñada para instrumentistas en vivo. [61] : 157 Estos programas brindan soporte para marcas de dinámica y expresión, visualización de acordes y letras y estilos de partitura complejos. [61] : 167 Hay software disponible que puede imprimir partituras en braille . [62]

Los programas de notación incluyen Finale , Encore , Sibelius , MuseScore y Dorico . El software SmartScore puede producir archivos MIDI a partir de partituras escaneadas . [63]

Los editores de parches permiten a los usuarios programar sus equipos a través de la interfaz de la computadora. Estos se volvieron esenciales con la aparición de sintetizadores complejos como el Yamaha FS1R , [64] que contenía varios miles de parámetros programables, pero tenía una interfaz que consistía en quince botones diminutos, cuatro perillas y una pequeña pantalla LCD. [65] Los instrumentos digitales generalmente desalientan a los usuarios de la experimentación, debido a su falta de retroalimentación y control directo que proporcionarían los interruptores y las perillas, [66] : 393 pero los editores de parches brindan a los propietarios de instrumentos de hardware y dispositivos de efectos la misma funcionalidad de edición que está disponible para los usuarios de sintetizadores de software. [67] Algunos editores están diseñados para un instrumento o dispositivo de efectos específico, mientras que otros editores universales admiten una variedad de equipos e idealmente pueden controlar los parámetros de cada dispositivo en una configuración mediante el uso de mensajes exclusivos del sistema. [2] : 129 Los mensajes exclusivos del sistema usan el protocolo MIDI para enviar información sobre los parámetros del sintetizador.

Los bibliotecarios de parches tienen la función especializada de organizar los sonidos en una colección de equipos e intercambiar bancos completos de sonidos entre un instrumento y una computadora. De esta manera, el almacenamiento de parches limitado del dispositivo se ve aumentado por la capacidad de disco mucho mayor de una computadora. [2] : 133 Una vez transferidos a la computadora, es posible compartir parches personalizados con otros propietarios del mismo instrumento. [68] Los editores/bibliotecarios universales que combinan las dos funciones alguna vez fueron comunes, e incluían Galaxy de Opcode Systems, SoundDiver de eMagic y Unisyn de MOTU. Aunque estos programas más antiguos han sido abandonados en gran medida con la tendencia hacia la síntesis basada en computadora utilizando instrumentos virtuales, varios editores/bibliotecarios siguen disponibles, incluyendo Patch Base de Coffeeshop, [69] Midi Quest de Sound Quest y varios editores de Sound Tower. Kore de Native Instruments fue un esfuerzo por llevar el concepto de editor/bibliotecario a la era de los instrumentos de software, [70] pero fue abandonado en 2011. [71]

Los programas que pueden generar pistas de acompañamiento de forma dinámica se denominan programas de acompañamiento automático . Estos crean un arreglo de banda completa en un estilo que el usuario selecciona y envían el resultado a un dispositivo generador de sonido MIDI para su reproducción. Las pistas generadas se pueden utilizar como herramientas educativas o de práctica, como acompañamiento para presentaciones en vivo o como ayuda para la composición de canciones. [72] : 42

Las computadoras pueden usar software para generar sonidos, que luego pasan a través de un convertidor digital a analógico (DAC) a un amplificador de potencia y un sistema de altavoces. [12] : 213 La cantidad de sonidos que se pueden reproducir simultáneamente (la polifonía ) depende de la potencia de la CPU de la computadora , al igual que la frecuencia de muestreo y la profundidad de bits de reproducción, que afectan directamente la calidad del sonido. [73] Los sintetizadores implementados en software están sujetos a problemas de sincronización que no están necesariamente presentes en los instrumentos de hardware, cuyos sistemas operativos dedicados no están sujetos a interrupciones de tareas en segundo plano como lo están los sistemas operativos de escritorio . Estos problemas de sincronización pueden causar problemas de sincronización y clics y estallidos cuando se interrumpe la reproducción de la muestra. Los sintetizadores de software también pueden exhibir latencia adicional en su generación de sonido. [74]

Las raíces de la síntesis de software se remontan a la década de 1950, cuando Max Mathews de Bell Labs escribió el lenguaje de programación MUSIC-N , que era capaz de generar sonido en tiempo no real. [75] Reality, de Seer Systems de Dave Smith , fue uno de los primeros sintetizadores que se ejecutaba directamente en la CPU de un ordenador anfitrión. Reality logró una baja latencia mediante una estrecha integración del controlador y, por lo tanto, solo podía ejecutarse en tarjetas de sonido Creative Labs . [76] [77] Alpha Syntauri de Syntauri Corporation fue otro de los primeros sintetizadores basados en software. Se ejecutaba en el ordenador Apple IIe y utilizaba una combinación de software y el hardware del ordenador para producir síntesis aditiva. [78] Algunos sistemas utilizan hardware dedicado para reducir la carga en la CPU del host, como con Kyma System de Symbolic Sound Corporation , [75] y los sistemas Creamware / Sonic Core Pulsar/SCOPE, [79] que alimentan los instrumentos, unidades de efectos y mezcladores de un estudio de grabación completo . [80] La capacidad de construir arreglos MIDI completos enteramente en software de computadora permite a un compositor reproducir un resultado final directamente como un archivo de audio. [30]

Los primeros juegos de PC se distribuían en disquetes, y el pequeño tamaño de los archivos MIDI los convertía en un medio viable para proporcionar bandas sonoras. Los juegos de las eras DOS y Windows tempranos normalmente requerían compatibilidad con tarjetas de audio Ad Lib o Sound Blaster . Estas tarjetas usaban síntesis FM , que genera sonido a través de la modulación de ondas sinusoidales . John Chowning , el pionero de la técnica, teorizó que la tecnología sería capaz de recrear con precisión cualquier sonido si se usaban suficientes ondas sinusoidales , pero las tarjetas de audio de computadora económicas realizaban síntesis FM con solo dos ondas sinusoidales. Combinado con el audio de 8 bits de las tarjetas, esto resultó en un sonido descrito como "artificial" [81] y "primitivo". [82]

Las placas hijas de tabla de ondas que estuvieron disponibles posteriormente proporcionaban muestras de audio que podían utilizarse en lugar del sonido FM. Eran caras, pero a menudo utilizaban los sonidos de instrumentos MIDI respetados, como el E-mu Proteus . [82] A mediados de los años 90, la industria informática se inclinó hacia las tarjetas de sonido basadas en tabla de ondas con reproducción de 16 bits, pero estandarizadas en un almacenamiento de tabla de ondas de 2 MB, un espacio demasiado pequeño para que cupieran muestras de buena calidad de 128 instrumentos General MIDI más kits de batería. Para aprovechar al máximo el espacio limitado, algunos fabricantes almacenaron muestras de 12 bits y las ampliaron a 16 bits durante la reproducción. [83]

A pesar de su asociación con dispositivos musicales, MIDI puede controlar cualquier dispositivo electrónico o digital que pueda leer y procesar un comando MIDI. MIDI ha sido adoptado como un protocolo de control en una serie de aplicaciones no musicales. MIDI Show Control utiliza comandos MIDI para dirigir sistemas de iluminación de escenario y para activar eventos marcados en producciones teatrales. Los VJ y turntablistas lo utilizan para marcar clips y para sincronizar equipos, y los sistemas de grabación lo utilizan para sincronización y automatización . Wayne Lytle, el fundador de Animusic , derivó un sistema que denominó MIDIMotion para producir la serie Animusic de álbumes de videos musicales animados por computadora; Animusic luego diseñaría su propio software de animación específicamente para MIDIMotion llamado Animotion [84] . Apple Motion permite un control similar de los parámetros de animación a través de MIDI. El juego de disparos en primera persona de 1987 MIDI Maze y el juego de rompecabezas de computadora Atari ST de 1990 Oxyd usaron MIDI para conectar computadoras en red.

Según el estándar MIDI 1.0 original, los cables terminan en un conector DIN de cinco pines de 180° (DIN 41524). Las aplicaciones típicas utilizan solo tres de los cinco conductores: un cable de tierra (pin 2) y un par de conductores balanceados (pines 4 y 5) que transportan la señal MIDI como corriente eléctrica . [85] [72] : 41 Esta configuración de conector solo puede transportar mensajes en una dirección, por lo que es necesario un segundo cable para la comunicación bidireccional. [2] : 13 Algunas aplicaciones propietarias, como los controladores de pedal con alimentación fantasma , utilizan los pines libres para la transmisión de energía de corriente continua (CC). [86]

Los optoaisladores mantienen los dispositivos MIDI separados eléctricamente de sus conexiones MIDI, lo que evita bucles de tierra [87] : 63 y protege el equipo de picos de voltaje. [14] : 277 No hay capacidad de detección de errores en MIDI, por lo que la longitud máxima del cable se establece en 15 metros (49 pies) para limitar la interferencia . [88]

Para ahorrar espacio, algunos dispositivos MIDI (en particular los más pequeños) comenzaron a utilizar conectores telefónicos TRS de 3,5 mm (también conocidos como conectores de audio minijack). [89] Esto se generalizó lo suficiente como para que la Asociación de Fabricantes MIDI estandarizara el cableado. [90] El documento de estándares MIDI sobre minijack también recomienda el uso de conectores de 2,5 mm en lugar de los de 3,5 mm para evitar confusiones con los conectores de audio. [91]

La mayoría de los dispositivos no copian mensajes desde su puerto de entrada a su puerto de salida. Un tercer tipo de puerto, el puerto de transferencia , emite una copia de todo lo que se recibe en el puerto de entrada, lo que permite que los datos se envíen a otro instrumento [14] : 278 en una disposición en cadena . [92] No todos los dispositivos cuentan con puertos de transferencia, y los dispositivos que carecen de la capacidad de generar datos MIDI, como unidades de efectos y módulos de sonido, pueden no incluir puertos de salida. [66] : 384

Cada dispositivo en una cadena de margaritas añade retardo al sistema. Esto se puede evitar utilizando un MIDI thru box, que contiene varias salidas que proporcionan una copia exacta de la señal de entrada del box. Un fusionador MIDI puede combinar la entrada de múltiples dispositivos en una sola secuencia y permite que varios controladores se conecten a un solo dispositivo. Un conmutador MIDI permite cambiar entre múltiples dispositivos y elimina la necesidad de volver a conectar físicamente los cables. Los enrutadores MIDI combinan todas estas funciones. Contienen múltiples entradas y salidas, y permiten que cualquier combinación de canales de entrada se enrute a cualquier combinación de canales de salida. Las configuraciones de enrutamiento se pueden crear utilizando software de computadora, almacenar en la memoria y seleccionar mediante comandos de cambio de programa MIDI. [2] : 47–50 Esto permite que los dispositivos funcionen como enrutadores MIDI independientes en situaciones en las que no hay una computadora presente. [2] : 62–3 [93] Los procesadores de datos MIDI se utilizan para tareas de utilidad y efectos especiales. Estos incluyen filtros MIDI, que eliminan datos MIDI no deseados de la transmisión, y retrasos MIDI, efectos que envían una copia repetida de los datos de entrada en un tiempo establecido. [2] : 51

La función principal de una interfaz MIDI de computadora es sincronizar las comunicaciones entre el dispositivo MIDI y la computadora. [92] Algunas tarjetas de sonido de computadora incluyen un conector MIDI estándar, mientras que otras se conectan por varios medios que incluyen el puerto de juego D-sub DA-15 , USB , FireWire , Ethernet o una conexión propietaria. El uso creciente de conectores USB en la década de 2000 ha llevado a la disponibilidad de interfaces de datos MIDI a USB que pueden transferir canales MIDI a computadoras equipadas con USB. Algunos controladores de teclado MIDI están equipados con conectores USB y se pueden conectar directamente a computadoras que ejecutan software de música.

La transmisión en serie de MIDI genera problemas de sincronización. Un mensaje MIDI de tres bytes requiere casi 1 milisegundo para su transmisión. [94] Debido a que MIDI es serial, solo puede enviar un evento a la vez. Si se envía un evento en dos canales a la vez, el evento en el segundo canal no puede transmitirse hasta que finalice el primero, y por lo tanto se retrasa 1 ms. Si se envía un evento en todos los canales al mismo tiempo, la transmisión del último canal se retrasa hasta 16 ms. Esto contribuyó al surgimiento de interfaces MIDI con múltiples puertos de entrada y salida, porque la sincronización mejora cuando los eventos se distribuyen entre múltiples puertos en lugar de múltiples canales en el mismo puerto. [74] El término MIDI slop se refiere a errores de sincronización audibles que resultan cuando se retrasa la transmisión MIDI. [95]

Existen dos tipos de controladores MIDI: controladores de interpretación que generan notas y se utilizan para interpretar música [96] y controladores que no pueden enviar notas, pero sí transmitir otros tipos de eventos en tiempo real. Muchos dispositivos son una combinación de los dos tipos.

Los teclados son, con diferencia, el tipo más común de controlador MIDI. [68] MIDI se diseñó teniendo en cuenta los teclados, y cualquier controlador que no sea un teclado se considera un controlador "alternativo". [97] Esto fue visto como una limitación por los compositores que no estaban interesados en la música basada en teclados, pero el estándar demostró ser flexible y se introdujo la compatibilidad MIDI con otros tipos de controladores, incluidas las guitarras y otros instrumentos de cuerda y los controladores de batería y de viento , que emulan la ejecución de la batería y los instrumentos de viento, respectivamente, y controladores especializados y experimentales. [12] : 23 Sin embargo, algunas características de la ejecución del teclado para las que se diseñó MIDI no capturan por completo las capacidades de otros instrumentos; Jaron Lanier cita el estándar como un ejemplo de "bloqueo" tecnológico que inesperadamente limitó lo que era posible expresar. [98] Algunas de estas deficiencias se han abordado en extensiones del protocolo.

Los sintetizadores de software ofrecen gran potencia y versatilidad, pero algunos músicos sienten que la división de la atención entre un teclado MIDI y un teclado y ratón de ordenador le quita algo de inmediatez a la experiencia de interpretación. [99] Los dispositivos dedicados al control MIDI en tiempo real proporcionan un beneficio ergonómico y pueden proporcionar una mayor sensación de conexión con el instrumento que una interfaz a la que se accede a través de un ordenador. Los controladores pueden ser dispositivos de propósito general que están diseñados para funcionar con una variedad de equipos, o pueden estar diseñados para funcionar con un software específico. Ejemplos de estos últimos incluyen el controlador APC40 de Akai para Ableton Live y el controlador MS-20ic de Korg, una reproducción del panel de control de su sintetizador analógico MS-20 . El controlador MS-20ic incluye cables de conexión que se pueden utilizar para controlar el enrutamiento de la señal en su reproducción virtual del sintetizador MS-20 y también puede controlar dispositivos de terceros. [100]

Un instrumento MIDI contiene puertos para enviar y recibir señales MIDI, una CPU para procesar esas señales, una interfaz que permite la programación del usuario, circuitos de audio para generar sonido y controladores. El sistema operativo y los sonidos de fábrica suelen almacenarse en una unidad de memoria de solo lectura (ROM). [2] : 67–70

Un instrumento MIDI también puede ser un módulo independiente (sin un teclado tipo piano) que consta de una tarjeta de sonido General MIDI (GM, GS y XG), edición integrada, que incluye transposición, selección de instrumentos MIDI y ajuste de volumen, panorama, niveles de reverberación y otros controladores MIDI. Normalmente, el módulo MIDI incluye una pantalla, de modo que el usuario puede ver información sobre la función seleccionada actualmente.

Los sintetizadores pueden emplear cualquiera de una variedad de técnicas de generación de sonido. Pueden incluir un teclado integrado o pueden existir como módulos de sonido que generan sonidos cuando se activan mediante un controlador externo, como un teclado MIDI. Los módulos de sonido generalmente están diseñados para montarse en un rack de 19 pulgadas . [2] : 70–72 Los fabricantes suelen producir un sintetizador tanto en versiones independientes como montadas en rack, y a menudo ofrecen la versión de teclado en una variedad de tamaños.

Un sampler puede grabar y digitalizar audio, almacenarlo en una memoria de acceso aleatorio (RAM) y reproducirlo. Los samplers suelen permitir al usuario editar una muestra y guardarla en un disco duro, aplicarle efectos y darle forma con las mismas herramientas que utilizan los sintetizadores sustractivos . También pueden estar disponibles en formato de teclado o montado en rack. [2] : 74–8 Los instrumentos que generan sonidos a través de la reproducción de muestras, pero que no tienen capacidades de grabación, se conocen como " ROMplers ".

Los samplers no se establecieron como instrumentos MIDI viables tan rápidamente como lo hicieron los sintetizadores, debido al gasto de memoria y poder de procesamiento en ese momento. [14] : 295 El primer sampler MIDI de bajo costo fue el Ensoniq Mirage , presentado en 1984. [14] : 304 Los samplers MIDI generalmente están limitados por pantallas que son demasiado pequeñas para usarlas para editar formas de onda muestreadas, aunque algunos se pueden conectar a un monitor de computadora. [14] : 305

Las cajas de ritmos son dispositivos de reproducción de samples que se especializan en sonidos de batería y percusión. Suelen contener un secuenciador que permite crear patrones de batería y organizarlos en una canción. Suelen tener varias salidas de audio, de modo que cada sonido o grupo de sonidos se puede enviar a una salida independiente. Las voces de batería individuales se pueden reproducir desde otro instrumento MIDI o desde un secuenciador. [2] : 84

La tecnología de secuenciadores es anterior a MIDI. Los secuenciadores analógicos utilizan señales CV/Gate para controlar sintetizadores analógicos pre-MIDI. Los secuenciadores MIDI suelen funcionar con funciones de transporte modeladas a partir de las de las pletinas de cinta . Son capaces de grabar interpretaciones MIDI y organizarlas en pistas individuales utilizando un paradigma de grabación multipista . Las estaciones de trabajo musical combinan teclados controladores con un generador de sonido interno y un secuenciador. Se pueden utilizar para crear arreglos completos y reproducirlos utilizando sus propios sonidos internos, y funcionan como estudios de producción musical autónomos. Suelen incluir capacidades de almacenamiento y transferencia de archivos. [2] : 103–4

Algunas unidades de efectos se pueden controlar de forma remota a través de MIDI. Por ejemplo, el Ultra-harmonizer Eventide H3000 permite un control MIDI tan amplio que se puede tocar como un sintetizador. [14] : 322 El Drum Buddy , una caja de ritmos con formato de pedal , tiene una conexión MIDI para poder sincronizar su tempo con un pedal looper o efectos basados en el tiempo como el delay.

Los mensajes MIDI están compuestos por bytes de 8 bits transmitidos a 31 250 [b] (±1 %) baudios mediante comunicación serial asíncrona 8-N-1 como se describe en la figura. El primer bit de cada byte identifica si el byte es un byte de estado o un byte de datos , y es seguido por siete bits de información. [2] : 13–14

Un enlace MIDI puede transportar dieciséis canales independientes, numerados del 1 al 16. Un dispositivo puede escuchar canales específicos e ignorar los mensajes de otros canales ( modo omni desactivado ) o puede escuchar todos los canales, ignorando efectivamente la dirección del canal ( modo omni activado ).

Un dispositivo polifónico puede hacer sonar varias notas simultáneamente hasta que se alcanza el límite de polifonía del dispositivo, o las notas llegan al final de su envolvente de decaimiento , o se reciben comandos MIDI explícitos de nota desactivada . Un dispositivo monofónico , en cambio, termina cualquier nota anterior cuando llegan nuevos comandos de nota activada .

Algunos dispositivos receptores pueden configurarse en las cuatro combinaciones de modos omnidireccional apagado/encendido y mono/poli . [2] : 14–18

Un mensaje MIDI es una instrucción que controla algún aspecto del dispositivo receptor. Un mensaje MIDI consta de un byte de estado, que indica el tipo de mensaje, seguido de hasta dos bytes de datos que contienen los parámetros. [35] Los mensajes MIDI pueden ser mensajes de canal enviados en solo uno de los 16 canales y monitoreados solo por dispositivos en ese canal, o mensajes de sistema que reciben todos los dispositivos. Cada dispositivo receptor ignora los datos que no son relevantes para su función. [66] : 384 Hay cinco tipos de mensajes: Voz de canal, Modo de canal, Común del sistema, Tiempo real del sistema y Exclusivo del sistema. [102]

Los mensajes de voz de canal transmiten datos de interpretación en tiempo real a través de un único canal. Algunos ejemplos incluyen mensajes de nota activada que contienen un número de nota MIDI que especifica el tono de la nota, un valor de velocidad que indica la fuerza con la que se tocó la nota y el número de canal; mensajes de nota desactivada que finalizan una nota; mensajes de cambio de programa que cambian el parche de un dispositivo; y cambios de control que permiten ajustar los parámetros de un instrumento. Las notas MIDI están numeradas del 0 al 127 y se asignan desde C −1 hasta G 9 . Esto se extiende más allá del rango de piano de 88 notas desde A 0 hasta C 8 y corresponde a un rango de frecuencia de 8,175799 a 12543,85 Hz. [c]

Los mensajes exclusivos del sistema ( SysEx ) envían información sobre las funciones de un sintetizador, en lugar de datos de rendimiento como qué notas se están reproduciendo y a qué volumen. Dado que pueden incluir funciones que van más allá de las que ofrece el estándar MIDI, son una de las principales razones de la flexibilidad y la longevidad del estándar MIDI. Los fabricantes los utilizan para crear mensajes propietarios que controlan sus equipos de forma más exhaustiva que las limitaciones de los mensajes MIDI estándar. [14] : 287

La Asociación de Fabricantes MIDI emite un número de identificación único para las empresas MIDI. [103] Estos se incluyen en los mensajes SysEx, para garantizar que solo el dispositivo al que se dirige específicamente responda al mensaje, mientras que todos los demás saben que deben ignorarlo. Muchos instrumentos también incluyen una configuración de ID SysEx, por lo que un controlador puede direccionar dos dispositivos del mismo modelo de forma independiente. [104]

Los mensajes exclusivos del sistema universal son una clase especial de mensajes SysEx utilizados para extensiones de MIDI que no están destinadas a ser exclusivas de un fabricante. [105]

Los dispositivos normalmente no responden a todos los tipos de mensajes definidos por la especificación MIDI. La MMA estandarizó el diagrama de implementación MIDI como una forma de que los usuarios vean qué capacidades específicas tiene un instrumento y cómo responde a los mensajes. [2] : 231 Un diagrama de implementación MIDI completo suele publicarse como parte de la documentación de los dispositivos MIDI.

La interfaz eléctrica de MIDI 1.0 se basa en un bucle de corriente completamente aislado [101] a lo largo de las líneas roja y azul en el siguiente esquema :

"DIN / TRS" en este esquema indica que se puede utilizar un conector DIN [d] o un conector telefónico TRS [e] . [106] [107]

Para transmitir un 0 lógico y un bit de inicio, el UART del transmisor [f] produce un voltaje bajo. Esto da como resultado un flujo de corriente nominal de 5 miliamperios [101] proveniente de la fuente de alto voltaje del transmisor, [g] que viaja hacia la derecha a lo largo de las líneas rojas a través del cable de par trenzado blindado [h] y hacia el optoaislador del receptor. La corriente sale del optoaislador y regresa hacia la izquierda a lo largo de las líneas azules hacia el UART del transmisor, que absorbe la corriente. [i] Las resistencias R1 y R2 limitan la corriente y son iguales para proporcionar una impedancia equilibrada . El diodo es para protección. [109] Esta corriente enciende el LED y el fototransistor del optoaislador [j] , por lo que el UART del receptor puede leer la señal con la ayuda de la resistencia pull-up R3 a la fuente de voltaje del receptor. Si bien las fuentes en la especificación original son de 5 voltios , el receptor y el transmisor pueden usar diferentes niveles de voltaje.

Para transmitir un 1 lógico, un bit de parada y, mientras está inactivo, el UART del transmisor produce el mismo alto voltaje que proporciona su fuente de voltaje , lo que da como resultado que no haya flujo de corriente. Esto evita el desperdicio de energía cuando está inactivo.

La flexibilidad y la adopción generalizada de MIDI han llevado a muchos refinamientos del estándar y han permitido su aplicación a propósitos más allá de aquellos para los que fue originalmente pensado.

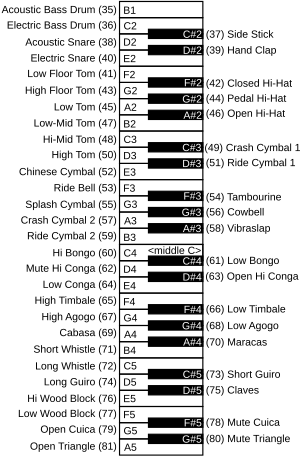

MIDI permite la selección de sonidos de un instrumento a través de mensajes de cambio de programa, pero no hay garantía de que dos instrumentos tengan el mismo sonido en una ubicación de programa dada. [110] El programa #0 puede ser un piano en un instrumento o una flauta en otro. El estándar General MIDI (GM) se estableció en 1991 y proporciona un banco de sonidos estandarizado que permite que un archivo MIDI estándar creado en un dispositivo suene similar cuando se reproduce en otro. GM especifica un banco de 128 sonidos organizados en 16 familias de ocho instrumentos relacionados y asigna un número de programa específico a cada instrumento. [111] Cualquier cambio de programa dado selecciona el mismo sonido de instrumento en cualquier instrumento compatible con GM. [112] Los instrumentos de percusión se colocan en el canal 10 y se asigna un valor de nota MIDI específico a cada sonido de percusión.

El estándar GM elimina la variación en la asignación de notas. Algunos fabricantes no se ponían de acuerdo sobre qué número de nota debería representar el Do central, pero GM especifica que la nota número 69 reproduce el A440 , lo que a su vez fija el Do central como la nota número 60.

Los dispositivos compatibles con GM deben ofrecer polifonía de 24 notas. [113] Los dispositivos compatibles con GM deben responder a la velocidad, aftertouch y pitch bend, estar configurados con valores predeterminados específicos al inicio y ser compatibles con ciertos números de controlador, como pedal de sustain y números de parámetros registrados (RPN). [114]

Una versión simplificada de GM, llamada GM Lite , se utiliza para dispositivos con potencia de procesamiento limitada. [110] [115]

Rápidamente se formó una opinión general de que el conjunto de sonidos de 128 instrumentos del GM no era lo suficientemente grande. El General Standard de Roland, o Roland GS , incluía sonidos, kits de batería y efectos adicionales, proporcionaba un comando de selección de banco que se podía usar para acceder a ellos y usaba números de parámetros no registrados MIDI (NRPN) para acceder a sus nuevas funciones. El General MIDI extendido de Yamaha, o Yamaha XG , siguió en 1994. XG ofrecía de manera similar sonidos, kits de batería y efectos adicionales, pero usaba controladores estándar en lugar de NRPN para la edición y aumentó la polifonía a 32 voces. Ambos estándares cuentan con compatibilidad con versiones anteriores de la especificación GM, pero no son compatibles entre sí. [116] Ninguno de los estándares ha sido adoptado más allá de su creador, pero ambos son comúnmente compatibles con títulos de software musical.

Las empresas miembros de la AMEI de Japón desarrollaron la especificación General MIDI Nivel 2 en 1999. GM2 mantiene la compatibilidad con versiones anteriores de GM, pero aumenta la polifonía a 32 voces, estandariza varios números de controlador como para sostenuto y pedal suave ( una corda ), RPN y mensajes exclusivos del sistema universal, e incorpora el estándar de afinación MIDI. [117] GM2 es la base del mecanismo de selección de instrumentos en Scalable Polyphony MIDI (SP-MIDI), una variante MIDI para dispositivos de bajo consumo que permite que la polifonía del dispositivo se escale de acuerdo con su potencia de procesamiento. [110]

La mayoría de los sintetizadores MIDI utilizan una afinación de temperamento igual . El estándar de afinación MIDI (MTS), ratificado en 1992, permite afinaciones alternativas. [118] El MTS permite microafinaciones que se pueden cargar desde un banco de hasta 128 parches y permite el ajuste en tiempo real de los tonos de las notas. [119] Los fabricantes no están obligados a dar soporte al estándar. Aquellos que lo hacen no están obligados a implementar todas sus características. [118]

Un secuenciador puede controlar un sistema MIDI con su reloj interno, pero cuando un sistema contiene varios secuenciadores, deben sincronizarse con un reloj común. El código de tiempo MIDI (MTC), desarrollado por Digidesign , [120] implementa mensajes SysEx [121] desarrollados específicamente para fines de sincronización, y puede traducir hacia y desde el estándar de código de tiempo SMPTE . [14] : 288 Las interfaces MIDI como MIDI Timepiece de Mark of the Unicorn pueden convertir código SMPTE a MTC. [122] Mientras que el reloj MIDI se basa en el tempo, el código de tiempo se basa en cuadros y es independiente del tempo. MTC, como el código SMPTE, incluye información de posición y puede recuperarse en caso de una caída . [123]

El control de máquina MIDI (MMC) consiste en un conjunto de comandos SysEx [124] que operan los controles de transporte de los dispositivos de grabación de hardware. MMC permite que un secuenciador envíe comandos Start , Stop y Record a una pletina de cinta o un sistema de grabación de disco duro conectado, y que avance o rebobine rápidamente el dispositivo para iniciar la reproducción en el mismo punto que el secuenciador. No intervienen datos de sincronización, aunque los dispositivos pueden sincronizarse a través de MTC. [125]

MIDI Show Control (MSC) es un conjunto de comandos SysEx para secuenciar y activar de forma remota dispositivos de control de espectáculos, como iluminación, reproducción de música y sonido, y sistemas de control de movimiento . [127] Las aplicaciones incluyen producciones teatrales, exhibiciones en museos, sistemas de control de estudios de grabación y atracciones de parques de diversiones . [126]

Una solución a los problemas de sincronización MIDI es marcar los eventos MIDI con los tiempos en que se van a reproducir, transmitirlos de antemano y almacenarlos en un búfer en el dispositivo receptor. El envío de datos de antemano reduce la probabilidad de que un pasaje concurrido sature el enlace de transmisión. Una vez almacenada en el receptor, la información ya no está sujeta a problemas de sincronización asociados con las interfaces MIDI o USB y se puede reproducir con un alto grado de precisión. [128] El sellado de tiempo MIDI solo funciona cuando tanto el hardware como el software lo admiten. MTS de MOTU, AMT de eMagic y Midex 8 de Steinberg tenían implementaciones que eran incompatibles entre sí y requerían que los usuarios tuvieran software y hardware fabricados por la misma empresa para funcionar. [74] El sellado de tiempo está integrado en las interfaces MIDI FireWire, [129] Mac OS X Core Audio y Linux ALSA Sequencer.

Una capacidad imprevista de los mensajes SysEx fue su uso para transportar muestras de audio entre instrumentos. Esto condujo al desarrollo del estándar de volcado de muestras (SDS), que estableció un nuevo formato SysEx para la transmisión de muestras. [14] : 287 El SDS se amplió posteriormente con un par de comandos que permiten la transmisión de información sobre puntos de bucle de muestra, sin necesidad de transmitir la muestra completa. [130]

La especificación de Sonidos Descargables (DLS), ratificada en 1997, permite a los dispositivos móviles y a las tarjetas de sonido de ordenador ampliar sus tablas de ondas con conjuntos de sonidos descargables. [131] La especificación DLS Nivel 2 se introdujo en 2006 y definió una arquitectura de sintetizador estandarizada. El estándar Mobile DLS exige que los bancos DLS se combinen con SP-MIDI, como archivos Mobile XMF autónomos. [132]

MIDI Polyphonic Expression (MPE) es un método de uso de MIDI que permite que el pitch bend y otras dimensiones del control expresivo se ajusten continuamente para notas individuales. [133] MPE funciona asignando cada nota a su propio canal MIDI para que los mensajes del controlador se puedan aplicar a cada nota individualmente. [134] [133] Las especificaciones fueron publicadas en noviembre de 2017 por AMEI y en enero de 2018 por MMA. [135] Instrumentos como Continuum Fingerboard , LinnStrument , ROLI Seaboard , Sensel Morph y Eigenharp permiten a los usuarios controlar el tono, el timbre y otros matices de notas individuales dentro de los acordes. [136]

Además de utilizar un bucle de corriente de 31,25 kbit/s a través de un conector DIN , los mismos datos se pueden transmitir a través de diferentes transportes de hardware, como USB , FireWire y Ethernet .

Los miembros de la USB-IF desarrollaron en 1999 un estándar para MIDI sobre USB, la "Definición de clase de dispositivo de bus serie universal para dispositivos MIDI". [137] MIDI sobre USB se ha vuelto cada vez más común a medida que otras interfaces que se habían utilizado para conexiones MIDI ( tarjeta ISA , puerto de juegos , etc.) desaparecieron de las computadoras personales. Los sistemas operativos Linux, Microsoft Windows, Macintosh OS X y Apple iOS incluyen controladores de clase estándar para admitir dispositivos que utilizan la "Definición de clase de dispositivo de bus serie universal para dispositivos MIDI".

Apple Computer desarrolló la interfaz FireWire durante la década de 1990. Comenzó a aparecer en las cámaras de vídeo digital (DV) hacia finales de la década, y en los modelos Macintosh G3 en 1999. [138] Fue creado para su uso con aplicaciones multimedia. [129] A diferencia del USB, FireWire utiliza controladores inteligentes que pueden gestionar su propia transmisión sin la atención de la CPU principal. [139] Al igual que con los dispositivos MIDI estándar, los dispositivos FireWire pueden comunicarse entre sí sin necesidad de una computadora presente. [140]

El sintetizador Octave-Plateau Voyetra-8 fue una de las primeras implementaciones MIDI que utilizaba conectores XLR3 en lugar del DIN de 5 pines . Se lanzó en los años previos a MIDI y luego se modernizó con una interfaz MIDI, pero mantuvo su conector XLR. [141]

A medida que las configuraciones de estudio basadas en computadora se hicieron comunes, aparecieron dispositivos MIDI que podían conectarse directamente a una computadora. Estos típicamente usaban el conector mini-DIN de 8 pines que Apple usaba para los puertos seriales antes de la introducción de los modelos Blue & White G3 . Las interfaces MIDI diseñadas para usarse como la pieza central de un estudio, como Mark of the Unicorn MIDI Time Piece, fueron posibles gracias a un modo de transmisión "rápido" que podía aprovechar la capacidad de estos puertos seriales para operar a 20 veces la velocidad MIDI estándar. [2] : 62–3 [140] Los puertos mini-DIN se incorporaron a algunos instrumentos MIDI de finales de la década de 1990 y permitieron que dichos dispositivos se conectaran directamente a una computadora. [142] Algunos dispositivos se conectaban a través del puerto paralelo DB-25 de las PC o a través del puerto de joystick DA-15 que se encuentra en muchas tarjetas de sonido de PC. [140]

Yamaha introdujo el protocolo mLAN en 1999. Fue concebido como una red de área local para instrumentos musicales que utilizaban FireWire como transporte, y fue diseñado para transportar múltiples canales MIDI junto con audio digital multicanal, transferencias de archivos de datos y código de tiempo. [138] [139] mLan se utilizó en varios productos Yamaha, en particular en las consolas de mezclas digitales y el sintetizador Motif , y en productos de terceros como PreSonus FIREstation y Korg Triton Studio . [143] No se han lanzado nuevos productos mLan desde 2007.

La interfaz de dispositivo MIDI SCSI (SMDI) fue utilizada por algunos samplers y grabadores de disco duro en la década de 1990 (por ejemplo, Kurzweil K2000 y Peavey SP Sample Playback Synthesizer [144] ) para el transporte rápido de muestras bidireccionales a unidades de disco duro y unidades magneto-ópticas . [145] [146]

Las implementaciones de MIDI en redes informáticas proporcionan capacidades de enrutamiento de red y el canal de gran ancho de banda que las alternativas anteriores a MIDI, como ZIPI , pretendían ofrecer. Existen implementaciones propietarias desde la década de 1980, algunas de las cuales utilizan cables de fibra óptica para la transmisión. [2] : 53–4 La especificación abierta RTP-MIDI del Internet Engineering Task Force ha ganado el apoyo de la industria. Apple ha admitido este protocolo desde Mac OS X 10.4 en adelante, y existe un controlador de Windows basado en la implementación de Apple para Windows XP y versiones más nuevas. [147]

Los sistemas para transmisión MIDI inalámbrica han estado disponibles desde la década de 1980. [2] : 44 Varios transmisores disponibles comercialmente permiten la transmisión inalámbrica de señales MIDI y OSC a través de Wi-Fi y Bluetooth . [148] Los dispositivos iOS pueden funcionar como superficies de control MIDI, utilizando Wi-Fi y OSC. [149] Se puede utilizar una radio XBee para construir un transceptor MIDI inalámbrico como un proyecto de bricolaje. [150] Los dispositivos Android pueden funcionar como superficies de control MIDI completas utilizando varios protocolos diferentes a través de Wi-Fi y Bluetooth . [151]

El estándar MIDI 2.0 se presentó el 17 de enero de 2020 en el Winter NAMM Show en Anaheim, California. Representantes de Yamaha, Roli , Microsoft, Google y la Asociación MIDI presentaron la actualización, [152] que permite la comunicación bidireccional manteniendo la compatibilidad con versiones anteriores. [153]

La investigación sobre el nuevo protocolo comenzó en 2005. [54] [154] [155] Los dispositivos prototipo que muestran conexiones cableadas e inalámbricas se han mostrado de forma privada en NAMM. [154] Se han desarrollado políticas de licencia y certificación de productos, [156] aunque no se anunció ninguna fecha de lanzamiento proyectada. [157] La capa física y la capa de transporte propuestas incluían protocolos basados en Ethernet como RTP MIDI y Audio Video Bridging / Time-Sensitive Networking , [140] así como transporte basado en el Protocolo de datagramas de usuario (UDP). [155]

AMEI y MMA anunciaron que se publicarán las especificaciones completas luego de las pruebas de interoperabilidad de las implementaciones de prototipos de los principales fabricantes como Google , Yamaha , Steinberg , Roland , Ableton , Native Instruments y ROLI , entre otros. [21] [135] [158] En enero de 2020, Roland anunció el teclado controlador A-88mkII que admite MIDI 2.0. [159]

MIDI 2.0 incluye la especificación MIDI Capability Inquiry para intercambio de propiedades y perfiles, y el nuevo formato Universal MIDI Packet para transportes de alta velocidad que admite mensajes de voz MIDI 1.0 y MIDI 2.0.

Algunos dispositivos que funcionan con MIDI 1.0 pueden "adaptarse" a algunas funciones de la versión 2.0. Desde su lanzamiento a principios de enero de 2020 por parte de la Asociación de Fabricantes MIDI, aún no se han publicado más detalles sobre la nueva actualización. Actualmente, MIDI tiene cinco componentes, como: M2-100-U v1.0 MIDI 2.0 Specification Overview, M2-101-UM v1.1 MIDI-CI Specification, M2-102-U v1.0 Common Rules for MIDI-CI Profiles, M2-103-UM v1.0 Common Rules for MIDI-CI PE y M2-104-UM v1.0 UMP and MIDI 2.0 Protocol Specification. Otras especificaciones relacionadas con MIDI 2.0 incluyen: permitir el uso de 32 000 controladores y mejoras de notas de amplio rango. Estas mejoras se mejoran mediante el intercambio de propiedades. [160]

El intercambio de propiedades en MIDI 2.0 utiliza JSON o notación de objetos JavaScript. Esto proporciona un formato legible para el intercambio de conjuntos de datos. Al hacerlo, se abre una amplia gama de capacidades para MIDI 2.0. JSON permite que cualquier dispositivo conectado, ya sea un teclado, un piano o cualquier otro dispositivo eléctrico, describa lo que está haciendo y lo que puede hacer en lugar de que la persona que lo opera cambie su configuración cada vez que opera un nuevo dispositivo. Por ejemplo, un teclado MIDI que está conectado a un dispositivo iOS con configuraciones MIDI específicas ahora se puede conectar a un dispositivo Windows y no es necesario cambiar sus configuraciones manualmente. Cualquier componente musical utilizado en un dispositivo se mantendrá y se puede alterar automáticamente en otro. [160]

MIDI Capability Inquiry (MIDI-CI) especifica mensajes SysEx universales para implementar perfiles de dispositivos, intercambio de parámetros y negociación de protocolos MIDI. [135] Las especificaciones fueron publicadas en noviembre de 2017 por AMEI y en enero de 2018 por MMA.

El intercambio de parámetros define métodos para consultar las capacidades del dispositivo, como los controladores compatibles, los nombres de parches, los perfiles de instrumentos, la configuración del dispositivo y otros metadatos, y para obtener o establecer los ajustes de configuración del dispositivo. El intercambio de propiedades utiliza mensajes exclusivos del sistema que llevan datos en formato JSON . Los perfiles definen conjuntos comunes de controladores MIDI para varios tipos de instrumentos, como órganos de barras y sintetizadores analógicos, o para tareas particulares, lo que mejora la interoperabilidad entre instrumentos de diferentes fabricantes. La negociación de protocolos permite que los dispositivos empleen el protocolo de próxima generación o protocolos específicos del fabricante. [158]

MIDI 2.0 define un nuevo formato de paquete MIDI universal, que contiene mensajes de longitud variable (32, 64, 96 o 128 bits) según el tipo de carga útil. Este nuevo formato de paquete admite un total de 256 canales MIDI, organizados en 16 grupos de 16 canales; cada grupo puede transportar un flujo de protocolo MIDI 1.0 o un nuevo flujo de protocolo MIDI 2.0, y también puede incluir mensajes del sistema, datos exclusivos del sistema y marcas de tiempo para la representación precisa de varias notas simultáneas. Para simplificar la adopción inicial, se permite explícitamente que los productos existentes solo implementen mensajes MIDI 1.0. El paquete MIDI universal está pensado para el transporte de alta velocidad, como USB y Ethernet, y no es compatible con las conexiones DIN de 5 pines existentes. [158] Los mensajes de tiempo real del sistema y comunes del sistema son los mismos que se definen en MIDI 1.0. [158]

A partir de enero de 2019, el borrador de especificación del nuevo protocolo admite todos los mensajes principales que también existen en MIDI 1.0, pero amplía su precisión y resolución; también define muchos mensajes de controlador nuevos de alta precisión. [158] La especificación define reglas de traducción predeterminadas para convertir entre mensajes de voz de canal MIDI 2.0 y mensajes de voz de canal MIDI 1.0 que usan una resolución de datos diferente, así como para mapear 256 flujos MIDI 2.0 a 16 flujos MIDI 1.0. [161] [162]

Los mensajes System Exclusive 8 utilizan un nuevo formato de datos de 8 bits, basado en los mensajes Universal System Exclusive. Los mensajes de conjunto de datos mixtos están pensados para transferir grandes conjuntos de datos. Los mensajes System Exclusive 7 utilizan el formato de datos anterior de 7 bits. [158]

{{cite web}}: CS1 maint: varios nombres: lista de autores ( enlace )También se especificó originalmente un Tipo 2, pero nunca se popularizó.

{{cite web}}: CS1 maint: url-status (link)