La teoría de la probabilidad o el cálculo de probabilidad es la rama de las matemáticas que se ocupa de la probabilidad . Aunque existen varias interpretaciones diferentes de la probabilidad , la teoría de la probabilidad trata el concepto de una manera matemática rigurosa expresándolo a través de un conjunto de axiomas . Por lo general, estos axiomas formalizan la probabilidad en términos de un espacio de probabilidad , que asigna una medida que toma valores entre 0 y 1, denominada medida de probabilidad , a un conjunto de resultados llamado espacio muestral . Cualquier subconjunto específico del espacio muestral se denomina evento .

Los temas centrales de la teoría de la probabilidad incluyen las variables aleatorias discretas y continuas , las distribuciones de probabilidad y los procesos estocásticos (que proporcionan abstracciones matemáticas de procesos no deterministas o inciertos o cantidades medidas que pueden ser ocurrencias únicas o evolucionar con el tiempo de manera aleatoria). Aunque no es posible predecir perfectamente los eventos aleatorios, se puede decir mucho sobre su comportamiento. Dos resultados importantes en la teoría de la probabilidad que describen dicho comportamiento son la ley de los grandes números y el teorema del límite central .

Como fundamento matemático de la estadística , la teoría de la probabilidad es esencial para muchas actividades humanas que implican el análisis cuantitativo de datos. [1] Los métodos de la teoría de la probabilidad también se aplican a las descripciones de sistemas complejos dado solo un conocimiento parcial de su estado, como en la mecánica estadística o la estimación secuencial . Un gran descubrimiento de la física del siglo XX fue la naturaleza probabilística de los fenómenos físicos a escala atómica, descritos en la mecánica cuántica . [2]

La teoría matemática moderna de la probabilidad tiene sus raíces en los intentos de analizar los juegos de azar por parte de Gerolamo Cardano en el siglo XVI, y por Pierre de Fermat y Blaise Pascal en el siglo XVII (por ejemplo el « problema de los puntos »). [3] Christiaan Huygens publicó un libro sobre el tema en 1657. [4] En el siglo XIX, lo que se considera la definición clásica de probabilidad fue completada por Pierre Laplace . [5]

Inicialmente, la teoría de la probabilidad consideraba principalmente eventos discretos y sus métodos eran principalmente combinatorios . Finalmente, las consideraciones analíticas obligaron a incorporar variables continuas a la teoría.

Esto culminó en la teoría de probabilidad moderna, sobre las bases establecidas por Andrey Nikolaevich Kolmogorov . Kolmogorov combinó la noción de espacio muestral , introducida por Richard von Mises , y la teoría de la medida y presentó su sistema de axiomas para la teoría de probabilidad en 1933. Esto se convirtió en la base axiomática mayoritariamente indiscutible para la teoría de probabilidad moderna; pero existen alternativas, como la adopción de la aditividad finita en lugar de la contable por Bruno de Finetti . [6]

La mayoría de las introducciones a la teoría de la probabilidad tratan las distribuciones de probabilidad discretas y las distribuciones de probabilidad continuas por separado. El tratamiento de la probabilidad basado en la teoría de la medida abarca las distribuciones de probabilidad discretas, continuas, una combinación de ambas y más.

Consideremos un experimento que puede producir varios resultados. El conjunto de todos los resultados se denomina espacio muestral del experimento. El conjunto potencia del espacio muestral (o, equivalentemente, el espacio de sucesos) se forma considerando todas las diferentes colecciones de resultados posibles. Por ejemplo, al lanzar un dado honesto se obtiene uno de seis resultados posibles. Una colección de resultados posibles corresponde a obtener un número impar. Por lo tanto, el subconjunto {1,3,5} es un elemento del conjunto potencia del espacio muestral de tiradas de dados. Estas colecciones se denominan sucesos . En este caso, {1,3,5} es el suceso de que el dado caiga en algún número impar. Si los resultados que realmente ocurren caen en un suceso dado, se dice que ese suceso ha ocurrido.

La probabilidad es una forma de asignar a cada "evento" un valor entre cero y uno, con el requisito de que al evento compuesto por todos los resultados posibles (en nuestro ejemplo, el evento {1,2,3,4,5,6}) se le asigne un valor de uno. Para calificar como una distribución de probabilidad , la asignación de valores debe satisfacer el requisito de que si se observa una colección de eventos mutuamente excluyentes (eventos que no contienen resultados comunes, por ejemplo, los eventos {1,6}, {3} y {2,4} son todos mutuamente excluyentes), la probabilidad de que cualquiera de estos eventos ocurra está dada por la suma de las probabilidades de los eventos. [7]

La probabilidad de que ocurra cualquiera de los eventos {1,6}, {3} o {2,4} es 5/6. Esto es lo mismo que decir que la probabilidad del evento {1,2,3,4,6} es 5/6. Este evento abarca la posibilidad de que salga cualquier número excepto el cinco. El evento mutuamente excluyente {5} tiene una probabilidad de 1/6, y el evento {1,2,3,4,5,6} tiene una probabilidad de 1, es decir, certeza absoluta.

Al realizar cálculos utilizando los resultados de un experimento, es necesario que todos esos eventos elementales tengan un número asignado. Esto se hace utilizando una variable aleatoria . Una variable aleatoria es una función que asigna a cada evento elemental en el espacio muestral un número real . Esta función se denota generalmente por una letra mayúscula. [8] En el caso de un dado, la asignación de un número a ciertos eventos elementales se puede hacer utilizando la función identidad . Esto no siempre funciona. Por ejemplo, al lanzar una moneda los dos resultados posibles son "cara" y "cruz". En este ejemplo, la variable aleatoria X podría asignar al resultado "cara" el número "0" ( ) y al resultado "cruz" el número "1" ( ).

La teoría de probabilidad discreta se ocupa de eventos que ocurren en espacios muestrales contables .

Ejemplos: lanzar dados , experimentos con barajas de cartas , caminata aleatoria y lanzamiento de monedas .

Definición clásica : Inicialmente la probabilidad de que ocurra un evento se definió como el número de casos favorables para el evento, sobre el número total de resultados posibles en un espacio muestral equiprobable: ver Definición clásica de probabilidad .

Por ejemplo, si el evento es "aparición de un número par al lanzar un dado", la probabilidad está dada por , ya que 3 caras de las 6 tienen números pares y cada cara tiene la misma probabilidad de aparecer.

Definición moderna : La definición moderna comienza con un conjunto finito o numerable llamado espacio muestral , que se relaciona con el conjunto de todos los resultados posibles en el sentido clásico, denotado por . Luego se supone que para cada elemento , se le asigna un valor de "probabilidad" intrínseco , que satisface las siguientes propiedades:

Es decir, la función de probabilidad f ( x ) se encuentra entre cero y uno para cada valor de x en el espacio muestral Ω , y la suma de f ( x ) sobre todos los valores x en el espacio muestral Ω es igual a 1. Un evento se define como cualquier subconjunto del espacio muestral . La probabilidad del evento se define como

Entonces, la probabilidad de todo el espacio muestral es 1 y la probabilidad del evento nulo es 0.

La función que asigna un punto en el espacio muestral al valor de "probabilidad" se denomina función de masa de probabilidad, abreviada como pmf .

La teoría de probabilidad continua se ocupa de eventos que ocurren en un espacio muestral continuo.

Definición clásica : La definición clásica se desmorona cuando se la confronta con el caso continuo. Véase la paradoja de Bertrand .

Definición moderna : Si el espacio muestral de una variable aleatoria X es el conjunto de números reales ( ) o un subconjunto de ellos, entonces existe una función llamada función de distribución acumulativa ( CDF ) , definida por . Es decir, F ( x ) devuelve la probabilidad de que X sea menor o igual a x .

La CDF satisface necesariamente las siguientes propiedades.

Se dice que la variable aleatoria tiene una distribución de probabilidad continua si la CDF correspondiente es continua. Si es absolutamente continua , es decir, su derivada existe e integrando la derivada obtenemos nuevamente la CDF, entonces se dice que la variable aleatoria X tiene una función de densidad de probabilidad ( PDF ) o simplemente densidad

Para un conjunto , la probabilidad de que la variable aleatoria X esté en es

En caso de que exista el PDF, esto se puede escribir como

Mientras que la PDF existe solo para variables aleatorias continuas, la CDF existe para todas las variables aleatorias (incluidas las variables aleatorias discretas) que toman valores en

Estos conceptos pueden generalizarse para casos multidimensionales y otros espacios muestrales continuos.

La utilidad del tratamiento de la probabilidad basado en la teoría de la medida es que unifica los casos discretos y continuos y hace que la diferencia sea una cuestión de qué medida se utiliza. Además, abarca distribuciones que no son ni discretas ni continuas ni mezclas de ambas.

Un ejemplo de tales distribuciones podría ser una mezcla de distribuciones discretas y continuas; por ejemplo, una variable aleatoria que es 0 con probabilidad 1/2 y toma un valor aleatorio de una distribución normal con probabilidad 1/2. Aún se puede estudiar hasta cierto punto considerando que tiene una PDF de , donde es la función delta de Dirac .

Es posible que otras distribuciones ni siquiera sean una mezcla; por ejemplo, la distribución de Cantor no tiene probabilidad positiva para ningún punto individual ni tampoco tiene densidad. El enfoque moderno de la teoría de la probabilidad resuelve estos problemas utilizando la teoría de la medida para definir el espacio de probabilidad :

Dado cualquier conjunto (también llamado espacio muestral ) y un σ-álgebra sobre él, una medida definida en se denomina medida de probabilidad si

Si es la σ-álgebra de Borel sobre el conjunto de números reales, entonces existe una medida de probabilidad única para cualquier función de distribución de probabilidad, y viceversa. Se dice que la medida correspondiente a una función de distribución de probabilidad es inducida por la función de distribución de probabilidad. Esta medida coincide con la función de masa de probabilidad para variables discretas y la función de densidad de probabilidad para variables continuas, lo que hace que el enfoque de la teoría de la medida esté libre de falacias.

La probabilidad de un conjunto en el σ-álgebra se define como

donde la integración es con respecto a la medida inducida por

Además de proporcionar una mejor comprensión y unificación de las probabilidades discretas y continuas, el tratamiento de la teoría de la medida también nos permite trabajar con probabilidades fuera de , como en la teoría de procesos estocásticos . Por ejemplo, para estudiar el movimiento browniano , la probabilidad se define en un espacio de funciones.

Cuando es conveniente trabajar con una medida dominante, se utiliza el teorema de Radon-Nikodym para definir una densidad como la derivada de Radon-Nikodym de la distribución de probabilidad de interés con respecto a esta medida dominante. Las densidades discretas se definen habitualmente como esta derivada con respecto a una medida de conteo sobre el conjunto de todos los resultados posibles. Las densidades para distribuciones absolutamente continuas se definen habitualmente como esta derivada con respecto a la medida de Lebesgue . Si un teorema se puede demostrar en este contexto general, se cumple tanto para distribuciones discretas como continuas, así como para otras; no se requieren demostraciones separadas para distribuciones discretas y continuas.

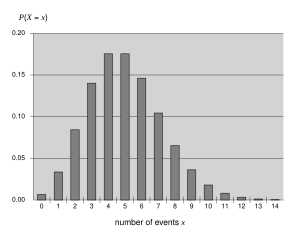

Ciertas variables aleatorias aparecen con mucha frecuencia en la teoría de la probabilidad porque describen bien muchos procesos naturales o físicos. Por lo tanto, sus distribuciones han adquirido especial importancia en la teoría de la probabilidad. Algunas distribuciones discretas fundamentales son la distribuciones uniforme discreta , la de Bernoulli , la binomial , la binomial negativa , la de Poisson y la geométrica . Entre las distribuciones continuas importantes se encuentran la distribuciones uniforme continua , la normal , la exponencial , la gamma y la beta .

En teoría de la probabilidad, existen varias nociones de convergencia para variables aleatorias . Se enumeran a continuación en orden de fuerza, es decir, cualquier noción de convergencia posterior en la lista implica convergencia de acuerdo con todas las nociones anteriores.

Como lo indican los nombres, la convergencia débil es más débil que la convergencia fuerte. De hecho, la convergencia fuerte implica convergencia en probabilidad, y la convergencia en probabilidad implica convergencia débil. Las afirmaciones inversas no siempre son ciertas.

La intuición común sugiere que si una moneda justa se lanza muchas veces, entonces aproximadamente la mitad de las veces saldrá cara y la otra mitad saldrá cruz . Además, cuanto más a menudo se lance la moneda, más probable debería ser que la relación entre el número de caras y el número de cruces se acerque a la unidad. La teoría de la probabilidad moderna proporciona una versión formal de esta idea intuitiva, conocida como la ley de los grandes números . Esta ley es notable porque no se asume en los fundamentos de la teoría de la probabilidad, sino que surge de estos fundamentos como un teorema. Dado que vincula las probabilidades derivadas teóricamente con su frecuencia real de ocurrencia en el mundo real, la ley de los grandes números se considera un pilar en la historia de la teoría estadística y ha tenido una amplia influencia. [9]

La ley de los grandes números (LLN) establece que el promedio de la muestra

de una secuencia de variables aleatorias independientes e idénticamente distribuidas converge hacia su expectativa común (valor esperado) , siempre que la expectativa de sea finita.

Es en las diferentes formas de convergencia de las variables aleatorias que se separa la ley débil y la ley fuerte de los grandes números [10].

Del LLN se desprende que si un evento de probabilidad p se observa repetidamente durante experimentos independientes, la relación entre la frecuencia observada de ese evento y el número total de repeticiones converge hacia p .

Por ejemplo, si son variables aleatorias de Bernoulli independientes que toman valores 1 con probabilidad p y 0 con probabilidad 1- p , entonces para todo i , de modo que converge a p casi con seguridad .

El teorema del límite central (TLC) explica la ocurrencia ubicua de la distribución normal en la naturaleza, y este teorema, según David Williams, "es uno de los grandes resultados de las matemáticas". [11]

El teorema establece que el promedio de muchas variables aleatorias independientes e idénticamente distribuidas con varianza finita tiende hacia una distribución normal independientemente de la distribución seguida por las variables aleatorias originales. Formalmente, sean variables aleatorias independientes con media y varianza . Entonces, la secuencia de variables aleatorias

converge en distribución a una variable aleatoria normal estándar .

Para algunas clases de variables aleatorias, el teorema clásico del límite central funciona con bastante rapidez, como lo ilustra el teorema de Berry-Esseen . Por ejemplo, las distribuciones con primer, segundo y tercer momento finitos de la familia exponencial ; por otro lado, para algunas variables aleatorias de la variedad de cola pesada y cola gorda , funciona muy lentamente o puede no funcionar en absoluto: en tales casos se puede utilizar el Teorema del límite central generalizado (GCLT).