Correlación

La correlación entre dos variables no implica, por sí misma, ninguna relación de causalidad (Véase cum hoc ergo propter hoc).

Una relación funcional se expresa mediante una función matemática.

Si X es la variable independiente e Y es la variable dependiente, una relación funcional tiene la forma: pY=f(X) Las correlaciones son útiles porque pueden indicar una relación predictiva que puede explotarse en la práctica.

En este ejemplo, existe una relación causal, porque el tiempo extremo hace que la gente utilice más electricidad para calefacción o refrigeración.

Sin embargo, en general, la presencia de una correlación no es suficiente para inferir la presencia de una relación causal (es decir, correlación no implica causalidad).

Formalmente, las variables aleatorias son dependientes si no satisfacen una propiedad matemática de independencia probabilística.

En lenguaje informal, correlación es sinónimo de dependencia.

Sin embargo, cuando se utiliza en un sentido técnico, la correlación se refiere a cualquiera de varios tipos específicos de operaciones matemáticas entre las variables probadas y sus respectivos valores esperados.

Esencialmente, la correlación es la medida de cómo dos o más variables están relacionadas entre sí.

Existen varios coeficientes de correlación, a menudo denotados

[1][2][3] Información mutua también puede aplicarse para medir la dependencia entre dos variables.

es una notación alternativa ampliamente utilizada para el coeficiente de correlación.

La correlación de Pearson sólo se define si ambas desviaciones típicas son finitas y positivas.

Una fórmula alternativa puramente en términos de momentos es:

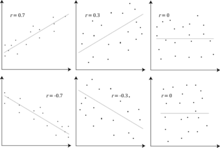

El coeficiente de correlación es +1 en el caso de una relación lineal directa (creciente) perfecta (correlación), -1 en el caso de una relación lineal inversa (decreciente) perfecta (anticorrelación),[5] y algún valor en el intervalo abierto

en todos los demás casos, indicando el grado de dependencia lineal entre las variables.

A medida que se acerca a cero hay menos relación (más cerca de la no correlación).

se distribuye simétricamente alrededor de cero, y

son perfectamente dependientes, pero su correlación es cero; están no correlacionadas.

Sin embargo, en el caso especial de que

sean distribuciones normales multivariadas, la falta de correlación es equivalente a la independencia.

Aunque los datos no correlacionados no implican necesariamente independencia, se puede comprobar si las variables aleatorias son independientes si su información mutua es 0.

Otros coeficientes son: Dados los valores muestrales de dos variables aleatorias

El coseno del ángulo alfa entre estos vectores es dado por la fórmula siguiente:

El coeficiente de correlación es el coseno del ángulo entre ambos vectores centrados: Más generalmente:

Por supuesto, desde el punto vista geométrico, no hablamos de correlación lineal: el coeficiente de correlación tiene siempre un sentido, cualquiera sea su valor entre -1 y 1.

donde: Nótese que el valor esperado del coeficiente de correlación muestral r es:

Puede obtenerse un estimador aproximado no sesgado resolviendo la ecuación:

de variables aleatorias sigue una distribución normal bivariada, la media condicional

, junto con las medias y varianzas marginales de