Compresión de datos

Por tanto, cuantos más bits se empleen mayor será el tamaño del archivo.

No obstante, la resolución viene impuesta por el sistema digital con que se trabaja y no se puede alterar el número de bits a voluntad; por ello, se utiliza la compresión, para transmitir la misma cantidad de información que ocuparía una gran resolución en un número inferior de bits.

En realidad, el proceso es mucho más complejo, ya que raramente se consigue encontrar patrones de repetición tan exactos (salvo en algunas imágenes).

[10] DEFLATE, un algoritmo de compresión sin pérdidas especificado en 1996, se utiliza en el formato Portable Network Graphics (PNG).

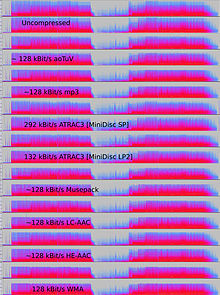

Estos algoritmos se basan casi todos en la psicoacústica para eliminar o reducir la fidelidad de los sonidos menos audibles, reduciendo así el espacio necesario para almacenarlos o transmitirlos.

Los códecs sin pérdidas utilizan el ajuste de curvas o la predicción lineal como base para estimar la señal.

Algunos formatos están asociados a un sistema distinto, como Direct Stream Transfer, utilizado en Super Audio CD y Meridian Lossless Packing, utilizado en DVD-Audio, Dolby TrueHD, Blu-ray y HD DVD.

Estos formatos incluyen MPEG-4 SLS (Scalable to Lossless), WavPack y OptimFROG DualStream.

Cuando se van a procesar archivos de audio, ya sea por compresión posterior o para edición, es deseable trabajar a partir de un original inalterado (sin comprimir o comprimido sin pérdidas).

Sin embargo, los formatos con pérdidas, como el MP3, son muy populares entre los usuarios finales, ya que el tamaño del archivo se reduce al 5-20 % del tamaño original y un megabyte puede almacenar aproximadamente un minuto de música con la calidad adecuada.

La LPC utiliza un modelo del tracto vocal humano para analizar los sonidos del habla e inferir los parámetros utilizados por el modelo para producirlos momento a momento.

La latencia inherente al algoritmo de codificación puede ser crítica; por ejemplo, cuando hay una transmisión bidireccional de datos, como en una conversación telefónica, los retrasos significativos pueden degradar seriamente la calidad percibida.

Por ello, la voz puede codificarse con alta calidad utilizando una tasa de bits relativamente baja.

En 1973, P. Cummiskey, Nikil S. Jayant y James L. Flanagan introdujeron la DPCM adaptativa (ADPCM).

Veinte años después, casi todas las emisoras de radio del mundo utilizaban una tecnología similar fabricada por varias empresas.

Estos datos suelen contener abundantes cantidades de redundancia espacial y temporal.

La compresión Inter-frame (una codificación delta temporal) (re)utiliza los datos de uno o más fotogramas anteriores o posteriores de una secuencia para describir el fotograma actual.

La codificación intracuadro, por el contrario, utiliza solo datos del cuadro actual, siendo en realidad una compresión de imagen.

Los vídeos muy comprimidos pueden presentar artefactos de compresión visibles o molestos.

[46] H.261 fue desarrollado por varias empresas, entre ellas Hitachi, PictureTel, NTT, BT y Toshiba.

MPEG-1 fue desarrollado por el Motion Picture Experts Group (MPEG) en 1991, y fue diseñado para comprimir vídeo de calidad VHS.

Fue sucedido en 1994 por MPEG-2/H.262,[48] que fue desarrollado por varias empresas, principalmente Sony, Thomson y Mitsubishi Electric.

[50] MPEG-2 se convirtió en el formato de vídeo estándar para DVD y televisión digital SD.

[51] H.264/MPEG-4 AVC fue desarrollado en 2003 por varias organizaciones, principalmente Panasonic, Godo Kaisha IP Bridge y LG Electronics.

[52] AVC introdujo comercialmente los modernos algoritmos de codificación aritmética binaria adaptable al contexto (CABAC) y codificación de longitud variable adaptable al contexto (CAVLC).

Para ello, Chanda, Elhaik y Bader introdujeron la codificación basada en MAF (MAFE), que reduce la heterogeneidad del conjunto de datos clasificando los SNP por su frecuencia alélica menor, homogeneizando así el conjunto de datos.

Al lidiar directamente con grupos se utilizan métodos algebraicos de gran formalidad.

De alguna manera, se trabaja solo con variables e incógnitas pensando siempre en que hay un objeto por detrás, pero sin aferrarse nunca a él.

El ejemplo al que se recurre como demostración suele ser del siguiente tipo: Traducimos una información, un texto, un libro con 100 000 palabras.

Y las restamos n veces, hasta llegar a obtener un número menor que el patrón utilizado.