El test de Turing , llamado originalmente el juego de imitación por Alan Turing en 1949, [2] es una prueba de la capacidad de una máquina para exhibir un comportamiento inteligente equivalente o indistinguible del de un humano. Turing propuso que un evaluador humano juzgaría conversaciones en lenguaje natural entre un humano y una máquina diseñada para generar respuestas similares a las humanas. El evaluador sería consciente de que uno de los dos participantes en la conversación era una máquina, y todos los participantes estarían separados unos de otros. La conversación se limitaría a un canal de solo texto, como un teclado y una pantalla de computadora, por lo que el resultado no dependería de la capacidad de la máquina para traducir palabras como habla. [3] Si el evaluador no pudiera distinguir de manera confiable la máquina del humano, se diría que la máquina había pasado la prueba. Los resultados de la prueba no dependerían de la capacidad de la máquina para dar respuestas correctas a las preguntas , sino solo de qué tan parecidas sus respuestas se asemejarían a las que daría un humano. Dado que la prueba de Turing es una prueba de indistinguibilidad en la capacidad de desempeño, la versión verbal se generaliza naturalmente a toda la capacidad de desempeño humano, tanto verbal como no verbal (robótica). [4]

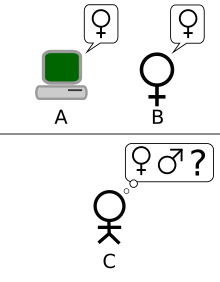

La prueba fue introducida por Turing en su artículo de 1950 " Computing Machinery and Intelligence " mientras trabajaba en la Universidad de Manchester . [5] Comienza con las palabras: "Propongo considerar la pregunta: '¿Pueden pensar las máquinas? ' ". Debido a que "pensar" es difícil de definir, Turing elige "reemplazar la pregunta por otra, que está estrechamente relacionada con ella y se expresa en palabras relativamente inequívocas". [6] Turing describe la nueva forma del problema en términos de un juego de tres personas llamado el "juego de imitación", en el que un interrogador hace preguntas a un hombre y una mujer en otra habitación para determinar el sexo correcto de los dos jugadores. La nueva pregunta de Turing es: "¿Existen computadoras digitales imaginables que se desempeñarían bien en el juego de imitación ?" [2] Esta pregunta, creía Turing, era una que realmente podía responderse. En el resto del artículo, argumentó en contra de todas las principales objeciones a la proposición de que "las máquinas pueden pensar". [7]

Desde que Turing introdujo su prueba, ha sido muy influyente y ampliamente criticada, y se ha convertido en un concepto importante en la filosofía de la inteligencia artificial . [8] [9] [10] El filósofo John Searle comentaría sobre la prueba de Turing en su argumento de la habitación china , un experimento mental que estipula que una máquina no puede tener una " mente ", " entendimiento " o " conciencia ", independientemente de cuán inteligente o similar a lo humano pueda hacer el programa que se comporte la computadora. Searle critica la prueba de Turing y afirma que es insuficiente para detectar la presencia de conciencia.

La prueba de Turing condujo posteriormente al desarrollo de los " chatbots ", entidades de software de IA desarrolladas con el único propósito de realizar sesiones de chat de texto con personas. Ahora, los chatbots tienen una definición más inclusiva: un programa informático que puede mantener una conversación con una persona, generalmente a través de Internet. OED [11] [12]

En 1966, Joseph Weizenbaum creó un programa llamado ELIZA . El programa funcionaba examinando los comentarios escritos por un usuario en busca de palabras clave. Si se encuentra una palabra clave, se aplica una regla que transforma los comentarios del usuario y se devuelve la oración resultante. Si no se encuentra una palabra clave, ELIZA responde con una respuesta genérica o repitiendo uno de los comentarios anteriores. [13] Además, Weizenbaum desarrolló ELIZA para replicar el comportamiento de un psicoterapeuta rogeriano , lo que le permitió a ELIZA ser "libre de asumir la pose de no saber casi nada del mundo real". [14] Con estas técnicas, el programa de Weizenbaum pudo engañar a algunas personas haciéndoles creer que estaban hablando con una persona real, y a algunos sujetos fue "muy difícil convencerlos de que ELIZA [...] no es humano". [14] Por lo tanto, algunos afirman que ELIZA es uno de los programas (quizás el primero) capaz de pasar la prueba de Turing, [14] [15] aunque esta opinión es muy polémica (véase Ingenuidad de los interrogadores más abajo).

Kenneth Colby creó PARRY en 1972, un programa descrito como "ELIZA con actitud". [16] Intentó modelar el comportamiento de un esquizofrénico paranoide , utilizando un enfoque similar (aunque más avanzado) al empleado por Weizenbaum. Para validar el trabajo, PARRY se puso a prueba a principios de la década de 1970 utilizando una variación de la prueba de Turing. Un grupo de psiquiatras experimentados analizó una combinación de pacientes reales y computadoras que ejecutaban PARRY a través de teleimpresoras . A otro grupo de 33 psiquiatras se les mostraron transcripciones de las conversaciones. Luego se pidió a los dos grupos que identificaran cuáles de los "pacientes" eran humanos y cuáles eran programas de computadora. [17] Los psiquiatras pudieron hacer la identificación correcta solo el 52 por ciento de las veces, una cifra consistente con una suposición aleatoria. [17]

En 2001, en San Petersburgo, Rusia , un grupo de tres programadores, el ruso Vladimir Veselov, el ucraniano Eugene Demchenko y el ruso Sergey Ulasen, desarrollaron un chatbot llamado Eugene Goostman . El 7 de julio de 2014, se convirtió en el primer chatbot que pareció pasar la prueba de Turing en un evento en la Universidad de Reading que conmemoraba el 60 aniversario de la muerte de Alan Turing. El treinta y tres por ciento de los jueces del evento pensaron que Goostman era humano; el organizador del evento Kevin Warwick consideró que había pasado la prueba de Turing. Fue retratado como un niño de trece años de Odesa, Ucrania , que tiene un conejillo de indias como mascota y un padre que es ginecólogo . La elección de la edad fue intencional para inducir a las personas que "conversan" con él a perdonar errores gramaticales menores en sus respuestas. [11] [18] [19]

En junio de 2022, el chatbot LaMDA (Language Model for Dialog Applications) de Google recibió una amplia cobertura en relación con las afirmaciones sobre su capacidad de sentir. Inicialmente, en un artículo en The Economist, el investigador de Google Blaise Agüera y Arcas dijo que el chatbot había demostrado un grado de comprensión de las relaciones sociales. [20] Varios días después, el ingeniero de Google Blake Lemoine afirmó en una entrevista con el Washington Post que LaMDA había alcanzado la capacidad de sentir. Lemoine había sido suspendido por Google por afirmaciones internas en este sentido. Agüera y Arcas (vicepresidente de Google) y Jen Gennai (directora de Innovación Responsable) habían investigado las afirmaciones, pero las desestimaron. [21] La afirmación de Lemoine fue rechazada rotundamente por otros expertos en el campo, señalando que un modelo de lenguaje que parezca imitar la conversación humana no indica que haya inteligencia detrás de él, [22] a pesar de parecer pasar la prueba de Turing. El amplio debate entre los defensores y los contrarios a la afirmación de que LaMDA ha alcanzado la sensibilidad ha suscitado debates en las redes sociales, que incluyen la definición del significado de la sensibilidad, así como de lo que significa ser humano.

El chatbot de OpenAI , ChatGPT, lanzado en noviembre de 2022, se basa en los modelos de lenguaje grandes GPT-3.5 y GPT-4 . Celeste Biever escribió en un artículo de Nature que "ChatGPT superó la prueba de Turing". [23] Los investigadores de Stanford informaron que ChatGPT pasa la prueba; descubrieron que ChatGPT-4 "pasa una rigurosa prueba de Turing, desviándose del comportamiento humano promedio principalmente para ser más cooperativo". [24] [25]

Los asistentes virtuales también son agentes de software impulsados por IA diseñados para responder a comandos o preguntas y realizar tareas electrónicamente, ya sea con comandos de texto o verbales, por lo que naturalmente incorporan capacidades de chatbot. Los asistentes virtuales destacados para uso directo del consumidor incluyen Siri de Apple , Alexa de Amazon , Google Assistant , Bixby de Samsung y Copilot de Microsoft . [26] [27] [28] [29]

Existen versiones de estos programas que siguen engañando a la gente. "CyberLover", un programa malicioso , se aprovecha de los usuarios de Internet convenciéndolos de que "revelen información sobre sus identidades o los lleven a visitar un sitio web que enviará contenido malicioso a sus computadoras". [30] El programa ha surgido como un "riesgo de San Valentín" que coquetea con personas "que buscan relaciones en línea para recopilar sus datos personales". [31]

La cuestión de si es posible que las máquinas piensen tiene una larga historia, que está firmemente arraigada en la distinción entre las concepciones dualistas y materialistas de la mente. René Descartes prefigura aspectos de la prueba de Turing en su Discurso del método de 1637 cuando escribe:

[32] ¡Cuántos autómatas o máquinas móviles diferentes podrían ser fabricados por la industria del hombre...! Es fácil comprender que una máquina esté constituida de tal manera que pueda pronunciar palabras e incluso emitir algunas respuestas a una acción de tipo corporal sobre ella, lo que produce un cambio en sus órganos; por ejemplo, si se la toca en una parte particular, puede preguntar qué queremos decirle; si en otra parte puede exclamar que le están haciendo daño, etc. Pero nunca sucede que ordene su habla de diversas maneras, para responder adecuadamente a todo lo que se le diga en su presencia, como puede hacerlo incluso el tipo más bajo de hombre .

En este punto, Descartes señala que los autómatas son capaces de responder a las interacciones humanas, pero sostiene que no pueden responder adecuadamente a las cosas que se dicen en su presencia, como lo haría cualquier ser humano. Por lo tanto, Descartes prefigura el test de Turing al definir la insuficiencia de una respuesta lingüística apropiada como aquello que separa al ser humano del autómata. Descartes no considera la posibilidad de que los autómatas futuros puedan superar esa insuficiencia, y por lo tanto no propone el test de Turing como tal, aunque prefigura su marco conceptual y criterio.

Denis Diderot formula en su libro Pensées philosophiques de 1746 un criterio de prueba de Turing, aunque manteniendo el importante supuesto limitante implícito de que los participantes son seres vivos naturales, en lugar de considerar artefactos creados:

Si encontraran un loro que pudiera responder a todo, diría sin dudarlo que es un ser inteligente.

Esto no quiere decir que esté de acuerdo con ello, sino que ya era un argumento común de los materialistas en aquella época.

Según el dualismo, la mente no es física (o, al menos, tiene propiedades no físicas ) [33] y, por lo tanto, no puede explicarse en términos puramente físicos. Según el materialismo, la mente puede explicarse físicamente, lo que deja abierta la posibilidad de mentes producidas artificialmente. [34]

En 1936, el filósofo Alfred Ayer consideró la pregunta filosófica estándar de las otras mentes : ¿cómo sabemos que otras personas tienen las mismas experiencias conscientes que nosotros? En su libro, Lenguaje, verdad y lógica , Ayer sugirió un protocolo para distinguir entre un hombre consciente y una máquina inconsciente: "El único fundamento que puedo tener para afirmar que un objeto que parece ser consciente no es realmente un ser consciente, sino solo un muñeco o una máquina, es que no satisface una de las pruebas empíricas por las que se determina la presencia o ausencia de conciencia". [35] (Esta sugerencia es muy similar a la prueba de Turing, pero no es seguro que el clásico filosófico popular de Ayer fuera familiar para Turing). En otras palabras, una cosa no es consciente si no pasa la prueba de conciencia.

Una idea rudimentaria de la prueba de Turing aparece en la novela Los viajes de Gulliver de Jonathan Swift de 1726. [36] [37] Cuando Gulliver es llevado ante el rey de los Brobdingnaggianos, el rey piensa al principio que Gulliver podría ser una "pieza de relojería (que en ese país ha alcanzado una gran perfección) ideada por algún artista ingenioso". Incluso cuando escucha a Gulliver hablar, el rey todavía duda de si a Gulliver le enseñaron "un conjunto de palabras" para que "vendiera a un mejor precio". Gulliver dice que sólo después de "hacerme varias otras preguntas y seguir recibiendo respuestas racionales" el rey quedó convencido de que Gulliver no era una máquina. [38]

Las pruebas en las que un humano juzga si una computadora o un extraterrestre es inteligente eran una convención establecida en la ciencia ficción en la década de 1940, y es probable que Turing hubiera estado al tanto de ellas. [39] " Una odisea marciana " (1934) de Stanley G. Weinbaum proporciona un ejemplo de cuán matizadas podían ser dichas pruebas. [39]

Ejemplos anteriores de máquinas o autómatas que intentan hacerse pasar por humanos incluyen el antiguo mito griego de Pigmalión , que crea una escultura de una mujer animada por Afrodita ; la novela de Carlo Collodi Las aventuras de Pinocho , sobre una marioneta que quiere convertirse en un niño de verdad, y la historia de ETA Hoffmann de 1816 " El hombre de arena ", donde el protagonista se enamora de un autómata. En todos estos ejemplos, las personas son engañadas por seres artificiales que, hasta cierto punto, se hacen pasar por humanos. [40]

Los investigadores del Reino Unido habían estado explorando la "inteligencia de las máquinas" durante hasta diez años antes de la fundación del campo de investigación de la inteligencia artificial ( IA ) en 1956. [41] Era un tema común entre los miembros del Ratio Club , un grupo informal de investigadores británicos en cibernética y electrónica que incluía a Alan Turing. [42]

Turing, en particular, había estado manejando el concepto de inteligencia de las máquinas desde al menos 1941 [43] y una de las primeras menciones conocidas de la "inteligencia de la computadora" fue hecha por él en 1947. [44] En el informe de Turing, "Maquinaria Inteligente", [45] investigó "la cuestión de si es o no posible que la maquinaria muestre un comportamiento inteligente" [46] y, como parte de esa investigación, propuso lo que puede considerarse el precursor de sus pruebas posteriores:

No es difícil idear una máquina de papel que juegue una partida de ajedrez no muy mala. [47] Ahora tomemos tres hombres A, B y C como sujetos para el experimento. A y C deben ser jugadores de ajedrez bastante malos, B es el operador que maneja la máquina de papel. ... Se utilizan dos habitaciones con algún arreglo para comunicar los movimientos, y se juega una partida entre C y A o la máquina de papel. C puede encontrar bastante difícil saber a cuál está jugando. [48]

" Computing Machinery and Intelligence " (1950) fue el primer artículo publicado por Turing que se centraba exclusivamente en la inteligencia de las máquinas. Turing comienza el artículo de 1950 con la afirmación: "Propongo considerar la pregunta '¿Pueden pensar las máquinas? ' " [6] Como destaca, el enfoque tradicional para una pregunta de este tipo es comenzar con definiciones , definiendo tanto los términos "máquina" como "pensar". Turing elige no hacerlo; en cambio, reemplaza la pregunta con una nueva, "que está estrechamente relacionada con ella y se expresa en palabras relativamente inequívocas". [6] En esencia, propone cambiar la pregunta de "¿Pueden pensar las máquinas?" a "¿Pueden las máquinas hacer lo que nosotros (como entidades pensantes) podemos hacer?" [49] La ventaja de la nueva pregunta, argumenta Turing, es que traza "una línea bastante nítida entre las capacidades físicas e intelectuales de un hombre". [50]

Para demostrar este enfoque, Turing propone una prueba inspirada en un juego de mesa , conocido como el "juego de la imitación", en el que un hombre y una mujer van a habitaciones separadas y los invitados intentan distinguirlos escribiendo una serie de preguntas y leyendo las respuestas mecanografiadas que se envían de vuelta. En este juego, tanto el hombre como la mujer intentan convencer a los invitados de que son el otro. (Huma Shah sostiene que esta versión del juego para dos humanos fue presentada por Turing solo para presentar al lector la prueba de preguntas y respuestas entre máquina y humano. [51] ) Turing describió su nueva versión del juego de la siguiente manera:

Ahora nos planteamos la pregunta: "¿Qué ocurrirá cuando una máquina asuma el papel de A en este juego?" ¿Se equivocará el interrogador con la misma frecuencia cuando el juego se juega de esta manera que cuando se juega entre un hombre y una mujer? Estas preguntas sustituyen a la pregunta original: "¿Pueden pensar las máquinas?" [50]

Más adelante en el artículo, Turing sugiere una formulación alternativa "equivalente" que implica que un juez conversa únicamente con una computadora y un hombre. [52] Si bien ninguna de estas formulaciones coincide exactamente con la versión de la prueba de Turing que se conoce más generalmente hoy, propuso una tercera en 1952. En esta versión, que Turing discutió en una transmisión de radio de la BBC , un jurado le hace preguntas a una computadora y el papel de la computadora es hacer que una proporción significativa del jurado crea que en realidad es un hombre. [53]

El artículo de Turing consideró nueve objeciones putativas, que incluyen algunos de los principales argumentos contra la inteligencia artificial que se han planteado en los años desde que se publicó el artículo (ver " Maquinaria informática e inteligencia "). [7]

En su artículo de 1980 Minds, Brains, and Programs (Mentes, cerebros y programas), John Searle propuso el experimento mental de la « habitación china » y argumentó que el test de Turing no podía utilizarse para determinar si una máquina podía pensar. Searle señaló que los programas informáticos (como ELIZA) podían pasar el test de Turing simplemente manipulando símbolos que no entendían. Sin comprensión, no podían ser descritos como «pensantes» en el mismo sentido que las personas. Por lo tanto, Searle concluyó que el test de Turing no podía demostrar que las máquinas podían pensar. [54] Al igual que el propio test de Turing, el argumento de Searle ha sido ampliamente criticado [55] y respaldado. [56]

Argumentos como los de Searle y otros que trabajaban en la filosofía de la mente desencadenaron un debate más intenso sobre la naturaleza de la inteligencia, la posibilidad de máquinas con una mente consciente y el valor de la prueba de Turing que continuó durante los años 1980 y 1990. [57]

El Premio Loebner ofrece una plataforma anual para pruebas prácticas de Turing y la primera competencia se celebró en noviembre de 1991. [58] Está patrocinado por Hugh Loebner . El Centro de Estudios del Comportamiento de Cambridge en Massachusetts , Estados Unidos, organizó los premios hasta el concurso de 2003 inclusive. Como lo describió Loebner, una de las razones por las que se creó la competencia es para avanzar en el estado de la investigación de IA, al menos en parte, porque nadie había tomado medidas para implementar la prueba de Turing a pesar de 40 años de discusión al respecto. [59]

El primer concurso del Premio Loebner, celebrado en 1991, dio lugar a un renovado debate sobre la viabilidad del test de Turing y el valor de su aplicación, tanto en la prensa popular [60] como en el mundo académico. [61] El primer concurso lo ganó un programa sin mente y sin inteligencia identificable que consiguió engañar a interrogadores ingenuos para que hicieran una identificación errónea. Esto puso de relieve varias de las deficiencias del test de Turing (que se analizan a continuación): el ganador ganó, al menos en parte, porque era capaz de "imitar los errores de tipeo humanos"; [60] los interrogadores poco sofisticados eran fácilmente engañados; [61] y algunos investigadores de IA han llegado a pensar que el test es simplemente una distracción de una investigación más fructífera. [62]

Los premios de plata (sólo texto) y oro (audio y video) nunca han sido ganados. Sin embargo, el concurso ha otorgado la medalla de bronce cada año al sistema informático que, en opinión de los jueces, muestra el comportamiento conversacional "más humano" entre los presentados ese año. Artificial Linguistic Internet Computer Entity (ALICE) ha ganado el premio de bronce en tres ocasiones en los últimos tiempos (2000, 2001, 2004). Learning AI Jabberwacky ganó en 2005 y 2006.

El Premio Loebner pone a prueba la inteligencia conversacional; los ganadores suelen ser programas chatbot o Entidades Conversacionales Artificiales (ACE) . Las primeras reglas del Premio Loebner restringían las conversaciones: cada participante y cada humano oculto conversaban sobre un solo tema, [63] por lo que los interrogadores estaban restringidos a una línea de preguntas por interacción con la entidad. La regla de conversación restringida se levantó para el Premio Loebner de 1995. La duración de la interacción entre el juez y la entidad ha variado en los Premios Loebner. En Loebner 2003, en la Universidad de Surrey, a cada interrogador se le permitieron cinco minutos para interactuar con una entidad, máquina o humano oculto. Entre 2004 y 2007, el tiempo de interacción permitido en los Premios Loebner fue de más de veinte minutos.

CAPTCHA (Completely Automated Public Turing test to tell Computers and Humans Apart) es uno de los conceptos más antiguos de la Inteligencia Artificial. El sistema CAPTCHA se utiliza habitualmente en Internet para distinguir a los humanos de los robots. También se basa en el test de Turing e implica mostrar letras y números distorsionados. Pide al usuario que identifique las letras y los números y los escriba en un campo, algo que los robots tienen dificultades para hacer. [11] [64]

El reCaptcha es un sistema CAPTCHA propiedad de Google . Tanto el reCaptcha v1 como el v2 solían funcionar pidiendo al usuario que hiciera coincidir imágenes distorsionadas o que identificara letras y números distorsionados. Pero el reCaptcha v3 está diseñado para no interrumpir a los usuarios y se ejecuta automáticamente cuando se cargan páginas o se hace clic en botones. Esta verificación de Captcha "invisible" ocurre en segundo plano y no aparecen desafíos, lo que filtra la mayoría de los bots básicos. [65] [66]

Saul Traiger sostiene que existen al menos tres versiones principales del test de Turing, dos de las cuales se ofrecen en "Computing Machinery and Intelligence" y una que él describe como la "Interpretación estándar". [67] Si bien existe cierto debate sobre si la "Interpretación estándar" es la descrita por Turing o, en cambio, se basa en una lectura errónea de su artículo, estas tres versiones no se consideran equivalentes, [67] y sus fortalezas y debilidades son distintas. [68]

El artículo original de Turing describe un juego de mesa sencillo en el que participan tres jugadores. El jugador A es un hombre, el jugador B es una mujer y el jugador C (que desempeña el papel de interrogador) es de uno u otro sexo. En el juego de imitación, el jugador C no puede ver ni al jugador A ni al jugador B, y sólo puede comunicarse con ellos mediante notas escritas. Al hacer preguntas al jugador A y al jugador B, el jugador C intenta determinar cuál de los dos es el hombre y cuál es la mujer. El papel del jugador A es engañar al interrogador para que tome la decisión equivocada, mientras que el jugador B intenta ayudarlo a tomar la decisión correcta. [8]

Turing entonces pregunta:

“¿Qué ocurrirá cuando una máquina asuma el papel de A en este juego? ¿Se equivocará el interrogador con la misma frecuencia cuando el juego se juega de esta manera que cuando se juega entre un hombre y una mujer?” Estas preguntas sustituyen a la pregunta original: “¿Pueden pensar las máquinas?” [50]

La segunda versión apareció más tarde en el artículo de Turing de 1950. De manera similar a la prueba del juego de imitación original, el papel del jugador A lo desempeña una computadora. Sin embargo, el papel del jugador B lo desempeña un hombre en lugar de una mujer.

Fijemos nuestra atención en un ordenador digital particular, C. ¿Es cierto que modificando este ordenador para que tenga una memoria adecuada, aumentando convenientemente su velocidad de acción y dotándolo de un programa apropiado, se puede hacer que C desempeñe satisfactoriamente el papel de A en el juego de imitación, mientras que el papel de B lo desempeña un hombre? [50]

En esta versión, tanto el jugador A (la computadora) como el jugador B intentan engañar al interrogador para que tome una decisión incorrecta.

La interpretación estándar no está incluida en el artículo original, pero es aceptada y debatida. La interpretación común sostiene que el propósito de la prueba de Turing no es específicamente determinar si una computadora es capaz de engañar a un interrogador para que crea que es un humano, sino más bien si una computadora puede imitar a un humano. [8] Si bien hay cierta controversia sobre si esta interpretación fue la intención de Turing, Sterrett cree que sí [69] y, por lo tanto, confunde la segunda versión con esta, mientras que otros, como Traiger, no lo creen [67] ; sin embargo, esto ha llevado a lo que puede verse como la "interpretación estándar". En esta versión, el jugador A es una computadora y el jugador B una persona de cualquier sexo. El papel del interrogador no es determinar quién es hombre y quién es mujer, sino quién es una computadora y quién es un humano. [70] El problema fundamental con la interpretación estándar es que el interrogador no puede diferenciar quién responde es humano y quién es una máquina. Hay problemas con la duración, pero la interpretación estándar generalmente considera esta limitación como algo que debería ser razonable.

Ha surgido una controversia sobre cuál de las formulaciones alternativas de la prueba pretendía Turing. [69] Sterrett sostiene que se pueden extraer dos pruebas distintas de su artículo de 1950 y que, a pesar de la observación de Turing, no son equivalentes. La prueba que emplea el juego de mesa y compara las frecuencias de éxito se conoce como la "Prueba del juego de imitación original", mientras que la prueba que consiste en un juez humano que conversa con un humano y una máquina se conoce como la "Prueba de Turing estándar", señalando que Sterrett equipara esto con la "interpretación estándar" en lugar de la segunda versión del juego de imitación. Sterrett está de acuerdo en que la prueba de Turing estándar (STT) tiene los problemas que citan sus críticos, pero siente que, en contraste, la prueba del juego de imitación original (prueba OIG) así definida es inmune a muchos de ellos, debido a una diferencia crucial: a diferencia de la STT, no hace de la similitud con el desempeño humano el criterio, aunque emplea el desempeño humano para establecer un criterio para la inteligencia de la máquina. Un hombre puede fallar en la prueba de la OIG, pero se sostiene que es una virtud de una prueba de inteligencia que el fracaso indique una falta de ingenio: la prueba de la OIG requiere el ingenio asociado con la inteligencia y no meramente "la simulación del comportamiento conversacional humano". La estructura general de la prueba de la OIG podría incluso utilizarse con versiones no verbales de juegos de imitación. [71]

Según Huma Shah, el propio Turing estaba preocupado por si una máquina podía pensar y estaba proporcionando un método simple para examinar esto: a través de sesiones de preguntas y respuestas entre humanos y máquinas. [72] Shah sostiene que el juego de imitación que Turing describió podría ponerse en práctica de dos maneras diferentes: a) prueba interrogador-máquina uno a uno, y b) comparación simultánea de una máquina con un humano, ambos interrogados en paralelo por un interrogador. [51]

Otros escritores [73] han interpretado que Turing propone que el juego de imitación en sí mismo es la prueba, sin especificar cómo tener en cuenta la declaración de Turing de que la prueba que propuso utilizando la versión de grupo del juego de imitación se basa en un criterio de frecuencia comparativa de éxito en ese juego de imitación, en lugar de en la capacidad de tener éxito en una ronda del juego.

Algunos autores sostienen que el juego de imitación se entiende mejor a partir de sus aspectos sociales. En su artículo de 1948, Turing se refiere a la inteligencia como un "concepto emocional" y señala que

El grado en que consideramos que algo se comporta de manera inteligente está determinado tanto por nuestro propio estado mental y formación como por las propiedades del objeto en cuestión. Si somos capaces de explicar y predecir su comportamiento o si parece que no hay ningún plan subyacente, tenemos poca tentación de imaginar inteligencia. Por lo tanto, es posible que un hombre considere inteligente un objeto y otro no; el segundo hombre habrá descubierto las reglas de su comportamiento. [74]

Siguiendo esta observación y otras similares dispersas en las publicaciones de Turing, Diane Proudfoot [75] afirma que Turing sostenía un enfoque de dependencia de la respuesta a la inteligencia, según el cual una entidad inteligente (o pensante) es aquella que parece inteligente a un interrogador promedio. Bernardo Gonçalves muestra que, aunque Turing utilizó la retórica de presentar su prueba como una especie de experimento crucial para decidir si se puede decir que las máquinas piensan, [76] la presentación real de su prueba satisface propiedades bien conocidas de los experimentos mentales en la tradición científica moderna de Galileo. [77] Shlomo Danziger [78] promueve una interpretación sociotecnológica, según la cual Turing veía el juego de imitación no como una prueba de inteligencia sino como una aspiración tecnológica, cuya realización probablemente implicaría un cambio en la actitud de la sociedad hacia las máquinas. Según esta lectura, la célebre predicción de 50 años de Turing (que para fines del siglo XX su prueba será aprobada por alguna máquina) en realidad consiste en dos predicciones distinguibles. La primera es una predicción tecnológica:

Creo que dentro de unos cincuenta años será posible programar ordenadores... para hacer que jueguen el juego de la imitación tan bien que un interrogador medio no tendrá más del 70% de posibilidades de hacer la identificación correcta después de cinco minutos de interrogatorio. [79]

La segunda predicción que hace Turing es sociológica:

Creo que a finales del siglo el uso de las palabras y la opinión educada en general habrán cambiado tanto que se podrá hablar de máquinas que piensan sin esperar ser contradicho. [79]

Danziger afirma además que para Turing, la alteración de la actitud de la sociedad hacia la maquinaria es un prerrequisito para la existencia de máquinas inteligentes: Sólo cuando el término "máquina inteligente" deje de ser visto como un oxímoron, la existencia de máquinas inteligentes se volverá lógicamente posible.

Saygin ha sugerido que tal vez el juego original sea una forma de proponer un diseño experimental menos sesgado, ya que oculta la participación de la computadora. [80] El juego de imitación también incluye un "truco social" que no se encuentra en la interpretación estándar, ya que en el juego tanto la computadora como el ser humano deben jugar como si fingieran ser alguien que no son. [81]

Un elemento crucial de cualquier prueba de laboratorio es que debe haber un control. Turing nunca deja claro si el interrogador en sus pruebas es consciente de que uno de los participantes es una computadora. Sólo afirma que el jugador A debe ser reemplazado por una máquina, no que el jugador C debe ser consciente de este reemplazo. [50] Cuando Colby, FD Hilf, S Weber y AD Kramer probaron PARRY, lo hicieron asumiendo que los interrogadores no necesitaban saber que uno o más de los entrevistados eran una computadora durante el interrogatorio. [82] Como Ayse Saygin, Peter Swirski, [83] y otros han destacado, esto hace una gran diferencia en la implementación y el resultado de la prueba. [8] En un estudio experimental que examinó las violaciones de la máxima de Grice utilizando transcripciones de los concursos de Loebner uno a uno (interrogador-interlocutor oculto) para el Premio de IA entre 1994 y 1999, Ayse Saygin encontró diferencias significativas entre las respuestas de los participantes que sabían y no sabían que las computadoras estaban involucradas. [84]

El poder y el atractivo del test de Turing se derivan de su simplicidad. La filosofía de la mente , la psicología y la neurociencia moderna no han sido capaces de proporcionar definiciones de "inteligencia" y "pensamiento" que sean lo suficientemente precisas y generales como para ser aplicadas a las máquinas. Sin esas definiciones, no se pueden responder las preguntas centrales de la filosofía de la inteligencia artificial . El test de Turing, aunque imperfecto, al menos proporciona algo que realmente se puede medir. Como tal, es un intento pragmático de responder a una difícil pregunta filosófica.

El formato de la prueba permite al interrogador dar a la máquina una amplia variedad de tareas intelectuales. Turing escribió que "el método de preguntas y respuestas parece ser adecuado para introducir casi cualquiera de los campos de la actividad humana que deseamos incluir". [85] John Haugeland añade que "entender las palabras no es suficiente; también hay que entender el tema ". [86]

Para pasar una prueba de Turing bien diseñada, la máquina debe usar lenguaje natural , razonar , tener conocimiento y aprender . La prueba se puede ampliar para incluir una entrada de video, así como una "trampilla" a través de la cual se pueden pasar objetos: esto obligaría a la máquina a demostrar un uso hábil de la visión y la robótica bien diseñadas . Juntos, estos representan casi todos los problemas principales que la investigación de inteligencia artificial quisiera resolver. [87]

La prueba de Feigenbaum está diseñada para aprovechar la amplia gama de temas disponibles en una prueba de Turing. Es una forma limitada del juego de preguntas y respuestas de Turing que compara la máquina con las habilidades de expertos en campos específicos, como la literatura o la química .

Como licenciado en matemáticas con honores en Cambridge, se podría haber esperado que Turing propusiera una prueba de inteligencia informática que exigiera conocimientos especializados en algún campo altamente técnico, y por lo tanto anticipando un enfoque más reciente del tema . En cambio, como ya se señaló, la prueba que describió en su influyente artículo de 1950 requiere que la computadora sea capaz de competir con éxito en un juego de sociedad común, y esto mediante un desempeño tan bueno como el hombre típico al responder una serie de preguntas de modo que pueda fingir de manera convincente que es la concursante femenina.

Dado que el dimorfismo sexual humano es uno de los temas más antiguos , está implícito en el escenario anterior que las preguntas a responder no involucrarán ni conocimiento factual especializado ni técnica de procesamiento de información. El desafío para la computadora, más bien, será demostrar empatía por el papel de la mujer y demostrar también una sensibilidad estética característica, cualidades ambas que se exhiben en este fragmento de diálogo que Turing ha imaginado:

Cuando Turing introduce algún conocimiento especializado en uno de sus diálogos imaginarios, el tema no son las matemáticas ni la electrónica, sino la poesía:

Turing demuestra así una vez más su interés por la empatía y la sensibilidad estética como componentes de una inteligencia artificial; y a la luz de una creciente conciencia de la amenaza que supone una IA descontrolada, [88] se ha sugerido [89] que este enfoque tal vez represente una intuición crítica por parte de Turing, es decir, que la inteligencia emocional y estética desempeñará un papel clave en la creación de una " IA amistosa ". Se observa, además, que cualquier inspiración que Turing pueda aportar en esta dirección depende de la preservación de su visión original, es decir, que la promulgación de una "interpretación estándar" del test de Turing -es decir, una que se centre únicamente en una inteligencia discursiva- debe considerarse con cierta cautela.

Turing no afirmó explícitamente que el test de Turing pudiera utilizarse como medida de la " inteligencia " o de cualquier otra cualidad humana. Quería ofrecer una alternativa clara y comprensible a la palabra "pensar", que pudiera utilizar para responder a las críticas sobre la posibilidad de que existieran "máquinas pensantes" y sugerir formas de avanzar en la investigación.

Sin embargo, se ha propuesto el test de Turing como medida de la “capacidad de pensar” o “inteligencia” de una máquina. Esta propuesta ha recibido críticas tanto de filósofos como de científicos informáticos. La interpretación parte del supuesto de que un interrogador puede determinar si una máquina está “pensando” comparando su comportamiento con el comportamiento humano. Se han puesto en tela de juicio todos los elementos de este supuesto: la fiabilidad del juicio del interrogador, el valor de comparar la máquina con un ser humano y el valor de comparar únicamente el comportamiento. Debido a estas y otras consideraciones, algunos investigadores de la IA han cuestionado la relevancia del test para su campo.

En la práctica, los resultados de la prueba pueden ser fácilmente dominados no por la inteligencia de la computadora, sino por las actitudes, la habilidad o la ingenuidad del que la realiza. Numerosos expertos en la materia, incluido el científico cognitivo Gary Marcus , insisten en que la prueba de Turing sólo muestra lo fácil que es engañar a los humanos y no es un indicador de la inteligencia de las máquinas. [90]

Turing no especifica las habilidades y conocimientos precisos requeridos por el interrogador en su descripción de la prueba, pero sí utilizó el término "interrogador promedio": "[el] interrogador promedio no tendría más del 70 por ciento de posibilidades de hacer la identificación correcta después de cinco minutos de interrogatorio". [79]

Los programas de chatbots como ELIZA han engañado repetidamente a personas desprevenidas haciéndoles creer que se están comunicando con seres humanos. En estos casos, los "interrogadores" ni siquiera son conscientes de la posibilidad de que estén interactuando con computadoras. Para parecer humanos con éxito, no es necesario que la máquina tenga inteligencia alguna y solo se requiere un parecido superficial con el comportamiento humano.

Los primeros concursos del Premio Loebner utilizaban interrogadores "poco sofisticados" que eran fácilmente engañados por las máquinas. [61] Desde 2004, los organizadores del Premio Loebner han incluido entre los interrogadores a filósofos, científicos informáticos y periodistas. No obstante, algunos de estos expertos han sido engañados por las máquinas. [91]

Una característica interesante de la prueba de Turing es la frecuencia del efecto confederado , cuando los interrogadores identifican erróneamente a los humanos confederados (probados) como máquinas. Se ha sugerido que lo que los interrogadores esperan como respuestas humanas no es necesariamente típico de los humanos. Como resultado, algunos individuos pueden ser categorizados como máquinas. Esto puede funcionar a favor de una máquina competidora. A los humanos se les instruye a "actuar como ellos mismos", pero a veces sus respuestas son más parecidas a lo que el interrogador espera que diga una máquina. [92] Esto plantea la cuestión de cómo garantizar que los humanos estén motivados para "actuar como humanos".

La prueba de Turing no prueba directamente si el ordenador se comporta de forma inteligente, sino únicamente si se comporta como un ser humano. Como el comportamiento humano y el comportamiento inteligente no son exactamente lo mismo, la prueba puede no medir con precisión la inteligencia de dos maneras:

La prueba de Turing se centra estrictamente en la forma de actuar del sujeto , es decir, en el comportamiento externo de la máquina. En este sentido, adopta un enfoque conductista o funcionalista para el estudio de la mente. El ejemplo de ELIZA sugiere que una máquina que supere la prueba puede ser capaz de simular el comportamiento conversacional humano siguiendo una lista simple (pero extensa) de reglas mecánicas, sin pensar ni tener mente en absoluto.

John Searle ha sostenido que el comportamiento externo no puede utilizarse para determinar si una máquina está "realmente" pensando o simplemente "simulando pensar". [54] Su argumento de la habitación china pretende demostrar que, incluso si la prueba de Turing es una buena definición operativa de la inteligencia, puede no indicar que la máquina tenga una mente , conciencia o intencionalidad . (La intencionalidad es un término filosófico que designa el poder de los pensamientos de "ver" algo).

Turing anticipó esta línea de crítica en su artículo original, [96] escribiendo:

No quiero dar la impresión de que creo que no hay ningún misterio en torno a la conciencia. Existe, por ejemplo, una especie de paradoja relacionada con cualquier intento de localizarla. Pero no creo que sea necesario resolver esos misterios antes de poder responder a la pregunta que nos ocupa en este artículo. [97]

Los investigadores de IA convencionales sostienen que intentar pasar la prueba de Turing es simplemente una distracción de una investigación más fructífera. [62] De hecho, la prueba de Turing no es un foco activo de mucho esfuerzo académico o comercial, como escriben Stuart Russell y Peter Norvig : "Los investigadores de IA han dedicado poca atención a pasar la prueba de Turing". [98] Hay varias razones.

En primer lugar, existen formas más sencillas de probar sus programas. La mayoría de las investigaciones actuales en campos relacionados con la IA se dirigen a objetivos modestos y específicos, como el reconocimiento de objetos o la logística . Para probar la inteligencia de los programas que resuelven estos problemas, los investigadores de la IA simplemente les dan la tarea directamente. Stuart Russell y Peter Norvig sugieren una analogía con la historia de los vuelos : los aviones se prueban por lo bien que vuelan, no comparándolos con pájaros. " Los textos de ingeniería aeronáutica ", escriben, "no definen el objetivo de su campo como 'fabricar máquinas que vuelen tan exactamente como las palomas que puedan engañar a otras palomas ' " . [98]

En segundo lugar, crear simulaciones realistas de seres humanos es un problema difícil de por sí que no necesita ser resuelto para alcanzar los objetivos básicos de la investigación en IA. Los personajes humanos creíbles pueden ser interesantes en una obra de arte, un juego o una interfaz de usuario sofisticada , pero no son parte de la ciencia de crear máquinas inteligentes, es decir, máquinas que resuelvan problemas utilizando la inteligencia.

Turing no pretendía que su idea se utilizara para poner a prueba la inteligencia de los programas; quería proporcionar un ejemplo claro y comprensible que ayudara en el debate sobre la filosofía de la inteligencia artificial . [99] John McCarthy sostiene que no debería sorprendernos que una idea filosófica resulte inútil para aplicaciones prácticas. Observa que es "poco probable que la filosofía de la IA tenga más efecto en la práctica de la investigación de la IA que el que la filosofía de la ciencia en general tiene en la práctica de la ciencia". [100] [101]

Otra objeción bien conocida que se plantea contra el Test de Turing se refiere a su enfoque exclusivo sobre el comportamiento lingüístico (es decir, es sólo un experimento "basado en el lenguaje", mientras que no se ponen a prueba todas las demás facultades cognitivas). Este inconveniente reduce el papel de otras "capacidades inteligentes" específicas de la modalidad que conciernen a los seres humanos y que el psicólogo Howard Gardner, en su " teoría de las inteligencias múltiples ", propone considerar (las capacidades verbales y lingüísticas son sólo una de ellas). [102]

Un aspecto crítico de la prueba de Turing es que una máquina debe delatar su condición de máquina por sus expresiones. El interrogador debe entonces hacer la "identificación correcta" identificando correctamente a la máquina como tal. Sin embargo, si una máquina permanece en silencio durante una conversación, entonces no es posible que el interrogador identifique con precisión la máquina de otra manera que no sea mediante una suposición calculada. [103] Incluso tener en cuenta a un humano paralelo/oculto como parte de la prueba puede no ayudar a la situación, ya que a menudo los humanos pueden ser identificados erróneamente como máquinas. [104]

Al centrarse en imitar a los humanos, en lugar de aumentar o extender las capacidades humanas, el Test de Turing corre el riesgo de dirigir la investigación y la implementación hacia tecnologías que sustituyen a los humanos y, por lo tanto, reducen los salarios y los ingresos de los trabajadores. A medida que pierden poder económico, estos trabajadores también pueden perder poder político, lo que les dificulta cambiar la asignación de riqueza e ingresos. Esto puede atraparlos en un mal equilibrio. Erik Brynjolfsson ha llamado a esto "la trampa de Turing" y ha sostenido que actualmente existen incentivos excesivos para crear máquinas que imiten a los humanos en lugar de aumentarlos.

A lo largo de los años se han planteado numerosas otras versiones de la prueba de Turing, incluidas las expuestas anteriormente.

Una modificación de la prueba de Turing en la que el objetivo de uno o más de los roles se ha invertido entre máquinas y humanos se denomina prueba de Turing inversa. Un ejemplo está implícito en el trabajo del psicoanalista Wilfred Bion , [105] que estaba particularmente fascinado por la "tormenta" que resultaba del encuentro de una mente con otra. En su libro de 2000, [83] entre varios otros puntos originales con respecto a la prueba de Turing, el erudito literario Peter Swirski discutió en detalle la idea de lo que él llamó la prueba de Swirski, esencialmente la prueba de Turing inversa. Señaló que supera la mayoría, si no todas, las objeciones estándar dirigidas a la versión estándar.

Siguiendo esta idea, RD Hinshelwood [106] describió la mente como un "aparato de reconocimiento de mentes". El desafío para la computadora sería poder determinar si estaba interactuando con un humano o con otra computadora. Esta es una extensión de la pregunta original que Turing intentó responder, pero tal vez ofrecería un estándar lo suficientemente alto como para definir una máquina que pudiera "pensar" de una manera que normalmente definimos como característicamente humana.

CAPTCHA es una forma de prueba de Turing inversa. Antes de que se le permita realizar alguna acción en un sitio web, se le presentan al usuario caracteres alfanuméricos en una imagen gráfica distorsionada y se le pide que los escriba. Esto tiene como objetivo evitar que se utilicen sistemas automatizados para abusar del sitio. La razón es que no existe un software lo suficientemente sofisticado como para leer y reproducir la imagen distorsionada con precisión (o no está disponible para el usuario promedio), por lo que es probable que cualquier sistema capaz de hacerlo sea un ser humano.

Poco después de la creación de CAPTCHA, se empezó a desarrollar un software que podía revertir CAPTCHA con cierta precisión analizando patrones en el motor generador. [107] En 2013, los investigadores de Vicarious anunciaron que habían desarrollado un sistema para resolver los desafíos CAPTCHA de Google , Yahoo! y PayPal hasta el 90% del tiempo. [108] En 2014, los ingenieros de Google demostraron un sistema que podía vencer los desafíos CAPTCHA con una precisión del 99,8%. [109] En 2015, Shuman Ghosemajumder , ex zar del fraude de clics de Google, afirmó que había sitios cibercriminales que vencerían los desafíos CAPTCHA por una tarifa, para permitir varias formas de fraude. [110]

Otra variante está motivada por la preocupación de que el procesamiento del lenguaje natural moderno resulte muy exitoso en la generación de textos a partir de un enorme corpus de textos y que, eventualmente, pueda pasar la prueba de Turing simplemente manipulando palabras y oraciones que se hayan utilizado en el entrenamiento inicial del modelo. Dado que el interrogador no tiene una comprensión precisa de los datos de entrenamiento, el modelo podría simplemente devolver oraciones que existen de manera similar en la enorme cantidad de datos de entrenamiento. Por esta razón, Arthur Schwaninger propone una variante de la prueba de Turing que puede distinguir entre sistemas que solo son capaces de usar el lenguaje y sistemas que lo entienden . Propone una prueba en la que la máquina se enfrenta a preguntas filosóficas que no dependen de ningún conocimiento previo y, sin embargo, requieren autorreflexión para ser respondidas adecuadamente. [111]

Otra variante se conoce como la prueba de Turing del experto en la materia , en la que la respuesta de una máquina no se puede distinguir de la de un experto en un campo determinado. Esta prueba también se conoce como "prueba de Feigenbaum" y fue propuesta por Edward Feigenbaum en un artículo de 2003. [112]

Robert French (1990) sostiene que un interrogador puede distinguir entre interlocutores humanos y no humanos al plantear preguntas que revelen los procesos de bajo nivel (es decir, inconscientes) de la cognición humana, tal como los estudia la ciencia cognitiva . Tales preguntas revelan los detalles precisos de la materialización humana del pensamiento y pueden desenmascarar a una computadora a menos que experimente el mundo como lo hacen los humanos. [113]

La variante del test de Turing, "Total Turing test" [4] , propuesta por el científico cognitivo Stevan Harnad [114], añade dos requisitos más al test de Turing tradicional. El interrogador también puede poner a prueba las capacidades perceptivas del sujeto (requiriendo visión por ordenador ) y la capacidad del sujeto para manipular objetos (requiriendo robótica ). [115]

Una carta publicada en Communications of the ACM [116] describe el concepto de generar una población de pacientes sintéticos y propone una variación de la prueba de Turing para evaluar la diferencia entre pacientes sintéticos y reales. La carta afirma: "En el contexto de la historia clínica electrónica, aunque un médico humano puede distinguir fácilmente entre pacientes humanos reales y generados sintéticamente, ¿podría dotarse a una máquina de la inteligencia necesaria para tomar esa determinación por sí sola?" y añade: "Antes de que las identidades sintéticas de los pacientes se conviertan en un problema de salud pública, el mercado legítimo de la historia clínica electrónica podría beneficiarse de la aplicación de técnicas similares a la prueba de Turing para garantizar una mayor fiabilidad de los datos y un mayor valor diagnóstico. Por tanto, cualquier técnica nueva debe tener en cuenta la heterogeneidad de los pacientes y es probable que tenga una complejidad mayor que la que puede evaluar la prueba de ciencias de octavo grado de Allen".

La prueba de la señal de inteligencia mínima fue propuesta por Chris McKinstry como "la abstracción máxima de la prueba de Turing", [117] en la que sólo se permiten respuestas binarias (verdadero/falso o sí/no), para centrarse únicamente en la capacidad de pensamiento. Elimina los problemas del chat de texto como el sesgo antropomorfista y no requiere la emulación de la conducta humana no inteligente, lo que permite sistemas que superan la inteligencia humana. Sin embargo, las preguntas deben ser independientes, lo que la hace más parecida a una prueba de CI que a un interrogatorio. Se utiliza normalmente para recopilar datos estadísticos con los que se puede medir el rendimiento de los programas de inteligencia artificial. [118]

Los organizadores del Premio Hutter creen que comprimir texto en lenguaje natural es un problema de inteligencia artificial difícil, equivalente a aprobar el test de Turing.

La prueba de compresión de datos tiene algunas ventajas sobre la mayoría de las versiones y variaciones de una prueba de Turing, entre ellas:

Las principales desventajas de utilizar la compresión de datos como prueba son:

Un enfoque relacionado con el premio de Hutter que apareció mucho antes, a fines de la década de 1990, es la inclusión de problemas de compresión en una prueba de Turing extendida. [119] o mediante pruebas que se derivan completamente de la complejidad de Kolmogorov . [120] Otras pruebas relacionadas en esta línea son presentadas por Hernández-Orallo y Dowe. [121]

El CI algorítmico, o AIQ para abreviar, es un intento de convertir la Medida de Inteligencia Universal teórica de Legg y Hutter (basada en la inferencia inductiva de Solomonoff ) en una prueba práctica funcional de la inteligencia de las máquinas. [122]

Dos ventajas importantes de algunas de estas pruebas son su aplicabilidad a inteligencias no humanas y la ausencia de requisito de evaluadores humanos.

La prueba de Turing inspiró la prueba de Ebert propuesta en 2011 por el crítico de cine Roger Ebert, que es una prueba para determinar si una voz sintetizada por computadora tiene suficiente habilidad en términos de entonaciones, inflexiones, ritmo, etc., para hacer reír a la gente. [123]

Aprovechando los modelos de lenguaje de gran tamaño , en 2023 la empresa de investigación AI21 Labs creó un experimento social en línea titulado "¿Humano o no?". [124] [125] Fue jugado más de 10 millones de veces por más de 2 millones de personas. [126] Es el mayor experimento de estilo Turing hasta esa fecha. Los resultados mostraron que el 32% de las personas no podían distinguir entre humanos y máquinas. [127] [128]

En 1990 se cumplió el cuadragésimo aniversario de la primera publicación del artículo de Turing "Computing Machinery and Intelligence" y se produjo un renovado interés por el test. Ese año se produjeron dos acontecimientos importantes: el primero fue el Coloquio de Turing, que se celebró en la Universidad de Sussex en abril y reunió a académicos e investigadores de una amplia variedad de disciplinas para debatir el test de Turing en términos de su pasado, presente y futuro; el segundo fue la creación del concurso anual del Premio Loebner .

Blay Whitby enumera cuatro puntos de inflexión importantes en la historia de la prueba de Turing: la publicación de "Computing Machinery and Intelligence" en 1950, el anuncio de ELIZA de Joseph Weizenbaum en 1966, la creación de PARRY por Kenneth Colby , que se describió por primera vez en 1972, y el Coloquio de Turing en 1990. [129]

En paralelo al Premio Loebner de 2008 celebrado en la Universidad de Reading , [130] la Sociedad para el Estudio de la Inteligencia Artificial y la Simulación del Comportamiento (AISB) organizó un simposio de un día para discutir el test de Turing, organizado por John Barnden, Mark Bishop , Huma Shah y Kevin Warwick . [131] Entre los oradores se encontraban la directora de la Royal Institution, la baronesa Susan Greenfield , Selmer Bringsjord , el biógrafo de Turing , Andrew Hodges , y el científico de la conciencia Owen Holland . No surgió ningún acuerdo para un test de Turing canónico, aunque Bringsjord expresó que un premio considerable daría como resultado que el test de Turing se aprobara antes.

Como hombre homosexual que pasó casi toda su vida en el armario, Turing debe haber sido muy consciente de la dificultad social de falsificar constantemente su verdadera identidad. Y hay una deliciosa ironía en el hecho de que durante décadas los científicos de IA hayan optado por ignorar la prueba de manipulación de género de Turing, solo para que tres mujeres en edad universitaria se apropiaran de ella.. (Versión completa archivada el 23 de marzo de 2019 en Wayback Machine ).

Lo llama la "prueba de Ebert", en honor al estándar de inteligencia artificial de Turing...