La bioestadística (también conocida como biometría ) es una rama de la estadística que aplica métodos estadísticos a una amplia gama de temas de biología . Abarca el diseño de experimentos biológicos , la recopilación y el análisis de datos de esos experimentos y la interpretación de los resultados.

El modelado bioestadístico forma una parte importante de numerosas teorías biológicas modernas. Los estudios genéticos , desde sus inicios, utilizaron conceptos estadísticos para comprender los resultados experimentales observados. Algunos científicos genéticos incluso contribuyeron con avances estadísticos con el desarrollo de métodos y herramientas. Gregor Mendel inició los estudios genéticos investigando patrones de segregación genética en familias de guisantes y utilizó estadísticas para explicar los datos recopilados. A principios de la década de 1900, después del redescubrimiento del trabajo de herencia mendeliana de Mendel, existían brechas en la comprensión entre la genética y el darwinismo evolutivo. Francis Galton intentó expandir los descubrimientos de Mendel con datos humanos y propuso un modelo diferente con fracciones de la herencia provenientes de cada ancestro que componen una serie infinita. Llamó a esto la teoría de la " Ley de la Herencia Ancestral ". Sus ideas fueron fuertemente rechazadas por William Bateson , quien siguió las conclusiones de Mendel, de que la herencia genética provenía exclusivamente de los padres, la mitad de cada uno de ellos. Esto dio lugar a un intenso debate entre los biometristas, que apoyaban las ideas de Galton, como Raphael Weldon , Arthur Dukinfield Darbishire y Karl Pearson , y los mendelianos, que apoyaban las ideas de Bateson (y de Mendel), como Charles Davenport y Wilhelm Johannsen . Más tarde, los biometristas no pudieron reproducir las conclusiones de Galton en diferentes experimentos, y prevalecieron las ideas de Mendel. En la década de 1930, los modelos basados en el razonamiento estadístico habían ayudado a resolver estas diferencias y a producir la síntesis evolutiva moderna neodarwinista .

La solución de estas diferencias permitió también definir el concepto de genética de poblaciones y unificar la genética y la evolución. Las tres figuras principales que establecieron la genética de poblaciones y esta síntesis se basaron en la estadística y desarrollaron su uso en biología.

Estos y otros bioestadísticos, biólogos matemáticos y genetistas con inclinaciones estadísticas ayudaron a reunir la biología evolutiva y la genética en un todo consistente y coherente que pudiera comenzar a ser modelado cuantitativamente .

Paralelamente a este desarrollo general, el trabajo pionero de D'Arcy Thompson en On Growth and Form también ayudó a añadir disciplina cuantitativa al estudio biológico.

A pesar de la importancia fundamental y la frecuente necesidad del razonamiento estadístico, puede que haya existido una tendencia entre los biólogos a desconfiar o desaprobar los resultados que no son cualitativamente evidentes. Una anécdota describe a Thomas Hunt Morgan prohibiendo la calculadora Friden en su departamento en Caltech , diciendo: "Bueno, soy como un tipo que está buscando oro a lo largo de las orillas del río Sacramento en 1849. Con un poco de inteligencia, puedo agacharme y recoger grandes pepitas de oro. Y mientras pueda hacer eso, no voy a permitir que ninguna persona en mi departamento desperdicie recursos escasos en la minería de placer ". [3]

Toda investigación en ciencias de la vida se propone responder a una pregunta científica que podamos tener. Para responder a esta pregunta con un alto grado de certeza, necesitamos resultados precisos . La definición correcta de la hipótesis principal y el plan de investigación reducirán los errores al tomar una decisión para comprender un fenómeno. El plan de investigación puede incluir la pregunta de investigación, la hipótesis que se va a probar, el diseño experimental , los métodos de recopilación de datos , las perspectivas de análisis de datos y los costos involucrados. Es esencial llevar a cabo el estudio basándose en los tres principios básicos de la estadística experimental: aleatorización , replicación y control local.

La pregunta de investigación definirá el objetivo de un estudio. La investigación estará encabezada por la pregunta, por lo que debe ser concisa, al mismo tiempo que se centra en temas interesantes y novedosos que puedan mejorar la ciencia y el conocimiento en ese campo. Para definir la forma de plantear la pregunta científica , puede ser necesaria una revisión exhaustiva de la literatura . De esta manera, la investigación puede ser útil para agregar valor a la comunidad científica . [4]

Una vez definido el objetivo del estudio, se pueden proponer las posibles respuestas a la pregunta de investigación, transformando esta pregunta en una hipótesis . La propuesta principal se llama hipótesis nula (H 0 ) y generalmente se basa en un conocimiento permanente sobre el tema o una ocurrencia obvia de los fenómenos, sustentada por una revisión profunda de la literatura. Podemos decir que es la respuesta estándar esperada para los datos bajo la situación en prueba . En general, H O no asume asociación entre tratamientos. Por otro lado, la hipótesis alternativa es la negación de H O . Supone algún grado de asociación entre el tratamiento y el resultado. Aunque, la hipótesis está sustentada por la pregunta de investigación y sus respuestas esperadas e inesperadas. [4]

Como ejemplo, consideremos grupos de animales similares (ratones, por ejemplo) bajo dos sistemas de dieta diferentes. La pregunta de investigación sería: ¿cuál es la mejor dieta? En este caso, H 0 sería que no hay diferencia entre las dos dietas en el metabolismo de los ratones (H 0 : μ 1 = μ 2 ) y la hipótesis alternativa sería que las dietas tienen diferentes efectos sobre el metabolismo de los animales (H 1 : μ 1 ≠ μ 2 ).

La hipótesis la define el investigador, de acuerdo con sus intereses en responder a la pregunta principal. Además, la hipótesis alternativa puede ser más de una hipótesis. Puede suponer no solo diferencias entre los parámetros observados, sino también su grado de diferencia ( es decir , mayor o menor).

Por lo general, un estudio tiene como objetivo comprender el efecto de un fenómeno sobre una población . En biología , una población se define como todos los individuos de una especie dada , en un área específica en un momento dado. En bioestadística, este concepto se extiende a una variedad de colecciones posibles de estudio. Aunque, en bioestadística, una población no son solo los individuos, sino el total de un componente específico de sus organismos , como todo el genoma , o todos los espermatozoides , para los animales, o el área foliar total, para una planta, por ejemplo.

No es posible tomar medidas de todos los elementos de una población . Por ello, el proceso de muestreo es muy importante para la inferencia estadística . El muestreo se define como la obtención aleatoria de una parte representativa de toda la población, para realizar inferencias posteriores sobre la población. Por tanto, la muestra puede captar la mayor variabilidad en una población. [5] El tamaño de la muestra está determinado por varios factores, desde el alcance de la investigación hasta los recursos disponibles. En la investigación clínica , el tipo de ensayo, como la inferioridad , la equivalencia y la superioridad, son claves para determinar el tamaño de la muestra . [4]

Los diseños experimentales sustentan esos principios básicos de la estadística experimental . Hay tres diseños experimentales básicos para asignar aleatoriamente los tratamientos en todas las parcelas del experimento . Son el diseño completamente aleatorizado , el diseño de bloques aleatorizados y los diseños factoriales . Los tratamientos se pueden organizar de muchas maneras dentro del experimento. En agricultura , el diseño experimental correcto es la raíz de un buen estudio y la disposición de los tratamientos dentro del estudio es esencial porque el medio ambiente afecta en gran medida a las parcelas ( plantas , ganado , microorganismos ). Estos arreglos principales se pueden encontrar en la literatura bajo los nombres de " enrejados ", "bloques incompletos", " parcela dividida ", "bloques aumentados" y muchos otros. Todos los diseños pueden incluir parcelas de control , determinadas por el investigador, para proporcionar una estimación de error durante la inferencia .

En los estudios clínicos , las muestras suelen ser más pequeñas que en otros estudios biológicos y, en la mayoría de los casos, el efecto del entorno se puede controlar o medir. Es habitual utilizar ensayos clínicos controlados aleatorizados , donde los resultados suelen compararse con diseños de estudios observacionales como los de casos y controles o de cohortes . [6]

Los métodos de recolección de datos deben considerarse en la planificación de la investigación, porque influyen en gran medida en el tamaño de la muestra y el diseño experimental.

La recolección de datos varía según el tipo de datos. Para los datos cualitativos , la recolección se puede realizar con cuestionarios estructurados o por observación, considerando la presencia o intensidad de la enfermedad, utilizando el criterio de puntuación para categorizar los niveles de ocurrencia. [7] Para los datos cuantitativos , la recolección se realiza midiendo la información numérica utilizando instrumentos.

En los estudios de agricultura y biología, los datos de rendimiento y sus componentes pueden obtenerse mediante medidas métricas . Sin embargo, los daños causados por plagas y enfermedades en las parcelas se obtienen mediante observación, considerando escalas de puntuación para los niveles de daño. Especialmente, en los estudios genéticos, se deben considerar los métodos modernos para la recopilación de datos en campo y laboratorio, como plataformas de alto rendimiento para la fenotipificación y genotipificación. Estas herramientas permiten experimentos más grandes, al tiempo que permiten evaluar muchas parcelas en menos tiempo que un método de recopilación de datos basado únicamente en humanos. Finalmente, todos los datos recopilados de interés deben almacenarse en un marco de datos organizado para su posterior análisis.

Los datos se pueden representar mediante tablas o representaciones gráficas , como gráficos de líneas, gráficos de barras, histogramas y diagramas de dispersión. Además, las medidas de tendencia central y variabilidad pueden ser muy útiles para describir una visión general de los datos. A continuación, se muestran algunos ejemplos:

Un tipo de tabla es la tabla de frecuencias , que consta de datos dispuestos en filas y columnas, donde la frecuencia es el número de ocurrencias o repeticiones de los datos. La frecuencia puede ser: [8]

Absoluto : representa el número de veces que aparece un valor determinado;

Relativa : se obtiene dividiendo la frecuencia absoluta por el número total;

En el siguiente ejemplo, tenemos el número de genes en diez operones del mismo organismo.

Los gráficos de líneas representan la variación de un valor a lo largo de otra métrica, como el tiempo. En general, los valores se representan en el eje vertical, mientras que la variación temporal se representa en el eje horizontal. [10]

Un gráfico de barras es un gráfico que muestra datos categóricos como barras que presentan alturas (barra vertical) o anchos (barra horizontal) proporcionales para representar valores. Los gráficos de barras proporcionan una imagen que también se puede representar en formato tabular. [10]

En el ejemplo del gráfico de barras, tenemos la tasa de natalidad en Brasil para los meses de diciembre de 2010 a 2016. [9] La fuerte caída en diciembre de 2016 refleja el brote del virus Zika en la tasa de natalidad en Brasil.

El histograma (o distribución de frecuencias) es una representación gráfica de un conjunto de datos tabulados y divididos en clases uniformes o no uniformes. Fue introducido por primera vez por Karl Pearson . [11]

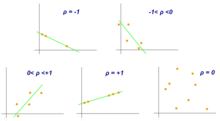

Un diagrama de dispersión es un diagrama matemático que utiliza coordenadas cartesianas para mostrar los valores de un conjunto de datos. Un diagrama de dispersión muestra los datos como un conjunto de puntos, cada uno de los cuales presenta el valor de una variable que determina la posición en el eje horizontal y otra variable en el eje vertical. [12] También se les llama gráfico de dispersión , diagrama de dispersión , diagrama de dispersión o diagrama de dispersión . [13]

La media aritmética es la suma de una colección de valores ( ) dividida por el número de elementos de esta colección ( ).

La mediana es el valor en el medio de un conjunto de datos.

La moda es el valor de un conjunto de datos que aparece con mayor frecuencia. [14]

El diagrama de caja es un método para representar gráficamente grupos de datos numéricos. Los valores máximos y mínimos se representan mediante líneas, y el rango intercuartil (RIC) representa entre el 25 y el 75 % de los datos. Los valores atípicos se pueden representar como círculos.

Aunque las correlaciones entre dos tipos diferentes de datos se pueden inferir mediante gráficos, como un diagrama de dispersión, es necesario validarlas mediante información numérica. Por este motivo, se requieren coeficientes de correlación , que proporcionan un valor numérico que refleja la fuerza de una asociación. [10]

El coeficiente de correlación de Pearson es una medida de asociación entre dos variables, X e Y. Este coeficiente, generalmente representado por ρ (rho) para la población y r para la muestra, asume valores entre −1 y 1, donde ρ = 1 representa una correlación positiva perfecta, ρ = −1 representa una correlación negativa perfecta y ρ = 0 no es correlación lineal. [10]

Se utiliza para realizar inferencias [15] sobre una población desconocida, mediante estimación y/o prueba de hipótesis. En otras palabras, es deseable obtener parámetros para describir la población de interés, pero como los datos son limitados, es necesario hacer uso de una muestra representativa para estimarlos. Con ello, es posible probar hipótesis previamente definidas y aplicar las conclusiones a toda la población. El error estándar de la media es una medida de variabilidad que resulta crucial para realizar inferencias. [5]

La prueba de hipótesis es esencial para realizar inferencias sobre poblaciones con el objetivo de responder a las preguntas de investigación, tal como se establece en el apartado “Planificación de la investigación”. Los autores definen cuatro pasos a seguir: [5]

Un intervalo de confianza es un rango de valores que puede contener el valor real de un parámetro dado un cierto nivel de confianza. El primer paso es estimar la mejor estimación insesgada del parámetro de la población. El valor superior del intervalo se obtiene sumando esta estimación con la multiplicación entre el error estándar de la media y el nivel de confianza. El cálculo del valor inferior es similar, pero en lugar de una suma, se debe aplicar una resta. [5]

Al probar una hipótesis, hay dos tipos de errores estadísticos posibles: error tipo I y error tipo II .

El nivel de significancia denotado por α es la tasa de error de tipo I y debe elegirse antes de realizar la prueba. La tasa de error de tipo II se denota por β y la potencia estadística de la prueba es 1 − β.

El valor p es la probabilidad de obtener resultados tan extremos como los observados o más extremos que ellos, suponiendo que la hipótesis nula (H 0 ) es verdadera. También se le llama probabilidad calculada. Es común confundir el valor p con el nivel de significancia (α) , pero, el α es un umbral predefinido para considerar resultados significativos. Si p es menor que α, la hipótesis nula (H 0 ) es rechazada. [16]

En múltiples pruebas de la misma hipótesis, la probabilidad de ocurrencia de falsos positivos (tasa de error por familia) aumenta y se utiliza alguna estrategia para controlar esta ocurrencia. Esto se logra comúnmente utilizando un umbral más estricto para rechazar hipótesis nulas. La corrección de Bonferroni define un nivel de significación global aceptable, denotado por α* y cada prueba se compara individualmente con un valor de α = α*/m. Esto asegura que la tasa de error por familia en todas las m pruebas, sea menor o igual a α*. Cuando m es grande, la corrección de Bonferroni puede ser demasiado conservadora. Una alternativa a la corrección de Bonferroni es controlar la tasa de falsos descubrimientos (FDR) . La FDR controla la proporción esperada de hipótesis nulas rechazadas (los llamados descubrimientos) que son falsas (rechazos incorrectos). Este procedimiento asegura que, para pruebas independientes, la tasa de falsos descubrimientos sea como máximo q*. Por lo tanto, la FDR es menos conservadora que la corrección de Bonferroni y tiene más poder, a costa de más falsos positivos. [17]

La hipótesis principal que se está probando (por ejemplo, no hay asociación entre tratamientos y resultados) a menudo está acompañada por otros supuestos técnicos (por ejemplo, sobre la forma de la distribución de probabilidad de los resultados) que también son parte de la hipótesis nula. Cuando los supuestos técnicos se violan en la práctica, entonces la hipótesis nula puede ser rechazada con frecuencia incluso si la hipótesis principal es verdadera. Se dice que tales rechazos se deben a una especificación incorrecta del modelo. [18] Verificar si el resultado de una prueba estadística no cambia cuando los supuestos técnicos se alteran ligeramente (los llamados controles de robustez) es la principal forma de combatir la especificación incorrecta.

La selección de criterios de modelo seleccionará o modelará el modelo verdadero más aproximado. El criterio de información de Akaike (AIC) y el criterio de información bayesiano (BIC) son ejemplos de criterios asintóticamente eficientes.

Los últimos avances han tenido un gran impacto en la bioestadística. Dos cambios importantes han sido la capacidad de recopilar datos a gran escala y la capacidad de realizar análisis mucho más complejos utilizando técnicas computacionales. Esto se debe al desarrollo en áreas como las tecnologías de secuenciación , la bioinformática y el aprendizaje automático ( Machine learning in bioinformatics ).

Las nuevas tecnologías biomédicas, como los microarrays , los secuenciadores de última generación (para la genómica) y la espectrometría de masas (para la proteómica), generan enormes cantidades de datos, lo que permite realizar muchas pruebas simultáneamente. [19] Se requiere un análisis cuidadoso con métodos bioestadísticos para separar la señal del ruido. Por ejemplo, un microarray podría utilizarse para medir muchos miles de genes simultáneamente, determinando cuáles de ellos tienen una expresión diferente en las células enfermas en comparación con las células normales. Sin embargo, solo una fracción de los genes se expresarán de forma diferencial. [20]

La multicolinealidad se produce a menudo en entornos bioestadísticos de alto rendimiento. Debido a la alta intercorrelación entre los predictores (como los niveles de expresión genética ), la información de un predictor puede estar contenida en otro. Podría ser que solo el 5% de los predictores sean responsables del 90% de la variabilidad de la respuesta. En tal caso, se podría aplicar la técnica bioestadística de reducción de dimensión (por ejemplo, mediante el análisis de componentes principales). Las técnicas estadísticas clásicas como la regresión lineal o logística y el análisis discriminante lineal no funcionan bien para datos de alta dimensión (es decir, cuando el número de observaciones n es menor que el número de características o predictores p: n < p). De hecho, se pueden obtener valores R 2 bastante altos a pesar del poder predictivo muy bajo del modelo estadístico. Estas técnicas estadísticas clásicas (en especial, la regresión lineal de mínimos cuadrados ) se desarrollaron para datos de baja dimensión (es decir, donde el número de observaciones n es mucho mayor que el número de predictores p: n >> p). En casos de alta dimensionalidad, siempre se debe considerar un conjunto de pruebas de validación independiente y la suma residual de cuadrados (RSS) y R 2 correspondientes del conjunto de pruebas de validación, no los del conjunto de entrenamiento.

A menudo, resulta útil agrupar la información de varios predictores. Por ejemplo, el análisis de enriquecimiento de conjuntos de genes (GSEA) considera la perturbación de conjuntos de genes completos (funcionalmente relacionados) en lugar de genes individuales. [21] Estos conjuntos de genes pueden ser vías bioquímicas conocidas o genes funcionalmente relacionados. La ventaja de este enfoque es que es más robusto: es más probable que se descubra que un solo gen está falsamente perturbado que que una vía completa esté falsamente perturbada. Además, se puede integrar el conocimiento acumulado sobre las vías bioquímicas (como la vía de señalización JAK-STAT ) utilizando este enfoque.

El desarrollo de bases de datos biológicas permite el almacenamiento y la gestión de datos biológicos con la posibilidad de garantizar el acceso a usuarios de todo el mundo. Son útiles para los investigadores que depositan datos, recuperan información y archivos (en bruto o procesados) originados a partir de otros experimentos o indexan artículos científicos, como PubMed . Otra posibilidad es buscar el término deseado (un gen, una proteína, una enfermedad, un organismo, etc.) y consultar todos los resultados relacionados con esta búsqueda. Existen bases de datos dedicadas a los SNP ( dbSNP ), al conocimiento sobre la caracterización de los genes y sus vías ( KEGG ) y a la descripción de la función de los genes clasificándolos por componente celular, función molecular y proceso biológico ( Gene Ontology ). [22] Además de las bases de datos que contienen información molecular específica, existen otras que son amplias en el sentido de que almacenan información sobre un organismo o grupo de organismos. Como ejemplo de una base de datos dirigida a un solo organismo, pero que contiene muchos datos sobre él, está la base de datos genética y molecular de Arabidopsis thaliana – TAIR. [23] Phytozome, [24] a su vez, almacena los ensamblajes y archivos de anotación de docenas de genomas de plantas, conteniendo también herramientas de visualización y análisis. Además, existe una interconexión entre algunas bases de datos en el intercambio/compartición de información y una iniciativa importante fue la International Nucleotide Sequence Database Collaboration (INSDC) [25] que relaciona datos de DDBJ, [26] EMBL-EBI, [27] y NCBI. [28]

En la actualidad, el aumento en el tamaño y la complejidad de los conjuntos de datos moleculares conduce al uso de métodos estadísticos poderosos proporcionados por algoritmos de ciencias de la computación desarrollados por el área de aprendizaje automático . Por lo tanto, la minería de datos y el aprendizaje automático permiten la detección de patrones en datos con una estructura compleja, como los biológicos, mediante el uso de métodos de aprendizaje supervisado y no supervisado , regresión, detección de clústeres y minería de reglas de asociación , entre otros. [22] Para indicar algunos de ellos, los mapas autoorganizados y k -medias son ejemplos de algoritmos de clúster; la implementación de redes neuronales y los modelos de máquinas de vectores de soporte son ejemplos de algoritmos de aprendizaje automático comunes.

El trabajo colaborativo entre biólogos moleculares, bioinformáticos, estadísticos y científicos informáticos es importante para realizar un experimento correctamente, desde la planificación, pasando por la generación y análisis de datos, y terminando con la interpretación biológica de los resultados. [22]

Por otra parte, el advenimiento de la tecnología informática moderna y de recursos informáticos relativamente baratos han hecho posible el uso de métodos bioestadísticos de uso intensivo de la computadora, como los métodos de bootstrap y de remuestreo.

En los últimos tiempos, los bosques aleatorios han ganado popularidad como método para realizar la clasificación estadística . Las técnicas de bosques aleatorios generan un panel de árboles de decisión. Los árboles de decisión tienen la ventaja de que se pueden dibujar e interpretar (incluso con un conocimiento básico de matemáticas y estadística). Por ello, los bosques aleatorios se han utilizado para sistemas de apoyo a la toma de decisiones clínicas. [ cita requerida ]

Salud pública , que incluye epidemiología , investigación en servicios de salud , nutrición , salud ambiental y políticas y gestión de la atención sanitaria. En estos contenidos de medicina , es importante considerar el diseño y análisis de los ensayos clínicos . Como ejemplo, está la evaluación del estado de gravedad de un paciente con un pronóstico del resultado de una enfermedad.

Con las nuevas tecnologías y el conocimiento genético, la bioestadística se utiliza ahora también para la medicina de sistemas , que consiste en una medicina más personalizada. Para ello, se realiza una integración de datos de diferentes fuentes, incluidos datos convencionales de pacientes, parámetros clínico-patológicos, datos moleculares y genéticos, así como datos generados por tecnologías adicionales de nueva ómica. [29]

Estudio de la genética de poblaciones y la genética estadística con el fin de vincular la variación en el genotipo con una variación en el fenotipo . En otras palabras, es deseable descubrir la base genética de un rasgo medible, un rasgo cuantitativo, que está bajo control poligénico. Una región del genoma que es responsable de un rasgo continuo se llama locus de rasgo cuantitativo (QTL). El estudio de los QTL se hace posible mediante el uso de marcadores moleculares y la medición de rasgos en poblaciones, pero su mapeo necesita la obtención de una población a partir de un cruce experimental, como una F2 o cepas /líneas endogámicas recombinantes (RIL). Para escanear regiones de QTL en un genoma, se debe construir un mapa genético basado en el ligamiento. Algunos de los algoritmos de mapeo de QTL más conocidos son el mapeo de intervalos, el mapeo de intervalos compuestos y el mapeo de intervalos múltiples. [30]

Sin embargo, la resolución del mapeo de QTL se ve afectada por la cantidad de recombinación ensayada, un problema para las especies en las que es difícil obtener una gran descendencia. Además, la diversidad de alelos está restringida a individuos originados de padres contrastantes, lo que limita los estudios de diversidad de alelos cuando tenemos un panel de individuos que representan una población natural. [31] Por esta razón, se propuso el estudio de asociación de todo el genoma para identificar QTL basados en el desequilibrio de ligamiento , es decir, la asociación no aleatoria entre rasgos y marcadores moleculares. Esto fue impulsado por el desarrollo de la genotipificación de SNP de alto rendimiento . [32]

En el mejoramiento animal y vegetal , el uso de marcadores en la selección con fines de mejoramiento, principalmente los moleculares, colaboró con el desarrollo de la selección asistida por marcadores . Mientras que el mapeo de QTL es limitado debido a la resolución, los GWAS no tienen suficiente poder cuando variantes raras de pequeño efecto que también están influenciadas por el ambiente. Entonces, el concepto de Selección Genómica (GS) surge con el fin de utilizar todos los marcadores moleculares en la selección y permitir la predicción del desempeño de los candidatos en esta selección. La propuesta es genotipar y fenotipar una población de entrenamiento, desarrollar un modelo que pueda obtener los valores genéticos estimados genómicamente (GEBVs) de individuos pertenecientes a una población de genotipo pero no de fenotipo, llamada población de prueba. [33] Este tipo de estudio también podría incluir una población de validación, pensando en el concepto de validación cruzada , en la que los resultados del fenotipo real medidos en esta población se comparan con los resultados del fenotipo basados en la predicción, lo que se utiliza para verificar la precisión del modelo.

A modo de resumen, algunos puntos sobre la aplicación de la genética cuantitativa son:

Los estudios de expresión diferencial de genes a partir de datos de RNA-Seq , como RT-qPCR y microarrays , exigen la comparación de condiciones. El objetivo es identificar genes que tienen un cambio significativo en abundancia entre diferentes condiciones. Luego, los experimentos se diseñan adecuadamente, con réplicas para cada condición/tratamiento, aleatorización y bloqueo, cuando sea necesario. En RNA-Seq, la cuantificación de la expresión utiliza la información de lecturas mapeadas que se resumen en alguna unidad genética, como exones que forman parte de una secuencia genética. Como los resultados de microarrays pueden aproximarse mediante una distribución normal, los datos de recuento de RNA-Seq se explican mejor mediante otras distribuciones. La primera distribución utilizada fue la de Poisson , pero subestima el error de muestra, lo que conduce a falsos positivos. Actualmente, la variación biológica se considera mediante métodos que estiman un parámetro de dispersión de una distribución binomial negativa . Se utilizan modelos lineales generalizados para realizar las pruebas de significación estadística y, como el número de genes es alto, se debe considerar la corrección de múltiples pruebas. [34] Algunos ejemplos de otros análisis de datos genómicos provienen de experimentos de microarrays o proteómica . [35] [36] A menudo se refieren a enfermedades o estadios de enfermedades. [37]

Existen muchas herramientas que se pueden utilizar para realizar análisis estadísticos de datos biológicos. La mayoría de ellas son útiles en otras áreas del conocimiento, abarcando un gran número de aplicaciones (en orden alfabético). A continuación se describen brevemente algunas de ellas:

Casi todos los programas de formación en bioestadística son de nivel de posgrado . Suelen impartirse en escuelas de salud pública, afiliadas a facultades de medicina, silvicultura o agricultura, o como foco de aplicación en departamentos de estadística.

En Estados Unidos, donde varias universidades cuentan con departamentos dedicados a la bioestadística, muchas otras universidades de primer nivel integran a la facultad de bioestadística en departamentos de estadística u otros, como el de epidemiología . Por lo tanto, los departamentos que llevan el nombre de "bioestadística" pueden existir bajo estructuras bastante diferentes. Por ejemplo, se han fundado departamentos de bioestadística relativamente nuevos con un enfoque en la bioinformática y la biología computacional , mientras que los departamentos más antiguos, generalmente afiliados a escuelas de salud pública , tendrán líneas de investigación más tradicionales que involucran estudios epidemiológicos y ensayos clínicos , así como bioinformática. En las universidades más grandes de todo el mundo, donde existen tanto un departamento de estadística como un departamento de bioestadística, el grado de integración entre los dos departamentos puede variar desde el mínimo indispensable hasta una colaboración muy estrecha. En general, la diferencia entre un programa de estadística y un programa de bioestadística es doble: (i) los departamentos de estadística a menudo albergarán investigaciones teóricas/metodológicas que son menos comunes en los programas de bioestadística y (ii) los departamentos de estadística tienen líneas de investigación que pueden incluir aplicaciones biomédicas pero también otras áreas como la industria ( control de calidad ), negocios y economía y áreas biológicas distintas de la medicina.

La literatura científica ofrece varios artículos revisados por pares interesantes y útiles con una descripción general de los conceptos básicos de la aplicación de la bioestadística a la investigación moderna, como uno sobre cómo escribir una sección de análisis estadístico en la investigación médica, [46] otro sobre errores estadísticos comunes en la investigación científica básica [47] o un artículo sobre errores estadísticos comunes a tener en cuenta al escribir o revisar un manuscrito. [48] Estos artículos revisados por pares recientes son bastante valiosos para la capacitación de los estudiantes en el uso avanzado de la bioestadística. [49]

![]() Medios relacionados con Bioestadística en Wikimedia Commons

Medios relacionados con Bioestadística en Wikimedia Commons