El álgebra lineal es la rama de las matemáticas que se ocupa de ecuaciones lineales como:

mapas lineales como:

y sus representaciones en espacios vectoriales y mediante matrices . [1] [2] [3]

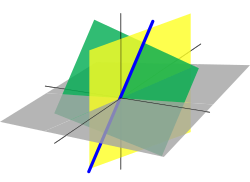

El álgebra lineal es fundamental para casi todas las áreas de las matemáticas. Por ejemplo, el álgebra lineal es fundamental en las presentaciones modernas de geometría , incluso para definir objetos básicos como líneas , planos y rotaciones . Además, el análisis funcional , una rama del análisis matemático , puede verse como la aplicación del álgebra lineal a espacios funcionales .

El álgebra lineal también se utiliza en la mayoría de las ciencias y campos de la ingeniería , porque permite modelar muchos fenómenos naturales y calcular de manera eficiente con dichos modelos. Para sistemas no lineales , que no se pueden modelar con álgebra lineal, se suele utilizar para tratar con aproximaciones de primer orden , aprovechando el hecho de que el diferencial de una función multivariante en un punto es el mapa lineal que mejor se aproxima a la función cerca de ese punto.

El procedimiento (usando varillas de conteo) para resolver ecuaciones lineales simultáneas ahora llamado eliminación gaussiana aparece en el antiguo texto matemático chino Capítulo Ocho: Matrices rectangulares de los nueve capítulos sobre el arte matemático . Su uso se ilustra en dieciocho problemas, con dos a cinco ecuaciones. [4]

Los sistemas de ecuaciones lineales surgieron en Europa con la introducción en 1637 por René Descartes de las coordenadas en geometría . De hecho, en esta nueva geometría, ahora llamada geometría cartesiana , las líneas y los planos se representan mediante ecuaciones lineales, y calcular sus intersecciones equivale a resolver sistemas de ecuaciones lineales.

Los primeros métodos sistemáticos para resolver sistemas lineales utilizaron determinantes y fueron considerados por primera vez por Leibniz en 1693. En 1750, Gabriel Cramer los utilizó para dar soluciones explícitas de sistemas lineales, ahora llamada regla de Cramer . Más tarde, Gauss describió con más detalle el método de eliminación, que inicialmente fue catalogado como un avance en geodesia . [5]

En 1844 Hermann Grassmann publicó su "Teoría de la Extensión", que incluía nuevos temas fundamentales de lo que hoy se llama álgebra lineal. En 1848, James Joseph Sylvester introdujo el término matriz , que en latín significa útero .

El álgebra lineal creció con ideas anotadas en el plano complejo . Por ejemplo, dos números w y z tienen una diferencia w – z , y los segmentos de línea wz y 0( w − z ) tienen la misma longitud y dirección. Los segmentos son equipolentes . El sistema cuatridimensional de cuaterniones fue descubierto por WR Hamilton en 1843. [6] El término vector se introdujo como v = x i + y j + z k , que representa un punto en el espacio. La diferencia de cuaternión p – q también produce un segmento equipolento a pq . Otros sistemas numéricos hipercomplejos también utilizaron la idea de un espacio lineal con una base .

Arthur Cayley introdujo la multiplicación de matrices y la matriz inversa en 1856, haciendo posible el grupo lineal general . El mecanismo de representación grupal estuvo disponible para describir números complejos e hipercomplejos. Fundamentalmente, Cayley usó una sola letra para denotar una matriz, tratando así una matriz como un objeto agregado. También se dio cuenta de la conexión entre matrices y determinantes y escribió: "Habría muchas cosas que decir sobre esta teoría de matrices que, en mi opinión, debería preceder a la teoría de los determinantes". [5]

Benjamin Peirce publicó su Álgebra asociativa lineal (1872), y su hijo Charles Sanders Peirce amplió el trabajo más tarde. [7]

El telégrafo requería un sistema explicativo, y la publicación de 1873 de Tratado sobre electricidad y magnetismo instituyó una teoría de campo de fuerzas y requirió geometría diferencial para su expresión. El álgebra lineal es geometría diferencial plana y sirve en espacios tangentes a variedades . Las simetrías electromagnéticas del espacio-tiempo se expresan mediante las transformaciones de Lorentz , y gran parte de la historia del álgebra lineal es la historia de las transformaciones de Lorentz .

Peano introdujo la primera definición moderna y más precisa de un espacio vectorial en 1888; [5] en 1900, había surgido una teoría de transformaciones lineales de espacios vectoriales de dimensión finita. El álgebra lineal tomó su forma moderna en la primera mitad del siglo XX, cuando muchas ideas y métodos de siglos anteriores se generalizaron como álgebra abstracta . El desarrollo de las computadoras condujo a una mayor investigación sobre algoritmos eficientes para la eliminación gaussiana y las descomposiciones matriciales, y el álgebra lineal se convirtió en una herramienta esencial para el modelado y las simulaciones. [5]

Hasta el siglo XIX el álgebra lineal se introdujo mediante sistemas de ecuaciones lineales y matrices . En matemáticas modernas, generalmente se prefiere la presentación a través de espacios vectoriales , ya que es más sintética , más general (no limitada al caso de dimensión finita) y conceptualmente más simple, aunque más abstracta.

Un espacio vectorial sobre un campo F (a menudo el campo de los números reales ) es un conjunto V equipado con dos operaciones binarias que satisfacen los siguientes axiomas . Los elementos de V se llaman vectores y los elementos de F se llaman escalares . La primera operación, suma de vectores , toma dos vectores cualesquiera v y w y genera un tercer vector v + w . La segunda operación, multiplicación escalar , toma cualquier escalar a y cualquier vector v y genera un nuevo vector a v . Los axiomas que deben satisfacer la suma y la multiplicación escalar son los siguientes. (En la siguiente lista, u , v y w son elementos arbitrarios de V , y a y b son escalares arbitrarios en el campo F ). [8]

Los primeros cuatro axiomas significan que V es un grupo abeliano bajo suma.

Un elemento de un espacio vectorial específico puede tener diversa naturaleza; por ejemplo, podría ser una secuencia , una función , un polinomio o una matriz . El álgebra lineal se ocupa de aquellas propiedades de dichos objetos que son comunes a todos los espacios vectoriales.

Los mapas lineales son mapeos entre espacios vectoriales que preservan la estructura del espacio vectorial. Dados dos espacios vectoriales V y W sobre un campo F , una aplicación lineal (también llamada, en algunos contextos, transformación lineal o aplicación lineal) es una aplicación

que sea compatible con la suma y la multiplicación escalar, es decir

para cualquier vector u , v en V y escalar a en F .

Esto implica que para cualquier vector u , v en V y escalares a , b en F , se tiene

Cuando V = W son el mismo espacio vectorial, un mapa lineal T : V → V también se conoce como operador lineal en V .

Una aplicación lineal biyectiva entre dos espacios vectoriales (es decir, cada vector del segundo espacio está asociado exactamente con uno del primero) es un isomorfismo . Debido a que un isomorfismo preserva la estructura lineal, dos espacios vectoriales isomórficos son "esencialmente iguales" desde el punto de vista del álgebra lineal, en el sentido de que no pueden distinguirse mediante el uso de propiedades del espacio vectorial. Una cuestión esencial en álgebra lineal es comprobar si una aplicación lineal es un isomorfismo o no y, si no es un isomorfismo, encontrar su rango (o imagen) y el conjunto de elementos que se asignan al vector cero, llamado núcleo . del mapa. Todas estas cuestiones se pueden resolver utilizando la eliminación gaussiana o alguna variante de este algoritmo .

El estudio de aquellos subconjuntos de espacios vectoriales que son en sí mismos espacios vectoriales bajo las operaciones inducidas es fundamental, al igual que para muchas estructuras matemáticas. Estos subconjuntos se denominan subespacios lineales . Más precisamente, un subespacio lineal de un espacio vectorial V sobre un campo F es un subconjunto W de V tal que u + v y a u están en W , para cada u , v en W y cada a en F. (Estas condiciones son suficientes para implicar que W es un espacio vectorial).

Por ejemplo, dado un mapa lineal T : V → W , la imagen T ( V ) de V y la imagen inversa T −1 ( 0 ) de 0 (llamada núcleo o espacio nulo), son subespacios lineales de W y V , respectivamente.

Otra forma importante de formar un subespacio es considerar combinaciones lineales de un conjunto S de vectores: el conjunto de todas las sumas

donde v 1 , v 2 , ..., v k están en S , y a 1 , a 2 , ..., a k están en F forman un subespacio lineal llamado tramo de S . El lapso de S es también la intersección de todos los subespacios lineales que contienen S. En otras palabras, es el subespacio lineal más pequeño (para la relación de inclusión) que contiene S.

Un conjunto de vectores es linealmente independiente si ninguno está en el intervalo de los demás. De manera equivalente, un conjunto S de vectores es linealmente independiente si la única forma de expresar el vector cero como una combinación lineal de elementos de S es tomar cero para cada coeficiente a i .

Un conjunto de vectores que abarca un espacio vectorial se llama conjunto generador o conjunto generador . Si un conjunto generador S es linealmente dependiente (es decir , no es linealmente independiente), entonces algún elemento w de S está en el intervalo de los otros elementos de S , y el intervalo seguiría siendo el mismo si se elimina w de S. Se pueden continuar eliminando elementos de S hasta obtener un conjunto generador linealmente independiente . Un conjunto linealmente independiente que abarca un espacio vectorial V se llama base de V. La importancia de las bases radica en el hecho de que son simultáneamente conjuntos generadores mínimos y conjuntos independientes máximos. Más precisamente, si S es un conjunto linealmente independiente y T es un conjunto generador tal que S ⊆ T , entonces existe una base B tal que S ⊆ B ⊆ T .

Dos bases cualesquiera de un espacio vectorial V tienen la misma cardinalidad , que se denomina dimensión de V ; este es el teorema de dimensión para espacios vectoriales . Además, dos espacios vectoriales sobre el mismo campo F son isomorfos si y sólo si tienen la misma dimensión. [9]

Si cualquier base de V (y por tanto toda base) tiene un número finito de elementos, V es un espacio vectorial de dimensión finita . Si U es un subespacio de V , entonces tenue U ≤ tenue V. En el caso de que V sea de dimensión finita, la igualdad de las dimensiones implica U = V.

Si U 1 y U 2 son subespacios de V , entonces

donde U 1 + U 2 denota el lapso de U 1 ∪ U 2 . [10]

Las matrices permiten la manipulación explícita de espacios vectoriales de dimensión finita y mapas lineales . Por tanto, su teoría es una parte esencial del álgebra lineal.

Sea V un espacio vectorial de dimensión finita sobre un campo F , y ( v 1 , v 2 , ..., v m ) sea una base de V (por lo tanto, m es la dimensión de V ). Por definición de base, el mapa

es una biyección de F m , el conjunto de las secuencias de m elementos de F , sobre V . Este es un isomorfismo de espacios vectoriales, si F m está equipado con su estructura estándar de espacio vectorial, donde la suma de vectores y la multiplicación escalar se realizan componente por componente.

Este isomorfismo permite representar un vector por su imagen inversa bajo este isomorfismo, es decir por el vector de coordenadas ( a 1 , ..., a m ) o por la matriz columna

Si W es otro espacio vectorial de dimensión finita (posiblemente el mismo), con una base ( w 1 , ..., w n ) , un mapa lineal f de W a V está bien definido por sus valores en los elementos base, es decir ( f ( w 1 ), ..., f ( w n )) . Por tanto, f está bien representada por la lista de las matrices de columnas correspondientes. Es decir, si

para j = 1, ..., n , entonces f está representada por la matriz

con m filas yn columnas .

La multiplicación de matrices se define de tal manera que el producto de dos matrices es la matriz de la composición de los mapas lineales correspondientes, y el producto de una matriz y una matriz de columnas es la matriz de columnas que representa el resultado de aplicar el mapa lineal representado a el vector representado. De ello se deduce que la teoría de espacios vectoriales de dimensión finita y la teoría de matrices son dos lenguajes diferentes para expresar exactamente los mismos conceptos.

Se llaman similares dos matrices que codifican la misma transformación lineal en bases diferentes . Se puede demostrar que dos matrices son similares si y sólo si se puede transformar una en la otra mediante operaciones elementales de fila y columna . Para una matriz que representa un mapa lineal de W a V , las operaciones de fila corresponden al cambio de bases en V y las operaciones de columna corresponden al cambio de bases en W. Cada matriz es similar a una matriz identidad posiblemente delimitada por cero filas y cero columnas. En términos de espacios vectoriales, esto significa que, para cualquier aplicación lineal de W a V , hay bases tales que una parte de la base de W se aplica biyectivamente a una parte de la base de V , y que los elementos de base restantes de W , si los hay, se asignan a cero. La eliminación gaussiana es el algoritmo básico para encontrar estas operaciones elementales y probar estos resultados.

Un conjunto finito de ecuaciones lineales en un conjunto finito de variables, por ejemplo, x 1 , x 2 , ..., x n , o x , y , ..., z se denomina sistema de ecuaciones lineales o sistema lineal. . [11] [12] [13] [14] [15]

Los sistemas de ecuaciones lineales forman una parte fundamental del álgebra lineal. Históricamente, el álgebra lineal y la teoría de matrices se han desarrollado para resolver dichos sistemas. En la presentación moderna del álgebra lineal a través de espacios vectoriales y matrices, muchos problemas pueden interpretarse en términos de sistemas lineales.

Por ejemplo, dejemos

ser un sistema lineal.

A tal sistema, se le puede asociar su matriz

y su vector miembro derecho

Sea T la transformación lineal asociada a la matriz M. Una solución del sistema ( S ) es un vector

tal que

ese es un elemento de la preimagen de v por T .

Sea ( S′ ) el sistema homogéneo asociado , donde los lados derechos de las ecuaciones se ponen a cero:

Las soluciones de ( S′ ) son exactamente los elementos del núcleo de T o, equivalentemente, M .

La eliminación gaussiana consiste en realizar operaciones elementales por filas sobre la matriz aumentada.

para ponerlo en forma escalonada de hileras reducidas . Estas operaciones con renglones no cambian el conjunto de soluciones del sistema de ecuaciones. En el ejemplo, la forma escalonada reducida es

mostrando que el sistema ( S ) tiene la solución única

De esta interpretación matricial de sistemas lineales se deduce que se pueden aplicar los mismos métodos para resolver sistemas lineales y para muchas operaciones con matrices y transformaciones lineales, que incluyen el cálculo de rangos , núcleos y inversas de matrices .

Un endomorfismo lineal es una aplicación lineal que asigna un espacio vectorial V a sí mismo. Si V tiene una base de n elementos, dicho endomorfismo está representado por una matriz cuadrada de tamaño n .

Con respecto a los mapas lineales generales, los endomorfismos lineales y las matrices cuadradas tienen algunas propiedades específicas que hacen de su estudio una parte importante del álgebra lineal, que se utiliza en muchas partes de las matemáticas, incluidas transformaciones geométricas , cambios de coordenadas , formas cuadráticas y muchas otras partes. de matemáticas.

El determinante de una matriz cuadrada A se define como [16]

donde S n es el grupo de todas las permutaciones de n elementos, σ es una permutación y (−1) σ la paridad de la permutación. Una matriz es invertible si y sólo si el determinante es invertible (es decir, distinto de cero si los escalares pertenecen a un campo).

La regla de Cramer es una expresión de forma cerrada , en términos de determinantes, de la solución de un sistema de n ecuaciones lineales en n incógnitas . La regla de Cramer es útil para razonar sobre la solución, pero, excepto para n = 2 o 3 , rara vez se usa para calcular una solución, ya que la eliminación gaussiana es un algoritmo más rápido.

El determinante de un endomorfismo es el determinante de la matriz que representa el endomorfismo en términos de alguna base ordenada. Esta definición tiene sentido, ya que este determinante es independiente de la elección de la base.

Si f es un endomorfismo lineal de un espacio vectorial V sobre un campo F , un vector propio de f es un vector v distinto de cero de V tal que f ( v ) = av para algún escalar a en F. Este escalar a es un valor propio de f .

Si la dimensión de V es finita y se ha elegido una base, f y v pueden representarse, respectivamente, mediante una matriz cuadrada M y una matriz de columnas z ; la ecuación que define vectores propios y valores propios se convierte en

Usando la matriz identidad I , cuyas entradas son todas cero, excepto las de la diagonal principal, que son iguales a uno, esto se puede reescribir

Como se supone que z es distinto de cero, esto significa que M – aI es una matriz singular y, por tanto, su determinante det ( M – aI ) es igual a cero. Los valores propios son, por tanto, las raíces del polinomio.

Si V es de dimensión n , se trata de un polinomio mónico de grado n , llamado polinomio característico de la matriz (o del endomorfismo), y existen, como máximo, n valores propios.

Si existe una base que consta únicamente de vectores propios, la matriz de f sobre esta base tiene una estructura muy simple: es una matriz diagonal tal que las entradas en la diagonal principal son valores propios y las otras entradas son cero. En este caso se dice que el endomorfismo y la matriz son diagonalizables . De manera más general, un endomorfismo y una matriz también se dicen diagonalizables, si se vuelven diagonalizables después de extender el campo de los escalares. En este sentido extendido, si el polinomio característico no tiene cuadrados , entonces la matriz es diagonalizable.

Una matriz simétrica siempre es diagonalizable. Existen matrices no diagonalizables, siendo la más simple

(no puede ser diagonalizable ya que su cuadrado es la matriz cero , y el cuadrado de una matriz diagonal distinta de cero nunca es cero).

Cuando un endomorfismo no es diagonalizable, hay bases sobre las cuales tiene una forma simple, aunque no tan simple como la forma diagonal. La forma normal de Frobenius no necesita ampliar el campo de los escalares y hace que el polinomio característico sea inmediatamente legible en la matriz. La forma normal de Jordan requiere ampliar el campo del escalar para contener todos los valores propios y difiere de la forma diagonal sólo en algunas entradas que están justo encima de la diagonal principal y son iguales a 1.

Una forma lineal es una aplicación lineal desde un espacio vectorial V sobre un campo F hasta el campo de escalares F , visto como un espacio vectorial sobre sí mismo. Equipadas con suma y multiplicación puntuales por un escalar, las formas lineales forman un espacio vectorial, llamado espacio dual de V , y generalmente denotado V* [17] o V ′ . [18] [19]

Si v 1 , ..., v n es una base de V (esto implica que V es de dimensión finita), entonces se puede definir, para i = 1, ..., n , una aplicación lineal v i * tal que v yo *( v yo ) = 1 y v yo *( v j ) = 0 si j ≠ yo . Estos mapas lineales forman una base de V * , llamada base dual de v 1 , ..., v n . (Si V no es de dimensión finita, v i * puede definirse de manera similar; son linealmente independientes, pero no forman una base).

Para v en V , el mapa

es una forma lineal en V* . Esto define el mapa lineal canónico de V a ( V *)* , el dual de V* , llamado bidual de V . Esta aplicación canónica es un isomorfismo si V es de dimensión finita, y esto permite identificar V con su bidual. (En el caso de dimensión infinita, el mapa canónico es inyectivo, pero no sobreyectivo).

Por tanto, existe una simetría completa entre un espacio vectorial de dimensión finita y su dual. Esto motiva el uso frecuente, en este contexto, de la notación bracket.

para denotar f ( x ) .

Dejar

ser un mapa lineal. Para cada forma lineal h en W , la función compuesta h ∘ f es una forma lineal en V. Esto define un mapa lineal.

entre los espacios duales, lo que se llama dual o transpuesta de f .

Si V y W son de dimensiones finitas, y M es la matriz de f en términos de algunas bases ordenadas, entonces la matriz de f* sobre las bases duales es la transpuesta MT de M , obtenida intercambiando filas y columnas.

Si los elementos de los espacios vectoriales y sus duales se representan mediante vectores columna, esta dualidad se puede expresar en notación de soporte mediante

Para resaltar esta simetría, los dos miembros de esta igualdad a veces se escriben

Además de estos conceptos básicos, el álgebra lineal también estudia espacios vectoriales con estructura adicional, como un producto interno . El producto interno es un ejemplo de forma bilineal y le da al espacio vectorial una estructura geométrica al permitir la definición de longitudes y ángulos. Formalmente, un producto interno es un mapa.

que satisface los tres axiomas siguientes para todos los vectores u , v , w en V y todos los escalares a en F : [20] [21]

Podemos definir la longitud de un vector v en V por

y podemos probar la desigualdad de Cauchy-Schwarz :

En particular, la cantidad

y entonces podemos llamar a esta cantidad coseno del ángulo entre los dos vectores.

Dos vectores son ortogonales si ⟨ u , v ⟩ = 0 . Una base ortonormal es una base en la que todos los vectores de base tienen longitud 1 y son ortogonales entre sí. Dado cualquier espacio vectorial de dimensión finita, el procedimiento de Gram-Schmidt podría encontrar una base ortonormal . Las bases ortonormales son particularmente fáciles de tratar, ya que si v = a 1 v 1 + ⋯ + a n v n , entonces

El producto interior facilita la construcción de muchos conceptos útiles. Por ejemplo, dada una transformada T , podemos definir su conjugado hermitiano T* como la transformada lineal que satisface

Si T satisface TT* = T*T , llamamos a T normal . Resulta que las matrices normales son precisamente las matrices que tienen un sistema ortonormal de vectores propios que abarcan V .

Existe una fuerte relación entre el álgebra lineal y la geometría , que comenzó con la introducción por parte de René Descartes , en 1637, de las coordenadas cartesianas . En esta nueva (en aquel momento) geometría, ahora llamada geometría cartesiana , los puntos se representan mediante coordenadas cartesianas , que son secuencias de tres números reales (en el caso del habitual espacio tridimensional ). Los objetos básicos de la geometría, que son las líneas y los planos , se representan mediante ecuaciones lineales. Por tanto, calcular intersecciones de líneas y planos equivale a resolver sistemas de ecuaciones lineales. Esta fue una de las principales motivaciones para desarrollar el álgebra lineal.

La mayoría de las transformaciones geométricas , como traslaciones , rotaciones , reflexiones , movimientos rígidos , isometrías y proyecciones , transforman líneas en líneas. De ello se deduce que pueden definirse, especificarse y estudiarse en términos de mapas lineales. Este es también el caso de las homografías y las transformaciones de Möbius , cuando se las considera como transformaciones de un espacio proyectivo .

Hasta finales del siglo XIX, los espacios geométricos estaban definidos por axiomas que relacionaban puntos, rectas y planos ( geometría sintética ). Alrededor de esta fecha, parecía que también se podían definir espacios geométricos mediante construcciones que involucraran espacios vectoriales (ver, por ejemplo, Espacio proyectivo y Espacio afín ). Se ha demostrado que los dos enfoques son esencialmente equivalentes. [22] En la geometría clásica, los espacios vectoriales involucrados son espacios vectoriales sobre los reales, pero las construcciones pueden extenderse a espacios vectoriales sobre cualquier campo, permitiendo considerar la geometría sobre campos arbitrarios, incluidos los campos finitos .

Actualmente, la mayoría de los libros de texto introducen espacios geométricos a partir del álgebra lineal, y la geometría a menudo se presenta, en el nivel elemental, como un subcampo del álgebra lineal.

El álgebra lineal se utiliza en casi todas las áreas de las matemáticas, lo que la hace relevante en casi todos los dominios científicos que utilizan las matemáticas. Estas aplicaciones se pueden dividir en varias categorías amplias.

El análisis funcional estudia los espacios funcionales . Se trata de espacios vectoriales con estructura adicional, como los espacios de Hilbert . El álgebra lineal es, por tanto, una parte fundamental del análisis funcional y sus aplicaciones, que incluyen, en particular, la mecánica cuántica ( funciones de onda ) y el análisis de Fourier ( base ortogonal ).

Casi todos los cálculos científicos implican álgebra lineal. [23] En consecuencia, los algoritmos de álgebra lineal se han optimizado altamente. BLAS y LAPACK son las implementaciones más conocidas. Para mejorar la eficiencia, algunos de ellos configuran los algoritmos automáticamente, en tiempo de ejecución, para adaptarlos a las especificidades del ordenador ( tamaño de la caché , número de núcleos disponibles , ...).

Algunos procesadores , normalmente unidades de procesamiento de gráficos (GPU), están diseñados con una estructura matricial para optimizar las operaciones de álgebra lineal. [ cita necesaria ]

El modelado del espacio ambiental se basa en la geometría . Las ciencias que se ocupan de este espacio utilizan ampliamente la geometría. Éste es el caso de la mecánica y la robótica , para describir la dinámica de los cuerpos rígidos ; geodesia para describir la forma de la Tierra ; perspectiva , visión por computadora y gráficos por computadora , para describir la relación entre una escena y su representación plana; y muchos otros dominios científicos.

En todas estas aplicaciones, la geometría sintética se utiliza a menudo para descripciones generales y un enfoque cualitativo, pero para el estudio de situaciones explícitas, se debe calcular con coordenadas . Esto requiere el uso intensivo de álgebra lineal.

La mayoría de los fenómenos físicos se modelan mediante ecuaciones diferenciales parciales . Para resolverlos, normalmente se descompone el espacio en el que se buscan las soluciones en pequeñas celdas que interactúan entre sí . Para sistemas lineales, esta interacción involucra funciones lineales . Para sistemas no lineales , esta interacción a menudo se aproxima mediante funciones lineales. [b] Esto se llama modelo lineal o aproximación de primer orden. Los modelos lineales se utilizan con frecuencia para sistemas complejos no lineales del mundo real porque hacen que la parametrización sea más manejable. [24] En ambos casos se trata generalmente de matrices muy grandes. El pronóstico del tiempo (o más específicamente, la parametrización para el modelado atmosférico ) es un ejemplo típico de una aplicación del mundo real, donde toda la atmósfera de la Tierra se divide en células de, digamos, 100 km de ancho y 100 km de alto.

[25] [26] [27]

El álgebra lineal, una rama de las matemáticas que se ocupa de espacios vectoriales y asignaciones lineales entre estos espacios, desempeña un papel fundamental en diversas disciplinas de la ingeniería, incluidas la mecánica de fluidos , la dinámica de fluidos y los sistemas de energía térmica . Su aplicación en estos campos es multifacética e indispensable para la resolución de problemas complejos.

En mecánica de fluidos , el álgebra lineal es fundamental para comprender y resolver problemas relacionados con el comportamiento de los fluidos. Ayuda en el modelado y simulación del flujo de fluidos, proporcionando herramientas esenciales para el análisis de problemas de dinámica de fluidos . Por ejemplo, las técnicas algebraicas lineales se utilizan para resolver sistemas de ecuaciones diferenciales que describen el movimiento de fluidos. Estas ecuaciones, a menudo complejas y no lineales , se pueden linealizar utilizando métodos de álgebra lineal, lo que permite soluciones y análisis más simples.

En el campo de la dinámica de fluidos, el álgebra lineal encuentra su aplicación en la dinámica de fluidos computacional (CFD), una rama que utiliza análisis numérico y estructuras de datos para resolver y analizar problemas que involucran flujos de fluidos. CFD se basa en gran medida en el álgebra lineal para calcular el flujo de fluidos y la transferencia de calor en diversas aplicaciones. Por ejemplo, las ecuaciones de Navier-Stokes , fundamentales en dinámica de fluidos , suelen resolverse mediante técnicas derivadas del álgebra lineal. Esto incluye el uso de matrices y vectores para representar y manipular campos de flujo de fluidos.

Además, el álgebra lineal juega un papel crucial en los sistemas de energía térmica , particularmente en el análisis de sistemas de energía . Se utiliza para modelar y optimizar la generación, transmisión y distribución de energía eléctrica. Se emplean conceptos algebraicos lineales, como operaciones matriciales y problemas de valores propios , para mejorar la eficiencia, la confiabilidad y el desempeño económico de los sistemas de energía . La aplicación del álgebra lineal en este contexto es vital para el diseño y operación de sistemas eléctricos modernos , incluidas las fuentes de energía renovables y las redes inteligentes .

En general, la aplicación del álgebra lineal en mecánica de fluidos , dinámica de fluidos y sistemas de energía térmica es un ejemplo de la profunda interconexión entre las matemáticas y la ingeniería . Proporciona a los ingenieros las herramientas necesarias para modelar, analizar y resolver problemas complejos en estos dominios, lo que genera avances en la tecnología y la industria.

Esta sección presenta varios temas relacionados que generalmente no aparecen en los libros de texto elementales sobre álgebra lineal, pero que comúnmente se consideran, en matemáticas avanzadas, como partes del álgebra lineal.

La existencia de inversos multiplicativos en campos no está involucrada en los axiomas que definen un espacio vectorial. Por lo tanto, se puede reemplazar el campo de escalares por un anillo R , y esto da la estructura llamada módulo sobre R , o R -módulo.

Los conceptos de independencia lineal, intervalo, base y aplicaciones lineales (también llamados homomorfismos de módulo ) se definen para módulos exactamente como para espacios vectoriales, con la diferencia esencial de que, si R no es un campo, hay módulos que no tienen ningún campo. base. Los módulos que tienen una base son los módulos libres , y los que están abarcados por un conjunto finito son los módulos generados de forma finita . Los homomorfismos de módulos entre módulos libres generados finitamente pueden representarse mediante matrices. La teoría de las matrices sobre un anillo es similar a la de las matrices sobre un campo, excepto que los determinantes existen sólo si el anillo es conmutativo , y que una matriz cuadrada sobre un anillo conmutativo es invertible sólo si su determinante tiene un inverso multiplicativo en el anillo. .

Los espacios vectoriales se caracterizan completamente por su dimensión (hasta un isomorfismo). En general, no existe una clasificación tan completa para los módulos, incluso si nos limitamos a módulos generados de forma finita. Sin embargo, cada módulo es un núcleo de un homomorfismo de módulos libres.

Los módulos sobre los números enteros se pueden identificar con grupos abelianos , ya que la multiplicación por un número entero se puede identificar con una suma repetida. La mayor parte de la teoría de los grupos abelianos puede ampliarse a módulos sobre un dominio ideal principal . En particular, sobre un dominio ideal principal, cada submódulo de un módulo libre es libre, y el teorema fundamental de los grupos abelianos generados finitamente puede extenderse directamente a módulos generados finitamente sobre un anillo principal.

Hay muchos anillos para los cuales existen algoritmos para resolver ecuaciones lineales y sistemas de ecuaciones lineales. Sin embargo, estos algoritmos generalmente tienen una complejidad computacional mucho mayor que algoritmos similares en un campo. Para obtener más detalles, consulte Ecuación lineal sobre un anillo .

En álgebra multilineal , se consideran transformaciones lineales multivariables, es decir, asignaciones que son lineales en cada una de una serie de variables diferentes. Esta línea de investigación conduce naturalmente a la idea del espacio dual , el espacio vectorial V* que consta de aplicaciones lineales f : V → F donde F es el campo de los escalares. Los mapas multilineales T : V n → F se pueden describir mediante productos tensoriales de elementos de V* .

Si, además de la suma de vectores y la multiplicación escalar, existe un producto vectorial bilineal V × V → V , el espacio vectorial se llama álgebra ; por ejemplo, las álgebras asociativas son álgebras con un producto vectorial asociado (como el álgebra de matrices cuadradas o el álgebra de polinomios).

Los espacios vectoriales que no son de dimensión finita a menudo requieren una estructura adicional para ser manejables. Un espacio vectorial normado es un espacio vectorial junto con una función llamada norma , que mide el "tamaño" de los elementos. La norma induce una métrica , que mide la distancia entre elementos, e induce una topología , que permite una definición de mapas continuos. La métrica también permite una definición de límites y completitud : un espacio métrico completo se conoce como espacio de Banach . Un espacio métrico completo junto con la estructura adicional de un producto interno (una forma sesquilineal simétrica conjugada ) se conoce como espacio de Hilbert , que es en cierto sentido un espacio de Banach particularmente bien comportado. El análisis funcional aplica los métodos del álgebra lineal junto con los del análisis matemático para estudiar varios espacios funcionales; Los objetos centrales de estudio en el análisis funcional son los espacios L p , que son espacios de Banach, y especialmente el espacio L 2 de funciones cuadradas integrables, que es el único espacio de Hilbert entre ellos. El análisis funcional es de particular importancia para la mecánica cuántica, la teoría de ecuaciones diferenciales parciales, el procesamiento de señales digitales y la ingeniería eléctrica. También proporciona la base y el marco teórico que subyace a la transformada de Fourier y los métodos relacionados.