La semántica léxica (también conocida como lexicosemántica ), como subcampo de la semántica lingüística , es el estudio de los significados de las palabras. [1] [2] Incluye el estudio de cómo las palabras estructuran su significado, cómo actúan en gramática y composicionalidad , [1] y las relaciones entre los distintos sentidos y usos de una palabra. [2]

Las unidades de análisis en semántica léxica son unidades léxicas que incluyen no sólo palabras sino también subpalabras o subunidades como afijos e incluso palabras y frases compuestas . Las unidades léxicas incluyen el catálogo de palabras de una lengua, el léxico . La semántica léxica analiza cómo el significado de las unidades léxicas se correlaciona con la estructura del lenguaje o la sintaxis . Esto se conoce como interfaz sintaxis-semántica . [3]

El estudio de la semántica léxica se refiere a:

Las unidades léxicas, también denominadas átomos sintácticos, pueden ser independientes, como en el caso de las raíces de las palabras o partes de palabras compuestas, o requieren asociación con otras unidades, como lo hacen los prefijos y sufijos. Los primeros se denominan morfemas libres y los segundos morfemas ligados . [4] Caen en una gama estrecha de significados ( campos semánticos ) y pueden combinarse entre sí para generar nuevas denotaciones.

La semántica cognitiva es el paradigma/marco lingüístico que desde la década de 1980 ha generado la mayor cantidad de estudios en semántica léxica, introduciendo innovaciones como la teoría de prototipos , las metáforas conceptuales y la semántica de marcos . [5]

Los elementos léxicos contienen información sobre categoría (léxica y sintáctica), forma y significado. La semántica relacionada con estas categorías luego se relaciona con cada elemento léxico del léxico . [6] Los elementos léxicos también se pueden clasificar semánticamente en función de si sus significados se derivan de unidades léxicas individuales o de su entorno circundante.

Los elementos léxicos participan en patrones regulares de asociación entre sí. Algunas relaciones entre elementos léxicos incluyen hiponimia, hipernimia , sinonimia y antonimia , así como homonimia . [6]

La hiponimia y la hipernimia se refieren a una relación entre un término general y los términos más específicos que caen bajo la categoría del término general.

Por ejemplo, los colores rojo , verde , azul y amarillo son hipónimos. Se incluyen en el término general de color , que es el hiperónimo.

Los hipónimos e hiperónimos se pueden describir mediante una taxonomía , como se ve en el ejemplo.

Sinónimo se refiere a palabras que se pronuncian y escriben de manera diferente pero que contienen el mismo significado.

Antónimo se refiere a palabras que están relacionadas por tener significados opuestos entre sí. Hay tres tipos de antónimos: antónimos graduados , antónimos complementarios y antónimos relacionales .

La homonimia se refiere a la relación entre palabras que se escriben o pronuncian de la misma manera pero que tienen significados diferentes.

La polisemia se refiere a una palabra que tiene dos o más significados relacionados.

Ambonym se refiere a la relación entre dos palabras que las aplican como sinónimos y antónimos simultáneamente debido a las múltiples definiciones de las palabras individuales. No confundir con contrónimo .

La semántica léxica también explora si el significado de una unidad léxica se establece observando su vecindad en la red semántica (palabras con las que aparece en oraciones naturales), o si el significado ya está contenido localmente en la unidad léxica.

En inglés, WordNet es un ejemplo de red semántica. Contiene palabras en inglés que se agrupan en synsets . Algunas relaciones semánticas entre estos conjuntos sintéticos son meronimia , hiponimia , sinonimia y antonimia .

Propuesta por primera vez por Trier en la década de 1930, [7] la teoría del campo semántico propone que un grupo de palabras con significados interrelacionados pueden clasificarse bajo un dominio conceptual más amplio. Por tanto, toda esta entidad se conoce como campo semántico. Las palabras hervir , hornear , freír y asar , por ejemplo, entrarían en la categoría semántica más amplia de cocinar . La teoría del campo semántico afirma que el significado léxico no se puede entender completamente mirando una palabra de forma aislada, sino mirando un grupo de palabras semánticamente relacionadas. [8] Las relaciones semánticas pueden referirse a cualquier relación de significado entre lexemas , incluida la sinonimia (grande y grande), la antonimia (grande y pequeña), la hipernimia y la hiponimia (rosa y flor), la conversabilidad (compra y venta) y la incompatibilidad. La teoría del campo semántico no tiene pautas concretas que determinen el alcance de las relaciones semánticas entre lexemas. La validez abstracta de la teoría es un tema de debate. [7]

Por lo tanto, conocer el significado de un elemento léxico significa conocer las implicaciones semánticas que trae consigo la palabra. Sin embargo, también es posible comprender sólo una palabra de un campo semántico sin comprender otras palabras relacionadas. Tomemos, por ejemplo, una taxonomía de plantas y animales: es posible entender las palabras rosa y conejo sin saber qué es una caléndula o una rata almizclera . Esto también se aplica a los colores, como comprender la palabra rojo sin conocer el significado de escarlata, pero comprender el escarlata sin conocer el significado de rojo puede ser menos probable. Por tanto, un campo semántico puede ser muy grande o muy pequeño, dependiendo del nivel de contraste que se realice entre elementos léxicos. Si bien tanto el gato como el perro caen dentro del campo semántico más amplio de los animales, incluir la raza de perro, como el pastor alemán, requeriría contrastes entre otras razas de perros (por ejemplo , corgi o caniche ), ampliando así aún más el campo semántico. [9]

La estructura de eventos se define como la relación semántica de un verbo y sus propiedades sintácticas. [10] La estructura del evento tiene tres componentes principales: [11]

Los verbos pueden pertenecer a uno de tres tipos: estados, procesos o transiciones.

(1a) define el estado de la puerta que está cerrada; no hay oposición en este predicado . (1b) y (1c) tienen predicados que muestran las transiciones de la puerta que pasa de estar implícitamente abierta a cerrada . (1b) da el uso intransitivo del verbo cerrar, sin mencionar explícitamente al causante, pero (1c) hace mención explícita del agente involucrado en la acción.

El análisis de estas diferentes unidades léxicas tuvo un papel decisivo en el campo de la " lingüística generativa " durante los años sesenta. [12] El término generativo fue propuesto por Noam Chomsky en su libro Estructuras sintácticas publicado en 1957. El término lingüística generativa se basó en la gramática generativa de Chomsky , una teoría lingüística que establece conjuntos sistemáticos de reglas ( teoría X' ) que pueden predecir frases gramaticales dentro de un lenguaje natural. [13] La lingüística generativa también se conoce como teoría vinculante para el gobierno. Los lingüistas generativos de la década de 1960, incluidos Noam Chomsky y Ernst von Glasersfeld , creían que las relaciones semánticas entre los verbos transitivos y los intransitivos estaban ligadas a su organización sintáctica independiente. [12] Esto significó que vieron una frase verbal simple como si abarcara una estructura sintáctica más compleja. [12]

Las teorías lexicalistas se hicieron populares durante la década de 1980 y enfatizaban que la estructura interna de una palabra era una cuestión de morfología y no de sintaxis . [14] Las teorías lexicalistas enfatizaron que las palabras complejas (que resultan de la combinación y derivación de afijos ) tienen entradas léxicas que se derivan de la morfología, en lugar de resultar de propiedades sintácticas y fonológicas superpuestas, como predice la Lingüística Generativa. La distinción entre la lingüística generativa y las teorías lexicalistas se puede ilustrar considerando la transformación de la palabra destruir en destrucción :

Una entrada léxica enumera las propiedades básicas de la palabra completa o las propiedades individuales de los morfemas que componen la palabra misma. Las propiedades de los elementos léxicos incluyen su selección de categorías, selección c , propiedades de selección , selección s (también conocida como selección semántica), [12] propiedades fonológicas y características. Las propiedades de los elementos léxicos son idiosincrásicas, impredecibles y contienen información específica sobre los elementos léxicos que describen. [12]

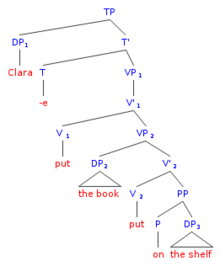

El siguiente es un ejemplo de una entrada léxica para el verbo poner :

Las teorías lexicalistas afirman que el significado de una palabra se deriva de su morfología o del léxico del hablante, y no de su sintaxis. El grado de influencia de la morfología en la gramática general sigue siendo controvertido. [12] Actualmente, los lingüistas que perciben un motor que impulsa tanto elementos morfológicos como sintácticos son la mayoría.

A principios de la década de 1990, el marco minimalista de Chomsky sobre la estructura del lenguaje condujo a técnicas sofisticadas de sondeo para investigar las lenguas. [15] Estas técnicas de sondeo analizaron datos negativos sobre gramáticas prescriptivas , y debido al Principio de Proyección Extendida propuesto por Chomsky en 1986, las técnicas de sondeo mostraron hacia dónde se habían movido los especificadores de una oración para cumplir con el EPP. Esto permitió a los sintácticos plantear la hipótesis de que los elementos léxicos con características sintácticas complejas (como los verbos ditransitivos , incoativos y causativos ) podrían seleccionar su propio elemento especificador dentro de una construcción de árbol sintáctico . (Para más información sobre técnicas de sondeo, consulte Suci, G., Gammon, P. y Gamlin, P. (1979)).

Esto volvió a centrar la atención en la interfaz sintaxis-semántica léxica ; sin embargo, los sintácticos todavía buscaban comprender la relación entre los verbos complejos y su estructura sintáctica relacionada, y hasta qué punto la sintaxis se proyectaba desde el léxico, como argumentaban las teorías lexicalistas.

A mediados de la década de 1990, los lingüistas Heidi Harley , Samuel Jay Keyser y Kenneth Hale abordaron algunas de las implicaciones que plantean los verbos complejos y una sintaxis derivada léxicamente. Sus propuestas indicaron que los predicados CAUSA y CONVERTIRSE, denominados subunidades dentro de una frase verbal, actuaban como plantilla léxica semántica. [16] Los predicados son verbos y declaran o afirman algo sobre el sujeto de la oración o el argumento de la oración. Por ejemplo, los predicados fueron y están aquí abajo afirman el argumento del sujeto y el estado del sujeto respectivamente.

Las subunidades de frases verbales llevaron a la hipótesis de la estructura argumental y a la hipótesis de la frase verbal, ambas se describen a continuación. [17] La recursión encontrada bajo la frase verbal "paraguas", el VP Shell, se adaptaba a la teoría de la ramificación binaria; Otro tema crítico durante la década de 1990. [18] La teoría actual reconoce que el predicado en la posición Especificadora de un árbol en verbos incoativos/ anticausativos (intransitivos), o verbos causativos (transitivos), es lo que selecciona el rol theta unido a un verbo en particular. [12]

Kenneth Hale y Samuel Jay Keyser introdujeron su tesis sobre la estructura del argumento léxico a principios de los años noventa. [19] Argumentan que la estructura argumental de un predicado está representada en la sintaxis, y que la representación sintáctica del predicado es una proyección léxica de sus argumentos. Por lo tanto, la estructura de un predicado es estrictamente una representación léxica, donde cada cabeza de frase proyecta su argumento en un nivel de frase dentro del árbol sintáctico. La selección de esta cabeza de frase se basa en el principio de categoría vacía de Chomsky. Esta proyección léxica del argumento del predicado sobre la estructura sintáctica es la base de la Hipótesis de la estructura argumental. [19] Esta idea coincide con el Principio de Proyección de Chomsky , porque obliga a que un VP sea seleccionado localmente y sea seleccionado mediante una Frase Tiemposa (TP).

Con base en la interacción entre las propiedades léxicas, la localidad y las propiedades del EPP (donde un encabezado de frase selecciona otro elemento de frase localmente), Hale y Keyser afirman que la posición del especificador o un complemento son las únicas dos relaciones semánticas que proyectan una argumento del predicado. En 2003, Hale y Keyser plantearon esta hipótesis y argumentaron que una unidad léxica debe tener uno u otro, Especificador o Complemento, pero no puede tener ambos. [20]

Morris Halle y Alec Marantz introdujeron la noción de morfología distribuida en 1993. [21] Esta teoría considera la estructura sintáctica de las palabras como resultado de la morfología y la semántica, en lugar de que la sintaxis prediga la interfaz morfo-semántica. Esencialmente, la idea de que bajo el Principio de Proyección Extendida existe un límite local bajo el cual ocurre un significado especial. Este significado sólo puede ocurrir si un morfema que proyecta la cabeza está presente dentro del dominio local de la estructura sintáctica. [22] El siguiente es un ejemplo de la estructura de árbol propuesta por la morfología distribuida para la oración "John está destruyendo la ciudad" . Destruir es la raíz, V-1 representa la verbalización y D representa la nominalización. [22]

En su libro de 2008, Verb Meaning and The Lexicon: A First-Phase Syntax , la lingüista Gillian Ramchand reconoce el papel de las entradas léxicas en la selección de verbos complejos y sus argumentos. [23] La sintaxis 'Primera fase' propone que la estructura del evento y los participantes del evento se representen directamente en la sintaxis mediante ramificación binaria . Esta ramificación asegura que el especificador sea el sujeto consistente, incluso cuando se investiga la proyección de la entrada léxica de un verbo complejo y su correspondiente construcción sintáctica. Esta generalización también está presente en la teoría de Ramchand de que el complemento de un encabezamiento de una frase verbal compleja debe codescribir el evento del verbo.

Ramchand también introdujo el concepto de Unidad Homomorfa, que se refiere a la sincronización estructural entre la cabeza de una frase verbal compleja y su complemento. Según Ramchand, la unidad homomórfica es "cuando dos descriptores de eventos se fusionan sintácticamente, la estructura del complemento debe unificarse con la estructura de la cabeza". [23]

La hipótesis no acusativa fue propuesta por David Perlmutter en 1987 y describe cómo dos clases de verbos intransitivos tienen dos estructuras sintácticas diferentes. Se trata de verbos no acusativos y verbos no ergativos . [24] Perlmutter define estas clases de verbos sólo en términos sintácticos. Tienen las siguientes estructuras subyacentes:

El siguiente es un ejemplo del inglés:

En (2a), el verbo subyacente toma un objeto directo, mientras que en (2b) el verbo subyacente toma un sujeto.

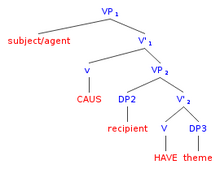

La propiedad de cambio de estado de las frases verbales (VP) es una observación importante para la sintaxis de la semántica léxica porque proporciona evidencia de que las subunidades están integradas en la estructura de la VP y que el significado de la VP completa está influenciado por esta estructura gramatical interna. estructura. (Por ejemplo, el VP que el jarrón rompió conlleva un significado de cambio de estado de que el jarrón se rompe y, por lo tanto, tiene una subunidad silenciosa CONVERTIRSE dentro de su estructura subyacente). Hay dos tipos de predicados de cambio de estado: incoativos y causativo .

Los verbos incoativos son intransitivos , es decir que aparecen sin objeto directo, y estos verbos expresan que su sujeto ha sufrido un determinado cambio de estado. Los verbos incoativos también se conocen como verbos anticausativos . [26] Los verbos causativos son transitivos, lo que significa que ocurren con un objeto directo y expresan que el sujeto provoca un cambio de estado en el objeto.

El lingüista Martin Haspelmath clasifica los pares de verbos incoativos/causativos en tres categorías principales: alternancias causativas, anticausativas y no dirigidas. [27] Las alternancias no dirigidas se subdividen en alternancias lábiles, equipolentas y supletivas.

El inglés tiende a favorecer las alternancias lábiles , [28] lo que significa que el mismo verbo se usa en las formas incoativa y causativa. [27] Esto se puede ver en el siguiente ejemplo: break es un verbo incoativo intransitivo en (3a) y un verbo causativo transitivo en (3b).

Como se ve en la estructura de árbol subyacente para (3a), la subunidad silenciosa CONVERTIRSE está incrustada dentro de la frase verbal (VP), lo que da como resultado el significado de cambio de estado incoativo (y se convierte en z). En la estructura de árbol subyacente para (3b), las subunidades silenciosas CAUS y BECOME están ambas incrustadas dentro del VP, lo que resulta en el significado de cambio de estado causativo (x causa y se convierte en z). [12]

Los verbos de cambio de estado en inglés suelen ser deadjetivales, lo que significa que se derivan de adjetivos. Esto lo podemos ver en el siguiente ejemplo:

En el ejemplo (4a) comenzamos con un adjetivo intransitivo estativo y derivamos (4b) donde vemos un verbo incoativo intransitivo. En (4c) vemos un verbo causativo transitivo.

Algunos idiomas (p. ej., alemán , italiano y francés ) tienen múltiples clases morfológicas de verbos incoativos. [30] En términos generales, estos idiomas separan sus verbos incoativos en tres clases: verbos que están obligatoriamente sin marcar (no están marcados con un pronombre reflexivo , clítico o afijo ), verbos que están marcados opcionalmente y verbos que están marcados obligatoriamente. Los verbos causativos en estos idiomas permanecen sin marcar. Haspelmath se refiere a esto como la alternancia anticausativa .

Por ejemplo, los verbos incoativos en alemán se clasifican en tres clases morfológicas. Los verbos de clase A necesariamente forman incoativos con el pronombre reflexivo sich , los verbos de clase B forman incoativos necesariamente sin el pronombre reflexivo y los verbos de clase C forman incoativos opcionalmente con o sin el pronombre reflexivo. En el ejemplo (5), el verbo zerbrach es un verbo incoativo no marcado de la Clase B , que también permanece sin marcar en su forma causativa. [30]

Por el contrario, el verbo öffnete es un verbo de clase A que necesariamente toma el pronombre reflexivo sich en su forma incoativa, pero permanece sin marcar en su forma causativa.

Ha habido cierto debate sobre si las diferentes clases de verbos incoativos se basan puramente en la morfología o si la diferenciación se deriva de las propiedades léxico-semánticas de cada verbo individual. Si bien este debate aún no está resuelto en idiomas como el italiano , el francés y el griego , el lingüista Florian Schäfer ha sugerido que existen diferencias semánticas entre las incoativas marcadas y no marcadas en alemán . Específicamente, solo los verbos incoativos no marcados permiten una lectura causante no intencional (lo que significa que pueden adoptar una lectura " x y causada involuntariamente "). [30]

Los morfemas causativos están presentes en los verbos de muchos idiomas (p. ej., tagalo , malgache , turco , etc.) y suelen aparecer en forma de afijo en el verbo. [26] Esto se puede ver en los siguientes ejemplos del tagalo , donde el prefijo causativo pag- (realizado aquí como regañar ) se adjunta al verbo tumba para derivar un verbo causativo transitivo en (7b), pero el prefijo no aparece en el verbo incoativo intransitivo en (7a). Haspelmath se refiere a esto como la alternancia causativa .

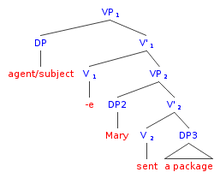

Richard Kayne propuso la idea de caminos inequívocos como una alternativa a las relaciones de comando c, que es el tipo de estructura que se ve en los ejemplos (8). La idea de caminos inequívocos establecía que un antecedente y una anáfora debían estar conectados a través de un camino inequívoco. Esto significa que la línea que conecta un antecedente y una anáfora no puede romperse con otro argumento. [31] Cuando se aplica a verbos ditransitivos, esta hipótesis introduce la estructura del diagrama (8a). En esta estructura de árbol se puede ver que se puede trazar el mismo camino desde cualquiera de los DP hasta el verbo. El diagrama de árbol (7b) ilustra esta estructura con un ejemplo del inglés. Este análisis fue un paso hacia los árboles de ramificación binaria, que fue un cambio teórico que fue impulsado por el análisis VP-shell de Larson. [32]

Larson postuló su Hipótesis del complemento único en la que afirmaba que cada complemento se introduce con un verbo. La construcción de doble objeto presentada en 1988 dio evidencia clara de una estructura jerárquica que utiliza ramificaciones binarias asimétricas. [32] Las oraciones con objetos dobles ocurren con verbos ditransitivos, como podemos ver en el siguiente ejemplo:

Parece como si el verbo enviar tuviera dos objetos, o complementos (argumentos): tanto María , el destinatario como paquete , el tema. La estructura argumental de las frases verbales ditransitivas es compleja y ha pasado por diferentes hipótesis estructurales.

La hipótesis estructural original era la de la ramificación ternaria vista en (9a) y (9b), pero a partir del análisis de Kayne de 1981, Larson sostuvo que cada complemento es introducido por un verbo. [31] [32]

Su hipótesis muestra que hay un verbo inferior incrustado dentro de un caparazón VP que se combina con un verbo superior (puede ser invisible), creando así un caparazón VP (como se ve en el diagrama de árbol a la derecha). La mayoría de las teorías actuales ya no permiten la estructura de árbol ternario de (9a) y (9b), por lo que el tema y el objetivo/destinatario se ven en una relación jerárquica dentro de una estructura de ramificación binaria . [34]

A continuación se muestran ejemplos de las pruebas de Larson para mostrar que el orden jerárquico (superior) de dos objetos cualesquiera se alinea con un orden lineal, de modo que el segundo está gobernado (comandado por c) por el primero. [32] Esto está en consonancia con la teoría X'Bar de la gramática de la estructura de frases, con la estructura de árbol de Larson utilizando el verbo vacío al que se eleva la V.

Los reflexivos y recíprocos (anáforas) muestran esta relación en la que deben ser comandados por sus antecedentes, de modo que (10a) es gramatical pero (10b) no lo es:

Un pronombre debe tener como antecedente un cuantificador:

Las palabras de las preguntas siguen este orden:

El efecto de polaridad negativa significa que "cualquiera" debe tener un cuantificador negativo como antecedente:

Estas pruebas con verbos ditransitivos que confirman el comando c también confirman la presencia de verbos causativos subyacentes o invisibles. En verbos ditransitivos como darle algo a alguien , enviarle algo a alguien , mostrarle algo a alguien, etc., hay un significado causativo subyacente que está representado en la estructura subyacente. Como se ve en el ejemplo (9a) anterior, John le envió un paquete a Mary , existe el significado subyacente de que "John "causó" que Mary tuviera un paquete".

Larson propuso que ambas oraciones en (9a) y (9b) comparten la misma estructura subyacente y la diferencia superficial radica en que la construcción de doble objeto "John le envió un paquete a Mary" se deriva por transformación de una construcción NP más PP "John Envió un paquete a María".

Beck y Johnson, sin embargo, dan evidencia de que las dos estructuras subyacentes no son las mismas. [35] Al hacerlo, también brindan evidencia adicional de la presencia de dos VP donde el verbo se une a un verbo causativo. En los ejemplos (14a) y (b), cada una de las construcciones de objeto doble se alterna con construcciones NP + PP.

Beck y Johnson muestran que el objeto en (15a) tiene una relación diferente con el verbo de movimiento, ya que no es capaz de transmitir el significado de HAVING que el poseedor (9a) y (15a) sí puede. En (15a), Satoshi es un poseedor animado y por eso tiene kisimen. El PP para Satoshi en (15b) es de naturaleza benéfica y tampoco necesariamente conlleva este significado de TENER.

Por tanto, las estructuras subyacentes no son las mismas. Las diferencias residen en la semántica y la sintaxis de las frases, a diferencia de la teoría transformacional de Larson. Se proporciona más evidencia de la existencia estructural de capas VP con una unidad verbal invisible en la aplicación del complemento o modificador "otra vez". La oración (16) es ambigua y al examinar los dos significados diferentes se revela una diferencia en la estructura.

Sin embargo, en (17a), queda claro que fue Sally quien repitió la acción de abrir la puerta. En (17b), el evento está en la puerta que se abre y Sally puede haberla abierto o no previamente. Para traducir estos dos significados diferentes, "nuevamente" se asocia a VP en dos lugares diferentes y, por lo tanto, describe dos eventos con un cambio puramente estructural.

{{cite journal}}: Citar diario requiere |journal=( ayuda ){{cite book}}: |journal=ignorado ( ayuda ){{cite journal}}: Citar diario requiere |journal=( ayuda )