En física de partículas , la electrodinámica cuántica ( EDQ ) es la teoría cuántica de campos relativista de la electrodinámica . [1] [2] [3] En esencia, describe cómo interactúan la luz y la materia y es la primera teoría en la que se logra un acuerdo completo entre la mecánica cuántica y la relatividad especial . [2] La EQQ describe matemáticamente todos los fenómenos que involucran partículas cargadas eléctricamente que interactúan mediante el intercambio de fotones y representa la contraparte cuántica del electromagnetismo clásico , brindando una explicación completa de la interacción de la materia y la luz. [2] [3]

En términos técnicos, la QED puede describirse como una forma muy precisa de calcular la probabilidad de la posición y el movimiento de partículas, incluso aquellas sin masa como los fotones, y la cantidad que depende de la posición (campo) de esas partículas, y describió la luz y la materia más allá de la dualidad onda-partícula propuesta por Albert Einstein en 1905. Richard Feynman la llamó "la joya de la física" por sus predicciones extremadamente precisas de cantidades como el momento magnético anómalo del electrón y el desplazamiento Lamb de los niveles de energía del hidrógeno . [2] : Ch1 Es la teoría más precisa y rigurosamente probada en física. [4] [5]

La primera formulación de una teoría cuántica que describe la interacción entre la radiación y la materia se atribuye al científico británico Paul Dirac , quien (durante la década de 1920) pudo calcular el coeficiente de emisión espontánea de un átomo . [6] También se le atribuye la invención del término "electrodinámica cuántica". [7]

Dirac describió la cuantificación del campo electromagnético como un conjunto de osciladores armónicos con la introducción del concepto de operadores de creación y aniquilación de partículas. En los años siguientes, con contribuciones de Wolfgang Pauli , Eugene Wigner , Pascual Jordan , Werner Heisenberg y una elegante formulación de la electrodinámica cuántica por Enrico Fermi , [8] los físicos llegaron a creer que, en principio, sería posible realizar cualquier cálculo para cualquier proceso físico que involucrara fotones y partículas cargadas. Sin embargo, estudios posteriores de Felix Bloch con Arnold Nordsieck , [9] y Victor Weisskopf , [10] en 1937 y 1939, revelaron que tales cálculos eran confiables solo en un primer orden de teoría de perturbación , un problema ya señalado por Robert Oppenheimer . [11] En órdenes superiores en la serie surgieron los infinitos, haciendo que tales cálculos carecieran de sentido y arrojando serias dudas sobre la consistencia interna de la teoría misma. Como en ese momento no se conocía ninguna solución para este problema, parecía que existía una incompatibilidad fundamental entre la relatividad especial y la mecánica cuántica .

Las dificultades con la teoría aumentaron hasta finales de la década de 1940. Las mejoras en la tecnología de microondas permitieron tomar medidas más precisas del desplazamiento de los niveles de un átomo de hidrógeno , [12] ahora conocido como desplazamiento Lamb y momento magnético del electrón. [13] Estos experimentos expusieron discrepancias que la teoría no podía explicar.

Una primera indicación de una posible salida fue dada por Hans Bethe en 1947, [14] después de asistir a la Conferencia de Shelter Island . [15] Mientras viajaba en tren desde la conferencia a Schenectady, realizó el primer cálculo no relativista del desplazamiento de las líneas del átomo de hidrógeno medido por Lamb y Retherford . [14] A pesar de las limitaciones del cálculo, el acuerdo fue excelente. La idea era simplemente adjuntar infinitos a las correcciones de masa y carga que en realidad estaban fijadas a un valor finito por experimentos. De esta manera, los infinitos se absorben en esas constantes y producen un resultado finito en buen acuerdo con los experimentos. Este procedimiento se denominó renormalización .

Basándose en la intuición de Bethe y en los artículos fundamentales sobre el tema de Shin'ichirō Tomonaga , [16] Julian Schwinger , [17] [18] Richard Feynman [1] [19] [20] y Freeman Dyson , [21] [22] finalmente fue posible obtener formulaciones completamente covariantes que fueran finitas en cualquier orden en una serie de perturbaciones de la electrodinámica cuántica. Shin'ichirō Tomonaga, Julian Schwinger y Richard Feynman fueron galardonados conjuntamente con el Premio Nobel de Física de 1965 por su trabajo en esta área. [23] Sus contribuciones, y las de Freeman Dyson , fueron sobre formulaciones covariantes e invariantes de calibre de la electrodinámica cuántica que permiten cálculos de observables en cualquier orden de la teoría de perturbaciones . La técnica matemática de Feynman, basada en sus diagramas , inicialmente parecía muy diferente del enfoque teórico de campos y basado en operadores de Schwinger y Tomonaga, pero Freeman Dyson demostró más tarde que los dos enfoques eran equivalentes. [21] La renormalización , la necesidad de adjuntar un significado físico a ciertas divergencias que aparecen en la teoría a través de integrales , se ha convertido posteriormente en uno de los aspectos fundamentales de la teoría cuántica de campos y ha llegado a ser vista como un criterio para la aceptabilidad general de una teoría. Aunque la renormalización funciona muy bien en la práctica, Feynman nunca se sintió del todo cómodo con su validez matemática, llegando incluso a referirse a la renormalización como un "juego de trileros" y un "abracadabra". [2] : 128

Por tanto, ni Feynman ni Dirac estaban contentos con esa manera de abordar las observaciones realizadas en física teórica, sobre todo en mecánica cuántica. [24]

La QED ha servido como modelo y plantilla para todas las teorías cuánticas de campos posteriores. Una de esas teorías posteriores es la cromodinámica cuántica , que comenzó a principios de la década de 1960 y alcanzó su forma actual en el trabajo de la década de 1970 de H. David Politzer , Sidney Coleman , David Gross y Frank Wilczek . Basándose en el trabajo pionero de Schwinger , Gerald Guralnik , Dick Hagen y Tom Kibble , [25] [26] Peter Higgs , Jeffrey Goldstone y otros, Sheldon Glashow , Steven Weinberg y Abdus Salam demostraron de forma independiente cómo la fuerza nuclear débil y la electrodinámica cuántica podían fusionarse en una única fuerza electrodébil .

Hacia el final de su vida, Richard Feynman dio una serie de conferencias sobre la QED destinadas al público en general. Estas conferencias fueron transcritas y publicadas como Feynman (1985), QED: The Strange Theory of Light and Matter [2] , una exposición clásica no matemática de la QED desde el punto de vista que se articula a continuación.

Los componentes clave de la presentación de Feynman de la QED son tres acciones básicas. [2] : 85

Estas acciones se representan en forma de abreviatura visual mediante los tres elementos básicos de los diagramas : una línea ondulada para el fotón, una línea recta para el electrón y una unión de dos líneas rectas y una ondulada para un vértice que representa la emisión o absorción de un fotón por un electrón. Todos ellos se pueden ver en el diagrama adyacente.

Además de la abreviatura visual para las acciones, Feynman introduce otro tipo de abreviatura para las cantidades numéricas llamadas amplitudes de probabilidad. La probabilidad es el cuadrado del valor absoluto de la amplitud de probabilidad total, . Si un fotón se mueve de un lugar y tiempo a otro lugar y tiempo , la cantidad asociada se escribe en la abreviatura de Feynman como , y depende solo del momento y la polarización del fotón. La cantidad similar para un electrón que se mueve de a se escribe . Depende del momento y la polarización del electrón, además de una constante que Feynman llama n , a veces llamada la masa "desnuda" del electrón: está relacionada con, pero no es lo mismo que, la masa medida del electrón. Finalmente, la cantidad que nos dice sobre la amplitud de probabilidad de que un electrón emita o absorba un fotón Feynman la llama j , y a veces se llama la carga "desnuda" del electrón: es una constante, y está relacionada con, pero no es lo mismo que, la carga medida del electrón e . [2] : 91

La QED se basa en el supuesto de que las interacciones complejas de muchos electrones y fotones pueden representarse juntando una colección adecuada de los tres bloques de construcción anteriores y luego utilizando las amplitudes de probabilidad para calcular la probabilidad de cualquier interacción compleja de ese tipo. Resulta que la idea básica de la QED puede comunicarse asumiendo que el cuadrado del total de las amplitudes de probabilidad mencionadas anteriormente ( P ( A a B ), E ( C a D ) y j ) actúa exactamente como nuestra probabilidad cotidiana (una simplificación hecha en el libro de Feynman). Más adelante, esto se corregirá para incluir específicamente matemáticas de estilo cuántico, siguiendo a Feynman.

Las reglas básicas de amplitudes de probabilidad que se utilizarán son: [2] : 93

El criterio de indistinguibilidad en (a) es muy importante: significa que no hay ninguna característica observable presente en el sistema dado que de alguna manera "revele" qué alternativa se toma. En tal caso, no se puede observar qué alternativa ocurre realmente sin cambiar la configuración experimental de alguna manera (por ejemplo, introduciendo un nuevo aparato en el sistema). Siempre que se puede observar qué alternativa ocurre, se encuentra que la probabilidad del evento es la suma de las probabilidades de las alternativas. De hecho, si este no fuera el caso, el término "alternativas" para describir estos procesos sería inadecuado. Lo que (a) dice es que una vez que se eliminan los medios físicos para observar qué alternativa ocurrió , no se puede decir que el evento está ocurriendo a través de "exactamente una de las alternativas" en el sentido de sumar probabilidades; en cambio, se deben sumar las amplitudes. [2] : 82

De manera similar, el criterio de independencia en (b) es muy importante: sólo se aplica a procesos que no están "entrelazados".

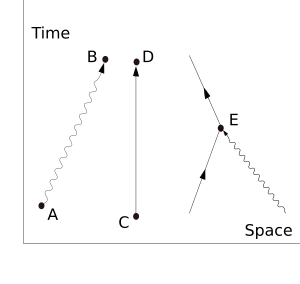

Supongamos que empezamos con un electrón en un lugar y tiempo determinados (a este lugar y tiempo se le da la etiqueta arbitraria A ) y un fotón en otro lugar y tiempo (a este lugar y tiempo se le da la etiqueta B ). Una pregunta típica desde un punto de vista físico es: "¿Cuál es la probabilidad de encontrar un electrón en C (otro lugar y un tiempo posterior) y un fotón en D (otro lugar y tiempo más)?". El proceso más simple para lograr este fin es que el electrón se mueva de A a C (una acción elemental) y que el fotón se mueva de B a D (otra acción elemental). A partir del conocimiento de las amplitudes de probabilidad de cada uno de estos subprocesos - E ( A a C ) y P ( B a D ) - esperaríamos calcular la amplitud de probabilidad de que ambos ocurran juntos multiplicándolos, utilizando la regla b) anterior. Esto da una amplitud de probabilidad general estimada simple, que se eleva al cuadrado para dar una probabilidad estimada. [ cita requerida ]

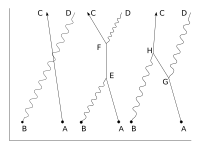

Pero hay otras formas en las que el resultado podría producirse. El electrón podría moverse a un lugar y tiempo E , donde absorbe el fotón; luego seguir adelante antes de emitir otro fotón en F ; luego seguir a C , donde es detectado, mientras que el nuevo fotón sigue adelante a D . La probabilidad de este complejo proceso puede calcularse de nuevo conociendo las amplitudes de probabilidad de cada una de las acciones individuales: tres acciones de electrones, dos acciones de fotones y dos vértices, uno de emisión y uno de absorción. Esperaríamos encontrar la amplitud de probabilidad total multiplicando las amplitudes de probabilidad de cada una de las acciones, para cualquier posición elegida de E y F . Luego, utilizando la regla a) anterior, tenemos que sumar todas estas amplitudes de probabilidad para todas las alternativas para E y F . (Esto no es elemental en la práctica e implica integración .) Pero hay otra posibilidad, que es que el electrón se mueva primero a G , donde emite un fotón, que continúa hacia D , mientras que el electrón se mueve hacia H , donde absorbe el primer fotón, antes de moverse hacia C. Nuevamente, podemos calcular la amplitud de probabilidad de estas posibilidades (para todos los puntos G y H ). Entonces tenemos una mejor estimación para la amplitud de probabilidad total sumando las amplitudes de probabilidad de estas dos posibilidades a nuestra estimación simple original. Por cierto, el nombre que se le da a este proceso de un fotón que interactúa con un electrón de esta manera es dispersión Compton . [ cita requerida ]

Existe una infinidad de otros procesos "virtuales" intermedios en los que se absorben y/o emiten cada vez más fotones. Para cada uno de estos procesos se podría dibujar un diagrama de Feynman que lo describiera. Esto implica un cálculo complejo para las amplitudes de probabilidad resultantes, pero siempre que se dé el caso de que cuanto más complicado sea el diagrama, menos contribuya al resultado, es sólo cuestión de tiempo y esfuerzo encontrar una respuesta tan precisa como se desee a la pregunta original. Éste es el enfoque básico de la QED. Para calcular la probabilidad de cualquier proceso interactivo entre electrones y fotones, es cuestión de anotar primero, con diagramas de Feynman, todas las formas posibles en que se puede construir el proceso a partir de los tres elementos básicos. Cada diagrama implica algún cálculo que implica reglas definidas para encontrar la amplitud de probabilidad asociada.

Ese andamiaje básico se mantiene cuando se pasa a una descripción cuántica, pero se necesitan algunos cambios conceptuales. Uno de ellos es que, mientras que en nuestra vida cotidiana podríamos esperar que existieran algunas restricciones sobre los puntos a los que una partícula puede moverse, eso no es cierto en la electrodinámica cuántica completa. Existe una amplitud de probabilidad distinta de cero de que un electrón en A o un fotón en B se desplacen como acción básica a cualquier otro lugar y tiempo en el universo . Eso incluye lugares a los que solo se podría llegar a velocidades mayores que la de la luz y también tiempos anteriores . (Un electrón que se mueve hacia atrás en el tiempo puede verse como un positrón que se mueve hacia adelante en el tiempo.) [2] : 89, 98–99

La mecánica cuántica introduce un cambio importante en la forma en que se calculan las probabilidades. Las probabilidades todavía se representan mediante los números reales habituales que utilizamos para las probabilidades en nuestro mundo cotidiano, pero se calculan como el módulo cuadrado de las amplitudes de probabilidad , que son números complejos .

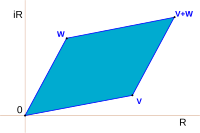

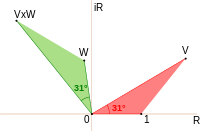

Feynman evita exponer al lector a las matemáticas de los números complejos al utilizar una representación simple pero precisa de ellos como flechas en una hoja de papel o en una pantalla. (Estas no deben confundirse con las flechas de los diagramas de Feynman, que son representaciones simplificadas en dos dimensiones de una relación entre puntos en tres dimensiones del espacio y una del tiempo). Las flechas de amplitud son fundamentales para la descripción del mundo dada por la teoría cuántica. Están relacionadas con nuestras ideas cotidianas de probabilidad por la simple regla de que la probabilidad de un evento es el cuadrado de la longitud de la flecha de amplitud correspondiente. Entonces, para un proceso dado, si están involucradas dos amplitudes de probabilidad, v y w , la probabilidad del proceso estará dada por

o

Sin embargo, las reglas en lo que respecta a la suma o multiplicación son las mismas que las anteriores. Pero donde se esperaría sumar o multiplicar probabilidades, en cambio se suman o multiplican amplitudes de probabilidad que ahora son números complejos.

La suma y la multiplicación son operaciones comunes en la teoría de números complejos y se dan en las figuras. La suma se encuentra de la siguiente manera. Sea el inicio de la segunda flecha al final de la primera. La suma es entonces una tercera flecha que va directamente desde el inicio de la primera hasta el final de la segunda. El producto de dos flechas es una flecha cuya longitud es el producto de las dos longitudes. La dirección del producto se encuentra sumando los ángulos que cada una de las dos ha sido girada con respecto a una dirección de referencia: eso da el ángulo que el producto está girado con respecto a la dirección de referencia.

Ese cambio, de probabilidades a amplitudes de probabilidad, complica las matemáticas sin cambiar el enfoque básico. Pero ese cambio todavía no es suficiente porque no tiene en cuenta el hecho de que tanto los fotones como los electrones pueden polarizarse, lo que significa que deben tenerse en cuenta sus orientaciones en el espacio y el tiempo. Por lo tanto, P ( A a B ) consta de 16 números complejos o flechas de amplitud de probabilidad. [2] : 120–121 También hay algunos cambios menores relacionados con la cantidad j , que puede tener que rotarse por un múltiplo de 90° para algunas polarizaciones, lo que solo es de interés para la contabilidad detallada.

Asociado con el hecho de que el electrón puede ser polarizado hay otro pequeño detalle necesario, que está conectado con el hecho de que un electrón es un fermión y obedece a la estadística de Fermi-Dirac . La regla básica es que si tenemos la amplitud de probabilidad para un proceso complejo dado que involucra más de un electrón, entonces cuando incluimos (como siempre debemos) el diagrama de Feynman complementario en el que intercambiamos dos eventos electrónicos, la amplitud resultante es la inversa -la negativa- de la primera. El caso más simple sería dos electrones comenzando en A y B terminando en C y D. La amplitud se calcularía como la "diferencia", E ( A a D ) × E ( B a C ) − E ( A a C ) × E ( B a D ) , donde esperaríamos, de nuestra idea cotidiana de probabilidades, que fuera una suma. [2] : 112–113

Finalmente, hay que calcular P ( A a B ) y E ( C a D ) correspondientes a las amplitudes de probabilidad para el fotón y el electrón respectivamente. Estas son esencialmente las soluciones de la ecuación de Dirac , que describe el comportamiento de la amplitud de probabilidad del electrón y las ecuaciones de Maxwell , que describen el comportamiento de la amplitud de probabilidad del fotón. Estas se denominan propagadores de Feynman . La traducción a una notación comúnmente utilizada en la literatura estándar es la siguiente:

donde un símbolo abreviado como representa los cuatro números reales que dan el tiempo y la posición en tres dimensiones del punto denominado A.

Históricamente surgió un problema que detuvo el progreso durante veinte años: aunque empecemos con el supuesto de tres acciones básicas "simples", las reglas del juego dicen que si queremos calcular la amplitud de probabilidad de que un electrón llegue de A a B , debemos tener en cuenta todas las formas posibles: todos los diagramas de Feynman posibles con esos puntos finales. Así, habrá una forma en la que el electrón viajará a C , emitirá un fotón allí y luego lo absorberá de nuevo en D antes de pasar a B. O podría hacer este tipo de cosas dos veces, o más. En resumen, tenemos una situación de tipo fractal en la que si observamos de cerca una línea, se descompone en una colección de líneas "simples", cada una de las cuales, si se mira de cerca, está compuesta a su vez de líneas "simples", y así sucesivamente hasta el infinito . Esta es una situación difícil de manejar. Si agregar ese detalle solo alterara las cosas ligeramente, entonces no habría sido tan malo, pero el desastre se produjo cuando se descubrió que la simple corrección mencionada anteriormente conducía a amplitudes de probabilidad infinitas . Con el tiempo, este problema se "arregló" mediante la técnica de la renormalización . Sin embargo, el propio Feynman no estaba satisfecho con ella y la llamó un "proceso descuidado" [2] : 128 , y Dirac también criticó este procedimiento porque "en matemáticas uno no se deshace de los infinitos cuando no le agradan". [24]

En el marco de referencia antes mencionado, los físicos pudieron calcular con un alto grado de precisión algunas de las propiedades de los electrones, como el momento dipolar magnético anómalo . Sin embargo, como señala Feynman, esto no explica por qué partículas como el electrón tienen las masas que tienen. "No existe ninguna teoría que explique adecuadamente estos números. Usamos los números en todas nuestras teorías, pero no los entendemos: qué son o de dónde vienen. Creo que, desde un punto de vista fundamental, este es un problema muy interesante y serio". [2] : 152

Matemáticamente, la QED es una teoría de calibración abeliana con el grupo de simetría U(1) , definido en el espacio de Minkowski (espacio-tiempo plano). El campo de calibración , que media la interacción entre los campos de espín 1/2 cargados , es el campo electromagnético . El lagrangiano de la QED para un campo de espín 1/2 que interactúa con el campo electromagnético en unidades naturales da lugar a la acción [27] : 78

dónde

La expansión de la derivada covariante revela una segunda forma útil del lagrangiano (campo externo establecido en cero para simplificar)

donde es la corriente conservada que surge del teorema de Noether. Se escribe

Desarrollando la derivada covariante en el lagrangiano obtenemos

Para simplificar, se ha establecido en cero. Alternativamente, podemos absorber en un nuevo campo de calibración y volver a etiquetar el nuevo campo como

A partir de este Lagrangiano, se pueden obtener las ecuaciones de movimiento para los campos y .

Estos surgen de manera más directa al considerar la ecuación de Euler-Lagrange para . Dado que el lagrangiano no contiene términos, obtenemos inmediatamente

Así que la ecuación de movimiento se puede escribir

Las derivadas esta vez son

Sustituyendo nuevamente en ( 3 ) obtenemos

que puede escribirse en términos de la corriente como

Ahora bien, si imponemos la condición de calibre de Lorenz, las ecuaciones se reducen a que es una ecuación de onda para el potencial cuatrienal, la versión QED de las ecuaciones clásicas de Maxwell en el calibre de Lorenz . (El cuadrado representa el operador de onda , .)

Esta teoría se puede cuantificar directamente tratando los sectores bosónico y fermiónico [ aclaración necesaria ] como libres. Esto nos permite construir un conjunto de estados asintóticos que se pueden utilizar para iniciar el cálculo de las amplitudes de probabilidad para diferentes procesos. Para ello, tenemos que calcular un operador de evolución que, para un estado inicial dado, dará un estado final de tal manera que tenga [27] : 5

Esta técnica también se conoce como matriz S. El operador de evolución se obtiene en la imagen de interacción , donde la evolución temporal está dada por el hamiltoniano de interacción, que es la integral en el espacio del segundo término en la densidad lagrangiana dada anteriormente: [27] : 123

y así, se tiene [27] : 86

donde T es el operador de ordenación temporal . Este operador de evolución solo tiene sentido como serie, y lo que obtenemos aquí es una serie de perturbaciones con la constante de estructura fina como parámetro de desarrollo. Esta serie se denomina serie de Dyson .

A pesar de la claridad conceptual de este enfoque de Feynman para la QED, casi ningún libro de texto temprano lo sigue en su presentación. Al realizar cálculos, es mucho más fácil trabajar con las transformadas de Fourier de los propagadores . Las pruebas experimentales de la electrodinámica cuántica son típicamente experimentos de dispersión. En la teoría de la dispersión, se consideran los momentos de las partículas en lugar de sus posiciones, y es conveniente pensar en las partículas como creadas o aniquiladas cuando interactúan. Los diagramas de Feynman entonces parecen iguales, pero las líneas tienen diferentes interpretaciones. La línea del electrón representa un electrón con una energía y un momento dados, con una interpretación similar de la línea del fotón. Un diagrama de vértices representa la aniquilación de un electrón y la creación de otro junto con la absorción o creación de un fotón, cada uno con energías y momentos específicos.

Utilizando el teorema de Wick sobre los términos de la serie de Dyson, todos los términos de la matriz S para la electrodinámica cuántica pueden calcularse mediante la técnica de los diagramas de Feynman . En este caso, las reglas para su dibujo son las siguientes [27] : 801–802

A estas reglas debemos añadir otra más para bucles cerrados que implica una integración en los momentos , ya que estas partículas internas ("virtuales") no están limitadas a ninguna energía-momento específica, ni siquiera la que suele requerir la relatividad especial (véase Propagador para más detalles). La firma de la métrica es .

A partir de ellos, los cálculos de amplitudes de probabilidad se dan de forma sencilla. Un ejemplo es la dispersión Compton , con un electrón y un fotón sometidos a dispersión elástica . Los diagramas de Feynman son en este caso [27] : 158–159

y así podemos obtener la amplitud correspondiente en el primer orden de una serie de perturbaciones para la matriz S :

a partir de lo cual podemos calcular la sección transversal para esta dispersión.

El éxito predictivo de la electrodinámica cuántica se basa en gran medida en el uso de la teoría de perturbaciones, expresada en diagramas de Feynman. Sin embargo, la electrodinámica cuántica también conduce a predicciones más allá de la teoría de perturbaciones. En presencia de campos eléctricos muy fuertes, predice que los electrones y positrones se producirán espontáneamente, lo que provocará la desintegración del campo. Este proceso, llamado efecto Schwinger , [28] no se puede entender en términos de ningún número finito de diagramas de Feynman y, por lo tanto, se describe como no perturbativo . Matemáticamente, se puede derivar mediante una aproximación semiclásica a la integral de trayectoria de la electrodinámica cuántica.

Los términos de orden superior se pueden calcular directamente para el operador de evolución, pero estos términos muestran diagramas que contienen los siguientes términos más simples [27] : cap. 10

que, al ser bucles cerrados, implican la presencia de integrales divergentes que no tienen significado matemático. Para superar esta dificultad, se ha ideado una técnica llamada renormalización , que produce resultados finitos en concordancia muy cercana con los experimentos. Un criterio para que la teoría sea significativa después de la renormalización es que el número de diagramas divergentes sea finito. En este caso, se dice que la teoría es "renormalizable". La razón de esto es que para obtener observables renormalizados, se necesita un número finito de constantes para mantener intacto el valor predictivo de la teoría. Este es exactamente el caso de la electrodinámica cuántica que muestra solo tres diagramas divergentes. Este procedimiento proporciona observables en concordancia muy cercana con el experimento como se ve, por ejemplo, para la relación giromagnética del electrón .

La renormalizabilidad se ha convertido en un criterio esencial para que una teoría cuántica de campos sea considerada viable. Todas las teorías que describen interacciones fundamentales , excepto la gravitación , cuya contraparte cuántica es sólo conjetural y actualmente está siendo objeto de una investigación muy activa, son teorías renormalizables.

Un argumento de Freeman Dyson muestra que el radio de convergencia de la serie de perturbaciones en QED es cero. [29] El argumento básico es el siguiente: si la constante de acoplamiento fuera negativa, esto sería equivalente a que la constante de fuerza de Coulomb fuera negativa. Esto "invertiría" la interacción electromagnética de modo que las cargas iguales se atraerían y las cargas diferentes se repelerían . Esto haría que el vacío fuera inestable frente a la desintegración en un cúmulo de electrones en un lado del universo y un cúmulo de positrones en el otro lado del universo. Debido a que la teoría es "enferma" para cualquier valor negativo de la constante de acoplamiento, la serie no converge sino que, en el mejor de los casos, es una serie asintótica .

Desde una perspectiva moderna, decimos que la QED no está bien definida como una teoría cuántica de campos para energías arbitrariamente altas. [30] La constante de acoplamiento se extiende hasta el infinito a energía finita, lo que indica un polo de Landau . El problema es esencialmente que la QED parece sufrir problemas de trivialidad cuántica . Esta es una de las motivaciones para incorporar la QED dentro de una Gran Teoría Unificada .

Esta teoría puede extenderse, al menos como teoría clásica de campos, al espacio-tiempo curvo. Esto surge de manera similar al caso del espacio-tiempo plano, al acoplar una teoría electromagnética libre a una teoría de fermiones libres e incluir una interacción que promueva la derivada parcial en la teoría de fermiones a una derivada covariante de calibración.