El análisis de supervivencia es una rama de la estadística que analiza la duración esperada del tiempo hasta que ocurre un evento, como la muerte en organismos biológicos o la falla en sistemas mecánicos. Este tema se llama teoría de la confiabilidad , análisis de la confiabilidad o ingeniería de la confiabilidad en ingeniería , análisis de la duración o modelado de la duración en economía y análisis del historial de eventos en sociología . El análisis de supervivencia intenta responder ciertas preguntas, como ¿cuál es la proporción de una población que sobrevivirá más allá de cierto tiempo? De los que sobreviven, ¿a qué tasa morirán o fallarán? ¿Se pueden tener en cuenta múltiples causas de muerte o falla? ¿Cómo aumentan o disminuyen las circunstancias o características particulares la probabilidad de supervivencia ?

Para responder a estas preguntas, es necesario definir el concepto de "duración de la vida". En el caso de la supervivencia biológica, la muerte es inequívoca, pero en el caso de la fiabilidad mecánica, el fallo puede no estar bien definido, ya que puede haber sistemas mecánicos en los que el fallo sea parcial, una cuestión de grado o no localizado en el tiempo . Incluso en los problemas biológicos, algunos acontecimientos (por ejemplo, un ataque cardíaco o una falla de otro órgano) pueden tener la misma ambigüedad. La teoría que se describe a continuación supone acontecimientos bien definidos en momentos específicos; otros casos pueden tratarse mejor con modelos que tengan en cuenta explícitamente los acontecimientos ambiguos.

En términos más generales, el análisis de supervivencia implica la modelización de los datos de tiempo hasta el evento; en este contexto, la muerte o el fracaso se consideran un "evento" en la literatura de análisis de supervivencia; tradicionalmente, solo ocurre un único evento para cada sujeto, después del cual el organismo o mecanismo muere o se rompe. Los modelos de eventos recurrentes o eventos repetidos flexibilizan ese supuesto. El estudio de eventos recurrentes es relevante en la confiabilidad de los sistemas y en muchas áreas de las ciencias sociales y la investigación médica.

El análisis de supervivencia se utiliza de varias maneras:

Los siguientes términos se utilizan comúnmente en los análisis de supervivencia:

Este ejemplo utiliza el conjunto de datos de supervivencia de leucemia mielógena aguda "aml" del paquete "survival" de R. El conjunto de datos es de Miller (1997) [1] y la pregunta es si el tratamiento estándar de quimioterapia debería extenderse ('mantenerse') durante ciclos adicionales.

El conjunto de datos aml ordenados por tiempo de supervivencia se muestra en el cuadro.

La última observación (11), a las 161 semanas, está censurada. La censura indica que el paciente no tuvo un evento (no hubo recurrencia del cáncer de leucemia mieloide aguda). Otro sujeto, la observación 3, fue censurado a las 13 semanas (indicado por el estado = 0). Este sujeto estuvo en el estudio solo durante 13 semanas, y el cáncer de leucemia mieloide aguda no recurrió durante esas 13 semanas. Es posible que este paciente haya sido incluido cerca del final del estudio, de modo que pudiera ser observado solo durante 13 semanas. También es posible que el paciente haya sido incluido al principio del estudio, pero se haya perdido el seguimiento o se haya retirado del estudio. La tabla muestra que otros sujetos fueron censurados a las 16, 28 y 45 semanas (observaciones 17, 6 y 9 con estado = 0). Todos los sujetos restantes experimentaron eventos (recurrencia del cáncer de leucemia mieloide aguda) mientras estaban en el estudio. La pregunta de interés es si la recurrencia ocurre más tarde en los pacientes mantenidos que en los pacientes no mantenidos.

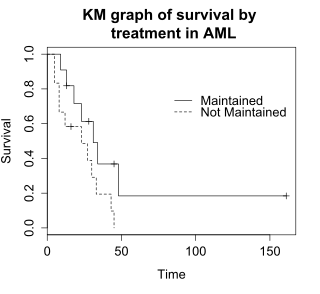

La función de supervivencia S ( t ) es la probabilidad de que un sujeto sobreviva más tiempo que t . S ( t ) es teóricamente una curva suave, pero normalmente se estima utilizando la curva de Kaplan-Meier (KM). El gráfico muestra la curva de KM para los datos de aml y se puede interpretar de la siguiente manera:

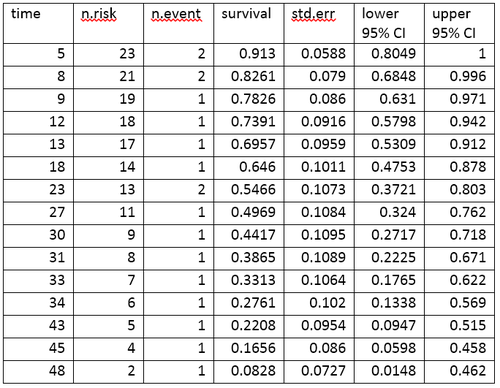

Una tabla de vida resume los datos de supervivencia en términos de la cantidad de eventos y la proporción de sobrevivientes en cada punto temporal del evento. Se muestra la tabla de vida para los datos de aml, creada con el software R.

La tabla de vida resume los eventos y la proporción de sobrevivientes en cada momento del evento. Las columnas de la tabla de vida tienen la siguiente interpretación:

La prueba de rangos logarítmicos compara los tiempos de supervivencia de dos o más grupos. Este ejemplo utiliza una prueba de rangos logarítmicos para determinar la diferencia en la supervivencia entre los grupos de tratamiento mantenido y no mantenido en los datos de leucemia mieloide aguda. El gráfico muestra los gráficos de KM para los datos de leucemia mieloide aguda desglosados por grupo de tratamiento, lo que se indica mediante la variable "x" en los datos.

La hipótesis nula para una prueba de log-rank es que los grupos tienen la misma supervivencia. El número esperado de sujetos que sobreviven en cada punto temporal de cada uno se ajusta al número de sujetos en riesgo en los grupos en cada momento del evento. La prueba de log-rank determina si el número observado de eventos en cada grupo es significativamente diferente del número esperado. La prueba formal se basa en una estadística de chi-cuadrado. Cuando la estadística de log-rank es grande, es evidencia de una diferencia en los tiempos de supervivencia entre los grupos. La estadística de log-rank tiene aproximadamente una distribución de chi-cuadrado con un grado de libertad, y el valor p se calcula utilizando la prueba de chi-cuadrado .

Para los datos de ejemplo, la prueba de log-rank para la diferencia en supervivencia arroja un valor p de p=0,0653, lo que indica que los grupos de tratamiento no difieren significativamente en cuanto a supervivencia, suponiendo un nivel alfa de 0,05. El tamaño de la muestra de 23 sujetos es modesto, por lo que hay poco poder para detectar diferencias entre los grupos de tratamiento. La prueba de chi-cuadrado se basa en una aproximación asintótica, por lo que el valor p debe considerarse con cautela para tamaños de muestra pequeños .

Las curvas de Kaplan-Meier y las pruebas de log-rank son más útiles cuando la variable predictora es categórica (p. ej., fármaco frente a placebo) o toma una pequeña cantidad de valores (p. ej., dosis de fármaco de 0, 20, 50 y 100 mg/día) que pueden tratarse como categóricas. La prueba de log-rank y las curvas KM no funcionan fácilmente con predictores cuantitativos como la expresión genética, el recuento de glóbulos blancos o la edad. Para las variables predictoras cuantitativas, un método alternativo es el análisis de regresión de riesgos proporcionales de Cox . Los modelos de Cox PH también funcionan con variables predictoras categóricas, que se codifican como variables indicadoras {0,1} o variables ficticias. La prueba de log-rank es un caso especial de un análisis de Cox PH y se puede realizar utilizando el software de Cox PH.

Este ejemplo utiliza el conjunto de datos de melanoma del Capítulo 14 de Dalgaard. [2]

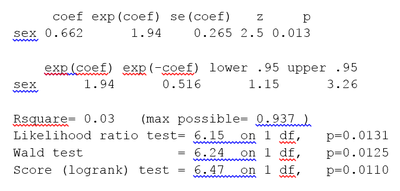

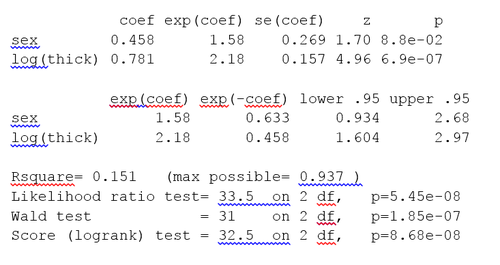

Los datos se encuentran en el paquete R ISwR. La regresión de riesgos proporcionales de Cox con R arroja los resultados que se muestran en el recuadro.

Los resultados de la regresión de Cox se interpretan de la siguiente manera.

El resultado resumido también proporciona intervalos de confianza superior e inferior del 95 % para el cociente de riesgo: límite inferior del 95 % = 1,15; límite superior del 95 % = 3,26.

Finalmente, el resultado proporciona valores p para tres pruebas alternativas de significancia general del modelo:

Estas tres pruebas son asintóticamente equivalentes. Para un N suficientemente grande, darán resultados similares. Para un N pequeño, pueden diferir un poco. La última fila, "Prueba de puntuación (logrank)" es el resultado de la prueba log-rank, con p=0,011, el mismo resultado que la prueba log-rank, porque la prueba log-rank es un caso especial de una regresión de Cox PH. La prueba de razón de verosimilitud tiene un mejor comportamiento para tamaños de muestra pequeños, por lo que generalmente se prefiere.

El modelo de Cox extiende la prueba de log-rank al permitir la inclusión de covariables adicionales. [3] Este ejemplo utiliza el conjunto de datos de melanoma donde las variables predictoras incluyen una covariable continua, el grosor del tumor (nombre de la variable = "grueso").

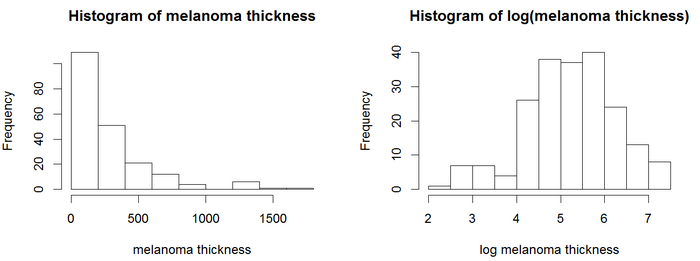

En los histogramas, los valores de espesor están sesgados positivamente y no tienen una distribución de probabilidad simétrica similar a la de Gauss . Los modelos de regresión, incluido el modelo de Cox, generalmente brindan resultados más confiables con variables distribuidas normalmente. [ cita requerida ] Para este ejemplo, podemos usar una transformación logarítmica . El logaritmo del espesor del tumor parece estar distribuido de manera más normal, por lo que los modelos de Cox usarán el logaritmo del espesor. El análisis de pH de Cox brinda los resultados en el recuadro.

El valor p para las tres pruebas generales (probabilidad, Wald y puntuación) es significativo, lo que indica que el modelo es significativo. El valor p para log(thick) es 6,9e-07, con un cociente de riesgo HR = exp(coef) = 2,18, lo que indica una fuerte relación entre el grosor del tumor y un mayor riesgo de muerte.

En cambio, el valor p para el sexo es ahora p=0,088. El cociente de riesgo HR = exp(coef) = 1,58, con un intervalo de confianza del 95% de 0,934 a 2,68. Como el intervalo de confianza para el HR incluye 1, estos resultados indican que el sexo hace una contribución menor a la diferencia en el HR después de controlar el grosor del tumor, y solo tiende hacia la significación. El examen de los gráficos de log(grosor) por sexo y una prueba t de log(grosor) por sexo indican que existe una diferencia significativa entre hombres y mujeres en el grosor del tumor cuando ven por primera vez al médico.

El modelo de Cox supone que los riesgos son proporcionales. La hipótesis de riesgo proporcional se puede probar utilizando la función R cox.zph(). Un valor p inferior a 0,05 indica que los riesgos no son proporcionales. Para los datos de melanoma obtenemos p=0,222. Por lo tanto, no podemos rechazar la hipótesis nula de que los riesgos sean proporcionales. En los libros de texto citados se describen pruebas y gráficos adicionales para examinar un modelo de Cox.

Los modelos de Cox se pueden ampliar para abordar variaciones en el análisis simple.

El modelo de regresión de Cox PH es un modelo lineal. Es similar a la regresión lineal y a la regresión logística. En concreto, estos métodos suponen que una única línea, curva, plano o superficie es suficiente para separar grupos (vivos, muertos) o para estimar una respuesta cuantitativa (tiempo de supervivencia).

En algunos casos, las particiones alternativas brindan una clasificación o estimaciones cuantitativas más precisas. Un conjunto de métodos alternativos son los modelos de supervivencia estructurados en árbol [4] [5] [6], incluidos los bosques aleatorios de supervivencia. [7] Los modelos de supervivencia estructurados en árbol pueden brindar predicciones más precisas que los modelos de Cox. Examinar ambos tipos de modelos para un conjunto de datos determinado es una estrategia razonable.

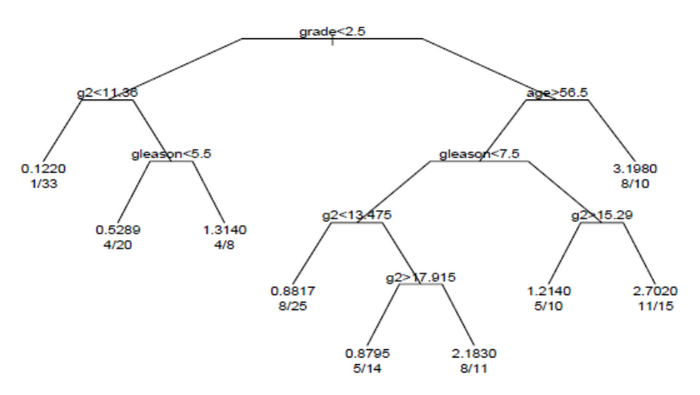

Este ejemplo de análisis de árbol de supervivencia utiliza el paquete R "rpart". [8] El ejemplo se basa en 146 pacientes con cáncer de próstata en estadio C del conjunto de datos stagec en rpart. Rpart y el ejemplo stagec se describen en Atkinson y Therneau (1997), [9] que también se distribuye como una viñeta del paquete rpart. [8]

Las variables en etapas son:

El árbol de supervivencia producido por el análisis se muestra en la figura.

Cada rama del árbol indica una división en el valor de una variable. Por ejemplo, la raíz del árbol divide a los sujetos con una calificación < 2,5 frente a los sujetos con una calificación 2,5 o superior. Los nodos terminales indican la cantidad de sujetos del nodo, la cantidad de sujetos que tienen eventos y la tasa relativa de eventos en comparación con la raíz. En el nodo del extremo izquierdo, los valores 1/33 indican que uno de los 33 sujetos del nodo tuvo un evento y que la tasa relativa de eventos es 0,122. En el nodo del extremo inferior derecho, los valores 11/15 indican que 11 de los 15 sujetos del nodo tuvieron un evento y la tasa relativa de eventos es 2,7.

Una alternativa a la construcción de un único árbol de supervivencia es construir muchos árboles de supervivencia, donde cada árbol se construye utilizando una muestra de los datos y se promedian los árboles para predecir la supervivencia. [7] Este es el método subyacente a los modelos de bosque aleatorio de supervivencia. El análisis de bosque aleatorio de supervivencia está disponible en el paquete R "randomForestSRC". [10]

El paquete randomForestSRC incluye un ejemplo de análisis de bosque aleatorio de supervivencia utilizando el conjunto de datos pbc. Estos datos proceden del ensayo de cirrosis biliar primaria (CBP) de la Clínica Mayo realizado entre 1974 y 1984. En el ejemplo, el modelo de supervivencia de bosque aleatorio proporciona predicciones de supervivencia más precisas que el modelo de PH de Cox. Los errores de predicción se calculan mediante un nuevo muestreo bootstrap .

Los avances recientes en el aprendizaje de representaciones profundas se han extendido a la estimación de supervivencia. El modelo DeepSurv [11] propone reemplazar la parametrización log-lineal del modelo CoxPH con un perceptrón multicapa. Otras extensiones como Deep Survival Machines [12] y Deep Cox Mixtures [13] implican el uso de modelos de mezcla de variables latentes para modelar la distribución del tiempo hasta el evento como una mezcla de distribuciones paramétricas o semiparamétricas mientras se aprenden conjuntamente representaciones de las covariables de entrada. Los enfoques de aprendizaje profundo han demostrado un rendimiento superior, especialmente en modalidades de datos de entrada complejos, como imágenes y series temporales clínicas.

El objeto de interés principal es la función de supervivencia , convencionalmente denominada S , que se define como

donde t es un tiempo, T es una variable aleatoria que denota el momento de la muerte y "Pr" representa la probabilidad . Es decir, la función de supervivencia es la probabilidad de que el momento de la muerte sea posterior a un tiempo especificado t . La función de supervivencia también se denomina función de supervivencia o función de supervivencia en problemas de supervivencia biológica, y función de fiabilidad en problemas de supervivencia mecánica. En este último caso, la función de fiabilidad se denota R ( t ).

Generalmente se supone que S (0) = 1, aunque podría ser menor que 1 si existe la posibilidad de muerte o falla inmediata.

La función de supervivencia debe ser no creciente: S ( u ) ≤ S ( t ) si u ≥ t . Esta propiedad se deduce directamente porque T > u implica T > t . Esto refleja la noción de que la supervivencia hasta una edad posterior es posible solo si se alcanzan todas las edades más jóvenes. Dada esta propiedad, la función de distribución de la vida útil y la densidad de eventos ( F y f a continuación) están bien definidas.

Generalmente se supone que la función de supervivencia se acerca a cero a medida que aumenta la edad sin límite (es decir, S ( t ) → 0 cuando t → ∞), aunque el límite podría ser mayor que cero si es posible la vida eterna. Por ejemplo, podríamos aplicar el análisis de supervivencia a una mezcla de isótopos de carbono estables e inestables ; los isótopos inestables se desintegrarían tarde o temprano, pero los isótopos estables durarían indefinidamente.

Las cantidades relacionadas se definen en términos de la función de supervivencia.

La función de distribución de vida útil , convencionalmente denominada F , se define como el complemento de la función de supervivencia,

Si F es diferenciable , entonces la derivada, que es la función de densidad de la distribución de vida útil, se denota convencionalmente f ,

La función f a veces se denomina densidad de eventos ; es la tasa de eventos de muerte o falla por unidad de tiempo.

La función de supervivencia se puede expresar en términos de funciones de distribución de probabilidad y de densidad de probabilidad.

De manera similar, una función de densidad de eventos de supervivencia se puede definir como

En otros campos, como la física estadística, la función de densidad de eventos de supervivencia se conoce como densidad de tiempo de primer paso .

La función de riesgo , convencionalmente denominada como , se define como la tasa de eventos en el momento condicional a la supervivencia hasta el momento o más tarde (es decir, ). Supongamos que un elemento ha sobrevivido durante un tiempo y deseamos la probabilidad de que no sobreviva durante un tiempo adicional :

La fuerza de mortalidad es un sinónimo de función de riesgo que se utiliza particularmente en demografía y ciencia actuarial , donde se denota por . El término tasa de riesgo es otro sinónimo.

La fuerza de mortalidad de la función de supervivencia se define como

La fuerza de la mortalidad también se denomina fuerza del fracaso. Es la función de densidad de probabilidad de la distribución de la mortalidad.

En la ciencia actuarial, la tasa de riesgo es la tasa de muerte para las personas mayores de . Para una persona mayor de , la fuerza de mortalidad años después es la fuerza de mortalidad para una persona de – años. La tasa de riesgo también se denomina tasa de fracaso. La tasa de riesgo y la tasa de fracaso son nombres que se utilizan en la teoría de la confiabilidad.

Cualquier función es una función de riesgo si y sólo si satisface las siguientes propiedades:

De hecho, la tasa de riesgo suele ser más informativa acerca del mecanismo subyacente del fallo que las otras representaciones de una distribución a lo largo de la vida.

La función de riesgo debe ser no negativa, , y su integral debe ser infinita, pero no está restringida de ninguna otra manera; puede ser creciente o decreciente, no monótona o discontinua. Un ejemplo es la función de riesgo de la curva de la bañera , que es grande para valores pequeños de , decreciente hasta un mínimo y luego creciente nuevamente; esto puede modelar la propiedad de algunos sistemas mecánicos de fallar poco después de la operación o mucho más tarde, a medida que el sistema envejece.

La función de riesgo se puede representar alternativamente en términos de la función de riesgo acumulativo , denotada convencionalmente como :

Así que transponiendo signos y exponenciando

o diferenciando (con la regla de la cadena)

El nombre "función de riesgo acumulativo" se deriva del hecho de que

que es la “acumulación” del peligro a lo largo del tiempo.

De la definición de , vemos que aumenta sin límite cuando t tiende a infinito (suponiendo que tiende a cero). Esto implica que no debe disminuir demasiado rápido, ya que, por definición, el riesgo acumulado tiene que divergir. Por ejemplo, no es la función de riesgo de ninguna distribución de supervivencia, porque su integral converge a 1.

La función de supervivencia , la función de riesgo acumulativo , la densidad , la función de riesgo y la función de distribución de vida útil están relacionadas a través de

La vida futura en un momento dado es el tiempo restante hasta la muerte, dada la supervivencia hasta la edad . Por lo tanto, está en la notación actual. La vida futura esperada es el valor esperado de la vida futura. La probabilidad de muerte a la edad o antes , dada la supervivencia hasta la edad , es simplemente

Por lo tanto, la densidad de probabilidad de la vida futura es

y la vida útil futura esperada es

donde la segunda expresión se obtiene mediante integración por partes .

Porque , es decir, al nacer, esto se reduce al tiempo de vida esperado.

En los problemas de confiabilidad, la vida útil esperada se denomina tiempo medio hasta el fallo , y la vida útil futura esperada se denomina vida útil residual media .

Como la probabilidad de que un individuo sobreviva hasta la edad t o más es S ( t ), por definición, el número esperado de sobrevivientes a la edad t de una población inicial de n recién nacidos es n × S ( t ), asumiendo la misma función de supervivencia para todos los individuos. Por lo tanto, la proporción esperada de sobrevivientes es S ( t ). Si la supervivencia de diferentes individuos es independiente, el número de sobrevivientes a la edad t tiene una distribución binomial con parámetros n y S ( t ), y la varianza de la proporción de sobrevivientes es S ( t ) × (1- S ( t ))/ n .

La edad a la que sobreviven una determinada proporción de supervivientes se puede determinar resolviendo la ecuación S ( t ) = q para t , donde q es el cuantil en cuestión. Normalmente, se interesa por la mediana de vida , para la que q = 1/2, u otros cuantiles como q = 0,90 o q = 0,99.

La censura es una forma de problema de datos faltantes en el que no se observa el tiempo transcurrido hasta el evento por razones como la finalización del estudio antes de que todos los sujetos reclutados hayan mostrado el evento de interés o el sujeto haya abandonado el estudio antes de experimentar un evento. La censura es común en el análisis de supervivencia.

Si solo se conoce el límite inferior l para el tiempo real del evento T , de modo que T > l , esto se denomina censura derecha . La censura derecha se producirá, por ejemplo, para aquellos sujetos cuya fecha de nacimiento se conoce, pero que aún están vivos cuando se pierden para el seguimiento o cuando finaliza el estudio. Generalmente nos encontramos con datos censurados por la derecha.

Si el evento de interés ya ocurrió antes de que el sujeto fuera incluido en el estudio pero no se sabe cuándo ocurrió, se dice que los datos están censurados por la izquierda . [14] Cuando solo se puede decir que el evento ocurrió entre dos observaciones o exámenes, esto es censura de intervalo .

La censura a la izquierda se produce, por ejemplo, cuando un diente permanente ya ha salido antes de que se inicie un estudio odontológico cuyo objetivo es estimar la distribución de su aparición. En el mismo estudio, se censura el intervalo de tiempo de aparición cuando el diente permanente está presente en la boca en el examen actual pero todavía no en el examen anterior. La censura a intervalos se produce a menudo en los estudios sobre el VIH/SIDA. De hecho, el tiempo hasta la seroconversión al VIH solo se puede determinar mediante una evaluación de laboratorio que generalmente se inicia después de una visita al médico. En ese caso, solo se puede concluir que la seroconversión al VIH se ha producido entre dos exámenes. Lo mismo se aplica al diagnóstico del SIDA, que se basa en los síntomas clínicos y debe confirmarse mediante un examen médico.

También puede ocurrir que los sujetos con una vida útil inferior a un cierto umbral no sean observados en absoluto: esto se llama truncamiento . Obsérvese que el truncamiento es diferente de la censura a la izquierda, ya que para un dato censurado a la izquierda, sabemos que el sujeto existe, pero para un dato truncado, podemos ignorar por completo al sujeto. El truncamiento también es común. En un llamado estudio de entrada retrasada , los sujetos no son observados en absoluto hasta que han alcanzado una cierta edad. Por ejemplo, es posible que las personas no sean observadas hasta que hayan alcanzado la edad para ingresar a la escuela. Cualquier sujeto fallecido en el grupo de edad preescolar sería desconocido. Los datos truncados a la izquierda son comunes en el trabajo actuarial para seguros de vida y pensiones . [15]

Los datos censurados a la izquierda pueden aparecer cuando el tiempo de supervivencia de una persona se vuelve incompleto en el lado izquierdo del período de seguimiento de la misma. Por ejemplo, en un ejemplo epidemiológico, podemos hacer un seguimiento de un paciente para detectar un trastorno infeccioso a partir del momento en que da positivo en la prueba de la infección. Aunque podemos conocer el lado derecho de la duración de interés, es posible que nunca sepamos el tiempo exacto de exposición al agente infeccioso. [16]

Los modelos de supervivencia pueden considerarse modelos de regresión ordinarios en los que la variable de respuesta es el tiempo. Sin embargo, el cálculo de la función de verosimilitud (necesaria para ajustar parámetros o hacer otros tipos de inferencias) se complica por la censura. La función de verosimilitud para un modelo de supervivencia, en presencia de datos censurados, se formula de la siguiente manera. Por definición, la función de verosimilitud es la probabilidad condicional de los datos dados los parámetros del modelo. Es habitual suponer que los datos son independientes dados los parámetros. Entonces, la función de verosimilitud es el producto de la verosimilitud de cada dato. Es conveniente dividir los datos en cuatro categorías: sin censura, censurados por la izquierda, censurados por la derecha y censurados por intervalo. Estas se denotan "unc.", "lc", "rc" e "ic" en la ecuación siguiente.

Para datos sin censura, con igual edad al momento de la muerte, tenemos

Para los datos censurados a la izquierda, de modo que se sabe que la edad al momento de la muerte es menor que , tenemos

Para los datos censurados a la derecha, de modo que se sabe que la edad al momento de la muerte es mayor que , tenemos

Para un dato censurado por intervalo, tal que se sabe que la edad al momento de la muerte es menor que y mayor que , tenemos

Una aplicación importante donde surgen datos censurados por intervalos son los datos de estado actual, donde se sabe que un evento no ocurrió antes de un tiempo de observación y que ocurrió antes del siguiente tiempo de observación.

El estimador de Kaplan-Meier se puede utilizar para estimar la función de supervivencia. El estimador de Nelson-Aalen se puede utilizar para proporcionar una estimación no paramétrica de la función de tasa de riesgo acumulada. Estos estimadores requieren datos de toda la vida. Los recuentos periódicos de casos (cohortes) y muertes (y recuperación) son estadísticamente suficientes para realizar estimaciones no paramétricas de máxima verosimilitud y mínimos cuadrados de las funciones de supervivencia, sin datos de toda la vida.

Si bien muchos modelos paramétricos suponen un tiempo continuo, los modelos de supervivencia de tiempo discreto se pueden mapear a un problema de clasificación binaria. En un modelo de supervivencia de tiempo discreto, el período de supervivencia se remuestrea artificialmente en intervalos donde para cada intervalo se registra un indicador objetivo binario si el evento tiene lugar en un cierto horizonte de tiempo. [17] Si se calibra un clasificador binario (potencialmente mejorado con una probabilidad diferente para tener más en cuenta la estructura del problema) , entonces la puntuación del clasificador es la función de riesgo (es decir, la probabilidad condicional de falla). [17]

Los modelos de supervivencia en tiempo discreto están conectados con la probabilidad empírica . [18] [19]

La bondad de ajuste de los modelos de supervivencia se puede evaluar utilizando reglas de puntuación . [20]

El libro de texto de Kleinbaum tiene ejemplos de análisis de supervivencia utilizando SAS, R y otros paquetes. [21] Los libros de texto de Brostrom, [22] Dalgaard [2] y Tableman y Kim [23] dan ejemplos de análisis de supervivencia utilizando R (o utilizando S, y que se ejecutan en R).