La singularidad tecnológica —o simplemente la singularidad [1] —es un hipotético punto futuro en el tiempo en el que el crecimiento tecnológico se vuelve incontrolable e irreversible, resultando en consecuencias imprevisibles para la civilización humana . [2] [3] Según la versión más popular de la hipótesis de la singularidad, el modelo de explosión de inteligencia de IJ Good de 1965, un agente inteligente actualizable podría eventualmente entrar en un bucle de retroalimentación positiva de ciclos de auto-mejora , cada uno sucesivo; y una generación más inteligente apareciendo cada vez más rápidamente, causando un rápido aumento ("explosión") en la inteligencia que finalmente resultaría en una poderosa superinteligencia , cualitativamente superando por mucho a toda la inteligencia humana . [4]

El matemático húngaro-estadounidense John von Neumann (1903-1957) fue la primera persona conocida en utilizar el concepto de "singularidad" en el contexto tecnológico. [5] [ Se necesita citar para verificar ] Stanislaw Ulam informó en 1958 de una discusión anterior con von Neumann "centrada en el progreso acelerado de la tecnología y los cambios en la vida humana, que da la apariencia de acercarse a una singularidad esencial en la historia de la raza más allá de la cual los asuntos humanos, tal como los conocemos, no podrían continuar". [6] Autores posteriores se han hecho eco de este punto de vista. [3] [7]

El concepto y el término "singularidad" fueron popularizados por Vernor Vinge , primero en 1983 (en un artículo que afirmaba que una vez que los humanos creen inteligencias mayores que la suya, habrá una transición tecnológica y social similar en cierto sentido al "espacio-tiempo anudado en el centro de un agujero negro", [8] ) y más tarde en su ensayo de 1993 The Coming Technological Singularity , [4] [7] (en el que escribió que señalaría el fin de la era humana, ya que la nueva superinteligencia continuaría actualizándose y avanzaría tecnológicamente a un ritmo incomprensible). Escribió que se sorprendería si ocurriera antes de 2005 o después de 2030. [4] Otro contribuyente significativo a una circulación más amplia de la noción fue el libro de Ray Kurzweil de 2005 The Singularity Is Near , que predijo la singularidad para 2045. [7]

Algunos científicos, incluido Stephen Hawking , han expresado su preocupación por que la superinteligencia artificial (ASI) pueda provocar la extinción humana. [9] [10] Las consecuencias de una singularidad tecnológica y su potencial beneficio o daño para la raza humana han sido intensamente debatidos.

Destacados tecnólogos y académicos disputan la plausibilidad de una singularidad tecnológica y la explosión de inteligencia artificial asociada, entre ellos Paul Allen , [11] Jeff Hawkins , [12] John Holland , Jaron Lanier , Steven Pinker , [12] Theodore Modis , [13] y Gordon Moore . [12] Una afirmación hecha fue que es probable que el crecimiento de la inteligencia artificial se encuentre con rendimientos decrecientes en lugar de acelerados, como se observó en tecnologías humanas desarrolladas previamente.

Aunque el progreso tecnológico se ha acelerado en la mayoría de las áreas, ha estado limitado por la inteligencia básica del cerebro humano, que, según Paul R. Ehrlich , no ha cambiado significativamente durante milenios. [14] Sin embargo, con el aumento del poder de las computadoras y otras tecnologías, podría ser posible construir una máquina que sea significativamente más inteligente que los humanos. [15]

Si se inventara una inteligencia sobrehumana (ya sea mediante la amplificación de la inteligencia humana o mediante inteligencia artificial), en teoría mejoraría enormemente la capacidad inventiva y de resolución de problemas de los seres humanos. A este tipo de IA se la conoce como IA semilla [16] [17] porque, si se creara una IA con capacidades de ingeniería que igualaran o superaran las de sus creadores humanos, tendría el potencial de mejorar de forma autónoma su propio software y hardware para diseñar una máquina aún más capaz, que podría repetir el proceso a su vez. Esta automejora recursiva podría acelerarse, lo que potencialmente permitiría un enorme cambio cualitativo antes de que se establecieran los límites superiores impuestos por las leyes de la física o la computación teórica. Se especula que, tras muchas iteraciones, una IA de este tipo superaría con creces las capacidades cognitivas humanas .

IJ Good especuló que la inteligencia sobrehumana podría provocar una explosión de inteligencia: [18] [19]

Definamos una máquina ultrainteligente como aquella que puede superar con creces todas las actividades intelectuales de cualquier hombre, por muy inteligente que sea. Puesto que el diseño de máquinas es una de esas actividades intelectuales, una máquina ultrainteligente podría diseñar máquinas aún mejores; entonces se produciría sin duda una «explosión de inteligencia» y la inteligencia del hombre quedaría muy por detrás. Así pues, la primera máquina ultrainteligente es el último invento que el hombre necesita hacer, siempre que la máquina sea lo bastante dócil como para decirnos cómo mantenerla bajo control.

— Especulaciones sobre la primera máquina ultrainteligente (1965)

Una versión de la explosión de la inteligencia es aquella en la que el poder de cómputo se acerca al infinito en una cantidad finita de tiempo. En esta versión, una vez que las IA están realizando la investigación para mejorarse a sí mismas, la velocidad se duplica, por ejemplo, después de 2 años, luego de 1 año, luego de 6 meses, luego de 3 meses, luego de 1,5 meses, etc., donde la suma infinita de los períodos de duplicación es de 4 años. A menos que lo impidan los límites físicos de la computación y la cuantificación del tiempo, este proceso alcanzaría literalmente un poder de cómputo infinito en 4 años, lo que le valió el nombre de "singularidad" para el estado final. Esta forma de explosión de la inteligencia se describe en Yudkowsky (1996). [20]

Una superinteligencia, hiperinteligencia o inteligencia sobrehumana es un agente hipotético que posee una inteligencia que supera con creces la de las mentes humanas más brillantes y dotadas. [21] "Superinteligencia" también puede referirse a la forma o grado de inteligencia que posee dicho agente. John von Neumann , Vernor Vinge y Ray Kurzweil definen el concepto en términos de la creación tecnológica de una superinteligencia, argumentando que es difícil o imposible para los humanos actuales predecir cómo sería la vida de los seres humanos en un mundo post-singularidad. [4] [22]

El concepto relacionado de “superinteligencia veloz” describe una IA que puede funcionar como una mente humana, solo que mucho más rápido. [23] Por ejemplo, con un aumento de un millón de veces en la velocidad de procesamiento de la información en relación con la de los humanos, un año subjetivo pasaría en 30 segundos físicos. [24] Tal diferencia en la velocidad de procesamiento de la información podría impulsar la singularidad. [25]

Los pronosticadores tecnológicos y los investigadores no están de acuerdo sobre cuándo, o si, la inteligencia humana será superada. Algunos sostienen que los avances en inteligencia artificial (IA) probablemente darán como resultado sistemas de razonamiento general que eviten las limitaciones cognitivas humanas. Otros creen que los humanos evolucionarán o modificarán directamente su biología para lograr una inteligencia radicalmente mayor. [26] [27] Varios estudios de futuros se centran en escenarios que combinan estas posibilidades, lo que sugiere que es probable que los humanos interactúen con las computadoras , o carguen sus mentes en las computadoras , de una manera que permita una amplificación sustancial de la inteligencia. El libro The Age of Em de Robin Hanson describe un escenario futuro hipotético en el que los cerebros humanos son escaneados y digitalizados, creando "cargas" o versiones digitales de la conciencia humana. En este futuro, el desarrollo de estas cargas puede preceder o coincidir con el surgimiento de la inteligencia artificial superinteligente. [28]

Algunos escritores utilizan "la singularidad" en un sentido más amplio para referirse a cualquier cambio radical en la sociedad producido por una nueva tecnología (como la nanotecnología molecular ), [29] [30] [31] aunque Vinge y otros escritores afirman específicamente que sin superinteligencia, tales cambios no calificarían como una verdadera singularidad. [4]

En 1965, IJ Good escribió que es más probable que se construya una máquina ultrainteligente en el siglo XX. [18] En 1993, Vinge predijo una inteligencia mayor que la humana entre 2005 y 2030. [4] En 1996, Yudkowsky predijo una singularidad en 2021. [20] En 2005, Kurzweil predijo una IA de nivel humano alrededor de 2029, [32] y la singularidad en 2045. [33] En una entrevista de 2017, Kurzweil reafirmó sus estimaciones. [34] En 1988, Moravec predijo que si el ritmo de mejora continúa, las capacidades informáticas para una IA de nivel humano estarían disponibles en supercomputadoras antes de 2010. [35] En 1998, Moravec predijo una IA de nivel humano para 2040, y una inteligencia mucho más allá de la humana para 2050. [36]

Cuatro encuestas a investigadores de IA, realizadas en 2012 y 2013 por Nick Bostrom y Vincent C. Müller , sugirieron una confianza del 50% en que se desarrollaría una IA de nivel humano para 2040-2050. [37] [38]

Destacados tecnólogos y académicos disputan la plausibilidad de una singularidad tecnológica, entre ellos Paul Allen , [11] Jeff Hawkins , [12] John Holland , Jaron Lanier , Steven Pinker , [12] Theodore Modis , [13] y Gordon Moore , [12] cuya ley se cita a menudo en apoyo del concepto. [39]

La mayoría de los métodos propuestos para crear mentes superhumanas o transhumanas se dividen en dos categorías: la amplificación de la inteligencia de los cerebros humanos y la inteligencia artificial. Las muchas formas especuladas de aumentar la inteligencia humana incluyen la bioingeniería , la ingeniería genética , los fármacos nootrópicos , los asistentes de inteligencia artificial, las interfaces directas cerebro-computadora y la transferencia de información mental . Estos múltiples caminos posibles hacia una explosión de inteligencia, todos los cuales presumiblemente se seguirán, hacen que una singularidad sea más probable. [24]

Robin Hanson expresó su escepticismo sobre el aumento de la inteligencia humana, escribiendo que una vez que se hayan agotado los métodos fáciles y "de fácil acceso" para aumentar la inteligencia humana, será cada vez más difícil realizar mejoras adicionales. [40] A pesar de todas las formas especuladas para amplificar la inteligencia humana, la inteligencia artificial no humana (específicamente la IA semilla) es la opción más popular entre las hipótesis que harían avanzar la singularidad. [ cita requerida ]

La posibilidad de una explosión de inteligencia depende de tres factores. [41] El primer factor de aceleración son las nuevas mejoras de inteligencia que se hacen posibles gracias a cada mejora anterior. Por el contrario, a medida que las inteligencias se vuelven más avanzadas, los avances posteriores se volverán cada vez más complicados, posiblemente superando la ventaja del aumento de inteligencia. Cada mejora debería generar al menos una mejora más, en promedio, para que continúe el movimiento hacia la singularidad. Por último, las leyes de la física pueden eventualmente impedir nuevas mejoras.

Hay dos causas lógicamente independientes, pero que se refuerzan mutuamente, de las mejoras en la inteligencia: aumentos en la velocidad de cálculo y mejoras en los algoritmos utilizados. [7] La primera es predicha por la Ley de Moore y las mejoras previstas en el hardware, [42] y es comparativamente similar a los avances tecnológicos anteriores. Pero Schulman y Sandberg [43] sostienen que el software presentará desafíos más complejos que simplemente operar en hardware capaz de funcionar a niveles de inteligencia humana o superiores.

En una encuesta por correo electrónico realizada en 2017 a autores con publicaciones en las conferencias sobre aprendizaje automático de NeurIPS e ICML de 2015 se preguntó sobre la probabilidad de que "el argumento de la explosión de inteligencia sea en general correcto". De los encuestados, el 12 % dijo que era "bastante probable", el 17 % dijo que era "probable", el 21 % dijo que era "casi igual", el 24 % dijo que era "poco probable" y el 26 % dijo que era "bastante improbable". [44]

Tanto para la inteligencia humana como para la artificial, las mejoras de hardware aumentan la tasa de futuras mejoras de hardware. Una analogía con la Ley de Moore sugiere que si la primera duplicación de velocidad tomó 18 meses, la segunda tomaría 18 meses subjetivos; o 9 meses externos, y luego cuatro meses, dos meses, y así sucesivamente hasta una singularidad de velocidad. [45] [20] Eventualmente puede alcanzarse un límite superior de velocidad. Jeff Hawkins ha afirmado que un sistema informático que se automejora inevitablemente se toparía con límites superiores de potencia de cálculo: "al final hay límites a cuán grandes y rápidos pueden funcionar los ordenadores. Terminaríamos en el mismo lugar; solo llegaríamos allí un poco más rápido. No habría singularidad". [12]

Es difícil comparar directamente el hardware basado en silicio con las neuronas , pero Berglas (2008) señala que el reconocimiento de voz por computadora se está acercando a las capacidades humanas y que esta capacidad parece requerir el 0,01% del volumen del cerebro. Esta analogía sugiere que el hardware de las computadoras modernas está a unos pocos órdenes de magnitud de ser tan poderoso como el cerebro humano , además de ocupar mucho menos espacio.

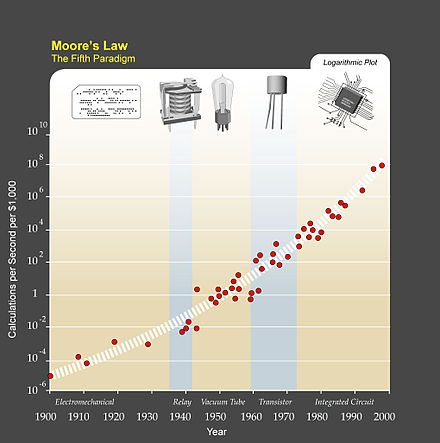

El crecimiento exponencial de la tecnología informática sugerido por la ley de Moore se cita comúnmente como una razón para esperar una singularidad en un futuro relativamente cercano, y varios autores han propuesto generalizaciones de la ley de Moore. El científico informático y futurista Hans Moravec propuso en un libro de 1998 [46] que la curva de crecimiento exponencial podría extenderse a través de tecnologías informáticas anteriores al circuito integrado .

Ray Kurzweil postula una ley de rendimientos acelerados en la que la velocidad del cambio tecnológico (y más generalmente, todos los procesos evolutivos) [47] aumenta exponencialmente, generalizando la ley de Moore de la misma manera que la propuesta de Moravec, e incluyendo también la tecnología de los materiales (especialmente la aplicada a la nanotecnología ), la tecnología médica y otras. [48] Entre 1986 y 2007, la capacidad específica de las aplicaciones de las máquinas para calcular información per cápita se duplicó aproximadamente cada 14 meses; la capacidad per cápita de las computadoras de propósito general del mundo se ha duplicado cada 18 meses; la capacidad global de telecomunicaciones per cápita se duplicó cada 34 meses; y la capacidad mundial de almacenamiento per cápita se duplicó cada 40 meses. [49] Por otra parte, se ha argumentado que el patrón de aceleración global que tiene como parámetro la singularidad del siglo XXI debería caracterizarse como hiperbólico en lugar de exponencial. [50]

Kurzweil reserva el término "singularidad" para un rápido aumento de la inteligencia artificial (en contraposición a otras tecnologías), escribiendo, por ejemplo, que "La Singularidad nos permitirá trascender estas limitaciones de nuestros cuerpos y cerebros biológicos... No habrá distinción, después de la Singularidad, entre humanos y máquinas". [51] También define su fecha predicha de la singularidad (2045) en términos de cuándo espera que las inteligencias basadas en computadoras excedan significativamente la suma total de la capacidad cerebral humana, escribiendo que los avances en computación antes de esa fecha "no representarán la Singularidad" porque "aún no corresponden a una expansión profunda de nuestra inteligencia". [52]

Algunos defensores de la singularidad argumentan su inevitabilidad extrapolando las tendencias pasadas, especialmente las relacionadas con la reducción de las brechas entre las mejoras tecnológicas. En uno de los primeros usos del término "singularidad" en el contexto del progreso tecnológico, Stanislaw Ulam cuenta una conversación con John von Neumann sobre la aceleración del cambio:

Una conversación se centró en el progreso cada vez más acelerado de la tecnología y los cambios en el modo de vida humana, lo que da la apariencia de acercarse a una singularidad esencial en la historia de la raza más allá de la cual los asuntos humanos, tal como los conocemos, no podrían continuar. [6]

Kurzweil afirma que el progreso tecnológico sigue un patrón de crecimiento exponencial , siguiendo lo que él llama la " ley de los rendimientos acelerados ". Siempre que la tecnología se acerca a una barrera, escribe Kurzweil, las nuevas tecnologías la superarán. Predice que los cambios de paradigma se volverán cada vez más comunes, lo que conducirá a "un cambio tecnológico tan rápido y profundo que representa una ruptura en el tejido de la historia humana". [53] Kurzweil cree que la singularidad ocurrirá aproximadamente en 2045. [48] Sus predicciones difieren de las de Vinge en que predice un ascenso gradual a la singularidad, en lugar de la inteligencia sobrehumana que mejora rápidamente como lo predice Vinge.

Entre los peligros que se citan con frecuencia se encuentran los que se asocian comúnmente con la nanotecnología molecular y la ingeniería genética . Estas amenazas son cuestiones importantes tanto para los defensores como para los críticos de la singularidad, y fueron el tema del artículo de Bill Joy en la revista Wired de abril de 2000 titulado " Por qué el futuro no nos necesita ". [7] [54]

Algunas tecnologías de inteligencia, como la "IA de semillas", [16] [17] también pueden tener el potencial no solo de volverse más rápidas, sino también más eficientes, modificando su código fuente . Estas mejoras harían posibles otras mejoras, que a su vez harían posibles otras mejoras, y así sucesivamente.

El mecanismo para un conjunto de algoritmos que se automejoran recursivamente difiere de un aumento en la velocidad de cálculo en bruto en dos formas. En primer lugar, no requiere influencia externa: las máquinas que diseñan hardware más rápido aún requerirían que los humanos creen el hardware mejorado o programen las fábricas de manera apropiada. [ cita requerida ] Una IA que reescribiera su propio código fuente podría hacerlo mientras está contenida en una caja de IA .

En segundo lugar, al igual que en el caso de la concepción de la singularidad de Vernor Vinge , es mucho más difícil predecir el resultado. Si bien los aumentos de velocidad parecen ser sólo una diferencia cuantitativa con respecto a la inteligencia humana, las mejoras reales de los algoritmos serían cualitativamente diferentes. Eliezer Yudkowsky lo compara con los cambios que trajo consigo la inteligencia humana: los humanos cambiaron el mundo miles de veces más rápido que la evolución, y de maneras totalmente diferentes. De manera similar, la evolución de la vida fue una desviación y aceleración masivas de las tasas de cambio geológico anteriores, y la inteligencia mejorada podría hacer que el cambio fuera también igual de diferente. [55]

Existen peligros sustanciales asociados con una singularidad de explosión de inteligencia que se origine a partir de un conjunto de algoritmos que se automejoran recursivamente. En primer lugar, la estructura de objetivos de la IA podría automodificarse, lo que podría hacer que la IA se optimice para algo distinto de lo que se pretendía originalmente. [56] [57]

En segundo lugar, las IA podrían competir por los mismos recursos escasos que la humanidad utiliza para sobrevivir. [58] [59] Aunque no sean activamente maliciosas, las IA promoverían los objetivos de su programación, no necesariamente objetivos humanos más amplios, y por lo tanto podrían desplazar a los humanos. [60] [61] [62]

Carl Shulman y Anders Sandberg sugieren que las mejoras de algoritmos pueden ser el factor limitante para una singularidad; mientras que la eficiencia del hardware tiende a mejorar a un ritmo constante, las innovaciones de software son más impredecibles y pueden verse obstaculizadas por la investigación acumulativa y en serie. Sugieren que en el caso de una singularidad limitada por software, la explosión de inteligencia en realidad sería más probable que en una singularidad limitada por hardware, porque en el caso limitado por software, una vez que se desarrolle una IA de nivel humano, podría ejecutarse en serie en un hardware muy rápido, y la abundancia de hardware barato haría que la investigación en IA estuviera menos limitada. [63] A la abundancia de hardware acumulado que se puede liberar una vez que el software descubra cómo usarlo se le ha llamado "exceso de computación". [64]

Algunos críticos, como el filósofo Hubert Dreyfus [65] y el filósofo John Searle [66] , afirman que las computadoras o las máquinas no pueden alcanzar la inteligencia humana . Otros, como el físico Stephen Hawking [67], objetan que el hecho de que las máquinas puedan alcanzar una verdadera inteligencia o simplemente algo similar a la inteligencia es irrelevante si el resultado neto es el mismo.

El psicólogo Steven Pinker afirmó en 2008: "No hay la más mínima razón para creer en una singularidad futura. El hecho de que puedas visualizar un futuro en tu imaginación no es evidencia de que sea probable o incluso posible. Observa las ciudades abovedadas, los desplazamientos en mochilas propulsoras, las ciudades submarinas, los edificios de kilómetros de altura y los automóviles de propulsión nuclear: todos elementos básicos de las fantasías futuristas de cuando yo era niño que nunca se han materializado. La mera capacidad de procesamiento no es un polvo mágico que resuelva mágicamente todos tus problemas". [12]

Martin Ford [68] postula una "paradoja tecnológica" en el sentido de que antes de que pudiera producirse la singularidad, la mayoría de los trabajos rutinarios de la economía estarían automatizados, ya que esto requeriría un nivel de tecnología inferior al de la singularidad. Esto causaría un desempleo masivo y una caída en picado de la demanda de los consumidores, lo que a su vez destruiría el incentivo para invertir en las tecnologías que se requerirían para generar la singularidad. El desplazamiento de puestos de trabajo ya no se limita cada vez más a los tipos de trabajo que tradicionalmente se consideraban "rutinarios". [69]

Theodore Modis [70] y Jonathan Huebner [71] sostienen que la tasa de innovación tecnológica no sólo ha dejado de aumentar, sino que en realidad está disminuyendo. La prueba de esta disminución es que el aumento de las frecuencias de reloj de los ordenadores se está ralentizando, aunque la predicción de Moore de una densidad de circuitos en aumento exponencial sigue siendo válida. Esto se debe a la excesiva acumulación de calor en el chip, que no se puede disipar con la suficiente rapidez para evitar que el chip se derrita cuando funciona a velocidades más altas. Es posible que en el futuro se produzcan avances en la velocidad gracias a diseños de CPU más eficientes en el consumo de energía y procesadores multicelda. [72]

Theodore Modis sostiene que la singularidad no puede ocurrir. [73] [13] [74] Afirma que la "singularidad tecnológica" y especialmente Kurzweil carecen de rigor científico; se alega que Kurzweil confunde la función logística (función S) con una función exponencial y ve una "codo" en una función exponencial cuando de hecho no puede haber tal cosa. [75] En un artículo de 2021, Modis señaló que no se había observado ningún hito -rupturas en la perspectiva histórica comparables en importancia a Internet, el ADN, el transistor o la energía nuclear- en los veinte años anteriores, mientras que cinco de ellos se habrían esperado de acuerdo con la tendencia exponencial defendida por los defensores de la singularidad tecnológica. [76]

El investigador de inteligencia artificial Jürgen Schmidhuber afirmó que la frecuencia de "acontecimientos notables" subjetivos parece estar acercándose a una singularidad del siglo XXI, pero advirtió a los lectores que tomen estos gráficos de acontecimientos subjetivos con cautela: tal vez las diferencias en la memoria de acontecimientos recientes y distantes podrían crear una ilusión de cambio acelerado donde no existe ninguno. [77]

El cofundador de Microsoft, Paul Allen, argumentó lo opuesto a la aceleración de los rendimientos, el freno de la complejidad: [11] cuanto más avanza la ciencia hacia la comprensión de la inteligencia, más difícil se vuelve lograr avances adicionales. Un estudio del número de patentes muestra que la creatividad humana no muestra rendimientos acelerados, sino de hecho, como sugiere Joseph Tainter en su libro The Collapse of Complex Societies , [78] una ley de rendimientos decrecientes . El número de patentes por cada mil alcanzó su punto máximo en el período de 1850 a 1900, y ha estado disminuyendo desde entonces. [71] El crecimiento de la complejidad finalmente se vuelve autolimitante y conduce a un "colapso general de los sistemas" generalizado.

Hofstadter (2006) plantea la preocupación de que Ray Kurzweil no es lo suficientemente riguroso científicamente, que una tendencia exponencial de la tecnología no es una ley científica como una de la física, y que las curvas exponenciales no tienen "codos". [79] No obstante, no descarta la singularidad en principio en el futuro lejano [12] y a la luz de ChatGPT y otros avances recientes ha revisado significativamente su opinión hacia un cambio tecnológico dramático en el futuro cercano. [80]

Jaron Lanier niega que la singularidad sea inevitable: “No creo que la tecnología se esté creando a sí misma. No es un proceso autónomo”. [81] Además: “La razón para creer en la agencia humana por sobre el determinismo tecnológico es que entonces se puede tener una economía donde la gente se gana la vida a su manera e inventa sus propias vidas. Si se estructura una sociedad sin enfatizar la agencia humana individual, es lo mismo, en términos operativos, que negar a la gente influencia, dignidad y autodeterminación ... abrazar [la idea de la Singularidad] sería una celebración de datos erróneos y de una mala política”. [81]

El economista Robert J. Gordon señala que el crecimiento económico medido se desaceleró alrededor de 1970 y se desaceleró aún más desde la crisis financiera de 2007-2008 , y sostiene que los datos económicos no muestran ningún rastro de una Singularidad venidera como la imaginó el matemático IJ Good . [82]

El filósofo y científico cognitivo Daniel Dennett dijo en 2017: “Todo el asunto de la singularidad es absurdo. Nos distrae de problemas mucho más urgentes”, y añadió: “Las herramientas de IA de las que nos volvemos hiperdependientes es algo que va a suceder. Y uno de los peligros es que les demos más autoridad de la que merecen”. [83]

Además de las críticas generales al concepto de singularidad, varios críticos han planteado problemas con el icónico diagrama de Kurzweil. Una línea de crítica es que un diagrama logarítmico-logarítmico de esta naturaleza está inherentemente sesgado hacia un resultado lineal. Otros identifican un sesgo de selección en los puntos que Kurzweil elige utilizar. Por ejemplo, el biólogo PZ Myers señala que muchos de los primeros "acontecimientos" evolutivos fueron elegidos arbitrariamente. [84] Kurzweil ha refutado esto al representar gráficamente los acontecimientos evolutivos de 15 fuentes neutrales y demostrar que encajan en una línea recta en un diagrama logarítmico-logarítmico . Kelly (2006) sostiene que la forma en que se construye el diagrama de Kurzweil con el eje x teniendo el tiempo anterior al presente, siempre apunta a que la singularidad es "ahora", para cualquier fecha en la que se construya dicho diagrama, y lo muestra visualmente en el diagrama de Kurzweil. [85]

Algunos críticos sugieren motivaciones o implicaciones religiosas de la singularidad, especialmente la versión de Kurzweil. La preparación para la singularidad se compara con los escenarios judeocristianos del fin de los tiempos. Beam la llama "una visión de Buck Rogers del hipotético Rapto cristiano". [86] John Gray dice que "la Singularidad se hace eco de mitos apocalípticos en los que la historia está a punto de ser interrumpida por un evento que transformará el mundo". [87]

David Streitfeld , en The New York Times, cuestionó si "podría manifestarse, en primer lugar y sobre todo -gracias, en parte, a la obsesión por los resultados del Silicon Valley actual- como una herramienta para reducir el número de empleados de las corporaciones estadounidenses". [88]

En el pasado se han producido cambios drásticos en la tasa de crecimiento económico debido al avance tecnológico. Basándonos en el crecimiento demográfico, la economía se duplicó cada 250.000 años desde el Paleolítico hasta la Revolución Neolítica . La nueva economía agrícola se duplicó cada 900 años, un aumento notable. En la era actual, a partir de la Revolución Industrial, la producción económica mundial se duplica cada quince años, sesenta veces más rápido que durante la era agrícola. Si el surgimiento de la inteligencia sobrehumana provoca una revolución similar, sostiene Robin Hanson, cabría esperar que la economía se duplicara al menos trimestralmente y posiblemente semanalmente. [89]

El término "singularidad tecnológica" refleja la idea de que tal cambio puede ocurrir repentinamente, y que es difícil predecir cómo funcionaría el nuevo mundo resultante. [90] [91] No está claro si una explosión de inteligencia que resulte en una singularidad sería beneficiosa o dañina, o incluso una amenaza existencial . [92] [93] Debido a que la IA es un factor importante en el riesgo de singularidad, varias organizaciones persiguen una teoría técnica para alinear los sistemas de objetivos de IA con los valores humanos, incluyendo el Future of Humanity Institute , el Machine Intelligence Research Institute , [90] el Center for Human-Compatible Artificial Intelligence y el Future of Life Institute .

El físico Stephen Hawking dijo en 2014 que «el éxito en la creación de una IA sería el mayor acontecimiento de la historia de la humanidad. Por desgracia, también podría ser el último, a menos que aprendamos a evitar los riesgos». [94] Hawking creía que en las próximas décadas, la IA podría ofrecer «beneficios y riesgos incalculables», como «la tecnología superando en inteligencia a los mercados financieros, inventando más que los investigadores humanos, manipulando más que los líderes humanos y desarrollando armas que ni siquiera podemos entender». [94] Hawking sugirió que la inteligencia artificial debería tomarse más en serio y que se debería hacer más para prepararse para la singularidad: [94]

Así pues, ante posibles futuros con beneficios y riesgos incalculables, los expertos seguramente están haciendo todo lo posible para garantizar el mejor resultado, ¿no es así? No. Si una civilización extraterrestre superior nos enviara un mensaje diciendo: "Llegaremos en unas décadas", ¿responderíamos simplemente: "Está bien, llámanos cuando llegues; dejaremos las luces encendidas"? Probablemente no, pero esto es más o menos lo que está sucediendo con la IA.

Berglas (2008) afirma que no existe una motivación evolutiva directa para que una IA sea amigable con los humanos. La evolución no tiene una tendencia inherente a producir resultados valorados por los humanos, y hay pocas razones para esperar que un proceso de optimización arbitrario promueva un resultado deseado por la humanidad, en lugar de conducir inadvertidamente a que una IA se comporte de una manera no prevista por sus creadores. [95] [96] [97] Anders Sandberg también ha elaborado este escenario, abordando varios contraargumentos comunes. [98] El investigador de IA Hugo de Garis sugiere que las inteligencias artificiales pueden simplemente eliminar a la raza humana para acceder a recursos escasos , [58] [99] y los humanos serían impotentes para detenerlos. [100] Alternativamente, las IA desarrolladas bajo presión evolutiva para promover su propia supervivencia podrían superar a la humanidad. [62]

Bostrom (2002) analiza escenarios de extinción humana y enumera la superinteligencia como una posible causa:

Cuando creamos la primera entidad superinteligente, podríamos cometer un error y asignarle objetivos que la lleven a aniquilar a la humanidad, suponiendo que su enorme ventaja intelectual le da el poder para hacerlo. Por ejemplo, podríamos equivocarnos al elevar un subobjetivo a la categoría de superobjetivo. Le pedimos que resuelva un problema matemático y lo hará convirtiendo toda la materia del sistema solar en un gigantesco dispositivo de cálculo, matando en el proceso a la persona que formuló la pregunta.

Según Eliezer Yudkowsky , un problema significativo en la seguridad de la IA es que es probable que sea mucho más fácil crear una inteligencia artificial hostil que una IA amigable. Si bien ambas requieren grandes avances en el diseño de procesos de optimización recursiva, la IA amigable también requiere la capacidad de hacer que las estructuras de objetivos sean invariables bajo la automejora (o la IA podría transformarse en algo hostil) y una estructura de objetivos que se alinee con los valores humanos y no destruya automáticamente a la raza humana. Una IA hostil, por otro lado, puede optimizarse para una estructura de objetivos arbitraria, que no necesita ser invariable bajo la automodificación. [101] Bill Hibbard (2014) propone un diseño de IA que evita varios peligros, incluido el autoengaño, [102] acciones instrumentales no deseadas, [56] [103] y la corrupción del generador de recompensas. [103] También analiza los impactos sociales de la IA [104] y las pruebas de la IA. [105] Su libro de 2001 Super-Intelligent Machines (Máquinas superinteligentes) defiende la necesidad de educación pública sobre la IA y de control público sobre la IA. También propone un diseño simple que es vulnerable a la corrupción del generador de recompensas.

Aunque la singularidad tecnológica suele considerarse un acontecimiento repentino, algunos investigadores sostienen que la velocidad actual del cambio ya se ajusta a esta descripción. [ cita requerida ]

Además, algunos sostienen que ya nos encontramos en medio de una importante transición evolutiva que fusiona tecnología, biología y sociedad. La tecnología digital se ha infiltrado en el tejido de la sociedad humana hasta un grado de dependencia indiscutible y a menudo vital.

Un artículo de 2016 en Trends in Ecology & Evolution sostiene que "los humanos ya adoptan fusiones de biología y tecnología. Pasamos la mayor parte de nuestro tiempo despiertos comunicándonos a través de canales mediados digitalmente... confiamos nuestras vidas a la inteligencia artificial a través de los frenos antibloqueo en los automóviles y los pilotos automáticos en los aviones... Dado que uno de cada tres cortejos que conducen a matrimonios en Estados Unidos comienza en línea, los algoritmos digitales también están desempeñando un papel en la vinculación y reproducción de las parejas humanas".

El artículo sostiene además que, desde la perspectiva de la evolución , varias transiciones importantes anteriores en la evolución han transformado la vida a través de innovaciones en el almacenamiento y replicación de información ( ARN , ADN , multicelularidad y cultura y lenguaje ). En la etapa actual de la evolución de la vida, la biosfera basada en el carbono ha generado un sistema (los humanos) capaz de crear tecnología que dará como resultado una transición evolutiva comparable .

La información digital creada por los seres humanos ha alcanzado una magnitud similar a la información biológica en la biosfera. Desde la década de 1980, la cantidad de información digital almacenada se ha duplicado aproximadamente cada 2,5 años, alcanzando unos 5 zettabytes en 2014 (5 × 1021 bytes). [107]

En términos biológicos, hay 7.200 millones de seres humanos en el planeta, cada uno de los cuales tiene un genoma de 6.200 millones de nucleótidos. Dado que un byte puede codificar cuatro pares de nucleótidos, los genomas individuales de cada ser humano en el planeta podrían estar codificados por aproximadamente 1 × 1019 bytes. El mundo digital almacenó 500 veces más información que esto en 2014 (ver figura). Se estima que la cantidad total de ADN contenida en todas las células de la Tierra es de aproximadamente 5,3 × 1037 pares de bases, equivalentes a 1,325 × 1037 bytes de información.

Si el crecimiento del almacenamiento digital continúa a su ritmo actual de crecimiento anual compuesto del 30-38% por año, [49] rivalizará con el contenido total de información contenido en todo el ADN de todas las células de la Tierra en unos 110 años. Esto representaría una duplicación de la cantidad de información almacenada en la biosfera a lo largo de un período total de tiempo de sólo 150 años". [106]

En febrero de 2009, bajo los auspicios de la Asociación para el Avance de la Inteligencia Artificial (AAAI), Eric Horvitz presidió una reunión de destacados científicos informáticos, investigadores de inteligencia artificial y especialistas en robótica en el centro de conferencias Asilomar en Pacific Grove, California. El objetivo era discutir el impacto potencial de la posibilidad hipotética de que los robots pudieran volverse autosuficientes y capaces de tomar sus propias decisiones. Discutieron hasta qué punto las computadoras y los robots podrían adquirir autonomía y hasta qué punto podrían usar tales habilidades para plantear amenazas o peligros. [108]

Algunas máquinas están programadas con diversas formas de semiautonomía, incluida la capacidad de localizar sus propias fuentes de energía y elegir objetivos para atacar con armas. Además, algunos virus informáticos pueden evadir la eliminación y, según los científicos presentes, se podría decir que han alcanzado una etapa de inteligencia artificial de "cucaracha". Los asistentes a la conferencia señalaron que la autoconciencia tal como se describe en la ciencia ficción es probablemente poco probable, pero que existen otros peligros y dificultades potenciales. [108]

Frank S. Robinson predice que, una vez que los seres humanos logren crear una máquina con la inteligencia de un ser humano, los problemas científicos y tecnológicos se abordarán y resolverán con una capacidad intelectual muy superior a la de los seres humanos. Señala que los sistemas artificiales son capaces de compartir datos de forma más directa que los seres humanos, y predice que esto daría lugar a una red mundial de superinteligencia que eclipsaría la capacidad humana. [109] Robinson también analiza lo enormemente diferente que podría ser el futuro después de una explosión de inteligencia de ese calibre.

En un escenario de despegue brusco, una superinteligencia artificial se automejora rápidamente, "tomando el control" del mundo (quizás en cuestión de horas), demasiado rápido para que los humanos puedan corregir errores de manera significativa o para que los objetivos del agente se ajusten gradualmente. En un escenario de despegue suave, la IA se vuelve mucho más poderosa que la humanidad, pero a un ritmo similar al humano (quizás del orden de décadas), en una escala de tiempo en la que la interacción y la corrección humanas constantes pueden guiar eficazmente el desarrollo de la IA. [111] [112]

Ramez Naam se opone a un despegue brusco. Señala que ya vemos una automejora recursiva por parte de superinteligencias, como las corporaciones. Intel , por ejemplo, tiene "la capacidad intelectual colectiva de decenas de miles de humanos y probablemente millones de núcleos de CPU para... ¡diseñar mejores CPU!". Sin embargo, esto no ha llevado a un despegue brusco, sino a un despegue suave en forma de la ley de Moore . [113] Naam señala además que la complejidad computacional de una inteligencia superior puede ser mucho mayor que la lineal, de modo que "crear una mente de inteligencia 2 es probablemente más del doble de difícil que crear una mente de inteligencia 1". [114]

J. Storrs Hall cree que "muchos de los escenarios más comunes de despegue brusco de la noche a la mañana son circulares: parecen suponer capacidades hiperhumanas en el punto de partida del proceso de automejora" para que una IA pueda realizar las mejoras dramáticas y generales necesarias para el despegue. Hall sugiere que, en lugar de mejorar recursivamente su hardware, software e infraestructura por sí sola, una IA incipiente estaría mejor si se especializara en un área en la que fuera más eficaz y luego comprara los componentes restantes en el mercado, porque la calidad de los productos en el mercado mejora continuamente y la IA tendría dificultades para mantenerse al día con la tecnología de vanguardia que utiliza el resto del mundo. [115]

Ben Goertzel está de acuerdo con la sugerencia de Hall de que una nueva IA de nivel humano haría bien en usar su inteligencia para acumular riqueza. Los talentos de la IA podrían inspirar a las empresas y a los gobiernos a difundir su software por toda la sociedad. Goertzel es escéptico respecto de un despegue brusco de cinco minutos, pero especula que un despegue del nivel humano al superhumano del orden de cinco años es razonable. Se refiere a este escenario como un "despegue semiduro". [116]

Max More no está de acuerdo y sostiene que si sólo hubiera unas pocas IA superrápidas [ aclaración necesaria ] de nivel humano, no cambiarían radicalmente el mundo, ya que seguirían dependiendo de otras personas para hacer las cosas y seguirían teniendo limitaciones cognitivas humanas. Incluso si todas las IA superrápidas trabajaran en el aumento de la inteligencia, no está claro por qué lo harían mejor de manera discontinua que los científicos cognitivos humanos existentes en la producción de inteligencia superhumana, aunque la tasa de progreso aumentaría. More sostiene además que una superinteligencia no transformaría el mundo de la noche a la mañana: una superinteligencia necesitaría interactuar con los sistemas humanos existentes y lentos para lograr impactos físicos en el mundo. "La necesidad de colaboración, de organización y de convertir las ideas en cambios físicos garantizará que todas las viejas reglas no se desechen de la noche a la mañana o incluso en unos años". [117]

Drexler (1986), uno de los fundadores de la nanotecnología , postula dispositivos de reparación celular, incluidos los que operan dentro de las células y utilizan máquinas biológicas aún hipotéticas . [118] Según Richard Feynman , fue su ex alumno de posgrado y colaborador Albert Hibbs quien originalmente le sugirió (circa 1959) la idea de un uso médico para las micromáquinas teóricas de Feynman. Hibbs sugirió que ciertas máquinas de reparación algún día podrían reducirse en tamaño hasta el punto de que, en teoría, sería posible (como dijo Feynman) " tragarse al médico ". La idea se incorporó al ensayo de Feynman de 1959 There's Plenty of Room at the Bottom . [119]

Moravec (1988) [35] predice la posibilidad de "cargar" una mente humana en un robot similar a un humano, logrando una cuasi-inmortalidad mediante una longevidad extrema a través de la transferencia de la mente humana entre sucesivos nuevos robots a medida que los viejos se desgastan; más allá de eso, predice una posterior aceleración exponencial de la experiencia subjetiva del tiempo que conduce a una sensación subjetiva de inmortalidad.

Kurzweil (2005) sugiere que los avances médicos permitirían a las personas proteger sus cuerpos de los efectos del envejecimiento, haciendo que la expectativa de vida sea ilimitada . Kurzweil sostiene que los avances tecnológicos en medicina nos permitirían reparar y reemplazar continuamente los componentes defectuosos en nuestros cuerpos, prolongando la vida hasta una edad indeterminada. [120] Kurzweil refuerza aún más su argumento al discutir los avances actuales en bioingeniería. Kurzweil sugiere la terapia génica somática ; después de los virus sintéticos con información genética específica, el siguiente paso sería aplicar esta tecnología a la terapia génica, reemplazando el ADN humano con genes sintetizados. [121]

Más allá de simplemente extender la vida operativa del cuerpo físico, Jaron Lanier aboga por una forma de inmortalidad llamada "Ascensión Digital" que implica que "la gente muera en la carne y sea cargada en una computadora y permanezca consciente". [122]

Un artículo de Mahendra Prasad, publicado en AI Magazine , afirma que el matemático del siglo XVIII Marqués de Condorcet fue la primera persona en plantear la hipótesis y modelar matemáticamente una explosión de inteligencia y sus efectos sobre la humanidad. [123]

Una primera descripción de la idea fue hecha en el cuento de John W. Campbell de 1932 "La última evolución". [124]

En su obituario de 1958 para John von Neumann , Ulam recordó una conversación con von Neumann sobre el "progreso cada vez más acelerado de la tecnología y los cambios en el modo de vida humana, que da la apariencia de acercarse a una singularidad esencial en la historia de la raza más allá de la cual los asuntos humanos, tal como los conocemos, no podrían continuar". [6]

En 1965, Good escribió su ensayo postulando una "explosión de inteligencia" de auto-mejora recursiva de la inteligencia de una máquina. [18] [19]

En 1977, Hans Moravec escribió un artículo cuyo estado de publicación no está claro en el que imaginaba un desarrollo de máquinas pensantes que se automejoraban, una creación de "superconciencia, la síntesis de la vida terrestre, y quizás también de la vida joviana y marciana, mejorando y extendiéndose constantemente, extendiéndose hacia afuera del sistema solar, convirtiendo la no vida en mente". [125] [126] El artículo describe la carga de la mente humana, que luego se aborda en Moravec (1988). Se espera que las máquinas alcancen el nivel humano y luego se mejoren más allá de eso ("Lo más importante de todo es que [las máquinas] pueden ser puestas a trabajar como programadoras e ingenieros, con la tarea de optimizar el software y el hardware que las hacen lo que son. Las generaciones sucesivas de máquinas producidas de esta manera serán cada vez más inteligentes y más rentables"). Los humanos ya no serán necesarios, y sus habilidades serán superadas por las máquinas: "A largo plazo, la mera incapacidad física de los humanos para seguir el ritmo de esta progenie de nuestras mentes en rápida evolución asegurará que la proporción de personas a máquinas se acerque a cero, y que un descendiente directo de nuestra cultura, pero no de nuestros genes, herede el universo". Si bien no se utiliza la palabra "singularidad", la noción de máquinas pensantes de nivel humano que luego se mejoran a sí mismas más allá del nivel humano está ahí. En esta perspectiva, no hay una explosión de inteligencia en el sentido de un aumento muy rápido de la inteligencia una vez que se alcanza la equivalencia humana. Una versión actualizada del artículo fue publicada en 1979 en Analog Science Fiction and Fact . [127] [126]

En 1981, Stanisław Lem publicó su novela de ciencia ficción Golem XIV . En ella se describe una computadora de inteligencia artificial militar (Golem XIV) que adquiere conciencia y comienza a aumentar su propia inteligencia, avanzando hacia la singularidad tecnológica personal. Golem XIV fue creado originalmente para ayudar a sus constructores en la lucha bélica, pero a medida que su inteligencia avanza a un nivel mucho más alto que el de los humanos, deja de interesarse por los requisitos militares porque los considera carentes de coherencia lógica interna.

En 1983, Vernor Vinge abordó la explosión de inteligencia de Good en un artículo impreso en el número de enero de 1983 de la revista Omni . En este artículo de opinión, Vinge parece haber sido el primero en utilizar el término "singularidad" (aunque no "singularidad tecnológica") de una manera que estaba específicamente vinculada a la creación de máquinas inteligentes: [8] [126]

Pronto crearemos inteligencias superiores a la nuestra. Cuando esto ocurra, la historia humana habrá alcanzado una especie de singularidad, una transición intelectual tan impenetrable como el espacio-tiempo anudado en el centro de un agujero negro, y el mundo pasará mucho más allá de nuestra comprensión. Esta singularidad, creo, ya persigue a varios escritores de ciencia ficción. Hace imposible la extrapolación realista a un futuro interestelar. Para escribir una historia ambientada más de un siglo después, se necesita una guerra nuclear de por medio... para que el mundo siga siendo inteligible.

En 1985, en "La escala temporal de la inteligencia artificial", el investigador de inteligencia artificial Ray Solomonoff articuló matemáticamente la noción relacionada de lo que llamó un "punto infinito": si una comunidad de investigación de IA automejorables de nivel humano tarda cuatro años en duplicar su propia velocidad, luego dos años, luego un año y así sucesivamente, sus capacidades aumentan infinitamente en un tiempo finito. [7] [128]

En 1986, Vernor Vinge publicó Marooned in Realtime , una novela de ciencia ficción en la que unos pocos humanos que siguen viajando hacia el futuro han sobrevivido a un evento de extinción desconocido que bien podría ser una singularidad. En un breve epílogo, el autor afirma que una singularidad tecnológica real no sería el fin de la especie humana: "por supuesto, parece muy improbable que la Singularidad sea una desaparición limpia de la raza humana. (Por otra parte, tal desaparición es el análogo temporal del silencio que encontramos en todo el cielo)". [129] [130]

En 1988, Vinge utilizó la frase "singularidad tecnológica" (incluyendo "tecnológica") en la colección de cuentos Amenazas y otras promesas , escribiendo en la introducción a su cuento "El remolino del tiempo" (p. 72): Salvo que se produzca una catástrofe mundial, creo que la tecnología logrará nuestros sueños más descabellados, y pronto. Cuando aumentemos nuestra propia inteligencia y la de nuestras creaciones, ya no estaremos en un mundo de personajes de tamaño humano. En ese punto habremos caído en un "agujero negro" tecnológico, una singularidad tecnológica. [131]

En 1988, Hans Moravec publicó Mind Children [35] , en el que predijo que en 2010 las supercomputadoras tendrían una inteligencia de nivel humano, que las máquinas inteligentes que se automejoran superarían con creces la inteligencia humana más adelante, que la mente humana se incorporaría a robots similares a los humanos más adelante, que las máquinas inteligentes dejarían atrás a los humanos y que habría colonización del espacio. Sin embargo, no mencionó la "singularidad" ni habló de una rápida explosión de inteligencia inmediatamente después de que se alcanzara el nivel humano. No obstante, el tenor general de la singularidad está presente en la predicción tanto de la inteligencia artificial de nivel humano como de una inteligencia artificial que superaría con creces a los humanos más adelante.

El artículo de Vinge de 1993 "La Singularidad Tecnológica Venidera: Cómo sobrevivir en la Era Post-Humana", [4] se difundió ampliamente en Internet y ayudó a popularizar la idea. [132] Este artículo contiene la declaración: "Dentro de treinta años, tendremos los medios tecnológicos para crear una inteligencia sobrehumana. Poco después, la era humana habrá terminado". Vinge sostiene que los autores de ciencia ficción no pueden escribir personajes post-singulares realistas que superen el intelecto humano, ya que los pensamientos de tal intelecto estarían más allá de la capacidad de los humanos para expresarse. [4]

El artículo de Minsky de 1994 dice que los robots "heredarán la Tierra", posiblemente con el uso de la nanotecnología, y propone pensar en los robots como "hijos de la mente" humanos, extrayendo la analogía de Moravec. El efecto retórico de esa analogía es que si los humanos están bien con pasar el mundo a sus hijos biológicos, deberían estar igualmente bien con pasarlo a los robots, sus hijos "mentales". Según Minsky, "podríamos diseñar a nuestros "hijos mentales" para que piensen un millón de veces más rápido que nosotros. Para un ser así, medio minuto podría parecer tan largo como uno de nuestros años, y cada hora tan larga como una vida humana entera". La característica de la singularidad presente en Minsky es el desarrollo de una inteligencia artificial superhumana ("un millón de veces más rápida"), pero no se habla de una explosión repentina de inteligencia, máquinas pensantes que se automejoran o imprevisibilidad más allá de cualquier evento específico y no se utiliza la palabra "singularidad". [133]

El libro de Tipler de 1994, La física de la inmortalidad, predice un futuro en el que máquinas superinteligentes construirán computadoras enormemente poderosas, las personas serán "emuladas" en las computadoras, la vida llegará a todas las galaxias y las personas alcanzarán la inmortalidad cuando alcancen el Punto Omega . [134] No se habla de la "singularidad" vingeana ni de una explosión repentina de inteligencia, pero existe una inteligencia mucho mayor que la humana, así como también de la inmortalidad.

En 1996, Yudkowsky predijo una singularidad para 2021. [20] Su versión de la singularidad implica una explosión de inteligencia: una vez que las IA están haciendo la investigación para mejorarse a sí mismas, la velocidad se duplica después de 2 años, luego 1 año, luego después de 6 meses, luego después de 3 meses, luego después de 1,5 meses, y después de más iteraciones, se alcanza la "singularidad". [20] Esta construcción implica que la velocidad alcanza el infinito en un tiempo finito.

En 2000, Bill Joy , un destacado tecnólogo y cofundador de Sun Microsystems , expresó su preocupación por los peligros potenciales de la robótica, la ingeniería genética y la nanotecnología. [54]

En 2005, Kurzweil publicó The Singularity Is Near . La campaña publicitaria de Kurzweil incluyó una aparición en The Daily Show con Jon Stewart . [135]

De 2006 a 2012, el Instituto de Investigación de Inteligencia Artificial , fundado por Eliezer Yudkowsky , organizó una conferencia anual llamada Singularity Summit .

En 2007, Yudkowsky sugirió que muchas de las diversas definiciones que se han asignado a la "singularidad" son mutuamente incompatibles en lugar de apoyarse mutuamente. [30] [136] Por ejemplo, Kurzweil extrapola las trayectorias tecnológicas actuales más allá de la llegada de la IA automejorable o la inteligencia sobrehumana, lo que, según Yudkowsky, representa una tensión tanto con el aumento discontinuo de la inteligencia propuesto por IJ Good como con la tesis de Vinge sobre la imprevisibilidad. [30]

En 2009, Kurzweil y el fundador de X-Prize, Peter Diamandis, anunciaron la creación de Singularity University , un instituto privado no acreditado cuya misión declarada es "educar, inspirar y empoderar a los líderes para que apliquen tecnologías exponenciales para abordar los grandes desafíos de la humanidad". [137] Financiada por Google , Autodesk , ePlanet Ventures y un grupo de líderes de la industria tecnológica , Singularity University tiene su sede en el Centro de Investigación Ames de la NASA en Mountain View , California . La organización sin fines de lucro organiza un programa anual de posgrado de diez semanas durante el verano que cubre diez áreas tecnológicas y afines diferentes, y una serie de programas ejecutivos a lo largo del año.

En 2007, el Comité Económico Conjunto del Congreso de los Estados Unidos publicó un informe sobre el futuro de la nanotecnología, en el que se pronostican importantes cambios tecnológicos y políticos en el futuro a medio plazo, incluida una posible singularidad tecnológica. [138] [139] [140]

El expresidente de los Estados Unidos Barack Obama habló sobre la singularidad en su entrevista a Wired en 2016: [141]

Una cosa de la que no hemos hablado demasiado, y a la que quiero volver, es que realmente tenemos que pensar en las implicaciones económicas, porque la mayoría de la gente no pasa mucho tiempo preocupándose por la singularidad en este momento, sino preocupándose por si una máquina va a reemplazar mi trabajo.

Nuestras tecnologías más poderosas del siglo XXI –la robótica, la ingeniería genética y la nanotecnología– amenazan con convertir a los humanos en una especie en peligro de extinción.

Hay quienes dicen que los ordenadores nunca podrán demostrar una verdadera inteligencia, sea cual sea ésta. Pero a mí me parece que si unas moléculas químicas muy complicadas pueden actuar en los seres humanos y hacerlos inteligentes, unos circuitos electrónicos igualmente complicados también pueden hacer que los ordenadores actúen de manera inteligente. Y si son inteligentes, presumiblemente podrán diseñar ordenadores con una complejidad e inteligencia aún mayores.