La función de transferencia óptica ( OTF ) de un sistema óptico como una cámara , un microscopio , un ojo humano o un proyector especifica cómo se capturan o transmiten las diferentes frecuencias espaciales. Lo utilizan los ingenieros ópticos para describir cómo la óptica proyecta la luz del objeto o escena sobre una película fotográfica, un conjunto de detectores , una retina , una pantalla o simplemente el siguiente elemento en la cadena de transmisión óptica. Una variante, la función de transferencia de modulación ( MTF ), ignora los efectos de fase, pero es equivalente a la OTF en muchas situaciones.

Cualquiera de las funciones de transferencia especifica la respuesta a un patrón de onda sinusoidal periódica que pasa a través del sistema de lentes, en función de su frecuencia o período espacial, y su orientación. Formalmente, OTF se define como la transformada de Fourier de la función de dispersión puntual (PSF, es decir, la respuesta al impulso de la óptica, la imagen de una fuente puntual). Como transformada de Fourier, la OTF tiene valores complejos; pero tendrá un valor real en el caso común de un PSF que sea simétrico con respecto a su centro. El MTF se define formalmente como la magnitud (valor absoluto) del complejo OTF.

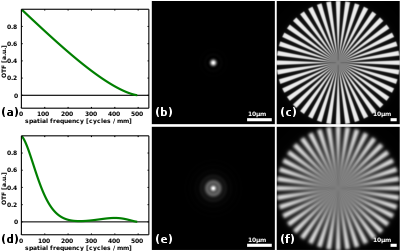

La imagen de la derecha muestra las funciones de transferencia óptica para dos sistemas ópticos diferentes en los paneles (a) y (d). El primero corresponde al sistema de imágenes ideal, limitado por difracción , con pupila circular . Su función de transferencia disminuye aproximadamente gradualmente con la frecuencia espacial hasta alcanzar el límite de difracción, en este caso a 500 ciclos por milímetro o un período de 2 μm. Dado que este sistema de imágenes captura características periódicas tan pequeñas como este período, se podría decir que su resolución es de 2 μm. [1] El panel (d) muestra un sistema óptico que está desenfocado. Esto conduce a una fuerte reducción del contraste en comparación con el sistema de imágenes con difracción limitada. Se puede observar que el contraste es cero alrededor de 250 ciclos/mm, o períodos de 4 μm. Esto explica por qué las imágenes del sistema desenfocado (e,f) son más borrosas que las del sistema de difracción limitada (b,c). Tenga en cuenta que aunque el sistema desenfocado tiene un contraste muy bajo en frecuencias espaciales de alrededor de 250 ciclos/mm, el contraste en frecuencias espaciales cercanas al límite de difracción de 500 ciclos/mm está limitado por la difracción. Una observación minuciosa de la imagen en el panel (f) muestra que la imagen de las grandes densidades de radios cerca del centro del objetivo de los radios es relativamente nítida.

Dado que la función de transferencia óptica [2] (OTF) se define como la transformada de Fourier de la función de dispersión puntual (PSF), en general es una función de frecuencia espacial de valores complejos . La proyección de un patrón periódico específico está representada por un número complejo con valor absoluto y argumento complejo proporcional al contraste relativo y la traducción de la proyección proyectada, respectivamente.

A menudo, la reducción del contraste es de mayor interés y la traducción del patrón puede ignorarse. El contraste relativo viene dado por el valor absoluto de la función de transferencia óptica, una función comúnmente conocida como función de transferencia de modulación ( MTF ). Sus valores indican cuánto contraste del objeto se captura en la imagen en función de la frecuencia espacial. La MTF tiende a disminuir al aumentar la frecuencia espacial de 1 a 0 (en el límite de difracción); sin embargo, la función no suele ser monótona . Por otro lado, cuando también la traducción del patrón es importante, el argumento complejo de la función de transferencia óptica se puede representar como una segunda función de valor real, comúnmente denominada función de transferencia de fase ( PhTF ). La función de transferencia óptica de valor complejo puede verse como una combinación de estas dos funciones de valor real:

dónde

y representa la función argumento compleja, mientras que es la frecuencia espacial del patrón periódico. En general es un vector con una frecuencia espacial para cada dimensión, es decir, indica también la dirección del patrón periódico.

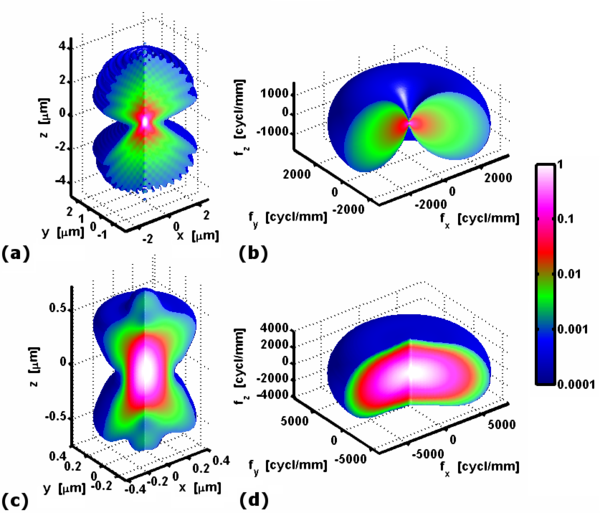

La respuesta al impulso de un sistema óptico bien enfocado es una distribución de intensidad tridimensional con un máximo en el plano focal y, por lo tanto, podría medirse registrando una pila de imágenes mientras se desplaza el detector axialmente. En consecuencia, la función de transferencia óptica tridimensional puede definirse como la transformada de Fourier tridimensional de la respuesta al impulso. Aunque normalmente sólo se utiliza una sección unidimensional o, a veces, bidimensional, la función de transferencia óptica tridimensional puede mejorar la comprensión de microscopios como el microscopio de iluminación estructurada.

Fiel a la definición de función de transferencia , debe indicar la fracción de luz que se detectó desde el objeto fuente puntual. Sin embargo, normalmente el contraste con respecto a la cantidad total de luz detectada es lo más importante. Por tanto, es una práctica común normalizar la función de transferencia óptica a la intensidad detectada, por lo tanto .

Generalmente, la función de transferencia óptica depende de factores como el espectro y la polarización de la luz emitida y la posición de la fuente puntual. Por ejemplo, el contraste y la resolución de la imagen suelen ser óptimos en el centro de la imagen y se deterioran hacia los bordes del campo de visión. Cuando se produce una variación significativa, la función de transferencia óptica puede calcularse para un conjunto de posiciones o colores representativos.

A veces es más práctico definir las funciones de transferencia basándose en un patrón binario de franjas blancas y negras. La función de transferencia para un patrón periódico blanco y negro de igual ancho se conoce como función de transferencia de contraste (CTF) . [3]

Un sistema de lentes perfecto proporcionará una proyección de alto contraste sin cambiar el patrón periódico, por lo que la función de transferencia óptica es idéntica a la función de transferencia de modulación. Normalmente, el contraste se reducirá gradualmente hacia cero en un punto definido por la resolución de la óptica. Por ejemplo, un sistema de imágenes ópticas f/4 perfecto y no aberrado utilizado, en la longitud de onda visible de 500 nm, tendría la función de transferencia óptica que se muestra en la figura de la derecha.

En el gráfico se puede leer que el contraste se reduce gradualmente y llega a cero con una frecuencia espacial de 500 ciclos por milímetro, es decir, la resolución óptica de la proyección de la imagen es de 1/500 de milímetro o 2 micrómetros. En consecuencia, para este dispositivo de imágenes en particular, los radios se vuelven cada vez más borrosos hacia el centro hasta que se fusionan en un disco gris sin resolver. Tenga en cuenta que a veces la función de transferencia óptica se da en unidades del objeto o espacio muestral, ángulo de observación, ancho de la película o se normaliza al máximo teórico. La conversión entre los dos suele ser una cuestión de multiplicación o división. Por ejemplo, un microscopio normalmente aumenta todo entre 10 y 100 veces, y una cámara réflex generalmente demagnifica objetos a una distancia de 5 metros en un factor de 100 a 200.

La resolución de un dispositivo de imagen digital no sólo está limitada por la óptica, sino también por el número de píxeles, más concretamente por su distancia de separación. Como lo explica el teorema de muestreo de Nyquist-Shannon , para igualar la resolución óptica del ejemplo dado, los píxeles de cada canal de color deben estar separados por 1 micrómetro, la mitad del período de 500 ciclos por milímetro. Una mayor cantidad de píxeles en el mismo tamaño de sensor no permitirá la resolución de detalles más finos. Por otro lado, cuando el espaciado entre píxeles es mayor a 1 micrómetro, la resolución estará limitada por la separación entre píxeles; además, el aliasing puede conducir a una reducción adicional de la fidelidad de la imagen.

Un sistema de imágenes imperfecto y aberrado podría poseer la función de transferencia óptica que se muestra en la siguiente figura.

Como sistema de lentes ideal, el contraste llega a cero a una frecuencia espacial de 500 ciclos por milímetro. Sin embargo, a frecuencias espaciales más bajas el contraste es considerablemente menor que el del sistema perfecto del ejemplo anterior. De hecho, el contraste llega a ser cero en varias ocasiones incluso para frecuencias espaciales inferiores a 500 ciclos por milímetro. Esto explica las bandas circulares grises en la imagen de los radios que se muestra en la figura anterior. Entre las bandas grises, los radios parecen invertirse de negro a blanco y viceversa , esto se conoce como inversión de contraste, directamente relacionado con la inversión de signos en la parte real de la función de transferencia óptica, y se representa como un desplazamiento de medio período para algunos patrones periódicos.

Si bien se podría argumentar que la resolución tanto del sistema ideal como del imperfecto es de 2 μm, o 500 LP/mm, está claro que las imágenes del último ejemplo son menos nítidas. Una definición de resolución que esté más en línea con la calidad percibida utilizaría en cambio la frecuencia espacial en la que ocurre el primer cero, 10 μm o 100 LP/mm. Las definiciones de resolución, incluso para sistemas de imágenes perfectos, varían ampliamente. La función de transferencia óptica proporciona una imagen más completa e inequívoca.

Los sistemas ópticos, y en particular las aberraciones ópticas, no siempre son simétricos rotacionalmente. De este modo, se pueden representar patrones periódicos que tienen una orientación diferente con diferente contraste incluso si su periodicidad es la misma. Por lo tanto, las funciones de transferencia óptica o funciones de transferencia de modulación son generalmente funciones bidimensionales. Las siguientes figuras muestran el equivalente bidimensional del sistema ideal e imperfecto discutido anteriormente, para un sistema óptico con trébol , una aberración no simétrica rotacional.

Las funciones de transferencia óptica no siempre tienen un valor real. Los patrones de período pueden variar en cualquier cantidad, dependiendo de la aberración del sistema. Este es generalmente el caso de las aberraciones no simétricas rotacionales. El tono de los colores de los gráficos de superficie en la figura anterior indica la fase. Se puede ver que, mientras que para las aberraciones simétricas rotacionales la fase es 0 o π y, por lo tanto, la función de transferencia tiene un valor real, para las aberraciones simétricas no rotacionales la función de transferencia tiene un componente imaginario y la fase varía continuamente.

Mientras que la resolución óptica , como se usa comúnmente con referencia a los sistemas de cámaras, describe solo el número de píxeles en una imagen y, por lo tanto, el potencial para mostrar detalles finos, la función de transferencia describe la capacidad de los píxeles adyacentes para cambiar de negro a blanco en respuesta a patrones de frecuencia espacial variable y, por lo tanto, la capacidad real de mostrar detalles finos, ya sea con contraste total o reducido. Una imagen reproducida con una función de transferencia óptica que "se desplaza" a altas frecuencias espaciales aparecerá "borrosa" en el lenguaje cotidiano.

Tomando el ejemplo de un sistema de vídeo de alta definición (HD) actual, con 1920 por 1080 píxeles, el teorema de Nyquist establece que debería ser posible, en un sistema perfecto, resolver completamente (con verdaderas transiciones de negro a blanco) un total de 1920 líneas alternas en blanco y negro combinadas, también denominada frecuencia espacial de 1920/2 = 960 pares de líneas por ancho de imagen, o 960 ciclos por ancho de imagen (también son posibles definiciones en términos de ciclos por unidad de ángulo o por mm, pero generalmente menos claro cuando se trata de cámaras y más apropiado para telescopios, etc.). En la práctica, esto está lejos de ser el caso, y las frecuencias espaciales que se acercan a la frecuencia de Nyquist generalmente se reproducirán con amplitud decreciente, de modo que los detalles finos, aunque pueden verse, se reducen considerablemente en contraste. Esto da lugar a la interesante observación de que, por ejemplo, una imagen de televisión de definición estándar derivada de un escáner de película que utiliza sobremuestreo , como se describe más adelante, puede parecer más nítida que una imagen de alta definición tomada con una cámara con una función de transferencia de modulación deficiente. Las dos imágenes muestran una diferencia interesante que a menudo se pasa por alto: la primera tiene un contraste total en los detalles hasta cierto punto, pero luego no tiene detalles realmente finos, mientras que la segunda contiene detalles más finos, pero con un contraste tan reducido que parece inferior en general.

Aunque normalmente se piensa que una imagen es plana o bidimensional, el sistema de imágenes producirá una distribución de intensidad tridimensional en el espacio de la imagen que, en principio, se puede medir. por ejemplo, se podría traducir un sensor bidimensional para capturar una distribución de intensidad tridimensional. La imagen de una fuente puntual es también una distribución de intensidad tridimensional (3D) que puede representarse mediante una función de dispersión de puntos 3D. Como ejemplo, la figura de la derecha muestra la función de dispersión de puntos 3D en el espacio de objetos de un microscopio de campo amplio (a) junto con la de un microscopio confocal (c). Aunque se utiliza el mismo objetivo de microscopio con una apertura numérica de 1,49, está claro que la función de dispersión del punto confocal es más compacta tanto en las dimensiones laterales (x,y) como en la dimensión axial (z). Se podría concluir con razón que la resolución de un microscopio confocal es superior a la de un microscopio de campo amplio en las tres dimensiones.

Una función de transferencia óptica tridimensional se puede calcular como la transformada de Fourier tridimensional de la función de dispersión de puntos 3D. Su magnitud codificada por colores se representa en los paneles (b) y (d), correspondientes a las funciones de dispersión de puntos que se muestran en los paneles (a) y (c), respectivamente. La función de transferencia del microscopio de campo amplio tiene un soporte que es la mitad que el del microscopio confocal en las tres dimensiones, lo que confirma la resolución más baja del microscopio de campo amplio, observada anteriormente. Tenga en cuenta que a lo largo del eje z , para x = y = 0, la función de transferencia es cero en todas partes excepto en el origen. Este cono faltante es un problema bien conocido que impide el corte óptico utilizando un microscopio de campo amplio. [4]

La función de transferencia óptica bidimensional en el plano focal se puede calcular integrando la función de transferencia óptica 3D a lo largo del eje z . Aunque la función de transferencia 3D del microscopio de campo amplio (b) es cero en el eje z para z ≠ 0; su integral, la transferencia óptica 2D, alcanza un máximo en x = y = 0. Esto sólo es posible porque la función de transferencia óptica 3D diverge en el origen x = y = z = 0. Los valores de la función a lo largo del eje z de la La función de transferencia óptica 3D corresponde a la función delta de Dirac .

La mayoría del software de diseño óptico tiene la funcionalidad de calcular la función de transferencia óptica o de modulación de un diseño de lente. Los sistemas ideales, como los de los ejemplos aquí, se calculan fácilmente numéricamente utilizando software como Julia , GNU Octave o Matlab y, en algunos casos específicos, incluso analíticamente. La función de transferencia óptica se puede calcular siguiendo dos enfoques: [5]

Matemáticamente ambos enfoques son equivalentes. Los cálculos numéricos suelen realizarse de manera más eficiente mediante la transformada de Fourier; sin embargo, el cálculo analítico puede ser más manejable utilizando el enfoque de autocorrelación.

Dado que la función de transferencia óptica es la transformada de Fourier de la función de dispersión de puntos , y la función de dispersión de puntos es el cuadrado absoluto de la función de pupila transformada de Fourier inversa , la función de transferencia óptica también se puede calcular directamente a partir de la función de pupila . Del teorema de convolución se puede ver que la función de transferencia óptica es en realidad la autocorrelación de la función de pupila . [5]

La función de la pupila de un sistema óptico ideal con una apertura circular es un disco de radio unitario. Por tanto, la función de transferencia óptica de dicho sistema se puede calcular geométricamente a partir del área de intersección entre dos discos idénticos a una distancia de , donde está la frecuencia espacial normalizada a la frecuencia transmitida más alta. [2] En general, la función de transferencia óptica está normalizada a un valor máximo de uno para , por lo que el área resultante debe dividirse por .

El área de intersección se puede calcular como la suma de las áreas de dos segmentos circulares idénticos : , donde es el ángulo del segmento circular. Sustituyendo y usando las igualdades y , la ecuación del área se puede reescribir como . Por tanto, la función de transferencia óptica normalizada viene dada por:

Una discusión más detallada se puede encontrar en [5] y. [2] : 152-153

La función de transferencia óptica unidimensional se puede calcular como la transformada discreta de Fourier de la función de dispersión de línea. Estos datos se grafican con los datos de frecuencia espacial . En este caso, se ajusta un polinomio de sexto orden a la curva MTF versus frecuencia espacial para mostrar la tendencia. La frecuencia de corte del 50% se determina para producir la frecuencia espacial correspondiente. Por lo tanto, a partir de estos datos se determina la posición aproximada de mejor enfoque de la unidad bajo prueba .

La transformada de Fourier de la función de dispersión de líneas (LSF) no se puede determinar analíticamente mediante las siguientes ecuaciones:

Por lo tanto, la Transformada de Fourier se aproxima numéricamente utilizando la transformada de Fourier discreta . [6]

dónde

Luego, el MTF se traza frente a la frecuencia espacial y todos los datos relevantes relacionados con esta prueba se pueden determinar a partir de ese gráfico.

En aperturas numéricas elevadas, como las que se encuentran en la microscopía, es importante considerar la naturaleza vectorial de los campos que transportan la luz. Al descomponer las ondas en tres componentes independientes correspondientes a los ejes cartesianos, se puede calcular una función de dispersión puntual para cada componente y combinarla en una función de dispersión puntual vectorial . De manera similar, se puede determinar una función de transferencia óptica vectorial como se muestra en ( [7] ) y ( [8] ).

La función de transferencia óptica no sólo es útil para el diseño de sistemas ópticos, sino que también es valiosa para caracterizar sistemas fabricados.

La función de transferencia óptica se define como la transformada de Fourier de la respuesta al impulso del sistema óptico, también llamada función de dispersión puntual . La función de transferencia óptica se obtiene así fácilmente adquiriendo primero la imagen de una fuente puntual y aplicando la transformada de Fourier discreta bidimensional a la imagen muestreada. Una fuente puntual de este tipo puede ser, por ejemplo, una luz brillante detrás de una pantalla con un orificio, una microesfera fluorescente o metálica , o simplemente un punto pintado en una pantalla. El cálculo de la función de transferencia óptica a través de la función de dispersión puntual es versátil ya que puede caracterizar completamente la óptica con aberraciones cromáticas y variables espaciales repitiendo el procedimiento para varias posiciones y espectros de longitud de onda de la fuente puntual.

Cuando se puede suponer que las aberraciones son espacialmente invariantes, se pueden usar patrones alternativos para determinar la función de transferencia óptica, como líneas y bordes. Las funciones de transferencia correspondientes se denominan función de extensión de línea y función de extensión de borde, respectivamente. Estos objetos extendidos iluminan más píxeles en la imagen y pueden mejorar la precisión de la medición debido a la mayor relación señal-ruido. La función de transferencia óptica se calcula en este caso como la transformada de Fourier discreta bidimensional de la imagen y se divide por la del objeto extendido. Normalmente se utiliza una línea o un borde blanco y negro.

La transformada de Fourier bidimensional de una recta que pasa por el origen es una recta ortogonal a él y que pasa por el origen. Por lo tanto, el divisor es cero para todas las dimensiones excepto una; en consecuencia, la función de transferencia óptica solo se puede determinar para una sola dimensión utilizando una función de dispersión de línea única (LSF). Si es necesario, la función de transferencia óptica bidimensional se puede determinar repitiendo la medición con líneas en varios ángulos.

La función de extensión de línea se puede encontrar utilizando dos métodos diferentes. Se puede encontrar directamente a partir de una aproximación de línea ideal proporcionada por un objetivo de prueba de rendija o se puede derivar de la función de dispersión de bordes, que se analiza en la siguiente subsección.

La transformada de Fourier bidimensional de un borde también es distinta de cero en una sola línea, ortogonal al borde. Esta función a veces se denomina función de dispersión de bordes (ESF). [9] [10] Sin embargo, los valores en esta línea son inversamente proporcionales a la distancia desde el origen. Aunque las imágenes de medición obtenidas con esta técnica iluminan una gran área de la cámara, esto beneficia principalmente la precisión en frecuencias espaciales bajas. Al igual que con la función de dispersión de líneas, cada medición solo determina un único eje de la función de transferencia óptica, por lo que son necesarias mediciones repetidas si no se puede suponer que el sistema óptico sea simétrico rotacional.

Como se muestra en la figura de la derecha, un operador define un área de caja que abarca el borde de una imagen de objetivo de prueba con filo de cuchillo retroiluminada por un cuerpo negro . El área del cuadro se define como aproximadamente el 10% [ cita necesaria ] del área total del marco. Los datos de píxeles de la imagen se traducen en una matriz bidimensional ( intensidad de píxeles y posición de píxeles). La amplitud (intensidad de píxeles) de cada línea dentro de la matriz se normaliza y promedia. Esto produce la función de extensión de borde.

dónde

La función de dispersión de líneas es idéntica a la primera derivada de la función de dispersión de bordes, [11] que se diferencia mediante métodos numéricos . En caso de que sea más práctico medir la función de extensión de borde, se puede determinar la función de extensión de línea de la siguiente manera:

Normalmente, el ESF solo se conoce en puntos discretos, por lo que el LSF se aproxima numéricamente utilizando la diferencia finita :

dónde:

Aunque la "nitidez" a menudo se juzga según patrones de cuadrícula de líneas alternas en blanco y negro, debe medirse estrictamente utilizando una variación de onda sinusoidal de negro a blanco (una versión borrosa del patrón habitual). Cuando se utiliza un patrón de onda cuadrada (simples líneas blancas y negras) no sólo hay más riesgo de aliasing, sino que se debe tener en cuenta el hecho de que el componente fundamental de una onda cuadrada es mayor que la amplitud de la onda cuadrada misma ( los componentes armónicos reducen la amplitud del pico). Por lo tanto, un gráfico de prueba de onda cuadrada mostrará resultados optimistas (mejor resolución de frecuencias espaciales altas de la que realmente se logra). El resultado de la onda cuadrada a veces se denomina "función de transferencia de contraste" (CTF).

En la práctica, muchos factores dan lugar a una considerable borrosidad de una imagen reproducida, de modo que los patrones con una frecuencia espacial justo por debajo de la tasa de Nyquist pueden ni siquiera ser visibles, y los patrones más finos que pueden aparecer "descoloridos" como tonos de gris, no de negro y blanco. Un factor importante suele ser la imposibilidad de fabricar el filtro óptico de "pared de ladrillos" perfecto (a menudo realizado como una "placa de fase" o una lente con propiedades de desenfoque específicas en cámaras digitales y videocámaras). Un filtro de este tipo es necesario para reducir el alias eliminando las frecuencias espaciales por encima de la tasa de Nyquist de la visualización.

En la práctica, la única forma de acercarse a la nitidez teórica posible en un sistema de imágenes digitales como una cámara es utilizar más píxeles en el sensor de la cámara que muestras en la imagen final, y "reducir" o "interpolar" utilizando un procesamiento digital especial que corta de frecuencias altas por encima de la tasa de Nyquist para evitar el aliasing mientras se mantiene un MTF razonablemente plano hasta esa frecuencia. Este enfoque se adoptó por primera vez en la década de 1970, cuando se desarrollaron escáneres de puntos voladores y, posteriormente, escáneres de líneas CCD , que tomaban muestras de más píxeles de los necesarios y luego los convertían, razón por la cual las películas siempre se han visto más nítidas en la televisión que otros materiales filmados con una cámara de vídeo. . La única forma teóricamente correcta de interpolar o convertir a la baja es mediante el uso de un filtro espacial de paso bajo pronunciado, realizado mediante convolución con una función de ponderación bidimensional sin( x )/ x que requiere un procesamiento potente. En la práctica, se utilizan varias aproximaciones matemáticas para reducir el requisito de procesamiento. Estas aproximaciones ahora se implementan ampliamente en sistemas de edición de video y en programas de procesamiento de imágenes como Photoshop .

Así como el vídeo de definición estándar con un MTF de alto contraste sólo es posible con sobremuestreo, la televisión HD con una nitidez teórica completa sólo es posible comenzando con una cámara que tenga una resolución significativamente mayor, seguida de un filtrado digital. Ahora que las películas se graban en vídeo 4k e incluso 8k para cine, podemos esperar ver las mejores imágenes en HDTV sólo de películas o material filmado con un estándar más alto. Por mucho que aumentemos el número de píxeles utilizados en las cámaras, esto siempre será así en ausencia de un filtro espacial óptico perfecto. De manera similar, una imagen de 5 megapíxeles obtenida con una cámara fija de 5 megapíxeles nunca puede ser más nítida que una imagen de 5 megapíxeles obtenida después de una conversión descendente de una cámara fija de 10 megapíxeles de igual calidad. Debido al problema de mantener un MTF de alto contraste, emisoras como la BBC consideraron durante mucho tiempo mantener la televisión de definición estándar, pero mejorando su calidad filmando y viendo con muchos más píxeles (aunque, como se mencionó anteriormente, un sistema de este tipo, aunque impresionante , en última instancia, carece de detalles muy finos que, aunque atenuados, realzan el efecto de la visualización en alta definición real).

Otro factor en las cámaras y videocámaras digitales es la resolución de la lente. Se puede decir que una lente "resuelve" 1920 líneas horizontales, pero esto no significa que lo haga con una modulación completa del negro al blanco. La 'función de transferencia de modulación' (sólo un término para la magnitud de la función de transferencia óptica sin tener en cuenta la fase) proporciona la medida real del rendimiento de la lente y se representa mediante un gráfico de amplitud frente a frecuencia espacial.

La difracción de apertura de la lente también limita el MTF. Si bien reducir la apertura de una lente generalmente reduce las aberraciones y, por lo tanto, mejora la planitud del MTF, existe una apertura óptima para cualquier lente y tamaño de sensor de imagen más allá de la cual aperturas más pequeñas reducen la resolución debido a la difracción, que propaga la luz a través del sensor de imagen. Esto no era un problema en la época de las cámaras de placa e incluso de las películas de 35 mm, pero se ha convertido en una limitación insuperable con los sensores de formato muy pequeño utilizados en algunas cámaras digitales y especialmente en las cámaras de vídeo. Las videocámaras de consumo HD de primera generación utilizaban sensores de 1/4 de pulgada, para los cuales aperturas menores que aproximadamente f4 comienzan a limitar la resolución. Incluso las cámaras de vídeo profesionales utilizan principalmente sensores de 2/3 de pulgada, lo que prohíbe el uso de aperturas alrededor de f16 que se habrían considerado normales para los formatos de película. Algunas cámaras (como la Pentax K10D ) cuentan con un modo de "exposición automática MTF", donde la elección de la apertura se optimiza para obtener la máxima nitidez. Normalmente esto significa en algún lugar en el medio del rango de apertura. [12]

Recientemente se ha producido un cambio hacia el uso de cámaras réflex digitales de lente única de gran formato de imagen impulsado por la necesidad de sensibilidad con poca luz y efectos de profundidad de campo estrecha . Esto ha llevado a que algunos realizadores de programas de cine y televisión prefieran estas cámaras incluso a las cámaras de vídeo HD profesionales, debido a su potencial "fílmico". En teoría, el uso de cámaras con sensores de 16 y 21 megapíxeles ofrece la posibilidad de una nitidez casi perfecta mediante conversión descendente dentro de la cámara, con filtrado digital para eliminar el aliasing. Estas cámaras producen resultados muy impresionantes y parecen estar liderando el camino en la producción de vídeo hacia la conversión descendente de gran formato, convirtiéndose el filtrado digital en el enfoque estándar para la realización de un MTF plano con verdadera libertad de aliasing.

Debido a efectos ópticos, el contraste puede ser subóptimo y acercarse a cero antes de que se alcance la frecuencia Nyquist de la pantalla. La reducción del contraste óptico se puede revertir parcialmente amplificando digitalmente las frecuencias espaciales de forma selectiva antes de la visualización o el procesamiento posterior. Aunque existen procedimientos de restauración de imágenes digitales más avanzados, el algoritmo de deconvolución de Wiener se utiliza a menudo por su simplicidad y eficiencia. Dado que esta técnica multiplica los componentes espectrales espaciales de la imagen, también amplifica el ruido y los errores debidos, por ejemplo, al aliasing. Por lo tanto, sólo es eficaz en grabaciones de buena calidad con una relación señal-ruido suficientemente alta.

En general, en la función de dispersión puntual , la imagen de una fuente puntual también depende de factores como la longitud de onda ( color ) y el ángulo del campo (posición lateral de la fuente puntual). Cuando dicha variación es suficientemente gradual, el sistema óptico podría caracterizarse por un conjunto de funciones de transferencia óptica. Sin embargo, cuando la imagen de la fuente puntual cambia abruptamente durante la traslación lateral, la función de transferencia óptica no describe el sistema óptico con precisión.