La simetría no sólo se da en geometría , sino también en otras ramas de las matemáticas. La simetría es un tipo de invariancia : la propiedad de que un objeto matemático permanece invariable ante un conjunto de operaciones o transformaciones . [1]

Dado un objeto estructurado X de cualquier tipo, una simetría es una aplicación del objeto sobre sí mismo que preserva la estructura. Esto puede ocurrir de muchas maneras; por ejemplo, si X es un conjunto sin estructura adicional, una simetría es una aplicación biyectiva del conjunto sobre sí mismo, dando lugar a grupos de permutación . Si el objeto X es un conjunto de puntos en el plano con su estructura métrica o cualquier otro espacio métrico , una simetría es una biyección del conjunto sobre sí mismo que preserva la distancia entre cada par de puntos (es decir, una isometría ).

En general, cada tipo de estructura en matemáticas tendrá su propio tipo de simetría, muchos de los cuales se enumeran en los puntos mencionados anteriormente.

Los tipos de simetría considerados en geometría básica incluyen simetría reflexiva , simetría rotacional , simetría traslacional y simetría de reflexión de deslizamiento , que se describen con más detalle en el artículo principal Simetría (geometría) .

Sea f ( x ) una función de valor real de una variable real, entonces f es par si la siguiente ecuación se cumple para todos los x y -x en el dominio de f :

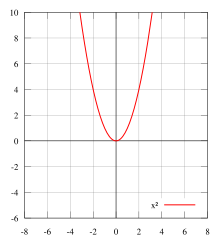

Geométricamente hablando, la cara gráfica de una función par es simétrica con respecto al eje y , lo que significa que su gráfica permanece inalterada después de la reflexión sobre el eje y . Algunos ejemplos de funciones pares son | x | , x 2 , x 4 , cos ( x ) y cosh ( x ).

Nuevamente, sea f una función de valor real de una variable real, entonces f es impar si la siguiente ecuación se cumple para todos los x y -x en el dominio de f :

Eso es,

Geométricamente, la gráfica de una función impar tiene simetría rotacional con respecto al origen , lo que significa que su gráfica permanece inalterada después de una rotación de 180 grados sobre el origen. Ejemplos de funciones impares son x , x 3 , sen ( x ), senh ( x ) y erf ( x ).

La integral de una función impar de − A a + A es cero, siempre que A sea finito y que la función sea integrable (por ejemplo, no tenga asíntotas verticales entre − A y A ). [3]

La integral de una función par de − A a + A es el doble de la integral de 0 a + A , siempre que A sea finito y la función sea integrable (por ejemplo, no tenga asíntotas verticales entre − A y A ). [3] Esto también es válido cuando A es infinito, pero solo si la integral converge.

En álgebra lineal , una matriz simétrica es una matriz cuadrada que es igual a su transpuesta (es decir, es invariante ante la transposición de matrices). Formalmente, la matriz A es simétrica si

Según la definición de igualdad de matrices, que exige que las entradas en todas las posiciones correspondientes sean iguales, las matrices iguales deben tener las mismas dimensiones (ya que las matrices de diferentes tamaños o formas no pueden ser iguales). En consecuencia, solo las matrices cuadradas pueden ser simétricas.

Las entradas de una matriz simétrica son simétricas respecto de la diagonal principal . Por lo tanto, si las entradas se escriben como A = ( a ij ), entonces a ij = a ji , para todos los índices i y j .

Por ejemplo, la siguiente matriz 3×3 es simétrica:

Toda matriz diagonal cuadrada es simétrica, ya que todos los elementos fuera de la diagonal son cero. De manera similar, cada elemento diagonal de una matriz antisimétrica debe ser cero, ya que cada uno es su propio negativo.

En álgebra lineal, una matriz simétrica real representa un operador autoadjunto sobre un espacio de producto interno real . El objeto correspondiente para un espacio de producto interno complejo es una matriz hermítica con entradas de valor complejo, que es igual a su transpuesta conjugada . Por lo tanto, en álgebra lineal sobre números complejos, a menudo se supone que una matriz simétrica se refiere a una que tiene entradas de valor real. Las matrices simétricas aparecen de forma natural en una variedad de aplicaciones, y el software de álgebra lineal numérica típico hace adaptaciones especiales para ellas.

El grupo simétrico S n (en un conjunto finito de n símbolos) es el grupo cuyos elementos son todas las permutaciones de los n símbolos, y cuya operación de grupo es la composición de tales permutaciones, que se tratan como funciones biyectivas del conjunto de símbolos hacia sí mismo. [4] Puesto que hay n ! ( n factorial ) permutaciones posibles de un conjunto de n símbolos, se deduce que el orden (es decir, el número de elementos) del grupo simétrico S n es n !.

Un polinomio simétrico es un polinomio P ( X 1 , X 2 , ..., X n ) en n variables, tal que si se intercambia cualquiera de las variables, se obtiene el mismo polinomio. Formalmente, P es un polinomio simétrico si para cualquier permutación σ de los subíndices 1, 2, ..., n , se tiene P ( X σ(1) , X σ(2) , ..., X σ( n ) ) = P ( X 1 , X 2 , ..., X n ).

Los polinomios simétricos surgen de manera natural en el estudio de la relación entre las raíces de un polinomio en una variable y sus coeficientes, ya que los coeficientes pueden darse mediante expresiones polinómicas en las raíces, y todas las raíces desempeñan un papel similar en este contexto. Desde este punto de vista, los polinomios simétricos elementales son los polinomios simétricos más fundamentales. Un teorema establece que cualquier polinomio simétrico puede expresarse en términos de polinomios simétricos elementales, lo que implica que cada expresión polinómica simétrica en las raíces de un polinomio mónico puede darse alternativamente como una expresión polinómica en los coeficientes del polinomio.

En dos variables X 1 y X 2 , se tienen polinomios simétricos como:

y en tres variables X 1 , X 2 y X 3 , se tiene como polinomio simétrico:

En matemáticas , un tensor simétrico es un tensor que es invariante bajo una permutación de sus argumentos vectoriales:

para cada permutación σ de los símbolos {1,2,..., r }. Alternativamente, un tensor simétrico de orden r representado en coordenadas como una cantidad con índices r satisface

El espacio de tensores simétricos de rango r en un espacio vectorial de dimensión finita es naturalmente isomorfo al dual del espacio de polinomios homogéneos de grado r en V . Sobre cuerpos de característica cero , el espacio vectorial graduado de todos los tensores simétricos puede identificarse naturalmente con el álgebra simétrica en V . Un concepto relacionado es el de tensor antisimétrico o forma alternada . Los tensores simétricos se encuentran ampliamente en ingeniería , física y matemáticas .

Dado un polinomio, puede ser que algunas de las raíces estén conectadas por varias ecuaciones algebraicas . Por ejemplo, puede ser que para dos de las raíces, digamos A y B , que A 2 + 5 B 3 = 7. La idea central de la teoría de Galois es considerar aquellas permutaciones (o reordenamientos) de las raíces que tienen la propiedad de que cualquier ecuación algebraica satisfecha por las raíces sigue satisfecha después de que las raíces hayan sido permutadas. Una condición importante es que nos limitamos a ecuaciones algebraicas cuyos coeficientes son números racionales . Por lo tanto, la teoría de Galois estudia las simetrías inherentes a las ecuaciones algebraicas.

En álgebra abstracta , un automorfismo es un isomorfismo de un objeto matemático a sí mismo. Es, en cierto sentido, una simetría del objeto y una forma de mapear el objeto a sí mismo mientras se preserva toda su estructura. El conjunto de todos los automorfismos de un objeto forma un grupo , llamado grupo de automorfismos . Es, en términos generales, el grupo de simetría del objeto.

En mecánica cuántica, los bosones tienen representantes que son simétricos bajo los operadores de permutación, y los fermiones tienen representantes antisimétricos.

Esto implica el principio de exclusión de Pauli para los fermiones. De hecho, el principio de exclusión de Pauli con una función de onda de múltiples partículas de un solo valor es equivalente a exigir que la función de onda sea antisimétrica. Un estado antisimétrico de dos partículas se representa como una suma de estados en los que una partícula está en estado y la otra en estado :

y la antisimetría bajo intercambio significa que A ( x , y ) = − A ( y , x ) . Esto implica que A ( x , x ) = 0 , que es exclusión de Pauli. Es cierto en cualquier base, ya que los cambios unitarios de base mantienen a las matrices antisimétricas antisimétricas, aunque estrictamente hablando, la cantidad A ( x , y ) no es una matriz sino un tensor antisimétrico de rango dos .

Por el contrario, si las cantidades diagonales A ( x , x ) son cero en cada base , entonces el componente de la función de onda:

es necesariamente antisimétrica. Para demostrarlo, considere el elemento de matriz:

Esto es cero, porque las dos partículas tienen probabilidad cero de estar ambas en el estado de superposición . Pero esto es igual a

El primer y el último término del lado derecho son elementos diagonales y son cero, y la suma total es igual a cero. Por lo tanto, los elementos de la matriz de función de onda obedecen a:

o

Llamamos a una relación simétrica si cada vez que la relación va de A a B, también va de B a A. Nótese que la simetría no es el opuesto exacto de la antisimetría .

Una isometría es una función que preserva la distancia entre espacios métricos . Dado un espacio métrico, o un conjunto y un esquema para asignar distancias entre elementos del conjunto, una isometría es una transformación que asigna elementos a otro espacio métrico de modo que la distancia entre los elementos en el nuevo espacio métrico sea igual a la distancia entre los elementos en el espacio métrico original. En un espacio bidimensional o tridimensional, dos figuras geométricas son congruentes si están relacionadas por una isometría: relacionadas por un movimiento rígido o por una composición de un movimiento rígido y una reflexión . Hasta una relación por un movimiento rígido, son iguales si están relacionadas por una isometría directa .

Las isometrías se han utilizado para unificar la definición de trabajo de simetría en geometría y para funciones, distribuciones de probabilidad, matrices, cadenas, gráficos, etc. [7]

Una simetría de una ecuación diferencial es una transformación que deja la ecuación diferencial invariable. El conocimiento de dichas simetrías puede ayudar a resolver la ecuación diferencial.

La simetría lineal de un sistema de ecuaciones diferenciales es una simetría continua del sistema de ecuaciones diferenciales. El conocimiento de la simetría lineal se puede utilizar para simplificar una ecuación diferencial ordinaria mediante la reducción de orden . [8]

Para las ecuaciones diferenciales ordinarias , el conocimiento de un conjunto apropiado de simetrías de Lie permite calcular explícitamente un conjunto de primeras integrales, produciendo una solución completa sin integración.

Las simetrías se pueden encontrar resolviendo un conjunto relacionado de ecuaciones diferenciales ordinarias. [8] Resolver estas ecuaciones suele ser mucho más simple que resolver las ecuaciones diferenciales originales.

En el caso de un número finito de resultados posibles, la simetría con respecto a las permutaciones (reetiquetados) implica una distribución uniforme discreta .

En el caso de un intervalo real de resultados posibles, la simetría con respecto a los subintervalos intercambiables de igual longitud corresponde a una distribución uniforme continua .

En otros casos, como "tomar un entero aleatorio" o "tomar un número real aleatorio", no hay distribuciones de probabilidad simétricas en absoluto con respecto a los reetiquetados o al intercambio de subintervalos de igual longitud. Otras simetrías razonables no distinguen una distribución en particular o, en otras palabras, no hay una distribución de probabilidad única que proporcione la máxima simetría.

Hay un tipo de isometría en una dimensión que puede dejar la distribución de probabilidad sin cambios, es decir la reflexión en un punto, por ejemplo el cero.

Una posible simetría para la aleatoriedad con resultados positivos es que la primera se aplica al logaritmo, es decir, el resultado y su recíproco tienen la misma distribución. Sin embargo, esta simetría no distingue de forma única ninguna distribución en particular.

Para un "punto aleatorio" en un plano o en el espacio, se puede elegir un origen y considerar una distribución de probabilidad con simetría circular o esférica, respectivamente.