La falacia de la tasa base , también llamada negligencia de la tasa base [2] o sesgo de la tasa base , es un tipo de falacia en la que las personas tienden a ignorar la tasa base (p. ej., la prevalencia general ) a favor de la información individualizadora (es decir, la información que pertenece solo a un caso específico). [3] Por ejemplo, si alguien escucha que un amigo es muy tímido y callado, podría pensar que es más probable que el amigo sea bibliotecario que vendedor. Sin embargo, hay muchos más vendedores que bibliotecarios en general, por lo que es más probable que su amigo sea en realidad un vendedor, incluso si una mayor proporción de bibliotecarios se ajustan a la descripción de ser tímidos y callados. La negligencia de la tasa base es una forma específica de la negligencia de extensión más general .

También se denomina falacia del fiscal o falacia del abogado defensor cuando se aplica a los resultados de pruebas estadísticas (como las pruebas de ADN) en el contexto de procedimientos judiciales. Estos términos fueron introducidos por William C. Thompson y Edward Schumann en 1987, [4] [5] aunque se ha argumentado que su definición de falacia del fiscal se extiende a muchas imputaciones adicionales inválidas de culpabilidad o responsabilidad que no son analizables como errores en las tasas base o el teorema de Bayes . [6]

Un ejemplo de la falacia de la tasa base es la paradoja de los falsos positivos (también conocida como paradoja de la precisión ). Esta paradoja describe situaciones en las que hay más resultados de pruebas falsos positivos que verdaderos positivos (esto significa que el clasificador tiene una precisión baja ). Por ejemplo, si una cámara de reconocimiento facial puede identificar a los criminales buscados con un 99 % de precisión, pero analiza a 10 000 personas al día, la alta precisión se ve compensada por la cantidad de pruebas; debido a esto, la lista de criminales del programa probablemente tendrá muchos más civiles (falsos positivos) que criminales (verdaderos positivos) porque hay muchos más civiles que criminales en general. La probabilidad de un resultado positivo en la prueba está determinada no solo por la precisión de la prueba, sino también por las características de la población muestreada. [7] La cuestión fundamental es que la prevalencia mucho más alta de verdaderos negativos significa que el grupo de personas que dan positivo estará dominado por falsos positivos, dado que incluso una pequeña fracción del grupo [negativo] mucho más grande producirá una mayor cantidad de positivos indicados que la fracción más grande del grupo [positivo] mucho más pequeño.

Cuando la prevalencia, la proporción de aquellos que tienen una condición dada, es menor que la tasa de falsos positivos de la prueba , incluso las pruebas que tienen un riesgo muy bajo de dar un falso positivo en un caso individual darán más falsos positivos que verdaderos positivos en general . [8]

Es especialmente contra-intuitivo cuando se interpreta un resultado positivo en una prueba en una población de baja prevalencia después de haber tratado con resultados positivos extraídos de una población de alta prevalencia. [8] Si la tasa de falsos positivos de la prueba es mayor que la proporción de la nueva población con la condición, entonces un administrador de pruebas cuya experiencia se ha obtenido de pruebas en una población de alta prevalencia puede concluir a partir de la experiencia que un resultado positivo de la prueba generalmente indica un sujeto positivo, cuando en realidad es mucho más probable que haya ocurrido un falso positivo.

Imaginemos que se realiza una prueba de detección de enfermedades infecciosas en una población A de 1000 personas, de las cuales el 40 % están infectadas. La prueba tiene una tasa de falsos positivos del 5 % (0,05) y una tasa de falsos negativos de cero. El resultado esperado de las 1000 pruebas en la población A sería:

Entonces, en la población A , una persona que recibe un resultado positivo en la prueba podría tener más del 93 % de confianza (400/30 + 400) que indica correctamente la infección.

Consideremos ahora la misma prueba aplicada a la población B , de la cual sólo el 2% está infectado. El resultado esperado de 1000 pruebas en la población B sería:

En la población B , solo 20 de las 69 personas totales con un resultado positivo en la prueba están realmente infectadas. Por lo tanto, la probabilidad de estar realmente infectado después de que a alguien le digan que está infectado es solo del 29 % ( 20/20 + 49) para una prueba que de otro modo parece tener una "precisión del 95%".

A un examinador con experiencia en el grupo A le puede parecer una paradoja que en el grupo B , un resultado que normalmente indicaba correctamente una infección ahora suele ser un falso positivo. La confusión de la probabilidad posterior de infección con la probabilidad previa de recibir un falso positivo es un error natural después de recibir un resultado de prueba que amenaza la salud.

Imaginemos que un grupo de policías tiene alcoholímetros que muestran una falsa ebriedad en el 5% de los casos en los que el conductor está sobrio. Sin embargo, los alcoholímetros nunca fallan en detectar a una persona realmente borracha. Uno de cada mil conductores conduce borracho. Supongamos que los agentes de policía detienen a un conductor al azar para realizarle una prueba de alcoholemia. Esto indica que el conductor está borracho. No se conoce ninguna otra información sobre él.

Muchos estimarían que la probabilidad de que el conductor esté ebrio es del 95%, pero la probabilidad correcta es de alrededor del 2%.

Una explicación para esto es la siguiente: en promedio, por cada 1.000 conductores examinados,

Por lo tanto, la probabilidad de que cualquier conductor entre los 1 + 49,95 = 50,95 resultados positivos de la prueba realmente esté ebrio es .

Sin embargo, la validez de este resultado depende de la validez de la suposición inicial de que el policía detuvo al conductor verdaderamente al azar y no por mala conducción. Si esa u otra razón no arbitraria para detener al conductor estuviera presente, entonces el cálculo también incluye la probabilidad de que un conductor ebrio conduzca competentemente y un conductor no ebrio conduzca (in)competentemente.

De manera más formal, se puede establecer la misma probabilidad de aproximadamente 0,02 utilizando el teorema de Bayes . El objetivo es encontrar la probabilidad de que el conductor esté borracho dado que el alcoholímetro indicó que está borracho, lo que se puede representar como

donde D significa que el alcoholímetro indica que el conductor está borracho. Utilizando el teorema de Bayes,

En este escenario se conoce la siguiente información:

Como se puede ver en la fórmula, se necesita p ( D ) para el teorema de Bayes, que se puede calcular a partir de los valores anteriores utilizando la ley de probabilidad total :

Lo cual da

Introduciendo estos números en el teorema de Bayes, se obtiene que

cual es la precisión de la prueba.

En una ciudad de 1 millón de habitantes, supongamos que hay 100 terroristas y 999.900 no terroristas. Para simplificar el ejemplo, se supone que todas las personas presentes en la ciudad son habitantes. Por lo tanto, la probabilidad base de que un habitante de la ciudad seleccionado al azar sea un terrorista es 0,0001, y la probabilidad base de que ese mismo habitante sea un no terrorista es 0,9999. En un intento de atrapar a los terroristas, la ciudad instala un sistema de alarma con una cámara de vigilancia y un software de reconocimiento facial automático .

El software tiene dos tasas de fallo del 1%:

Supongamos ahora que un habitante activa la alarma. Alguien que cometiera la falacia de la tasa base inferiría que existe una probabilidad del 99% de que la persona detectada sea un terrorista. Aunque la inferencia parece tener sentido, en realidad es un razonamiento erróneo y un cálculo a continuación mostrará que la probabilidad de que se trate de un terrorista en realidad es cercana al 1%, no al 99%.

La falacia surge de confundir las naturalezas de dos tasas de fallo diferentes. El «número de no campanas por cada 100 terroristas» (P(¬B | T), o la probabilidad de que la campana no suene dado que el habitante es un terrorista) y el «número de no terroristas por cada 100 campanas» (P(¬T | B), o la probabilidad de que el habitante sea un no terrorista dado que la campana suena) son cantidades no relacionadas; una no necesariamente es igual a la otra (ni siquiera cercana a ella). Para demostrarlo, considere lo que sucede si se instala un sistema de alarma idéntico en una segunda ciudad sin terroristas en absoluto. Al igual que en la primera ciudad, la alarma suena para 1 de cada 100 habitantes no terroristas detectados, pero a diferencia de la primera ciudad, la alarma nunca suena para un terrorista. Por lo tanto, el 100% de todas las ocasiones en que suena la alarma son para no terroristas, pero ni siquiera se puede calcular una tasa de falsos negativos. El 'número de no terroristas por cada 100 campanadas' en esa ciudad es 100, pero P(T | B) = 0%. No hay ninguna probabilidad de que se haya detectado un terrorista dado el sonido de la campana.

Imaginemos que toda la población de la primera ciudad, un millón de habitantes, pasa por delante de la cámara. Aproximadamente 99 de los 100 terroristas harán sonar la alarma, y lo mismo harán unos 9.999 de los 999.900 no terroristas. Por lo tanto, aproximadamente 10.098 personas harán sonar la alarma, de las cuales aproximadamente 99 serán terroristas. La probabilidad de que una persona que haga sonar la alarma sea en realidad un terrorista es de tan solo 99 entre 10.098, lo que es menos del 1% y muy, muy por debajo de la estimación inicial del 99%.

La falacia de la tasa base es tan engañosa en este ejemplo porque hay muchos más no terroristas que terroristas, y el número de falsos positivos (no terroristas escaneados como terroristas) es mucho mayor que el de verdaderos positivos (terroristas escaneados como terroristas).

Varios profesionales han argumentado que, como la tasa base de terrorismo es extremadamente baja, el uso de minería de datos y algoritmos predictivos para identificar terroristas no puede funcionar de manera factible debido a la paradoja de los falsos positivos. [9] [10] [11] [12] Las estimaciones del número de falsos positivos para cada resultado preciso varían de más de diez mil [12] a mil millones; [10] en consecuencia, investigar cada pista sería prohibitivo en términos de costo y tiempo. [9] [11] El nivel de precisión requerido para que estos modelos sean viables es probablemente inalcanzable. En primer lugar, la baja tasa base de terrorismo también significa que hay una falta de datos con los que hacer un algoritmo preciso. [11] Además, en el contexto de la detección del terrorismo, los falsos negativos son altamente indeseables y, por lo tanto, deben minimizarse tanto como sea posible; sin embargo, esto requiere aumentar la sensibilidad a costa de la especificidad , lo que aumenta los falsos positivos. [12] También es cuestionable si el uso de dichos modelos por parte de las autoridades encargadas de hacer cumplir la ley cumpliría con la carga de la prueba requerida , dado que más del 99% de los resultados serían falsos positivos. [12]

Se comete un delito. El análisis forense determina que el autor tiene un determinado tipo de sangre que comparte el 10% de la población. Se detiene a un sospechoso y se descubre que tiene ese mismo tipo de sangre.

Un fiscal podría acusar al sospechoso del delito sólo sobre esa base y afirmar en el juicio que la probabilidad de que el acusado sea culpable es del 90%.

Sin embargo, esta conclusión sólo es aproximada si el acusado fue seleccionado como principal sospechoso sobre la base de pruebas sólidas descubiertas antes del análisis de sangre y no relacionadas con él. De lo contrario, el razonamiento presentado es defectuoso, ya que pasa por alto la alta probabilidad previa (es decir, anterior al análisis de sangre) de que sea una persona inocente elegida al azar. Supongamos, por ejemplo, que en la ciudad donde ocurrió el crimen viven 1000 personas. Esto significa que allí viven 100 personas que tienen el tipo de sangre del perpetrador, de las cuales sólo una es el verdadero perpetrador; por lo tanto, la probabilidad real de que el acusado sea culpable –basada únicamente en el hecho de que su tipo de sangre coincide con el del asesino– es sólo del 1%, mucho menos que el 90% argumentado por el fiscal.

La falacia del fiscal consiste en suponer que la probabilidad previa de una coincidencia aleatoria es igual a la probabilidad de que el acusado sea inocente. Al utilizarla, un fiscal que interrogue a un testigo experto puede preguntar: "Las probabilidades de encontrar esta prueba en un hombre inocente son tan pequeñas que el jurado puede descartar con seguridad la posibilidad de que este acusado sea inocente, ¿correcto?" [13] La afirmación supone que la probabilidad de que se encuentren pruebas en un hombre inocente es la misma que la probabilidad de que un hombre sea inocente dado que se encontraron pruebas en él, lo que no es cierto. Mientras que la primera suele ser pequeña (10% en el ejemplo anterior) debido a buenos procedimientos de prueba forense , la segunda (99% en ese ejemplo) no se relaciona directamente con ella y a menudo será mucho más alta, ya que, de hecho, depende de las probabilidades previas bastante altas de que el acusado sea una persona inocente al azar.

O.J. Simpson fue juzgado y absuelto en 1995 por los asesinatos de su ex esposa Nicole Brown Simpson y su amigo Ronald Goldman.

La sangre de la escena del crimen coincidía con la de Simpson y tenía características compartidas por 1 de cada 400 personas. Sin embargo, la defensa argumentó que la cantidad de personas de Los Ángeles que coincidían con la muestra podría llenar un estadio de fútbol y que la cifra de 1 de cada 400 era inútil. [14] [15] Habría sido incorrecto, y un ejemplo de falacia del fiscal, basarse únicamente en la cifra de "1 de cada 400" para deducir que una persona dada que coincidiera con la muestra probablemente sería el culpable.

En el mismo juicio, la fiscalía presentó pruebas de que Simpson había sido violento con su esposa. La defensa argumentó que solo había una mujer asesinada por cada 2500 mujeres que fueron sometidas a abuso conyugal, y que cualquier antecedente de violencia de Simpson hacia su esposa era irrelevante para el juicio. Sin embargo, el razonamiento detrás del cálculo de la defensa era falaz. Según el autor Gerd Gigerenzer , la probabilidad correcta requiere un contexto adicional: la esposa de Simpson no solo había sido sometida a violencia doméstica, sino que también había sido sometida a violencia doméstica (por Simpson) y asesinada (por alguien). Gigerenzer escribe que "las probabilidades de que un agresor realmente haya asesinado a su pareja, dado que ella ha sido asesinada, son de aproximadamente 8 en 9 o aproximadamente el 90%". [16] Si bien la mayoría de los casos de abuso conyugal no terminan en asesinato, la mayoría de los casos de asesinato en los que hay antecedentes de abuso conyugal fueron cometidos por el cónyuge.

En 1998, Sally Clark , una mujer británica, fue acusada de haber matado a su primer hijo a las 11 semanas de edad y luego a su segundo hijo a las 8 semanas de edad. La fiscalía hizo que el testigo experto Sir Roy Meadow , profesor y pediatra consultor, [17] testificara que la probabilidad de que dos niños de la misma familia mueran por SMSL es de aproximadamente 1 en 73 millones. Esa tasa era mucho menos frecuente que la tasa real medida en datos históricos : Meadow la estimó a partir de datos de muertes por SMSL individuales y la suposición de que la probabilidad de tales muertes no debería estar correlacionada entre bebés. [18]

Meadow reconoció que no es imposible que ocurra una muerte por SMSL en 73 millones, pero sostuvo que este tipo de accidentes ocurrirían "una vez cada cien años" y que, en un país de 15 millones de familias con dos hijos, es mucho más probable que las muertes dobles se deban al síndrome de Münchausen por poder que a un accidente tan poco frecuente. Sin embargo, hay buenas razones para suponer que la probabilidad de una muerte por SMSL en una familia es significativamente mayor si ya ha muerto un hijo anterior en estas circunstancias (es probable que una predisposición genética al SMSL invalide esa supuesta independencia estadística [19] ), lo que hace que algunas familias sean más susceptibles al SMSL y que el error sea el resultado de la falacia ecológica [20] . La probabilidad de dos muertes por SMSL en la misma familia no se puede estimar de manera sólida elevando al cuadrado la probabilidad de una sola muerte de este tipo en todas las familias que, por lo demás, son similares [21] .

La cifra de 1 entre 73 millones subestimó en gran medida la probabilidad de que se produjeran dos accidentes sucesivos, pero incluso si esa evaluación fuera correcta, el tribunal parece haber pasado por alto el hecho de que la cifra de 1 entre 73 millones no significaba nada por sí sola. Como probabilidad a priori , debería haberse sopesado frente a las probabilidades a priori de las alternativas. Dado que se habían producido dos muertes, una de las siguientes explicaciones debe ser cierta, y todas ellas son a priori extremadamente improbables:

No está claro si alguna vez se propuso una estimación de la probabilidad de la segunda posibilidad durante el juicio o si la comparación de las dos primeras probabilidades se entendió como la estimación clave a realizar en el análisis estadístico para evaluar el caso de la fiscalía frente al caso de inocencia.

Clark fue condenado en 1999, lo que dio lugar a un comunicado de prensa de la Royal Statistical Society que señaló los errores. [22]

En 2002, Ray Hill (profesor de matemáticas en Salford ) intentó comparar con precisión las probabilidades de estas dos posibles explicaciones; concluyó que los accidentes sucesivos son entre 4,5 y 9 veces más probables que los asesinatos sucesivos, de modo que las probabilidades a priori de la culpabilidad de Clark eran entre 4,5 a 1 y 9 a 1 en contra. [23]

Después de que el tribunal determinó que el patólogo forense que había examinado a ambos bebés había ocultado pruebas exculpatorias , un tribunal superior anuló posteriormente la condena de Clark, el 29 de enero de 2003. [24]

En experimentos se ha descubierto que las personas prefieren la información individualizada a la información general cuando la primera está disponible. [25] [26] [27]

En algunos experimentos, se pidió a los estudiantes que estimaran los promedios de calificaciones (GPA) de estudiantes hipotéticos. Cuando se les dieron estadísticas relevantes sobre la distribución de GPA, los estudiantes tendieron a ignorarlas si se les daba información descriptiva sobre el estudiante en particular, incluso si la nueva información descriptiva era obviamente de poca o ninguna relevancia para el desempeño escolar. [26] Este hallazgo se ha utilizado para argumentar que las entrevistas son una parte innecesaria del proceso de admisión a la universidad porque los entrevistadores no pueden elegir a los candidatos exitosos mejor que las estadísticas básicas.

Los psicólogos Daniel Kahneman y Amos Tversky intentaron explicar este hallazgo en términos de una regla simple o "heurística" llamada representatividad . Argumentaron que muchos juicios relacionados con la probabilidad, o con la causa y el efecto, se basan en cuán representativa es una cosa de otra, o de una categoría. [26] Kahneman considera que la negligencia de la tasa base es una forma específica de negligencia de extensión . [28] Richard Nisbett ha argumentado que algunos sesgos atribucionales como el error de atribución fundamental son ejemplos de la falacia de la tasa base: las personas no utilizan la "información de consenso" (la "tasa base") sobre cómo se comportaron otros en situaciones similares y en su lugar prefieren atribuciones disposicionales más simples . [29]

Existe un debate considerable en psicología sobre las condiciones en las que las personas aprecian o no la información de tasa base. [30] [31] Los investigadores del programa de heurística y sesgos han enfatizado los hallazgos empíricos que muestran que las personas tienden a ignorar las tasas base y hacer inferencias que violan ciertas normas de razonamiento probabilístico, como el teorema de Bayes . La conclusión extraída de esta línea de investigación fue que el pensamiento probabilístico humano es fundamentalmente defectuoso y propenso a errores. [32] Otros investigadores han enfatizado el vínculo entre los procesos cognitivos y los formatos de información, argumentando que tales conclusiones no están generalmente justificadas. [33] [34]

Consideremos nuevamente el Ejemplo 2 anterior. La inferencia requerida es estimar la probabilidad (posterior) de que un conductor (elegido al azar) esté borracho, dado que la prueba de alcoholemia es positiva. Formalmente, esta probabilidad se puede calcular utilizando el teorema de Bayes, como se muestra arriba. Sin embargo, hay diferentes maneras de presentar la información relevante. Consideremos la siguiente variante formalmente equivalente del problema:

En este caso, la información numérica relevante —p (borracho), p ( D | borracho), p ( D | sobrio)— se presenta en términos de frecuencias naturales con respecto a una cierta clase de referencia (véase el problema de la clase de referencia ). Los estudios empíricos muestran que las inferencias de las personas se corresponden más estrechamente con la regla de Bayes cuando la información se presenta de esta manera, lo que ayuda a superar la negligencia de la tasa base en los legos [34] y los expertos. [35] Como consecuencia, organizaciones como la Colaboración Cochrane recomiendan utilizar este tipo de formato para comunicar las estadísticas de salud. [36] Enseñar a las personas a traducir este tipo de problemas de razonamiento bayesiano en formatos de frecuencia natural es más eficaz que simplemente enseñarles a introducir probabilidades (o porcentajes) en el teorema de Bayes. [37] También se ha demostrado que las representaciones gráficas de frecuencias naturales (por ejemplo, matrices de iconos, gráficos de resultados hipotéticos) ayudan a las personas a hacer mejores inferencias. [37] [38] [39] [40]

Una razón importante por la que los formatos de frecuencia natural son útiles es que este formato de información facilita la inferencia requerida porque simplifica los cálculos necesarios. Esto se puede ver al utilizar una forma alternativa de calcular la probabilidad requerida p (borracho| D ):

donde N (borracho ∩ D ) denota el número de conductores que están borrachos y obtienen un resultado positivo en el alcoholímetro, y N ( D ) denota el número total de casos con un resultado positivo en el alcoholímetro. La equivalencia de esta ecuación con la anterior se desprende de los axiomas de la teoría de la probabilidad, según los cuales N (borracho ∩ D ) = N × p ( D | borracho) × p (borracho). Es importante destacar que, aunque esta ecuación es formalmente equivalente a la regla de Bayes, no es psicológicamente equivalente. El uso de frecuencias naturales simplifica la inferencia porque la operación matemática requerida se puede realizar en números naturales, en lugar de fracciones normalizadas (es decir, probabilidades), porque hace que el alto número de falsos positivos sea más transparente y porque las frecuencias naturales exhiben una "estructura de conjunto anidado". [41] [42]

No todos los formatos de frecuencia facilitan el razonamiento bayesiano. [42] [43] Las frecuencias naturales se refieren a la información de frecuencia que resulta del muestreo natural , [44] que preserva la información de la tasa base (por ejemplo, el número de conductores ebrios al tomar una muestra aleatoria de conductores). Esto es diferente del muestreo sistemático , en el que las tasas base se fijan a priori (por ejemplo, en experimentos científicos). En el último caso, no es posible inferir la probabilidad posterior p (ebrio | prueba positiva) a partir de la comparación del número de conductores que están ebrios y dan positivo en la prueba en comparación con el número total de personas que obtienen un resultado positivo en el alcoholímetro, porque la información de la tasa base no se preserva y debe reintroducirse explícitamente utilizando el teorema de Bayes.

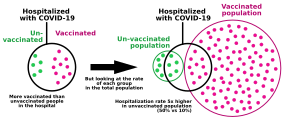

Si la exposición al COVID-19 se mantiene igual, a medida que más personas se vacunen, habrá más casos, hospitalizaciones y muertes en personas vacunadas, ya que seguirán constituyendo una parte cada vez mayor de la población. Por ejemplo, si el 100% de la población estuviera vacunada, el 100% de los casos se darían entre personas vacunadas.

MENSAJE: Las pruebas de falsos positivos son más probables que las de verdaderos positivos cuando la población general tiene una baja prevalencia de la enfermedad. Esto se denomina paradoja de los falsos positivos.

esteroides

los estudiantes en general

, más probable es que un estudiante identificado como consumidor sea un no consumidor. Esto se ha llamado la paradoja del falso positivo.- Citando: Gonick, L.; Smith, W. (1993). The cartoon guide to statistics . Nueva York: Harper Collins. pág. 49.

Es evidentemente injusto utilizar las características que básicamente la convierten en una buena madre que lleva una vida limpia como factores que cuentan en su contra. Sí, podemos estar de acuerdo en que dichos factores hacen que una muerte natural sea menos probable, pero esas mismas características también hacen que el asesinato sea menos probable.

La sociedad no tolera que los médicos cometan errores clínicos graves porque se entiende ampliamente que tales errores pueden significar la diferencia entre la vida y la muerte. El caso de R v. Sally Clark es un ejemplo de un testigo experto médico que cometió un error estadístico grave, que puede haber tenido un profundo efecto en el resultado del caso.