En estadística , un tamaño del efecto es un valor que mide la fuerza de la relación entre dos variables en una población, o una estimación basada en una muestra de esa cantidad. Puede referirse al valor de una estadística calculada a partir de una muestra de datos , al valor de un parámetro para una población hipotética o a la ecuación que operacionaliza cómo las estadísticas o los parámetros conducen al valor del tamaño del efecto. [1] Los ejemplos de tamaños del efecto incluyen la correlación entre dos variables, [2] el coeficiente de regresión en una regresión, la diferencia de medias o el riesgo de que ocurra un evento particular (como un ataque cardíaco). Los tamaños del efecto son una herramienta complementaria para la prueba de hipótesis estadísticas y juegan un papel importante en los análisis de potencia para evaluar el tamaño de muestra requerido para nuevos experimentos. [3] El tamaño del efecto es fundamental en los metanálisis que tienen como objetivo proporcionar el tamaño del efecto combinado basado en datos de múltiples estudios. El conjunto de métodos de análisis de datos relacionados con los tamaños del efecto se conoce como estadísticas de estimación .

El tamaño del efecto es un componente esencial a la hora de evaluar la solidez de una afirmación estadística, y es el primer elemento (magnitud) de los criterios MAGIC . La desviación estándar del tamaño del efecto es de importancia crítica, ya que indica cuánta incertidumbre se incluye en la medición. Una desviación estándar demasiado grande hará que la medición casi no tenga sentido. En el metanálisis, donde el propósito es combinar múltiples tamaños del efecto, la incertidumbre en el tamaño del efecto se utiliza para ponderar los tamaños del efecto, de modo que los estudios grandes se consideren más importantes que los estudios pequeños. La incertidumbre en el tamaño del efecto se calcula de forma diferente para cada tipo de tamaño del efecto, pero generalmente solo requiere conocer el tamaño de la muestra del estudio ( N ), o el número de observaciones ( n ) en cada grupo.

La presentación de informes sobre el tamaño del efecto o sus estimaciones (estimación del efecto [EE], estimación del efecto) se considera una buena práctica a la hora de presentar los resultados de investigaciones empíricas en muchos campos. [4] [5] La presentación de informes sobre el tamaño del efecto facilita la interpretación de la importancia de un resultado de investigación, en contraste con su significación estadística . [6] Los tamaños del efecto son particularmente destacados en las ciencias sociales y en la investigación médica (donde el tamaño del efecto del tratamiento es importante).

Los tamaños de los efectos pueden medirse en términos relativos o absolutos. En los tamaños de los efectos relativos, se comparan directamente dos grupos entre sí, como en los odds ratios y los riesgos relativos . En el caso de los tamaños de los efectos absolutos, un valor absoluto mayor siempre indica un efecto más fuerte. Muchos tipos de mediciones pueden expresarse como absolutas o relativas, y pueden utilizarse juntas porque transmiten información diferente. Un destacado grupo de trabajo de la comunidad de investigación en psicología hizo la siguiente recomendación:

Siempre presente los tamaños del efecto para los resultados primarios... Si las unidades de medida son significativas a un nivel práctico (por ejemplo, número de cigarrillos fumados por día), entonces generalmente preferimos una medida no estandarizada (coeficiente de regresión o diferencia de medias) a una medida estandarizada ( r o d ). [4]

Al igual que en la estimación estadística , el tamaño del efecto real se distingue del tamaño del efecto observado. Por ejemplo, para medir el riesgo de enfermedad en una población (el tamaño del efecto de la población) se puede medir el riesgo dentro de una muestra de esa población (el tamaño del efecto de la muestra). Las convenciones para describir los tamaños del efecto verdadero y observado siguen las prácticas estadísticas estándar: un enfoque común es usar letras griegas como ρ [rho] para denotar parámetros de la población y letras latinas como r para denotar la estadística correspondiente. Alternativamente, se puede colocar un "sombrero" sobre el parámetro de la población para denotar la estadística, por ejemplo, siendo la estimación del parámetro .

Como en cualquier contexto estadístico, los tamaños del efecto se estiman con un error de muestreo y pueden estar sesgados a menos que el estimador del tamaño del efecto que se utilice sea apropiado para la forma en que se muestrearon los datos y la forma en que se realizaron las mediciones. Un ejemplo de esto es el sesgo de publicación , que ocurre cuando los científicos informan los resultados solo cuando los tamaños del efecto estimados son grandes o son estadísticamente significativos. Como resultado, si muchos investigadores realizan estudios con bajo poder estadístico, los tamaños del efecto informados tenderán a ser mayores que los efectos reales (poblacionales), si los hay. [7] Otro ejemplo en el que los tamaños del efecto pueden estar distorsionados es en un experimento de múltiples ensayos, donde el cálculo del tamaño del efecto se basa en la respuesta promedio o agregada a lo largo de los ensayos. [8]

Los estudios más pequeños a veces muestran tamaños de efecto diferentes, a menudo mayores, que los estudios más grandes. Este fenómeno se conoce como el efecto del estudio pequeño, que puede indicar un sesgo de publicación. [9]

Los tamaños de efecto basados en muestras se distinguen de las estadísticas de prueba utilizadas en las pruebas de hipótesis, en que estiman la fuerza (magnitud) de, por ejemplo, una relación aparente, en lugar de asignar un nivel de significación que refleje si la magnitud de la relación observada podría deberse al azar. El tamaño del efecto no determina directamente el nivel de significación, o viceversa. Dado un tamaño de muestra suficientemente grande, una comparación estadística no nula siempre mostrará un resultado estadísticamente significativo a menos que el tamaño del efecto de la población sea exactamente cero (e incluso en ese caso mostrará significación estadística a la tasa del error de tipo I utilizado). Por ejemplo, un coeficiente de correlación de Pearson de muestra de 0,01 es estadísticamente significativo si el tamaño de la muestra es 1000. Informar solo el valor p significativo de este análisis podría ser engañoso si una correlación de 0,01 es demasiado pequeña para ser de interés en una aplicación particular.

El término tamaño del efecto puede referirse a una medida estandarizada del efecto (como r , d de Cohen o el odds ratio ) o a una medida no estandarizada (por ejemplo, la diferencia entre las medias de los grupos o los coeficientes de regresión no estandarizados). Las medidas estandarizadas del tamaño del efecto se utilizan normalmente cuando:

En los metanálisis, los tamaños del efecto estandarizados se utilizan como una medida común que puede calcularse para diferentes estudios y luego combinarse en un resumen general.

El hecho de que un tamaño de efecto se deba interpretar como pequeño, mediano o grande depende de su contexto sustantivo y de su definición operativa. Los criterios convencionales de Cohen , pequeño , mediano o grande [10], son casi omnipresentes en muchos campos, aunque Cohen [10] advirtió:

"Los términos 'pequeño', 'mediano' y 'grande' son relativos, no sólo entre sí, sino también con respecto al área de la ciencia del comportamiento o, más particularmente, al contenido específico y al método de investigación que se emplee en una investigación determinada... Frente a esta relatividad, existe un cierto riesgo inherente al hecho de ofrecer definiciones operacionales convencionales para estos términos para su uso en el análisis de potencia en un campo de investigación tan diverso como la ciencia del comportamiento. No obstante, este riesgo se acepta en la creencia de que se gana más de lo que se pierde al proporcionar un marco de referencia convencional común que se recomienda utilizar sólo cuando no se dispone de una base mejor para estimar el índice ES". (p. 25)

En el diseño de dos muestras, Sawilowsky [11] concluyó: "Basándose en los hallazgos de investigación actuales en la literatura aplicada, parece apropiado revisar las reglas generales para los tamaños de efecto", teniendo en cuenta las advertencias de Cohen, y amplió las descripciones para incluir muy pequeño , muy grande y enorme . Los mismos estándares de facto podrían desarrollarse para otros diseños.

Lenth [12] señaló que, en el caso de un tamaño del efecto "medio", "se elegirá el mismo n independientemente de la precisión o fiabilidad del instrumento, o de la estrechez o diversidad de los sujetos. Es evidente que aquí se están ignorando consideraciones importantes. Los investigadores deberían interpretar la importancia sustancial de sus resultados basándolos en un contexto significativo o cuantificando su contribución al conocimiento, y las descripciones del tamaño del efecto de Cohen pueden ser útiles como punto de partida". [6] De manera similar, un informe patrocinado por el Departamento de Educación de los EE. UU. decía que "el uso indiscriminado y generalizado de los valores genéricos de tamaño del efecto pequeño, mediano y grande de Cohen para caracterizar los tamaños del efecto en dominios a los que no se aplican sus valores normativos es, por lo tanto, igualmente inapropiado y engañoso". [13]

Sugirieron que "las normas apropiadas son aquellas basadas en distribuciones de tamaños de efecto para medidas de resultados comparables de intervenciones comparables dirigidas a muestras comparables". Por lo tanto, si un estudio en un campo donde la mayoría de las intervenciones son diminutas produjo un efecto pequeño (según los criterios de Cohen), estos nuevos criterios lo llamarían "grande". En un punto relacionado, véase la paradoja de Abelson y la paradoja de Sawilowsky. [14] [15] [16]

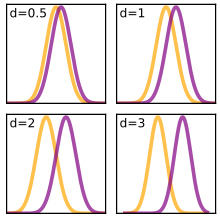

Se conocen entre 50 y 100 medidas distintas del tamaño del efecto. Muchos tamaños del efecto de distintos tipos se pueden convertir a otros tipos, ya que muchos estiman la separación de dos distribuciones, por lo que están relacionados matemáticamente. Por ejemplo, un coeficiente de correlación se puede convertir en una d de Cohen y viceversa.

Estos tamaños del efecto estiman la cantidad de varianza dentro de un experimento que es "explicada" o "contabilizada" por el modelo del experimento ( Variación explicada ).

La correlación de Pearson , a menudo denominada r e introducida por Karl Pearson , se utiliza ampliamente como un tamaño del efecto cuando se dispone de datos cuantitativos pareados; por ejemplo, si se estuviese estudiando la relación entre el peso al nacer y la longevidad. El coeficiente de correlación también se puede utilizar cuando los datos son binarios. La r de Pearson puede variar en magnitud de −1 a 1, donde −1 indica una relación lineal negativa perfecta, 1 indica una relación lineal positiva perfecta y 0 indica que no hay relación lineal entre dos variables. Cohen ofrece las siguientes directrices para las ciencias sociales: [10] [17]

Un tamaño del efecto relacionado es r 2 , el coeficiente de determinación (también conocido como R 2 o " r -cuadrado"), calculado como el cuadrado de la correlación de Pearson r . En el caso de datos pareados, esta es una medida de la proporción de varianza compartida por las dos variables, y varía de 0 a 1. Por ejemplo, con un r de 0,21, el coeficiente de determinación es 0,0441, lo que significa que el 4,4% de la varianza de cualquiera de las variables se comparte con la otra variable. El r 2 siempre es positivo, por lo que no transmite la dirección de la correlación entre las dos variables.

El eta-cuadrado describe la razón de la varianza explicada en la variable dependiente por un predictor mientras se controlan otros predictores, lo que lo hace análogo al r 2 . El eta-cuadrado es un estimador sesgado de la varianza explicada por el modelo en la población (estima solo el tamaño del efecto en la muestra). Esta estimación comparte la debilidad con r 2 de que cada variable adicional aumentará automáticamente el valor de η 2 . Además, mide la varianza explicada de la muestra, no de la población, lo que significa que siempre sobrestimará el tamaño del efecto, aunque el sesgo se hace más pequeño a medida que la muestra se hace más grande.

Un estimador menos sesgado de la varianza explicada en la población es ω 2 [18]

Esta forma de la fórmula está limitada al análisis entre sujetos con tamaños de muestra iguales en todas las celdas. [18] Dado que es menos sesgada (aunque no libre de sesgos), ω 2 es preferible a η 2 ; sin embargo, puede ser más incómoda de calcular para análisis complejos. Se ha publicado una forma generalizada del estimador para análisis entre sujetos y dentro de sujetos, medidas repetidas, diseño mixto y experimentos de diseño de bloques aleatorios. [19] Además, se han publicado métodos para calcular ω 2 parcial para factores individuales y factores combinados en diseños con hasta tres variables independientes. [19]

La f 2 de Cohen es una de las diversas medidas del tamaño del efecto que se pueden utilizar en el contexto de una prueba F para ANOVA o regresión múltiple . Su grado de sesgo (sobreestimación del tamaño del efecto para el ANOVA) depende del sesgo de su medición subyacente de varianza explicada (por ejemplo, R 2 , η 2 , ω 2 ).

La medida del tamaño del efecto f 2 para la regresión múltiple se define como: donde R 2 es la correlación múltiple al cuadrado .

De igual modo, f 2 puede definirse como: o para modelos descritos por aquellas medidas de tamaño del efecto. [20]

La medida del tamaño del efecto para la regresión múltiple secuencial y también común para el modelado PLS [21] se define como: donde R 2 A es la varianza explicada por un conjunto de una o más variables independientes A , y R 2 AB es la varianza combinada explicada por A y otro conjunto de una o más variables independientes de interés B . Por convención, los tamaños del efecto f 2 de , , y se denominan pequeños , medianos y grandes , respectivamente. [10]

El método de Cohen también se puede encontrar para el análisis factorial de varianza (ANOVA) trabajando al revés, utilizando:

En un diseño equilibrado (tamaños de muestra equivalentes entre los grupos) de ANOVA, el parámetro poblacional correspondiente de es donde μ j denota la media poblacional dentro del grupo j del total de K grupos, y σ las desviaciones estándar poblacionales equivalentes dentro de cada grupo. SS es la suma de cuadrados en ANOVA.

Otra medida que se utiliza con las diferencias de correlación es la q de Cohen. Esta es la diferencia entre dos coeficientes de regresión de Pearson transformados por Fisher. En símbolos, esto es

donde r 1 y r 2 son las regresiones que se comparan. El valor esperado de q es cero y su varianza es donde N 1 y N 2 son el número de puntos de datos en la primera y segunda regresión respectivamente.

El tamaño del efecto bruto correspondiente a una comparación de dos grupos se calcula inherentemente como las diferencias entre las dos medias. Sin embargo, para facilitar la interpretación es habitual estandarizar el tamaño del efecto; a continuación se presentan diversas convenciones para la estandarización estadística.

Un tamaño del efecto (poblacional) θ basado en medias generalmente considera la diferencia de medias estandarizada (SMD) entre dos poblaciones [22] : 78 donde μ 1 es la media de una población, μ 2 es la media de la otra población y σ es una desviación estándar basada en una o ambas poblaciones.

En la práctica, los valores de la población normalmente no se conocen y deben estimarse a partir de estadísticas de muestra. Las distintas versiones de los tamaños del efecto basadas en las medias difieren con respecto a las estadísticas que se utilizan.

Esta forma de calcular el tamaño del efecto se asemeja al cálculo de una estadística de prueba t , con la diferencia fundamental de que la estadística de prueba t incluye un factor de . Esto significa que, para un tamaño de efecto determinado, el nivel de significancia aumenta con el tamaño de la muestra. A diferencia de la estadística de prueba t , el tamaño del efecto tiene como objetivo estimar un parámetro de población y no se ve afectado por el tamaño de la muestra.

Los valores SMD de 0,2 a 0,5 se consideran pequeños, de 0,5 a 0,8 se consideran medianos y mayores de 0,8 se consideran grandes. [23]

La d de Cohen se define como la diferencia entre dos medias dividida por una desviación estándar de los datos, es decir

Jacob Cohen definió s , la desviación estándar agrupada , como (para dos muestras independientes): [10] : 67 donde la varianza para uno de los grupos se define como y de manera similar para el otro grupo.

La siguiente tabla contiene descripciones para magnitudes de d = 0,01 a 2,0, como lo sugirió inicialmente Cohen (quien advirtió contra la posibilidad de que los valores se convirtieran en estándares de facto, instando a la flexibilidad de interpretación) y como lo amplió Sawilowsky. [11]

Otros autores eligen un cálculo ligeramente diferente de la desviación estándar cuando se refieren a la " d de Cohen ", donde el denominador no tiene "-2" [24] [25] : 14 Esta definición de " d de Cohen " es denominada estimador de máxima verosimilitud por Hedges y Olkin, [22] y está relacionada con la g de Hedges por un factor de escala (ver más abajo).

Con dos muestras pareadas, observamos la distribución de las puntuaciones de diferencia. En ese caso, s es la desviación estándar de esta distribución de puntuaciones de diferencia. Esto crea la siguiente relación entre la estadística t para probar si hay una diferencia en las medias de los dos grupos y la d de Cohen : y

La d de Cohen se utiliza con frecuencia para estimar tamaños de muestra para pruebas estadísticas. Una d de Cohen más baja indica la necesidad de tamaños de muestra más grandes, y viceversa, como se puede determinar posteriormente junto con los parámetros adicionales del nivel de significación deseado y la potencia estadística . [26]

Para muestras pareadas, Cohen sugiere que la d calculada es en realidad una d', que no proporciona la respuesta correcta para obtener la potencia de la prueba, y que antes de buscar los valores en las tablas proporcionadas, se debe corregir para r como en la siguiente fórmula: [27]

En 1976, Gene V. Glass propuso un estimador del tamaño del efecto que utiliza sólo la desviación estándar del segundo grupo [22] : 78

El segundo grupo puede considerarse un grupo de control, y Glass argumentó que si se comparaban varios tratamientos con el grupo de control, sería mejor utilizar sólo la desviación estándar calculada a partir del grupo de control, de modo que los tamaños del efecto no difirieran bajo medias iguales y varianzas diferentes.

Bajo un supuesto correcto de varianzas poblacionales iguales, una estimación agrupada para σ es más precisa.

La g de Hedges , sugerida por Larry Hedges en 1981, [28] es como las otras medidas basadas en una diferencia estandarizada [22] : 79 donde la desviación estándar agrupada se calcula como:

Sin embargo, como estimador del tamaño del efecto poblacional θ es sesgado . No obstante, este sesgo se puede corregir aproximadamente a través de la multiplicación por un factor Hedges y Olkin se refieren a este estimador menos sesgado como d , [22] pero no es lo mismo que la d de Cohen . La forma exacta para el factor de corrección J () involucra la función gamma [22] : 104 También hay variantes multinivel de la g de Hedges, por ejemplo, para su uso en ensayos controlados aleatorizados por conglomerados (CRT). [29] Los CRT implican la aleatorización de conglomerados, como escuelas o aulas, a diferentes condiciones y se utilizan con frecuencia en la investigación educativa.

Un estimador de tamaño del efecto similar para comparaciones múltiples (por ejemplo, ANOVA ) es el efecto estandarizado de raíz cuadrada media Ψ: [20] donde k es el número de grupos en las comparaciones.

Esto presenta esencialmente la diferencia ómnibus de todo el modelo ajustado por la raíz cuadrada media, análoga a d o g .

Además, se ha proporcionado una generalización para diseños multifactoriales. [20]

Siempre que los datos estén distribuidos de forma gaussiana , una g de Hedges escalada sigue una distribución t no central con el parámetro de no centralidad y ( n 1 + n 2 − 2) grados de libertad. Asimismo, la Δ de Glass escalada se distribuye con n 2 − 1 grados de libertad.

A partir de la distribución es posible calcular la expectativa y la varianza de los tamaños del efecto.

En algunos casos se utilizan aproximaciones de la varianza a partir de muestras grandes. Una sugerencia para la varianza del estimador imparcial de Hedges es [22] : 86

La distancia de Mahalanobis (D) es una generalización multivariada de la d de Cohen, que tiene en cuenta las relaciones entre las variables. [30]

Las medidas de asociación comúnmente utilizadas para la prueba de chi-cuadrado son el coeficiente Phi y la V de Cramér (a veces denominada phi de Cramér y denotada como φ c ). Phi está relacionada con el coeficiente de correlación biserial puntual y la d de Cohen y estima el grado de relación entre dos variables (2 × 2). [31] La V de Cramér se puede utilizar con variables que tienen más de dos niveles.

Phi se puede calcular encontrando la raíz cuadrada de la estadística chi-cuadrado dividida por el tamaño de la muestra.

De manera similar, la V de Cramér se calcula tomando la raíz cuadrada de la estadística chi-cuadrado dividida por el tamaño de la muestra y la longitud de la dimensión mínima ( k es el menor entre el número de filas r o columnas c ).

φ c es la intercorrelación de las dos variables discretas [32] y se puede calcular para cualquier valor de r o c . Sin embargo, como los valores de chi-cuadrado tienden a aumentar con el número de celdas, cuanto mayor sea la diferencia entre r y c , más probable será que V tienda a 1 sin evidencia sólida de una correlación significativa.

Otra medida del tamaño del efecto utilizada para las pruebas de chi-cuadrado es el omega de Cohen ( ). Este se define como donde p 0 i es la proporción de la i ésima célula bajo H 0 , p 1 i es la proporción de la i ésima célula bajo H 1 y m es el número de células.

En Statistical Power Analysis for the Behavioral Sciences (1988, pp. 224-225), Cohen da la siguiente guía general para interpretar omega (ver la tabla a continuación), pero advierte contra su "posible inadecuación en cualquier contexto sustantivo dado" y aconseja utilizar en su lugar un juicio relevante para el contexto.

La razón de probabilidades (OR) es otro tamaño del efecto útil. Es apropiado cuando la pregunta de investigación se centra en el grado de asociación entre dos variables binarias . Por ejemplo, considere un estudio de la capacidad de ortografía. En un grupo de control, dos estudiantes aprueban la clase por cada uno que reprueba, por lo que las probabilidades de aprobar son de dos a uno (o 2/1 = 2). En el grupo de tratamiento, seis estudiantes aprueban por cada uno que reprueba, por lo que las probabilidades de aprobar son de seis a uno (o 6/1 = 6). El tamaño del efecto se puede calcular observando que las probabilidades de aprobar en el grupo de tratamiento son tres veces mayores que en el grupo de control (porque 6 dividido por 2 es 3). Por lo tanto, la razón de probabilidades es 3. Las estadísticas de la razón de probabilidades están en una escala diferente a la d de Cohen, por lo que este '3' no es comparable a una d de Cohen de 3.

El riesgo relativo (RR), también llamado razón de riesgo , es simplemente el riesgo (probabilidad) de un evento en relación con alguna variable independiente. Esta medida del tamaño del efecto difiere de la razón de probabilidades en que compara probabilidades en lugar de probabilidades , pero se aproxima asintóticamente a esta última para probabilidades pequeñas. Usando el ejemplo anterior, las probabilidades para aquellos en el grupo de control y el grupo de tratamiento de aprobar son 2/3 (o 0,67) y 6/7 (o 0,86), respectivamente. El tamaño del efecto se puede calcular de la misma manera que antes, pero usando las probabilidades en su lugar. Por lo tanto, el riesgo relativo es 1,28. Dado que se utilizaron probabilidades bastante grandes de aprobar, hay una gran diferencia entre el riesgo relativo y la razón de probabilidades. Si se hubiera utilizado el fracaso (una probabilidad menor) como el evento (en lugar de aprobar ), la diferencia entre las dos medidas del tamaño del efecto no sería tan grande.

Si bien ambas medidas son útiles, tienen diferentes usos estadísticos. En la investigación médica, el odds ratio se utiliza comúnmente para estudios de casos y controles , ya que generalmente se estiman las probabilidades, pero no las probabilidades. [33] El riesgo relativo se utiliza comúnmente en ensayos controlados aleatorizados y estudios de cohorte , pero el riesgo relativo contribuye a sobreestimar la efectividad de las intervenciones. [34]

La diferencia de riesgo (DR), a veces llamada reducción absoluta del riesgo, es simplemente la diferencia en el riesgo (probabilidad) de un evento entre dos grupos. Es una medida útil en la investigación experimental, ya que la DR indica en qué medida una intervención experimental cambia la probabilidad de un evento o resultado. Usando el ejemplo anterior, las probabilidades de que los del grupo de control y del grupo de tratamiento pasen son 2/3 (o 0,67) y 6/7 (o 0,86), respectivamente, y por lo tanto el tamaño del efecto de la DR es 0,86 − 0,67 = 0,19 (o 19%). La DR es la mejor medida para evaluar la efectividad de las intervenciones. [34]

Una medida utilizada en el análisis de potencia cuando se comparan dos proporciones independientes es la h de Cohen . Esta se define de la siguiente manera , donde p 1 y p 2 son las proporciones de las dos muestras que se comparan y arcsin es la transformación del arcoseno.

Para describir más fácilmente el significado de un tamaño de efecto a personas ajenas a las estadísticas, el tamaño del efecto del lenguaje común, como su nombre lo indica, fue diseñado para comunicarlo en un lenguaje sencillo. Se utiliza para describir una diferencia entre dos grupos y fue propuesto, así como nombrado, por Kenneth McGraw y SP Wong en 1992. [35] Utilizaron el siguiente ejemplo (sobre las alturas de hombres y mujeres): "en cualquier emparejamiento aleatorio de hombres y mujeres adultos jóvenes, la probabilidad de que el hombre sea más alto que la mujer es de 0,92, o en términos más simples aún, en 92 de cada 100 citas a ciegas entre adultos jóvenes, el hombre será más alto que la mujer", [35] al describir el valor poblacional del tamaño del efecto del lenguaje común.

La delta de Cliff o , desarrollada originalmente por Norman Cliff para su uso con datos ordinales, [36] [ dudosa – discutir ] es una medida de la frecuencia con la que los valores de una distribución son mayores que los valores de una segunda distribución. Fundamentalmente, no requiere ninguna suposición sobre la forma o dispersión de las dos distribuciones.

La estimación de la muestra viene dada por: donde las dos distribuciones son de tamaño y con ítems y , respectivamente, y es el corchete de Iverson , que es 1 cuando los contenidos son verdaderos y 0 cuando son falsos.

está relacionada linealmente con la estadística U de Mann–Whitney ; sin embargo, captura la dirección de la diferencia en su signo. Dado el Mann–Whitney , es:

Los intervalos de confianza de los tamaños de efecto estandarizados, especialmente los de Cohen y , se basan en el cálculo de los intervalos de confianza de los parámetros de no centralidad ( ncp ). Un enfoque común para construir el intervalo de confianza de ncp es encontrar los valores críticos de ncp para ajustar la estadística observada a los cuantiles de cola α /2 y (1 − α /2). El paquete SAS y R MBESS proporciona funciones para encontrar valores críticos de ncp .

Para un solo grupo, M denota la media de la muestra, μ la media de la población, SD la desviación estándar de la muestra, σ la desviación estándar de la población y n es el tamaño de la muestra del grupo. El valor t se utiliza para probar la hipótesis sobre la diferencia entre la media y una línea base μ línea base . Por lo general, μ línea base es cero. En el caso de dos grupos relacionados, el grupo único se construye por las diferencias en un par de muestras, mientras que SD y σ denotan las desviaciones estándar de las diferencias de la muestra y la población en lugar de dentro de los dos grupos originales. y la ecuación de Cohen

es la estimación puntual de

Entonces,

n 1 o n 2 son los respectivos tamaños de muestra.

donde

y la de Cohen es la estimación puntual de

Entonces,

La prueba ANOVA unidireccional aplica una distribución F no central . Mientras que con una desviación estándar de población dada , la misma pregunta de prueba aplica una distribución de chi-cuadrado no central .

Para cada j -ésima muestra dentro del i -ésimo grupo X i , j , denote

Mientras,

Por lo tanto, tanto ncp ( s ) de F como igualan

En el caso de K grupos independientes del mismo tamaño, el tamaño total de la muestra es N := n · K .

La prueba t para un par de grupos independientes es un caso especial de ANOVA de una vía. Nótese que el parámetro de no centralidad de F no es comparable con el parámetro de no centralidad de la t correspondiente . En realidad, , y .

Los valores de SMD de 0,2 a 0,5 se consideran pequeños, los valores de 0,5 a 0,8 se consideran medianos y los valores > 0,8 se consideran grandes. En los estudios de psicofarmacología que comparan grupos independientes, las SMD que son estadísticamente significativas casi siempre están en el rango pequeño a mediano. Es raro que se obtengan SMD grandes.

Más explicaciones