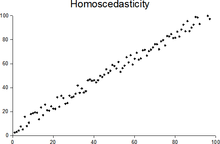

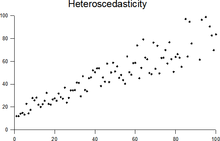

En estadística , una secuencia de variables aleatorias es homocedástica ( / ˌh oʊ m oʊ s k ə ˈ d æ s t ɪ k / ) si todas sus variables aleatorias tienen la misma varianza finita ; esto también se conoce como homogeneidad de varianza . La noción complementaria se llama heterocedasticidad , también conocida como heterogeneidad de varianza . Las grafías homos kedasticity y heteros kedasticity también se utilizan con frecuencia. “Scedasticidad” proviene de la palabra griega antigua “skedánnymi”, que significa “dispersar”. [1] [2] [3] Suponer que una variable es homocedástica cuando en realidad es heterocedástica ( / ˌ h ɛ t ər oʊ s k ə ˈ d æ s t ɪ k / ) da como resultado estimaciones puntuales imparciales pero ineficientes y estimaciones sesgadas de los errores estándar , y puede resultar en una sobreestimación de la bondad del ajuste medida por el coeficiente de Pearson .

La existencia de heterocedasticidad es una preocupación importante en el análisis de regresión y el análisis de varianza , ya que invalida las pruebas estadísticas de significancia que suponen que todos los errores de modelado tienen la misma varianza. Si bien el estimador de mínimos cuadrados ordinarios sigue siendo imparcial en presencia de heterocedasticidad, es ineficiente y la inferencia basada en el supuesto de homocedasticidad es engañosa. En ese caso, los mínimos cuadrados generalizados (GLS) se usaban con frecuencia en el pasado. [4] [5] Hoy en día, la práctica estándar en econometría es incluir errores estándar consistentes con la heterocedasticidad en lugar de usar GLS, ya que GLS puede exhibir un fuerte sesgo en muestras pequeñas si se desconoce la función cedástica real. [6]

Dado que la heterocedasticidad se refiere a las expectativas del segundo momento de los errores, su presencia se denomina especificación errónea de segundo orden. [7]

El econometrista Robert Engle recibió el Premio Nobel de Economía en 2003 por sus estudios sobre el análisis de regresión en presencia de heterocedasticidad, lo que condujo a su formulación de la técnica de modelado de heterocedasticidad condicional autorregresiva (ARCH). [8]

Considere la ecuación de regresión lineal donde la variable aleatoria dependiente es igual a la variable determinista multiplicada por el coeficiente más un término de perturbación aleatoria que tiene media cero. Las perturbaciones son homocedásticas si la varianza de es una constante ; de lo contrario, son heterocedásticas. En particular, las perturbaciones son heterocedásticas si la varianza de depende de o del valor de . Una forma en que podrían ser heterocedásticas es si (un ejemplo de una función cedástica ), por lo que la varianza es proporcional al valor de .

En términos más generales, si la matriz de varianza-covarianza de la perturbación a lo largo del tiempo tiene una diagonal no constante, la perturbación es heterocedástica. [9] Las matrices a continuación son covarianzas cuando hay solo tres observaciones a lo largo del tiempo. La perturbación en la matriz A es homocedástica; este es el caso simple donde MCO es el mejor estimador lineal insesgado. Las perturbaciones en las matrices B y C son heterocedásticas. En la matriz B, la varianza varía con el tiempo y aumenta de manera constante a lo largo del tiempo; en la matriz C, la varianza depende del valor de . La perturbación en la matriz D es homocedástica porque las varianzas diagonales son constantes, aunque las covarianzas fuera de la diagonal no son cero y los mínimos cuadrados ordinarios son ineficientes por una razón diferente: la correlación serial.

La heterocedasticidad a menudo ocurre cuando hay una gran diferencia entre los tamaños de las observaciones.

Un ejemplo clásico de heterocedasticidad es el de los ingresos frente a los gastos en alimentación. Una persona rica puede comer alimentos baratos a veces y alimentos caros en otras ocasiones. Una persona pobre casi siempre comerá alimentos baratos. Por lo tanto, las personas con mayores ingresos muestran una mayor variabilidad en los gastos en alimentación.

En el lanzamiento de un cohete, un observador mide la distancia recorrida por el cohete una vez por segundo. En los primeros segundos, las mediciones pueden tener una precisión de un centímetro. Después de cinco minutos, la precisión de las mediciones puede ser buena sólo hasta los 100 m, debido al aumento de la distancia, la distorsión atmosférica y una variedad de otros factores. Por lo tanto, las mediciones de distancia pueden presentar heterocedasticidad.

Uno de los supuestos del modelo clásico de regresión lineal es que no hay heterocedasticidad. Romper este supuesto significa que el teorema de Gauss-Markov no se aplica, lo que significa que los estimadores MCO no son los mejores estimadores lineales insesgados (BLUE) y su varianza no es la más baja de todos los demás estimadores insesgados. La heterocedasticidad no hace que las estimaciones de los coeficientes de mínimos cuadrados ordinarios sean sesgadas, aunque puede hacer que las estimaciones de mínimos cuadrados ordinarios de la varianza (y, por lo tanto, los errores estándar) de los coeficientes sean sesgadas, posiblemente por encima o por debajo de la varianza real de la población. Por lo tanto, el análisis de regresión que utiliza datos heterocedásticos seguirá proporcionando una estimación insesgada de la relación entre la variable predictora y el resultado, pero los errores estándar y, por lo tanto, las inferencias obtenidas del análisis de datos son sospechosas. Los errores estándar sesgados conducen a una inferencia sesgada, por lo que los resultados de las pruebas de hipótesis posiblemente sean erróneos. Por ejemplo, si se realiza un MCO en un conjunto de datos heterocedásticos, lo que produce una estimación de error estándar sesgada, un investigador podría no rechazar una hipótesis nula en un nivel de significancia dado , cuando esa hipótesis nula en realidad no es característica de la población real (cometiendo un error de tipo II ).

Bajo ciertas suposiciones, el estimador MCO tiene una distribución asintótica normal cuando está correctamente normalizado y centrado (incluso cuando los datos no provienen de una distribución normal ). Este resultado se utiliza para justificar el uso de una distribución normal, o una distribución de chi cuadrado (dependiendo de cómo se calcule la estadística de prueba ), al realizar una prueba de hipótesis . Esto se mantiene incluso bajo heterocedasticidad. Más precisamente, el estimador MCO en presencia de heterocedasticidad es asintóticamente normal, cuando está correctamente normalizado y centrado, con una matriz de varianza-covarianza que difiere del caso de homocedasticidad. En 1980, White propuso un estimador consistente para la matriz de varianza-covarianza de la distribución asintótica del estimador MCO. [2] Esto valida el uso de pruebas de hipótesis utilizando estimadores MCO y el estimador de varianza-covarianza de White bajo heterocedasticidad.

La heterocedasticidad también es un problema práctico importante que se plantea en los problemas ANOVA . [10] La prueba F todavía se puede utilizar en algunas circunstancias. [11]

Sin embargo, se ha dicho que los estudiantes de econometría no deberían reaccionar exageradamente a la heterocedasticidad. [3] Un autor escribió: "la varianza de error desigual solo vale la pena corregirla cuando el problema es grave". [12] Además, otra advertencia estaba en la forma: "la heterocedasticidad nunca ha sido una razón para descartar un modelo que, por lo demás, es bueno". [3] [13] Con la llegada de los errores estándar consistentes con la heterocedasticidad que permiten la inferencia sin especificar el segundo momento condicional del término de error, probar la homocedasticidad condicional no es tan importante como en el pasado. [6]

Sin embargo, para cualquier modelo no lineal (por ejemplo, los modelos Logit y Probit ), la heterocedasticidad tiene consecuencias más graves: las estimaciones de máxima verosimilitud (MLE) de los parámetros normalmente estarán sesgadas, así como inconsistentes (a menos que la función de verosimilitud se modifique para tener en cuenta correctamente la forma precisa de heterocedasticidad o la distribución sea miembro de la familia exponencial lineal y la función de expectativa condicional se especifique correctamente). [14] [15] Sin embargo, en el contexto de los modelos de elección binaria ( Logit o Probit ), la heterocedasticidad solo dará como resultado un efecto de escala positivo en la media asintótica de la MLE mal especificada (es decir, el modelo que ignora la heterocedasticidad). [16] Como resultado, las predicciones que se basan en la MLE mal especificada seguirán siendo correctas. Además, la MLE Probit y Logit mal especificada se distribuirá normalmente de forma asintótica, lo que permite realizar las pruebas de significancia habituales (con la matriz de varianza-covarianza adecuada). Sin embargo, en lo que respecta a la prueba de hipótesis general, como señala Greene , "el simple cálculo de una matriz de covarianza robusta para un estimador que de otro modo sería inconsistente no le otorga redención. En consecuencia, la virtud de una matriz de covarianza robusta en este contexto no está clara". [17]

Existen varias correcciones comunes para la heterocedasticidad, que son:

Los residuos se pueden probar para homocedasticidad utilizando la prueba de Breusch-Pagan , [20] que realiza una regresión auxiliar de los residuos al cuadrado sobre las variables independientes. A partir de esta regresión auxiliar, se conserva la suma explicada de los cuadrados, se divide por dos y luego se convierte en la estadística de prueba para una distribución de chi-cuadrado con los grados de libertad iguales al número de variables independientes. [21] La hipótesis nula de esta prueba de chi-cuadrado es homocedasticidad, y la hipótesis alternativa indicaría heterocedasticidad. Dado que la prueba de Breusch-Pagan es sensible a las desviaciones de la normalidad o tamaños de muestra pequeños, la prueba de Koenker-Bassett o "Breusch-Pagan generalizada" se utiliza comúnmente en su lugar. [22] [ cita(s) adicional(es) necesaria(s) ] A partir de la regresión auxiliar, se conserva el valor R-cuadrado que luego se multiplica por el tamaño de la muestra y luego se convierte en la estadística de prueba para una distribución de chi-cuadrado (y utiliza los mismos grados de libertad). Aunque no es necesario para la prueba de Koenker-Bassett, la prueba de Breusch-Pagan requiere que los residuos al cuadrado también se dividan por la suma de los cuadrados de los residuos dividida por el tamaño de la muestra. [22] La prueba de heterocedasticidad por grupo se puede realizar con la prueba de Goldfeld-Quandt . [23]

Debido al uso estándar de errores estándar consistentes con la heterocedasticidad y al problema de la prueba previa , hoy en día los econometristas rara vez utilizan pruebas para heterocedasticidad condicional. [6]

Aunque las pruebas de heterocedasticidad entre grupos pueden considerarse formalmente como un caso especial de pruebas dentro de modelos de regresión, algunas pruebas tienen estructuras específicas para este caso.

Dos o más distribuciones normales son homocedásticas y carecen de correlación serial si comparten las mismas diagonales en su matriz de covarianza y sus entradas no diagonales son cero. Las distribuciones homocedásticas son especialmente útiles para derivar algoritmos de reconocimiento de patrones estadísticos y de aprendizaje automático . Un ejemplo popular de un algoritmo que asume homocedasticidad es el análisis discriminante lineal de Fisher . El concepto de homocedasticidad se puede aplicar a distribuciones en esferas. [27]

El estudio de la homecedasticidad y la heterocedasticidad se ha generalizado al caso multivariado, que trata con las covarianzas de las observaciones vectoriales en lugar de la varianza de las observaciones escalares. Una versión de esto es utilizar matrices de covarianza como medida multivariada de dispersión. Varios autores han considerado pruebas en este contexto, tanto para situaciones de regresión como de datos agrupados. [28] [29] La prueba de Bartlett para heterocedasticidad entre datos agrupados, utilizada más comúnmente en el caso univariado, también se ha extendido para el caso multivariado, pero solo existe una solución manejable para 2 grupos. [30] Existen aproximaciones para más de dos grupos, y ambas se denominan prueba M de Box .

La mayoría de los libros de texto de estadística incluyen al menos algún material sobre homocedasticidad y heterocedasticidad. Algunos ejemplos son: