El método de mínimos cuadrados es un método de estimación de parámetros en el análisis de regresión basado en minimizar la suma de los cuadrados de los residuos (un residuo es la diferencia entre un valor observado y el valor ajustado proporcionado por un modelo) generados en los resultados de cada ecuación individual. (En términos más simples, los mínimos cuadrados son un procedimiento matemático para encontrar la curva que mejor se ajusta a un conjunto dado de puntos al minimizar la suma de los cuadrados de los desplazamientos ("los residuos") de los puntos de la curva).

La aplicación más importante es en el ajuste de datos . Cuando el problema tiene incertidumbres sustanciales en la variable independiente (la variable x ), entonces los métodos de regresión simple y de mínimos cuadrados tienen problemas; en tales casos, se puede considerar la metodología requerida para ajustar modelos de errores en las variables en lugar de la de mínimos cuadrados.

Los problemas de mínimos cuadrados se dividen en dos categorías: mínimos cuadrados lineales u ordinarios y mínimos cuadrados no lineales , dependiendo de si las funciones del modelo son lineales o no en todas las incógnitas. El problema de mínimos cuadrados lineales se presenta en el análisis de regresión estadística ; tiene una solución de forma cerrada . El problema no lineal se resuelve generalmente mediante refinamiento iterativo ; en cada iteración, el sistema se aproxima mediante uno lineal y, por lo tanto, el cálculo central es similar en ambos casos.

Los mínimos cuadrados polinomiales describen la varianza en una predicción de la variable dependiente en función de la variable independiente y las desviaciones de la curva ajustada.

Cuando las observaciones provienen de una familia exponencial con identidad como sus estadísticas naturales suficientes y se satisfacen las condiciones suaves (por ejemplo, para distribuciones normales , exponenciales , de Poisson y binomiales ), las estimaciones de mínimos cuadrados estandarizados y las estimaciones de máxima verosimilitud son idénticas. [1] El método de mínimos cuadrados también se puede derivar como un estimador del método de momentos .

La siguiente discusión se presenta principalmente en términos de funciones lineales , pero el uso de mínimos cuadrados es válido y práctico para familias de funciones más generales. Además, al aplicar iterativamente la aproximación cuadrática local a la probabilidad (a través de la información de Fisher ), el método de mínimos cuadrados puede usarse para ajustar un modelo lineal generalizado .

El método de mínimos cuadrados fue descubierto y publicado oficialmente por Adrien-Marie Legendre (1805), [2] aunque generalmente también se le atribuye el mérito a Carl Friedrich Gauss (1809), [3] [4] quien contribuyó con importantes avances teóricos al método, [4] y es posible que también lo haya utilizado en su trabajo anterior en 1794 y 1795. [5] [4]

El método de mínimos cuadrados surgió en los campos de la astronomía y la geodesia , cuando los científicos y matemáticos buscaban aportar soluciones a los desafíos de navegar por los océanos de la Tierra durante la Era de los Descubrimientos . La descripción precisa del comportamiento de los cuerpos celestes fue la clave para permitir que los barcos navegaran en mar abierto, donde los marineros ya no podían confiar en las observaciones de la tierra para navegar.

El método fue la culminación de varios avances que tuvieron lugar a lo largo del siglo XVIII: [6]

La primera exposición clara y concisa del método de mínimos cuadrados fue publicada por Legendre en 1805. [7] La técnica se describe como un procedimiento algebraico para ajustar ecuaciones lineales a datos y Legendre demuestra el nuevo método analizando los mismos datos que Laplace para la forma de la Tierra. En el plazo de diez años después de la publicación de Legendre, el método de mínimos cuadrados había sido adoptado como una herramienta estándar en astronomía y geodesia en Francia, Italia y Prusia, lo que constituye una aceptación extraordinariamente rápida de una técnica científica. [6]

En 1809 Carl Friedrich Gauss publicó su método de cálculo de las órbitas de los cuerpos celestes. En ese trabajo afirmó haber estado en posesión del método de mínimos cuadrados desde 1795. [8] Esto naturalmente condujo a una disputa de prioridad con Legendre. Sin embargo, para crédito de Gauss, fue más allá de Legendre y logró conectar el método de mínimos cuadrados con los principios de probabilidad y con la distribución normal . Había logrado completar el programa de Laplace de especificar una forma matemática de la densidad de probabilidad para las observaciones, dependiendo de un número finito de parámetros desconocidos, y definir un método de estimación que minimiza el error de estimación. Gauss demostró que la media aritmética es de hecho la mejor estimación del parámetro de ubicación al cambiar tanto la densidad de probabilidad como el método de estimación. Luego dio la vuelta al problema preguntando qué forma debería tener la densidad y qué método de estimación debería usarse para obtener la media aritmética como estimación del parámetro de ubicación. En este intento, inventó la distribución normal.

Una demostración temprana de la fuerza del método de Gauss se produjo cuando se utilizó para predecir la futura ubicación del recién descubierto asteroide Ceres . El 1 de enero de 1801, el astrónomo italiano Giuseppe Piazzi descubrió Ceres y pudo rastrear su trayectoria durante 40 días antes de que se perdiera en el resplandor del Sol. Basándose en estos datos, los astrónomos deseaban determinar la ubicación de Ceres después de que emergiera de detrás del Sol sin resolver las complicadas ecuaciones no lineales de Kepler del movimiento planetario. Las únicas predicciones que permitieron con éxito al astrónomo húngaro Franz Xaver von Zach reubicar a Ceres fueron las realizadas por Gauss, de 24 años, utilizando el análisis de mínimos cuadrados.

En 1810, después de leer el trabajo de Gauss, Laplace, después de demostrar el teorema del límite central , lo utilizó para dar una justificación de muestra grande para el método de mínimos cuadrados y la distribución normal. En 1822, Gauss pudo afirmar que el enfoque de mínimos cuadrados para el análisis de regresión es óptimo en el sentido de que en un modelo lineal donde los errores tienen una media de cero, no están correlacionados, se distribuyen normalmente y tienen varianzas iguales, el mejor estimador lineal insesgado de los coeficientes es el estimador de mínimos cuadrados. Una versión extendida de este resultado se conoce como el teorema de Gauss-Markov .

La idea del análisis de mínimos cuadrados también fue formulada independientemente por el estadounidense Robert Adrian en 1808. En los dos siglos siguientes, los investigadores de la teoría de errores y de la estadística encontraron muchas formas diferentes de implementar los mínimos cuadrados. [9]

El objetivo consiste en ajustar los parámetros de una función modelo para que se ajuste mejor a un conjunto de datos. Un conjunto de datos simple consta de n puntos (pares de datos) , i = 1, …, n , donde es una variable independiente y es una variable dependiente cuyo valor se encuentra por observación. La función modelo tiene la forma , donde m parámetros ajustables se mantienen en el vector . El objetivo es encontrar los valores de los parámetros para el modelo que "mejor" se ajustan a los datos. El ajuste de un modelo a un punto de datos se mide por su residuo , definido como la diferencia entre el valor observado de la variable dependiente y el valor predicho por el modelo:

El método de mínimos cuadrados encuentra los valores óptimos de los parámetros minimizando la suma de los residuos al cuadrado : [ 10]

En el caso más simple , el resultado del método de mínimos cuadrados es la media aritmética de los datos de entrada.

Un ejemplo de un modelo en dos dimensiones es el de la línea recta. Si se denota la intersección con el eje y como y la pendiente como , la función del modelo viene dada por . Véase el ejemplo de mínimos cuadrados lineales para obtener un ejemplo completamente elaborado de este modelo.

Un punto de datos puede constar de más de una variable independiente. Por ejemplo, al ajustar un plano a un conjunto de mediciones de altura, el plano es una función de dos variables independientes, x y z , por ejemplo. En el caso más general, puede haber una o más variables independientes y una o más variables dependientes en cada punto de datos.

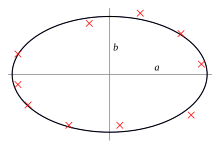

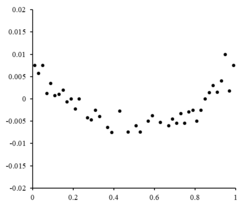

A la derecha hay un gráfico residual que ilustra fluctuaciones aleatorias alrededor de , lo que indica que un modelo lineal es apropiado. es una variable aleatoria independiente. [10]

Si los puntos residuales tuvieran algún tipo de forma y no fluctuaran aleatoriamente, un modelo lineal no sería apropiado. Por ejemplo, si el gráfico de residuos tuviera una forma parabólica como se ve a la derecha, un modelo parabólico sería apropiado para los datos. Los residuos para un modelo parabólico se pueden calcular mediante . [10]

Esta formulación de regresión considera únicamente los errores de observación en la variable dependiente (pero la regresión alternativa de mínimos cuadrados totales puede tener en cuenta los errores en ambas variables). Hay dos contextos bastante diferentes con diferentes implicaciones:

El mínimo de la suma de los cuadrados se obtiene fijando el gradiente en cero. Como el modelo contiene m parámetros, hay m ecuaciones de gradiente: y como , las ecuaciones de gradiente se convierten en

Las ecuaciones de gradiente se aplican a todos los problemas de mínimos cuadrados. Cada problema particular requiere expresiones particulares para el modelo y sus derivadas parciales . [12]

Un modelo de regresión es lineal cuando el modelo comprende una combinación lineal de los parámetros, es decir, donde la función es una función de . [12]

Si ponemos y ponemos las variables independientes y dependientes en las matrices y , respectivamente, podemos calcular los mínimos cuadrados de la siguiente manera. Nótese que es el conjunto de todos los datos. [12] [13]

El gradiente de la pérdida es:

Estableciendo el gradiente de la pérdida en cero y resolviendo para , obtenemos: [13] [12]

En algunos casos, existe una solución cerrada para un problema de mínimos cuadrados no lineal, pero en general no la hay. En el caso de que no exista una solución cerrada, se utilizan algoritmos numéricos para encontrar el valor de los parámetros que minimiza el objetivo. La mayoría de los algoritmos implican la elección de valores iniciales para los parámetros. Luego, los parámetros se refinan iterativamente, es decir, los valores se obtienen por aproximación sucesiva: donde un superíndice k es un número de iteración y el vector de incrementos se denomina vector de desplazamiento. En algunos algoritmos de uso común, en cada iteración el modelo puede linealizarse por aproximación a una expansión de la serie de Taylor de primer orden sobre :

El jacobiano J es una función de constantes, la variable independiente y los parámetros, por lo que cambia de una iteración a la siguiente. Los residuos están dados por

Para minimizar la suma de los cuadrados de , la ecuación del gradiente se establece en cero y se resuelve para : que, al reordenar, se convierten en m ecuaciones lineales simultáneas, las ecuaciones normales :

Las ecuaciones normales se escriben en notación matricial como

Éstas son las ecuaciones definitorias del algoritmo de Gauss-Newton .

Estas diferencias deben tenerse en cuenta siempre que se busque la solución a un problema de mínimos cuadrados no lineal. [12]

Consideremos un ejemplo sencillo extraído de la física. Un resorte debe obedecer la ley de Hooke , que establece que la extensión de un resorte y es proporcional a la fuerza, F , aplicada a él. constituye el modelo, donde F es la variable independiente. Para estimar la constante de fuerza , k , realizamos una serie de n mediciones con diferentes fuerzas para producir un conjunto de datos, , donde y i es una extensión de resorte medida. [14] Cada observación experimental contendrá algún error, , por lo que podemos especificar un modelo empírico para nuestras observaciones,

Existen muchos métodos que podemos utilizar para estimar el parámetro desconocido k . Dado que las n ecuaciones en las m variables de nuestros datos comprenden un sistema sobredeterminado con una incógnita y n ecuaciones, estimamos k utilizando mínimos cuadrados. La suma de cuadrados que se debe minimizar es [12]

La estimación de mínimos cuadrados de la constante de fuerza, k , está dada por

Suponemos que al aplicar fuerza el resorte se expande. Después de haber obtenido la constante de fuerza mediante el ajuste por mínimos cuadrados, predecimos la extensión a partir de la ley de Hooke.

En un cálculo de mínimos cuadrados con pesos unitarios, o en regresión lineal, la varianza en el parámetro j ésimo, denotado , se estima usualmente con donde la varianza del error verdadero σ 2 se reemplaza por una estimación, la estadística chi-cuadrado reducida , basada en el valor minimizado de la suma residual de cuadrados (función objetivo), S . El denominador, n − m , son los grados de libertad estadísticos ; vea los grados de libertad efectivos para generalizaciones. [12] C es la matriz de covarianza .

Si se conoce la distribución de probabilidad de los parámetros o se realiza una aproximación asintótica, se pueden hallar límites de confianza . De manera similar, se pueden realizar pruebas estadísticas sobre los residuos si se conoce o se supone la distribución de probabilidad de los residuos. Podemos derivar la distribución de probabilidad de cualquier combinación lineal de las variables dependientes si se conoce o se supone la distribución de probabilidad de los errores experimentales. La inferencia es fácil cuando se supone que los errores siguen una distribución normal, lo que implica en consecuencia que las estimaciones de los parámetros y los residuos también se distribuirán normalmente en función de los valores de las variables independientes. [12]

Es necesario hacer suposiciones sobre la naturaleza de los errores experimentales para comprobar los resultados estadísticamente. Una suposición común es que los errores pertenecen a una distribución normal. El teorema del límite central respalda la idea de que esta es una buena aproximación en muchos casos.

Sin embargo, supongamos que los errores no se distribuyen normalmente. En ese caso, un teorema de límite central implica a menudo que las estimaciones de los parámetros se distribuirán aproximadamente de manera normal siempre que la muestra sea razonablemente grande. Por esta razón, dada la importante propiedad de que la media del error es independiente de las variables independientes, la distribución del término de error no es una cuestión importante en el análisis de regresión. En concreto, no suele ser importante si el término de error sigue una distribución normal.

Un caso especial de mínimos cuadrados generalizados llamado mínimos cuadrados ponderados ocurre cuando todas las entradas fuera de la diagonal de Ω (la matriz de correlación de los residuos) son nulas; las varianzas de las observaciones (a lo largo de la diagonal de la matriz de covarianza) aún pueden ser desiguales ( heterocedasticidad ). En términos más simples, la heterocedasticidad es cuando la varianza de depende del valor de lo que hace que el gráfico de residuos cree un efecto de "despliegue" hacia valores más grandes como se ve en el gráfico de residuos a la derecha. Por otro lado, la homocedasticidad supone que la varianza de y la varianza de son iguales. [10]

El primer componente principal de la media de un conjunto de puntos se puede representar mediante la línea que más se aproxima a los puntos de datos (medida por la distancia al cuadrado del punto de aproximación más cercano, es decir, perpendicular a la línea). Por el contrario, los mínimos cuadrados lineales intentan minimizar la distancia solo en la dirección. Por lo tanto, aunque ambos utilizan una métrica de error similar, los mínimos cuadrados lineales son un método que trata una dimensión de los datos de manera preferencial, mientras que el PCA trata todas las dimensiones por igual.

La destacada estadística Sara van de Geer utilizó la teoría de procesos empíricos y la dimensión de Vapnik-Chervonenkis para demostrar que un estimador de mínimos cuadrados puede interpretarse como una medida en el espacio de funciones integrables al cuadrado . [16]

En algunos contextos, puede ser preferible una versión regularizada de la solución de mínimos cuadrados. La regularización de Tikhonov (o regresión de cresta ) agrega una restricción de que , la norma al cuadrado del vector de parámetros, no es mayor que un valor dado a la formulación de mínimos cuadrados, lo que conduce a un problema de minimización restringida. Esto es equivalente al problema de minimización sin restricciones donde la función objetivo es la suma residual de cuadrados más un término de penalización y es un parámetro de ajuste (esta es la forma lagrangiana del problema de minimización restringida). [17]

En un contexto bayesiano , esto equivale a colocar una distribución normal a priori con media cero en el vector de parámetros.

Una versión regularizada alternativa de mínimos cuadrados es Lasso (operador de selección y contracción mínima absoluta), que utiliza la restricción de que , la norma L 1 del vector de parámetros, no es mayor que un valor dado. [18] [19] [20] (Se puede demostrar como arriba usando multiplicadores de Lagrange que esto es equivalente a una minimización sin restricciones de la penalización de mínimos cuadrados con agregado). En un contexto bayesiano , esto es equivalente a colocar una distribución previa de Laplace de media cero en el vector de parámetros. [21] El problema de optimización se puede resolver usando programación cuadrática o métodos de optimización convexa más generales , así como también mediante algoritmos específicos como el algoritmo de regresión de ángulo mínimo .

Una de las principales diferencias entre Lasso y la regresión de cresta es que en la regresión de cresta, a medida que aumenta la penalización, todos los parámetros se reducen sin dejar de ser distintos de cero, mientras que en Lasso, al aumentar la penalización, cada vez más parámetros se reducen a cero. Esta es una ventaja de Lasso sobre la regresión de cresta, ya que reducir los parámetros a cero deselecciona las características de la regresión. Por lo tanto, Lasso selecciona automáticamente las características más relevantes y descarta las demás, mientras que la regresión de cresta nunca descarta ninguna característica por completo. Algunas técnicas de selección de características se desarrollan en base a LASSO, incluyendo Bolasso, que realiza un bootstrap de muestras, [22] y FeaLect, que analiza los coeficientes de regresión correspondientes a diferentes valores de para puntuar todas las características. [23]

La formulación L 1 -regularizada es útil en algunos contextos debido a su tendencia a preferir soluciones donde más parámetros son cero, lo que da soluciones que dependen de menos variables. [18] Por esta razón, el Lasso y sus variantes son fundamentales para el campo de la detección comprimida . Una extensión de este enfoque es la regularización de red elástica .

{{cite book}}: CS1 maint: others (link){{cite book}}: CS1 maint: location (link) CS1 maint: location missing publisher (link) CS1 maint: multiple names: authors list (link) CS1 maint: numeric names: authors list (link)