La gramática generativa es una tradición de investigación en lingüística que tiene como objetivo explicar la base cognitiva del lenguaje mediante la formulación y prueba de modelos explícitos del conocimiento gramatical subconsciente de los humanos. Los lingüistas generativos, o generativistas ( /ˈdʒɛnərətɪvɪsts/ ) , [ 1] tienden a compartir ciertos supuestos de trabajo como la distinción entre competencia y desempeño y la noción de que algunos aspectos específicos del dominio de la gramática son parcialmente innatos en los humanos. Estos supuestos son rechazados en enfoques no generativos como los modelos de lenguaje basados en el uso . La lingüística generativa incluye trabajo en áreas centrales como sintaxis , semántica , fonología , psicolingüística y adquisición del lenguaje , con extensiones adicionales a temas que incluyen biolingüística y cognición musical .

La gramática generativa comenzó a fines de la década de 1950 con el trabajo de Noam Chomsky , y tiene raíces en enfoques anteriores como la lingüística estructural . La primera versión del modelo de Chomsky se denominó gramática transformacional , con iteraciones posteriores conocidas como teoría de gobierno y vinculación y el programa minimalista . Otros modelos generativos actuales incluyen la teoría de la optimalidad , la gramática categórica y la gramática de árboles adyacentes .

La gramática generativa es un término general que engloba una variedad de enfoques de la lingüística. Lo que une a estos enfoques es el objetivo de descubrir la base cognitiva del lenguaje mediante la formulación y prueba de modelos explícitos del conocimiento gramatical subconsciente de los humanos. [2] [3]

La gramática generativa estudia el lenguaje como parte de la ciencia cognitiva . Por lo tanto, la investigación en la tradición generativa implica formular y probar hipótesis sobre los procesos mentales que permiten a los humanos utilizar el lenguaje. [4] [5] [6]

Al igual que otros enfoques de la lingüística, la gramática generativa se ocupa de la descripción lingüística más que de la prescripción lingüística . [7] [8]

La gramática generativa propone modelos de lenguaje que consisten en sistemas de reglas explícitas, que hacen predicciones comprobables y falsables . Esto es diferente de la gramática tradicional , donde los patrones gramaticales suelen describirse de forma más vaga. [9] [10] Estos modelos pretenden ser parsimoniosos, capturando generalizaciones en los datos con la menor cantidad de reglas posible. Por ejemplo, debido a que las preguntas de etiqueta imperativa en inglés obedecen las mismas restricciones que las etiquetas declarativas de futuro en segunda persona , Paul Postal propuso que las dos construcciones se derivan de la misma estructura subyacente. Al adoptar esta hipótesis, pudo capturar las restricciones de las etiquetas con una sola regla. Este tipo de razonamiento es común en la investigación generativa. [9]

Se han expresado teorías particulares dentro de la gramática generativa utilizando una variedad de sistemas formales , muchos de los cuales son modificaciones o extensiones de gramáticas libres de contexto . [9]

La gramática generativa generalmente distingue entre competencia lingüística y desempeño lingüístico . [11] La competencia es el conjunto de reglas subconscientes que uno conoce cuando conoce una lengua; el desempeño es el sistema que pone en práctica estas reglas. [11] [12] Esta distinción está relacionada con la noción más amplia de los niveles de Marr utilizados en otras ciencias cognitivas, donde la competencia corresponde al nivel computacional de Marr. [13]

Por ejemplo, las teorías generativas generalmente brindan explicaciones basadas en la competencia para explicar por qué los hablantes de inglés juzgarían la oración en (1) como impar . En estas explicaciones, la oración sería agramatical porque las reglas del inglés solo generan oraciones donde los demostrativos concuerdan con el número gramatical de su sustantivo asociado . [14]

Por el contrario, las teorías generativas generalmente brindan explicaciones basadas en el desempeño para la rareza de las oraciones con inserción central como la del punto (2). Según tales explicaciones, la gramática del inglés podría, en principio, generar tales oraciones, pero hacerlo en la práctica es tan exigente para la memoria de trabajo que la oración termina siendo imposible de analizar . [14] [15]

En general, las explicaciones basadas en el desempeño ofrecen una teoría gramatical más simple a costa de suposiciones adicionales sobre la memoria y el análisis sintáctico. Como resultado, la elección entre una explicación basada en la competencia y una explicación basada en el desempeño para un fenómeno dado no siempre es obvia y puede requerir investigar si las suposiciones adicionales están respaldadas por evidencia independiente. [15] [16] Por ejemplo, mientras que muchos modelos generativos de sintaxis explican los efectos isla postulando restricciones dentro de la gramática, también se ha argumentado que algunas o todas estas restricciones son de hecho el resultado de limitaciones en el desempeño. [17] [18]

Los enfoques no generativos a menudo no plantean ninguna distinción entre competencia y desempeño. Por ejemplo, los modelos de lenguaje basados en el uso suponen que los patrones gramaticales surgen como resultado del uso. [19]

Un objetivo importante de la investigación generativa es determinar qué aspectos de la competencia lingüística son innatos y cuáles no. En el ámbito de la gramática generativa, se acepta generalmente que al menos algunos aspectos específicos de un dominio son innatos, y el término "gramática universal" se utiliza a menudo como sustituto de los que resulten serlo. [20] [21]

La idea de que al menos algunos aspectos son innatos está motivada por la pobreza de los argumentos de estímulo. [22] [23] Por ejemplo, una famosa pobreza del argumento de estímulo se refiere a la adquisición de preguntas de sí o no en inglés. Este argumento parte de la observación de que los niños sólo cometen errores compatibles con reglas que apuntan a la estructura jerárquica, aunque los ejemplos que encuentran podrían haber sido generados por una regla más simple que apunta al orden lineal. En otras palabras, los niños parecen ignorar la posibilidad de que la regla de la pregunta sea tan simple como "cambiar el orden de las dos primeras palabras" e inmediatamente saltan a alternativas que reordenan los constituyentes en estructuras de árbol . Esto se toma como evidencia de que los niños nacen sabiendo que las reglas gramaticales implican una estructura jerárquica, aunque tienen que averiguar cuáles son esas reglas. [22] [23] [24] La base empírica de la pobreza de los argumentos de estímulo ha sido cuestionada por Geoffrey Pullum y otros, lo que ha dado lugar a un debate de ida y vuelta en la literatura sobre adquisición del lenguaje . [25] [26] Trabajos recientes también han sugerido que algunas arquitecturas de redes neuronales recurrentes pueden aprender la estructura jerárquica sin una restricción explícita. [27]

Dentro de la gramática generativa, hay una variedad de teorías sobre en qué consiste la gramática universal. Una notable hipótesis propuesta por Hagit Borer sostiene que las operaciones sintácticas fundamentales son universales y que toda variación surge de diferentes especificaciones de características en el léxico . [21] [28] Por otro lado, una hipótesis fuerte adoptada en algunas variantes de la teoría de la optimalidad sostiene que los humanos nacen con un conjunto universal de restricciones, y que toda variación surge de diferencias en cómo se clasifican estas restricciones. [21] [29] En un artículo de 2002, Noam Chomsky , Marc Hauser y W. Tecumseh Fitch propusieron que la gramática universal consiste únicamente en la capacidad de estructurar frases jerárquicas. [30]

En la investigación cotidiana, la noción de que existe una gramática universal motiva los análisis en términos de principios generales. En la medida de lo posible, los datos sobre lenguas particulares se derivan de estos principios generales en lugar de de estipulaciones específicas de cada lengua. [20]

La investigación en gramática generativa abarca varios subcampos, que también se estudian en enfoques no generativos.

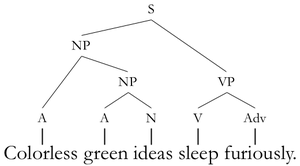

La sintaxis estudia los sistemas de reglas que combinan unidades más pequeñas, como los morfemas, en unidades más grandes, como frases y oraciones . [31] Dentro de la sintaxis generativa, los enfoques destacados incluyen el minimalismo , la teoría del gobierno y la vinculación , la gramática léxico-funcional (LFG) y la gramática de estructura de frase impulsada por la cabeza (HPSG). [3]

La fonología estudia los sistemas de reglas que organizan los sonidos lingüísticos. Por ejemplo, la investigación en fonología incluye trabajos sobre reglas fonotácticas que gobiernan qué fonemas se pueden combinar, así como las que determinan la colocación del acento , el tono y otros elementos suprasegmentales . [32] Dentro de la gramática generativa, un enfoque destacado de la fonología es la teoría de la optimalidad . [29]

La semántica estudia los sistemas de reglas que determinan el significado de las expresiones. Dentro de la gramática generativa, la semántica es una especie de semántica formal que proporciona modelos compositivos de cómo se calculan las denotaciones de las oraciones en función de los significados de los morfemas individuales y su estructura sintáctica. [33]

La gramática generativa se ha aplicado a la teoría y el análisis musical desde la década de 1980. [34] Un enfoque notable es la teoría generativa de la música tonal de Fred Lerdahl y Ray Jackendoff , que formalizó y amplió las ideas del análisis schenkeriano . [35]

Trabajos recientes en biolingüística de inspiración generativa han propuesto que la gramática universal consiste únicamente en recursión sintáctica , y que surgió recientemente en humanos como resultado de una mutación genética aleatoria. [36] La biolingüística de inspiración generativa no ha descubierto ningún gen en particular responsable del lenguaje. Si bien se plantearon algunas perspectivas con el descubrimiento del gen FOXP2 , [37] [38] no hay suficiente respaldo para la idea de que sea "el gen de la gramática" o que haya tenido mucho que ver con la aparición relativamente reciente del habla sintáctica. [39]

Como tradición de investigación distinta, la gramática generativa comenzó a fines de la década de 1950 con el trabajo de Noam Chomsky . [40] Sin embargo, sus raíces incluyen enfoques estructuralistas anteriores como la glosemática que a su vez tenían raíces más antiguas, por ejemplo en el trabajo del antiguo gramático indio Pāṇini . [41] [42] [43] La financiación militar a la investigación generativa fue un factor importante en su difusión temprana en la década de 1960. [44]

La versión inicial de la sintaxis generativa se denominó gramática transformacional . En la gramática transformacional, las reglas llamadas transformaciones asignaban un nivel de representación llamado estructuras profundas a otro nivel de representación llamado estructura superficial. La interpretación semántica de una oración se representaba mediante su estructura profunda, mientras que la estructura superficial proporcionaba su pronunciación. Por ejemplo, una oración activa como "El médico examinó al paciente" y "El médico examinó al paciente" tenían la misma estructura profunda. La diferencia en las estructuras superficiales surge de la aplicación de la transformación de pasivización, que se suponía que no afectaba al significado. Esta suposición fue cuestionada en la década de 1960 con el descubrimiento de ejemplos como "Todos en la sala saben dos idiomas" y "Todos en la sala saben dos idiomas". [ cita requerida ]

Después de las guerras lingüísticas de finales de los años 1960 y principios de los años 1970, Chomsky desarrolló un modelo revisado de sintaxis llamado teoría del gobierno y la vinculación , que con el tiempo se convirtió en minimalismo . A raíz de esas disputas, se propusieron otros modelos generativos de sintaxis, entre ellos la gramática relacional , la gramática léxico-funcional (LFG) y la gramática de estructura de frase impulsada por la cabeza (HPSG). [ cita requerida ]

La fonología generativa se centró originalmente en las reglas de reescritura , en un sistema conocido comúnmente como fonología SPE en honor al libro The Sound Pattern of English de Chomsky y Morris Halle de 1968. En la década de 1990, este enfoque fue reemplazado en gran medida por la teoría de la optimalidad , que fue capaz de capturar generalizaciones llamadas conspiraciones que debían estipularse en la fonología SPE. [29]

La semántica surgió como un subcampo de la lingüística generativa a finales de los años 1970, con el trabajo pionero de Richard Montague . Montague propuso un sistema llamado gramática Montague , que consistía en reglas de interpretación que asignaban expresiones de un modelo de sintaxis a medida a fórmulas de lógica intensional . El trabajo posterior de Barbara Partee , Irene Heim , Tanya Reinhart y otros demostró que las ideas clave de la gramática Montague podían incorporarse a sistemas sintácticamente más plausibles. [45] [46]

...la gramática generativa no es tanto una teoría como una familia de teorías, o una escuela de pensamiento... [que tiene] supuestos y objetivos compartidos, dispositivos formales ampliamente utilizados y resultados empíricos generalmente aceptados.