La historia del hardware informático a partir de 1960 está marcada por la conversión de los tubos de vacío a dispositivos de estado sólido , como los transistores y luego los chips de circuitos integrados (IC). Alrededor de 1953 a 1959, los transistores discretos comenzaron a considerarse lo suficientemente confiables y económicos como para hacer que las computadoras de tubos de vacío no fueran competitivas . La tecnología de integración a gran escala (LSI) de metal-óxido-semiconductor (MOS) condujo posteriormente al desarrollo de la memoria de semiconductores a mediados y fines de la década de 1960 y luego al microprocesador a principios de la década de 1970. Esto llevó a que la memoria de computadora primaria se alejara de los dispositivos de memoria de núcleo magnético a la memoria de semiconductores estática y dinámica de estado sólido, lo que redujo en gran medida el costo, el tamaño y el consumo de energía de las computadoras. Estos avances llevaron a la computadora personal (PC) miniaturizada en la década de 1970, comenzando con las computadoras domésticas y las computadoras de escritorio , seguidas por las computadoras portátiles y luego las computadoras móviles durante las siguientes décadas.

A los efectos de este artículo, el término "segunda generación" se refiere a los ordenadores que utilizan transistores discretos, incluso cuando los fabricantes se referían a ellos como "de tercera generación". En 1960, los ordenadores con transistores estaban sustituyendo a los ordenadores de válvulas de vacío, ofreciendo un menor coste, mayor velocidad y un menor consumo de energía. El mercado estaba dominado por IBM y los siete enanitos :

Algunos ejemplos de computadoras de segunda generación de la década de 1960 de dichos fabricantes son:

Sin embargo, algunas empresas más pequeñas hicieron contribuciones significativas. Asimismo, hacia el final de la segunda generación, Digital Equipment Corporation (DEC) era un competidor serio en el mercado de máquinas pequeñas y medianas.

Mientras tanto, en la URSS también se estaban desarrollando ordenadores de segunda generación, como, por ejemplo, la familia Razdan de ordenadores digitales de propósito general, creada en el Instituto de Investigación y Desarrollo Informático de Ereván .

Las arquitecturas informáticas de segunda generación inicialmente variaron; incluyeron computadoras decimales basadas en caracteres , computadoras decimales de magnitud de signo con una palabra de 10 dígitos, computadoras binarias de magnitud de signo y computadoras binarias de complemento a uno , aunque Philco, RCA y Honeywell, por ejemplo, tenían algunas computadoras que eran computadoras binarias basadas en caracteres y Digital Equipment Corporation (DEC) y Philco, por ejemplo, tenían computadoras de complemento a dos . Con la llegada del IBM System/360 , el complemento a dos se convirtió en la norma para las nuevas líneas de productos.

Los tamaños de palabra más comunes para mainframes binarios eran 36 y 48 bits, aunque las máquinas de nivel de entrada y de rango medio usaban palabras más pequeñas, por ejemplo, 12 bits , 18 bits , 24 bits , 30 bits. Todas las máquinas, excepto las más pequeñas, tenían canales de E/S asíncronos e interrupciones . Por lo general, las computadoras binarias con un tamaño de palabra de hasta 36 bits tenían una instrucción por palabra, las computadoras binarias con 48 bits por palabra tenían dos instrucciones por palabra y las máquinas CDC de 60 bits podían tener dos, tres o cuatro instrucciones por palabra, dependiendo de la combinación de instrucciones; las líneas Burroughs B5000 , B6500/B7500 y B8500 son excepciones notables a esto.

Las computadoras de primera generación con canales de datos (canales de E/S) tenían una interfaz DMA básica con el cable del canal. La segunda generación presentó diseños más simples (por ejemplo, los canales de la serie CDC 6000 no tenían DMA) y más sofisticados (por ejemplo, el 7909 en el IBM 7090 tenía un sistema de interrupción, ramificación condicional y computación limitada).

En 1960, el núcleo magnético era la tecnología de memoria dominante, aunque todavía había algunas máquinas nuevas que usaban tambores y líneas de retardo durante la década de 1960. La película delgada magnética y la memoria de varilla se usaron en algunas máquinas de segunda generación, pero los avances en la tecnología del núcleo significaron que siguieron siendo jugadores de nicho hasta que la memoria de semiconductores reemplazó tanto al núcleo como a la película delgada.

En la primera generación, las computadoras orientadas a palabras tenían típicamente un solo acumulador y una extensión, denominada, por ejemplo, acumulador superior e inferior, acumulador y registro multiplicador-cociente (MQ). En la segunda generación, se volvió común que las computadoras tuvieran múltiples acumuladores direccionables. En algunas computadoras, por ejemplo, PDP-6 , los mismos registros servían como acumuladores y registros de índice , lo que los convirtió en un ejemplo temprano de registros de propósito general .

En la segunda generación hubo un desarrollo considerable de nuevos modos de direccionamiento , incluyendo direccionamiento truncado en, por ejemplo, el Philco TRANSAC S-2000 , el UNIVAC III , y el incremento automático del registro de índice en, por ejemplo, el RCA 601, UNIVAC 1107 , y la serie GE-600 . Aunque los registros de índice se introdujeron en la primera generación bajo el nombre de línea B , su uso se hizo mucho más común en la segunda generación. De manera similar, el direccionamiento indirecto se hizo más común en la segunda generación, ya sea en conjunción con los registros de índice o en lugar de ellos. Mientras que las computadoras de primera generación típicamente tenían una pequeña cantidad de registros de índice o ninguno, varias líneas de computadoras de segunda generación tenían una gran cantidad de registros de índice, por ejemplo, Atlas , Bendix G-20 , IBM 7070 .

La primera generación fue pionera en el uso de funciones especiales para llamar a subrutinas, por ejemplo, TSX en el IBM 709. En la segunda generación, dichas funciones eran omnipresentes; algunos ejemplos son:

La segunda generación vio la introducción de características destinadas a soportar configuraciones multiprogramación y multiprocesador , incluyendo el modo maestro/esclavo (supervisor/problema), claves de protección de almacenamiento, registros de límite, protección asociada con la traducción de direcciones e instrucciones atómicas .

El aumento masivo del uso de computadoras se aceleró con las computadoras de tercera generación que comenzaron a comercializarse en el mercado comercial alrededor de 1966. Estas computadoras generalmente se basaban en la tecnología de circuitos integrados (de menos de 1000 transistores) . La tercera generación termina con la cuarta generación basada en microprocesadores .

En 1958, Jack Kilby de Texas Instruments inventó el circuito integrado híbrido (IC híbrido), [1] que tenía conexiones de cables externos, lo que dificultaba su producción en masa. [2] En 1959, Robert Noyce de Fairchild Semiconductor inventó el chip de circuito integrado (IC) monolítico. [3] [2] Estaba hecho de silicio , mientras que el chip de Kilby estaba hecho de germanio . La base para el IC monolítico de Noyce fue el proceso planar de Fairchild , que permitió diseñar circuitos integrados utilizando los mismos principios que los de los circuitos impresos . El proceso planar fue desarrollado por el colega de Noyce, Jean Hoerni , a principios de 1959, basado en los procesos de pasivación de la superficie de silicio y oxidación térmica desarrollados por Carl Frosch y Lincoln Derrick en 1955 y 1957. [4] [5] [6] [7] [8] [9]

Las computadoras que utilizan chips IC comenzaron a aparecer a principios de la década de 1960. Por ejemplo, la Semiconductor Network Computer (Molecular Electronic Computer, Mol-E-Com) de 1961, [10] [11] [12] la primera computadora monolítica de circuito integrado [13] [14] [15] de propósito general (construida para fines de demostración, programada para simular una calculadora de escritorio) fue construida por Texas Instruments para la Fuerza Aérea de los EE . UU . [16] [17] [18] [19]

Algunos de sus primeros usos fueron en sistemas integrados , en particular los utilizados por la NASA para la computadora de guía Apollo , por los militares en el misil balístico intercontinental LGM-30 Minuteman , la computadora aerotransportada Honeywell ALERT, [20] [21] y en la computadora central de datos aéreos utilizada para el control de vuelo en el avión de combate F-14A Tomcat de la Marina de los EE. UU .

Un uso comercial temprano fue el SDS 92 de 1965. [22] [23] IBM utilizó por primera vez circuitos integrados en computadoras para la lógica del System/360 Modelo 85 enviado en 1969 y luego hizo un uso extensivo de circuitos integrados en su System/370 que comenzó a enviarse en 1971.

El circuito integrado permitió el desarrollo de ordenadores mucho más pequeños. El miniordenador fue una innovación significativa en los años 1960 y 1970. Hizo llegar la potencia informática a más personas, no sólo por su tamaño físico más conveniente, sino también por la ampliación del campo de proveedores de ordenadores. Digital Equipment Corporation se convirtió en la segunda empresa de ordenadores detrás de IBM con sus populares sistemas informáticos PDP y VAX . El hardware más pequeño y asequible también provocó el desarrollo de nuevos sistemas operativos importantes como Unix .

En noviembre de 1966, Hewlett-Packard presentó la minicomputadora 2116A [24] [25] , una de las primeras computadoras comerciales de 16 bits. Utilizaba CTμL (Complementary Transistor MicroLogic) [26] en circuitos integrados de Fairchild Semiconductor . Hewlett-Packard siguió con computadoras de 16 bits similares, como la 2115A en 1967, [27] la 2114A en 1968, [28] y otras.

En 1969, Data General presentó el Nova y vendió un total de 50.000 a 8.000 dólares cada uno. La popularidad de los ordenadores de 16 bits, como la serie Hewlett-Packard 21xx y el Data General Nova, abrió el camino hacia longitudes de palabra que eran múltiplos del byte de 8 bits . El Nova fue el primero en emplear circuitos de integración a escala media (MSI) de Fairchild Semiconductor, y los modelos posteriores utilizaron circuitos integrados a gran escala (LSI). También era notable que todo el procesador central estuviera contenido en una placa de circuito impreso de 15 pulgadas .

Los grandes mainframes utilizaban circuitos integrados para aumentar las capacidades de almacenamiento y procesamiento. La familia de mainframes IBM System/360 de 1965 a veces se denomina ordenadores de tercera generación; sin embargo, su lógica consistía principalmente en circuitos híbridos SLT , que contenían transistores discretos y diodos interconectados en un sustrato con cables impresos y componentes pasivos impresos; los S/360 M85 y M91 sí utilizaban circuitos integrados para algunos de sus circuitos. El System/370 de IBM de 1971 utilizaba circuitos integrados para su lógica, y los modelos posteriores utilizaban memoria de semiconductores .

En 1971, la supercomputadora ILLIAC IV era la computadora más rápida del mundo y utilizaba alrededor de un cuarto de millón de circuitos integrados de puertas lógicas ECL de pequeña escala para formar sesenta y cuatro procesadores de datos paralelos. [29]

Las computadoras de tercera generación se ofrecieron hasta bien entrada la década de 1990; por ejemplo, la IBM ES9000 9X2 anunciada en abril de 1994 [30] utilizó 5.960 chips ECL para fabricar un procesador de 10 vías. [31] Otras computadoras de tercera generación ofrecidas en la década de 1990 incluyeron la DEC VAX 9000 (1989), construida a partir de matrices de puertas ECL y chips personalizados, [32] y la Cray T90 (1995).

Las minicomputadoras de tercera generación eran esencialmente versiones reducidas de las computadoras mainframe , mientras que los orígenes de la cuarta generación son fundamentalmente diferentes. [ aclaración necesaria ] La base de la cuarta generación es el microprocesador , un procesador de computadora contenido en un solo chip de circuito integrado MOS de integración a gran escala (LSI) . [33]

Los ordenadores basados en microprocesadores tenían en un principio una capacidad y una velocidad de cálculo muy limitadas y no pretendían en modo alguno reducir el tamaño de los miniordenadores, sino que se dirigían a un mercado completamente diferente.

La capacidad de procesamiento y de almacenamiento ha crecido más allá de todo reconocimiento desde la década de 1970, pero la tecnología subyacente se ha mantenido básicamente igual: microchips de integración a gran escala (LSI) o de integración a muy gran escala (VLSI), por lo que se considera ampliamente que la mayoría de las computadoras actuales todavía pertenecen a la cuarta generación.

.jpg/440px-C4004_(Intel).jpg)

El microprocesador tiene su origen en el chip de circuito integrado MOS (MOS IC). [33] El MOS IC fue fabricado por Fred Heiman y Steven Hofstein en RCA en 1962. [34] Debido al rápido escalamiento de los MOSFET , los chips MOS IC aumentaron rápidamente en complejidad a un ritmo predicho por la ley de Moore , lo que llevó a la integración a gran escala (LSI) con cientos de transistores en un solo chip MOS a fines de la década de 1960. La aplicación de chips MOS LSI a la computación fue la base de los primeros microprocesadores, ya que los ingenieros comenzaron a reconocer que un procesador de computadora completo podía estar contenido en un solo chip MOS LSI. [33]

Los primeros microprocesadores multichip fueron el Four-Phase Systems AL1 en 1969 y el Garrett AiResearch MP944 en 1970, cada uno de ellos utilizando varios chips MOS LSI. [33] El 15 de noviembre de 1971, Intel lanzó el primer microprocesador de un solo chip del mundo, el 4004 , en un solo chip MOS LSI. Su desarrollo fue dirigido por Federico Faggin , utilizando tecnología MOS de compuerta de silicio , junto con Ted Hoff , Stanley Mazor y Masatoshi Shima . [35] Fue desarrollado para una empresa japonesa de calculadoras llamada Busicom como una alternativa a los circuitos cableados, pero las computadoras se desarrollaron en torno a él, con gran parte de sus capacidades de procesamiento proporcionadas por un pequeño chip microprocesador. El chip de RAM dinámica (DRAM) se basó en la celda de memoria MOS DRAM desarrollada por Robert Dennard de IBM, que ofrece kilobits de memoria en un chip. Intel combinó el chip RAM con el microprocesador, lo que permitió que las computadoras de cuarta generación fueran más pequeñas y más rápidas que las computadoras anteriores. El 4004 solo podía procesar 60.000 instrucciones por segundo, pero sus sucesores aportaron una velocidad y una potencia cada vez mayores a las computadoras, incluidos los Intel 8008, 8080 (utilizados en muchas computadoras que utilizan el sistema operativo CP/M ) y la familia 8086/8088. (La computadora personal (PC) de IBM y las compatibles utilizan procesadores que aún son compatibles con el 8086). Otros fabricantes también fabricaron microprocesadores que se utilizaron ampliamente en microcomputadoras.

La siguiente tabla muestra una cronología del desarrollo significativo de microprocesadores.

Las supercomputadoras potentes de la época estaban en el otro extremo del espectro de la computación de las microcomputadoras , y también utilizaban tecnología de circuitos integrados. En 1976, Seymour Cray , que había dejado Control Data en 1972 para formar su propia empresa, desarrolló la Cray-1 . Esta máquina fue la primera supercomputadora que hizo práctico el procesamiento vectorial . Tenía una forma característica de herradura para acelerar el procesamiento acortando las rutas del circuito. El procesamiento vectorial utiliza una instrucción para realizar la misma operación en muchos argumentos; ha sido un método de procesamiento de supercomputadoras fundamental desde entonces. La Cray-1 podía calcular 150 millones de operaciones de punto flotante por segundo (150 megaflops ). Se enviaron 85 a un precio de 5 millones de dólares cada una. La Cray-1 tenía una CPU que estaba construida principalmente con circuitos integrados SSI y MSI ECL .

Antes de la introducción del microprocesador a principios de los años 70, las computadoras eran sistemas grandes y costosos que pertenecían a grandes instituciones (corporaciones, universidades, agencias gubernamentales, etc.). Los usuarios eran especialistas experimentados que no solían interactuar con la máquina en sí, sino que preparaban tareas para la computadora en equipos fuera de línea, como perforadoras de tarjetas . Se reunían varias tareas para la computadora y se procesaban en modo por lotes . Una vez finalizados los trabajos, los usuarios podían recoger las impresiones de salida y las tarjetas perforadas. En algunas organizaciones, podían pasar horas o días entre el envío de un trabajo al centro de cómputo y la recepción del resultado.

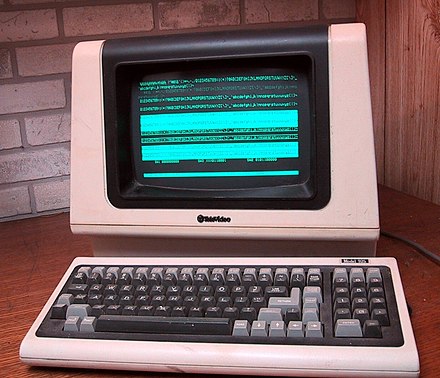

A mediados de los años 1960 se desarrolló comercialmente una forma más interactiva de uso de la computadora. En un sistema de tiempo compartido , múltiples terminales de teleimpresora y pantalla permitían que muchas personas compartieran el uso de un procesador de computadora central , y el sistema operativo asignaba franjas de tiempo a las tareas de cada usuario. Esto era común en aplicaciones comerciales y en ciencia e ingeniería.

Un modelo diferente de uso de la computadora fue prefigurado por la forma en que se usaron las primeras computadoras experimentales precomerciales, donde un usuario tenía uso exclusivo de un procesador. [36] Algunas de las primeras computadoras que podrían llamarse "personales" fueron las primeras minicomputadoras como la LINC y la PDP-8 , y más tarde las VAX y las minicomputadoras más grandes de Digital Equipment Corporation (DEC), Data General , Prime Computer y otras. Se originaron como procesadores periféricos para computadoras mainframe, asumiendo algunas tareas rutinarias y liberando el procesador para el cálculo.

Según los estándares actuales, eran físicamente grandes (aproximadamente del tamaño de un refrigerador) y costosas (normalmente decenas de miles de dólares estadounidenses ), por lo que rara vez las compraban los particulares. Sin embargo, eran mucho más pequeñas, menos costosas y, en general, más sencillas de utilizar que las computadoras mainframe de la época, por lo que eran asequibles para laboratorios individuales y proyectos de investigación. Las minicomputadoras liberaron en gran medida a estas organizaciones del procesamiento por lotes y la burocracia de un centro de cómputo comercial o universitario.

Además, las minicomputadoras eran más interactivas que las mainframes, y pronto tuvieron sus propios sistemas operativos . La minicomputadora Xerox Alto (1973) fue un paso histórico en el desarrollo de las computadoras personales, debido a su interfaz gráfica de usuario , pantalla de mapa de bits de alta resolución, gran almacenamiento de memoria interna y externa, mouse y software especial. [37]

En los miniordenadores, antecesores de los ordenadores personales modernos, el procesamiento se llevaba a cabo mediante circuitos con un gran número de componentes dispuestos en múltiples placas de circuito impreso de gran tamaño . Por consiguiente, los miniordenadores eran físicamente grandes y caros de producir en comparación con los sistemas de microprocesadores posteriores. Después de que se comercializara el "ordenador en un chip", el coste de producción de un sistema informático se redujo drásticamente. Las funciones aritméticas, lógicas y de control que antes ocupaban varias placas de circuito costosas ahora estaban disponibles en un circuito integrado que era muy caro de diseñar pero barato de producir en grandes cantidades. Al mismo tiempo, los avances en el desarrollo de la memoria de estado sólido eliminaron la memoria de núcleo magnético, voluminosa, costosa y de alto consumo de energía que se utilizaba en generaciones anteriores de ordenadores.

En Francia, la empresa R2E (Réalisations et Etudes Electroniques) formada por cinco antiguos ingenieros de la empresa Intertechnique , André Truong Trong Thi [38] [39] y François Gernelle [40] presentó en febrero de 1973 un microordenador, el Micral N basado en el Intel 8008. [ 41] Originalmente, el ordenador había sido diseñado por Gernelle, Lacombe, Beckmann y Benchitrite para el Institut National de la Recherche Agronomique para automatizar las mediciones higrométricas. [42] [43] El Micral N costaba una quinta parte del precio de un PDP-8 , unos 8500FF (1300 dólares). El reloj del Intel 8008 estaba fijado en 500 kHz, la memoria era de 16 kilobytes. Se introdujo un bus, llamado Pluribus, que permitía la conexión de hasta 14 placas. R2E disponía de diferentes placas para E/S digital, E/S analógica, memoria y disquetes.

El desarrollo del microprocesador de un solo chip fue un enorme catalizador para la popularización de computadoras baratas, fáciles de usar y verdaderamente personales. El Altair 8800 , presentado en un artículo de la revista Popular Electronics en el número de enero de 1975, en ese momento estableció un nuevo punto de precio bajo para una computadora, llevando la posesión de computadoras a un mercado ciertamente selecto en la década de 1970. A este le siguió el ordenador IMSAI 8080 , con capacidades y limitaciones similares. El Altair y el IMSAI eran esencialmente minicomputadoras a escala reducida e incompletas: para conectarles un teclado o un teleimpresor se necesitaban "periféricos" pesados y costosos. Ambas máquinas presentaban un panel frontal con interruptores y luces, que se comunicaban con el operador en binario . Para programar la máquina después de encenderla, el programa de carga de arranque tenía que introducirse, sin errores, en binario, y luego una cinta de papel que contenía un intérprete BASIC cargado desde un lector de cinta de papel. Para activar el cargador era necesario subir o bajar un conjunto de ocho interruptores y pulsar el botón de "carga", una vez por cada byte del programa, que normalmente tenía cientos de bytes de longitud. La computadora podía ejecutar programas BASIC una vez que se había cargado el intérprete.

El MITS Altair , el primer kit de microprocesador que tuvo éxito comercial, apareció en la portada de la revista Popular Electronics en enero de 1975. Fue el primer kit de computadora personal producido en masa del mundo, así como la primera computadora en utilizar un procesador Intel 8080. Fue un éxito comercial, con 10.000 Altairs enviados. El Altair también inspiró los esfuerzos de desarrollo de software de Paul Allen y su amigo de la escuela secundaria Bill Gates, quienes desarrollaron un intérprete BASIC para el Altair y luego formaron Microsoft .

El MITS Altair 8800 creó efectivamente una nueva industria de microcomputadoras y kits de computadoras, a la que le siguieron muchas otras, como una ola de computadoras para pequeñas empresas a fines de la década de 1970 basadas en los chips de microprocesador Intel 8080, Zilog Z80 e Intel 8085. La mayoría ejecutaba el sistema operativo CP/M - 80 desarrollado por Gary Kildall en Digital Research . CP/M-80 fue el primer sistema operativo de microcomputadoras popular que fue utilizado por muchos proveedores de hardware diferentes, y se escribieron muchos paquetes de software para él, como WordStar y dBase II.

A mediados de los años 70, muchos aficionados diseñaron sus propios sistemas, con distintos grados de éxito, y a veces se agruparon para facilitar el trabajo. De estas reuniones caseras surgió el Homebrew Computer Club , donde los aficionados se reunían para hablar de lo que habían hecho, intercambiar esquemas y software y demostrar sus sistemas. Mucha gente construyó o montó sus propios ordenadores siguiendo diseños publicados. Por ejemplo, muchos miles de personas construyeron el ordenador doméstico Galaksija a principios de los años 80.

El Altair fue influyente. Llegó antes que Apple Computer , así como Microsoft , que produjo y vendió el intérprete del lenguaje de programación BASIC Altair , el primer producto de Microsoft. La segunda generación de microcomputadoras , las que aparecieron a fines de la década de 1970, impulsadas por la demanda inesperada de computadoras en kit en los clubes de aficionados a la electrónica, generalmente se conocían como computadoras domésticas . Para uso comercial, estos sistemas eran menos capaces y, en algunos aspectos, menos versátiles que las grandes computadoras comerciales de la época. Fueron diseñadas para fines lúdicos y educativos, no tanto para uso práctico. Y aunque se podían usar algunas aplicaciones simples de oficina o productividad en ellas, generalmente los entusiastas de la computadora los usaban para aprender a programar y para ejecutar juegos de computadora, para lo cual las computadoras personales de la época eran menos adecuadas y demasiado caras. Para los aficionados más técnicos, las computadoras domésticas también se usaban para interactuar electrónicamente con dispositivos externos, como controlar trenes en miniatura y otras actividades de pasatiempos en general.

.jpg/440px-Home_or_Personal_Computers_from_1977_-_Commodore_PET_2001,_Apple_II,_TRS-80_Model_I,_together_called_'Trinity77'_(edited_image).jpg)

La llegada del microprocesador y la memoria de estado sólido hizo que la informática doméstica fuera asequible. Los primeros sistemas de microcomputadoras para aficionados, como el Altair 8800 y el Apple I , introducidos alrededor de 1975, marcaron el lanzamiento de chips procesadores de 8 bits de bajo coste, que tenían suficiente potencia informática para ser de interés para los usuarios aficionados y experimentales. En 1977, los sistemas preensamblados como el Apple II , el Commodore PET y el TRS-80 (posteriormente denominado "Trinidad de 1977" por la revista Byte ) [44] iniciaron la era de las computadoras domésticas de mercado masivo ; se requería mucho menos esfuerzo para obtener una computadora operativa, y las aplicaciones como juegos, procesamiento de textos y hojas de cálculo comenzaron a proliferar. A diferencia de las computadoras utilizadas en los hogares, los sistemas para pequeñas empresas se basaban típicamente en CP/M , hasta que IBM introdujo el IBM PC , que fue adoptado rápidamente. El PC fue clonado en gran medida , lo que llevó a la producción en masa y la consiguiente reducción de costos a lo largo de la década de 1980. Esto amplió la presencia de la PC en los hogares, reemplazando la categoría de computadora doméstica durante la década de 1990 y dando lugar a la monocultura actual de computadoras personales arquitectónicamente idénticas.

{{cite book}}: CS1 maint: others (link)