La neurociencia de la música es el estudio científico de los mecanismos cerebrales implicados en los procesos cognitivos que subyacen a la música . Estos comportamientos incluyen escuchar música , interpretar , componer , leer, escribir y actividades complementarias. También se interesa cada vez más por la base cerebral de la estética y la emoción musicales. Los científicos que trabajan en este campo pueden tener formación en neurociencia cognitiva, neurología , neuroanatomía , psicología , teoría musical , informática y otros campos relevantes.

La neurociencia cognitiva de la música representa una rama importante de la psicología musical y se distingue de campos relacionados, como la musicología cognitiva, por su dependencia de observaciones directas del cerebro y el uso de técnicas de imágenes cerebrales como la resonancia magnética funcional (fMRI) y la tomografía por emisión de positrones (PET).

Los sonidos consisten en ondas de moléculas de aire que vibran a diferentes frecuencias. Estas ondas viajan hasta la membrana basilar en la cóclea del oído interno. Diferentes frecuencias de sonido causarán vibraciones en diferentes lugares de la membrana basilar. Podemos escuchar diferentes tonos porque cada onda de sonido con una frecuencia única está correlacionada con una ubicación diferente a lo largo de la membrana basilar. Esta disposición espacial de los sonidos y sus respectivas frecuencias que se procesan en la membrana basilar se conoce como tonotopía . Cuando las células ciliadas de la membrana basilar se mueven hacia adelante y hacia atrás debido a las ondas sonoras vibrantes, liberan neurotransmisores y hacen que se produzcan potenciales de acción a lo largo del nervio auditivo . El nervio auditivo luego conduce a varias capas de sinapsis en numerosos grupos de neuronas, o núcleos , en el tronco encefálico auditivo . Estos núcleos también están organizados tonotópicamente, y el proceso de lograr esta tonotopía después de la cóclea no se entiende bien. [1] Esta tonotopía en general se mantiene hasta la corteza auditiva primaria en los mamíferos . [2]

Un mecanismo ampliamente postulado para el procesamiento del tono en el sistema auditivo central temprano es el bloqueo de fase y bloqueo de modo de los potenciales de acción a las frecuencias en un estímulo. El bloqueo de fase a las frecuencias del estímulo se ha demostrado en el nervio auditivo, [3] [4] el núcleo coclear , [3] [5] el colículo inferior , [6] y el tálamo auditivo . [7] Al bloquear la fase y el modo de esta manera, se sabe que el tronco encefálico auditivo preserva una buena parte de la información de frecuencia temporal y de paso bajo del sonido original; esto es evidente midiendo la respuesta del tronco encefálico auditivo usando EEG . [8] Esta preservación temporal es una forma de argumentar directamente a favor de la teoría temporal de la percepción del tono y de argumentar indirectamente en contra de la teoría del lugar de la percepción del tono.

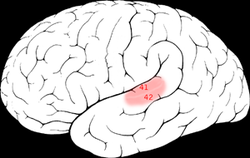

La corteza auditiva secundaria derecha tiene una resolución de tono más fina que la izquierda. Hyde, Peretz y Zatorre (2008) utilizaron imágenes por resonancia magnética funcional (fMRI) en su estudio para probar la participación de las regiones corticales auditivas derecha e izquierda en el procesamiento de frecuencia de secuencias melódicas. [9] Además de encontrar una resolución de tono superior en la corteza auditiva secundaria derecha, las áreas específicas que se encontraron involucradas fueron el plano temporal (PT) en la corteza auditiva secundaria y la corteza auditiva primaria en la sección medial del giro de Heschl (HG).

Muchos estudios de neuroimagen han encontrado evidencia de la importancia de las regiones auditivas secundarias derechas en aspectos del procesamiento del tono musical, como la melodía. [10] Muchos de estos estudios, como uno de Patterson, Uppenkamp, Johnsrude y Griffiths (2002), también encuentran evidencia de una jerarquía del procesamiento del tono. Patterson et al. (2002) utilizaron sonidos espectralmente coincidentes que produjeron: sin tono, tono fijo o melodía en un estudio de fMRI y encontraron que todas las condiciones activaron HG y PT. Los sonidos con tono activaron más de estas regiones que los sonidos sin él. Cuando se produjo una melodía, la activación se extendió al giro temporal superior (STG) y al plano polar (PP). Estos resultados respaldan la existencia de una jerarquía de procesamiento del tono.

El oído absoluto (PA) se define como la capacidad de identificar el tono de un tono musical o de producir un tono musical en un tono dado sin el uso de un tono de referencia externo. [11] [12] La investigación neurocientífica no ha descubierto un patrón de activación distintivo común para los poseedores de PA. Zatorre, Perry, Beckett, Westbury y Evans (1998) examinaron las bases neuronales del PA utilizando técnicas de imágenes cerebrales funcionales y estructurales. [13] La tomografía por emisión de positrones (PET) se utilizó para medir el flujo sanguíneo cerebral (FSC) en músicos que poseían PA y músicos que carecían de PA. Cuando se presentaron tonos musicales, surgieron patrones similares de aumento del FSC en las áreas corticales auditivas en ambos grupos. Los poseedores de PA y los sujetos sin PA demostraron patrones similares de actividad frontal dorsolateral izquierda cuando realizaron juicios de tono relativo. Sin embargo, en los sujetos sin PA, la activación en la corteza frontal inferior derecha estaba presente, mientras que los poseedores de PA no mostraron tal actividad. Este hallazgo sugiere que los músicos con PA no necesitan acceso a dispositivos de memoria de trabajo para tales tareas. Estos hallazgos implican que no existe un patrón de activación regional específico exclusivo de la PA, sino que la disponibilidad de mecanismos de procesamiento específicos y las demandas de la tarea determinan las áreas neuronales reclutadas.

Los estudios sugieren que las personas son capaces de detectar automáticamente una diferencia o anomalía en una melodía , como un tono desafinado que no encaja con su experiencia musical previa. Este procesamiento automático ocurre en la corteza auditiva secundaria. Brattico, Tervaniemi, Naatanen y Peretz (2006) realizaron un estudio de este tipo para determinar si la detección de tonos que no se ajustan a las expectativas de un individuo puede ocurrir automáticamente. [14] Registraron potenciales relacionados con eventos (ERP) en no músicos a medida que se les presentaban melodías desconocidas con un tono desafinado o un tono desafinado mientras los participantes estaban distraídos de los sonidos o prestaban atención a la melodía. Ambas condiciones revelaron una negatividad frontal temprana relacionada con el error independientemente de dónde se dirigiera la atención. Esta negatividad se originó en la corteza auditiva, más precisamente en el lóbulo supratemporal (que corresponde a la corteza auditiva secundaria) con mayor actividad del hemisferio derecho. La respuesta de negatividad fue mayor para el tono desafinado que para el desafinado. Las calificaciones de incongruencia musical fueron más altas para las melodías desafinadas que para las desafinadas. En la condición de atención enfocada, las melodías desafinadas y desafinadas produjeron positividad parietal tardía. Los hallazgos de Brattico et al. (2006) sugieren que hay un procesamiento automático y rápido de las propiedades melódicas en la corteza auditiva secundaria. [14] Los hallazgos de que las incongruencias de tono se detectaron automáticamente, incluso al procesar melodías desconocidas, sugieren que hay una comparación automática de la información entrante con el conocimiento a largo plazo de las propiedades de la escala musical, como las reglas de propiedades musicales influidas culturalmente (progresiones de acordes comunes, patrones de escala, etc.) y las expectativas individuales de cómo debe proceder la melodía.

Las áreas de cinturón y paracinto del hemisferio derecho están involucradas en el procesamiento del ritmo . [15] El ritmo es un patrón fuerte y repetido de movimiento o sonido. Cuando las personas se preparan para marcar un ritmo de intervalos regulares (1:2 o 1:3), se activan la corteza frontal izquierda , la corteza parietal izquierda y el cerebelo derecho . Con ritmos más difíciles, como 1:2.5, se involucran más áreas en la corteza cerebral y el cerebelo. [16] Los registros de EEG también han demostrado una relación entre la actividad eléctrica cerebral y la percepción del ritmo. Snyder y Large (2005) [17] realizaron un estudio que examinó la percepción del ritmo en sujetos humanos y encontraron que la actividad en la banda gamma (20 - 60 Hz) corresponde a los latidos de un ritmo simple. Snyder y Large encontraron dos tipos de actividad gamma: actividad gamma inducida y actividad gamma evocada . La actividad gamma evocada se encontró después del inicio de cada tono en el ritmo; Se encontró que esta actividad estaba sincronizada (los picos y valles estaban directamente relacionados con el inicio exacto del tono) y no aparecía cuando había una brecha (un latido perdido) en el ritmo. La actividad gamma inducida, que no se encontró sincronizada, también se encontró que correspondía con cada latido. Sin embargo, la actividad gamma inducida no disminuyó cuando había una brecha en el ritmo, lo que indica que la actividad gamma inducida posiblemente pueda servir como una especie de metrónomo interno independiente de la entrada auditiva.

La tonalidad describe las relaciones entre los elementos de la melodía y la armonía : tonos, intervalos , acordes y escalas . Estas relaciones suelen caracterizarse como jerárquicas, de modo que uno de los elementos domina o atrae a otro. Se producen tanto dentro como entre cada tipo de elemento, creando una percepción rica y variable en el tiempo entre los tonos y sus contextos melódicos, armónicos y cromáticos . En un sentido convencional, la tonalidad se refiere solo a los tipos de escala mayor y menor : ejemplos de escalas cuyos elementos son capaces de mantener un conjunto consistente de relaciones funcionales. La relación funcional más importante es la de la nota tónica (la primera nota de una escala) y el acorde tónico (la primera nota de la escala con la tercera y la quinta nota) con el resto de la escala. La tónica es el elemento que tiende a afirmar su dominio y atracción sobre todos los demás, y funciona como el punto último de atracción, descanso y resolución de la escala. [18]

La corteza auditiva derecha está principalmente involucrada en la percepción del tono y partes de la armonía, la melodía y el ritmo. [16] Un estudio de Petr Janata encontró que hay áreas sensibles a la tonalidad en la corteza prefrontal medial , el cerebelo , los surcos temporales superiores de ambos hemisferios y los giros temporales superiores (que tienen un sesgo hacia el hemisferio derecho). [19] Se han demostrado asimetrías hemisféricas en el procesamiento de sonidos disonantes/consonantes. Los estudios de ERP han mostrado respuestas evocadas más grandes sobre el área temporal izquierda en respuesta a acordes disonantes, y sobre la derecha, en respuesta a acordes consonantes. [20]

La interpretación musical suele implicar al menos tres funciones de control motor elementales: sincronización, secuenciación y organización espacial de los movimientos motores. La precisión en la sincronización de los movimientos está relacionada con el ritmo musical. El ritmo, el patrón de intervalos temporales dentro de una medida o frase musical , a su vez crea la percepción de pulsos más fuertes y más débiles. [21] La secuenciación y la organización espacial se relacionan con la expresión de notas individuales en un instrumento musical .

Estas funciones y sus mecanismos neuronales se han investigado por separado en muchos estudios, pero se sabe poco sobre su interacción combinada para producir una interpretación musical compleja. [21] El estudio de la música requiere examinarlos juntos.

Aunque los mecanismos neuronales implicados en el cronometraje del movimiento se han estudiado rigurosamente durante los últimos 20 años, aún hay mucha controversia al respecto. La capacidad de expresar movimientos en tiempo preciso se ha atribuido a un metrónomo neuronal o mecanismo de reloj donde el tiempo se representa a través de oscilaciones o pulsos. [22] [23] [24] [25] También se ha planteado una visión opuesta a este mecanismo de metrónomo, que afirma que es una propiedad emergente de la cinemática del movimiento en sí. [24] [25] [26] La cinemática se define como los parámetros del movimiento a través del espacio sin referencia a fuerzas (por ejemplo, dirección, velocidad y aceleración). [21]

Los estudios de neuroimagen funcional , así como los estudios de pacientes con daño cerebral, han vinculado la sincronización del movimiento a varias regiones corticales y subcorticales, incluido el cerebelo , los ganglios basales y el área motora suplementaria (AMS). [21] Específicamente, los ganglios basales y posiblemente el AMS han sido implicados en la sincronización de intervalos en escalas de tiempo más largas (1 segundo y más), mientras que el cerebelo puede ser más importante para controlar la sincronización motora en escalas de tiempo más cortas (milisegundos). [22] [27] Además, estos resultados indican que la sincronización motora no está controlada por una sola región cerebral, sino por una red de regiones que controlan parámetros específicos del movimiento y que dependen de la escala de tiempo relevante de la secuencia rítmica. [21]

La secuenciación motora se ha explorado en términos de la ordenación de movimientos individuales, como las secuencias de dedos para pulsar teclas, o la coordinación de subcomponentes de movimientos complejos de múltiples articulaciones. [21] En este proceso están implicadas varias regiones corticales y subcorticales, incluidos los ganglios basales, la AMS y la pre-AMS, el cerebelo y las cortezas premotora y prefrontal, todas involucradas en la producción y aprendizaje de secuencias motoras pero sin evidencia explícita de sus contribuciones específicas o interacciones entre sí. [21] En animales, los estudios neurofisiológicos han demostrado una interacción entre la corteza frontal y los ganglios basales durante el aprendizaje de secuencias de movimiento. [28] Los estudios de neuroimagen humana también han enfatizado la contribución de los ganglios basales para secuencias bien aprendidas. [29]

Se puede decir que el cerebelo es importante para el aprendizaje de secuencias y para la integración de movimientos individuales en secuencias unificadas, [29] [30] [31] [32] [33] mientras que se ha demostrado que la pre-AMS y la AMS están involucradas en la organización o fragmentación de secuencias de movimientos más complejas. [34] [35] Se cree que la fragmentación, definida como la reorganización o reagrupación de secuencias de movimientos en subsecuencias más pequeñas durante la ejecución, facilita la ejecución fluida de movimientos complejos y mejora la memoria motora . [21] Por último, se ha demostrado que la corteza premotora está involucrada en tareas que requieren la producción de secuencias relativamente complejas y puede contribuir a la predicción motora. [36] [37]

Pocos estudios sobre el control motor complejo han distinguido entre la organización secuencial y espacial, pero las interpretaciones musicales expertas exigen no solo una secuenciación precisa, sino también una organización espacial de los movimientos. Estudios en animales y humanos han establecido la participación de las cortezas parietal , sensoriomotora y premotora en el control de los movimientos, cuando se requiere la integración de información espacial, sensorial y motora. [38] [39] Hasta ahora, pocos estudios han examinado explícitamente el papel del procesamiento espacial en el contexto de las tareas musicales.

Una interacción auditiva-motora puede definirse de manera general como cualquier interacción o comunicación entre los dos sistemas. Dos clases de interacción auditiva-motora son la "feedforward" y la "feedback". [21] En las interacciones de "feedforward", es el sistema auditivo el que influye predominantemente en la salida motora, a menudo de manera predictiva. [40] Un ejemplo es el fenómeno de tocar el ritmo, donde el oyente anticipa los acentos rítmicos en una pieza musical. Otro ejemplo es el efecto de la música en los trastornos del movimiento: se ha demostrado que los estímulos auditivos rítmicos mejoran la capacidad de caminar en pacientes con enfermedad de Parkinson y accidente cerebrovascular . [41] [42]

Las interacciones de retroalimentación son particularmente relevantes al tocar un instrumento como el violín, o al cantar, donde el tono es variable y debe controlarse continuamente. Si se bloquea la retroalimentación auditiva, los músicos pueden seguir ejecutando piezas bien ensayadas, pero se ven afectados los aspectos expresivos de la interpretación. [43] Cuando la retroalimentación auditiva se manipula experimentalmente mediante retrasos o distorsiones, [44] el rendimiento motor se altera significativamente: la retroalimentación asincrónica altera la sincronización de los eventos, mientras que la alteración de la información del tono altera la selección de acciones apropiadas, pero no su sincronización. Esto sugiere que las interrupciones ocurren porque tanto las acciones como las percepciones dependen de una única representación mental subyacente. [21]

Se han propuesto varios modelos de interacciones auditivas-motoras. El modelo de Hickok y Poeppel [45] , que es específico para el procesamiento del habla, propone que una corriente auditiva ventral asigna los sonidos al significado, mientras que una corriente dorsal asigna los sonidos a representaciones articulatorias. Ellos y otros [46] sugieren que las regiones auditivas posteriores en el límite parietotemporal son partes cruciales de la interfaz auditiva-motora, asignando representaciones auditivas a representaciones motoras del habla y a melodías. [47]

El sistema de neuronas espejo tiene un papel importante en los modelos neuronales de integración sensomotora. Hay evidencia considerable de que las neuronas responden tanto a las acciones como a la observación acumulada de acciones. Un sistema propuesto para explicar esta comprensión de las acciones es que las representaciones visuales de las acciones se mapean en nuestro propio sistema motor. [48]

Algunas neuronas espejo se activan tanto por la observación de acciones dirigidas a un objetivo como por los sonidos asociados producidos durante la acción. Esto sugiere que la modalidad auditiva puede acceder al sistema motor. [49] [50] Si bien estas interacciones auditivo-motoras se han estudiado principalmente para los procesos del habla y se han centrado en el área de Broca y la vPMC, a partir de 2011, los experimentos han comenzado a arrojar luz sobre cómo estas interacciones son necesarias para la interpretación musical. Los resultados apuntan a una participación más amplia de la dPMC y otras áreas motoras. [21] La literatura ha demostrado una red cortical altamente especializada en el cerebro del músico experto que codifica la relación entre los gestos musicales y sus sonidos correspondientes. Los datos apuntan a la existencia de una red espejo audiomotora que involucra el giro temporal superior derecho, la corteza premotora, las áreas frontal inferior y parietal inferior, entre otras áreas. [51]

Se ha demostrado que ciertos aspectos del lenguaje y la melodía se procesan en áreas funcionales cerebrales casi idénticas. Brown, Martínez y Parsons (2006) examinaron las similitudes estructurales neurológicas entre la música y el lenguaje. [52] Utilizando la tomografía por emisión de positrones (PET), los hallazgos mostraron que tanto las frases lingüísticas como las melódicas produjeron activación en áreas funcionales cerebrales casi idénticas. Estas áreas incluían la corteza motora primaria , el área motora suplementaria , el área de Broca , la ínsula anterior, las cortezas auditivas primaria y secundaria, el polo temporal, los ganglios basales , el tálamo ventral y el cerebelo posterior . Se encontraron diferencias en las tendencias de lateralización ya que las tareas del lenguaje favorecían el hemisferio izquierdo, pero la mayoría de las activaciones eran bilaterales, lo que producía una superposición significativa entre las modalidades. [52]

Se ha demostrado que los mecanismos de información sintáctica tanto en la música como en el lenguaje se procesan de manera similar en el cerebro. Jentschke, Koelsch, Sallat y Friederici (2008) llevaron a cabo un estudio que investigaba el procesamiento de la música en niños con trastornos específicos del lenguaje (TEL). [53] Los niños con un desarrollo típico del lenguaje (TLD) mostraron patrones de ERP diferentes a los de los niños con TEL, lo que reflejaba sus dificultades para procesar regularidades sintácticas musicales. Las fuertes correlaciones entre la amplitud de la ERAN ( negatividad anterior derecha temprana , una medida específica de ERP) y las habilidades lingüísticas y musicales proporcionan evidencia adicional de la relación del procesamiento sintáctico en la música y el lenguaje. [53]

Sin embargo, la producción de melodía y la producción de habla pueden estar respaldadas por diferentes redes neuronales. Stewart, Walsh, Frith y Rothwell (2001) estudiaron las diferencias entre la producción de habla y la producción de canciones utilizando estimulación magnética transcraneal (TMS). [54] Stewart et al. descubrieron que la TMS aplicada al lóbulo frontal izquierdo altera el habla pero no la melodía, lo que respalda la idea de que están respaldadas por diferentes áreas del cerebro. Los autores sugieren que una razón para la diferencia es que la generación del habla puede localizarse bien, pero los mecanismos subyacentes de la producción melódica no. Alternativamente, también se sugirió que la producción del habla puede ser menos robusta que la producción melódica y, por lo tanto, más susceptible a la interferencia. [54]

El procesamiento del lenguaje es una función más del lado izquierdo del cerebro que del lado derecho, en particular del área de Broca y del área de Wernicke , aunque todavía no está claro el papel que desempeñan ambos lados del cerebro en el procesamiento de diferentes aspectos del lenguaje. La música también es procesada tanto por el lado izquierdo como por el derecho del cerebro. [52] [55] Evidencias recientes sugieren además un procesamiento compartido entre el lenguaje y la música a nivel conceptual. [56] También se ha descubierto que, entre los estudiantes de conservatorio de música, la prevalencia del oído absoluto es mucho mayor para los hablantes de lengua tonal, incluso controlando el origen étnico, lo que demuestra que el lenguaje influye en cómo se perciben los tonos musicales. [57] [58]

La estructura cerebral de los músicos y los no músicos es claramente diferente. Gaser y Schlaug (2003) compararon las estructuras cerebrales de músicos profesionales con las de no músicos y descubrieron diferencias en el volumen de materia gris en las regiones cerebrales motora, auditiva y visoespacial. [59] En concreto, se descubrieron correlaciones positivas entre el estatus de músico (profesional, aficionado y no músico) y el volumen de materia gris en las áreas motora primaria y somatosensorial , áreas premotoras , áreas parietales superiores anteriores y en el giro temporal inferior bilateralmente. Esta fuerte asociación entre el estatus de músico y las diferencias de materia gris apoya la noción de que los cerebros de los músicos muestran cambios estructurales dependientes del uso. [60] Debido a las claras diferencias en varias regiones cerebrales, es poco probable que estas diferencias sean innatas, sino más bien debidas a la adquisición a largo plazo y al ensayo repetitivo de habilidades musicales.

Los cerebros de los músicos también muestran diferencias funcionales con respecto a los de los no músicos. Krings, Topper, Foltys, Erberich, Sparing, Willmes y Thron (2000) utilizaron fMRI para estudiar la participación del área cerebral de pianistas profesionales y un grupo de control mientras realizaban movimientos complejos de los dedos. [61] Krings et al. encontraron que los pianistas profesionales mostraron niveles más bajos de activación cortical en áreas motoras del cerebro. Se concluyó que una menor cantidad de neuronas necesitaba ser activada para los pianistas debido a la práctica motora a largo plazo que da como resultado diferentes patrones de activación cortical. Koeneke, Lutz, Wustenberg y Jancke (2004) informaron hallazgos similares en teclistas. [62] Los teclistas expertos y un grupo de control realizaron tareas complejas que involucraban movimientos unimanuales y bimanuales de los dedos. Durante las condiciones de la tarea, tanto los no músicos como los teclistas mostraron fuertes respuestas hemodinámicas en el cerebelo, pero los no músicos mostraron la respuesta más fuerte. Este hallazgo indica que la práctica motora a largo plazo genera diferentes patrones de activación cortical. Esta evidencia respalda datos anteriores que muestran que los músicos necesitan menos neuronas para realizar los mismos movimientos.

Se ha demostrado que los músicos tienen un plano temporal izquierdo significativamente más desarrollado y también han demostrado tener una mayor memoria de palabras. [63] El estudio de Chan controló la edad, el promedio de calificaciones y los años de educación y encontró que cuando se les dio una prueba de memoria de 16 palabras, los músicos promediaron una o dos palabras más que sus contrapartes no musicales.

Los estudios han demostrado que el cerebro humano tiene una habilidad musical implícita. [64] [65] Koelsch, Gunter, Friederici y Schoger (2000) investigaron la influencia del contexto musical precedente, la relevancia de la tarea de acordes inesperados y el grado de probabilidad de violación en el procesamiento musical tanto en músicos como en no músicos. [64] Los hallazgos mostraron que el cerebro humano extrapola involuntariamente expectativas sobre la entrada auditiva inminente. Incluso en los no músicos, las expectativas extrapoladas son consistentes con la teoría musical. La capacidad de procesar información musicalmente apoya la idea de una habilidad musical implícita en el cerebro humano. En un estudio de seguimiento, Koelsch, Schroger y Gunter (2002) investigaron si ERAN y N5 podrían evocarse preatentivamente en no músicos. [65] Los hallazgos mostraron que tanto ERAN como N5 pueden ser provocados incluso en una situación donde el estímulo musical es ignorado por el oyente, lo que indica que hay una musicalidad preatentiva altamente diferenciada en el cerebro humano.

Existen pequeñas diferencias neurológicas en cuanto al procesamiento hemisférico entre los cerebros de hombres y mujeres. Koelsch, Maess, Grossmann y Friederici (2003) investigaron el procesamiento musical a través de EEG y ERP y descubrieron diferencias de género. [66] Los hallazgos mostraron que las mujeres procesan la información musical de forma bilateral y los hombres procesan la música con un predominio del hemisferio derecho. Sin embargo, la negatividad temprana de los hombres también estaba presente en el hemisferio izquierdo. Esto indica que los hombres no utilizan exclusivamente el hemisferio derecho para el procesamiento de la información musical. En un estudio de seguimiento, Koelsch, Grossman, Gunter, Hahne, Schroger y Friederici (2003) encontraron que los niños muestran lateralización de la negatividad anterior temprana en el hemisferio izquierdo, pero encontraron un efecto bilateral en las niñas. [67] Esto indica un efecto de desarrollo, ya que la negatividad temprana se lateraliza en el hemisferio derecho en los hombres y en el hemisferio izquierdo en los niños.

Se ha descubierto que los sujetos zurdos, en particular los que también son ambidiestros, tienen un mejor rendimiento que los diestros en la memoria a corto plazo para el tono. [68] [69] Se planteó la hipótesis de que esta ventaja de la lateralidad se debe al hecho de que los zurdos tienen más duplicación de almacenamiento en los dos hemisferios que los diestros. Otros trabajos han demostrado que existen diferencias pronunciadas entre diestros y zurdos (sobre una base estadística) en cómo se perciben los patrones musicales, cuando los sonidos provienen de diferentes regiones del espacio. Esto se ha encontrado, por ejemplo, en la ilusión de la octava [70] [71] y la ilusión de la escala . [72] [73]

La imaginería musical se refiere a la experiencia de reproducir música imaginándola dentro de la cabeza. [74] Los músicos muestran una capacidad superior para la imaginería musical debido a un entrenamiento musical intenso. [75] Herholz, Lappe, Knief y Pantev (2008) investigaron las diferencias en el procesamiento neuronal de una tarea de imaginería musical en músicos y no músicos. Utilizando magnetoencefalografía (MEG), Herholz et al. examinaron las diferencias en el procesamiento de una tarea de imaginería musical con melodías familiares en músicos y no músicos. Específicamente, el estudio examinó si la negatividad de desajuste (MMN) puede basarse únicamente en la imaginería de sonidos. La tarea implicó que los participantes escucharan el comienzo de una melodía, la continuación de la melodía en su cabeza y finalmente escucharan un tono correcto/incorrecto como continuación de la melodía. La imaginería de estas melodías fue lo suficientemente fuerte como para obtener una respuesta cerebral preatentiva temprana a violaciones imprevistas de las melodías imaginadas en los músicos. Estos resultados indican que se utilizan correlaciones neuronales similares para la imaginación y la percepción de los músicos entrenados. Además, los hallazgos sugieren que la modificación de la negatividad de la falta de correspondencia entre imágenes (iMMN) mediante un entrenamiento musical intenso da como resultado el logro de una capacidad superior para la imaginación y el procesamiento preatencional de la música.

Los procesos perceptivos musicales y la imaginería musical pueden compartir un sustrato neuronal en el cerebro. Un estudio PET realizado por Zatorre, Halpern, Perry, Meyer y Evans (1996) investigó los cambios en el flujo sanguíneo cerebral (FSC) relacionados con la imaginería auditiva y las tareas perceptivas. [76] Estas tareas examinaron la participación de regiones anatómicas particulares, así como las similitudes funcionales entre los procesos perceptivos y la imaginería. Patrones similares de cambios en el FSC proporcionaron evidencia que respalda la noción de que los procesos de imaginería comparten un sustrato neuronal sustancial con los procesos perceptivos relacionados. La actividad neuronal bilateral en la corteza auditiva secundaria se asoció tanto con la percepción como con la imaginación de canciones. Esto implica que dentro de la corteza auditiva secundaria, los procesos subyacen a la impresión fenomenológica de los sonidos imaginados. El área motora suplementaria (AMS) estuvo activa tanto en las tareas de imaginería como de percepción, lo que sugiere que la vocalización encubierta es un elemento de la imaginería musical. Los aumentos del FSC en la corteza polar frontal inferior y el tálamo derecho sugieren que estas regiones pueden estar relacionadas con la recuperación y/o generación de información auditiva de la memoria.

La música es capaz de crear una experiencia intensamente placentera que puede ser descrita como "escalofríos". [77] Blood y Zatorre (2001) utilizaron PET para medir los cambios en el flujo sanguíneo cerebral mientras los participantes escuchaban música que sabían que les producía "escalofríos" o cualquier tipo de respuesta emocional intensamente placentera. Encontraron que a medida que estos escalofríos aumentan, se observan muchos cambios en el flujo sanguíneo cerebral en regiones cerebrales como la amígdala , la corteza orbitofrontal , el cuerpo estriado ventral , el mesencéfalo y la corteza prefrontal medial ventral . Muchas de estas áreas parecen estar vinculadas a la recompensa, la motivación, la emoción y la excitación, y también se activan en otras situaciones placenteras. [77] Las respuestas de placer resultantes permiten la liberación de dopamina, serotonina y oxitocina. El núcleo accumbens (una parte del cuerpo estriado ) está involucrado tanto en las emociones relacionadas con la música como en el ritmo.

[78] Según el Instituto Nacional de Salud, los niños y adultos que sufren traumas emocionales han podido beneficiarse del uso de la música de diversas maneras. El uso de la música ha sido esencial para ayudar a los niños que tienen dificultades para concentrarse, para tener ansiedad y para la función cognitiva mediante el uso de la música de manera terapéutica. La musicoterapia también ha ayudado a los niños a lidiar con el autismo, el cáncer pediátrico y el dolor causado por los tratamientos.

Las emociones inducidas por la música activan regiones cerebrales frontales similares en comparación con las emociones provocadas por otros estímulos. [60] Schmidt y Trainor (2001) descubrieron que la valencia (es decir, positiva frente a negativa) de los segmentos musicales se distinguía por los patrones de actividad EEG frontal. [79] Los segmentos musicales alegres y felices se asociaron con aumentos en la actividad EEG frontal izquierda, mientras que los segmentos musicales temerosos y tristes se asociaron con aumentos en la actividad EEG frontal derecha. Además, la intensidad de las emociones se diferenció por el patrón de actividad EEG frontal general. La actividad general de la región frontal aumentó a medida que los estímulos musicales afectivos se volvieron más intensos. [79]

Cuando se tocan melodías desagradables, se activa la corteza cingulada posterior , lo que indica una sensación de conflicto o dolor emocional. [16] También se ha descubierto que el hemisferio derecho está correlacionado con la emoción, que también puede activar áreas de la corteza cingulada en momentos de dolor emocional, específicamente rechazo social (Eisenberger). Esta evidencia, junto con las observaciones, ha llevado a muchos teóricos musicales, filósofos y neurocientíficos a vincular la emoción con la tonalidad. Esto parece casi obvio porque los tonos en la música parecen una caracterización de los tonos en el habla humana, que indican contenido emocional. Las vocales en los fonemas de una canción se alargan para lograr un efecto dramático, y parece como si los tonos musicales fueran simplemente exageraciones de la tonalidad verbal normal.

La memoria musical implica tanto sistemas de memoria explícita como implícita. [80] La memoria musical explícita se diferencia además entre episódica (dónde, cuándo y qué de la experiencia musical) y semántica (memoria del conocimiento musical que incluye hechos y conceptos emocionales). La memoria implícita se centra en el "cómo" de la música e implica procesos automáticos como la memoria procedimental y el aprendizaje de habilidades motoras; en otras palabras, habilidades críticas para tocar un instrumento. Samson y Baird (2009) descubrieron que la capacidad de los músicos con enfermedad de Alzheimer para tocar un instrumento (memoria procedimental implícita) puede estar preservada.

Un estudio PET que investigó los correlatos neuronales de la memoria semántica musical y episódica encontró patrones de activación distintos. [81] La memoria musical semántica implica la sensación de familiaridad con las canciones. La condición de memoria semántica para la música resultó en una activación bilateral en la corteza frontal medial y orbital, así como en la circunvolución angular izquierda y la región anterior izquierda de las circunvoluciones temporales medias. Estos patrones respaldan la asimetría funcional que favorece al hemisferio izquierdo para la memoria semántica. Las regiones temporal anterior izquierda y frontal inferior que se activaron en la tarea de memoria semántica musical produjeron picos de activación específicamente durante la presentación de material musical, lo que sugiere que estas regiones están funcionalmente especializadas en cierto modo para las representaciones semánticas musicales.

La memoria episódica de la información musical implica la capacidad de recordar el contexto anterior asociado con un fragmento musical. [81] En la condición que invoca la memoria episódica para la música, se encontraron activaciones bilaterales en los giros frontales medio y superior y el precúneo, con activación predominante en el hemisferio derecho. Otros estudios han encontrado que el precúneo se activa en el recuerdo episódico exitoso. [82] Como se activó en la condición de memoria familiar de la memoria episódica, esta activación puede explicarse por el recuerdo exitoso de la melodía.

En lo que respecta a la memoria del tono, parece haber una red cerebral dinámica y distribuida que sustenta los procesos de memoria del tono. Gaab, Gaser, Zaehle, Jancke y Schlaug (2003) examinaron la anatomía funcional de la memoria del tono utilizando imágenes por resonancia magnética funcional (fMRI). [83] Un análisis de las puntuaciones de rendimiento en una tarea de memoria del tono dio como resultado una correlación significativa entre el buen rendimiento de la tarea y el giro supramarginal (SMG), así como el cerebelo dorsolateral. Los hallazgos indican que el cerebelo dorsolateral puede actuar como un procesador de discriminación del tono y el SMG puede actuar como un sitio de almacenamiento de información del tono a corto plazo. Se encontró que el hemisferio izquierdo era más prominente en la tarea de memoria del tono que las regiones del hemisferio derecho.

Se ha demostrado que la enseñanza musical favorece la memoria . Altenmuller et al. estudiaron la diferencia entre la enseñanza musical activa y pasiva y descubrieron que, durante un período de tiempo más largo (pero no corto), los estudiantes que recibían enseñanza activa retenían mucha más información que los que recibían enseñanza pasiva. También se descubrió que los estudiantes que recibían enseñanza activa tenían una mayor activación de la corteza cerebral. Los estudiantes que recibían enseñanza pasiva no estaban perdiendo el tiempo; ellos, junto con el grupo activo, mostraban una mayor actividad del hemisferio izquierdo, lo que es típico en los músicos entrenados. [84]

Las investigaciones sugieren que escuchamos las mismas canciones una y otra vez debido a la nostalgia musical. Un importante estudio, publicado en la revista Memory & Cognition, descubrió que la música permite que la mente evoque recuerdos del pasado, conocidos como memorias autobiográficas evocadas por la música . [85]

Treder et al. [86] identificaron correlatos neuronales de la atención al escuchar patrones musicales polifónicos simplificados. En un experimento musical extraño, hicieron que los participantes cambiaran su atención selectiva a uno de tres instrumentos diferentes en clips de audio musicales, y cada instrumento tocaba ocasionalmente una o varias notas que se desviaban de un patrón que de otro modo sería repetitivo. Al contrastar los instrumentos atendidos con los no atendidos, el análisis ERP muestra respuestas específicas del sujeto y del instrumento, incluidos los componentes auditivos tempranos y P300. El instrumento atendido se pudo clasificar fuera de línea con alta precisión. Esto indica que la atención prestada a un instrumento particular en la música polifónica se puede inferir a partir del EEG en curso, un hallazgo que es potencialmente relevante para construir interfaces cerebro-computadora basadas en listas de música más ergonómicas. [86]

Se ha descubierto que los niños de cuatro años que saben tocar tienen una mayor coherencia intrahemisférica en el hemisferio izquierdo. [84] En un estudio de Cowell et al. en 1992 se ha descubierto que los músicos tienen porciones anteriores del cuerpo calloso más desarrolladas. Esto fue confirmado por un estudio de Schlaug et al. en 1995 que descubrió que los músicos clásicos entre las edades de 21 y 36 tienen cuerpos callosos anteriores significativamente mayores que el control no musical. Schlaug también descubrió que había una fuerte correlación entre la exposición musical antes de los siete años y un gran aumento en el tamaño del cuerpo calloso. [84] Estas fibras unen los hemisferios izquierdo y derecho e indican un aumento de la transmisión entre ambos lados del cerebro. Esto sugiere la fusión entre el procesamiento espacial, emocional y tonal del cerebro derecho y el procesamiento lingüístico del cerebro izquierdo. Esta gran transmisión a través de muchas áreas diferentes del cerebro podría contribuir a la capacidad de la música para ayudar en la función de la memoria.

La distonía focal de la mano es un trastorno del movimiento relacionado con la tarea asociado con actividades ocupacionales que requieren movimientos repetitivos de la mano. [87] La distonía focal de la mano se asocia con un procesamiento anormal en las cortezas premotora y sensoriomotora primaria. Un estudio de fMRI examinó a cinco guitarristas con distonía focal de la mano. [88] El estudio reprodujo la distonía de la mano específica de la tarea haciendo que los guitarristas usaran un mástil de guitarra real dentro del escáner y realizaran un ejercicio de guitarra para desencadenar un movimiento anormal de la mano. Los guitarristas distónicos mostraron una activación significativamente mayor de la corteza sensoriomotora primaria contralateral, así como una subactivación bilateral de las áreas premotoras. Este patrón de activación representa el reclutamiento anormal de las áreas corticales involucradas en el control motor. Incluso en músicos profesionales, la participación generalizada de la región cortical bilateral es necesaria para producir movimientos complejos de la mano, como escalas y arpegios . El cambio anormal de la activación premotora a la sensoriomotora primaria se correlaciona directamente con la distonía de la mano inducida por la guitarra.

La agnosia musical , una agnosia auditiva , es un síndrome de deterioro selectivo en el reconocimiento de la música. [89] Dalla Bella y Peretz (1999) examinaron tres casos de agnosia musical: CN, GL e IR. Los tres pacientes sufrieron daño bilateral en la corteza auditiva que resultó en dificultades musicales mientras que la comprensión del habla permaneció intacta. Su deterioro es específico en el reconocimiento de melodías que alguna vez fueron familiares. No reconocen sonidos ambientales ni letras. Peretz (1996) ha estudiado más a fondo la agnosia musical de CN e informa de un deterioro inicial del procesamiento del tono y un procesamiento temporal intacto. [90] CN recuperó más tarde las habilidades de procesamiento del tono, pero permaneció afectado en el reconocimiento de melodías y los juicios de familiaridad.

Las agnosias musicales pueden clasificarse en función del proceso que se ve afectado en el individuo. [91] La agnosia musical aperceptiva implica un deterioro a nivel del análisis perceptivo que implica una incapacidad para codificar correctamente la información musical. La agnosia musical asociativa refleja un sistema de representación alterado que altera el reconocimiento de la música. Muchos de los casos de agnosia musical han sido resultado de una cirugía que afectaba a la arteria cerebral media. Los estudios de pacientes han superado una gran cantidad de evidencia que demuestra que el lado izquierdo del cerebro es más adecuado para mantener representaciones de la memoria a largo plazo de la música y que el lado derecho es importante para controlar el acceso a estas representaciones. Las agnosias musicales asociativas tienden a producirse por un daño en el hemisferio izquierdo, mientras que la agnosia musical aperceptiva refleja un daño en el hemisferio derecho.

La amusia congénita , también conocida como sordera tonal , es un término que se utiliza para referirse a problemas musicales de por vida que no son atribuibles a retraso mental, falta de exposición a la música o sordera, o daño cerebral después del nacimiento. [92] Se ha descubierto en estudios de fMRI que los cerebros amusicales tienen menos materia blanca y una corteza más gruesa que los controles en la corteza frontal inferior derecha. Estas diferencias sugieren un desarrollo neuronal anormal en la corteza auditiva y el giro frontal inferior, dos áreas que son importantes en el procesamiento del tono musical.

Los estudios realizados sobre personas con amusia sugieren que en la tonalidad del habla y la tonalidad musical intervienen diferentes procesos . Los amusianos congénitos carecen de la capacidad de distinguir entre tonos y, por lo tanto, no les afectan, por ejemplo, las disonancias o tocar la tecla equivocada en un piano. Tampoco se les puede enseñar a recordar una melodía o a recitar una canción; sin embargo, aún son capaces de escuchar la entonación del habla, por ejemplo, para distinguir entre "Hablas francés" y "¿Hablas francés?" cuando se les habla.

Los daños en la amígdala tienen efectos selectivos sobre el reconocimiento de la música. Gosselin, Peretz, Johnsen y Adolphs (2007) estudiaron a SM, un paciente con daño bilateral en la amígdala, pero con el resto del lóbulo temporal intacto, y descubrieron que SM tenía problemas para reconocer música triste y aterradora. [93] La percepción de SM de la música alegre era normal, al igual que su capacidad para usar señales como el tempo para distinguir entre música alegre y triste. Parece que los daños específicos en la amígdala pueden afectar selectivamente el reconocimiento de música aterradora.

Los daños cerebrales que dejan intactas otras capacidades musicales pueden provocar alteraciones musicales específicas. Cappelletti, Waley-Cohen, Butterworth y Kopelman (2000) estudiaron un caso único de un paciente llamado PKC, un músico profesional que sufrió daños en el lóbulo temporal posterior izquierdo, así como una pequeña lesión occipitotemporal derecha. [94] Después de sufrir daños en estas regiones, PKC sufrió alteraciones selectivas en las áreas de lectura, escritura y comprensión de la notación musical, pero mantuvo otras habilidades musicales. Conservó la capacidad de leer en voz alta letras, palabras, números y símbolos (incluidos los musicales). Sin embargo, PKC no podía leer en voz alta notas musicales en el pentagrama, independientemente de si la tarea implicaba nombrar con la letra convencional o cantando o tocando. Sin embargo, a pesar de este déficit específico, PKC conservó la capacidad de recordar y tocar melodías conocidas y nuevas.

La arritmia en la modalidad auditiva se define como una alteración del sentido rítmico e incluye déficits como la incapacidad de interpretar música rítmicamente, la incapacidad de mantener el ritmo de la música y la incapacidad de discriminar entre patrones rítmicos o reproducirlos. [95] Un estudio que investigó los elementos de la función rítmica examinó al paciente HJ, que adquirió arritmia después de sufrir un infarto temporoparietal derecho. [95] El daño a esta región dañó el sistema de sincronización central de HJ, que es esencialmente la base de su deterioro rítmico global. HJ no pudo generar pulsos constantes en una tarea de golpeteo. Estos hallazgos sugieren que mantener un ritmo musical depende del funcionamiento de la corteza auditiva temporal derecha.