Filosofía de la inteligencia artificial

Los argumentos a favor de la premisa básica deben demostrar que tal sistema es posible.

La cuenta sobre el conocimiento tácito del robot[13] elimina la necesidad de una descripción precisa en conjunto.

Alan Turing[15] redujo el problema de definir la inteligencia a una simple pregunta sobre la conversación.

El programa pasa la prueba si nadie puede decir cuál de los dos participantes es humano.

[16] Turing señala que nadie (excepto los filósofos) se plantea la pregunta de si "¿puede la gente pensar?"

Escribe "en lugar de discutir continuamente sobre este punto, lo habitual es tener una convención educada en la que todos piensan".

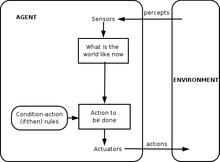

[19] Stuart Russell y Peter Norvig formalizaron esta definición utilizando agentes inteligentes abstractos.

[23] Hubert Dreyfus describe este argumento afirmando que "si el sistema nervioso obedece las leyes de la física y la química, lo cual tenemos todas las razones para suponer que lo hace, entonces... nosotros... deberíamos ser capaces de reproducir el comportamiento del sistema nervioso con algún dispositivo físico".

[24] Este argumento, presentado por primera vez en 1943[25] y descrito vívidamente por Hans Moravec en 1988,[26] es ahora asociado con el futurista Ray Kurzweil, quien estima que la potencia de la computadora será suficiente para una simulación cerebral completa para el año 2029.

Sin embargo, Searle señala que, en principio, cualquier cosa puede ser simulada por una computadora; por lo tanto, llevar la definición a su punto de ruptura lleva a la conclusión de que cualquier proceso puede ser técnicamente considerado "computación".

Ellos escribieron: "Un sistema de símbolos físicos tiene los medios necesarios y suficientes para la acción inteligente general".

Se aplica a lo que puede probarse teóricamente, dada una cantidad infinita de memoria y tiempo.

En la práctica, las máquinas reales (incluidos los humanos) tienen recursos finitos y tendrán dificultades para demostrar muchos teoremas.

[40] De manera menos formal, Douglas Hofstadter, en su libro ganador del premio Pulitzer Gödel, Escher, Bach: un Eterno y Grácil Bucle, afirma que estas "declaraciones de Gödel" siempre se refieren al sistema en sí, trazando una analogía con la forma en que la paradoja de Epiménides usa declaraciones que se refieren a sí misma, como "esta afirmación es falsa" o "estoy mintiendo".

[41] Pero, por supuesto, la paradoja de Epiménides se aplica a cualquier cosa que haga declaraciones, ya sean máquinas o humanos, incluso al propio Lucas.

[45] Hubert Dreyfus argumentó que la inteligencia y la experiencia humanas dependían principalmente de juicios intuitivos rápidos en lugar de una manipulación simbólica paso a paso, y argumentó que estas habilidades nunca serían capturadas en reglas formales.

[51] Los paradigmas de inteligencia computacional, como las redes neuronales, los algoritmos evolutivos, etc., se dirigen principalmente al razonamiento y el aprendizaje inconscientes simulados.

Si las hubiera formulado de manera menos agresiva, las acciones constructivas que sugirieron podrían haberse tomado mucho antes".

La pregunta gira en torno a una posición definida por John Searle como "IA fuerte": Un sistema de símbolos físicos puede tener una mente y estados mentales.

Algunos pensadores de la nueva era, por ejemplo, usan la palabra "conciencia" para describir algo similar al élan vital del filósofo Hanri Bergson: un fluido energético invisible que impregna la vida y especialmente la mente.

Los escritores de ciencia ficción usan la palabra para describir alguna propiedad esencial que nos hace humanos: una máquina o un extraterrestre que sea "consciente" se presentará como un personaje totalmente humano, con inteligencia, deseos, voluntad, perspicacia, orgullo, etc. (Los escritores de ciencia ficción también usan las palabras "sensibilidad", "sapiencia", "autoconciencia" o " fantasma ", como en la serie de manga y anime Ghost in the Shell, para describir esta propiedad humana esencial).

Escriba el programa en tarjetas de 3x5 y entrégueselas a una persona común que no hable chino.

Searle concluye que la habitación china, o cualquier otro sistema de símbolos físicos, no puede tener una mente.

[81] Esta pregunta se relaciona con las anteriores: si el cerebro humano es una especie de computadora, entonces las computadoras pueden ser tanto inteligentes como conscientes, y responder a las preguntas prácticas y filosóficas de la IA.

Esta es la hipótesis del sistema de símbolos físicos discutida anteriormente, e implica que la inteligencia artificial es posible.

Dada esta definición de emoción, Hans Moravec cree que "los robots en general serán bastante emocionales por ser buenas personas".

Moravec afirma que los robots "intentarán complacerte de una manera aparentemente desinteresada porque se emocionarán con este refuerzo positivo.

Visto de esta manera, se puede escribir un programa que informe sobre sus propios estados internos, como un depurador.

[94] Un problema es que las máquinas pueden adquirir la autonomía y la inteligencia necesarias para ser peligrosas muy rápidamente.

También señalaron que algunos virus informáticos pueden evadir la eliminación y han logrado una "inteligencia de cucaracha".