En estadística , la estimación de intervalos es el uso de datos de muestra para estimar un intervalo de posibles valores de un parámetro de interés. Esto contrasta con la estimación puntual , que proporciona un único valor. [1]

Las formas más frecuentes de estimación de intervalos son los intervalos de confianza ( un método frecuentista ) y los intervalos creíbles (un método bayesiano ). [2] Las formas menos comunes incluyen intervalos de verosimilitud , intervalos fiduciales , intervalos de tolerancia e intervalos de predicción . Para un método no estadístico, las estimaciones de intervalos se pueden deducir a partir de la lógica difusa .

Los intervalos de confianza se utilizan para estimar el parámetro de interés a partir de un conjunto de datos muestreados, comúnmente la media o la desviación estándar . Un intervalo de confianza indica que hay un 100γ% de confianza en que el parámetro de interés se encuentra dentro de un límite inferior y superior. Un error común en los intervalos de confianza es que el 100γ% del conjunto de datos se encuentra dentro o por encima/debajo de los límites; esto se conoce como intervalo de tolerancia, que se analiza a continuación.

Existen múltiples métodos utilizados para construir un intervalo de confianza, la elección correcta depende de los datos que se analizan. Para una distribución normal con una varianza conocida , se utiliza la tabla z para crear un intervalo donde se puede obtener un nivel de confianza del 100γ% centrado alrededor de la media de la muestra de un conjunto de datos de n mediciones, . Para una distribución binomial , los intervalos de confianza se pueden aproximar utilizando el método aproximado de Wald , el intervalo de Jeffreys y el intervalo de Clopper-Pearson . El método de Jeffrey también se puede utilizar para aproximar intervalos para una distribución de Poisson . [3] Si se desconoce la distribución subyacente, se puede utilizar el bootstrap para crear límites sobre la mediana del conjunto de datos.

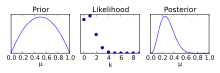

A diferencia de un intervalo de confianza, un intervalo creíble requiere una suposición previa , modificando la suposición utilizando un factor de Bayes y determinando una distribución posterior . Utilizando la distribución posterior, se puede determinar una probabilidad del 100γ% de que el parámetro de interés esté incluido, a diferencia del intervalo de confianza donde se puede tener una confianza del 100γ% de que una estimación está incluida dentro de un intervalo. [4]

Si bien una suposición previa es útil para proporcionar más datos para construir un intervalo, elimina la objetividad de un intervalo de confianza. Se utilizará una suposición previa para informar una suposición posterior; si no se la cuestiona, esta suposición previa puede conducir a predicciones incorrectas. [5]

Los límites del intervalo creíble son variables, a diferencia del intervalo de confianza. Existen múltiples métodos para determinar dónde se deben ubicar los límites superior e inferior correctos. Las técnicas comunes para ajustar los límites del intervalo incluyen el intervalo de densidad posterior más alto (HPDI), el intervalo de colas iguales o la elección del centro del intervalo alrededor de la media.

Utiliza los principios de una función de verosimilitud para estimar el parámetro de interés. Utilizando el método basado en verosimilitud, se pueden encontrar intervalos de confianza para medias exponenciales, de Weibull y lognormales. Además, los enfoques basados en verosimilitud pueden proporcionar intervalos de confianza para la desviación estándar. También es posible crear un intervalo de predicción combinando la función de verosimilitud y la variable aleatoria futura. [3]

La inferencia fiducial utiliza un conjunto de datos, elimina cuidadosamente el ruido y recupera un estimador de distribución, la Distribución Fiducial Generalizada (GFD). Sin el uso del Teorema de Bayes, no hay suposición de un previo, al igual que los intervalos de confianza. La inferencia fiducial es una forma menos común de inferencia estadística . El fundador, RA Fisher , que había estado desarrollando métodos de probabilidad inversa, tenía sus propias preguntas sobre la validez del proceso. Si bien la inferencia fiducial se desarrolló a principios del siglo XX, a fines del siglo XX se creía que el método era inferior a los enfoques frecuentistas y bayesianos, pero tenía un lugar importante en el contexto histórico para la inferencia estadística. Sin embargo, los enfoques modernos han generalizado el intervalo fiducial en la Inferencia Fiducial Generalizada (GFI), que se puede utilizar para estimar conjuntos de datos discretos y continuos. [6]

Los intervalos de tolerancia utilizan la población de un conjunto de datos recopilados para obtener un intervalo, dentro de los límites de tolerancia, que contiene valores del 100γ%. Los ejemplos que se utilizan normalmente para describir los intervalos de tolerancia incluyen la fabricación. En este contexto, se evalúa un porcentaje de un conjunto de productos existente para garantizar que un porcentaje de la población esté incluido dentro de los límites de tolerancia. Al crear intervalos de tolerancia, los límites se pueden escribir en términos de un límite de tolerancia superior e inferior, utilizando la media de la muestra , y la desviación estándar de la muestra , .

para intervalos de dos lados

Y en el caso de intervalos unilaterales donde la tolerancia se requiere sólo por encima o por debajo de un valor crítico,

Varía según la distribución y el número de lados, i, en la estimación del intervalo. En una distribución normal, se puede expresar como [7]

Dónde,

son los valores críticos obtenidos de la distribución normal.

Un intervalo de predicción estima el intervalo que contiene muestras futuras con cierta confianza, γ. Los intervalos de predicción se pueden utilizar tanto en contextos bayesianos como frecuentistas . Estos intervalos se utilizan normalmente en conjuntos de datos de regresión, pero no se utilizan para la extrapolación más allá de los parámetros controlados experimentalmente de los datos anteriores. [8]

La lógica difusa se utiliza para gestionar la toma de decisiones de forma no binaria en el ámbito de la inteligencia artificial, las decisiones médicas y otros campos. En general, toma datos de entrada, los mapea a través de sistemas de inferencia difusa y produce una decisión de salida. Este proceso implica fuzzificación, evaluación de reglas de lógica difusa y desfuzzificación. Al analizar la evaluación de reglas de lógica difusa, las funciones de pertenencia convierten nuestra información de entrada no binaria en variables tangibles. Estas funciones de pertenencia son esenciales para predecir la incertidumbre del sistema.

Los intervalos bilaterales estiman un parámetro de interés, Θ, con un nivel de confianza, γ, utilizando un límite inferior ( ) y un límite superior ( ). Algunos ejemplos pueden incluir la estimación de la altura promedio de los hombres en una región geográfica o las longitudes de un escritorio en particular fabricado por un fabricante. Estos casos tienden a estimar el valor central de un parámetro. Por lo general, esto se presenta en una forma similar a la ecuación siguiente.

A diferencia del intervalo bilateral, el intervalo unilateral utiliza un nivel de confianza, γ, para construir un límite mínimo o máximo que predice el parámetro de interés con una probabilidad de γ*100 %. Normalmente, se requiere un intervalo unilateral cuando el límite mínimo o máximo de la estimación no es de interés. Cuando se trata del valor mínimo predicho de Θ, ya no es necesario encontrar límites superiores de la estimación, lo que conduce a una forma reducida del intervalo bilateral.

Como resultado de eliminar el límite superior y mantener la confianza, el límite inferior ( ) aumentará. Del mismo modo, cuando se trata de encontrar solo un límite superior de la estimación de un parámetro, el límite superior disminuirá. Un intervalo unilateral es un parámetro que se encuentra comúnmente en el control de calidad de la producción de materiales , donde un valor esperado de la resistencia de un material, Θ, debe ser superior a un cierto valor mínimo ( ) con cierta confianza (100γ%). En este caso, el fabricante no está preocupado por producir un producto que sea demasiado fuerte, no hay límite superior ( ).

Al determinar la significancia estadística de un parámetro, es mejor comprender los datos y sus métodos de recolección. Antes de recolectar datos, se debe planificar un experimento de manera que el error de muestreo sea una variabilidad estadística (un error aleatorio ), en lugar de un sesgo estadístico (un error sistemático ). [9] Después de experimentar, un primer paso típico para crear estimaciones de intervalo es el análisis exploratorio que se realiza mediante varios métodos gráficos . A partir de esto, se puede determinar la distribución de muestras del conjunto de datos. Producir límites de intervalo con suposiciones incorrectas basadas en la distribución hace que una predicción sea defectuosa. [10]

Cuando se informan estimaciones de intervalos, deben tener una interpretación común dentro y fuera de la comunidad científica. Las estimaciones de intervalos derivadas de la lógica difusa tienen significados mucho más específicos de la aplicación.

En situaciones que ocurren con frecuencia, debe haber conjuntos de procedimientos estándar que se puedan utilizar, sujetos a la verificación y validez de los supuestos requeridos. Esto se aplica tanto a los intervalos de confianza como a los intervalos creíbles. Sin embargo, en situaciones más novedosas, debe haber una guía sobre cómo se pueden formular estimaciones de intervalos. En este sentido, los intervalos de confianza y los intervalos creíbles tienen una posición similar, pero hay dos diferencias. En primer lugar, los intervalos creíbles pueden manejar fácilmente la información previa, mientras que los intervalos de confianza no pueden. En segundo lugar, los intervalos de confianza son más flexibles y se pueden usar prácticamente en más situaciones que los intervalos creíbles: un área en la que los intervalos creíbles sufren en comparación es en el manejo de modelos no paramétricos .

Debería haber formas de probar el desempeño de los procedimientos de estimación de intervalos. Esto surge porque muchos de estos procedimientos implican aproximaciones de varios tipos y existe la necesidad de verificar que el desempeño real de un procedimiento sea cercano a lo que se afirma. El uso de simulaciones estocásticas hace que esto sea sencillo en el caso de los intervalos de confianza, pero es algo más problemático para los intervalos creíbles en los que es necesario tener en cuenta adecuadamente la información previa. La verificación de intervalos creíbles se puede realizar para situaciones que no representan información previa, pero la verificación implica verificar las propiedades de frecuencia de largo plazo de los procedimientos.

Severini (1993) analiza las condiciones bajo las cuales los intervalos creíbles y los intervalos de confianza producirán resultados similares, y también analiza tanto las probabilidades de cobertura de los intervalos creíbles como las probabilidades posteriores asociadas con los intervalos de confianza. [11]

En la teoría de la decisión , que es un enfoque común y una justificación de las estadísticas bayesianas, la estimación de intervalos no es de interés directo. El resultado es una decisión, no una estimación de intervalo, y por lo tanto los teóricos de la decisión bayesiana utilizan una acción bayesiana : minimizan la pérdida esperada de una función de pérdida con respecto a toda la distribución posterior, no a un intervalo específico.

Las aplicaciones de los intervalos de confianza se utilizan para resolver una variedad de problemas relacionados con la incertidumbre. Katz (1975) propone varios desafíos y beneficios para utilizar estimaciones de intervalos en procedimientos legales. [12] Para su uso en investigación médica, Altmen (1990) analiza el uso de intervalos de confianza y las pautas para su uso. [13] En la fabricación, también es común encontrar estimaciones de intervalos que estiman la vida útil de un producto o que evalúan las tolerancias de un producto. Meeker y Escobar (1998) presentan métodos para analizar datos de confiabilidad bajo estimación paramétrica y no paramétrica, incluida la predicción de variables aleatorias futuras (intervalos de predicción). [14]