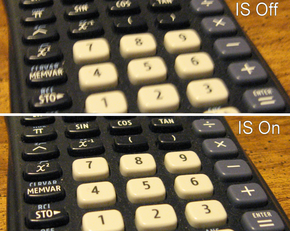

La estabilización de imagen ( IS ) es una familia de técnicas que reducen la borrosidad asociada con el movimiento de una cámara u otro dispositivo de imágenes durante la exposición .

Generalmente, compensa el giro y la inclinación (movimiento angular, equivalente a guiñada y cabeceo ) del dispositivo de imágenes, aunque la estabilización de imagen electrónica también puede compensar la rotación alrededor del eje óptico ( rollo ). [1] Se utiliza principalmente en binoculares con imagen estabilizada de alta gama , cámaras fotográficas y de video , telescopios astronómicos y también teléfonos inteligentes . En el caso de las cámaras fotográficas , el movimiento de la cámara es un problema particular con velocidades de obturación lentas o con lentes de distancia focal larga ( teleobjetivo o zoom ). Con las cámaras de video , el movimiento de la cámara provoca una fluctuación visible de cuadro a cuadro en el video grabado. En astronomía, al problema de la vibración de las lentes se suma la variación de la atmósfera , que cambia las posiciones aparentes de los objetos con el tiempo.

En fotografía, la estabilización de imagen puede facilitar velocidades de obturación de 2 a 5,5 pasos más lentas (exposiciones de 4 a 22+1 ⁄ 2 veces más), y se han informado velocidades efectivas incluso más lentas.

Una regla general para determinar la velocidad de obturación más lenta posible al sostenerlo con la mano sin que se note un desenfoque debido al movimiento de la cámara es tomar el recíproco de la distancia focal equivalente a 35 mm de la lente, también conocida como la "regla de 1/mm" [a ] . Por ejemplo, a una distancia focal de 125 mm en una cámara de 35 mm, la vibración o el movimiento de la cámara podrían afectar la nitidez si la velocidad de obturación es inferior a 1 ⁄ 125 segundos. Como resultado de las velocidades de obturación más lentas de 2 a 4,5 pasos permitidas por IS, una imagen tomada a una velocidad de 1 ⁄ 125 segundos con una lente normal podría tomarse a 1 ⁄ 15 o 1 ⁄ 8 segundos con una lente equipada con IS y producir casi la misma calidad. La nitidez que se puede obtener a una velocidad determinada puede aumentar drásticamente. [3] Al calcular la distancia focal efectiva, es importante tener en cuenta el formato de imagen que utiliza una cámara. Por ejemplo, muchas cámaras SLR digitales utilizan un sensor de imagen que tiene 2 ⁄ 3 , 5 ⁄ 8 o 1 ⁄ 2 del tamaño de un fotograma de película de 35 mm. Esto significa que el marco de 35 mm es 1,5, 1,6 o 2 veces el tamaño del sensor digital. Estos últimos valores se denominan factor de recorte , factor de recorte del campo de visión, multiplicador de distancia focal o factor de formato. En una cámara con factor de recorte de 2×, por ejemplo, una lente de 50 mm produce el mismo campo de visión que una lente de 100 mm utilizada en una cámara de película de 35 mm y, por lo general, se puede colocar en la mano a 1 ⁄ 100 de segundo.

Sin embargo, la estabilización de imagen no evita el desenfoque causado por el movimiento del sujeto o por movimientos extremos de la cámara. La estabilización de imagen solo está diseñada y es capaz de reducir la borrosidad que resulta del movimiento normal y diminuto de una lente debido al disparo sin trípode. Algunas lentes y cuerpos de cámara incluyen un modo de panorámica secundaria o un "modo activo" más agresivo, ambos descritos con mayor detalle a continuación en estabilización de imagen óptica.

La astrofotografía hace mucho uso de la fotografía de larga exposición , que requiere que la cámara esté fija en su lugar. Sin embargo, fijarlo a la Tierra no es suficiente, ya que la Tierra gira . Las Pentax K-5 y Kr, cuando están equipadas con el accesorio GPS O-GPS1 para datos de posición, pueden usar su capacidad de cambio de sensor para reducir los rastros de estrellas resultantes . [4]

La estabilización se puede aplicar en la lente o en el cuerpo de la cámara. Cada método tiene ventajas y desventajas distintivas. [5]

Un estabilizador de imagen óptico ( OIS , IS u OS ) es un mecanismo utilizado en cámaras fijas o de video que estabiliza la imagen grabada variando la ruta óptica hacia el sensor. Esta tecnología se implementa en la propia lente, a diferencia de la estabilización de imagen corporal ( IBIS ), que funciona moviendo el sensor como elemento final del camino óptico. El elemento clave de todos los sistemas de estabilización óptica es que estabilizan la imagen proyectada en el sensor antes de que el sensor convierta la imagen en información digital . IBIS puede tener hasta 5 ejes de movimiento: X, Y, Roll, Yaw y Pitch. IBIS tiene la ventaja adicional de trabajar con todos los lentes.

La estabilización de imagen óptica prolonga la velocidad de obturación posible para la fotografía portátil al reducir la probabilidad de que la imagen se vea borrosa debido al movimiento durante el mismo tiempo de exposición.

Para la grabación de video portátil , independientemente de las condiciones de iluminación, la estabilización de imagen óptica compensa las pequeñas sacudidas cuya apariencia se magnifica cuando se mira en una pantalla grande, como un televisor o un monitor de computadora . [6] [7] [8]

Diferentes empresas tienen diferentes nombres para la tecnología OIS, por ejemplo:

La mayoría de los teléfonos inteligentes de alta gama a finales de 2014 utilizan estabilización de imagen óptica para fotos y vídeos. [11]

En la implementación de Nikon y Canon , funciona mediante el uso de un elemento de lente flotante que se mueve ortogonalmente al eje óptico de la lente mediante electroimanes. [12] La vibración se detecta utilizando dos sensores piezoeléctricos de velocidad angular (a menudo llamados sensores giroscópicos ), uno para detectar el movimiento horizontal y el otro para detectar el movimiento vertical. [13] Como resultado, este tipo de estabilizador de imagen corrige solo las rotaciones de los ejes de cabeceo y guiñada, [14] [15] y no puede corregir la rotación alrededor del eje óptico. Algunos lentes tienen un modo secundario que contrarresta el movimiento vertical de la cámara. Este modo es útil cuando se utiliza una técnica de panorámica . Algunas de estas lentes lo activan automáticamente; otros usan un interruptor en la lente.

Para compensar el movimiento de la cámara al grabar videos mientras camina, Panasonic introdujo Power Hybrid OIS+ con corrección de cinco ejes: rotación de ejes, rotación horizontal, rotación vertical y movimiento horizontal y vertical. [dieciséis]

Algunas lentes Nikon habilitadas para VR ofrecen un modo "activo" para disparar desde un vehículo en movimiento, como un automóvil o un barco, que se supone que corrige las sacudidas más fuertes que el modo "normal". [17] Sin embargo, el modo activo utilizado para disparos normales puede producir peores resultados que el modo normal. [18] Esto se debe a que el modo activo está optimizado para reducir los movimientos de velocidad angular más alta (normalmente cuando se dispara desde una plataforma en gran movimiento usando velocidades de obturación más rápidas), mientras que el modo normal intenta reducir los movimientos de velocidad angular más baja en una amplitud y período de tiempo mayores (normalmente el cuerpo). y movimiento de la mano al estar de pie sobre una plataforma fija o que se mueve lentamente mientras se utilizan velocidades de obturación más lentas).

La mayoría de los fabricantes sugieren que la función IS de una lente se desactive cuando la lente esté montada en un trípode, ya que puede causar resultados erráticos y generalmente es innecesario. Muchas lentes de estabilización de imagen modernas (en particular, las lentes IS más recientes de Canon) pueden detectar automáticamente que están montadas en un trípode (como resultado de lecturas de vibración extremadamente bajas) y desactivar IS automáticamente para evitar esto y cualquier reducción consiguiente de la calidad de la imagen. [19] El sistema también consume energía de la batería, por lo que desactivarlo cuando no es necesario prolonga la carga de la batería.

Una desventaja de la estabilización de imagen basada en lentes es el costo. Cada lente requiere su propio sistema de estabilización de imagen. Además, no todos los lentes están disponibles en una versión con imagen estabilizada. Este suele ser el caso de los objetivos fijos rápidos y gran angular. Sin embargo, el objetivo más rápido con estabilización de imagen es el Nocticron con una velocidad de f /1,2. Si bien la ventaja más obvia para la estabilización de imagen radica en distancias focales más largas, incluso las lentes normales y gran angular se benefician en aplicaciones con poca luz.

La estabilización basada en lentes también tiene ventajas sobre la estabilización corporal. En situaciones de poca luz o bajo contraste, el sistema de enfoque automático (que no tiene sensores estabilizados) puede funcionar con mayor precisión cuando la imagen proveniente de la lente ya está estabilizada. [ cita necesaria ] En cámaras con visores ópticos, la imagen vista por el fotógrafo a través de la lente estabilizada (a diferencia de la estabilización interna) revela más detalles debido a su estabilidad y también facilita el encuadre correcto. Este es especialmente el caso de los teleobjetivos más largos. Esto no es un problema para los sistemas de cámaras de lentes intercambiables sin espejo , porque la salida del sensor a la pantalla o al visor electrónico está estabilizada.

El sensor que captura la imagen se puede mover de tal manera que contrarreste el movimiento de la cámara, una tecnología a menudo denominada estabilización de imagen mecánica. Cuando la cámara gira, provocando un error angular, los giroscopios codifican información para el actuador que mueve el sensor. [20] El sensor se mueve para mantener la proyección de la imagen en el plano de la imagen, que es función de la distancia focal de la lente que se utiliza. Las cámaras modernas pueden adquirir automáticamente información sobre la distancia focal de lentes modernos fabricados para esa cámara. Minolta y Konica Minolta utilizaron una técnica llamada Anti-Shake (AS) ahora comercializada como SteadyShot (SS) en la línea α de Sony y Shake Reduction (SR) en las cámaras Pentax de las series K y Q , que se basa en un ángulo muy preciso. Sensor de velocidad para detectar el movimiento de la cámara. [21] Olympus introdujo la estabilización de imagen con su cuerpo E-510 D-SLR , empleando un sistema construido alrededor de su Supersonic Wave Drive. [22] Otros fabricantes utilizan procesadores de señales digitales (DSP) para analizar la imagen sobre la marcha y luego mover el sensor de manera adecuada. El cambio de sensor también se utiliza en algunas cámaras de Fujifilm, Samsung, Casio Exilim y Ricoh Caplio. [23]

La ventaja de mover el sensor de imagen , en lugar del objetivo, es que la imagen se puede estabilizar incluso en objetivos fabricados sin estabilización. Esto puede permitir que la estabilización funcione con muchos lentes que de otro modo no estarían estabilizados y reduce el peso y la complejidad de los lentes. Además, cuando la tecnología de estabilización de imagen basada en sensores mejora, es necesario reemplazar solo la cámara para aprovechar las mejoras, lo que generalmente es mucho menos costoso que reemplazar todas las lentes existentes si se depende de la estabilización de imagen basada en lentes. Algunas implementaciones de estabilización de imagen basadas en sensores son capaces de corregir la rotación del carrete de la cámara , un movimiento que se excita fácilmente presionando el botón del obturador. Ningún sistema basado en lentes puede abordar esta posible fuente de imagen borrosa. Un subproducto de la compensación de "rollo" disponible es que la cámara puede corregir automáticamente los horizontes inclinados en el dominio óptico, siempre que esté equipada con un nivel de burbuja electrónico, como las cámaras Pentax K-7/K-5.

Una de las principales desventajas de mover el sensor de imagen es que la imagen proyectada en el visor no está estabilizada. De manera similar, la imagen proyectada a un sistema de enfoque automático por detección de fase que no forma parte del sensor de imagen, si se utiliza, no se estabiliza. Esto no es un problema en las cámaras que utilizan un visor electrónico (EVF), ya que la imagen proyectada en ese visor se toma del propio sensor de imagen.

Algunos cuerpos de cámara, pero no todos, con capacidad de estabilización interna se pueden preconfigurar manualmente a una distancia focal determinada. Su sistema de estabilización corrige como si esa lente de distancia focal estuviera colocada, por lo que la cámara puede estabilizar lentes más antiguas y lentes de otros fabricantes. Esto no es viable con lentes con zoom, porque su distancia focal es variable. Algunos adaptadores comunican información sobre la distancia focal del fabricante de una lente al cuerpo de otro fabricante. Algunas lentes que no informan su distancia focal se pueden adaptar con un chip que informa una distancia focal preprogramada al cuerpo de la cámara. A veces, ninguna de estas técnicas funciona y la estabilización de imagen no se puede utilizar con dichos lentes.

La estabilización de imagen en el cuerpo requiere que la lente tenga un círculo de imagen de salida más grande porque el sensor se mueve durante la exposición y, por lo tanto, utiliza una parte más grande de la imagen. En comparación con los movimientos de las lentes en los sistemas ópticos de estabilización de imagen, los movimientos del sensor son bastante grandes, por lo que la efectividad está limitada por el rango máximo de movimiento del sensor, donde una lente estabilizada ópticamente moderna típica tiene mayor libertad. Tanto la velocidad como el alcance del movimiento requerido del sensor aumentan con la distancia focal del objetivo que se utiliza, lo que hace que la tecnología de desplazamiento del sensor sea menos adecuada para teleobjetivos muy largos, especialmente cuando se utilizan velocidades de obturación más lentas, porque el rango de movimiento disponible del sensor rápidamente se vuelve insuficiente para hacer frente al creciente desplazamiento de la imagen.

En septiembre de 2023, Nikon anunció el lanzamiento de Nikon Z f , que cuenta con la primera tecnología Focus-Point VR del mundo que centra el eje de estabilización de imagen por desplazamiento del sensor en el punto de enfoque automático, en lugar de en el centro del sensor como el sensor convencional. sistema de estabilización de imagen por desplazamiento. Esto permite reducir la vibración en el punto enfocado en lugar de solo en el centro de la imagen. [24]

Comenzando con la Panasonic Lumix DMC-GX8 , anunciada en julio de 2015, y posteriormente con la Panasonic Lumix DC-GH5 , Panasonic, que anteriormente solo equipaba estabilización basada en lentes en su sistema de cámara de lentes intercambiables (del estándar Micro Four Thirds ), presentó Estabilización por cambio de sensor que funciona en conjunto con el sistema basado en lentes existente ("Dual IS").

Mientras tanto (2016), Olympus también ofreció dos lentes con estabilización de imagen que se pueden sincronizar con el sistema de estabilización de imagen incorporado de los sensores de imagen de las cámaras Micro Four Thirds de Olympus ("Sync IS"). Con esta tecnología se puede lograr una ganancia de 6,5 f -stops sin imágenes borrosas. [25] Esto está limitado por el movimiento de rotación de la superficie de la Tierra, que engaña a los acelerómetros de la cámara. Por lo tanto, dependiendo del ángulo de visión, el tiempo máximo de exposición no debe exceder 1 ⁄ 3 de segundo para tomas largas con teleobjetivo (con una distancia focal equivalente a 35 mm de 800 milímetros) y un poco más de diez segundos para tomas de gran angular (con una 35 mm (longitud focal equivalente a 24 milímetros), si el proceso de estabilización de imagen no tiene en cuenta el movimiento de la Tierra. [26]

En 2015, el sistema de cámara Sony E también permitía combinar sistemas de estabilización de imagen de lentes y cuerpos de cámara, pero sin sincronizar los mismos grados de libertad . En este caso, solo se activan los grados de compensación independientes de la estabilización del sensor de imagen incorporado para respaldar la estabilización de la lente. [27]

Canon y Nikon ahora tienen cuerpos sin espejo de fotograma completo que tienen IBIS y también admiten la estabilización basada en lentes de cada compañía. Los dos primeros cuerpos de este tipo de Canon, la EOS R y RP , no tienen IBIS, pero la característica se agregó para los modelos más recientes de gama alta R3 , R5 , R6 (y su versión MkII) y el APS-C R7 . Sin embargo, el R8 de fotograma completo y el APS-C R10 no tienen IBIS. Todos los cuerpos con montura Z de fotograma completo de Nikon ( Z 6 , Z 7 , las versiones Mark II de ambos, Z 8 y Z 9) tienen IBIS. Sin embargo, su APS-C Z 50 carece de IBIS.

La estabilización de imagen digital en tiempo real , también llamada estabilización electrónica de imagen (EIS), se utiliza en algunas cámaras de vídeo. Esta técnica desplaza el área recortada leída por el sensor de imagen para cada cuadro para contrarrestar el movimiento. Esto requiere que la resolución del sensor de imagen supere la resolución del vídeo grabado y reduce ligeramente el campo de visión porque el área del sensor de imagen fuera del marco visible actúa como un amortiguador contra los movimientos de la mano. [28] Esta técnica reduce las vibraciones que distraen de los videos al suavizar la transición de un cuadro a otro.

Esta técnica no puede hacer nada con respecto al desenfoque de movimiento existente, lo que puede provocar que una imagen aparentemente pierda el enfoque a medida que el movimiento se compensa debido al movimiento durante los tiempos de exposición de fotogramas individuales. Este efecto es más visible en paisajes más oscuros debido a los tiempos de exposición prolongados por fotograma.

Algunos fabricantes de cámaras fotográficas promocionaron sus cámaras con estabilización de imagen digital cuando en realidad sólo tenían un modo de alta sensibilidad que utiliza un tiempo de exposición corto, lo que produce imágenes con menos desenfoque de movimiento, pero más ruido. [29] Reduce el desenfoque al fotografiar algo que se está moviendo, así como el movimiento de la cámara.

Otros ahora también utilizan el procesamiento de señales digitales (DSP) para reducir el desenfoque en las fotografías, por ejemplo, subdividiendo la exposición en varias exposiciones más cortas en rápida sucesión, descartando las borrosas, realineando las subexposiciones más nítidas y sumándolas, y usando el giroscopio para detectar el mejor momento para tomar cada fotograma. [30] [31] [32]

Muchos sistemas de edición de vídeo no lineal utilizan filtros de estabilización que pueden corregir una imagen no estabilizada siguiendo el movimiento de los píxeles de la imagen y corrigiéndola moviendo el fotograma. [33] [34] El proceso es similar a la estabilización de imagen digital, pero como no hay una imagen más grande para trabajar con el filtro, se recorta la imagen para ocultar el movimiento del marco o se intenta recrear la imagen perdida en el borde mediante técnicas espaciales. o extrapolación temporal . [35]

Los servicios en línea, incluido YouTube , también están comenzando a proporcionar estabilización de video como paso de posprocesamiento después de cargar el contenido. Esto tiene la desventaja de no tener acceso a los datos giroscópicos en tiempo real, pero la ventaja de una mayor potencia informática y la capacidad de analizar imágenes tanto antes como después de un cuadro en particular. [36]

Utilizado en astronomía, un CCD de transferencia ortogonal (OTCCD) en realidad desplaza la imagen dentro del propio CCD mientras se captura la imagen, basándose en el análisis del movimiento aparente de las estrellas brillantes. Este es un raro ejemplo de estabilización digital para fotografías. Un ejemplo de esto es el próximo telescopio de gigapíxeles Pan-STARRS que se está construyendo en Hawaii. [37]

Una técnica que no requiere capacidades adicionales de ninguna combinación de cuerpo de cámara y lente consiste en estabilizar todo el cuerpo de la cámara externamente en lugar de utilizar un método interno. Esto se logra acoplando un giroscopio al cuerpo de la cámara, generalmente usando el soporte para trípode incorporado en la cámara. Esto permite que el giroscopio externo (cardán) estabilice la cámara y generalmente se usa en fotografías desde un vehículo en movimiento, cuando no hay disponible una lente o cámara que ofrezca otro tipo de estabilización de imagen. [38]

Una forma común de estabilizar cámaras en movimiento después de aprox. año 2015 es mediante el uso de un estabilizador de cámara , como un cabezal de cámara remoto estabilizado. La cámara y el objetivo se montan en un soporte de cámara controlado remotamente que luego se monta en cualquier objeto en movimiento, como sistemas de rieles, cables, automóviles o helicópteros. Un ejemplo de cabezal estabilizado remoto que se utiliza para estabilizar cámaras de televisión en movimiento que transmiten en vivo es el cabezal estabilizado Newton. [39]

Otra técnica para estabilizar el cuerpo de una cámara de vídeo o de cine es el sistema Steadicam , que aísla la cámara del cuerpo del operador mediante un arnés y un brazo de cámara con contrapeso.[40]

Un estabilizador de cámara es cualquier dispositivo u objeto que estabiliza externamente la cámara. Esto puede referirse a una Steadicam , un trípode , la mano del operador de la cámara o una combinación de estos.

En la fotografía de primeros planos, el uso de sensores de rotación para compensar los cambios en la dirección de orientación resulta insuficiente. Mover, en lugar de inclinar, la cámara hacia arriba/abajo o hacia la izquierda/derecha una fracción de milímetro se vuelve perceptible si intentas resolver detalles de tamaño milimétrico en el objeto. Los acelerómetros lineales de la cámara, junto con información como la distancia focal de la lente y la distancia enfocada, pueden introducir una corrección secundaria en el motor que mueve el sensor o la óptica, para compensar las sacudidas lineales y rotacionales.[41]

En muchos animales, incluidos los seres humanos, el oído interno funciona como análogo biológico de un acelerómetro en los sistemas de estabilización de imagen de las cámaras, para estabilizar la imagen moviendo los ojos . Cuando se detecta una rotación de la cabeza, se envía una señal inhibidora a los músculos extraoculares de un lado y una señal excitadora a los músculos del otro lado. El resultado es un movimiento compensatorio de los ojos. Normalmente, los movimientos oculares se retrasan con respecto a los movimientos de la cabeza en menos de 10 ms. [42]

{{cite web}}: Mantenimiento CS1: URL no apta ( enlace ){{cite book}}: Mantenimiento CS1: varios nombres: lista de autores ( enlace )