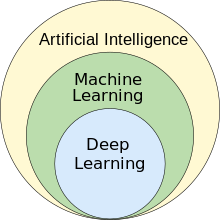

El aprendizaje automático ( ML ) es un campo de estudio en inteligencia artificial que se ocupa del desarrollo y estudio de algoritmos estadísticos que pueden aprender de los datos y generalizar a datos invisibles, y así realizar tareas sin instrucciones explícitas . [1] Los avances en el campo del aprendizaje profundo han permitido que las redes neuronales superen muchos enfoques anteriores en rendimiento. [2]

El ML encuentra aplicaciones en muchos campos, incluido el procesamiento del lenguaje natural , la visión por computadora , el reconocimiento de voz , el filtrado de correo electrónico , la agricultura y la medicina . [3] [4] La aplicación del ML a problemas comerciales se conoce como análisis predictivo .

Los métodos estadísticos y de optimización matemática (programación matemática) constituyen los fundamentos del aprendizaje automático. La minería de datos es un campo de estudio relacionado, que se centra en el análisis exploratorio de datos (EDA) a través del aprendizaje no supervisado . [6] [7]

Desde un punto de vista teórico, el aprendizaje probablemente aproximadamente correcto (PAC) proporciona un marco para describir el aprendizaje automático.

El término aprendizaje automático fue acuñado en 1959 por Arthur Samuel , un empleado de IBM y pionero en el campo de los juegos de computadora y la inteligencia artificial . [8] [9] El sinónimo computadoras autodidactas también se utilizó en este período de tiempo. [10] [11]

Aunque el primer modelo de aprendizaje automático se introdujo en la década de 1950, cuando Arthur Samuel inventó un programa que calculaba las posibilidades de ganar en las damas para cada lado, la historia del aprendizaje automático se remonta a décadas de deseo y esfuerzo humanos por estudiar los procesos cognitivos humanos. [12] En 1949, el psicólogo canadiense Donald Hebb publicó el libro The Organization of Behavior , en el que introdujo una estructura neuronal teórica formada por ciertas interacciones entre las células nerviosas . [13] El modelo de Hebb de neuronas que interactúan entre sí sentó las bases de cómo funcionan las IA y los algoritmos de aprendizaje automático bajo nodos, o neuronas artificiales utilizadas por las computadoras para comunicar datos. [12] Otros investigadores que han estudiado los sistemas cognitivos humanos también contribuyeron a las tecnologías modernas de aprendizaje automático, incluidos el lógico Walter Pitts y Warren McCulloch , quienes propusieron los primeros modelos matemáticos de redes neuronales para crear algoritmos que reflejaran los procesos de pensamiento humano. [12]

A principios de los años 1960, la compañía Raytheon había desarrollado una "máquina de aprendizaje" experimental con memoria de cinta perforada , llamada Cybertron, para analizar señales de sonar , electrocardiogramas y patrones de habla utilizando un aprendizaje de refuerzo rudimentario . Un operador/profesor humano la "entrenaba" repetidamente para reconocer patrones y la equipaba con un botón de " error " para hacer que reevaluara las decisiones incorrectas. [14] Un libro representativo sobre la investigación en aprendizaje automático durante los años 1960 fue el libro de Nilsson sobre máquinas de aprendizaje, que trataba principalmente sobre aprendizaje automático para la clasificación de patrones. [15] El interés relacionado con el reconocimiento de patrones continuó hasta los años 1970, como lo describieron Duda y Hart en 1973. [16] En 1981 se presentó un informe sobre el uso de estrategias de enseñanza para que una red neuronal artificial aprendiera a reconocer 40 caracteres (26 letras, 10 dígitos y 4 símbolos especiales) desde una terminal de computadora. [17]

Tom M. Mitchell proporcionó una definición más formal y ampliamente citada de los algoritmos estudiados en el campo del aprendizaje automático: "Se dice que un programa informático aprende de la experiencia E con respecto a alguna clase de tareas T y medida de rendimiento P si su rendimiento en tareas en T , medido por P , mejora con la experiencia E ". [18] Esta definición de las tareas en las que se involucra el aprendizaje automático ofrece una definición fundamentalmente operativa en lugar de definir el campo en términos cognitivos. Esto sigue la propuesta de Alan Turing en su artículo " Computing Machinery and Intelligence ", en el que la pregunta "¿Pueden pensar las máquinas?" se reemplaza por la pregunta "¿Pueden las máquinas hacer lo que nosotros (como entidades pensantes) podemos hacer?". [19]

El aprendizaje automático moderno tiene dos objetivos: uno es clasificar los datos basándose en modelos que se han desarrollado; el otro es hacer predicciones de resultados futuros basándose en estos modelos. Un algoritmo hipotético específico para clasificar datos puede utilizar la visión artificial de lunares junto con el aprendizaje supervisado para entrenarlo a clasificar los lunares cancerosos. Un algoritmo de aprendizaje automático para la negociación de acciones puede informar al operador de posibles predicciones futuras. [20]

Como esfuerzo científico, el aprendizaje automático surgió de la búsqueda de inteligencia artificial (IA). En los primeros días de la IA como disciplina académica , algunos investigadores estaban interesados en que las máquinas aprendieran de los datos. Intentaron abordar el problema con varios métodos simbólicos, así como con lo que entonces se denominaban " redes neuronales "; estas eran principalmente perceptrones y otros modelos que luego se descubrió que eran reinvenciones de los modelos lineales generalizados de estadística. [22] También se empleó el razonamiento probabilístico , especialmente en el diagnóstico médico automatizado . [23] : 488

Sin embargo, un énfasis creciente en el enfoque lógico basado en el conocimiento causó una ruptura entre la IA y el aprendizaje automático. Los sistemas probabilísticos estaban plagados de problemas teóricos y prácticos de adquisición y representación de datos. [23] : 488 Para 1980, los sistemas expertos habían llegado a dominar la IA, y las estadísticas estaban en desgracia. [24] El trabajo sobre el aprendizaje simbólico/basado en el conocimiento continuó dentro de la IA, lo que llevó a la programación lógica inductiva (ILP), pero la línea de investigación más estadística ahora estaba fuera del campo de la IA propiamente dicha, en el reconocimiento de patrones y la recuperación de información . [23] : 708–710, 755 La investigación de redes neuronales había sido abandonada por la IA y la informática casi al mismo tiempo. Esta línea también fue continuada fuera del campo de la IA/CS, como " conexionismo ", por investigadores de otras disciplinas, incluidos John Hopfield , David Rumelhart y Geoffrey Hinton . Su principal éxito llegó a mediados de la década de 1980 con la reinvención de la retropropagación . [23] : 25

El aprendizaje automático (ML), reorganizado y reconocido como un campo propio, comenzó a florecer en la década de 1990. El campo cambió su objetivo de lograr inteligencia artificial a abordar problemas solucionables de naturaleza práctica. Cambió el enfoque de los enfoques simbólicos que había heredado de la IA y se centró en métodos y modelos tomados de la estadística, la lógica difusa y la teoría de la probabilidad . [24]

Existe una estrecha relación entre el aprendizaje automático y la compresión. Un sistema que predice las probabilidades posteriores de una secuencia dada toda su historia se puede utilizar para la compresión óptima de datos (mediante el uso de codificación aritmética en la distribución de salida). Por el contrario, se puede utilizar un compresor óptimo para la predicción (al encontrar el símbolo que comprime mejor, dada la historia previa). Esta equivalencia se ha utilizado como justificación para utilizar la compresión de datos como un parámetro de referencia para la "inteligencia general". [25] [26] [27]

Una visión alternativa puede mostrar que los algoritmos de compresión mapean implícitamente cadenas en vectores de espacios de características implícitos , y las medidas de similitud basadas en la compresión calculan la similitud dentro de estos espacios de características. Para cada compresor C(.) definimos un espacio vectorial asociado ℵ, de modo que C(.) mapea una cadena de entrada x, correspondiente a la norma vectorial ||~x||. Un examen exhaustivo de los espacios de características subyacentes a todos los algoritmos de compresión se ve impedido por el espacio; en su lugar, los vectores de características eligen examinar tres métodos de compresión sin pérdida representativos, LZW, LZ77 y PPM. [28]

Según la teoría AIXI , una conexión explicada de forma más directa en Hutter Prize , la mejor compresión posible de x es el software más pequeño posible que genera x. Por ejemplo, en ese modelo, el tamaño comprimido de un archivo zip incluye tanto el archivo zip como el software de descompresión, ya que no se puede descomprimir sin ambos, pero puede haber una forma combinada aún más pequeña.

Algunos ejemplos de software de compresión de audio y video impulsado por IA incluyen NVIDIA Maxine y AIVC. [29] Algunos ejemplos de software que pueden realizar compresión de imágenes impulsada por IA incluyen OpenCV , TensorFlow , Image Processing Toolbox (IPT) de MATLAB y High-Fidelity Generative Image Compression. [30]

En el aprendizaje automático no supervisado , la agrupación en clústeres de k-medias se puede utilizar para comprimir datos mediante la agrupación de puntos de datos similares en clústeres. Esta técnica simplifica el manejo de conjuntos de datos extensos que carecen de etiquetas predefinidas y se usa ampliamente en campos como la compresión de imágenes . [31]

La compresión de datos tiene como objetivo reducir el tamaño de los archivos de datos, mejorando la eficiencia de almacenamiento y acelerando la transmisión de datos. La agrupación en k-medias, un algoritmo de aprendizaje automático no supervisado, se emplea para particionar un conjunto de datos en un número específico de grupos, k, cada uno representado por el centroide de sus puntos. Este proceso condensa conjuntos de datos extensos en un conjunto más compacto de puntos representativos. Particularmente beneficioso en el procesamiento de imágenes y señales , la agrupación en k-medias ayuda en la reducción de datos al reemplazar grupos de puntos de datos con sus centroides, preservando así la información central de los datos originales mientras disminuye significativamente el espacio de almacenamiento requerido. [32]

Los modelos de lenguaje de gran tamaño (LLM) también son capaces de comprimir datos sin pérdida, como lo demuestra la investigación de DeepMind con el modelo Chinchilla 70B. Desarrollado por DeepMind, Chinchilla 70B comprimió datos de manera efectiva, superando los métodos convencionales como Portable Network Graphics (PNG) para imágenes y Free Lossless Audio Codec (FLAC) para audio. Logró una compresión de datos de imagen y audio al 43,4% y 16,4% de sus tamaños originales, respectivamente. [33]El aprendizaje automático y la minería de datos suelen emplear los mismos métodos y se superponen significativamente, pero mientras que el aprendizaje automático se centra en la predicción, basada en propiedades conocidas aprendidas de los datos de entrenamiento, la minería de datos se centra en el descubrimiento de propiedades (previamente) desconocidas en los datos (este es el paso de análisis del descubrimiento de conocimiento en bases de datos). La minería de datos utiliza muchos métodos de aprendizaje automático, pero con diferentes objetivos; por otro lado, el aprendizaje automático también emplea métodos de minería de datos como " aprendizaje no supervisado " o como un paso de preprocesamiento para mejorar la precisión del alumno. Gran parte de la confusión entre estas dos comunidades de investigación (que a menudo tienen conferencias y revistas independientes, siendo ECML PKDD una excepción importante) proviene de los supuestos básicos con los que trabajan: en el aprendizaje automático, el rendimiento generalmente se evalúa con respecto a la capacidad de reproducir el conocimiento conocido , mientras que en el descubrimiento de conocimiento y la minería de datos (KDD) la tarea clave es el descubrimiento de conocimiento previamente desconocido . Evaluado con respecto al conocimiento conocido, un método no informado (no supervisado) será fácilmente superado por otros métodos supervisados, mientras que en una tarea KDD típica, los métodos supervisados no se pueden utilizar debido a la falta de disponibilidad de datos de entrenamiento.

El aprendizaje automático también tiene vínculos íntimos con la optimización : muchos problemas de aprendizaje se formulan como la minimización de alguna función de pérdida en un conjunto de ejemplos de entrenamiento. Las funciones de pérdida expresan la discrepancia entre las predicciones del modelo que se está entrenando y las instancias reales del problema (por ejemplo, en la clasificación, se desea asignar una etiqueta a las instancias y los modelos se entrenan para predecir correctamente las etiquetas preasignadas de un conjunto de ejemplos). [34]

Caracterizar la generalización de varios algoritmos de aprendizaje es un tema activo de investigación actual, especialmente para los algoritmos de aprendizaje profundo .

El aprendizaje automático y la estadística son campos estrechamente relacionados en términos de métodos, pero distintos en su objetivo principal: la estadística extrae inferencias poblacionales de una muestra , mientras que el aprendizaje automático encuentra patrones predictivos generalizables. [35] Según Michael I. Jordan , las ideas del aprendizaje automático, desde los principios metodológicos hasta las herramientas teóricas, tienen una larga prehistoria en la estadística. [36] También sugirió el término ciencia de datos como un marcador de posición para llamar al campo en general. [36]

Los análisis estadísticos convencionales requieren la selección a priori de un modelo más adecuado para el conjunto de datos de estudio. Además, solo se incluyen para el análisis variables significativas o teóricamente relevantes basadas en la experiencia previa. Por el contrario, el aprendizaje automático no se basa en un modelo preestructurado; más bien, los datos dan forma al modelo detectando patrones subyacentes. Cuantas más variables (entradas) se utilicen para entrenar el modelo, más preciso será el modelo final. [37]

Leo Breiman distinguió dos paradigmas de modelado estadístico: modelo de datos y modelo algorítmico, [38] donde "modelo algorítmico" significa más o menos los algoritmos de aprendizaje automático como Random Forest .

Algunos estadísticos han adoptado métodos del aprendizaje automático, dando lugar a un campo combinado al que denominan aprendizaje estadístico . [39]

Las técnicas analíticas y computacionales derivadas de la física profunda de sistemas desordenados se pueden extender a problemas de gran escala, incluido el aprendizaje automático, por ejemplo, para analizar el espacio de peso de redes neuronales profundas . [40] Por lo tanto, la física estadística está encontrando aplicaciones en el área de diagnóstico médico . [41]

Un objetivo central de un aprendiz es generalizar a partir de su experiencia. [5] [42] La generalización en este contexto es la capacidad de una máquina de aprendizaje de realizar tareas o ejemplos nuevos e inéditos con precisión después de haber experimentado un conjunto de datos de aprendizaje. Los ejemplos de entrenamiento provienen de una distribución de probabilidad generalmente desconocida (considerada representativa del espacio de ocurrencias) y el aprendiz tiene que construir un modelo general sobre este espacio que le permita producir predicciones suficientemente precisas en nuevos casos.

El análisis computacional de los algoritmos de aprendizaje automático y su desempeño es una rama de la informática teórica conocida como teoría del aprendizaje computacional a través del modelo de aprendizaje probablemente aproximadamente correcto (PAC). Debido a que los conjuntos de entrenamiento son finitos y el futuro es incierto, la teoría del aprendizaje generalmente no ofrece garantías del desempeño de los algoritmos. En cambio, los límites probabilísticos del desempeño son bastante comunes. La descomposición de sesgo-varianza es una forma de cuantificar el error de generalización .

Para obtener el mejor rendimiento en el contexto de la generalización, la complejidad de la hipótesis debe coincidir con la complejidad de la función subyacente a los datos. Si la hipótesis es menos compleja que la función, entonces el modelo ha ajustado por debajo de los datos. Si la complejidad del modelo aumenta en respuesta, entonces el error de entrenamiento disminuye. Pero si la hipótesis es demasiado compleja, entonces el modelo está sujeto a un sobreajuste y la generalización será peor. [43]

Además de los límites de rendimiento, los teóricos del aprendizaje estudian la complejidad temporal y la viabilidad del aprendizaje. En la teoría del aprendizaje computacional, un cálculo se considera factible si se puede realizar en tiempo polinomial . Hay dos tipos de resultados de complejidad temporal : los resultados positivos muestran que una determinada clase de funciones se puede aprender en tiempo polinomial. Los resultados negativos muestran que determinadas clases no se pueden aprender en tiempo polinomial.

Los enfoques de aprendizaje automático se dividen tradicionalmente en tres grandes categorías, que corresponden a paradigmas de aprendizaje, dependiendo de la naturaleza de la "señal" o "retroalimentación" disponible para el sistema de aprendizaje:

Aunque cada algoritmo tiene ventajas y limitaciones, ningún algoritmo funciona para todos los problemas. [44] [45] [46]

Los algoritmos de aprendizaje supervisado construyen un modelo matemático de un conjunto de datos que contiene tanto las entradas como las salidas deseadas. [47] Los datos, conocidos como datos de entrenamiento , consisten en un conjunto de ejemplos de entrenamiento. Cada ejemplo de entrenamiento tiene una o más entradas y la salida deseada, también conocida como señal de supervisión. En el modelo matemático, cada ejemplo de entrenamiento está representado por una matriz o vector, a veces llamado vector de características , y los datos de entrenamiento están representados por una matriz . A través de la optimización iterativa de una función objetivo , los algoritmos de aprendizaje supervisado aprenden una función que se puede utilizar para predecir la salida asociada con nuevas entradas. [48] Una función óptima permite que el algoritmo determine correctamente la salida para entradas que no formaban parte de los datos de entrenamiento. Se dice que un algoritmo que mejora la precisión de sus salidas o predicciones con el tiempo ha aprendido a realizar esa tarea. [18]

Los tipos de algoritmos de aprendizaje supervisado incluyen el aprendizaje activo , la clasificación y la regresión . [49] Los algoritmos de clasificación se utilizan cuando los resultados están restringidos a un conjunto limitado de valores, y los algoritmos de regresión se utilizan cuando los resultados pueden tener cualquier valor numérico dentro de un rango. Como ejemplo, para un algoritmo de clasificación que filtra correos electrónicos, la entrada sería un correo electrónico entrante y la salida sería el nombre de la carpeta en la que se archiva el correo electrónico. Ejemplos de regresión serían predecir la altura de una persona o la temperatura futura. [50]

El aprendizaje por similitud es un área del aprendizaje automático supervisado estrechamente relacionada con la regresión y la clasificación, pero el objetivo es aprender de ejemplos utilizando una función de similitud que mide qué tan similares o relacionados son dos objetos. Tiene aplicaciones en la clasificación , los sistemas de recomendación , el seguimiento de la identidad visual, la verificación facial y la verificación del hablante.

Los algoritmos de aprendizaje no supervisado encuentran estructuras en datos que no han sido etiquetados, clasificados o categorizados. En lugar de responder a la retroalimentación, los algoritmos de aprendizaje no supervisado identifican puntos en común en los datos y reaccionan en función de la presencia o ausencia de dichos puntos en común en cada nuevo dato. Las aplicaciones centrales del aprendizaje automático no supervisado incluyen la agrupación, la reducción de la dimensionalidad [7] y la estimación de la densidad [51] . Los algoritmos de aprendizaje no supervisado también agilizaron el proceso de identificación de grandes haplotipos basados en indel de un gen de interés a partir de un genoma completo [52] .

El análisis de conglomerados es la asignación de un conjunto de observaciones en subconjuntos (llamados conglomerados ) de modo que las observaciones dentro del mismo conglomerado sean similares de acuerdo con uno o más criterios predeterminados, mientras que las observaciones extraídas de diferentes conglomerados sean diferentes. Las diferentes técnicas de agrupamiento hacen diferentes suposiciones sobre la estructura de los datos, a menudo definidas por alguna métrica de similitud y evaluadas, por ejemplo, por la compacidad interna , o la similitud entre los miembros del mismo conglomerado, y la separación , la diferencia entre conglomerados. Otros métodos se basan en la densidad estimada y la conectividad de gráficos .

Un tipo especial de aprendizaje no supervisado, llamado aprendizaje autosupervisado , implica entrenar un modelo generando la señal de supervisión a partir de los propios datos. [54] [55]

El aprendizaje semisupervisado se encuentra entre el aprendizaje no supervisado (sin datos de entrenamiento etiquetados) y el aprendizaje supervisado (con datos de entrenamiento completamente etiquetados). A algunos de los ejemplos de entrenamiento les faltan etiquetas de entrenamiento, pero muchos investigadores de aprendizaje automático han descubierto que los datos no etiquetados, cuando se utilizan junto con una pequeña cantidad de datos etiquetados, pueden producir una mejora considerable en la precisión del aprendizaje.

En el aprendizaje débilmente supervisado , las etiquetas de entrenamiento son ruidosas, limitadas o imprecisas; sin embargo, estas etiquetas suelen ser más baratas de obtener, lo que da como resultado conjuntos de entrenamiento efectivos más grandes. [56]

El aprendizaje por refuerzo es un área del aprendizaje automático que se ocupa de cómo los agentes de software deben tomar acciones en un entorno para maximizar alguna noción de recompensa acumulativa. Debido a su generalidad, el campo se estudia en muchas otras disciplinas, como la teoría de juegos , la teoría de control , la investigación de operaciones , la teoría de la información , la optimización basada en simulación , los sistemas multiagente , la inteligencia de enjambre , las estadísticas y los algoritmos genéticos . En el aprendizaje por refuerzo, el entorno se representa típicamente como un proceso de decisión de Markov (MDP). Muchos algoritmos de aprendizaje por refuerzo utilizan técnicas de programación dinámica . [57] Los algoritmos de aprendizaje por refuerzo no suponen el conocimiento de un modelo matemático exacto del MDP y se utilizan cuando los modelos exactos son inviables. Los algoritmos de aprendizaje por refuerzo se utilizan en vehículos autónomos o para aprender a jugar un juego contra un oponente humano.

La reducción de dimensionalidad es un proceso de reducción del número de variables aleatorias bajo consideración mediante la obtención de un conjunto de variables principales. [58] En otras palabras, es un proceso de reducción de la dimensión del conjunto de características , también llamado "número de características". La mayoría de las técnicas de reducción de dimensionalidad pueden considerarse como eliminación o extracción de características . Uno de los métodos populares de reducción de dimensionalidad es el análisis de componentes principales (PCA). El PCA implica cambiar datos de mayor dimensión (por ejemplo, 3D) a un espacio más pequeño (por ejemplo, 2D). La hipótesis de la variedad propone que los conjuntos de datos de alta dimensión se encuentran a lo largo de variedades de baja dimensión , y muchas técnicas de reducción de dimensionalidad hacen esta suposición, lo que conduce al área de aprendizaje de variedades y regularización de variedades .

Se han desarrollado otros enfoques que no encajan perfectamente en esta triple categorización y, a veces, el mismo sistema de aprendizaje automático utiliza más de uno. Por ejemplo, el modelado de temas y el metaaprendizaje . [59]

El autoaprendizaje, como paradigma de aprendizaje automático, se introdujo en 1982 junto con una red neuronal capaz de autoaprender, denominada matriz adaptativa de barras cruzadas (CAA). [60] Se trata de un aprendizaje sin recompensas externas ni consejos externos del profesor. El algoritmo de autoaprendizaje CAA calcula, en forma de barras cruzadas, tanto las decisiones sobre acciones como las emociones (sentimientos) sobre situaciones de consecuencias. El sistema está impulsado por la interacción entre la cognición y la emoción. [61] El algoritmo de autoaprendizaje actualiza una matriz de memoria W =||w(a,s)|| de modo que en cada iteración ejecuta la siguiente rutina de aprendizaje automático:

Es un sistema con una sola entrada, situación, y una sola salida, acción (o conducta) a. No hay una entrada de refuerzo separada ni una entrada de consejo del entorno. El valor retropropagado (refuerzo secundario) es la emoción hacia la situación de consecuencia. El CAA existe en dos entornos, uno es el entorno conductual donde se comporta, y el otro es el entorno genético, de donde inicialmente y solo una vez recibe emociones iniciales sobre situaciones que se encontrarán en el entorno conductual. Después de recibir el vector del genoma (especie) del entorno genético, el CAA aprende una conducta de búsqueda de objetivos, en un entorno que contiene situaciones tanto deseables como indeseables. [62]

Varios algoritmos de aprendizaje tienen como objetivo descubrir mejores representaciones de las entradas proporcionadas durante el entrenamiento. [63] Los ejemplos clásicos incluyen el análisis de componentes principales y el análisis de conglomerados. Los algoritmos de aprendizaje de características, también llamados algoritmos de aprendizaje de representación, a menudo intentan preservar la información en su entrada, pero también transformarla de una manera que la haga útil, a menudo como un paso de preprocesamiento antes de realizar la clasificación o las predicciones. Esta técnica permite la reconstrucción de las entradas que provienen de la distribución generadora de datos desconocida, aunque no es necesariamente fiel a las configuraciones que son inverosímiles bajo esa distribución. Esto reemplaza la ingeniería de características manual y permite que una máquina aprenda las características y las use para realizar una tarea específica.

El aprendizaje de características puede ser supervisado o no supervisado. En el aprendizaje de características supervisado, las características se aprenden utilizando datos de entrada etiquetados. Los ejemplos incluyen redes neuronales artificiales , perceptrones multicapa y aprendizaje de diccionario supervisado . En el aprendizaje de características no supervisado, las características se aprenden con datos de entrada no etiquetados. Los ejemplos incluyen aprendizaje de diccionario, análisis de componentes independientes , autocodificadores , factorización matricial [64] y varias formas de agrupamiento . [65] [66] [67]

Los algoritmos de aprendizaje múltiple intentan hacerlo bajo la restricción de que la representación aprendida es de baja dimensión. Los algoritmos de codificación dispersa intentan hacerlo bajo la restricción de que la representación aprendida es dispersa, lo que significa que el modelo matemático tiene muchos ceros. Los algoritmos de aprendizaje de subespacios multilineales apuntan a aprender representaciones de baja dimensión directamente de representaciones tensoriales para datos multidimensionales, sin remodelarlos en vectores de dimensiones superiores. [68] Los algoritmos de aprendizaje profundo descubren múltiples niveles de representación, o una jerarquía de características, con características de nivel superior, más abstractas definidas en términos de (o generando) características de nivel inferior. Se ha argumentado que una máquina inteligente es aquella que aprende una representación que desenreda los factores subyacentes de variación que explican los datos observados. [69]

El aprendizaje de características está motivado por el hecho de que las tareas de aprendizaje automático, como la clasificación, a menudo requieren datos que sean matemática y computacionalmente convenientes para procesar. Sin embargo, los datos del mundo real, como imágenes, videos y datos sensoriales, no han dado lugar a intentos de definir algorítmicamente características específicas. Una alternativa es descubrir dichas características o representaciones mediante el examen, sin depender de algoritmos explícitos.

El aprendizaje de diccionario disperso es un método de aprendizaje de características en el que un ejemplo de entrenamiento se representa como una combinación lineal de funciones base y se supone que es una matriz dispersa . El método es fuertemente NP-hard y difícil de resolver de forma aproximada. [70] Un método heurístico popular para el aprendizaje de diccionario disperso es el algoritmo k -SVD . El aprendizaje de diccionario disperso se ha aplicado en varios contextos. En la clasificación, el problema es determinar la clase a la que pertenece un ejemplo de entrenamiento no visto previamente. Para un diccionario donde ya se ha construido cada clase, se asocia un nuevo ejemplo de entrenamiento con la clase que está mejor representada de forma dispersa por el diccionario correspondiente. El aprendizaje de diccionario disperso también se ha aplicado en la eliminación de ruido de imágenes . La idea clave es que un parche de imagen limpio puede ser representado de forma dispersa por un diccionario de imágenes, pero el ruido no. [71]

En la minería de datos , la detección de anomalías, también conocida como detección de valores atípicos, es la identificación de elementos, eventos u observaciones raros que generan sospechas al diferir significativamente de la mayoría de los datos. [72] Por lo general, los elementos anómalos representan un problema como un fraude bancario , un defecto estructural, problemas médicos o errores en un texto. Las anomalías se conocen como valores atípicos , novedades, ruido, desviaciones y excepciones. [73]

En particular, en el contexto de la detección de abusos e intrusiones en la red, los objetos interesantes no suelen ser objetos raros, sino estallidos inesperados de inactividad. Este patrón no se ajusta a la definición estadística común de un valor atípico como un objeto raro. Muchos métodos de detección de valores atípicos (en particular, algoritmos no supervisados) fallarán con dichos datos a menos que se agreguen adecuadamente. En cambio, un algoritmo de análisis de conglomerados puede ser capaz de detectar los microconglomerados formados por estos patrones. [74]

Existen tres categorías amplias de técnicas de detección de anomalías. [75] Las técnicas de detección de anomalías no supervisadas detectan anomalías en un conjunto de datos de prueba sin etiquetar bajo el supuesto de que la mayoría de las instancias en el conjunto de datos son normales, buscando instancias que parezcan ajustarse menos al resto del conjunto de datos. Las técnicas de detección de anomalías supervisadas requieren un conjunto de datos que haya sido etiquetado como "normal" y "anormal" e implican el entrenamiento de un clasificador (la diferencia clave con muchos otros problemas de clasificación estadística es la naturaleza inherentemente desequilibrada de la detección de valores atípicos). Las técnicas de detección de anomalías semisupervisadas construyen un modelo que representa el comportamiento normal a partir de un conjunto de datos de entrenamiento normal dado y luego prueban la probabilidad de que el modelo genere una instancia de prueba.

El aprendizaje robótico se inspira en una multitud de métodos de aprendizaje automático, empezando por el aprendizaje supervisado, el aprendizaje de refuerzo, [76] [77] y finalmente el metaaprendizaje (por ejemplo, MAML).

El aprendizaje de reglas de asociación es un método de aprendizaje automático basado en reglas para descubrir relaciones entre variables en bases de datos grandes. Su objetivo es identificar reglas sólidas descubiertas en bases de datos utilizando alguna medida de "interés". [78]

El aprendizaje automático basado en reglas es un término general para cualquier método de aprendizaje automático que identifica, aprende o desarrolla "reglas" para almacenar, manipular o aplicar conocimiento. La característica definitoria de un algoritmo de aprendizaje automático basado en reglas es la identificación y utilización de un conjunto de reglas relacionales que representan colectivamente el conocimiento capturado por el sistema. Esto contrasta con otros algoritmos de aprendizaje automático que comúnmente identifican un modelo singular que se puede aplicar universalmente a cualquier instancia para hacer una predicción. [79] Los enfoques de aprendizaje automático basados en reglas incluyen sistemas de clasificación de aprendizaje , aprendizaje de reglas de asociación y sistemas inmunológicos artificiales .

Basándose en el concepto de reglas fuertes, Rakesh Agrawal , Tomasz Imieliński y Arun Swami introdujeron reglas de asociación para descubrir regularidades entre productos en datos de transacciones a gran escala registrados por sistemas de puntos de venta (POS) en supermercados. [80] Por ejemplo, la regla encontrada en los datos de ventas de un supermercado indicaría que si un cliente compra cebollas y patatas juntas, es probable que también compre carne de hamburguesa. Dicha información se puede utilizar como base para decisiones sobre actividades de marketing, como precios promocionales o ubicaciones de productos . Además del análisis de la cesta de la compra , las reglas de asociación se emplean hoy en día en áreas de aplicación que incluyen la minería de uso web , la detección de intrusiones , la producción continua y la bioinformática . A diferencia de la minería de secuencias , el aprendizaje de reglas de asociación normalmente no considera el orden de los artículos ni dentro de una transacción ni entre transacciones.

Los sistemas de clasificación de aprendizaje (LCS) son una familia de algoritmos de aprendizaje automático basados en reglas que combinan un componente de descubrimiento, normalmente un algoritmo genético , con un componente de aprendizaje, realizando aprendizaje supervisado , aprendizaje de refuerzo o aprendizaje no supervisado . Buscan identificar un conjunto de reglas dependientes del contexto que almacenan y aplican colectivamente el conocimiento de manera fragmentada para hacer predicciones. [81]

La programación lógica inductiva (ILP) es un enfoque para el aprendizaje de reglas que utiliza la programación lógica como una representación uniforme para ejemplos de entrada, conocimiento previo e hipótesis. Dada una codificación del conocimiento previo conocido y un conjunto de ejemplos representados como una base de datos lógica de hechos, un sistema ILP derivará un programa lógico hipotético que implica todos los ejemplos positivos y ningún ejemplo negativo. La programación inductiva es un campo relacionado que considera cualquier tipo de lenguaje de programación para representar hipótesis (y no solo programación lógica), como programas funcionales .

La programación lógica inductiva es particularmente útil en bioinformática y procesamiento del lenguaje natural . Gordon Plotkin y Ehud Shapiro sentaron las bases teóricas iniciales para el aprendizaje automático inductivo en un entorno lógico. [82] [83] [84] Shapiro construyó su primera implementación (Model Inference System) en 1981: un programa Prolog que infería inductivamente programas lógicos a partir de ejemplos positivos y negativos. [85] El término inductivo aquí se refiere a la inducción filosófica , que sugiere una teoría para explicar hechos observados, en lugar de la inducción matemática , que demuestra una propiedad para todos los miembros de un conjunto bien ordenado.

AUn modelo de aprendizaje automático es un tipo demodelo matemáticoque, después de ser "entrenado" en un conjunto de datos determinado, puede usarse para hacer predicciones o clasificaciones sobre nuevos datos. Durante el entrenamiento, un algoritmo de aprendizaje ajusta iterativamente los parámetros internos del modelo para minimizar los errores en sus predicciones.[86]Por extensión, el término "modelo" puede referirse a varios niveles de especificidad, desde una clase general de modelos y sus algoritmos de aprendizaje asociados hasta un modelo completamente entrenado con todos sus parámetros internos ajustados.[87]

Se han utilizado e investigado varios tipos de modelos para los sistemas de aprendizaje automático; elegir el mejor modelo para una tarea se denomina selección de modelo .

Las redes neuronales artificiales (RNA), o sistemas conexionistas , son sistemas informáticos vagamente inspirados en las redes neuronales biológicas que constituyen los cerebros animales . Estos sistemas "aprenden" a realizar tareas considerando ejemplos, generalmente sin estar programados con reglas específicas para la tarea.

Una ANN es un modelo basado en una colección de unidades o nodos conectados llamados " neuronas artificiales ", que modelan libremente las neuronas en un cerebro biológico. Cada conexión, como las sinapsis en un cerebro biológico, puede transmitir información, una "señal", de una neurona artificial a otra. Una neurona artificial que recibe una señal puede procesarla y luego enviar una señal a neuronas artificiales adicionales conectadas a ella. En las implementaciones comunes de ANN, la señal en una conexión entre neuronas artificiales es un número real , y la salida de cada neurona artificial se calcula mediante alguna función no lineal de la suma de sus entradas. Las conexiones entre neuronas artificiales se denominan "bordes". Las neuronas artificiales y los bordes suelen tener un peso que se ajusta a medida que avanza el aprendizaje. El peso aumenta o disminuye la fuerza de la señal en una conexión. Las neuronas artificiales pueden tener un umbral de modo que la señal solo se envíe si la señal agregada cruza ese umbral. Normalmente, las neuronas artificiales se agregan en capas. Diferentes capas pueden realizar diferentes tipos de transformaciones en sus entradas. Las señales viajan desde la primera capa (la capa de entrada) a la última capa (la capa de salida), posiblemente después de atravesar las capas varias veces.

El objetivo original del enfoque ANN era resolver problemas de la misma manera que lo haría un cerebro humano . Sin embargo, con el tiempo, la atención se desplazó a la realización de tareas específicas, lo que llevó a desviaciones de la biología . Las redes neuronales artificiales se han utilizado en una variedad de tareas, incluida la visión artificial , el reconocimiento de voz , la traducción automática , el filtrado de redes sociales , los juegos de mesa y de video y el diagnóstico médico .

El aprendizaje profundo consta de múltiples capas ocultas en una red neuronal artificial. Este enfoque intenta modelar la forma en que el cerebro humano procesa la luz y el sonido para transformarlos en visión y audición. Algunas aplicaciones exitosas del aprendizaje profundo son la visión artificial y el reconocimiento de voz. [88]

El aprendizaje de árboles de decisión utiliza un árbol de decisión como modelo predictivo para pasar de las observaciones sobre un elemento (representado en las ramas) a las conclusiones sobre el valor objetivo del elemento (representado en las hojas). Es uno de los enfoques de modelado predictivo utilizados en estadística, minería de datos y aprendizaje automático. Los modelos de árbol donde la variable objetivo puede tomar un conjunto discreto de valores se denominan árboles de clasificación; en estas estructuras de árbol, las hojas representan etiquetas de clase y las ramas representan conjunciones de características que conducen a esas etiquetas de clase. Los árboles de decisión donde la variable objetivo puede tomar valores continuos (normalmente números reales ) se denominan árboles de regresión. En el análisis de decisiones, un árbol de decisión se puede utilizar para representar visual y explícitamente las decisiones y la toma de decisiones . En la minería de datos, un árbol de decisión describe los datos, pero el árbol de clasificación resultante puede ser una entrada para la toma de decisiones.

Las máquinas de vectores de soporte (SVM), también conocidas como redes de vectores de soporte, son un conjunto de métodos de aprendizaje supervisado relacionados que se utilizan para la clasificación y la regresión. Dado un conjunto de ejemplos de entrenamiento, cada uno marcado como perteneciente a una de dos categorías, un algoritmo de entrenamiento SVM construye un modelo que predice si un nuevo ejemplo cae en una categoría. [89] Un algoritmo de entrenamiento SVM es un clasificador lineal , binario y no probabilístico , aunque existen métodos como el escalamiento de Platt para usar SVM en un entorno de clasificación probabilística. Además de realizar una clasificación lineal, las SVM pueden realizar de manera eficiente una clasificación no lineal utilizando lo que se llama el truco del núcleo , mapeando implícitamente sus entradas en espacios de características de alta dimensión.

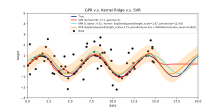

El análisis de regresión abarca una gran variedad de métodos estadísticos para estimar la relación entre las variables de entrada y sus características asociadas. Su forma más común es la regresión lineal , donde se dibuja una sola línea para ajustar mejor los datos dados de acuerdo con un criterio matemático como los mínimos cuadrados ordinarios . Este último a menudo se extiende mediante métodos de regularización para mitigar el sobreajuste y el sesgo, como en la regresión de cresta . Cuando se trata de problemas no lineales, los modelos a los que se recurre incluyen la regresión polinómica (por ejemplo, utilizada para el ajuste de líneas de tendencia en Microsoft Excel [90] ), la regresión logística (a menudo utilizada en la clasificación estadística ) o incluso la regresión kernel , que introduce la no linealidad al aprovechar el truco del kernel para mapear implícitamente las variables de entrada a un espacio de mayor dimensión.

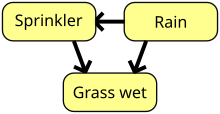

Una red bayesiana, red de creencias o modelo gráfico acíclico dirigido es un modelo gráfico probabilístico que representa un conjunto de variables aleatorias y su independencia condicional con un gráfico acíclico dirigido (DAG). Por ejemplo, una red bayesiana podría representar las relaciones probabilísticas entre enfermedades y síntomas. Dados los síntomas, la red se puede utilizar para calcular las probabilidades de presencia de varias enfermedades. Existen algoritmos eficientes que realizan inferencia y aprendizaje. Las redes bayesianas que modelan secuencias de variables, como señales de voz o secuencias de proteínas , se denominan redes bayesianas dinámicas . Las generalizaciones de redes bayesianas que pueden representar y resolver problemas de decisión en condiciones de incertidumbre se denominan diagramas de influencia .

Un proceso gaussiano es un proceso estocástico en el que cada colección finita de variables aleatorias en el proceso tiene una distribución normal multivariada y se basa en una función de covarianza predefinida , o kernel, que modela cómo los pares de puntos se relacionan entre sí dependiendo de sus ubicaciones.

Dado un conjunto de puntos observados, o ejemplos de entrada-salida, la distribución de la salida (no observada) de un nuevo punto en función de sus datos de entrada se puede calcular directamente observando los puntos observados y las covarianzas entre esos puntos y el nuevo punto no observado.

Los procesos gaussianos son modelos sustitutos populares en la optimización bayesiana que se utilizan para realizar optimización de hiperparámetros .

Un algoritmo genético (AG) es un algoritmo de búsqueda y una técnica heurística que imita el proceso de selección natural , utilizando métodos como la mutación y el cruce para generar nuevos genotipos con la esperanza de encontrar buenas soluciones a un problema determinado. En el aprendizaje automático, los algoritmos genéticos se utilizaron en las décadas de 1980 y 1990. [92] [93] Por el contrario, las técnicas de aprendizaje automático se han utilizado para mejorar el rendimiento de los algoritmos genéticos y evolutivos . [94]

La teoría de las funciones de creencia, también conocida como teoría de la evidencia o teoría de Dempster-Shafer, es un marco general para razonar con incertidumbre, con conexiones entendidas con otros marcos como las teorías de probabilidad , posibilidad y probabilidad imprecisa . Estos marcos teóricos pueden considerarse como una especie de aprendiz y tienen algunas propiedades análogas de cómo se combina la evidencia (por ejemplo, la regla de combinación de Dempster), al igual que cómo en un enfoque bayesiano basado en pmf [ aclaración necesaria ] se combinarían probabilidades. Sin embargo, existen muchas salvedades para estas funciones de creencia en comparación con los enfoques bayesianos para incorporar la ignorancia y la cuantificación de la incertidumbre . Estos enfoques de función de creencia que se implementan dentro del dominio del aprendizaje automático generalmente aprovechan un enfoque de fusión de varios métodos de conjunto para manejar mejor el límite de decisión del alumno , las muestras bajas y los problemas de clase ambiguos que el enfoque de aprendizaje automático estándar tiende a tener dificultades para resolver. [4] [9] Sin embargo, la complejidad computacional de estos algoritmos depende del número de proposiciones (clases) y puede generar un tiempo de cálculo mucho mayor en comparación con otros enfoques de aprendizaje automático.

Por lo general, los modelos de aprendizaje automático requieren una gran cantidad de datos confiables para realizar predicciones precisas. Al entrenar un modelo de aprendizaje automático, los ingenieros de aprendizaje automático deben apuntar y recopilar una muestra grande y representativa de datos. Los datos del conjunto de entrenamiento pueden ser tan variados como un corpus de texto , una colección de imágenes, datos de sensores y datos recopilados de usuarios individuales de un servicio. El sobreajuste es algo a tener en cuenta al entrenar un modelo de aprendizaje automático. Los modelos entrenados derivados de datos sesgados o no evaluados pueden dar como resultado predicciones sesgadas o no deseadas. Los modelos sesgados pueden dar como resultado resultados perjudiciales, lo que aumenta los impactos negativos en la sociedad o los objetivos. El sesgo algorítmico es un resultado potencial de que los datos no estén completamente preparados para el entrenamiento. La ética del aprendizaje automático se está convirtiendo en un campo de estudio y, en particular, se está integrando en los equipos de ingeniería de aprendizaje automático.

El aprendizaje federado es una forma adaptada de inteligencia artificial distribuida para entrenar modelos de aprendizaje automático que descentraliza el proceso de entrenamiento, lo que permite mantener la privacidad de los usuarios al no tener que enviar sus datos a un servidor centralizado. Esto también aumenta la eficiencia al descentralizar el proceso de entrenamiento a muchos dispositivos. Por ejemplo, Gboard utiliza el aprendizaje automático federado para entrenar modelos de predicción de consultas de búsqueda en los teléfonos móviles de los usuarios sin tener que enviar búsquedas individuales a Google . [95]

Existen muchas aplicaciones para el aprendizaje automático, entre ellas:

En 2006, el proveedor de servicios multimedia Netflix celebró el primer concurso " Netflix Prize " para encontrar un programa que predijera mejor las preferencias de los usuarios y mejorara la precisión de su algoritmo de recomendación de películas Cinematch existente en al menos un 10%. Un equipo conjunto formado por investigadores de AT&T Labs -Research en colaboración con los equipos Big Chaos y Pragmatic Theory construyó un modelo de conjunto para ganar el Gran Premio en 2009 por $ 1 millón. [98] Poco después de que se otorgara el premio, Netflix se dio cuenta de que las calificaciones de los espectadores no eran los mejores indicadores de sus patrones de visualización ("todo es una recomendación") y cambiaron su motor de recomendación en consecuencia. [99] En 2010, The Wall Street Journal escribió sobre la firma Rebellion Research y su uso del aprendizaje automático para predecir la crisis financiera. [100] En 2012, el cofundador de Sun Microsystems , Vinod Khosla , predijo que el 80% de los trabajos de los médicos se perderían en las próximas dos décadas debido al software de diagnóstico médico de aprendizaje automático automatizado. [101] En 2014, se informó que se había aplicado un algoritmo de aprendizaje automático en el campo de la historia del arte para estudiar pinturas de bellas artes y que puede haber revelado influencias previamente no reconocidas entre los artistas. [102] En 2019, Springer Nature publicó el primer libro de investigación creado utilizando aprendizaje automático. [103] En 2020, se utilizó la tecnología de aprendizaje automático para ayudar a realizar diagnósticos y ayudar a los investigadores a desarrollar una cura para COVID-19. [104] El aprendizaje automático se aplicó recientemente para predecir el comportamiento proambiental de los viajeros. [105] Recientemente, la tecnología de aprendizaje automático también se aplicó para optimizar el rendimiento y el comportamiento térmico de los teléfonos inteligentes en función de la interacción del usuario con el teléfono. [106] [107] [108] Cuando se aplican correctamente, los algoritmos de aprendizaje automático (MLA) pueden utilizar una amplia gama de características de la empresa para predecir el rendimiento de las acciones sin sobreajuste . Al emplear una ingeniería de características eficaz y combinar pronósticos, los MLA pueden generar resultados que superan con creces los obtenidos con técnicas lineales básicas como OLS . [109]

Los recientes avances en el aprendizaje automático se han extendido al campo de la química cuántica, donde nuevos algoritmos ahora permiten predecir los efectos de los solventes en las reacciones químicas, ofreciendo así nuevas herramientas para que los químicos adapten las condiciones experimentales para obtener resultados óptimos. [110]

El aprendizaje automático se está convirtiendo en una herramienta útil para investigar y predecir la toma de decisiones de evacuación en desastres a gran y pequeña escala. Se han probado diferentes soluciones para predecir si los propietarios de viviendas deciden evacuar durante incendios forestales y huracanes y cuándo lo hacen. [111] [112] [113] Otras aplicaciones se han centrado en las decisiones previas a la evacuación en incendios de edificios. [114] [115]

Aunque el aprendizaje automático ha sido transformador en algunos campos, los programas de aprendizaje automático a menudo no logran ofrecer los resultados esperados. [116] [117] [118] Las razones para esto son numerosas: falta de datos (adecuados), falta de acceso a los datos, sesgo de datos, problemas de privacidad, tareas y algoritmos mal elegidos, herramientas y personas equivocadas, falta de recursos y problemas de evaluación. [119]

La " teoría de la caja negra " plantea otro desafío, aunque significativo. La caja negra se refiere a una situación en la que el algoritmo o el proceso de producción de un resultado es completamente opaco, lo que significa que ni siquiera los codificadores del algoritmo pueden auditar el patrón que la máquina extrajo de los datos. [120] El Comité Selecto de la Cámara de los Lores, que afirmó que un "sistema de inteligencia" de ese tipo que podría tener un "impacto sustancial en la vida de un individuo" no se consideraría aceptable a menos que proporcionara "una explicación completa y satisfactoria de las decisiones" que toma. [120]

En 2018, un automóvil autónomo de Uber no detectó a un peatón, que murió después de una colisión. [121] Los intentos de utilizar el aprendizaje automático en el ámbito sanitario con el sistema IBM Watson no dieron resultado incluso después de años de tiempo y miles de millones de dólares invertidos. [122] [123] Se ha informado de que el chatbot Bing Chat de Microsoft produce una respuesta hostil y ofensiva contra sus usuarios. [124]

El aprendizaje automático se ha utilizado como estrategia para actualizar la evidencia relacionada con una revisión sistemática y el aumento de la carga de trabajo de los revisores en relación con el crecimiento de la literatura biomédica. Si bien ha mejorado con los conjuntos de entrenamiento, aún no se ha desarrollado lo suficiente como para reducir la carga de trabajo sin limitar la sensibilidad necesaria para la investigación de los hallazgos en sí. [125]

Los distintos enfoques de aprendizaje automático pueden sufrir distintos sesgos en los datos. Un sistema de aprendizaje automático entrenado específicamente con clientes actuales puede no ser capaz de predecir las necesidades de nuevos grupos de clientes que no están representados en los datos de entrenamiento. Cuando se entrena con datos generados por humanos, es probable que el aprendizaje automático detecte los sesgos constitucionales e inconscientes que ya están presentes en la sociedad. [126]

Se ha demostrado que los modelos de lenguaje aprendidos a partir de datos contienen sesgos similares a los humanos. [127] [128] En un experimento llevado a cabo por ProPublica , una organización de periodismo de investigación , la información de un algoritmo de aprendizaje automático sobre las tasas de reincidencia entre los prisioneros marcó falsamente "los acusados negros de alto riesgo con el doble de frecuencia que los acusados blancos". [129] En 2015, Google Photos solía etiquetar a las personas negras como gorilas, [129] y en 2018, esto todavía no se resolvió bien, pero Google, según se informa, todavía estaba usando la solución alternativa para eliminar a todos los gorilas de los datos de entrenamiento y, por lo tanto, no pudo reconocer gorilas reales en absoluto. [130] Se han encontrado problemas similares con el reconocimiento de personas no blancas en muchos otros sistemas. [131] En 2016, Microsoft probó Tay , un chatbot que aprendió de Twitter, y rápidamente captó lenguaje racista y sexista. [132]

Debido a estos desafíos, el uso efectivo del aprendizaje automático puede tardar más en ser adoptado en otros dominios. [133] La preocupación por la equidad en el aprendizaje automático, es decir, reducir el sesgo en el aprendizaje automático e impulsar su uso para el bien humano, es expresada cada vez más por los científicos de inteligencia artificial, incluido Fei-Fei Li , quien recuerda a los ingenieros que "[n]o hay nada artificial en la IA. Está inspirada por las personas, es creada por personas y, lo más importante, impacta en las personas. Es una herramienta poderosa que recién estamos comenzando a comprender, y eso es una profunda responsabilidad". [134]

La IA explicable (XAI), o IA interpretable, o aprendizaje automático explicable (XML), es inteligencia artificial (IA) en la que los humanos pueden comprender las decisiones o predicciones realizadas por la IA. [135] Contrasta con el concepto de "caja negra" en el aprendizaje automático, donde ni siquiera sus diseñadores pueden explicar por qué una IA llegó a una decisión específica. [136] Al refinar los modelos mentales de los usuarios de sistemas impulsados por IA y desmantelar sus conceptos erróneos, la XAI promete ayudar a los usuarios a desempeñarse de manera más efectiva. La XAI puede ser una implementación del derecho social a la explicación.

La adopción de una teoría deficiente y excesivamente compleja manipulada para que se ajuste a todos los datos de entrenamiento anteriores se conoce como sobreajuste. Muchos sistemas intentan reducir el sobreajuste recompensando una teoría de acuerdo con lo bien que se ajusta a los datos, pero penalizándola de acuerdo con lo compleja que es. [137]

Los estudiantes también pueden decepcionarse al "aprender la lección equivocada". Un ejemplo práctico es que un clasificador de imágenes entrenado sólo con imágenes de caballos marrones y gatos negros podría concluir que es probable que todas las manchas marrones sean caballos. [138] Un ejemplo del mundo real es que, a diferencia de los humanos, los clasificadores de imágenes actuales a menudo no realizan juicios principalmente a partir de la relación espacial entre los componentes de la imagen, y aprenden relaciones entre píxeles que los humanos no conocen, pero que aún se correlacionan con imágenes de ciertos tipos de objetos reales. Modificar estos patrones en una imagen legítima puede dar como resultado imágenes "antagónicas" que el sistema clasifica incorrectamente. [139] [140]

Las vulnerabilidades adversarias también pueden resultar en sistemas no lineales o perturbaciones que no siguen patrones. En algunos sistemas, es posible cambiar la salida modificando solo un píxel elegido por el adversario. [141] Los modelos de aprendizaje automático suelen ser vulnerables a la manipulación o evasión a través del aprendizaje automático adversario . [142]

Los investigadores han demostrado cómo se pueden colocar puertas traseras de forma indetectable en modelos de aprendizaje automático de clasificación (por ejemplo, para las categorías "spam" y "no spam" de publicaciones bien visibles) que a menudo son desarrollados y/o entrenados por terceros. Las partes pueden cambiar la clasificación de cualquier entrada, incluso en casos para los que se proporciona un tipo de transparencia de datos/software , posiblemente incluyendo el acceso de caja blanca . [143] [144] [145]

La clasificación de los modelos de aprendizaje automático se puede validar mediante técnicas de estimación de precisión como el método de retención , que divide los datos en un conjunto de entrenamiento y prueba (convencionalmente, designación de conjunto de entrenamiento 2/3 y conjunto de prueba 1/3) y evalúa el rendimiento del modelo de entrenamiento en el conjunto de prueba. En comparación, el método de validación cruzada K-fold divide aleatoriamente los datos en K subconjuntos y luego se realizan K experimentos, cada uno considerando respectivamente 1 subconjunto para la evaluación y los K-1 subconjuntos restantes para entrenar el modelo. Además de los métodos de retención y validación cruzada, se puede utilizar bootstrap , que muestrea n instancias con reemplazo del conjunto de datos, para evaluar la precisión del modelo. [146]

Además de la precisión general, los investigadores informan con frecuencia la sensibilidad y la especificidad , es decir, la tasa de verdaderos positivos (TPR) y la tasa de verdaderos negativos (TNR), respectivamente. De manera similar, los investigadores a veces informan la tasa de falsos positivos (FPR) así como la tasa de falsos negativos (FNR). Sin embargo, estas tasas son proporciones que no revelan sus numeradores y denominadores. La característica operativa total (TOC) es un método eficaz para expresar la capacidad diagnóstica de un modelo. La TOC muestra los numeradores y denominadores de las tasas mencionadas anteriormente, por lo que la TOC proporciona más información que la característica operativa del receptor (ROC) comúnmente utilizada y el área bajo la curva (AUC) asociada a la ROC. [147]

El aprendizaje automático plantea una serie de cuestiones éticas . Los sistemas que se entrenan con conjuntos de datos recopilados con sesgos pueden exhibir estos sesgos al usarlos ( sesgo algorítmico ), digitalizando así los prejuicios culturales. [148] Por ejemplo, en 1988, la Comisión para la Igualdad Racial del Reino Unido descubrió que la Escuela de Medicina de St. George había estado utilizando un programa informático entrenado a partir de datos del personal de admisiones anterior y que este programa había rechazado a casi 60 candidatos que se descubrió que eran mujeres o tenían nombres que no sonaban a europeos. [126] El uso de datos de contratación laboral de una empresa con políticas de contratación racistas puede llevar a un sistema de aprendizaje automático a duplicar el sesgo al calificar a los solicitantes de empleo por similitud con solicitantes exitosos anteriores. [149] [150] Otro ejemplo incluye el algoritmo predictivo de la empresa de vigilancia predictiva Geolitica que resultó en "niveles desproporcionadamente altos de vigilancia excesiva en comunidades de bajos ingresos y minoritarias" después de ser entrenado con datos históricos sobre delitos. [129]

Si bien la recopilación responsable de datos y la documentación de las reglas algorítmicas utilizadas por un sistema se considera una parte fundamental del aprendizaje automático, algunos investigadores culpan a la falta de participación y representación de la población minoritaria en el campo de la IA por la vulnerabilidad del aprendizaje automático a los sesgos. [151] De hecho, según una investigación realizada por la Asociación de Investigación Informática (CRA) en 2021, "las profesoras representan solo el 16,1%" de todos los profesores que se centran en la IA en varias universidades de todo el mundo. [152] Además, entre el grupo de "nuevos graduados de doctorado en IA residentes en EE. UU.", el 45% se identificó como blanco, el 22,4% como asiático, el 3,2% como hispano y el 2,4% como afroamericano, lo que demuestra aún más la falta de diversidad en el campo de la IA. [152]

La IA puede estar bien equipada para tomar decisiones en campos técnicos que dependen en gran medida de datos e información histórica. Estas decisiones dependen de la objetividad y el razonamiento lógico. [153] Debido a que los lenguajes humanos contienen sesgos, las máquinas entrenadas en corpus lingüísticos necesariamente también aprenderán estos sesgos. [154] [155]

En el ámbito de la atención sanitaria se observan otras formas de desafíos éticos, no relacionados con prejuicios personales. Entre los profesionales de la atención sanitaria existe la preocupación de que estos sistemas no estén diseñados en beneficio del público, sino como máquinas generadoras de ingresos. [156] Esto es especialmente cierto en los Estados Unidos, donde existe un dilema ético de larga data entre mejorar la atención sanitaria, pero también aumentar las ganancias. Por ejemplo, los algoritmos podrían estar diseñados para proporcionar a los pacientes pruebas o medicamentos innecesarios en los que los propietarios de los algoritmos tienen intereses. Existe el potencial de que el aprendizaje automático en el ámbito de la atención sanitaria proporcione a los profesionales una herramienta adicional para diagnosticar, medicar y planificar vías de recuperación para los pacientes, pero esto requiere que se mitiguen estos prejuicios. [157]

Desde la década de 2010, los avances tanto en algoritmos de aprendizaje automático como en hardware informático han dado lugar a métodos más eficientes para entrenar redes neuronales profundas (un subdominio particular y estrecho del aprendizaje automático) que contienen muchas capas de unidades ocultas no lineales. [158] Para 2019, las unidades de procesamiento gráfico ( GPU ), a menudo con mejoras específicas de IA, habían desplazado a las CPU como el método dominante para entrenar IA en la nube comercial a gran escala. [159] OpenAI estimó la computación de hardware utilizada en los proyectos de aprendizaje profundo más grandes desde AlexNet (2012) hasta AlphaZero (2017), y encontró un aumento de 300.000 veces en la cantidad de computación requerida, con una línea de tendencia de tiempo de duplicación de 3,4 meses. [160] [161]

Una red neuronal física o computadora neuromórfica es un tipo de red neuronal artificial en la que se utiliza un material ajustable eléctricamente para emular la función de una sinapsis neuronal . El término red neuronal "física" se utiliza para enfatizar la dependencia del hardware físico utilizado para emular neuronas en oposición a los enfoques basados en software. De manera más general, el término se aplica a otras redes neuronales artificiales en las que se utiliza un memristor u otro material de resistencia ajustable eléctricamente para emular una sinapsis neuronal. [162] [163]

El aprendizaje automático integrado es un subcampo del aprendizaje automático, donde el modelo de aprendizaje automático se ejecuta en sistemas integrados con recursos informáticos limitados, como computadoras portátiles , dispositivos de borde y microcontroladores . [164] [165] [166] La ejecución del modelo de aprendizaje automático en dispositivos integrados elimina la necesidad de transferir y almacenar datos en servidores en la nube para su posterior procesamiento, lo que reduce las violaciones de datos y las fugas de privacidad que ocurren debido a la transferencia de datos, y también minimiza el robo de propiedad intelectual, datos personales y secretos comerciales. El aprendizaje automático integrado se puede aplicar a través de varias técnicas, incluida la aceleración de hardware , [167] [168] el uso de computación aproximada , [169] la optimización de modelos de aprendizaje automático y muchas más. [170] [171] La poda , la cuantificación, la destilación del conocimiento , la factorización de bajo rango, la búsqueda de arquitectura de red (NAS) y el uso compartido de parámetros son algunas de las técnicas utilizadas para la optimización de los modelos de aprendizaje automático.

Los paquetes de software que contienen una variedad de algoritmos de aprendizaje automático incluyen los siguientes: