En informática , la aritmética de punto flotante ( FP ) es una aritmética que representa subconjuntos de números reales utilizando un entero con una precisión fija, llamado mantisa , escalado por un exponente entero de una base fija. Los números de esta forma se denominan números de punto flotante . [1] : 3 [2] : 10 Por ejemplo, 12.345 es un número de punto flotante en base diez con cinco dígitos de precisión:

Sin embargo, a diferencia de 12.345, 12.3456 no es un número de punto flotante en base diez con cinco dígitos de precisión, sino que necesita seis dígitos de precisión; el número de punto flotante más cercano con solo cinco dígitos es 12.346. En la práctica, la mayoría de los sistemas de punto flotante utilizan la base dos , aunque la base diez ( punto flotante decimal ) también es común.

Las operaciones aritméticas de punto flotante, como la suma y la división, aproximan las operaciones aritméticas de números reales correspondientes redondeando cualquier resultado que no sea un número de punto flotante a un número de punto flotante cercano. [1] : 22 [2] : 10 Por ejemplo, en una aritmética de punto flotante con cinco dígitos de base diez de precisión, la suma 12,345 + 1,0001 = 13,3451 podría redondearse a 13,345.

El término punto flotante se refiere al hecho de que el punto de la base del número puede "flotar" en cualquier lugar hacia la izquierda, la derecha o entre los dígitos significativos del número. Esta posición se indica mediante el exponente, por lo que el punto flotante puede considerarse una forma de notación científica .

Un sistema de coma flotante puede utilizarse para representar, con un número fijo de dígitos, números de órdenes de magnitud muy diferentes , como el número de metros entre galaxias o entre protones en un átomo . Por esta razón, la aritmética de coma flotante se utiliza a menudo para permitir números reales muy pequeños y muy grandes que requieren tiempos de procesamiento rápidos. El resultado de este rango dinámico es que los números que se pueden representar no están espaciados de manera uniforme; la diferencia entre dos números representables consecutivos varía con su exponente. [3]

A lo largo de los años, se han utilizado en las computadoras diversas representaciones de punto flotante. En 1985, se estableció el estándar IEEE 754 para aritmética de punto flotante y, desde la década de 1990, las representaciones más comunes son las definidas por el IEEE.

La velocidad de las operaciones de punto flotante, comúnmente medida en términos de FLOPS , es una característica importante de un sistema informático , especialmente para aplicaciones que implican cálculos matemáticos intensivos.

Una unidad de punto flotante (FPU, coloquialmente un coprocesador matemático ) es una parte de un sistema informático especialmente diseñada para realizar operaciones con números de punto flotante.

Una representación numérica especifica alguna forma de codificar un número, generalmente como una cadena de dígitos.

Existen varios mecanismos mediante los cuales las cadenas de dígitos pueden representar números. En la notación matemática estándar, la cadena de dígitos puede tener cualquier longitud y la ubicación del punto decimal se indica colocando allí un carácter de "punto" explícito (punto o coma). Si no se especifica el punto decimal, la cadena representa implícitamente un número entero y el punto decimal no especificado estaría fuera del extremo derecho de la cadena, junto al dígito menos significativo. En los sistemas de punto fijo , se especifica una posición en la cadena para el punto decimal. Por lo tanto, un esquema de punto fijo podría utilizar una cadena de 8 dígitos decimales con el punto decimal en el medio, por lo que "00012345" representaría 0001,2345.

En notación científica , el número dado se escala mediante una potencia de 10 , de modo que se encuentre dentro de un rango específico, generalmente entre 1 y 10, con el punto de la base que aparece inmediatamente después del primer dígito. Como potencia de diez, el factor de escala se indica por separado al final del número. Por ejemplo, el período orbital de la luna Ío de Júpiter es152.853,5047 segundos, un valor que se representaría en notación científica de forma estándar como1.528535047 × 10 5 segundos.

La representación en punto flotante es similar en concepto a la notación científica. Lógicamente, un número en punto flotante consta de:

Para derivar el valor del número de punto flotante, la mantisa se multiplica por la base elevada a la potencia del exponente , lo que equivale a desplazar el punto de la base desde su posición implícita por un número de lugares igual al valor del exponente: hacia la derecha si el exponente es positivo o hacia la izquierda si el exponente es negativo.

Usando la base 10 (la notación decimal familiar ) como ejemplo, el número152.853,5047 , que tiene diez dígitos decimales de precisión, se representa como el significado1.528.535.047 junto con 5 como exponente. Para determinar el valor real, se coloca un punto decimal después del primer dígito de la mantisa y el resultado se multiplica por 10.5 para dar1,528535047 × 10 5 , o152.853,5047 . Al almacenar dicho número, no es necesario almacenar la base (10), ya que será la misma para todo el rango de números admitidos y, por lo tanto, se puede inferir.

Simbólicamente, este valor final es:

donde s es la mantisa (ignorando cualquier punto decimal implícito), p es la precisión (la cantidad de dígitos en la mantisa), b es la base (en nuestro ejemplo, este es el número diez ) y e es el exponente.

Históricamente, se han utilizado varias bases numéricas para representar números de punto flotante, siendo la base dos ( binaria ) la más común, seguida de la base diez ( punto flotante decimal ), y otras variedades menos comunes, como la base dieciséis ( punto flotante hexadecimal [4] [5] [nb 3] ), la base ocho (punto flotante octal [1] [5] [ 6] [4] [nb 4] ), la base cuatro (punto flotante cuaternario [7] [5] [nb 5] ), la base tres ( punto flotante ternario equilibrado [1] ) e incluso la base 256 [5] [nb 6] y la base65.536 . [8] [n.º 7]

Un número de punto flotante es un número racional , porque se puede representar como un entero dividido por otro; por ejemplo1,45 × 10 3 es (145/100) × 1000 o145.000 /100. La base determina las fracciones que se pueden representar; por ejemplo, 1/5 no se puede representar exactamente como un número de punto flotante utilizando una base binaria, pero 1/5 se puede representar exactamente utilizando una base decimal (0,2 , o2 × 10 −1 ). Sin embargo, 1/3 no se puede representar exactamente ni en binario (0,010101...) ni en decimal (0,333...), pero en base 3 es trivial (0,1 o 1×3 −1 ). Las ocasiones en las que se producen expansiones infinitas dependen de la base y de sus factores primos .

La forma en que se almacenan la mantisa (incluido su signo) y el exponente en una computadora depende de la implementación. Los formatos IEEE comunes se describen en detalle más adelante y en otros lugares, pero, como ejemplo, en la representación binaria de punto flotante de precisión simple (32 bits), , y por lo tanto, la mantisa es una cadena de 24 bits . Por ejemplo, los primeros 33 bits del número π son:

En esta expansión binaria, denotemos las posiciones desde 0 (bit más a la izquierda, o bit más significativo) hasta 32 (bit más a la derecha). El bit significativo de 24 bits se detendrá en la posición 23, que se muestra como el bit subrayado.0 arriba. El siguiente bit, en la posición 24, se llama bit de redondeo o bit de redondeo . Se utiliza para redondear la aproximación de 33 bits al número de 24 bits más cercano (existen reglas específicas para valores intermedios , lo que no es el caso aquí). Este bit, que esEn este ejemplo, se suma 1 al entero formado por los 24 bits más a la izquierda, lo que da como resultado:

Cuando esto se almacena en la memoria utilizando la codificación IEEE 754, se convierte en el mantisa s . Se supone que el mantisa tiene un punto binario a la derecha del bit más a la izquierda. Por lo tanto, la representación binaria de π se calcula de izquierda a derecha de la siguiente manera:

donde p es la precisión (24 en este ejemplo), n es la posición del bit de la mantisa desde la izquierda (comenzando en0 y terminando en23 aquí) y e es el exponente (1 en este ejemplo).

Se puede requerir que el dígito más significativo de la mantisa de un número distinto de cero sea distinto de cero (excepto cuando el exponente correspondiente sea menor que el mínimo). Este proceso se llama normalización . Para formatos binarios (que utilizan solo los dígitos0 y1 ), este dígito distinto de cero es necesariamente1. Por lo tanto, no necesita representarse en la memoria, lo que permite que el formato tenga un bit más de precisión. Esta regla se denomina de diversas formas : convención de bits inicial , convención de bits implícita , convención de bits oculta [1] o convención de bits asumidos .

La representación en coma flotante es, con diferencia, la forma más habitual de representar en ordenadores una aproximación a los números reales. Sin embargo, existen alternativas:

En 1914, el ingeniero español Leonardo Torres Quevedo publicó Ensayos sobre automática , [9] donde diseñó una calculadora electromecánica de propósito especial basada en la máquina analítica de Charles Babbage y describió una forma de almacenar números de punto flotante de manera consistente. Afirmó que los números se almacenarán en formato exponencial como n x 10 , y ofreció tres reglas mediante las cuales se podría implementar la manipulación consistente de números de punto flotante por parte de máquinas. Para Torres, " n siempre será el mismo número de dígitos (p. ej. seis), el primer dígito de n será del orden de décimas, el segundo de centésimas, etc., y se escribirá cada cantidad en la forma: n ; m ." El formato que propuso muestra la necesidad de un mantra de tamaño fijo como el que se usa actualmente para datos de punto flotante, fijando la ubicación del punto decimal en el mantra para que cada representación fuera única, y cómo formatear dichos números especificando una sintaxis a usar que pudiera ser ingresada a través de una máquina de escribir , como fue el caso de su Aritmómetro Electromecánico en 1920. [10] [11] [12]

.jpg/440px-Konrad_Zuse_(1992).jpg)

En 1938, Konrad Zuse de Berlín completó la Z1 , la primera computadora mecánica binaria programable ; [13] utiliza una representación numérica de punto flotante binario de 24 bits con un exponente con signo de 7 bits, un mantisa de 17 bits (incluido un bit implícito) y un bit de signo. [14] La Z3 basada en relés más confiable , completada en 1941, tiene representaciones tanto para infinitos positivos como negativos; en particular, implementa operaciones definidas con infinito, como , y se detiene en operaciones no definidas, como .

Zuse también propuso, pero no completó, una aritmética de punto flotante cuidadosamente redondeada que incluye representaciones de NaN, anticipándose en cuatro décadas a las características del estándar IEEE. [15] Por el contrario, von Neumann recomendó no utilizar números de punto flotante para la máquina IAS de 1951 , argumentando que la aritmética de punto fijo es preferible. [15]

La primera computadora comercial con hardware de punto flotante fue la computadora Z4 de Zuse , diseñada entre 1942 y 1945. En 1946, Bell Laboratories presentó el Modelo V , que implementó números decimales de punto flotante . [16]

El Pilot ACE tiene aritmética binaria de punto flotante y comenzó a funcionar en 1950 en el Laboratorio Nacional de Física del Reino Unido . Treinta y tres se vendieron comercialmente más tarde como el English Electric DEUCE . La aritmética está realmente implementada en software, pero con una frecuencia de reloj de un megahercio, la velocidad de las operaciones de punto flotante y punto fijo en esta máquina era inicialmente más rápida que las de muchas computadoras de la competencia.

En 1954 se produjo en serie el IBM 704 , que introdujo el uso de un exponente sesgado . Durante muchas décadas después, el hardware de punto flotante era una característica opcional y se decía que los ordenadores que lo tenían eran "ordenadores científicos" o que tenían capacidad de " computación científica " (SC) (véase también Extensiones para computación científica (XSC)). No fue hasta el lanzamiento del Intel i486 en 1989 que los ordenadores personales de uso general tuvieron capacidad de punto flotante en el hardware como una característica estándar.

La serie UNIVAC 1100/2200 , introducida en 1962, admitía dos representaciones de punto flotante:

El IBM 7094 , también presentado en 1962, admitía representaciones de precisión simple y doble, pero sin relación con las representaciones de UNIVAC. De hecho, en 1964, IBM introdujo representaciones de punto flotante hexadecimal en sus mainframes System/360 ; estas mismas representaciones todavía están disponibles para su uso en los sistemas z/Architecture modernos . En 1998, IBM implementó aritmética de punto flotante binario compatible con IEEE en sus mainframes; en 2005, IBM también agregó aritmética de punto flotante decimal compatible con IEEE.

Inicialmente, las computadoras utilizaban muchas representaciones diferentes para los números de punto flotante. La falta de estandarización a nivel de mainframe era un problema constante a principios de la década de 1970 para quienes escribían y mantenían código fuente de nivel superior; estos estándares de punto flotante de los fabricantes diferían en los tamaños de palabra, las representaciones, el comportamiento de redondeo y la precisión general de las operaciones. La compatibilidad de punto flotante entre múltiples sistemas informáticos necesitaba desesperadamente una estandarización a principios de la década de 1980, lo que llevó a la creación del estándar IEEE 754 una vez que la palabra de 32 bits (o 64 bits) se había vuelto común. Este estándar se basó en gran medida en una propuesta de Intel, que estaba diseñando el coprocesador numérico i8087 ; Motorola, que estaba diseñando el 68000 en la misma época, también realizó importantes aportes.

En 1989, el matemático y científico informático William Kahan fue honrado con el Premio Turing por ser el arquitecto principal detrás de esta propuesta; fue ayudado por su estudiante Jerome Coonen y un profesor visitante, Harold Stone . [17]

Entre las innovaciones del x86 se encuentran las siguientes:

Un número de coma flotante consta de dos componentes de coma fija , cuyo rango depende exclusivamente del número de bits o dígitos en su representación. Mientras que los componentes dependen linealmente de su rango, el rango de coma flotante depende linealmente del rango de la mantisa y exponencialmente del rango del componente exponente, lo que otorga al número un rango notablemente más amplio.

En un sistema informático típico, un número binario de punto flotante de doble precisión (64 bits) tiene un coeficiente de 53 bits (incluido 1 bit implícito), un exponente de 11 bits y 1 bit de signo. Como 2 10 = 1024, el rango completo de los números de punto flotante normales positivos en este formato es de 2 −1022 ≈ 2 × 10 −308 a aproximadamente 2 1024 ≈ 2 × 10 308 .

El número de números de punto flotante normales en un sistema ( B , P , L , U ) donde

es .

Existe un número de punto flotante normal positivo más pequeño,

que tiene un 1 como dígito principal y 0 para los dígitos restantes del mantis, y el valor más pequeño posible para el exponente.

Hay un número de punto flotante más grande,

que tiene B − 1 como valor para cada dígito de la mantisa y el mayor valor posible para el exponente.

Además, existen valores representables estrictamente entre −UFL y UFL, es decir, ceros positivos y negativos , así como números subnormales .

El IEEE estandarizó la representación informática de los números binarios de coma flotante en IEEE 754 (también conocido como IEC 60559) en 1985. Este primer estándar es seguido por casi todas las máquinas modernas. Fue revisado en 2008. Los mainframes de IBM admiten el formato de coma flotante hexadecimal propio de IBM y el formato de coma flotante decimal IEEE 754-2008 además del formato binario IEEE 754. La serie Cray T90 tenía una versión IEEE, pero el SV1 todavía utiliza el formato de coma flotante Cray. [ cita requerida ]

El estándar prevé muchos formatos estrechamente relacionados, que difieren solo en unos pocos detalles. Cinco de estos formatos se denominan formatos básicos y otros se denominan formatos de precisión extendida y formatos de precisión extensible . Tres formatos se utilizan especialmente en hardware y lenguajes informáticos: [ cita requerida ]

Aumentar la precisión de la representación de punto flotante generalmente reduce la cantidad de error de redondeo acumulado causado por cálculos intermedios. [24] Otros formatos IEEE incluyen:

Cualquier número entero con valor absoluto menor que 2 24 se puede representar exactamente en el formato de precisión simple, y cualquier número entero con valor absoluto menor que 2 53 se puede representar exactamente en el formato de precisión doble. Además, se puede representar una amplia gama de potencias de 2 veces dicho número. Estas propiedades se utilizan a veces para datos puramente enteros, para obtener números enteros de 53 bits en plataformas que tienen números flotantes de precisión doble pero solo números enteros de 32 bits.

El estándar especifica algunos valores especiales y su representación: infinito positivo ( +∞ ), infinito negativo ( −∞ ), un cero negativo (−0) distinto del cero ordinario ("positivo") y valores "que no son un número" ( NaNs ).

La comparación de números de punto flotante, tal como se define en el estándar IEEE, es un poco diferente de la comparación de números enteros habitual. Los ceros negativos y positivos se comparan como iguales, y cada NaN se compara como desigual con cada valor, incluido él mismo. Todos los números de punto flotante finitos son estrictamente menores que +∞ y estrictamente mayores que −∞ , y están ordenados de la misma manera que sus valores (en el conjunto de números reales).

Los números de punto flotante se suelen incluir en un dato informático como bit de signo, campo de exponente y mantisa, de izquierda a derecha. Para los formatos binarios IEEE 754 (básico y extendido) que tienen implementaciones de hardware existentes, se distribuyen de la siguiente manera:

Si bien el exponente puede ser positivo o negativo, en formatos binarios se almacena como un número sin signo al que se le agrega un "sesgo" fijo. Los valores de todos los 0 en este campo se reservan para los ceros y los números subnormales ; los valores de todos los 1 se reservan para los infinitos y los NaN. El rango del exponente para los números normales es [−126, 127] para precisión simple, [−1022, 1023] para doble o [−16382, 16383] para cuádruple. Los números normales excluyen los valores subnormales, los ceros, los infinitos y los NaN.

En los formatos de intercambio binario IEEE, el bit inicial de un mantis normalizado no se almacena en los datos informáticos. Se lo denomina bit "oculto" o "implícito". Por este motivo, el formato de precisión simple tiene un mantis con 24 bits de precisión, el formato de precisión doble tiene 53 y el cuádruple tiene 113.

Por ejemplo, se demostró anteriormente que π, redondeado a 24 bits de precisión, tiene:

La suma del sesgo del exponente (127) y el exponente (1) es 128, por lo que esto se representa en el formato de precisión simple como

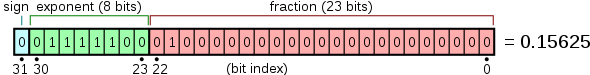

Un ejemplo de diseño para punto flotante de 32 bits es

y el diseño de 64 bits ("doble") es similar.

Además de los formatos estándar IEEE 754 ampliamente utilizados , se utilizan o se han utilizado otros formatos de punto flotante en ciertas áreas específicas del dominio.

Por su naturaleza, todos los números expresados en formato de punto flotante son números racionales con una expansión terminal en la base relevante (por ejemplo, una expansión decimal terminal en base 10 o una expansión binaria terminal en base 2). Los números irracionales, como π o √2, o los números racionales no terminales, deben aproximarse. El número de dígitos (o bits) de precisión también limita el conjunto de números racionales que se pueden representar exactamente. Por ejemplo, el número decimal 123456789 no se puede representar exactamente si solo se dispone de ocho dígitos decimales de precisión (se redondearía a uno de los dos valores representables intermedios, 12345678 × 10 1 o 12345679 × 10 1 ), lo mismo se aplica a los dígitos no terminales (. 5 se redondeará a .55555555 o .55555556).

Cuando un número se representa en algún formato (como una cadena de caracteres) que no es una representación nativa de punto flotante compatible con una implementación informática, será necesaria una conversión antes de poder usarse en esa implementación. Si el número se puede representar exactamente en el formato de punto flotante, la conversión es exacta. Si no hay una representación exacta, la conversión requiere la elección de qué número de punto flotante se usará para representar el valor original. La representación elegida tendrá un valor diferente del original, y el valor así ajustado se denomina valor redondeado .

El hecho de que un número racional tenga o no una expansión terminal depende de la base. Por ejemplo, en base 10 el número 1/2 tiene una expansión terminal (0,5) mientras que el número 1/3 no la tiene (0,333...). En base 2, solo los racionales con denominadores que sean potencias de 2 (como 1/2 o 3/16) son terminales. Cualquier racional con un denominador que tenga un factor primo distinto de 2 tendrá una expansión binaria infinita. Esto significa que los números que parecen cortos y exactos cuando se escriben en formato decimal pueden necesitar una aproximación cuando se convierten a punto flotante binario. Por ejemplo, el número decimal 0,1 no es representable en punto flotante binario de ninguna precisión finita; la representación binaria exacta tendría una secuencia "1100" que continuaría sin fin:

donde, como anteriormente, s es el significando y e es el exponente.

Cuando se redondea a 24 bits, esto se convierte en

que en realidad es 0,100000001490116119384765625 en decimal.

Como ejemplo adicional, el número real π , representado en binario como una secuencia infinita de bits es

pero es

cuando se aproxima mediante redondeo a una precisión de 24 bits.

En punto flotante binario de precisión simple, esto se representa como s = 1,10010010000111111011011 con e = 1. Esto tiene un valor decimal de

Mientras que una aproximación más precisa del valor verdadero de π es

El resultado del redondeo difiere del valor real en aproximadamente 0,03 partes por millón y coincide con la representación decimal de π en los primeros 7 dígitos. La diferencia es el error de discretización y está limitada por la épsilon de la máquina .

La diferencia aritmética entre dos números de punto flotante representables consecutivos que tienen el mismo exponente se denomina unidad en el último lugar (ULP). Por ejemplo, si no hay ningún número representable que se encuentre entre los números representables 1.45a70c22 hex y 1.45a70c24 hex , la ULP es 2×16 −8 , o 2 −31 . Para los números con una parte del exponente de base 2 de 0, es decir, números con un valor absoluto mayor o igual a 1 pero menor que 2, una ULP es exactamente 2 −23 o aproximadamente 10 −7 en precisión simple, y exactamente 2 −53 o aproximadamente 10 −16 en precisión doble. El comportamiento obligatorio del hardware compatible con IEEE es que el resultado esté dentro de la mitad de una ULP.

El redondeo se utiliza cuando el resultado exacto de una operación de punto flotante (o una conversión a formato de punto flotante) necesitaría más dígitos que los que hay en el mantisa. IEEE 754 requiere un redondeo correcto : es decir, el resultado redondeado es como si se hubiera utilizado una aritmética infinitamente precisa para calcular el valor y luego se hubiera redondeado (aunque en la implementación solo se necesitan tres bits adicionales para garantizar esto). Hay varios esquemas de redondeo diferentes (o modos de redondeo ). Históricamente, el truncamiento era el enfoque típico. Desde la introducción de IEEE 754, el método predeterminado ( redondear al más cercano, empates al par , a veces llamado redondeo bancario) se usa con más frecuencia. Este método redondea el resultado ideal (infinitamente preciso) de una operación aritmética al valor representable más cercano y da esa representación como resultado. [nb 8] En el caso de un empate, se elige el valor que haría que el mantisa termine en un dígito par. El estándar IEEE 754 exige que se aplique el mismo redondeo a todas las operaciones algebraicas fundamentales, incluidas las raíces cuadradas y las conversiones, cuando hay un resultado numérico (no NaN). Esto significa que los resultados de las operaciones IEEE 754 se determinan completamente en todos los bits del resultado, excepto en la representación de NaN. (Las funciones "de biblioteca", como coseno y logaritmo, no son obligatorias).

También hay opciones de redondeo alternativas disponibles. IEEE 754 especifica los siguientes modos de redondeo:

Los modos alternativos son útiles cuando se debe limitar la cantidad de error que se introduce. Las aplicaciones que requieren un error limitado son los cálculos de punto flotante de precisión múltiple y la aritmética de intervalos . Los modos de redondeo alternativos también son útiles para diagnosticar la inestabilidad numérica: si los resultados de una subrutina varían sustancialmente entre el redondeo a + y - infinito, es probable que sea numéricamente inestable y esté afectada por un error de redondeo. [34]

La conversión de un número binario de punto flotante de doble precisión en una cadena decimal es una operación común, pero un algoritmo que produjera resultados que fueran precisos y mínimos no apareció impreso hasta 1990, con Dragon4 de Steele y White. Algunas de las mejoras desde entonces incluyen:

Muchos entornos de ejecución de lenguajes modernos utilizan Grisu3 con un respaldo de Dragon4. [41]

El problema de analizar una cadena decimal para obtener una representación binaria de FP es complejo, y no fue hasta el trabajo de Clinger de 1990 (implementado en dtoa.c) que apareció un analizador preciso. [35] Asimismo, se han realizado otros trabajos en la dirección de un análisis más rápido. [42]

Para facilitar la presentación y la comprensión, en los ejemplos se utilizará un sistema decimal con una precisión de 7 dígitos, como en el formato IEEE 754 decimal32 . Los principios fundamentales son los mismos en cualquier sistema decimal o precisión, excepto que la normalización es opcional (no afecta el valor numérico del resultado). Aquí, s denota la mantisa y e denota el exponente.

Un método sencillo para sumar números de punto flotante es representarlos primero con el mismo exponente. En el ejemplo siguiente, el segundo número se desplaza tres dígitos hacia la derecha y luego se procede con el método de suma habitual:

123456,7 = 1,234567 × 10^5 101,7654 = 1,017654 × 10^2 = 0,001017654 × 10^5

Por eso: 123456,7 + 101,7654 = (1,234567 × 10^5) + (1,017654 × 10^2) = (1,234567 × 10^5) + (0,001017654 × 10^5) = (1,234567 + 0,001017654) × 10^5 = 1,235584654 × 10^5

En detalle:

e=5; s=1,234567 (123456,7)+ e=2; s=1,017654 (101,7654)

e=5; s=1,234567+ e=5; s=0,001017654 (después del cambio)-------------------- e=5; s=1,235584654 (suma verdadera: 123558,4654)

Este es el resultado real, la suma exacta de los operandos. Se redondeará a siete dígitos y luego se normalizará si es necesario. El resultado final es

e=5; s=1,235585 (suma final: 123558,5)

Los tres dígitos más bajos del segundo operando (654) se pierden esencialmente. Esto es un error de redondeo . En casos extremos, la suma de dos números distintos de cero puede ser igual a uno de ellos:

e=5; s=1,234567+ e=−3; s=9,876543

e=5; s=1,234567+ e=5; s=0,00000009876543 (después del cambio)---------------------- e=5; s=1,23456709876543 (suma verdadera) e=5; s=1,234567 (después del redondeo y la normalización)

En los ejemplos conceptuales anteriores, parecería que el sumador debería proporcionar una gran cantidad de dígitos adicionales para garantizar un redondeo correcto; sin embargo, para la suma o resta binaria que utiliza técnicas de implementación cuidadosas, solo es necesario llevar un bit de protección , un bit de redondeo y un bit fijo adicional más allá de la precisión de los operandos. [43] [44] : 218–220

Otro problema de pérdida de significancia ocurre cuando se restan las aproximaciones a dos números casi iguales. En el siguiente ejemplo, e = 5; s = 1,234571 y e = 5; s = 1,234567 son aproximaciones a los racionales 123457,1467 y 123456,659.

e=5; s=1,234571− e=5; s=1,234567---------------- e=5; s=0,000004 e=−1; s=4,000000 (después del redondeo y la normalización)

La diferencia de punto flotante se calcula exactamente porque los números son cercanos: el lema de Sterbenz garantiza esto, incluso en caso de desbordamiento por defecto cuando se admite el desbordamiento por defecto gradual . A pesar de esto, la diferencia de los números originales es e = −1; s = 4.877000, que difiere más del 20% de la diferencia e = −1; s = 4.000000 de las aproximaciones. En casos extremos, se pueden perder todos los dígitos significativos de precisión. [43] [45] Esta cancelación ilustra el peligro de suponer que todos los dígitos de un resultado calculado son significativos. El tratamiento de las consecuencias de estos errores es un tema del análisis numérico ; consulte también Problemas de precisión.

Para multiplicar, se multiplican los mantis mientras se suman los exponentes y el resultado se redondea y normaliza.

e=3; s=4,734612× e=5; s=5,417242----------------------- e=8; s=25,648538980104 (producto verdadero) e=8; s=25,64854 (después del redondeo) e=9; s=2,564854 (después de la normalización)

De manera similar, la división se logra restando el exponente del divisor del exponente del dividendo y dividiendo el mantisa del dividendo por el mantisa del divisor.

No hay problemas de cancelación o absorción con la multiplicación o división, aunque pueden acumularse pequeños errores a medida que se realizan operaciones en sucesión. [43] En la práctica, la forma en que se llevan a cabo estas operaciones en la lógica digital puede ser bastante compleja (ver el algoritmo de multiplicación de Booth y el algoritmo de división ). [nb 9]

Los literales para números de punto flotante dependen de los lenguajes. Normalmente utilizan eo Epara denotar la notación científica . El lenguaje de programación C y el estándar IEEE 754 también definen una sintaxis literal hexadecimal con un exponente de base 2 en lugar de 10. En lenguajes como C , cuando se omite el exponente decimal, se necesita un punto decimal para diferenciarlos de los números enteros. Otros lenguajes no tienen un tipo entero (como JavaScript ), o permiten la sobrecarga de tipos numéricos (como Haskell ). En estos casos, las cadenas de dígitos como 123también pueden ser literales de punto flotante.

Ejemplos de literales de punto flotante son:

99.9-5000.126.02e23-3e-450x1.fffffep+127en C y IEEE 754El cálculo de punto flotante en una computadora puede generar tres tipos de problemas:

Antes de la norma IEEE, estas condiciones solían provocar la finalización del programa o desencadenar algún tipo de trampa que el programador podía detectar. La forma en que esto funcionaba dependía del sistema, lo que significa que los programas de punto flotante no eran portables . (El término "excepción" tal como se utiliza en IEEE 754 es un término general que significa una condición excepcional, que no es necesariamente un error, y es un uso diferente al que se define típicamente en lenguajes de programación como C++ o Java, en los que una " excepción " es un flujo alternativo de control, más cercano a lo que se denomina una "trampa" en la terminología IEEE 754).

Aquí se analiza el método predeterminado requerido para manejar excepciones según IEEE 754 (no se analizan el atrapamiento opcional IEEE 754 ni otros modos de "manejo de excepciones alternativo"). Las excepciones aritméticas (por defecto) deben registrarse en bits de bandera de estado "pegajosos". Que sean "pegajosos" significa que no se restablecen en la siguiente operación (aritmética), sino que permanecen establecidos hasta que se restablezcan explícitamente. El uso de banderas "pegajosas" permite, por tanto, retrasar la prueba de condiciones excepcionales hasta después de una expresión o subrutina de punto flotante completa: sin ellas, las condiciones excepcionales que no podrían ignorarse de otro modo requerirían una prueba explícita inmediatamente después de cada operación de punto flotante. Por defecto, una operación siempre devuelve un resultado según la especificación sin interrumpir el cálculo. Por ejemplo, 1/0 devuelve +∞, mientras que también establece el bit de bandera de división por cero (este valor predeterminado de ∞ está diseñado para devolver a menudo un resultado finito cuando se utiliza en operaciones posteriores y, por lo tanto, se puede ignorar de forma segura).

Sin embargo, el estándar IEEE 754 original no recomendaba operaciones para manejar estos conjuntos de bits de indicadores de excepción aritmética. Por lo tanto, si bien estos se implementaron en hardware, inicialmente las implementaciones de lenguaje de programación generalmente no proporcionaban un medio para acceder a ellos (aparte del ensamblador). Con el tiempo, algunos estándares de lenguaje de programación (por ejemplo, C99 / C11 y Fortran) se han actualizado para especificar métodos para acceder y cambiar los bits de indicadores de estado. La versión 2008 del estándar IEEE 754 ahora especifica algunas operaciones para acceder y manejar los bits de indicadores aritméticos. El modelo de programación se basa en un solo hilo de ejecución y el uso de ellos por parte de múltiples hilos debe manejarse por un medio fuera del estándar (por ejemplo, C11 especifica que los indicadores tienen almacenamiento local del hilo ).

IEEE 754 especifica cinco excepciones aritméticas que deben registrarse en los indicadores de estado ("bits fijos"):

El valor de retorno predeterminado para cada una de las excepciones está diseñado para dar el resultado correcto en la mayoría de los casos, de modo que las excepciones se puedan ignorar en la mayoría de los códigos. inexact devuelve un resultado correctamente redondeado, y underflow devuelve un valor menor o igual al número normal positivo más pequeño en magnitud y casi siempre se puede ignorar. [46] divide-por-cero devuelve infinito exactamente, lo que normalmente dividirá un número finito y dará cero, o bien dará una excepción no válida posteriormente si no, y por lo tanto también se puede ignorar normalmente. Por ejemplo, la resistencia efectiva de n resistencias en paralelo (ver fig. 1) está dada por . Si se desarrolla un cortocircuito con establecido en 0, devolverá +infinito que dará un final de 0, como se esperaba [47] (ver el ejemplo de fracción continua de la justificación del diseño IEEE 754 para otro ejemplo).

Por lo general, no se pueden ignorar los desbordamientos y las excepciones no válidas , pero no necesariamente representan errores: por ejemplo, una rutina de búsqueda de raíces , como parte de su funcionamiento normal, puede evaluar una función pasada en valores fuera de su dominio, devolviendo NaN y un indicador de excepción no válida que se debe ignorar hasta encontrar un punto de inicio útil. [46]

El hecho de que los números de punto flotante no puedan representar con precisión todos los números reales y que las operaciones de punto flotante no puedan representar con precisión las operaciones aritméticas verdaderas conduce a muchas situaciones sorprendentes. Esto está relacionado con la precisión finita con la que las computadoras generalmente representan los números.

Por ejemplo, los números decimales 0,1 y 0,01 no se pueden representar exactamente como números binarios de punto flotante. En el formato IEEE 754 binary32 con su mantíndiz de 24 bits, el resultado de intentar elevar al cuadrado la aproximación a 0,1 no es ni 0,01 ni el número representable más cercano a él. El número decimal 0,1 se representa en binario como e = −4 ; s = 110011001100110011001101 , que es

Elevando este número al cuadrado obtenemos

Al elevarlo al cuadrado y redondearlo a la precisión de 24 bits se obtiene

Pero el número representable más cercano a 0,01 es

Además, la no representabilidad de π (y π/2) significa que un intento de cálculo de tan(π/2) no arrojará un resultado de infinito, ni siquiera se desbordará en los formatos de punto flotante habituales (suponiendo una implementación precisa de tan). Simplemente no es posible que el hardware de punto flotante estándar intente calcular tan(π/2), porque π/2 no se puede representar con exactitud. Este cálculo en C:

/* Suficientes dígitos para asegurarnos de que obtenemos la aproximación correcta. */ double pi = 3.1415926535897932384626433832795 ; double z = tan ( pi / 2.0 ); dará un resultado de 16331239353195370,0. En precisión simple (usando la tanffunción), el resultado será −22877332,0.

De la misma manera, un intento de cálculo de sin(π) no dará como resultado cero. El resultado será (aproximadamente) 0,1225 × 10 −15 en precisión doble, o −0,8742 × 10 −7 en precisión simple. [nb 10]

Si bien la suma y la multiplicación en coma flotante son conmutativas ( a + b = b + a y a × b = b × a ), no son necesariamente asociativas . Es decir, ( a + b ) + c no es necesariamente igual a a + ( b + c ) . Utilizando la aritmética decimal con mantisa de 7 dígitos:

a = 1234,567, b = 45,67834, c = 0,0004

(a + b) + c: 1234.567 (a) + 45.67834 (b) ____________ 1280.24534 se redondea a 1280.245

1280.245 (a+b) + 0,0004 (c) ____________ 1280.2454 se redondea a 1280.245 ← (a + b) + c

a + (b + c): 45.67834 (b) + 0,0004 (c) ____________ 45.67874

1234.567 (a) + 45.67874 (b + c) ____________ 1280.24574 se redondea a 1280.246 ← a + (b + c)

Tampoco son necesariamente distributivos . Es decir, ( a + b ) × c puede no ser lo mismo que a × c + b × c :

1234,567 × 3,333333 = 4115,223 1,234567 × 3,333333 = 4,115223 4115,223 + 4,115223 = 4119,338 pero 1234,567 + 1,234567 = 1235,802 1235,802 × 3,333333 = 4119,340

Además de la pérdida de significancia, la incapacidad de representar con exactitud números como π y 0,1 y otras ligeras imprecisiones, pueden ocurrir los siguientes fenómenos:

Intuitivamente, uno querría un valor h muy cercano a cero; sin embargo, al utilizar operaciones de punto flotante, el número más pequeño no dará la mejor aproximación de una derivada. A medida que h se hace más pequeño, la diferencia entre f ( a + h ) y f ( a ) se hace más pequeña, cancelando los dígitos más significativos y menos erróneos y haciendo que los dígitos más erróneos sean más importantes. Como resultado, el número más pequeño de h posible dará una aproximación más errónea de una derivada que un número algo mayor. Este es quizás el problema de precisión más común y serio.

La precisión de la máquina es una cantidad que caracteriza la exactitud de un sistema de punto flotante y se utiliza en el análisis de errores hacia atrás de algoritmos de punto flotante. También se conoce como redondeo unitario o épsilon de máquina . Generalmente se denota como Ε mach y su valor depende del redondeo particular que se utilice.

Con redondeo a cero, mientras que redondeo al más cercano, donde B es la base del sistema y P es la precisión del mantisa (en base B ).

Esto es importante porque limita el error relativo al representar cualquier número real x distinto de cero dentro del rango normalizado de un sistema de punto flotante:

El análisis de errores hacia atrás, cuya teoría fue desarrollada y popularizada por James H. Wilkinson , se puede utilizar para establecer que un algoritmo que implementa una función numérica es numéricamente estable. [51] El enfoque básico es mostrar que, aunque el resultado calculado, debido a los errores de redondeo, no será exactamente correcto, es la solución exacta a un problema cercano con datos de entrada ligeramente perturbados. Si la perturbación requerida es pequeña, del orden de la incertidumbre en los datos de entrada, entonces los resultados son en cierto sentido tan precisos como los datos "merecen". El algoritmo se define entonces como estable hacia atrás . La estabilidad es una medida de la sensibilidad a los errores de redondeo de un procedimiento numérico dado; por el contrario, el número de condición de una función para un problema dado indica la sensibilidad inherente de la función a pequeñas perturbaciones en su entrada y es independiente de la implementación utilizada para resolver el problema. [52]

Como ejemplo trivial, considere una expresión simple que da el producto interno de los vectores (de longitud dos) y , entonces y por lo tanto

dónde

dónde

por definición, que es la suma de dos datos de entrada ligeramente perturbados (del orden de Ε mach ), y por lo tanto es estable hacia atrás. Para ejemplos más realistas en álgebra lineal numérica , consulte Higham 2002 [53] y otras referencias a continuación.

Aunque se garantiza que las operaciones aritméticas individuales de IEEE 754 tienen una precisión de medio ULP , las fórmulas más complicadas pueden sufrir errores mayores por diversas razones. La pérdida de precisión puede ser sustancial si un problema o sus datos están mal condicionados , lo que significa que el resultado correcto es hipersensible a pequeñas perturbaciones en sus datos. Sin embargo, incluso las funciones que están bien condicionadas pueden sufrir una gran pérdida de precisión si se utiliza un algoritmo numéricamente inestable para esos datos: formulaciones aparentemente equivalentes de expresiones en un lenguaje de programación pueden diferir notablemente en su estabilidad numérica. Un enfoque para eliminar el riesgo de dicha pérdida de precisión es el diseño y análisis de algoritmos numéricamente estables, que es un objetivo de la rama de las matemáticas conocida como análisis numérico . Otro enfoque que puede proteger contra el riesgo de inestabilidades numéricas es el cálculo de valores intermedios (scratch) en un algoritmo con una precisión mayor que la que requiere el resultado final, [54] lo que puede eliminar o reducir en órdenes de magnitud [55] dicho riesgo: la precisión cuádruple y la precisión extendida IEEE 754 están diseñadas para este propósito cuando se calcula con precisión doble. [56] [nb 11]

Por ejemplo, el siguiente algoritmo es una implementación directa para calcular la función A ( x ) = ( x −1) / (exp( x −1) − 1) que está bien condicionada en 1.0, [nb 12] sin embargo, se puede demostrar que es numéricamente inestable y pierde hasta la mitad de los dígitos significativos transportados por la aritmética cuando se calcula cerca de 1.0. [57]

doble A ( doble X ) { doble Y , Z ; // [1] Y = X - 1.0 ; Z = exp ( Y ); si ( Z != 1.0 ) Z = Y / ( Z - 1.0 ); // [2] devuelve Z ; }Sin embargo, si todos los cálculos intermedios se realizan con precisión extendida (por ejemplo, estableciendo la línea [1] en C99 long double ), entonces se puede mantener hasta la precisión completa en el resultado doble final. [nb 13] Alternativamente, un análisis numérico del algoritmo revela que si se realiza el siguiente cambio no obvio en la línea [2]:

Z = logaritmo ( Z ) / ( Z - 1,0 ); Entonces el algoritmo se vuelve numéricamente estable y puede calcular con total precisión doble.

Para mantener las propiedades de estos programas numéricamente estables cuidadosamente construidos, se requiere un manejo cuidadoso por parte del compilador . Ciertas "optimizaciones" que los compiladores pueden hacer (por ejemplo, operaciones de reordenamiento) pueden ir en contra de los objetivos de un software que se comporte bien. Existe cierta controversia sobre las fallas de los compiladores y los diseños de lenguajes en esta área: C99 es un ejemplo de un lenguaje donde tales optimizaciones se especifican cuidadosamente para mantener la precisión numérica. Vea las referencias externas al final de este artículo.

Un tratamiento detallado de las técnicas para escribir software de punto flotante de alta calidad está más allá del alcance de este artículo, y se remite al lector a [53] [58] y las otras referencias al final de este artículo. Kahan sugiere varias reglas generales que pueden reducir sustancialmente en órdenes de magnitud [58] el riesgo de anomalías numéricas, además de, o en lugar de, un análisis numérico más cuidadoso. Estas incluyen: como se señaló anteriormente, calcular todas las expresiones y resultados intermedios en la precisión más alta admitida en hardware (una regla general común es llevar el doble de la precisión del resultado deseado, es decir, calcular en doble precisión para un resultado final de precisión simple, o en doble precisión extendida o cuádruple para resultados de hasta doble precisión [59] ); y redondear los datos de entrada y los resultados únicamente a la precisión requerida y compatible con los datos de entrada (llevar una precisión excesiva en el resultado final más allá de la requerida y compatible con los datos de entrada puede ser engañoso, aumenta el costo de almacenamiento y disminuye la velocidad, y los bits en exceso pueden afectar la convergencia de los procedimientos numéricos: [60] en particular, la primera forma del ejemplo iterativo que se da a continuación converge correctamente cuando se utiliza esta regla general). A continuación se presentan breves descripciones de varios problemas y técnicas adicionales.

Como las fracciones decimales a menudo no se pueden representar exactamente en coma flotante binaria, dicha aritmética es mejor cuando simplemente se usa para medir cantidades del mundo real en un amplio rango de escalas (como el período orbital de una luna alrededor de Saturno o la masa de un protón ), y en su peor momento cuando se espera que modele las interacciones de cantidades expresadas como cadenas decimales que se espera que sean exactas. [55] [58] Un ejemplo del último caso son los cálculos financieros. Por esta razón, el software financiero tiende a no usar una representación numérica de coma flotante binaria. [61] El tipo de datos "decimal" de los lenguajes de programación C# y Python , y los formatos decimales del estándar IEEE 754-2008 , están diseñados para evitar los problemas de las representaciones de coma flotante binaria cuando se aplican a valores decimales exactos ingresados por humanos, y hacer que la aritmética siempre se comporte como se espera cuando los números se imprimen en decimal.

Es posible que las expectativas de las matemáticas no se cumplan en el campo de los cálculos de punto flotante. Por ejemplo, se sabe que , y que , pero no se puede confiar en estos hechos cuando las cantidades involucradas son el resultado de cálculos de punto flotante.

El uso de la prueba de igualdad ( if (x==y) ...) requiere cuidado cuando se trabaja con números de punto flotante. Incluso expresiones simples como 0.6/0.2-3==0no serán verdaderas en la mayoría de las computadoras [62] (en IEEE 754, la precisión doble, por ejemplo, 0.6/0.2 - 3es aproximadamente igual a -4.44089209850063e-16). En consecuencia, tales pruebas a veces se reemplazan con comparaciones "difusas" ( if (abs(x-y) < epsilon) ..., donde épsilon es suficientemente pequeño y adaptado a la aplicación, como 1.0E−13). La sabiduría de hacer esto varía mucho y puede requerir un análisis numérico para limitar épsilon. [53] Los valores derivados de la representación de datos primarios y sus comparaciones deben realizarse con una precisión más amplia y extendida para minimizar el riesgo de tales inconsistencias debido a errores de redondeo. [58] A menudo es mejor organizar el código de tal manera que tales pruebas sean innecesarias. Por ejemplo, en geometría computacional , se pueden realizar pruebas exactas de si un punto se encuentra sobre o fuera de una línea o plano definido por otros puntos utilizando métodos de precisión adaptativa o aritmética exacta. [63]

Los pequeños errores en la aritmética de punto flotante pueden aumentar cuando los algoritmos matemáticos realizan operaciones una enorme cantidad de veces. Algunos ejemplos son la inversión de matrices , el cálculo de vectores propios y la resolución de ecuaciones diferenciales. Estos algoritmos deben diseñarse con mucho cuidado, utilizando enfoques numéricos como el refinamiento iterativo , para que funcionen bien. [64]

La suma de un vector de valores de punto flotante es un algoritmo básico en computación científica , por lo que es esencial saber cuándo puede producirse una pérdida de significación. Por ejemplo, si se suman una cantidad muy grande de números, los sumandos individuales son muy pequeños en comparación con la suma. Esto puede provocar una pérdida de significación. Una suma típica sería algo como

3253.671+ 3.141276-----------3256.812

Los tres dígitos inferiores de los sumandos se pierden de hecho. Supongamos, por ejemplo, que se necesitan sumar muchos números, todos aproximadamente iguales a 3. Después de sumar 1000 de ellos, la suma acumulada es de aproximadamente 3000; los dígitos perdidos no se recuperan. Se puede utilizar el algoritmo de suma de Kahan para reducir los errores. [53]

El error de redondeo puede afectar la convergencia y la precisión de los procedimientos numéricos iterativos. Por ejemplo, Arquímedes aproximó π calculando los perímetros de los polígonos que inscriben y circunscriben un círculo, comenzando con hexágonos y duplicando sucesivamente el número de lados. Como se señaló anteriormente, los cálculos se pueden reorganizar de una manera que sea matemáticamente equivalente pero menos propensa a errores ( análisis numérico ). Dos formas de la fórmula de recurrencia para el polígono circunscrito son: [ cita requerida ]

A continuación se muestra un cálculo que utiliza la aritmética IEEE "doble" (un significado con 53 bits de precisión):

i 6 × 2 i × t i , primera forma 6 × 2 i × t i , segunda forma-------------------------------------------------- ------- 0 3 .4641016151377543863 3 .4641016151377543863 1 3 .2153903091734710173 3 .2153903091734723496 2 3,1 596599420974940120 3,1 596599420975006733 3 3,14 60862151314012979 3,14 60862151314352708 4 3,14 27145996453136334 3,14 27145996453689225 5 3.141 8730499801259536 3.141 8730499798241950 6 3.141 6627470548084133 3.141 6627470568494473 7 3.141 6101765997805905 3.141 6101766046906629 8 3.14159 70343230776862 3.14159 70343215275928 9 3.14159 37488171150615 3.14159 3748771353666810 3.141592 9278733740748 3.141592 927385097988511 3.141592 7256228504127 3.141592 722038614837712 3.1415926 717412858693 3.1415926 70701999212513 3.1415926 189011456060 3.14159265 7867845472814 3.1415926 717412858693 3.14159265 4659307370915 3.14159 19358822321783 3.141592653 857173011916 3.1415926 717412858693 3.141592653 656639422217 3.1415 810075796233302 3.141592653 606506191318 3.1415926 717412858693 3.1415926535 93972883619 3.141 4061547378810956 3.1415926535 90839390120 3,14 05434924008406305 3,1415926535 90056016821 3.14 00068646912273617 3.141592653589 860839622 3.1 349453756585929919 3.141592653589 812211823 3.14 00068646912273617 3.14159265358979 9555224 3 .2245152435345525443 3.14159265358979 6890725 3.14159265358979 6224626 3.14159265358979 6224627 3.14159265358979 6224628 3.14159265358979 62246 El valor real es 3,14159265358979323846264338327...

Si bien las dos formas de la fórmula de recurrencia son claramente equivalentes matemáticamente, [nb 14] la primera resta 1 de un número extremadamente cercano a 1, lo que lleva a una pérdida cada vez más problemática de dígitos significativos . A medida que la recurrencia se aplica repetidamente, la precisión mejora al principio, pero luego se deteriora. Nunca mejora más de unos 8 dígitos, aunque la aritmética de 53 bits debería ser capaz de alcanzar unos 16 dígitos de precisión. Cuando se utiliza la segunda forma de la recurrencia, el valor converge a 15 dígitos de precisión.

La mencionada falta de asociatividad de las operaciones de punto flotante en general significa que los compiladores no pueden reordenar expresiones aritméticas de manera tan efectiva como podrían con la aritmética de números enteros y de punto fijo, lo que presenta un obstáculo en optimizaciones como la eliminación de subexpresiones comunes y la autovectorización . [ 65] La opción de "matemática rápida" en muchos compiladores (ICC, GCC, Clang, MSVC...) activa la reasociación junto con suposiciones inseguras como la falta de NaN y números infinitos en IEEE 754. Algunos compiladores también ofrecen opciones más granulares para activar solo la reasociación. En cualquier caso, el programador está expuesto a muchas de las trampas de precisión mencionadas anteriormente para la parte del programa que utiliza matemáticas "rápidas". [66]

En algunos compiladores (GCC y Clang), activar la matemática "rápida" puede provocar que el programa deshabilite los puntos flotantes subnormales al inicio, lo que afecta el comportamiento de punto flotante no solo del código generado, sino también de cualquier programa que use dicho código como biblioteca . [67]

En la mayoría de los compiladores Fortran , tal como lo permite el estándar Fortran ISO/IEC 1539-1:2004, la reasociación es la opción predeterminada, y la interrupción se evita en gran medida mediante la configuración "proteger paréntesis" (también activada de forma predeterminada). Esta configuración impide que el compilador reasocie más allá de los límites de los paréntesis. [68] Intel Fortran Compiler es un caso atípico notable. [69]

Un problema común en las matemáticas "rápidas" es que las subexpresiones pueden no optimizarse de manera idéntica en todos los casos, lo que genera diferencias inesperadas. Una interpretación de este problema es que las matemáticas "rápidas" tal como se implementan actualmente tienen una semántica mal definida. Un intento de formalizar las optimizaciones matemáticas "rápidas" se ve en Icing , un compilador verificado. [70]

[…] Los sistemas como el [Sistema de campo digital] DFS IV y DFS V eran sistemas de punto flotante cuaternario y utilizaban pasos de ganancia de 12 dB. […](256 páginas)

[…] la base flotante del Maniac, que es 2

16

= 65,536. […] La gran base del Maniac permite un aumento considerable en la velocidad de la aritmética de punto flotante. Aunque una base tan grande implica la posibilidad de hasta 15 ceros iniciales, el gran tamaño de palabra de 48 bits garantiza una significancia adecuada. […]

"Extendido" es el formato de datos doblemente extendido de IEC 60559. Extendido se refiere tanto al formato común de 80 bits como al cuádruple de 128 bits de IEC 60559.

la especificación de punto flotante IEEE-754 no define un formato de 16 bits, ILM creó el formato "half". Los valores half tienen 1 bit de signo, 5 bits de exponente y 10 bits de mantisa.

[…] _fmsbintoieee(float *src4, float *dest4) […] Formato binario MS […] orden de bytes => m3 | m2 | m1 | exponente […] m1 es

el byte más significativo

=> sbbb|bbbb […] m3 es el

byte menos significativo

[…] m = byte de mantisa […] s = bit de signo […] b = bit […] MBF es sesgo 128 e IEEE es sesgo 127. […] MBF coloca el

punto decimal

antes del

bit asumido

, mientras que IEEE coloca el punto decimal después del bit asumido. […] ieee_exp = msbin[3] - 2; /* en realidad, msbin[3]-1-128+127 */ […] _dmsbintoieee(double *src8, double *dest8) […] Formato binario MS […] orden de bytes => m7 | m6 | m5 | m4 | m3 | m2 | m1 | exponente […] m1 es el byte más significativo => smmm|mmmm […] m7 es el byte menos significativo […] MBF tiene un sesgo de 128 y IEEE tiene un sesgo de 1023. […] MBF coloca el punto decimal antes del bit asumido, mientras que IEEE coloca el punto decimal después del bit asumido. […] ieee_exp = msbin[7] - 128 - 1 + 1023; […]

más preocupante es el error de cancelación, que puede producir una pérdida catastrófica de precisión.[4]

Admitimos operaciones de reducción de punto flotante cuando se utiliza -ffast-math.