Internet profunda

Si los buscadores tuvieran la capacidad para acceder a toda la información entonces la magnitud de la «internet profunda» se reduciría casi en su totalidad.

Una parte de la «internet profunda» consiste en redes internas de instituciones científicas y académicas que forman la denominada Academic Invisible Web: («Internet académica invisible»), la cual se refiere a las bases de datos que contienen avances tecnológicos, publicaciones científicas y material académico en general a los cuales no se pueden acceder fácilmente.

Sin embargo, PLS, propietario de AT1, fue adquirida por AOL en 1998, y poco después el servicio AT1 fue abandonado.

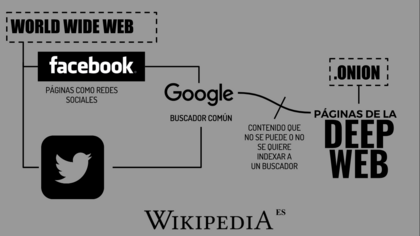

Estas páginas se sirven de forma ad hoc, y no necesitan registrarse, basta con que tu ordenador tenga funcionando un servicio onion, que hará las veces de un servicio dns, pero especial para las páginas del internet profundo.

Mientras que las páginas normales son identificadas mediante el protocolo UDP/IP, las páginas .onion son repetidas por el ramal al que se ha conectado el navegador especializado para tal sistema de navegación segura.

[16] La Association for Computing Machinery (ACM) publicó en 2007 que Google y Yahoo indexaban el 32 % de los objetos de la internet profunda, y MSN tenía la cobertura más pequeña con el 11 %.

[18] Una aproximación al indexamiento y apertura de la Internet académica invisible son los motores de búsqueda que se centran en información académica, como Google Scholar o Scirus.

[18] En dicha investigación Bergman realizó un listado de los 60 sitios académicos más largos de la Deep Web entre los que se encontraba el National Climatic Data Center (NOAA), NASA EOSDIS, National Oceanographic (combined with Geophysical) Data Center (NOAA), entre otras.

Los motores de búsqueda comerciales han comenzado a explorar métodos alternativos para rastrear la Web profunda.

El Protocolo del sitio (primero desarrollado e introducido por Google en 2005) y OAI son mecanismos que permiten a los motores de búsqueda y otras partes interesadas descubrir recursos de la internet profunda en los servidores web en particular.

Los resultados surgidos arrojaron mil consultas por segundo al contenido de la Web profunda.

[19] Este sistema se realiza utilizando tres algoritmos claves: Cuando se ingresa a un buscador y se realiza una consulta, el buscador no recorre la totalidad de internet en busca de las posibles respuestas, sino que busca en su propia base de datos, que ha sido generada e indexada previamente.

Se utiliza el término «araña web» (en inglés web crawler) o robots (por software, comúnmente llamados «bots») inteligentes que van haciendo búsquedas por enlaces de hipertexto de página en página, registrando la información ahí disponible.

Posteriormente fue patrocinado por la EFF (Electronic Frontier Foundation, una organización en defensa de los derechos digitales).

[20] Es posible encontrar sitios web que realicen transacciones ilegales (como drogas, armas, o incluso sicarios) en servidores exclusivos para usuarios de Tor.