La historia de la supercomputación se remonta a la década de 1960, cuando Seymour Cray diseñó una serie de computadoras en Control Data Corporation (CDC) para usar diseños innovadores y paralelismo para lograr un rendimiento computacional máximo superior. [1] La CDC 6600 , lanzada en 1964, generalmente se considera la primera supercomputadora. [2] [3] Sin embargo, algunas computadoras anteriores se consideraron supercomputadoras para su época, como la IBM NORC de 1954 en la década de 1950, [4] y, a principios de la década de 1960, la UNIVAC LARC (1960), [5] la IBM 7030 Stretch (1962), [6] y la Manchester Atlas (1962), todas [ especificar ] de las cuales eran de potencia comparable. [ cita requerida ]

Mientras que las supercomputadoras de la década de 1980 utilizaban sólo unos pocos procesadores, en la década de 1990 comenzaron a aparecer máquinas con miles de procesadores, tanto en Estados Unidos como en Japón, estableciendo nuevos récords de rendimiento computacional.

A finales del siglo XX se construyeron supercomputadoras masivamente paralelas con miles de procesadores "listos para usar" similares a los que se encuentran en las computadoras personales y rompieron la barrera computacional de los teraFLOPS .

El progreso en la primera década del siglo XXI fue espectacular y aparecieron supercomputadoras con más de 60.000 procesadores, alcanzando niveles de rendimiento de petaFLOPS.

El término "supercomputación" se utilizó por primera vez en el periódico New York World en 1929 [7] para referirse a los grandes tabuladores personalizados que IBM había fabricado para la Universidad de Columbia . [8]

En 1957, un grupo de ingenieros abandonó Sperry Corporation para formar Control Data Corporation (CDC) en Minneapolis , Minnesota. Seymour Cray dejó Sperry un año después para unirse a sus colegas en CDC. [1] En 1960, Cray completó el CDC 1604 , una de las primeras generaciones de computadoras transistorizadas comercialmente exitosas y en el momento de su lanzamiento, la computadora más rápida del mundo. [9] Sin embargo, el único Harwell CADET completamente transistorizado estuvo operativo en 1951, e IBM entregó su IBM 7090 transistorizado comercialmente exitoso en 1959.

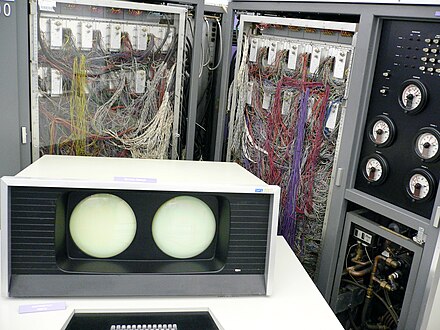

Alrededor de 1960, Cray decidió diseñar una computadora que sería la más rápida del mundo por un amplio margen. Después de cuatro años de experimentación junto con Jim Thornton, Dean Roush y otros 30 ingenieros, Cray completó el CDC 6600 en 1964. Cray cambió de transistores de germanio a transistores de silicio, construidos por Fairchild Semiconductor , que usaban el proceso planar. Estos no tenían los inconvenientes de los transistores de silicio mesa. Los hizo funcionar muy rápido, y la restricción de la velocidad de la luz obligó a un diseño muy compacto con graves problemas de sobrecalentamiento, que se resolvieron mediante la introducción de refrigeración, diseñada por Dean Roush. [10] El 6600 superó al poseedor del récord anterior de la industria, el IBM 7030 Stretch , [ aclaración necesaria ] por un factor de tres. [11] [12] Con un rendimiento de hasta tres megaFLOPS , [13] [14] fue denominada supercomputadora y definió el mercado de la supercomputación cuando se vendieron doscientas computadoras a 9 millones de dólares cada una. [9] [15]

El 6600 ganó velocidad al "subcontratar" el trabajo a elementos informáticos periféricos, liberando la CPU (Unidad Central de Procesamiento) para procesar datos reales. El compilador FORTRAN de Minnesota para la máquina fue desarrollado por Liddiard y Mundstock en la Universidad de Minnesota y con él el 6600 podía sostener 500 kiloflops en operaciones matemáticas estándar. [16] En 1968, Cray completó el CDC 7600 , nuevamente el ordenador más rápido del mundo. [9] A 36 MHz , el 7600 tenía 3,6 veces la velocidad de reloj del 6600, pero funcionaba significativamente más rápido debido a otras innovaciones técnicas. Vendieron solo alrededor de 50 de los 7600, no un fracaso. Cray dejó CDC en 1972 para formar su propia empresa. [9] Dos años después de su partida, CDC entregó el STAR-100 , que con 100 megaflops era tres veces la velocidad del 7600. Junto con el Texas Instruments ASC , el STAR-100 fue una de las primeras máquinas en utilizar procesamiento vectorial , que se inspiró alrededor de 1964 en el lenguaje de programación APL . [17] [18]

En 1956, un equipo de la Universidad de Manchester en el Reino Unido comenzó a desarrollar MUSE — nombre derivado de microsecond engine — el objetivo de eventualmente construir una computadora que pudiera operar a velocidades de procesamiento cercanas a un microsegundo por instrucción, aproximadamente un millón de instrucciones por segundo . [19] Mu (el nombre de la letra griega μ ) es un prefijo en el SI y otros sistemas de unidades que denota un factor de 10 −6 (una millonésima).

A finales de 1958, Ferranti aceptó colaborar con la Universidad de Manchester en el proyecto, y poco después el ordenador pasó a llamarse Atlas , con la empresa conjunta bajo el control de Tom Kilburn . El primer Atlas se puso en servicio oficialmente el 7 de diciembre de 1962 , casi tres años antes de que se introdujera superordenador Cray CDC 6600 , uno de los primeros superordenadores del mundo. En el momento de su puesta en servicio se consideró que era el ordenador más potente del mundo, equivalente a cuatro IBM 7094. Se decía que cada vez que Atlas se desconectaba se perdía la mitad de la capacidad informática del Reino Unido. [20] El Atlas fue pionero en la memoria virtual y la paginación como una forma de ampliar su memoria de trabajo al combinar sus 16.384 palabras de memoria de núcleo primario con 96K palabras adicionales de memoria de tambor secundaria . [21] Atlas también fue pionero en el Atlas Supervisor , "considerado por muchos como el primer sistema operativo moderno reconocible ". [20]

Cuatro años después de dejar CDC, Cray entregó el Cray-1 de 80 MHz en 1976, y se convirtió en la supercomputadora más exitosa de la historia. [18] [22] El Cray-1, que usaba circuitos integrados con dos puertas por chip, era un procesador vectorial . Introdujo una serie de innovaciones, como el encadenamiento , en el que los registros escalares y vectoriales generan resultados provisionales que se pueden usar inmediatamente, sin referencias de memoria adicionales que de otro modo reducirían la velocidad computacional. [10] [23] El Cray X-MP (diseñado por Steve Chen ) fue lanzado en 1982 como un procesador vectorial paralelo de memoria compartida de 105 MHz con mejor soporte de encadenamiento y múltiples canales de memoria. Los tres canales de punto flotante en el X-MP podían operar simultáneamente. [23] En 1983, Cray y Control Data eran líderes en supercomputadoras; a pesar de su liderazgo en el mercado general de computadoras, IBM no pudo producir un competidor rentable. [24]

El Cray-2 , lanzado en 1985, era un ordenador de cuatro procesadores refrigerado por líquido totalmente sumergido en un tanque de Fluorinert , que burbujeaba mientras funcionaba. [10] Alcanzó 1,9 gigaflops y fue el superordenador más rápido del mundo, y el primero en romper la barrera del gigaflop. [25] El Cray-2 era un diseño totalmente nuevo. No utilizaba encadenamiento y tenía una alta latencia de memoria, pero utilizaba mucho pipeline y era ideal para problemas que requerían grandes cantidades de memoria. [23] Los costes de software en el desarrollo de un superordenador no deben subestimarse, como lo demuestra el hecho de que en la década de 1980 el coste del desarrollo de software en Cray llegó a ser igual a lo que se gastaba en hardware. [26] Esa tendencia fue en parte responsable de un alejamiento del sistema operativo interno de Cray a UNICOS basado en Unix . [26]

El Cray Y-MP , también diseñado por Steve Chen, fue lanzado en 1988 como una mejora del X-MP y podía tener ocho procesadores vectoriales a 167 MHz con un rendimiento máximo de 333 megaflops por procesador. [23] A finales de los años 1980, el experimento de Cray sobre el uso de semiconductores de arseniuro de galio en el Cray-3 no tuvo éxito. Seymour Cray comenzó a trabajar en una computadora masivamente paralela a principios de los años 1990, pero murió en un accidente automovilístico en 1996 antes de que pudiera completarse. Sin embargo, Cray Research produjo tales computadoras. [22] [10]

El Cray-2, que marcó las fronteras de la supercomputación a mediados y finales de los años 80, tenía sólo 8 procesadores. En los años 90, empezaron a aparecer supercomputadoras con miles de procesadores. Otro avance a finales de los años 80 fue la llegada de las supercomputadoras japonesas, algunas de las cuales estaban basadas en el Cray-1.

Durante la primera mitad de la Iniciativa de Computación Estratégica , se demostró que algunas arquitecturas masivamente paralelas funcionaban, como la matriz sistólica WARP , MIMD de paso de mensajes como el hipercubo Cosmic Cube , SIMD como Connection Machine , etc. En 1987, se propuso un Programa de Tecnología Informática TeraOPS, con el objetivo de lograr 1 teraOPS (un billón de operaciones por segundo) para 1992, lo que se consideró alcanzable ampliando cualquiera de las arquitecturas probadas previamente. [27]

El SX-3/44R fue anunciado por NEC Corporation en 1989 y un año después obtuvo el título de más rápido del mundo con un modelo de cuatro procesadores. [28] Sin embargo, la supercomputadora Numerical Wind Tunnel de Fujitsu utilizó 166 procesadores vectoriales para obtener el primer puesto en 1994. Tenía una velocidad máxima de 1,7 gigaflops por procesador. [29] [30] El Hitachi SR2201 obtuvo un rendimiento máximo de 600 gigaflops en 1996 al utilizar 2.048 procesadores conectados a través de una red de barras cruzadas tridimensional rápida . [31] [32] [33]

En el mismo período de tiempo, el Intel Paragon podía tener entre 1.000 y 4.000 procesadores Intel i860 en varias configuraciones, y fue clasificado como el más rápido del mundo en 1993. El Paragon era una máquina MIMD que conectaba procesadores a través de una malla bidimensional de alta velocidad, lo que permitía que los procesos se ejecutaran en nodos separados; comunicándose a través de la interfaz de paso de mensajes . [34] En 1995, Cray también estaba enviando sistemas masivamente paralelos, por ejemplo, el Cray T3E con más de 2.000 procesadores, utilizando una interconexión de toro tridimensional . [35] [36]

La arquitectura Paragon pronto dio lugar a la supercomputadora Intel ASCI Red en los Estados Unidos, que ocupó el primer puesto en supercomputación hasta finales del siglo XX como parte de la Iniciativa de Simulación y Computación Avanzada . Este también era un sistema MIMD masivamente paralelo basado en malla con más de 9000 nodos de cómputo y más de 12 terabytes de almacenamiento en disco, pero utilizaba procesadores Pentium Pro estándar que se podían encontrar en las computadoras personales de todos los días. ASCI Red fue el primer sistema en superar la barrera de 1 teraflop en el benchmark MP- Linpack en 1996; finalmente alcanzó los 2 teraflops. [37]

En la primera década del siglo XXI se produjeron avances importantes. La eficiencia de las supercomputadoras siguió aumentando, pero no de forma espectacular. En 1991, el Cray C90 consumía 500 kilovatios de potencia, mientras que en 2003 el ASCI Q consumía 3000 kW y era 2000 veces más rápido, lo que aumentaba el rendimiento por vatio 300 veces. [38]

En 2004, la supercomputadora Earth Simulator construida por NEC en la Agencia Japonesa para la Ciencia y Tecnología Marina-Terrestre (JAMSTEC) alcanzó los 35,9 teraflops, utilizando 640 nodos, cada uno con ocho procesadores vectoriales propietarios . [39]

La arquitectura de supercomputadora IBM Blue Gene se utilizó ampliamente a principios del siglo XXI, y 27 de las computadoras de la lista TOP500 la usaban. El enfoque de Blue Gene es algo diferente, ya que sacrifica la velocidad del procesador por un bajo consumo de energía, de modo que se puede usar una mayor cantidad de procesadores a temperaturas de refrigeración por aire. Puede usar más de 60.000 procesadores, con 2048 procesadores "por bastidor", y los conecta a través de una interconexión de toro tridimensional. [40] [41]

El progreso en China ha sido rápido, ya que China se ubicó en el lugar 51 de la lista TOP500 en junio de 2003; a esto le siguió el lugar 14 en noviembre de 2003, el 10 en junio de 2004, luego el 5 en 2005, antes de obtener el primer lugar en 2010 con la supercomputadora Tianhe-I de 2,5 petaflop . [42] [43]

En julio de 2011, el ordenador japonés K de 8,1 petaflops se convirtió en el más rápido del mundo, utilizando más de 60.000 procesadores SPARC64 VIIIfx alojados en más de 600 gabinetes. El hecho de que el ordenador K sea más de 60 veces más rápido que el Earth Simulator, y que el Earth Simulator se ubique como el 68.º sistema del mundo siete años después de ocupar el primer puesto, demuestra tanto el rápido aumento del rendimiento máximo como el crecimiento generalizado de la tecnología de supercomputación en todo el mundo. [44] [45] [46] En 2014, el Earth Simulator había salido de la lista y en 2018 el ordenador K había salido del top 10. En 2018, Summit se había convertido en el superordenador más potente del mundo, con 200 petaFLOPS. En 2020, los japoneses volvieron a ocupar el primer puesto con el superordenador Fugaku , capaz de 442 PFLOPS. Finalmente, a partir de 2022 y hasta la actualidad (a diciembre de 2023 [actualizar]), la supercomputadora más rápida del mundo había pasado a ser la Hewlett Packard Enterprise Frontier , también conocida como OLCF-5 y alojada en el Oak Ridge Leadership Computing Facility (OLCF) en Tennessee , Estados Unidos. La Frontier está basada en la Cray EX , es la primera supercomputadora a exaescala del mundo , y utiliza únicamente CPU y GPU AMD ; alcanzó un Rmax de 1,102 exaFLOPS , lo que supone 1,102 quintillones de operaciones por segundo. [47] [48] [49] [50] [51]

Esta es una lista de las computadoras que aparecieron en la parte superior de la lista TOP500 desde 1993. [52] La "Velocidad máxima" se da como la clasificación "Rmax".

El CoCom y su posterior reemplazo, el Acuerdo de Wassenaar , regularon legalmente, es decir, exigieron licencias, aprobaciones y registros, o prohibieron por completo, la exportación de computadoras de alto rendimiento (HPC) a ciertos países. Tales controles se han vuelto más difíciles de justificar, lo que llevó a una flexibilización de estas regulaciones. Algunos han argumentado que estas regulaciones nunca estuvieron justificadas. [53] [54] [55] [56] [57] [58]