En teoría de la decisión , una regla de puntuación [1] proporciona una medida resumida para la evaluación de predicciones o pronósticos probabilísticos . Es aplicable a tareas en las que las predicciones asignan probabilidades a eventos, es decir, se emite una distribución de probabilidad como predicción. Esto incluye la clasificación probabilística de un conjunto de resultados o clases mutuamente excluyentes .

Por otro lado, una función de puntuación [2] proporciona una medida resumen para la evaluación de predicciones puntuales, es decir, se predice una propiedad o funcional , como la expectativa o la mediana .

Las reglas de puntuación y las funciones de puntuación pueden considerarse "funciones de costos" o " funciones de pérdidas ". Se evalúan como media empírica de una muestra determinada, lo que se denomina simplemente puntuación. Luego se pueden comparar puntuaciones de diferentes predicciones o modelos para concluir cuál es el mejor.

Si un costo se cobra en proporción a una regla de puntuación adecuada, el costo mínimo esperado corresponde a informar el verdadero conjunto de probabilidades. Se utilizan reglas de puntuación adecuadas en meteorología, finanzas y clasificación de patrones, donde un pronosticador o un algoritmo intentará minimizar la puntuación promedio para producir probabilidades refinadas y calibradas (es decir, probabilidades precisas).

Dado que las métricas en Evaluación de clasificadores binarios no evalúan la calibración, se necesitan reglas de puntuación que puedan hacerlo. Estas reglas de puntuación se pueden utilizar como funciones de pérdida en la minimización empírica del riesgo .

Considere un espacio muestral , un σ-álgebra de subconjuntos de y una clase convexa de medidas de probabilidad en . Una función definida y tomando valores en la línea real extendida, es cuasi integrable si es medible con respecto a y es cuasi integrable con respecto a todos .

Un pronóstico probabilístico es cualquier medida de probabilidad .

Una regla de puntuación es cualquier función extendida de valor real que sea casi integrable para todos . Representa la pérdida o penalización cuando se emite el pronóstico y se materializa la observación .

Un pronóstico puntual es un mapeo funcional, es decir, potencialmente valorado por un conjunto .

Una función de puntuación es cualquier función de valor real que representa la pérdida o penalización cuando se emite el pronóstico puntual y se materializa la observación.

Las reglas de puntuación y las funciones de puntuación están orientadas negativamente (positivamente) si valores más pequeños (más grandes) significan mejor. Aquí nos adherimos a una orientación negativa, de ahí la asociación con "pérdida".

Escribimos para obtener la puntuación esperada en

Dadas muestras aleatorias y pronósticos correspondientes o (por ejemplo, pronósticos de un solo modelo), se calcula la puntuación esperada estimada ( muestra de importancia ) como

o

Las puntuaciones promedio se utilizan para comparar y clasificar diferentes pronósticos o modelos.

Las reglas de puntuación estrictamente adecuadas y las funciones de puntuación estrictamente consistentes fomentan los pronósticos honestos mediante la maximización de la recompensa esperada: si un pronosticador recibe una recompensa de si se da cuenta (por ejemplo ), entonces la recompensa esperada más alta (puntuación más baja) se obtiene informando la distribución de probabilidad real. . [1]

Escribimos para obtener la puntuación esperada en

Una regla de puntuación es adecuada en relación con si (suponiendo una orientación negativa)

Es estrictamente apropiado si la ecuación anterior se cumple con igualdad si y sólo si .

Una función de puntuación es consistente para el funcional relativo a la clase si

Es estrictamente consistente si es consistente y la igualdad en la ecuación anterior implica que .

Un ejemplo de pronóstico probabilístico es el de la meteorología, donde un pronosticador del tiempo puede dar la probabilidad de lluvia al día siguiente. Se podría anotar el número de veces que se citó una probabilidad del 25%, durante un largo período, y compararlo con la proporción real de veces que llovió. Si el porcentaje real fue sustancialmente diferente de la probabilidad declarada, decimos que el pronosticador está mal calibrado . Un sistema de bonificación podría alentar a un pronosticador mal calibrado a hacerlo mejor. Un sistema de bonificación diseñado en torno a una regla de puntuación adecuada incentivará al pronosticador a informar probabilidades iguales a sus creencias personales . [3]

Además del caso simple de una decisión binaria , como asignar probabilidades a "lluvia" o "no llover", se pueden usar reglas de puntuación para múltiples clases, como "lluvia", "nieve" o "claro", o respuestas continuas como la cantidad de lluvia por día.

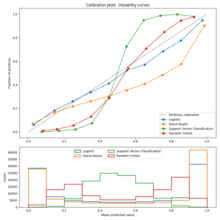

La imagen de la derecha muestra un ejemplo de una regla de puntuación, la regla de puntuación logarítmica, en función de la probabilidad reportada para el evento que realmente ocurrió. Una forma de utilizar esta regla sería como un costo basado en la probabilidad que asigna un pronosticador o algoritmo, y luego verificar qué evento ocurre realmente.

Hay un número infinito de reglas de puntuación, incluidas familias enteras parametrizadas de reglas de puntuación estrictamente adecuadas. Los que se muestran a continuación son simplemente ejemplos populares.

Para una variable de respuesta categórica con eventos mutuamente excluyentes, un pronosticador o algoritmo probabilístico devolverá un vector de probabilidad con una probabilidad para cada uno de los resultados.

La regla de puntuación logarítmica es una regla de puntuación local estrictamente adecuada. Esto también es lo negativo de la sorpresa , que se utiliza comúnmente como criterio de puntuación en la inferencia bayesiana ; el objetivo es minimizar la sorpresa esperada. Esta regla de puntuación tiene sólidos fundamentos en la teoría de la información .

Aquí, la puntuación se calcula como el logaritmo de la estimación de probabilidad del resultado real. Es decir, una predicción del 80% que se cumpliera correctamente recibiría una puntuación de ln(0,8) = −0,22 . Esta misma predicción también asigna un 20% de probabilidad al caso opuesto, por lo que si la predicción resulta falsa, recibiría una puntuación basada en el 20%: ln(0,2) = −1,6 . El objetivo de un pronosticador es maximizar la puntuación y que sea lo más grande posible, y −0,22 es, de hecho, mayor que −1,6.

Si se trata la verdad o falsedad de la predicción como una variable x con valor 1 o 0 respectivamente, y la probabilidad expresada como p , entonces se puede escribir la regla de puntuación logarítmica como x ln( p ) + (1 − x ) ln( 1 - pag ) . Tenga en cuenta que se puede utilizar cualquier base logarítmica, ya que las reglas de puntuación estrictamente adecuadas siguen siendo estrictamente adecuadas en la transformación lineal. Eso es:

es estrictamente apropiado para todos .

La regla de puntuación cuadrática es una regla de puntuación estrictamente adecuada.

donde es la probabilidad asignada a la respuesta correcta y es el número de clases.

La puntuación de Brier , propuesta originalmente por Glenn W. Brier en 1950, [4] puede obtenerse mediante una transformación afín de la regla de puntuación cuadrática.

Donde cuando el decimo evento es correcto y en caso contrario y es el número de clases.

Una diferencia importante entre estas dos reglas es que un pronosticador debe esforzarse por maximizar la puntuación cuadrática y al mismo tiempo minimizar la puntuación de Brier . Esto se debe a un signo negativo en la transformación lineal entre ellos.

La función de puntuación de Hyvärinen (de una densidad p) está definida por [5]

Donde denota la traza de Hesse y denota el gradiente . Esta regla de puntuación se puede utilizar para simplificar computacionalmente la inferencia de parámetros y abordar la comparación del modelo bayesiano con antecedentes arbitrariamente vagos. [5] [6] También se utilizó para introducir nuevas cantidades teóricas de la información más allá de la teoría de la información existente . [7]

La regla de puntuación esférica también es una regla de puntuación estrictamente adecuada.

La puntuación de probabilidad clasificada continua (CRPS) [8] es una regla de puntuación estrictamente adecuada y muy utilizada en Meteorología. Se define como

donde es la función de distribución acumulada de pronóstico, es la función de paso de Heaviside y es la observación. Tenga en cuenta que el pronóstico estima múltiples probabilidades, por lo que surge una función de distribución acumulativa.

Todas las reglas de puntuación adecuadas son iguales a sumas ponderadas (integrales con una función de ponderación no negativa) de las pérdidas en un conjunto de problemas de decisión simples de dos alternativas que utilizan la predicción probabilística, teniendo cada uno de esos problemas de decisión una combinación particular de parámetros de costos asociados. para decisiones falsas positivas y falsas negativas . Una regla de puntuación estrictamente adecuada corresponde a tener una ponderación distinta de cero para todos los umbrales de decisión posibles. Cualquier regla de puntuación adecuada dada es igual a las pérdidas esperadas con respecto a una distribución de probabilidad particular sobre los umbrales de decisión; por lo tanto, la elección de una regla de puntuación corresponde a una suposición sobre la distribución de probabilidad de los problemas de decisión para los cuales finalmente se emplearán las probabilidades predichas; por ejemplo, la regla de puntuación de pérdida cuadrática (o Brier) corresponde a una probabilidad uniforme del umbral de decisión. en cualquier lugar entre cero y uno. La puntuación de precisión de la clasificación (porcentaje de clasificación correcta), una regla de puntuación de umbral único que es cero o uno dependiendo de si la probabilidad prevista está en el lado apropiado de 0,5, es una regla de puntuación adecuada pero no una regla de puntuación estrictamente adecuada porque es optimizado (en expectativa) no solo prediciendo la probabilidad verdadera sino prediciendo cualquier probabilidad en el mismo lado de 0,5 que la probabilidad verdadera. [9] [10] [11] [12] [13] [14]

A continuación, a la izquierda, se muestra una comparación gráfica de las reglas de puntuación logarítmica, cuadrática y esférica para un problema de clasificación binaria. El eje x indica la probabilidad reportada del evento que realmente ocurrió.

Es importante señalar que cada una de las puntuaciones tiene diferentes magnitudes y ubicaciones. Sin embargo, las diferencias de magnitud no son relevantes ya que las puntuaciones siguen siendo adecuadas bajo transformación afín. Por tanto, para comparar diferentes puntuaciones es necesario trasladarlas a una escala común. Una elección razonable de normalización se muestra en la imagen de la derecha donde todas las puntuaciones cruzan los puntos (0,5,0) y (1,1). Esto garantiza que den como resultado 0 para una distribución uniforme (dos probabilidades de 0,5 cada una), lo que no refleja costo ni recompensa por informar lo que suele ser la distribución de referencia. Todas las puntuaciones normalizadas a continuación también arrojan 1 cuando a la clase verdadera se le asigna una probabilidad de 1.

Una regla de puntuación estrictamente adecuada, ya sea binaria o multiclase, después de una transformación afín sigue siendo una regla de puntuación estrictamente adecuada. [3] Es decir, si es una regla de puntuación estrictamente adecuada, entonces también es una regla de puntuación estrictamente adecuada, aunque si entonces el sentido de optimización de la regla de puntuación cambia entre maximización y minimización.

Se dice que una regla de puntuación adecuada es local si su estimación de la probabilidad de un evento específico depende sólo de la probabilidad de ese evento. Esta afirmación es vaga en la mayoría de las descripciones, pero, en la mayoría de los casos, podemos pensar en esto como si la solución óptima del problema de puntuación "en un evento específico" es invariante a todos los cambios en la distribución de observaciones que dejan la probabilidad de ese evento sin cambios. Todas las puntuaciones binarias son locales porque la probabilidad asignada al evento que no ocurrió se determina de modo que no hay ningún grado de flexibilidad para variar.

Las funciones afines de la regla de puntuación logarítmica son las únicas reglas de puntuación locales estrictamente adecuadas en un conjunto finito que no es binario.

El valor esperado de una regla de puntuación adecuada se puede descomponer en la suma de tres componentes, llamados incertidumbre , confiabilidad y resolución , [15] [16] que caracterizan diferentes atributos de los pronósticos probabilísticos:

Si una puntuación es adecuada y está orientada negativamente (como la puntuación Brier), los tres términos son definidos positivos. El componente de incertidumbre es igual a la puntuación esperada del pronóstico que predice constantemente la frecuencia promedio de los eventos. El componente de confiabilidad penaliza los pronósticos mal calibrados, en los que las probabilidades predichas no coinciden con las frecuencias de los eventos.

Las ecuaciones para los componentes individuales dependen de la regla de puntuación particular. Para el Brier Score, están dados por

donde es la probabilidad promedio de ocurrencia del evento binario y es la probabilidad del evento condicional, dada , es decir

El desequilibrio extremo de clases plantea un problema importante para obtener buenas estimaciones de probabilidad. [17]