Una variable se considera dependiente si depende de una variable independiente . Las variables dependientes se estudian bajo el supuesto o exigencia de que dependen, por alguna ley o regla (p. ej., por una función matemática ), de los valores de otras variables. Las variables independientes, a su vez, no se consideran dependientes de ninguna otra variable en el ámbito del experimento en cuestión. [a] En este sentido, algunas variables independientes comunes son el tiempo , el espacio , la densidad , la masa , la velocidad del flujo del fluido , [1] [2] y los valores previos de algún valor observado de interés (p. ej., el tamaño de la población humana) para predecir valores futuros (la variable dependiente). [3]

De las dos, siempre es la variable dependiente cuya variación se estudia, alterando las entradas, también conocidas como regresores en un contexto estadístico . En un experimento, cualquier variable a la que se le puede atribuir un valor sin atribuir un valor a ninguna otra variable se llama variable independiente. Los modelos y experimentos prueban los efectos que las variables independientes tienen sobre las variables dependientes. A veces, incluso si su influencia no es de interés directo, las variables independientes pueden incluirse por otras razones, como para tener en cuenta su posible efecto de confusión .

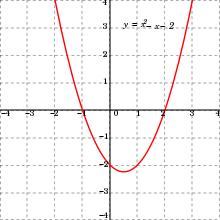

En matemáticas, una función es una regla para tomar una entrada (en el caso más simple, un número o un conjunto de números) [5] y proporcionar una salida (que también puede ser un número). [5] Un símbolo que representa una entrada arbitraria se llama variable independiente , mientras que un símbolo que representa una salida arbitraria se llama variable dependiente . [6] El símbolo más común para la entrada es x , y el símbolo más común para la salida es y ; la función en sí se escribe comúnmente y = f ( x ) . [6] [7]

Es posible tener múltiples variables independientes o múltiples variables dependientes. Por ejemplo, en el cálculo multivariable , a menudo se encuentran funciones de la forma z = f ( x , y ) , donde z es una variable dependiente y x e y son variables independientes. [8] Las funciones con múltiples salidas a menudo se denominan funciones con valores vectoriales .

En el modelado matemático se estudia la relación entre el conjunto de variables dependientes y el conjunto de variables independientes. [ cita requerida ]

En el modelo lineal estocástico simple y i = a + b x i + e i el término y i es el valor i de la variable dependiente y x i es el valor i de la variable independiente. El término e i se conoce como el "error" y contiene la variabilidad de la variable dependiente no explicada por la variable independiente. [ cita requerida ]

Con múltiples variables independientes, el modelo es y i = a + b x i ,1 + b x i ,2 + ... + b x i,n + e i , donde n es el número de variables independientes. [ cita requerida ]

En estadística, más específicamente en regresión lineal , se genera un diagrama de dispersión de datos con X como variable independiente e Y como variable dependiente. Esto también se denomina conjunto de datos bivariados, ( x 1 , y 1 )( x 2 , y 2 ) ...( x i , y i ) . El modelo de regresión lineal simple toma la forma de Y i = a + B x i + U i , para i = 1, 2, ... , n . En este caso, U i , ... , U n son variables aleatorias independientes. Esto ocurre cuando las mediciones no se influyen entre sí. A través de la propagación de la independencia, la independencia de U i implica la independencia de Y i , aunque cada Y i tenga un valor de expectativa diferente. Cada U i tiene un valor de expectativa de 0 y una varianza de σ 2 . [9] Expectativa de Y i Demostración: [9]

La línea de mejor ajuste para el conjunto de datos bivariados toma la forma y = α + βx y se denomina línea de regresión. α y β corresponden a la intersección y la pendiente, respectivamente. [9]

En un experimento , la variable manipulada por un experimentador es algo que se ha demostrado que funciona, llamada variable independiente. [10] La variable dependiente es el evento que se espera que cambie cuando se manipula la variable independiente. [11]

En las herramientas de minería de datos (para estadísticas multivariadas y aprendizaje automático ), a la variable dependiente se le asigna un rol comovariable objetivo (o en algunas herramientas comoatributo de etiqueta), mientras que a una variable independiente se le puede asignar un rol comovariable regular.[12]Se proporcionan valores conocidos para la variable objetivo para el conjunto de datos de entrenamiento yde datos de prueba, pero se deben predecir para otros datos. La variable objetivo se utiliza ende aprendizaje supervisadopero no en aprendizaje no supervisado.

Dependiendo del contexto, a una variable independiente a veces se le llama "variable predictora", "regresora", "covariable", "variable manipulada", "variable explicativa", "variable de exposición" (ver teoría de la confiabilidad ), " factor de riesgo " (ver estadísticas médicas ), " característica " (en aprendizaje automático y reconocimiento de patrones ) o "variable de entrada". [13] [14] En econometría , el término "variable de control" se usa generalmente en lugar de "covariable". [15] [16] [17] [18] [19]

"Variable explicativa"Algunos autores prefieren el término "variable independiente" cuando las cantidades tratadas como variables independientes pueden no ser estadísticamente independientes o manipulables independientemente por el investigador. [20] [21] Si se hace referencia a la variable independiente como una "variable explicativa", entonces el término "variable de respuesta"Algunos autores lo prefieren para la variable dependiente. [14] [20] [21]

Dependiendo del contexto, a una variable dependiente a veces se la denomina "variable de respuesta", "regresando", "criterio", "variable predicha", "variable medida", "variable explicada", "variable experimental", "variable de respuesta", "variable de resultado", "variable de salida", "objetivo" o "etiqueta". [14] En economía, las variables endógenas suelen hacer referencia al objetivo.

"Variable explicada"Algunos autores prefieren el término "variable dependiente" cuando las cantidades tratadas como "variables dependientes" pueden no ser estadísticamente dependientes. [22] Si se hace referencia a la variable dependiente como una "variable explicada", entonces el término "variable predictora"Algunos autores lo prefieren como variable independiente. [22]

Un ejemplo de ello lo constituye el análisis de la tendencia del nivel del mar realizado por Woodworth (1987). En este caso, la variable dependiente (y la variable de mayor interés) fue el nivel medio anual del mar en una ubicación determinada para la que se disponía de una serie de valores anuales. La variable independiente principal fue el tiempo. Se utilizó una covariable consistente en valores anuales de la presión atmosférica media anual al nivel del mar. Los resultados mostraron que la inclusión de la covariable permitió obtener estimaciones mejoradas de la tendencia en función del tiempo, en comparación con los análisis que omitieron la covariable.

Se puede pensar que una variable altera las variables dependientes o independientes, pero puede que no sea en realidad el foco del experimento, por lo que se mantendrá constante o se controlará para intentar minimizar su efecto en el experimento. Dichas variables pueden designarse como "variable controlada", " variable de control " o "variable fija".

Las variables extrañas, si se incluyen en un análisis de regresión como variables independientes, pueden ayudar a un investigador con una estimación precisa de los parámetros de respuesta, la predicción y la bondad del ajuste , pero no son de interés sustancial para la hipótesis en examen. Por ejemplo, en un estudio que examina el efecto de la educación postsecundaria en los ingresos de por vida, algunas variables extrañas pueden ser el género, la etnia, la clase social, la genética, la inteligencia, la edad, etc. Una variable es extraña solo cuando se puede suponer (o demostrar) que influye en la variable dependiente . Si se incluye en una regresión, puede mejorar el ajuste del modelo . Si se excluye de la regresión y si tiene una covarianza distinta de cero con una o más de las variables independientes de interés, su omisión sesgará el resultado de la regresión por el efecto de esa variable independiente de interés. Este efecto se llama sesgo de variable omitida o de confusión ; en estas situaciones, es necesario realizar cambios en el diseño y/o controlar una variable de control estadístico.

Las variables extrañas a menudo se clasifican en tres tipos:

En modelización, la variabilidad que no está cubierta por la variable independiente se designa y se conoce como " residuo ", "efecto secundario", " error ", "porción inexplicable", "variable residual", "perturbación" o "tolerancia".