La psicoacústica es la rama de la psicofísica que estudia científicamente la percepción del sonido por el sistema auditivo humano . Es la rama de la ciencia que estudia las respuestas psicológicas asociadas con el sonido, incluidos el ruido , el habla y la música . La psicoacústica es un campo interdisciplinario que incluye la psicología, la acústica , la ingeniería electrónica, la física, la biología, la fisiología y la informática. [1]

La audición no es un fenómeno puramente mecánico de propagación de ondas , sino que también es un evento sensorial y perceptivo. Cuando una persona escucha algo, ese algo llega al oído como una onda sonora mecánica que viaja a través del aire, pero dentro del oído se transforma en potenciales de acción neuronales . Estos pulsos nerviosos luego viajan al cerebro donde son percibidos. Por lo tanto, en muchos problemas de acústica, como en el procesamiento de audio , es ventajoso tener en cuenta no solo la mecánica del entorno, sino también el hecho de que tanto el oído como el cerebro están involucrados en la experiencia auditiva de una persona. [ cita requerida ]

El oído interno , por ejemplo, realiza un procesamiento de señales significativo al convertir las formas de onda del sonido en estímulos neuronales; este procesamiento hace que ciertas diferencias entre las formas de onda sean imperceptibles. [2] Las técnicas de compresión de datos , como MP3 , hacen uso de este hecho. [3] Además, el oído tiene una respuesta no lineal a sonidos de diferentes niveles de intensidad; esta respuesta no lineal se llama sonoridad . Las redes telefónicas y los sistemas de reducción de ruido de audio hacen uso de este hecho al comprimir de forma no lineal las muestras de datos antes de la transmisión y luego expandirlas para su reproducción. [4] Otro efecto de la respuesta no lineal del oído es que los sonidos que tienen una frecuencia cercana producen notas de pulso fantasma o productos de distorsión de intermodulación . [5]

El término psicoacústica también surge en los debates sobre la psicología cognitiva y los efectos que las expectativas, los prejuicios y las predisposiciones personales pueden tener en las evaluaciones y comparaciones relativas de los oyentes sobre la estética y la agudeza sonoras, y en las distintas determinaciones de los oyentes sobre las cualidades relativas de varios instrumentos musicales e intérpretes. La expresión de que uno "oye lo que quiere (o espera) oír" puede ser pertinente en tales debates. [ cita requerida ]

El oído humano puede oír nominalmente sonidos en el rango20 a 20 000 Hz . El límite superior tiende a disminuir con la edad; la mayoría de los adultos no pueden oír por encima de16 000 Hz . La frecuencia más baja que se ha identificado como tono musical es 12 Hz en condiciones ideales de laboratorio. [6] Los tonos entre 4 y 16 Hz se pueden percibir a través del sentido del tacto del cuerpo .

Se ha medido que la percepción humana de la separación temporal de las señales de audio es inferior a 10 microsegundos. Esto no significa que las frecuencias superiores a 100 kHz sean audibles, sino que la discriminación temporal no está directamente relacionada con el rango de frecuencia. [7] [8]

La resolución de frecuencia del oído es de aproximadamente 3,6 Hz dentro de la octava de1000–2000 Hz Es decir, los cambios de tono mayores de 3,6 Hz se pueden percibir en un entorno clínico. [6] Sin embargo, diferencias de tono incluso más pequeñas se pueden percibir a través de otros medios. Por ejemplo, la interferencia de dos tonos a menudo se puede escuchar como una variación repetitiva en el volumen del tono. Esta modulación de amplitud ocurre con una frecuencia igual a la diferencia de frecuencias de los dos tonos y se conoce como latido .

La escala de semitonos que se utiliza en la notación musical occidental no es una escala de frecuencia lineal, sino logarítmica . Otras escalas se han derivado directamente de experimentos sobre la percepción auditiva humana, como la escala mel y la escala Bark (se utilizan para estudiar la percepción, pero no suelen utilizarse en la composición musical), y son aproximadamente logarítmicas en frecuencia en el extremo de alta frecuencia, pero casi lineales en el extremo de baja frecuencia.

El rango de intensidad de los sonidos audibles es enorme. Los tímpanos humanos son sensibles a las variaciones de la presión sonora y pueden detectar cambios de presión desde unos pocos micropascales (μPa) hasta más de 10 ...100 kPa . Por este motivo, el nivel de presión sonora también se mide logarítmicamente, con todas las presiones referenciadas a20 μPa (o1,973 85 × 10 −10 atm ). Por lo tanto, el límite inferior de audibilidad se define como0 dB , pero el límite superior no está tan claramente definido. El límite superior es más una cuestión de límite en el que el oído se verá físicamente dañado o con el potencial de causar pérdida de audición inducida por ruido .

Una exploración más rigurosa de los límites inferiores de audibilidad determina que el umbral mínimo en el que se puede oír un sonido depende de la frecuencia. Al medir esta intensidad mínima para probar tonos de varias frecuencias, se puede derivar una curva de umbral absoluto de audición (ATH) dependiente de la frecuencia. Por lo general, el oído muestra un pico de sensibilidad (es decir, su ATH más bajo) entre1–5 kHz , aunque el umbral cambia con la edad y los oídos más viejos muestran una sensibilidad reducida por encima de los 2 kHz. [9]

El ATH es el más bajo de los contornos de igual sonoridad . Los contornos de igual sonoridad indican el nivel de presión sonora (dB SPL), sobre el rango de frecuencias audibles, que se perciben como de igual sonoridad. Los contornos de igual sonoridad fueron medidos por primera vez por Fletcher y Munson en Bell Labs en 1933 usando tonos puros reproducidos a través de auriculares, y los datos que recopilaron se denominan curvas de Fletcher-Munson . Debido a que la sonoridad subjetiva era difícil de medir, las curvas de Fletcher-Munson se promediaron sobre muchos sujetos.

Robinson y Dadson perfeccionaron el proceso en 1956 para obtener un nuevo conjunto de curvas de igual sonoridad para una fuente de sonido frontal medida en una cámara anecoica . Las curvas de Robinson-Dadson se estandarizaron como ISO 226 en 1986. En 2003, la ISO 226 se revisó como contorno de igual sonoridad utilizando datos recopilados de 12 estudios internacionales.

La localización del sonido es el proceso de determinar la ubicación de una fuente de sonido. El cerebro utiliza diferencias sutiles en volumen, tono y tiempo entre los dos oídos para permitirnos localizar fuentes de sonido. [10] La localización se puede describir en términos de posición tridimensional: el acimut o ángulo horizontal, el cenit o ángulo vertical y la distancia (para sonidos estáticos) o velocidad (para sonidos en movimiento). [11] Los humanos, como la mayoría de los animales de cuatro patas , son expertos en detectar la dirección en la horizontal, pero menos en las direcciones verticales debido a que las orejas están colocadas simétricamente. Algunas especies de búhos tienen sus orejas colocadas asimétricamente y pueden detectar sonido en los tres planos, una adaptación para cazar pequeños mamíferos en la oscuridad. [12]

Supongamos que un oyente puede oír una señal acústica dada en condiciones de silencio. Cuando se reproduce una señal mientras se reproduce otro sonido (un enmascarador), la señal tiene que ser más fuerte para que el oyente la oiga. El enmascarador no necesita tener los componentes de frecuencia de la señal original para que se produzca el enmascaramiento. Una señal enmascarada se puede oír aunque sea más débil que el enmascarador. El enmascaramiento se produce cuando se reproducen una señal y un enmascarador juntos (por ejemplo, cuando una persona susurra mientras otra grita) y el oyente no oye la señal más débil porque ha sido enmascarada por el enmascarador más fuerte. El enmascaramiento también puede producirse en una señal antes de que comience un enmascarador o después de que se detenga. Por ejemplo, un solo aplauso repentino y fuerte puede hacer inaudibles los sonidos que lo preceden o lo siguen inmediatamente. Los efectos del enmascaramiento hacia atrás son más débiles que los del enmascaramiento hacia adelante. El efecto de enmascaramiento se ha estudiado ampliamente en la investigación psicoacústica. Se puede cambiar el nivel del enmascarador y medir el umbral, luego crear un diagrama de una curva de ajuste psicofísico que revelará características similares. Los efectos de enmascaramiento también se utilizan en la codificación de audio con pérdida, como MP3 .

Cuando se presenta una serie armónica de frecuencias en la relación 2 f , 3 f , 4 f , 5 f , etc. (donde f es una frecuencia específica), los humanos tienden a percibir que el tono es f . Se puede encontrar un ejemplo audible en YouTube. [13]

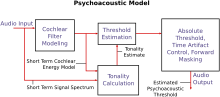

El modelo psicoacústico permite una compresión de señales con pérdida de alta calidad al describir qué partes de una señal de audio digital determinada se pueden eliminar (o comprimir agresivamente) de forma segura, es decir, sin pérdidas significativas en la calidad del sonido percibida (conscientemente).

Esto puede explicar por qué un aplauso agudo puede sonar dolorosamente fuerte en una biblioteca silenciosa, pero apenas se nota después de que un automóvil hace una explosión en una calle urbana concurrida. Esto proporciona un gran beneficio a la relación de compresión general, y el análisis psicoacústico conduce rutinariamente a archivos de música comprimidos que tienen un tamaño de una décima a una doceava parte del de los másteres de alta calidad, pero con una pérdida de calidad proporcional perceptiblemente menor. Este tipo de compresión es una característica de casi todos los formatos de compresión de audio con pérdida modernos. Algunos de estos formatos incluyen Dolby Digital (AC-3), MP3 , Opus , Ogg Vorbis , AAC , WMA , MPEG-1 Layer II (utilizado para la transmisión de audio digital en varios países) y ATRAC , la compresión utilizada en MiniDisc y algunos modelos de Walkman .

La psicoacústica se basa en gran medida en la anatomía humana , especialmente en las limitaciones del oído para percibir el sonido, como se ha explicado anteriormente. En resumen, estas limitaciones son:

Un algoritmo de compresión puede asignar una prioridad menor a los sonidos que se encuentran fuera del rango de audición humana. Al desplazar cuidadosamente los bits de los componentes no importantes hacia los importantes, el algoritmo garantiza que los sonidos que el oyente probablemente percibirá estén representados con mayor precisión.

La psicoacústica incluye temas y estudios que son relevantes para la psicología musical y la musicoterapia . Teóricos como Benjamin Boretz consideran que algunos de los resultados de la psicoacústica son significativos solo en un contexto musical. [14]

Los LP de la serie Environments de Irv Teibel (1969-79) son un ejemplo temprano de sonidos disponibles comercialmente lanzados expresamente para mejorar las capacidades psicológicas. [15]

La psicoacústica ha disfrutado durante mucho tiempo de una relación simbiótica con la informática . Los pioneros de Internet JCR Licklider y Bob Taylor realizaron estudios de posgrado en psicoacústica, mientras que BBN Technologies se especializó originalmente en consultoría sobre cuestiones acústicas antes de comenzar a construir la primera red de conmutación de paquetes .

Licklider escribió un artículo titulado "Una teoría dúplex de la percepción del tono". [16]

La psicoacústica se aplica en muchos campos del desarrollo de software, donde los desarrolladores mapean patrones matemáticos probados y experimentales en el procesamiento de señales digitales. Muchos códecs de compresión de audio como MP3 y Opus utilizan un modelo psicoacústico para aumentar las relaciones de compresión. El éxito de los sistemas de audio convencionales para la reproducción de música en teatros y hogares se puede atribuir a la psicoacústica [17] y las consideraciones psicoacústicas dieron lugar a nuevos sistemas de audio, como la síntesis de campo sonoro psicoacústico . [18] Además, los científicos han experimentado con un éxito limitado en la creación de nuevas armas acústicas, que emiten frecuencias que pueden dañar, dañar o matar. [19] La psicoacústica también se aprovecha en la sonificación para hacer que múltiples dimensiones de datos independientes sean audibles y fácilmente interpretables. [20] Esto permite la guía auditiva sin la necesidad de audio espacial y en juegos de computadora de sonificación [21] y otras aplicaciones, como el vuelo de drones y la cirugía guiada por imágenes . [22] También se aplica hoy en día en el ámbito de la música, donde los músicos y artistas siguen creando nuevas experiencias auditivas enmascarando frecuencias no deseadas de los instrumentos, lo que hace que se potencien otras frecuencias. Otra aplicación es el diseño de altavoces pequeños o de menor calidad, que pueden utilizar el fenómeno de la falta de fundamentales para dar el efecto de notas graves a frecuencias más bajas que las que los altavoces son físicamente capaces de producir (ver referencias).

Los fabricantes de automóviles diseñan sus motores e incluso sus puertas para que tengan un sonido determinado. [23]