Las investigaciones sobre la relación entre la magnitud termodinámica entropía y el origen y la evolución de la vida comenzaron a principios del siglo XX. En 1910, el historiador estadounidense Henry Adams imprimió y distribuyó entre las bibliotecas universitarias y los profesores de historia el pequeño volumen Carta a los profesores estadounidenses de historia, en el que proponía una teoría de la historia basada en la segunda ley de la termodinámica y en el principio de la entropía. [1] [2]

El libro de 1944 ¿Qué es la vida? del físico premio Nobel Erwin Schrödinger estimuló la investigación en este campo. En su libro, Schrödinger afirmó originalmente que la vida se alimenta de entropía negativa, o negentropía como a veces se la llama, pero en una edición posterior se corrigió a sí mismo en respuesta a las quejas y afirmó que la verdadera fuente es la energía libre . Trabajos más recientes han restringido el debate a la energía libre de Gibbs porque los procesos biológicos en la Tierra normalmente ocurren a una temperatura y presión constantes, como en la atmósfera o en el fondo del océano, pero no en ambos durante períodos cortos de tiempo para organismos individuales. La aplicación cuantitativa de los balances de entropía y las consideraciones de energía de Gibbs a células individuales es uno de los principios subyacentes del crecimiento y el metabolismo. [3]

Las ideas sobre la relación entre la entropía y los organismos vivos han inspirado hipótesis y especulaciones en muchos contextos, incluida la psicología, la teoría de la información , el origen de la vida y la posibilidad de vida extraterrestre .

En 1863, Rudolf Clausius publicó sus famosas memorias Sobre la concentración de rayos de calor y luz, y sobre los límites de su acción , en las que esbozaba una relación preliminar, basada en su propio trabajo y en el de William Thomson (Lord Kelvin) , entre los procesos vivos y su concepto recién desarrollado de entropía. [ cita requerida ] Sobre la base de esto, uno de los primeros en especular sobre una posible perspectiva termodinámica de la evolución orgánica fue el físico austríaco Ludwig Boltzmann . En 1875, basándose en los trabajos de Clausius y Kelvin, Boltzmann razonó:

La lucha general por la existencia de los seres animados no es una lucha por las materias primas –éstas, para los organismos, son el aire, el agua y el suelo, todas disponibles en abundancia– ni por la energía que existe en abundancia en cualquier cuerpo en forma de calor, sino una lucha por la entropía [negativa] , que se vuelve disponible a través de la transición de energía del sol caliente a la tierra fría . [4]

En 1876, el ingeniero civil estadounidense Richard Sears McCulloh , en su Tratado sobre la teoría mecánica del calor y su aplicación a la máquina de vapor , que fue uno de los primeros libros de texto de termodinámica, afirma, después de hablar sobre las leyes del mundo físico, que "no hay ninguna que esté establecida sobre una base más firme que las dos proposiciones generales de Joule y Carnot ; que constituyen las leyes fundamentales de nuestro tema". McCulloh luego continúa demostrando que estas dos leyes pueden combinarse en una sola expresión de la siguiente manera:

dónde

McCulloh declara entonces que las aplicaciones de estas dos leyes, es decir, lo que actualmente se conoce como la primera ley de la termodinámica y la segunda ley de la termodinámica , son innumerables:

Si reflexionamos sobre la relación que existe entre los fenómenos físicos y los cambios y relaciones térmicas, se hace evidente que hay pocas ramas de las ciencias naturales , si es que hay alguna, que no dependan en mayor o menor medida de las grandes verdades que se examinan. Por tanto, no debería sorprendernos que, en el breve espacio de tiempo (aún no ha transcurrido una generación) desde que se adoptó libremente la teoría mecánica del calor , ramas enteras de la ciencia física hayan sido revolucionadas por ella. [5] : p. 267

McCulloh da algunos de los que él llama los "ejemplos más interesantes" de la aplicación de estas leyes en extensión y utilidad. Su primer ejemplo es la fisiología , donde afirma que "el cuerpo de un animal, no menos que un barco de vapor o una locomotora, es verdaderamente una máquina térmica , y el consumo de alimentos en uno es precisamente análogo a la quema de combustible en el otro; en ambos, el proceso químico es el mismo: el llamado combustión ". Luego incorpora una discusión de la teoría de la respiración de Antoine Lavoisier con ciclos de digestión, excreción y transpiración, pero luego contradice a Lavoisier con hallazgos recientes, como el calor interno generado por la fricción , según la nueva teoría del calor , que, según McCulloh, establece que "el calor del cuerpo en general y de manera uniforme se difunde en lugar de concentrarse en el pecho". McCulloh luego da un ejemplo de la segunda ley, donde afirma que la fricción, especialmente en los vasos sanguíneos más pequeños, debe desarrollar calor. Sin duda, una parte del calor generado por los animales se produce de esta manera. Entonces pregunta: "¿Pero de dónde proviene el gasto de energía que causa esa fricción, y cuál debe ser a su vez explicado?"

Para responder a esta pregunta, McCulloh recurre a la teoría mecánica del calor y continúa describiendo vagamente cómo el corazón es lo que él llama una "bomba de fuerza", que recibe sangre y la envía a todas las partes del cuerpo, como descubrió William Harvey , y que "actúa como el pistón de un motor y depende y, en consecuencia, se debe al ciclo de nutrición y excreción que sustenta la vida física u orgánica". Es probable que McCulloh modelara partes de este argumento sobre el del famoso ciclo de Carnot . En conclusión, resume su argumento de la primera y la segunda ley de la siguiente manera:

Como todo lo físico está sujeto a la ley de conservación de la energía , se sigue que ninguna acción fisiológica puede tener lugar sin gasto de energía derivada de los alimentos; además, que un animal que realiza un trabajo mecánico debe generar, a partir de la misma cantidad de alimento, menos calor que uno que se abstiene de realizar el esfuerzo, siendo la diferencia precisamente el equivalente térmico del trabajo. [5] : p. 270

En el libro de 1944 ¿Qué es la vida?, el físico austríaco Erwin Schrödinger , que en 1933 había ganado el Premio Nobel de Física , teorizó que la vida, contrariamente a la tendencia general dictada por la segunda ley de la termodinámica , que establece que la entropía de un sistema aislado tiende a aumentar, disminuye o mantiene constante su entropía alimentándose de entropía negativa. [6] El problema de la organización en los sistemas vivos que aumenta a pesar de la segunda ley se conoce como la paradoja de Schrödinger. [7] En su nota al Capítulo 6 de ¿Qué es la vida?, sin embargo, Schrödinger comenta sobre su uso del término entropía negativa:

Permítanme decir primero que, si hubiera estado atendiendo sólo a ellos [los físicos], habría dejado que la discusión girara en torno a la energía libre . Es el concepto más familiar en este contexto, pero este término altamente técnico parecía lingüísticamente demasiado cercano a la energía como para que el lector medio se diera cuenta del contraste entre las dos cosas.

Esto, sostiene Schrödinger, es lo que diferencia la vida de otras formas de organización de la materia . En este sentido, aunque se pueda argumentar que la dinámica de la vida va en contra de la tendencia de la segunda ley, la vida no entra en conflicto con esta ley ni la invalida de ninguna manera, porque el principio de que la entropía solo puede aumentar o permanecer constante se aplica únicamente a un sistema cerrado que está aislado adiabáticamente, lo que significa que no puede entrar ni salir calor, y los procesos físicos y químicos que hacen posible la vida no ocurren en aislamiento adiabático, es decir, los sistemas vivos son sistemas abiertos. Siempre que un sistema puede intercambiar calor o materia con su entorno, una disminución de la entropía de ese sistema es completamente compatible con la segunda ley. [8]

Schrödinger se preguntó: “¿Cómo evita el organismo vivo la descomposición?”. La respuesta obvia es: “Comiendo, bebiendo, respirando y (en el caso de las plantas) asimilando”. Si bien la energía de los nutrientes es necesaria para mantener el orden de un organismo, Schrödinger también postuló proféticamente la existencia de otras moléculas igualmente necesarias para crear el orden observado en los organismos vivos: “El asombroso don de un organismo de concentrar una corriente de orden sobre sí mismo y así escapar de la descomposición en el caos atómico –de beber el orden de un entorno adecuado– parece estar relacionado con la presencia de los sólidos aperiódicos…”. Ahora sabemos que este cristal “aperiódico” es el ADN , y que su disposición irregular es una forma de información. “El ADN en el núcleo celular contiene la copia maestra del software, por duplicado. Este software parece controlar mediante la especificación de un algoritmo, o conjunto de instrucciones, la creación y el mantenimiento de todo el organismo que contiene la célula”. [9]

El ADN y otras macromoléculas determinan el ciclo vital de un organismo: nacimiento, crecimiento, madurez, decadencia y muerte. La nutrición es necesaria pero no suficiente para explicar el crecimiento en tamaño, ya que la genética es el factor determinante. En algún momento, prácticamente todos los organismos decaen y mueren normalmente incluso cuando permanecen en entornos que contienen suficientes nutrientes para mantener la vida. El factor controlador debe ser interno y no los nutrientes o la luz solar que actúan como variables exógenas causales. Los organismos heredan la capacidad de crear estructuras biológicas únicas y complejas; es poco probable que esas capacidades se reinventen o se enseñen a cada generación. Por lo tanto, el ADN debe ser operativo como causa principal de esta característica también. Aplicando la perspectiva de Boltzmann de la segunda ley, el cambio de estado desde un ordenamiento más probable, menos ordenado y de mayor entropía a uno de menor probabilidad, más orden y menor entropía (como se ve en el ordenamiento biológico) requiere una función como la conocida del ADN. La aparente función de procesamiento de información del ADN proporciona una resolución de la paradoja de Schrödinger planteada por la vida y el requisito de entropía de la segunda ley. [10]

En los últimos años, la interpretación termodinámica de la evolución en relación con la entropía ha comenzado a utilizar el concepto de energía libre de Gibbs , en lugar de entropía. [11] [12] Esto se debe a que los procesos biológicos en la Tierra tienen lugar a temperatura y presión aproximadamente constantes, una situación en la que la energía libre de Gibbs es una forma especialmente útil de expresar la segunda ley de la termodinámica. La energía libre de Gibbs viene dada por:

dónde

y la exergía y la energía libre de Gibbs son equivalentes si el entorno y la temperatura del sistema son equivalentes. De lo contrario, la energía libre de Gibbs será menor que la exergía (para sistemas con temperaturas superiores a la ambiente). La minimización de la energía libre de Gibbs es una forma del principio de energía mínima (energía mínima 'libre' o exergía), que se desprende del principio de maximización de la entropía para sistemas cerrados. Además, la ecuación de energía libre de Gibbs, en forma modificada, se puede utilizar para sistemas abiertos , incluidas las situaciones en las que se incluyen términos de potencial químico en la ecuación de balance de energía. En un popular libro de texto de 1982, Principles of Biochemistry , el destacado bioquímico estadounidense Albert Lehninger argumentó que el orden producido dentro de las células a medida que crecen y se dividen es más que compensado por el desorden que crean en su entorno en el curso del crecimiento y la división. En resumen, según Lehninger, "los organismos vivos preservan su orden interno tomando de su entorno energía libre , en forma de nutrientes o luz solar, y devolviendo a su entorno una cantidad igual de energía en forma de calor y entropía". [13]

De manera similar, según el químico John Avery , en su libro de 2003 Information Theory and Evolution , encontramos una presentación en la que el fenómeno de la vida, incluyendo su origen y evolución, así como la evolución cultural humana, tiene su base en el trasfondo de la termodinámica , la mecánica estadística y la teoría de la información . La (aparente) paradoja entre la segunda ley de la termodinámica y el alto grado de orden y complejidad que producen los sistemas vivos, según Avery, tiene su resolución "en el contenido de información de la energía libre de Gibbs que entra en la biosfera desde fuentes externas". [14] Suponiendo que la evolución conduce a los organismos hacia un mayor contenido de información, Gregory Chaitin postula que la vida tiene propiedades de alta información mutua, [15] y Tamvakis que la vida puede cuantificarse utilizando métricas de densidad de información mutua, una generalización del concepto de Biodiversidad . [16]

En un estudio titulado "Selección natural para la acción mínima" publicado en las Actas de la Royal Society A. , Ville Kaila y Arto Annila de la Universidad de Helsinki describen cómo el proceso de selección natural responsable de dicho aumento local en el orden puede derivarse matemáticamente directamente de la expresión de la ecuación de la segunda ley para sistemas abiertos conectados que no están en equilibrio. La segunda ley de la termodinámica puede escribirse como una ecuación de movimiento para describir la evolución, mostrando cómo la selección natural y el principio de acción mínima pueden conectarse expresando la selección natural en términos de termodinámica química. En esta perspectiva, la evolución explora posibles caminos para nivelar las diferencias en las densidades de energía y así aumentar la entropía más rápidamente. Así, un organismo sirve como un mecanismo de transferencia de energía, y las mutaciones beneficiosas permiten que los organismos sucesivos transfieran más energía dentro de su entorno. [17] [18]

El análisis de la segunda ley es valioso en el análisis científico y de ingeniería porque proporciona una serie de beneficios sobre el análisis de energía solo, incluida la base para determinar la calidad de la energía (o contenido de exergía [19] [20] [21] ), comprender los fenómenos físicos fundamentales, mejorar la evaluación y optimización del rendimiento o ampliar nuestra comprensión de los sistemas vivos.

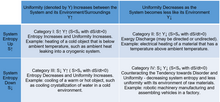

La segunda ley describe una tendencia universal hacia el desorden y la uniformidad, o el equilibrio interno y externo. Esto significa que los procesos reales, no ideales, causan la producción de entropía. La entropía también puede transferirse hacia o desde un sistema mediante el flujo o transferencia de materia y energía. Como resultado, la producción de entropía no necesariamente causa que la entropía del sistema aumente. De hecho, la entropía o el desorden en un sistema pueden disminuir espontáneamente, como un motor de turbina de gas de avión que se enfría después de apagarse, o como el agua en una taza que se deja afuera en temperaturas invernales bajo cero. En este último caso, un líquido relativamente desordenado se enfría y se congela espontáneamente en una estructura cristalizada de desorden reducido a medida que las moléculas se "pegan" entre sí. Aunque la entropía del sistema disminuye, el sistema se acerca a la uniformidad con su entorno, o se vuelve más termodinámicamente similar a él. [22] Este es un proceso de categoría III, que se refiere a las cuatro combinaciones de entropía (S) hacia arriba o hacia abajo, y uniformidad (Y) - entre el sistema y su entorno - ya sea hacia arriba o hacia abajo.

La segunda ley puede enunciarse conceptualmente [22] de la siguiente manera: la materia y la energía tienen la tendencia a alcanzar un estado de uniformidad o equilibrio interno y externo, un estado de máximo desorden (entropía). Los procesos reales de no equilibrio siempre producen entropía, lo que provoca un mayor desorden en el universo, mientras que los procesos reversibles idealizados no producen entropía y no se conoce ningún proceso que destruya la entropía. La tendencia de un sistema a acercarse a la uniformidad puede contrarrestarse, y el sistema puede volverse más ordenado o complejo, mediante la combinación de dos cosas, una fuente de trabajo o exergía y alguna forma de instrucción o inteligencia. Donde 'exergía' es el potencial de trabajo térmico, mecánico, eléctrico o químico de una fuente o flujo de energía, e 'instrucción o inteligencia', se entiende en el contexto de, o se caracteriza por, el conjunto de procesos que están dentro de la categoría IV.

Consideremos como ejemplo de un proceso de categoría IV la fabricación y el montaje robóticos de vehículos en una fábrica. La maquinaria robótica requiere instrucciones y entradas de trabajo eléctrico, pero cuando se completa, los productos fabricados tienen menos uniformidad con su entorno o más complejidad (orden superior) en relación con las materias primas de las que se fabricaron. Por tanto, la entropía o el desorden del sistema disminuyen mientras que la tendencia a la uniformidad entre el sistema y su entorno se contrarresta. En este ejemplo, las instrucciones, así como la fuente de trabajo, pueden ser internas o externas al sistema, y pueden o no cruzar el límite del sistema. Para ilustrarlo, las instrucciones pueden estar precodificadas y el trabajo eléctrico puede almacenarse en un sistema de almacenamiento de energía en el lugar. Alternativamente, el control de la maquinaria puede ser mediante operación remota a través de una red de comunicaciones, mientras que el trabajo eléctrico se suministra a la fábrica desde la red eléctrica local. Además, los humanos pueden desempeñar directamente, en todo o en parte, el papel que desempeña la maquinaria robótica en la fabricación. En este caso, pueden intervenir instrucciones, pero la inteligencia es responsable directa o indirectamente de la dirección o aplicación del trabajo de tal manera que se contrarreste la tendencia al desorden y la uniformidad.

Como otro ejemplo, consideremos la refrigeración del agua en un ambiente cálido. Debido a la refrigeración, se extrae calor del agua o se lo fuerza a fluir del mismo. Como resultado, la temperatura y la entropía del agua disminuyen y el sistema se aleja cada vez más de la uniformidad con su entorno cálido. El punto importante es que la refrigeración no solo requiere una fuente de trabajo, sino también un equipo diseñado, así como inteligencia operativa precodificada o directa o instrucciones para lograr el efecto de refrigeración deseado.

.jpg/440px-Hummingbird_(13951653023).jpg)

La observación es la base para entender que los procesos de la categoría IV requieren tanto una fuente de exergía como una fuente o forma de inteligencia o instrucción. Con respecto a los sistemas vivos, la luz solar proporciona la fuente de exergía para prácticamente toda la vida en la Tierra, es decir, la luz solar directamente (para la flora) o indirectamente en los alimentos (para la fauna). Obsérvese que el potencial de trabajo o exergía de la luz solar, con una cierta distribución espectral y direccional, tendrá un valor específico [19] [20] [21] que puede expresarse como un porcentaje del flujo de energía o contenido de exergía. Al igual que la Tierra en su conjunto, los seres vivos utilizan esta energía, convirtiendo la energía en otras formas (la primera ley), al tiempo que producen entropía (la segunda ley) y, por lo tanto, degradan la exergía o calidad de la energía. Mantener la vida, o el crecimiento de una semilla, por ejemplo, requiere la disposición continua de átomos y moléculas en ensamblajes elaborados necesarios para duplicar las células vivas. Esta unión en los organismos vivos disminuye la uniformidad y el desorden, contrarrestando la tendencia universal hacia el desorden y la uniformidad descrita por la segunda ley. Además de una fuente de energía de alta calidad, para contrarrestar esta tendencia se requiere una forma de instrucción o inteligencia, que está contenida principalmente en el ADN/ ARN .

En ausencia de instrucción o inteligencia, la energía de alta calidad no es suficiente por sí sola para producir conjuntos complejos, como una casa. Como ejemplo de la categoría I en contraste con la IV, aunque tenga mucha energía o exergía, un segundo tornado nunca reconstruirá una ciudad destruida por un tornado anterior, en cambio aumenta el desorden y la uniformidad (categoría I), la misma tendencia descrita por la segunda ley. Una línea de razonamiento relacionada es que, aunque improbable, a lo largo de miles de millones de años o billones de posibilidades, ¿la vida surgió sin dirección, a partir de materia no viva en ausencia de cualquier inteligencia? Algunas preguntas relacionadas que alguien puede hacer incluyen: ¿pueden los humanos con un suministro de alimentos (exergía) vivir sin ADN/ARN?, ¿puede construirse una casa provista de electricidad en el bosque sin humanos o una fuente de instrucción o programación?, ¿puede un refrigerador funcionar con electricidad pero sin sus tableros de control de computadora en funcionamiento?

La segunda ley garantiza que si construimos una casa, con el tiempo, ésta tenderá a desmoronarse o tenderá hacia un estado de desorden. Por otra parte, si al caminar por un bosque descubrimos una casa, probablemente concluyamos que alguien la construyó, en lugar de concluir que el orden surgió al azar. Sabemos que los sistemas vivos, como la estructura y función de una célula viva o el proceso de ensamblaje/plegado de proteínas, son extremadamente complejos. ¿Podría haber surgido la vida sin estar dirigida por una fuente de inteligencia y, en consecuencia, con el tiempo, haber dado lugar a cosas como el cerebro humano y su inteligencia, las computadoras, las ciudades, la calidad del amor y la creación de música o bellas artes? La tendencia de la segunda ley hacia el desorden y la uniformidad, y la distinción de los procesos de la categoría IV como contrarrestores de esta tendencia natural, [22] nos ofrecen información valiosa que podemos considerar en nuestra búsqueda de respuestas a estas preguntas.

Equilibrio de entropía

Un balance de entropía para un sistema abierto, o el cambio de entropía a lo largo del tiempo para un sistema en estado estable, se puede escribir como:

Suponiendo un sistema en estado estable, condiciones de presión y temperatura aproximadamente estables e intercambio solo a través de las superficies celulares, [23] esta expresión se puede reescribir para expresar el equilibrio de entropía para una célula individual como:

Dónde

intercambio de calor con el medio ambiente

entropía molar parcial del metabolito B

Entropía molar parcial de las estructuras resultantes del crecimiento.

tasa de producción de entropía

y los términos indican tasas de intercambio con el medio ambiente.

Esta ecuación se puede adaptar para describir el balance de entropía de una célula, lo que resulta útil para conciliar la espontaneidad del crecimiento celular con la intuición de que el desarrollo de estructuras complejas debe reducir en general la entropía dentro de la célula. De acuerdo con la segunda ley, ; debido a la organización interna resultante del crecimiento, será pequeña. Los procesos metabólicos fuerzan a que la suma de los dos términos restantes sea menor que cero a través de una gran tasa de transferencia de calor o la exportación de productos de desecho de alta entropía. [3] Ambos mecanismos evitan que se acumule un exceso de entropía dentro de la célula en crecimiento; esto último es lo que Schrödinger describió como alimentarse de entropía negativa o "negentropía". [24]

Implicaciones para el metabolismo

De hecho, es posible que esta contribución de "negentropía" sea lo suficientemente grande como para que el crecimiento sea completamente endotérmico , o en realidad elimine calor del ambiente. Este tipo de metabolismo, en el que el acetato, el metanol o varios otros compuestos de hidrocarburos se convierten en metano (un gas de alta entropía), [25] se conoce como metanogénesis acetoclástica; un ejemplo es el metabolismo de la arqueobacteria anaeróbica Methanosarcina barkeri . [26] [27] En el extremo opuesto está el metabolismo de la arqueobacteria termófila anaeróbica Methanobacterium thermoautotrophicum , [28] para la cual el calor exportado al ambiente a través de la fijación [29] es alto (~3730 kJ/C-mol). [27]

En general, en los procesos metabólicos, los procesos catabólicos espontáneos que descomponen biomoléculas proporcionan la energía para impulsar reacciones anabólicas no espontáneas que construyen biomasa organizada a partir de reactivos de alta entropía. [30] Por lo tanto, el rendimiento de biomasa está determinado por el equilibrio entre los procesos catabólicos y anabólicos acoplados, donde la relación entre estos procesos puede describirse por:

dónde

fuerza impulsora de reacción total/energía molar de Gibbs total

biomasa producida

Energía de Gibbs de las reacciones catabólicas (-)

Energía de Gibbs de las reacciones anabólicas (+)

Los organismos deben mantener un equilibrio óptimo entre y para evitar el equilibrio termodinámico ( ), en el que la producción de biomasa se maximizaría teóricamente pero el metabolismo procedería a un ritmo infinitamente lento, y el caso límite opuesto en el que el crecimiento es altamente favorable ( ), pero los rendimientos de biomasa son prohibitivamente bajos. Esta relación se describe mejor en términos generales y variará ampliamente de un organismo a otro. Debido a que los términos correspondientes a las contribuciones catabólicas y anabólicas estarían aproximadamente equilibrados en el primer escenario, este caso representa la cantidad máxima de materia organizada que se puede producir de acuerdo con la segunda ley de la termodinámica para un sistema metabólico muy generalizado. [23]

La segunda ley de la termodinámica aplicada al origen de la vida es una cuestión mucho más complicada que el desarrollo posterior de la vida, ya que no existe un "modelo estándar" de cómo surgieron las primeras formas de vida biológica, solo una serie de hipótesis en pugna. El problema se analiza en el contexto de la abiogénesis , lo que implica una evolución química gradual predarwiniana.

En 1924, Alexander Oparin sugirió que la energía suficiente para generar formas de vida tempranas a partir de moléculas no vivas se proporcionó en una " sopa primordial ". [31] Las leyes de la termodinámica imponen algunas restricciones a las primeras reacciones de mantenimiento de la vida que habrían surgido y evolucionado a partir de tal mezcla. Esencialmente, para permanecer consistentes con la segunda ley de la termodinámica, los sistemas autoorganizados que se caracterizan por valores de entropía más bajos que el equilibrio deben disipar energía para aumentar la entropía en el entorno externo. [32] Una consecuencia de esto es que los intermediarios químicos de baja entropía o alto potencial químico no pueden acumularse hasta niveles muy altos si la reacción que conduce a su formación no está acoplada a otra reacción química que libera energía. Estas reacciones a menudo toman la forma de pares redox , que deben haber sido proporcionados por el medio ambiente en el momento del origen de la vida. [33] En la biología actual, muchas de estas reacciones requieren catalizadores (o enzimas ) para proceder, que con frecuencia contienen metales de transición. Esto significa que identificar tanto las parejas redox como los metales que están fácilmente disponibles en un entorno candidato determinado para la abiogénesis es un aspecto importante de la química prebiótica.

La idea de que es necesario identificar los procesos que pueden ocurrir naturalmente en el medio ambiente y que actúan para disminuir localmente la entropía se ha aplicado en los estudios sobre el papel del fosfato en el origen de la vida, donde el entorno relevante para la abiogénesis es un entorno lacustre de la Tierra primitiva. Uno de esos procesos es la capacidad del fosfato para concentrar reactivos de forma selectiva debido a su carga negativa localizada. [34]

En el contexto de la hipótesis de los respiraderos hidrotermales alcalinos (AHV) para el origen de la vida, se ha sugerido una concepción de las formas de vida como "generadores de entropía" en un intento de desarrollar un marco para la abiogénesis en condiciones alcalinas de aguas profundas. Suponiendo que la vida se desarrolla rápidamente en determinadas condiciones, los experimentos pueden recrear la primera vía metabólica, ya que sería la más favorable energéticamente y, por lo tanto, la más probable de que se produzca. En este caso, los compuestos de sulfuro de hierro pueden haber actuado como los primeros catalizadores. [35] Por lo tanto, dentro de la concepción más amplia de la vida como convertidores de energía libre, sería eventualmente beneficioso caracterizar cuantitativamente cantidades como la producción de entropía y las tasas de disipación del gradiente de protones para los sistemas relevantes para el origen de la vida (en particular, los AHV). [36]

Se propuso que la evolución del orden, manifestada como complejidad biológica, en los sistemas vivos y la generación de orden en ciertos sistemas no vivos obedecían a un principio fundamental común llamado "la dinámica darwiniana". [37] La dinámica darwiniana se formuló considerando primero cómo se genera el orden microscópico en sistemas no biológicos relativamente simples que están lejos del equilibrio termodinámico (por ejemplo, tornados, huracanes). Luego se extendió la consideración a moléculas cortas de ARN replicante que se suponía que eran similares a las primeras formas de vida en el mundo del ARN . Se demostró que los procesos subyacentes de generación de orden en los sistemas no biológicos y en el ARN replicante son básicamente similares. Este enfoque ayuda a aclarar la relación de la termodinámica con la evolución, así como el contenido empírico de la teoría de Darwin .

En 2009, el físico Karo Michaelian publicó una teoría de disipación termodinámica para el origen de la vida [38] [39] en la que se considera que las moléculas fundamentales de la vida; ácidos nucleicos, aminoácidos, carbohidratos (azúcares) y lípidos se produjeron originalmente como estructuras disipativas microscópicas (a través de la estructuración disipativa de Prigogine [40] ) como pigmentos en la superficie del océano para absorber y disipar en calor el flujo UVC de luz solar que llega a la superficie de la Tierra durante el Arcaico, tal como lo hacen los pigmentos orgánicos en la región visible hoy. Estos pigmentos UVC se formaron a través de la estructuración disipativa fotoquímica a partir de moléculas precursoras más comunes y simples como HCN y H 2 O bajo el flujo UVC de luz solar. [38] [39] [41] La función termodinámica de los pigmentos originales (moléculas fundamentales de la vida) era aumentar la producción de entropía de la biosfera incipiente bajo el flujo de fotones solares y esto, de hecho, sigue siendo la función termodinámica más importante de la biosfera hoy, pero ahora principalmente en la región visible donde las intensidades de los fotones son más altas y las vías biosintéticas son más complejas, lo que permite que los pigmentos se sinteticen a partir de luz visible de menor energía en lugar de luz UVC que ya no llega a la superficie de la Tierra.

Jeremy England desarrolló una hipótesis sobre la física de los orígenes de la vida, que él llama "adaptación impulsada por la disipación". [42] [43] La hipótesis sostiene que grupos aleatorios de moléculas pueden autoorganizarse para absorber y disipar de manera más eficiente el calor del entorno. Su hipótesis afirma que tales sistemas autoorganizados son una parte inherente del mundo físico. [44]

Al igual que un sistema termodinámico, un sistema de información tiene un concepto análogo a la entropía llamado entropía de la información . Aquí, la entropía es una medida del aumento o disminución de la novedad de la información. Los flujos de trayectorias de información novedosa muestran un patrón familiar. Tienden a aumentar o disminuir el número de resultados posibles de la misma manera que las medidas de entropía termodinámica aumentan o disminuyen el espacio de estados. Al igual que la entropía termodinámica, la entropía de la información utiliza una escala logarítmica: –P(x) log P(x), donde P es la probabilidad de algún resultado x. [45] Las reducciones en la entropía de la información están asociadas con un menor número de resultados posibles en el sistema de información.

En 1984, Brooks y Wiley introdujeron el concepto de entropía de las especies como una medida de la suma de la reducción de entropía dentro de las poblaciones de especies en relación con la energía libre en el medio ambiente. [46] La entropía de Brooks-Wiley analiza tres categorías de cambios de entropía: información, cohesión y metabolismo. La entropía de información mide la eficiencia de la información genética en el registro de todas las combinaciones potenciales de herencia que están presentes. La entropía de cohesión analiza los vínculos sexuales dentro de una población. La entropía metabólica es la entropía química familiar que se utiliza para comparar la población con su ecosistema. La suma de estas tres es una medida de la entropía de no equilibrio que impulsa la evolución a nivel de población.

Un artículo de Helman de 2022 en Acta Biotheoretica sugiere identificar una medida de divergencia de estos tres tipos de entropías: entropía termodinámica, entropía de información y entropía de especies. [47] Cuando estas tres están sobredeterminadas, surgirá una libertad formal similar a cómo surge la quiralidad a partir de un número mínimo de dimensiones. Una vez que hay al menos cuatro puntos para los átomos, por ejemplo, en una molécula que tiene un átomo central, son posibles los enantiómeros izquierdo y derecho. Por analogía, una vez que se alcanza un umbral de sobredeterminación en la entropía en los sistemas vivos, habrá un espacio de estados interno que permita ordenar las operaciones de los sistemas. Ese proceso de ordenamiento interno es un umbral para distinguir los sistemas vivos de los no vivos.

En 1964, James Lovelock formó parte de un grupo de científicos a los que la NASA solicitó que crearan un sistema teórico de detección de vida para buscar vida en Marte durante las próximas misiones Viking . Un desafío importante fue determinar cómo construir una prueba que revelara la presencia de vida extraterrestre con diferencias significativas con respecto a la biología tal como la conocemos. Al considerar este problema, Lovelock se planteó dos preguntas: "¿Cómo podemos estar seguros de que el estilo de vida marciano, si es que lo hay, se revelará en pruebas basadas en el estilo de vida de la Tierra?", así como la pregunta subyacente más desafiante: "¿Qué es la vida y cómo se la debe reconocer?"

Como estas ideas entraban en conflicto con los enfoques más tradicionales que suponen que las firmas biológicas en otros planetas se verían muy similares a las de la Tierra, al discutir este tema con algunos de sus colegas del Laboratorio de Propulsión a Chorro , se le preguntó qué haría para buscar vida en Marte. A esto, Lovelock respondió: "Buscaría una reducción de la entropía, ya que debe ser una característica general de la vida". Esta idea tal vez se expresó mejor como una búsqueda de desequilibrios químicos sostenidos asociados con estados de baja entropía resultantes de procesos biológicos, y a través de una mayor colaboración se desarrolló en la hipótesis de que las biofirmas serían detectables mediante el examen de las composiciones atmosféricas. Lovelock determinó a través del estudio de la atmósfera de la Tierra que esta métrica de hecho tendría el potencial de revelar la presencia de vida. Esto tuvo la consecuencia de indicar que Marte probablemente no tenía vida, ya que su atmósfera carece de cualquier firma anómala de ese tipo. [48]

Este trabajo se ha ampliado recientemente como base para la detección de biofirmas en atmósferas exoplanetarias. Esencialmente, la detección de múltiples gases que no están típicamente en equilibrio estable entre sí en una atmósfera planetaria puede indicar la producción biótica de uno o más de ellos, de una manera que no requiere suposiciones sobre las reacciones bioquímicas exactas que la vida extraterrestre podría utilizar o los productos específicos que resultarían. Un ejemplo terrestre es la coexistencia de metano y oxígeno, los cuales eventualmente se agotarían si no fuera por la producción biogénica continua. La cantidad de desequilibrio puede describirse diferenciando las energías de Gibbs observadas y del estado de equilibrio para una composición atmosférica dada; puede demostrarse que esta cantidad se ha visto afectada directamente por la presencia de vida a lo largo de la historia de la Tierra. [49] La obtención de imágenes de exoplanetas por futuros telescopios terrestres y espaciales proporcionará restricciones observacionales sobre las composiciones de la atmósfera de los exoplanetas, a las que se podría aplicar este enfoque. [50]

Pero hay una salvedad relacionada con el potencial de que los desequilibrios químicos sirvan como una anti-biofirma dependiendo del contexto. De hecho, probablemente hubo un fuerte desequilibrio químico presente en la Tierra primitiva antes del origen de la vida debido a una combinación de los productos de la desgasificación volcánica sostenida y el vapor de agua oceánico. En este caso, el desequilibrio fue el resultado de una falta de organismos presentes para metabolizar los compuestos resultantes. Este desequilibrio en realidad se reduciría con la presencia de vida quimiotrófica , que eliminaría estos gases atmosféricos y crearía un mayor equilibrio termodinámico antes del advenimiento de los ecosistemas fotosintéticos. [51]

En 2013, Azua-Bustos y Vega argumentaron que, sin tener en cuenta los tipos de formas de vida que podrían imaginarse tanto en la Tierra como en otras partes del Universo, todas deberían compartir en común el atributo de disminuir su entropía interna a expensas de la energía libre obtenida de su entorno. Como la entropía permite la cuantificación del grado de desorden en un sistema, cualquier forma de vida imaginada debe tener un grado de orden más alto que su entorno inmediato. Estos autores demostraron que utilizando únicamente el análisis matemático fractal, podían cuantificar fácilmente el grado de diferencia de complejidad estructural (y, por lo tanto, la entropía) de los procesos vivos como entidades distintas separadas de sus entornos abióticos similares. Este enfoque puede permitir la detección futura de formas de vida desconocidas tanto en el Sistema Solar como en exoplanetas descubiertos recientemente basándose únicamente en diferenciales de entropía de conjuntos de datos complementarios (morfología, coloración, temperatura, pH, composición isotópica, etc.). [52]

La noción de entropía como desorden ha sido transferida de la termodinámica a la psicología por el psiquiatra polaco Antoni Kępiński , quien admitió estar inspirado por Erwin Schrödinger. [53] En su marco teórico ideado para explicar los trastornos mentales (la teoría del metabolismo de la información ), la diferencia entre los organismos vivos y otros sistemas se explicó como la capacidad de mantener el orden. Al contrario de la materia inanimada, los organismos mantienen el orden particular de sus estructuras corporales y mundos internos que imponen a su entorno y transmiten a las nuevas generaciones. La vida de un organismo o de la especie cesa tan pronto como pierde esa capacidad. [54] El mantenimiento de ese orden requiere un intercambio continuo de información entre el organismo y su entorno. En los organismos superiores, la información se adquiere principalmente a través de receptores sensoriales y se metaboliza en el sistema nervioso . El resultado es la acción: alguna forma de movimiento , por ejemplo, locomoción , habla, movimiento interno de órganos, secreción de hormonas , etc. Las reacciones de un organismo se convierten en una señal informativa para otros organismos. El metabolismo de la información , que permite a los sistemas vivos mantener el orden, sólo es posible si existe una jerarquía de valores, pues las señales que llegan al organismo deben estar estructuradas. En los humanos esa jerarquía tiene tres niveles, es decir, biológico, emocional y sociocultural. [55] Kępiński explicó cómo diversos trastornos mentales son causados por distorsiones de esa jerarquía, y que el retorno a la salud mental es posible a través de su restauración. [56]

La idea fue continuada por Struzik, quien propuso que la teoría del metabolismo de la información de Kępiński puede ser vista como una extensión del principio de negentropía de la información de Léon Brillouin . [57] En 2011, la noción de "entropía psicológica" fue reintroducida a los psicólogos por Hirsh et al. [58] De manera similar a Kępiński, estos autores señalaron que la gestión de la incertidumbre es una capacidad crítica para cualquier organismo. La incertidumbre, que surge debido al conflicto entre posibilidades perceptivas y conductuales en competencia , se experimenta subjetivamente como ansiedad . Hirsh y sus colaboradores propusieron que tanto el dominio perceptivo como el conductual pueden conceptualizarse como distribuciones de probabilidad y que la cantidad de incertidumbre asociada con una experiencia perceptiva o conductual dada puede cuantificarse en términos de la fórmula de entropía de Claude Shannon .

La entropía está bien definida para los sistemas en equilibrio, por lo que se han planteado objeciones a la extensión de la segunda ley y de la entropía a los sistemas biológicos, especialmente en lo que respecta a su uso para apoyar o desacreditar la teoría de la evolución. [59] [60] Los sistemas vivos y, de hecho, muchos otros sistemas y procesos en el universo operan lejos del equilibrio.

Sin embargo, la entropía se define de manera mucho más amplia, basándose en las probabilidades de los estados de un sistema, ya sea dinámico o no (para lo cual el equilibrio podría ser relevante). Incluso en aquellos sistemas físicos en los que el equilibrio podría ser relevante, (1) los sistemas vivos no pueden persistir aislados, y (2) el segundo principio de la termodinámica no requiere que la energía libre se transforme en entropía siguiendo el camino más corto: los organismos vivos absorben energía de la luz solar o de compuestos químicos ricos en energía y finalmente devuelven parte de dicha energía al medio ambiente como entropía (generalmente en forma de calor y compuestos de baja energía libre como el agua y el dióxido de carbono).

El científico belga Ilya Prigogine ha contribuido a lo largo de toda su investigación a esta línea de estudio e intentado resolver esos límites conceptuales, ganando el premio Nobel en 1977. Una de sus principales contribuciones fue el concepto de sistema disipativo , que describe la termodinámica de sistemas abiertos en estados de no equilibrio. [61]