Una razón de probabilidades ( OR ) es una estadística que cuantifica la fuerza de la asociación entre dos eventos, A y B. La razón de probabilidades se define como la relación entre las probabilidades de que el evento A ocurra en presencia de B y las probabilidades de A en ausencia de B. Debido a la simetría, la razón de probabilidades calcula recíprocamente la relación entre las probabilidades de que B ocurra en presencia de A y las probabilidades de B en ausencia de A. Dos eventos son independientes si y solo si la OR es igual a 1, es decir, las probabilidades de un evento son las mismas en presencia o ausencia del otro evento. Si el OR es mayor que 1, entonces A y B están asociados (correlacionados) en el sentido de que, en comparación con la ausencia de B, la presencia de B aumenta las probabilidades de A, y simétricamente la presencia de A aumenta las probabilidades de B. Por el contrario, si el OR es menor que 1, entonces A y B están correlacionados negativamente, y la presencia de un evento reduce las probabilidades de que ocurra el otro evento.

Obsérvese que la razón de probabilidades es simétrica en los dos eventos y no se implica ninguna dirección causal (la correlación no implica causalidad ): un OR mayor que 1 no establece que B cause A, o que A cause B. [1]

Dos estadísticas similares que se utilizan a menudo para cuantificar asociaciones son el riesgo relativo (RR) y la reducción absoluta del riesgo (ARR). A menudo, el parámetro de mayor interés es en realidad el RR, que es la relación de las probabilidades análogas a las probabilidades utilizadas en el OR. Sin embargo, los datos disponibles con frecuencia no permiten el cálculo del RR o el ARR, pero sí permiten el cálculo del OR, como en los estudios de casos y controles , como se explica a continuación. Por otro lado, si una de las propiedades (A o B) es suficientemente rara (en epidemiología esto se llama el supuesto de enfermedad rara ), entonces el OR es aproximadamente igual al RR correspondiente.

El OR juega un papel importante en el modelo logístico .

Si lanzamos una moneda sin sesgo, la probabilidad de que salga cara y la probabilidad de que salga cruz son iguales: ambas son del 50 %. Imaginemos que sacamos una moneda con sesgo, lo que hace que sea dos veces más probable que salga cara. Pero, ¿qué significa "el doble de probabilidad" en términos de probabilidad? No puede significar literalmente duplicar el valor de probabilidad original, porque duplicar el 50 % daría como resultado el 100 %. Más bien, son las probabilidades las que se duplican: de probabilidades de 1:1 a probabilidades de 2:1. Las nuevas probabilidades serían del 66⅔ % para cara y del 33⅓ % para cruz.

Supongamos que una fuga de radiación en un pueblo de 1.000 habitantes aumenta la incidencia de una enfermedad rara. El número total de personas expuestas a la radiación es de las que desarrollaron la enfermedad y se mantuvieron sanas. El número total de personas no expuestas es de las que desarrollaron la enfermedad y se mantuvieron sanas. Podemos organizar esto en una tabla de contingencia :

El riesgo de desarrollar la enfermedad dada la exposición es y el de desarrollar la enfermedad dada la no exposición es . Una forma obvia de comparar los riesgos es utilizar la relación entre ambos, el riesgo relativo .

La razón de probabilidades es diferente. Las probabilidades de contraer la enfermedad si se expone son y las probabilidades si no se expone son. La razón de probabilidades es la relación de las dos,

Como se ilustra en este ejemplo, en un caso de enfermedad rara como este, el riesgo relativo y la razón de probabilidades son casi iguales. Por definición, una enfermedad rara implica que y . Por lo tanto, los denominadores del riesgo relativo y la razón de probabilidades son casi iguales ( y .

El riesgo relativo es más fácil de entender que la razón de probabilidades, pero una razón para utilizar la razón de probabilidades es que, por lo general, no se dispone de datos sobre toda la población y se debe utilizar un muestreo aleatorio . En el ejemplo anterior, si fuera muy costoso entrevistar a los habitantes de la aldea y averiguar si estuvieron expuestos a la radiación, entonces no se conocería la prevalencia de exposición a la radiación, ni tampoco los valores de o . Se podría tomar una muestra aleatoria de cincuenta habitantes de la aldea, pero es muy posible que dicha muestra aleatoria no incluya a nadie con la enfermedad, ya que solo el 2,6% de la población está enferma. En su lugar, se podría utilizar un estudio de casos y controles [2] en el que se entreviste a los 26 habitantes de la aldea enfermos, así como a una muestra aleatoria de 26 que no tengan la enfermedad. Los resultados podrían ser los siguientes ("podrían", porque se trata de una muestra aleatoria):

En esta muestra, las probabilidades de contraer la enfermedad, dado que alguien está expuesto, son de 20/10 y las probabilidades de que alguien no esté expuesto son de 6/16. Por lo tanto , la razón de probabilidades es bastante cercana a la razón de probabilidades calculada para todo el pueblo. Sin embargo, no se puede calcular el riesgo relativo, porque es la razón de los riesgos de contraer la enfermedad y necesitaríamos calcularlos . Debido a que el estudio seleccionó a personas con la enfermedad, la mitad de las personas de la muestra tienen la enfermedad y se sabe que eso es más que la prevalencia en toda la población.

En la literatura médica, es habitual calcular la razón de probabilidades y luego utilizar el supuesto de enfermedad rara (que suele ser razonable) para afirmar que el riesgo relativo es aproximadamente igual a ella. Esto no solo permite el uso de estudios de casos y controles, sino que también facilita el control de variables de confusión como el peso o la edad mediante análisis de regresión y tiene las propiedades deseables que se analizan en otras secciones de este artículo de invariancia e insensibilidad al tipo de muestreo. [3]

La razón de probabilidades es la relación entre las probabilidades de que un evento ocurra en un grupo y las probabilidades de que ocurra en otro grupo. El término también se utiliza para referirse a las estimaciones de esta razón basadas en muestras. Estos grupos pueden ser hombres y mujeres, un grupo experimental y un grupo de control , o cualquier otra clasificación dicotómica . Si las probabilidades del evento en cada uno de los grupos son p 1 (primer grupo) y p 2 (segundo grupo), entonces la razón de probabilidades es:

donde q x = 1 − p x . Una razón de probabilidades de 1 indica que la condición o evento en estudio tiene la misma probabilidad de ocurrir en ambos grupos. Una razón de probabilidades mayor que 1 indica que la condición o evento tiene más probabilidad de ocurrir en el primer grupo. Y una razón de probabilidades menor que 1 indica que la condición o evento tiene menos probabilidad de ocurrir en el primer grupo. La razón de probabilidades debe ser no negativa si está definida. No está definida si p 2 q 1 es igual a cero, es decir, si p 2 es igual a cero o q 1 es igual a cero.

La razón de probabilidades también se puede definir en términos de la distribución de probabilidad conjunta de dos variables aleatorias binarias . La distribución conjunta de las variables aleatorias binarias X e Y se puede escribir

donde p 11 , p 10 , p 01 y p 00 son "probabilidades de celda" no negativas que suman uno. Las probabilidades de Y dentro de las dos subpoblaciones definidas por X = 1 y X = 0 se definen en términos de las probabilidades condicionales dadas X , es decir , P ( Y | X ) :

Por lo tanto, la razón de probabilidades es

La expresión simple de la derecha, arriba, es fácil de recordar como el producto de las probabilidades de las "celdas concordantes" ( X = Y ) dividido por el producto de las probabilidades de las "celdas discordantes" ( X ≠ Y ) . Sin embargo, en algunas aplicaciones, el etiquetado de categorías como cero y uno es arbitrario, por lo que no hay nada especial en los valores concordantes versus discordantes en estas aplicaciones.

Si hubiéramos calculado la razón de probabilidades en función de las probabilidades condicionales dadas Y ,

Habríamos obtenido el mismo resultado

Otras medidas del tamaño del efecto para datos binarios , como el riesgo relativo, no tienen esta propiedad de simetría.

Si X e Y son independientes, sus probabilidades conjuntas se pueden expresar en términos de sus probabilidades marginales p x = P ( X = 1) y p y = P ( Y = 1) , de la siguiente manera

En este caso, la razón de probabilidades es igual a uno y, a la inversa, la razón de probabilidades solo puede ser igual a uno si las probabilidades conjuntas se pueden factorizar de esta manera. Por lo tanto, la razón de probabilidades es igual a uno si y solo si X e Y son independientes .

La razón de probabilidades es una función de las probabilidades de las celdas y, a la inversa, las probabilidades de las celdas se pueden recuperar si se conoce la razón de probabilidades y las probabilidades marginales P ( X = 1) = p 11 + p 10 y P ( Y = 1) = p 11 + p 01. Si la razón de probabilidades R difiere de 1, entonces

donde p 1• = p 11 + p 10 , p •1 = p 11 + p 01 , y

En el caso donde R = 1 , tenemos independencia, por lo que p 11 = p 1• p •1 .

Una vez que tenemos p 11 , las otras tres probabilidades de celda se pueden recuperar fácilmente a partir de las probabilidades marginales.

Supongamos que en una muestra de 100 hombres, 90 bebieron vino en la semana anterior (por lo tanto, 10 no lo hicieron), mientras que en una muestra de 80 mujeres solo 20 bebieron vino en el mismo período (por lo tanto, 60 no lo hicieron). Esto forma la tabla de contingencia:

La razón de probabilidades (OR) se puede calcular directamente a partir de esta tabla como:

Por otra parte, las probabilidades de que un hombre beba vino son de 90 a 10, o 9:1, mientras que las probabilidades de que una mujer beba vino son de sólo 20 a 60, o 1:3 = 0,33. La razón de probabilidades es, por tanto, 9/0,33, o 27, lo que demuestra que los hombres tienen muchas más probabilidades de beber vino que las mujeres. El cálculo detallado es:

Este ejemplo también muestra cómo las razones de probabilidades a veces son sensibles a la hora de indicar posiciones relativas: en esta muestra, los hombres tienen (90/100)/(20/80) = 3,6 veces más probabilidades de haber bebido vino que las mujeres, pero tienen 27 veces más probabilidades. El logaritmo de la razón de probabilidades, la diferencia de los logits de las probabilidades , atenúa este efecto y también hace que la medida sea simétrica con respecto al ordenamiento de los grupos. Por ejemplo, utilizando logaritmos naturales , una razón de probabilidades de 27/1 corresponde a 3,296, y una razón de probabilidades de 1/27 corresponde a −3,296.

Se han desarrollado varios enfoques para la inferencia estadística de razones de probabilidades.

Un enfoque de inferencia utiliza aproximaciones de muestras grandes a la distribución de muestreo del logaritmo de la razón de probabilidades (el logaritmo natural de la razón de probabilidades). Si utilizamos la notación de probabilidad conjunta definida anteriormente, el logaritmo de la razón de probabilidades de la población es

Si observamos los datos en forma de tabla de contingencia

Entonces las probabilidades en la distribución conjunta se pueden estimar como

dóndeij = n ij / n , donde n = n 11 + n 10 + n 01 + n 00 es la suma de los cuatro recuentos de células. La razón de probabilidades logarítmica de la muestra es

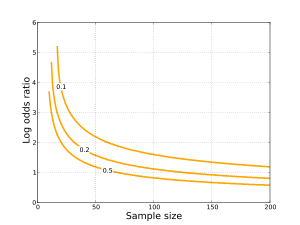

La distribución del log-odds ratio es aproximadamente normal con:

El error estándar para el logaritmo de la razón de probabilidades es aproximadamente

Esta es una aproximación asintótica y no dará un resultado significativo si alguno de los recuentos de células es muy pequeño. Si L es el logaritmo de la razón de probabilidades de la muestra, un intervalo de confianza aproximado del 95% para el logaritmo de la razón de probabilidades de la población es L ± 1,96SE . [4] Esto se puede mapear a exp( L − 1,96SE), exp( L + 1,96SE) para obtener un intervalo de confianza del 95% para el logaritmo de la razón de probabilidades. Si deseamos probar la hipótesis de que el logaritmo de la razón de probabilidades de la población es igual a uno, el valor p bilateral es 2 P ( Z < −| L |/SE) , donde P denota una probabilidad y Z denota una variable aleatoria normal estándar .

Un enfoque alternativo para la inferencia de razones de probabilidades analiza la distribución de los datos condicionalmente en las frecuencias marginales de X e Y. Una ventaja de este enfoque es que la distribución de muestreo de la razón de probabilidades se puede expresar con exactitud.

La regresión logística es una forma de generalizar la razón de probabilidades más allá de dos variables binarias. Supongamos que tenemos una variable de respuesta binaria Y y una variable predictora binaria X , y además tenemos otras variables predictoras Z 1 , ..., Z p que pueden ser binarias o no. Si utilizamos la regresión logística múltiple para hacer la regresión de Y sobre X , Z 1 , ..., Z p , entonces el coeficiente estimado para X está relacionado con una razón de probabilidades condicional. Específicamente, a nivel de población

Por lo tanto, es una estimación de esta razón de probabilidades condicional. La interpretación de es como una estimación de la razón de probabilidades entre Y y X cuando los valores de Z 1 , ..., Z p se mantienen fijos.

Si los datos forman una "muestra de población", las probabilidades de las celdas se interpretan como las frecuencias de cada uno de los cuatro grupos de la población, tal como se definen por sus valores X e Y. En muchos casos, no es práctico obtener una muestra de población, por lo que se utiliza una muestra seleccionada. Por ejemplo, podemos optar por muestrear unidades con X = 1 con una probabilidad dada f , independientemente de su frecuencia en la población (lo que requeriría muestrear unidades con X = 0 con una probabilidad de 1 − f ). En esta situación, nuestros datos seguirían las siguientes probabilidades conjuntas:

La razón de probabilidades p 11 p 00 / p 01 p 10 para esta distribución no depende del valor de f . Esto demuestra que la razón de probabilidades (y, en consecuencia, el logaritmo de la razón de probabilidades) es invariante con respecto a un muestreo no aleatorio basado en una de las variables estudiadas. Sin embargo, cabe señalar que el error estándar del logaritmo de la razón de probabilidades depende del valor de f . [ cita requerida ]

Este hecho se aprovecha en dos situaciones importantes:

En ambos entornos, la razón de probabilidades se puede calcular a partir de la muestra seleccionada, sin sesgar los resultados respecto de lo que se habría obtenido para una muestra de población.

Debido al uso generalizado de la regresión logística , la razón de probabilidades se utiliza ampliamente en muchos campos de la investigación médica y de las ciencias sociales. La razón de probabilidades se utiliza comúnmente en la investigación de encuestas , en epidemiología y para expresar los resultados de algunos ensayos clínicos , como en los estudios de casos y controles . A menudo se abrevia "OR" en los informes. Cuando se combinan datos de varias encuestas, a menudo se expresará como "OR agrupado".

Como se explica en la sección "Ejemplo motivador", el riesgo relativo suele ser mejor que la razón de probabilidades para entender la relación entre el riesgo y alguna variable como la radiación o un nuevo fármaco. En esa sección también se explica que si se cumple el supuesto de enfermedad rara , la razón de probabilidades es una buena aproximación al riesgo relativo [5] y que tiene algunas ventajas sobre el riesgo relativo. Cuando el supuesto de enfermedad rara no se cumple, la razón de probabilidades no ajustada será mayor que el riesgo relativo [6] [7] [8], pero los métodos novedosos pueden utilizar fácilmente los mismos datos para estimar el riesgo relativo, las diferencias de riesgo, las probabilidades base u otras cantidades [9] .

Si está disponible el riesgo absoluto en el grupo no expuesto, la conversión entre ambos se calcula mediante: [6]

donde R C es el riesgo absoluto del grupo no expuesto.

Si no se aplica el supuesto de enfermedad rara, el odds ratio puede ser muy diferente del riesgo relativo y no debe interpretarse como un riesgo relativo.

Consideremos la tasa de mortalidad de los pasajeros hombres y mujeres cuando se hundió un barco. [3] De 462 mujeres, 154 murieron y 308 sobrevivieron. De 851 hombres, 709 murieron y 142 sobrevivieron. Claramente, un hombre en el barco tenía más probabilidades de morir que una mujer, pero ¿cuántas más probabilidades? Dado que más de la mitad de los pasajeros murieron, el supuesto de enfermedad rara se viola rotundamente.

Para calcular la razón de probabilidades, tenga en cuenta que, en el caso de las mujeres, las probabilidades de morir eran de 1 a 2 (154/308). En el caso de los hombres, las probabilidades eran de 5 a 1 (709/142). La razón de probabilidades es de 9,99 (4,99/0,5). Los hombres tenían diez veces más probabilidades de morir que las mujeres.

En el caso de las mujeres, la probabilidad de muerte fue del 33% (154/462). En el caso de los hombres, la probabilidad fue del 83% (709/851). El riesgo relativo de muerte es de 2,5 (0,83/0,33). Un hombre tenía 2,5 veces más probabilidades de morir que una mujer.

En la literatura médica, las razones de probabilidades se han confundido a menudo con el riesgo relativo. Para quienes no son estadísticos, la razón de probabilidades es un concepto difícil de comprender y ofrece una cifra más impresionante del efecto. [10] Sin embargo, la mayoría de los autores consideran que el riesgo relativo se entiende fácilmente. [11] En un estudio, los miembros de una fundación nacional de enfermedades tenían en realidad 3,5 veces más probabilidades que los no miembros de haber oído hablar de un tratamiento común para esa enfermedad, pero la razón de probabilidades era de 24 y el artículo afirmaba que los miembros tenían "más de 20 veces más probabilidades de haber oído hablar" del tratamiento. [12] Un estudio de artículos publicados en dos revistas informó que el 26% de los artículos que utilizaban una razón de probabilidades la interpretaban como una razón de riesgo. [13]

Esto puede reflejar el simple proceso de autores incomprensivos que eligen la figura más impresionante y publicable. [11] Pero su uso puede ser deliberadamente engañoso en algunos casos. [14] Se ha sugerido que la razón de probabilidades solo debería presentarse como una medida del tamaño del efecto cuando no se puede estimar directamente la razón de riesgo , [10] pero con los métodos recientemente disponibles siempre es posible estimar la razón de riesgo, que generalmente debería usarse en su lugar. [9]

Si bien los riesgos relativos son potencialmente más fáciles de interpretar para un público general, existen ventajas matemáticas y conceptuales al utilizar un odds ratio en lugar de un riesgo relativo, en particular en los modelos de regresión. Por ese motivo, no existe un consenso en los campos de la epidemiología o la bioestadística sobre si se deben preferir los riesgos relativos o los odds ratios cuando ambos se pueden utilizar de forma válida, como en los ensayos clínicos y los estudios de cohorte [15].

La razón de probabilidades tiene otra propiedad única: es directamente invertible matemáticamente, ya sea que se analice el OR como supervivencia de la enfermedad o como incidencia de aparición de la enfermedad, donde el OR para la supervivencia es el recíproco directo de 1/OR para el riesgo. Esto se conoce como la "invariancia de la razón de probabilidades". Por el contrario, el riesgo relativo no posee esta propiedad matemática invertible cuando se estudia la supervivencia de la enfermedad frente a la incidencia de aparición. Este fenómeno de invertibilidad de la razón de probabilidades frente a la no invertibilidad del riesgo relativo se ilustra mejor con un ejemplo:

Supongamos que en un ensayo clínico, el riesgo de eventos adversos es de 4/100 en el grupo del fármaco y de 2/100 en el del placebo... lo que arroja un RR=2 y un OR=2,04166 para el riesgo adverso del fármaco frente al placebo. Sin embargo, si el análisis se invirtiera y los eventos adversos se analizaran en cambio como supervivencia libre de eventos, entonces el grupo del fármaco tendría una tasa de 96/100 y el grupo del placebo una tasa de 98/100, lo que arrojaría un RR=0,9796 para la supervivencia del fármaco frente al placebo, pero un OR=0,48979. Como se puede ver, un RR de 0,9796 claramente no es el recíproco de un RR de 2. En cambio, un OR de 0,48979 es de hecho el recíproco directo de un OR de 2,04166.

Esto es lo que se denomina nuevamente "invariancia de la razón de probabilidades" y por qué un RR para supervivencia no es lo mismo que un RR para riesgo, mientras que el OR tiene esta propiedad simétrica cuando se analiza la supervivencia o el riesgo adverso. El peligro para la interpretación clínica del OR surge cuando la tasa de eventos adversos no es rara, exagerando así las diferencias cuando no se cumple el supuesto de enfermedad rara del OR. Por otro lado, cuando la enfermedad es rara, el uso de un RR para supervivencia (por ejemplo, el RR = 0,9796 del ejemplo anterior) puede ocultar y disimular clínicamente una duplicación importante del riesgo adverso asociado con un fármaco o exposición. [ cita requerida ]

La razón de probabilidades de la muestra n 11 n 00 / n 10 n 01 es fácil de calcular y, para muestras moderadas y grandes, funciona bien como estimador de la razón de probabilidades de la población. Cuando una o más de las celdas de la tabla de contingencia pueden tener un valor pequeño, la razón de probabilidades de la muestra puede estar sesgada y presentar una varianza alta .

Se han propuesto varios estimadores alternativos de la razón de probabilidades para abordar las limitaciones de la razón de probabilidades de la muestra. Un estimador alternativo es el estimador de máxima verosimilitud condicional, que condiciona los márgenes de fila y columna al formar la probabilidad de maximizar (como en la prueba exacta de Fisher ). [16] Otro estimador alternativo es el estimador de Mantel-Haenszel . [ cita requerida ]

Las siguientes cuatro tablas de contingencia contienen los recuentos de células observados, junto con la razón de probabilidades de muestra ( OR ) y la razón de probabilidades logarítmica de muestra ( LOR ) correspondientes:

Las siguientes distribuciones de probabilidad conjunta contienen las probabilidades de las celdas de población, junto con la razón de probabilidades de población ( OR ) y la razón de probabilidades logarítmica de población ( LOR ) correspondientes:

Existen otras estadísticas de resumen para las tablas de contingencia que miden la asociación entre dos eventos, como la Y de Yule y la Q de Yule ; estas dos están normalizadas de modo que son 0 para eventos independientes, 1 para eventos perfectamente correlacionados y −1 para eventos perfectamente correlacionados negativamente. Edwards (1963) las estudió y argumentó que estas medidas de asociación deben ser funciones de la razón de probabilidades, a la que se refirió como razón cruzada . [ cita requerida ]

Un estudio de casos y controles implica la selección de muestras representativas de casos y controles que padecen o no alguna enfermedad, respectivamente. Estas muestras suelen ser independientes entre sí. La prevalencia previa de exposición a algún factor de riesgo se observa en los sujetos de ambas muestras. Esto permite la estimación de la razón de probabilidades de enfermedad en personas expuestas frente a no expuestas, como se señaló anteriormente. [17] Sin embargo, a veces tiene sentido emparejar los casos con los controles en una o más variables de confusión . [18] En este caso, la exposición previa de interés se determina para cada caso y su control emparejado. Los datos se pueden resumir en la siguiente tabla.

Esta tabla muestra el estado de exposición de los pares de sujetos emparejados. Hay pares en los que tanto el caso como su control emparejado estuvieron expuestos, pares en los que el paciente caso estuvo expuesto pero el sujeto de control no, pares en los que el sujeto de control estuvo expuesto pero el paciente caso no, y pares en los que ninguno de los sujetos estuvo expuesto. La exposición de los pares de casos y controles emparejados está correlacionada debido a los valores similares de sus variables de confusión compartidas.

La siguiente derivación se debe a Breslow & Day . [18] Consideramos que cada par pertenece a un estrato con valores idénticos de las variables de confusión. Condicionado a pertenecer al mismo estrato, el estado de exposición de los casos y controles es independiente entre sí. Para cualquier par caso-control dentro del mismo estrato, sea

sea la probabilidad de que un paciente caso esté expuesto,

sea la probabilidad de que un paciente de control esté expuesto,

sea la probabilidad de que un paciente caso no esté expuesto, y

sea la probabilidad de que un paciente de control no esté expuesto.

Entonces, la probabilidad de que un caso esté expuesto y un control no es , y la probabilidad de que un control esté expuesto y un caso no es . La razón de probabilidades dentro del estrato para la exposición en los casos en relación con los controles es

Suponemos que es constante en todos los estratos. [18]

Ahora bien, los pares concordantes en los que tanto el caso como el control están expuestos, o ninguno de ellos está expuesto, no nos dicen nada sobre las probabilidades de exposición en los casos en relación con las probabilidades de exposición entre los controles. La probabilidad de que el caso esté expuesto y el control no, dado que el par es discordante es

La distribución de dado el número de pares discordantes es binomial ~ B y la estimación de máxima verosimilitud de es

Al multiplicar ambos lados de esta ecuación por y restar se obtiene

y por lo tanto

.

Ahora es la estimación de máxima verosimilitud de , y es una función monótona de . De ello se deduce que es la estimación de máxima verosimilitud condicional de dado el número de pares discordantes. Rothman et al. [19] dan una derivación alternativa de al mostrar que es un caso especial de la estimación de Mantel-Haenszel de la razón de probabilidades intraestrato para tablas estratificadas 2x2. [19] También hacen referencia a Breslow & Day [18] como proveedores de la derivación dada aquí.

Bajo la hipótesis nula de que .

Por lo tanto, podemos probar la hipótesis nula de que . Esto se hace utilizando la prueba de McNemar .

Hay varias formas de calcular un intervalo de confianza para . Sea y el límite inferior y superior de un intervalo de confianza para , respectivamente. Como , el intervalo de confianza correspondiente para es

.

Las tablas 2x2 emparejadas también pueden analizarse utilizando regresión logística condicional . [20] Esta técnica tiene la ventaja de permitir a los usuarios hacer una regresión del estado de caso-control frente a múltiples factores de riesgo a partir de datos de caso-control emparejados.

McEvoy et al. [21] estudiaron el uso de teléfonos celulares por parte de los conductores como un factor de riesgo para accidentes automovilísticos en un estudio de casos cruzados. [17] Todos los sujetos del estudio estuvieron involucrados en un accidente automovilístico que requirió asistencia hospitalaria. El uso del teléfono celular de cada conductor en el momento de su accidente se comparó con su uso del teléfono celular en un intervalo de control a la misma hora del día una semana antes. Se esperaría que el uso del teléfono celular de una persona en el momento del accidente se correlacionara con su uso una semana antes. La comparación del uso durante el accidente y los intervalos de control ajusta las características del conductor y la hora del día y el día de la semana. Los datos se pueden resumir en la siguiente tabla.

Hubo 5 conductores que usaron sus teléfonos en ambos intervalos, 27 que los usaron en el intervalo de colisión pero no en el intervalo de control, 6 que los usaron en el intervalo de control pero no en el intervalo de colisión, y 288 que no los usaron en ninguno de los intervalos. La razón de probabilidades de sufrir una colisión mientras usaban su teléfono en relación con conducir sin usarlo fue

.

Prueba de la hipótesis nula que es lo mismo que probar la hipótesis nula de que dados 27 de 33 pares discordantes en los que el conductor estaba usando su teléfono en el momento de su accidente. McNemar's . Esta estadística tiene un grado de libertad y produce un valor P de 0,0003. Esto nos permite rechazar la hipótesis de que el uso del teléfono celular no tiene efecto sobre el riesgo de accidentes automovilísticos ( ) con un alto nivel de significancia estadística.

Usando el método de Wilson , un intervalo de confianza del 95% para es (0,6561, 0,9139). Por lo tanto, un intervalo de confianza del 95% para es

(McEvoy et al. [21] analizaron sus datos utilizando regresión logística condicional y obtuvieron resultados casi idénticos a los que se presentan aquí. Véase la última fila de la Tabla 3 en su artículo).