En estadística , un valor atípico es un punto de datos que difiere significativamente de otras observaciones. [1] [2] Un valor atípico puede deberse a una variabilidad en la medición, una indicación de datos nuevos o puede ser el resultado de un error experimental; estos últimos a veces se excluyen del conjunto de datos . [3] [4] Un valor atípico puede ser una indicación de una posibilidad emocionante, pero también puede causar problemas graves en los análisis estadísticos.

Los valores atípicos pueden ocurrir por casualidad en cualquier distribución, pero pueden indicar un comportamiento o estructuras novedosas en el conjunto de datos, un error de medición o que la población tiene una distribución de cola pesada . En el caso del error de medición, uno desea descartarlos o usar estadísticas que sean robustas a los valores atípicos, mientras que en el caso de distribuciones de cola pesada, indican que la distribución tiene una alta asimetría y que uno debe ser muy cauteloso al usar herramientas o intuiciones que asumen una distribución normal . Una causa frecuente de valores atípicos es una mezcla de dos distribuciones, que pueden ser dos subpoblaciones distintas, o pueden indicar "ensayo correcto" versus "error de medición"; esto se modela mediante un modelo de mezcla .

En la mayoría de los muestreos de datos más grandes, algunos puntos de datos estarán más alejados de la media de la muestra de lo que se considera razonable. Esto puede deberse a un error sistemático incidental o a fallas en la teoría que generó una familia supuesta de distribuciones de probabilidad , o puede ser que algunas observaciones estén lejos del centro de los datos. Por lo tanto, los puntos atípicos pueden indicar datos defectuosos, procedimientos erróneos o áreas en las que una determinada teoría podría no ser válida. Sin embargo, en muestras grandes, es de esperar que haya una pequeña cantidad de valores atípicos (y no debido a ninguna condición anómala).

Los valores atípicos, que son las observaciones más extremas, pueden incluir el máximo o el mínimo de la muestra , o ambos, dependiendo de si son extremadamente altos o bajos. Sin embargo, el máximo y el mínimo de la muestra no siempre son valores atípicos porque pueden no estar inusualmente alejados de otras observaciones.

La interpretación ingenua de las estadísticas derivadas de conjuntos de datos que incluyen valores atípicos puede ser engañosa. Por ejemplo, si se calcula la temperatura promedio de 10 objetos en una habitación, y nueve de ellos están entre 20 y 25 grados Celsius , pero un horno está a 175 °C, la mediana de los datos estará entre 20 y 25 °C, pero la temperatura media estará entre 35,5 y 40 °C. En este caso, la mediana refleja mejor la temperatura de un objeto muestreado aleatoriamente (pero no la temperatura en la habitación) que la media; interpretar ingenuamente la media como "una muestra típica", equivalente a la mediana, es incorrecto. Como se ilustra en este caso, los valores atípicos pueden indicar puntos de datos que pertenecen a una población diferente a la del resto del conjunto de muestra .

Se dice que los estimadores capaces de manejar valores atípicos son robustos: la mediana es una estadística robusta de tendencia central , mientras que la media no lo es. [5] Sin embargo, la media es generalmente un estimador más preciso. [6]

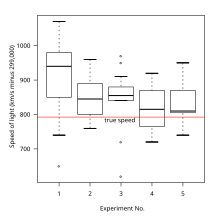

En el caso de datos distribuidos normalmente , la regla de tres sigma significa que aproximadamente 1 de cada 22 observaciones diferirá en el doble de la desviación estándar o más de la media, y 1 de cada 370 se desviará en tres veces la desviación estándar. [7] En una muestra de 1000 observaciones, la presencia de hasta cinco observaciones que se desvíen de la media en más de tres veces la desviación estándar está dentro del rango de lo que se puede esperar, siendo menos del doble del número esperado y, por lo tanto, dentro de 1 desviación estándar del número esperado (véase la distribución de Poisson ) y no indica una anomalía. Sin embargo, si el tamaño de la muestra es de solo 100, solo tres de esos valores atípicos ya son motivo de preocupación, siendo más de 11 veces el número esperado.

En general, si se conoce a priori la naturaleza de la distribución de la población , es posible comprobar si el número de valores atípicos se desvía significativamente de lo que se puede esperar: para un valor de corte dado (por lo que las muestras caen más allá del valor de corte con probabilidad p ) de una distribución dada, el número de valores atípicos seguirá una distribución binomial con parámetro p , que generalmente se puede aproximar bien mediante la distribución de Poisson con λ = pn . Por lo tanto, si se toma una distribución normal con un valor de corte de 3 desviaciones estándar de la media, p es aproximadamente 0,3% y, por lo tanto, para 1000 ensayos se puede aproximar el número de muestras cuya desviación supera las 3 sigmas mediante una distribución de Poisson con λ = 3.

Los valores atípicos pueden tener muchas causas anómalas. Un aparato físico para tomar medidas puede haber sufrido un mal funcionamiento transitorio. Puede haber habido un error en la transmisión o transcripción de datos. Los valores atípicos surgen debido a cambios en el comportamiento del sistema, comportamiento fraudulento, error humano, error del instrumento o simplemente a través de desviaciones naturales en las poblaciones. Una muestra puede haber sido contaminada con elementos externos a la población que se está examinando. Alternativamente, un valor atípico podría ser el resultado de un fallo en la teoría asumida, lo que requiere una investigación más profunda por parte del investigador. Además, la apariencia patológica de valores atípicos de una determinada forma aparece en una variedad de conjuntos de datos, lo que indica que el mecanismo causal de los datos puede diferir en el extremo ( efecto King ).

No existe una definición matemática rígida de lo que constituye un valor atípico; determinar si una observación es o no un valor atípico es, en última instancia, un ejercicio subjetivo. [8] Existen varios métodos de detección de valores atípicos, algunos de los cuales se tratan como sinónimos de detección de novedad. [9] [10] [11] [12] [13] Algunos son gráficos, como los gráficos de probabilidad normal . Otros se basan en modelos. Los diagramas de caja son un híbrido.

Los métodos basados en modelos que se utilizan comúnmente para la identificación suponen que los datos provienen de una distribución normal e identifican las observaciones que se consideran "poco probables" en función de la media y la desviación estándar:

Se propone determinar en una serie de observaciones el límite de error, más allá del cual todas las observaciones que impliquen un error tan grande pueden ser rechazadas, siempre que haya tantas como tales observaciones. El principio sobre el cual se propone resolver este problema es que las observaciones propuestas deben ser rechazadas cuando la probabilidad del sistema de errores obtenido al retenerlas sea menor que la del sistema de errores obtenido al rechazarlas multiplicada por la probabilidad de hacer tantas, y no más, observaciones anormales. (Citado en la nota editorial de la página 516 a Peirce (edición de 1982) de A Manual of Astronomy 2:558 de Chauvenet.) [15] [16] [17] [18]

Otros métodos señalan las observaciones en función de medidas como el rango intercuartil . Por ejemplo, si y son los cuartiles inferior y superior respectivamente, entonces se podría definir un valor atípico como cualquier observación fuera del rango:

para alguna constante no negativa . John Tukey propuso esta prueba, donde indica un "valor atípico" y indica datos que están "muy fuera de lugar". [19]

En varios dominios, como, entre otros, la estadística , el procesamiento de señales , las finanzas , la econometría , la fabricación , las redes y la minería de datos , la tarea de detección de anomalías puede adoptar otros enfoques. Algunos de estos pueden basarse en la distancia [20] [21] y en la densidad, como el factor de valor atípico local (LOF). [22] Algunos enfoques pueden utilizar la distancia a los k vecinos más cercanos para etiquetar las observaciones como valores atípicos o no atípicos. [23]

La prueba de Thompson Tau modificada [ cita requerida ] es un método utilizado para determinar si existe un valor atípico en un conjunto de datos. La fortaleza de este método radica en el hecho de que tiene en cuenta la desviación estándar y el promedio de un conjunto de datos y proporciona una zona de rechazo determinada estadísticamente; por lo tanto, proporciona un método objetivo para determinar si un punto de datos es un valor atípico. [ cita requerida ] [24] Cómo funciona: primero, se determina el promedio de un conjunto de datos. A continuación, se determina la desviación absoluta entre cada punto de datos y el promedio. En tercer lugar, se determina una región de rechazo utilizando la fórmula:

donde es el valor crítico de la distribución t de Student con n -2 grados de libertad, n es el tamaño de la muestra y s es la desviación estándar de la muestra. Para determinar si un valor es un valor atípico: Calcule . Si δ > Región de rechazo, el punto de datos es un valor atípico. Si δ ≤ Región de rechazo, el punto de datos no es un valor atípico.

La prueba de Thompson Tau modificada se utiliza para encontrar un valor atípico a la vez (se elimina el valor más grande de δ si es un valor atípico). Es decir, si se descubre que un punto de datos es un valor atípico, se lo elimina del conjunto de datos y se aplica nuevamente la prueba con un nuevo promedio y una región de rechazo. Este proceso continúa hasta que no queden valores atípicos en un conjunto de datos.

Algunos trabajos también han examinado valores atípicos para datos nominales (o categóricos). En el contexto de un conjunto de ejemplos (o instancias) en un conjunto de datos, la dureza de la instancia mide la probabilidad de que una instancia se clasifique incorrectamente ( donde y es la etiqueta de clase asignada y x representa el valor del atributo de entrada para una instancia en el conjunto de entrenamiento t ). [25] Idealmente, la dureza de la instancia se calcularía sumando el conjunto de todas las hipótesis posibles H :

En la práctica, esta formulación no es viable ya que H es potencialmente infinito y su cálculo es desconocido para muchos algoritmos. Por lo tanto, la dureza de la instancia se puede aproximar utilizando un subconjunto diverso :

donde es la hipótesis inducida por el algoritmo de aprendizaje entrenado en el conjunto de entrenamiento t con hiperparámetros . La dureza de la instancia proporciona un valor continuo para determinar si una instancia es una instancia atípica.

La elección de cómo tratar un valor atípico debe depender de la causa. Algunos estimadores son muy sensibles a los valores atípicos, en particular la estimación de matrices de covarianza .

Incluso cuando un modelo de distribución normal es apropiado para los datos que se analizan, se esperan valores atípicos para tamaños de muestra grandes y no se los debe descartar automáticamente si ese es el caso. [26] En cambio, se debe utilizar un método que sea robusto a los valores atípicos para modelar o analizar datos con valores atípicos que ocurren naturalmente. [26]

Al decidir si se debe eliminar un valor atípico, se debe considerar la causa. Como se mencionó anteriormente, si el origen del valor atípico se puede atribuir a un error experimental, o si se puede determinar de otra manera que el punto de datos atípico es erróneo, generalmente se recomienda eliminarlo. [26] [27] Sin embargo, es más conveniente corregir el valor erróneo, si es posible.

Por otra parte, la eliminación de un punto de datos únicamente porque es un valor atípico es una práctica controvertida, a menudo mal vista por muchos científicos e instructores de ciencias, ya que generalmente invalida los resultados estadísticos. [26] [27] Si bien los criterios matemáticos proporcionan un método objetivo y cuantitativo para el rechazo de datos, no hacen que la práctica sea más sólida científica o metodológicamente, especialmente en conjuntos pequeños o donde no se puede suponer una distribución normal. El rechazo de valores atípicos es más aceptable en áreas de práctica donde el modelo subyacente del proceso que se está midiendo y la distribución habitual del error de medición se conocen con confianza.

Los dos métodos habituales para excluir valores atípicos son el truncamiento (o recorte) y la técnica Winsorising . El recorte descarta los valores atípicos, mientras que la técnica Winsorising los reemplaza con los datos "no sospechosos" más cercanos. [28] La exclusión también puede ser una consecuencia del proceso de medición, como cuando un experimento no es totalmente capaz de medir esos valores extremos, lo que da como resultado datos censurados . [29]

En problemas de regresión , un enfoque alternativo puede ser excluir únicamente los puntos que exhiben un gran grado de influencia en los coeficientes estimados, utilizando una medida como la distancia de Cook . [30]

Si se excluye uno o más puntos de datos del análisis de datos , esto debe indicarse claramente en cualquier informe posterior.

Se debe considerar la posibilidad de que la distribución subyacente de los datos no sea aproximadamente normal, que tenga " colas gruesas ". Por ejemplo, cuando se toma una muestra de una distribución de Cauchy , [31] la varianza de la muestra aumenta con el tamaño de la muestra, la media de la muestra no converge a medida que aumenta el tamaño de la muestra y se esperan valores atípicos en tasas mucho mayores que para una distribución normal. Incluso una ligera diferencia en la gordura de las colas puede marcar una gran diferencia en el número esperado de valores extremos.

Un enfoque de pertenencia a conjuntos considera que la incertidumbre correspondiente a la i -ésima medición de un vector aleatorio desconocido x está representada por un conjunto Xi (en lugar de una función de densidad de probabilidad). Si no ocurren valores atípicos, x debería pertenecer a la intersección de todos los Xi . Cuando ocurren valores atípicos, esta intersección podría estar vacía, y deberíamos relajar un pequeño número de conjuntos Xi (tan pequeño como sea posible ) para evitar cualquier inconsistencia. [32] Esto se puede hacer usando la noción de q - intersección relajada . Como lo ilustra la figura, la q -intersección relajada corresponde al conjunto de todos los x que pertenecen a todos los conjuntos excepto q de ellos. Los conjuntos Xi que no intersecan la q -intersección relajada podrían sospecharse que son valores atípicos.

En los casos en que se conoce la causa de los valores atípicos, puede ser posible incorporar este efecto en la estructura del modelo, por ejemplo utilizando un modelo Bayes jerárquico o un modelo de mezcla . [33] [34]

Una observación atípica, o "atípica", es aquella que parece desviarse notablemente de otros miembros de la muestra en la que se encuentra.

es una observación que está muy alejada del resto de las observaciones.