La percepción del habla es el proceso mediante el cual se escuchan, interpretan y comprenden los sonidos del lenguaje . El estudio de la percepción del habla está estrechamente vinculado a los campos de la fonología y la fonética en lingüística y la psicología cognitiva y la percepción en psicología . La investigación en percepción del habla busca comprender cómo los oyentes humanos reconocen los sonidos del habla y usan esta información para comprender el lenguaje hablado. La investigación en percepción del habla tiene aplicaciones en la construcción de sistemas informáticos que pueden reconocer el habla , en la mejora del reconocimiento del habla para oyentes con discapacidad auditiva y del lenguaje y en la enseñanza de lenguas extranjeras.

El proceso de percepción del habla comienza en el nivel de la señal sonora y el proceso de audición. (Para una descripción completa del proceso de audición, consulte Audición ). Después de procesar la señal auditiva inicial, los sonidos del habla se procesan aún más para extraer pistas acústicas e información fonética. Esta información del habla puede luego usarse para procesos lingüísticos de nivel superior, como el reconocimiento de palabras.

Las señales acústicas son señales sensoriales contenidas en la señal sonora del habla que se utilizan en la percepción del habla para diferenciar los sonidos del habla que pertenecen a diferentes categorías fonéticas . Por ejemplo, una de las señales más estudiadas en el habla es el tiempo de inicio de la voz o VOT. El VOT es una señal primaria que señala la diferencia entre oclusivas sonoras y sordas, como "b" y "p". Otras señales diferencian sonidos que se producen en diferentes lugares de articulación o maneras de articulación . El sistema del habla también debe combinar estas señales para determinar la categoría de un sonido del habla específico. Esto a menudo se piensa en términos de representaciones abstractas de fonemas . Estas representaciones pueden luego combinarse para su uso en el reconocimiento de palabras y otros procesos del lenguaje.

No es fácil identificar a qué señales acústicas son sensibles los oyentes cuando perciben un sonido del habla en particular:

A primera vista, la solución al problema de cómo percibimos el habla parece engañosamente simple. Si uno pudiera identificar tramos de la forma de onda acústica que corresponden a unidades de percepción, entonces el camino desde el sonido hasta el significado estaría claro. Sin embargo, esta correspondencia o correspondencia ha resultado extremadamente difícil de encontrar, incluso después de unos cuarenta y cinco años de investigación sobre el problema. [1]

Si un aspecto específico de la forma de onda acústica indicara una unidad lingüística, una serie de pruebas con sintetizadores de voz serían suficientes para determinar dicha pista o pistas. Sin embargo, existen dos obstáculos importantes:

Aunque los oyentes perciben el habla como un flujo de unidades discretas [ cita requerida ] ( fonemas , sílabas y palabras ), esta linealidad es difícil de ver en la señal física del habla (ver la Figura 2 para un ejemplo). Los sonidos del habla no se suceden estrictamente entre sí, sino que se superponen. [5] Un sonido del habla está influenciado por los que lo preceden y los que lo siguen. Esta influencia puede ejercerse incluso a una distancia de dos o más segmentos (y a través de los límites de sílabas y palabras). [5]

Como la señal del habla no es lineal, existe un problema de segmentación. Es difícil delimitar un tramo de la señal del habla como perteneciente a una única unidad perceptiva. Por ejemplo, las propiedades acústicas del fonema /d/ dependerán de la producción de la vocal siguiente (debido a la coarticulación ).

La investigación y la aplicación de la percepción del habla deben hacer frente a varios problemas que resultan de lo que se ha denominado falta de invariancia. Es difícil encontrar relaciones constantes y fiables entre un fonema de una lengua y su manifestación acústica en el habla. Existen varias razones para ello:

El entorno fonético afecta las propiedades acústicas de los sonidos del habla. Por ejemplo, la /u/ en inglés se adelanta cuando está rodeada de consonantes coronales . [6] O bien, el tiempo de inicio de la voz que marca el límite entre las oclusivas sonoras y sordas es diferente para las oclusivas labiales, alveolares y velares y cambia con el acento o dependiendo de la posición dentro de una sílaba. [7]

Un factor importante que causa variación es la distinta velocidad del habla. Muchos contrastes fonémicos están constituidos por características temporales (vocales o consonantes cortas vs. largas, africadas vs. fricativas, oclusivas vs. glides, oclusivas sonoras vs. sordas, etc.) y ciertamente se ven afectados por cambios en el ritmo del habla . [1] Otra fuente importante de variación es el cuidado articulatorio vs. el descuido, que es típico del habla conectada (el "subtiro" articulatorio se refleja obviamente en las propiedades acústicas de los sonidos producidos).

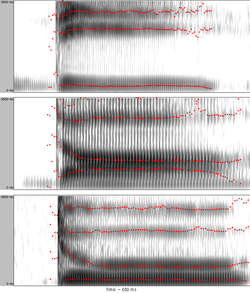

La estructura acústica resultante de las producciones de habla concretas depende de las propiedades físicas y psicológicas de los hablantes individuales. Los hombres, las mujeres y los niños generalmente producen voces con diferentes tonos. Debido a que los hablantes tienen tractos vocales de diferentes tamaños (debido especialmente al sexo y la edad), las frecuencias resonantes ( formantes ), que son importantes para el reconocimiento de los sonidos del habla, variarán en sus valores absolutos entre individuos [8] (ver Figura 3 para una ilustración de esto). La investigación muestra que los bebés a la edad de 7,5 meses no pueden reconocer la información presentada por hablantes de diferentes géneros; sin embargo, a la edad de 10,5 meses, pueden detectar las similitudes. [9] El dialecto y el acento extranjero también pueden causar variación, al igual que las características sociales del hablante y el oyente. [10]

A pesar de la gran variedad de hablantes y condiciones diferentes, los oyentes perciben las vocales y consonantes como categorías constantes. Se ha propuesto que esto se logra mediante el proceso de normalización perceptual en el que los oyentes filtran el ruido (es decir, la variación) para llegar a la categoría subyacente. Las diferencias en el tamaño del tracto vocal dan como resultado una variación en la frecuencia de los formantes entre hablantes; por lo tanto, un oyente tiene que ajustar su sistema perceptual a las características acústicas de un hablante en particular. Esto se puede lograr considerando las proporciones de los formantes en lugar de sus valores absolutos. [11] [12] [13] Este proceso se ha denominado normalización del tracto vocal (consulte la Figura 3 para ver un ejemplo). De manera similar, se cree que los oyentes ajustan la percepción de la duración al tempo actual del discurso que están escuchando; esto se ha denominado normalización de la velocidad del habla.

Si la normalización realmente se produce o no y cuál es su naturaleza exacta es un tema de controversia teórica (ver teorías más adelante). La constancia perceptiva es un fenómeno que no es exclusivo de la percepción del habla; también existe en otros tipos de percepción.

La percepción categórica interviene en los procesos de diferenciación perceptiva. Las personas perciben los sonidos del habla de manera categórica, es decir, es más probable que noten las diferencias entre categorías (fonemas) que dentro de las categorías. Por lo tanto, el espacio perceptivo entre categorías está distorsionado y los centros de categorías (o "prototipos") funcionan como un tamiz [14] o como imanes [15] para los sonidos del habla entrantes.

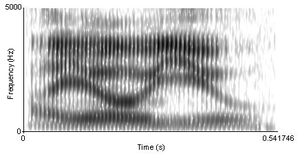

En un continuo artificial entre una oclusiva bilabial sorda y una sonora , cada nuevo paso difiere del anterior en la cantidad de VOT . El primer sonido es una [b] presonora , es decir, tiene un VOT negativo. Luego, al aumentar el VOT, llega a cero, es decir, la oclusiva es una [p] sorda simple no aspirada . Gradualmente, añadiendo la misma cantidad de VOT a la vez, la oclusiva es eventualmente una [pʰ] bilabial sorda fuertemente aspirada . (Este continuo fue utilizado en un experimento por Lisker y Abramson en 1970. [16] Los sonidos que utilizaron están disponibles en línea). En este continuo de, por ejemplo, siete sonidos, los oyentes nativos de inglés identificarán los primeros tres sonidos como /b/ y los últimos tres sonidos como /p/ con un límite claro entre las dos categorías. [16] Una prueba de identificación (o categorización) de dos alternativas producirá una función de categorización discontinua (ver la curva roja en la Figura 4).

En pruebas de capacidad para discriminar entre dos sonidos con valores VOT variables pero que tienen una distancia VOT constante entre sí (20 ms, por ejemplo), es probable que los oyentes se desempeñen a nivel de azar si ambos sonidos caen dentro de la misma categoría y a un nivel cercano al 100% si cada sonido cae en una categoría diferente (ver la curva de discriminación azul en la Figura 4).

La conclusión que se puede sacar de la prueba de identificación y de discriminación es que los oyentes tendrán una sensibilidad diferente al mismo aumento relativo de VOT dependiendo de si se cruzó o no el límite entre categorías. También se ha comprobado un ajuste perceptivo similar para otras señales acústicas.

En un experimento clásico, Richard M. Warren (1970) sustituyó un fonema de una palabra por un sonido similar a la tos. Perceptualmente, sus sujetos recuperaron el sonido del habla faltante sin ninguna dificultad y no pudieron identificar con precisión qué fonema había sido alterado, [17] un fenómeno conocido como el efecto de restauración fonémica . Por lo tanto, el proceso de percepción del habla no es necesariamente unidireccional.

Otro experimento básico comparó el reconocimiento de palabras habladas naturalmente dentro de una frase versus las mismas palabras de forma aislada, y descubrió que la precisión de la percepción generalmente disminuye en la última condición. Para investigar la influencia del conocimiento semántico en la percepción, Garnes y Bond (1976) utilizaron oraciones portadoras en las que las palabras objetivo solo diferían en un único fonema (bay/day/gay, por ejemplo) cuya calidad cambiaba a lo largo de un continuo. Cuando se colocaron en diferentes oraciones que naturalmente conducían a una interpretación, los oyentes tendieron a juzgar las palabras ambiguas de acuerdo con el significado de toda la oración [18] . [19] Es decir, los procesos del lenguaje de nivel superior conectados con la morfología , la sintaxis o la semántica pueden interactuar con los procesos básicos de percepción del habla para ayudar en el reconocimiento de los sonidos del habla.

Puede darse el caso de que no sea necesario e incluso posible que un oyente reconozca fonemas antes de reconocer unidades superiores, como palabras, por ejemplo. Después de obtener al menos una pieza fundamental de información sobre la estructura fonémica de la entidad percibida a partir de la señal acústica, los oyentes pueden compensar los fonemas faltantes o enmascarados por el ruido utilizando su conocimiento del lenguaje hablado. Los mecanismos compensatorios pueden incluso operar a nivel de oración, como en canciones, frases y versos aprendidos, un efecto respaldado por patrones de codificación neuronal consistentes con los fragmentos continuos del habla faltantes, [20] a pesar de la falta de toda la información sensorial ascendente relevante.

La primera hipótesis de la percepción del habla se utilizó con pacientes que adquirieron un déficit de comprensión auditiva, también conocido como afasia receptiva . Desde entonces se han clasificado muchas discapacidades, lo que dio como resultado una verdadera definición de "percepción del habla". [21] El término "percepción del habla" describe el proceso de interés que emplea contextos subléxicos para el proceso de sondeo. Consiste en muchas funciones lingüísticas y gramaticales diferentes, como: características, segmentos (fonemas), estructura silábica (unidad de pronunciación), formas fonológicas de las palabras (cómo se agrupan los sonidos), características gramaticales, morfemia (prefijos y sufijos) e información semántica (el significado de las palabras). En los primeros años, estaban más interesados en la acústica del habla. Por ejemplo, estaban buscando las diferencias entre /ba/ o /da/, pero ahora la investigación se ha dirigido a la respuesta en el cerebro a los estímulos. En los últimos años, se ha desarrollado un modelo para crear un sentido de cómo funciona la percepción del habla; Este modelo se conoce como el modelo de doble flujo. Este modelo ha cambiado drásticamente la forma en que los psicólogos ven la percepción. La primera sección del modelo de doble flujo es la vía ventral. Esta vía incorpora el giro temporal medio, el surco temporal inferior y quizás el giro temporal inferior . La vía ventral muestra representaciones fonológicas a las representaciones léxicas o conceptuales, que es el significado de las palabras. La segunda sección del modelo de doble flujo es la vía dorsal. Esta vía incluye el parietotemporal de Silvio, el giro frontal inferior, la ínsula anterior y la corteza premotora. Su función principal es tomar los estímulos sensoriales o fonológicos y transferirlos a una representación articulatorio-motora (formación del habla). [22]

La afasia es una alteración del procesamiento del lenguaje causada por un daño en el cerebro. Diferentes partes del procesamiento del lenguaje se ven afectadas según el área del cerebro que esté dañada, y la afasia se clasifica además según la ubicación de la lesión o la constelación de síntomas. El daño en el área de Broca del cerebro a menudo resulta en afasia expresiva que se manifiesta como un deterioro en la producción del habla. El daño en el área de Wernicke a menudo resulta en afasia receptiva donde el procesamiento del habla se ve afectado. [23]

La afasia con alteración de la percepción del habla suele presentar lesiones o daños localizados en los lóbulos temporal o parietal izquierdos . Son frecuentes las dificultades léxicas y semánticas, y puede verse afectada la comprensión. [23]

La agnosia es "la pérdida o disminución de la capacidad de reconocer objetos o estímulos familiares generalmente como resultado de un daño cerebral". [24] Hay varios tipos diferentes de agnosia que afectan a cada uno de nuestros sentidos, pero las dos más comunes relacionadas con el habla son la agnosia del habla y la fonagnosia .

Agnosia del habla : La sordera verbal pura, o agnosia del habla, es un deterioro en el que una persona mantiene la capacidad de oír, producir el habla e incluso leer el habla, pero no puede comprender o percibir correctamente el habla. Estos pacientes parecen tener todas las habilidades necesarias para procesar correctamente el habla, pero parecen no tener experiencia asociada con los estímulos del habla. Los pacientes han informado: "Puedo oírte hablar, pero no puedo traducirlo". [25] A pesar de que reciben y procesan físicamente los estímulos del habla, sin la capacidad de determinar el significado del habla, esencialmente son incapaces de percibir el habla en absoluto. No se han encontrado tratamientos conocidos, pero a partir de estudios de casos y experimentos se sabe que la agnosia del habla está relacionada con lesiones en el hemisferio izquierdo o en ambos, específicamente disfunciones temporoparietales derechas. [26]

Fonagnosia : La fonagnosia se asocia con la incapacidad de reconocer voces familiares. En estos casos, los estímulos del habla se pueden escuchar e incluso entender, pero se pierde la asociación del habla con una voz determinada. Esto puede deberse a un "procesamiento anormal de propiedades vocales complejas (timbre, articulación y prosodia, elementos que distinguen una voz individual"). [27] No se conoce ningún tratamiento; sin embargo, hay un informe de caso de una mujer epiléptica que comenzó a experimentar fonagnosia junto con otras deficiencias. Los resultados de su EEG y MRI mostraron "una lesión hiperintensa en T2 corticoparietal derecha sin realce de gadolinio y con deterioro discreto de la difusión de moléculas de agua". [27] Por lo tanto, aunque no se ha descubierto ningún tratamiento, la fonagnosia puede correlacionarse con la disfunción cortical parietal postictal.

Los bebés comienzan el proceso de adquisición del lenguaje al ser capaces de detectar diferencias muy pequeñas entre los sonidos del habla. Pueden discriminar todos los posibles contrastes del habla (fonemas). Gradualmente, a medida que se exponen a su lengua materna, su percepción se vuelve específica del lenguaje, es decir, aprenden a ignorar las diferencias dentro de las categorías fonémicas del idioma (diferencias que bien pueden ser contrastivas en otros idiomas; por ejemplo, el inglés distingue dos categorías de sonoridad de oclusivas , mientras que el tailandés tiene tres categorías ; los bebés deben aprender qué diferencias son distintivas en los usos de su lengua materna y cuáles no). A medida que los bebés aprenden a clasificar los sonidos del habla entrantes en categorías, ignorando las diferencias irrelevantes y reforzando las contrastivas, su percepción se vuelve categórica. Los bebés aprenden a contrastar diferentes fonemas vocálicos de su lengua materna aproximadamente a los 6 meses de edad. Los contrastes consonánticos nativos se adquieren a los 11 o 12 meses de edad. [28] Algunos investigadores han propuesto que los bebés pueden aprender las categorías de sonido de su lengua materna a través de la escucha pasiva, utilizando un proceso llamado aprendizaje estadístico . Otros incluso afirman que ciertas categorías de sonido son innatas, es decir, están especificadas genéticamente (véase la discusión sobre la distinción categórica innata versus adquirida ).

Si a los bebés de un día se les presenta la voz de su madre hablando normalmente, de forma anormal (monótona) y la voz de un extraño, reaccionan únicamente a la voz de su madre hablando normalmente. Cuando se reproduce un sonido humano y uno no humano, los bebés giran la cabeza únicamente hacia la fuente del sonido humano. Se ha sugerido que el aprendizaje auditivo comienza ya en el período prenatal. [29]

Una de las técnicas que se utilizan para examinar cómo perciben el habla los bebés, además del procedimiento de giro de la cabeza mencionado anteriormente, es la medición de su ritmo de succión. En un experimento de este tipo, un bebé succiona un pezón especial mientras se le presentan sonidos. Primero, se establece el ritmo de succión normal del bebé. Luego se reproduce un estímulo repetidamente. Cuando el bebé escucha el estímulo por primera vez, el ritmo de succión aumenta, pero a medida que el bebé se acostumbra al estímulo, el ritmo de succión disminuye y se estabiliza. Luego, se reproduce un nuevo estímulo para el bebé. Si el bebé percibe el estímulo recién introducido como diferente del estímulo de fondo, el ritmo de succión aumentará. [29] El ritmo de succión y el método de giro de la cabeza son algunos de los métodos conductuales más tradicionales para estudiar la percepción del habla. Entre los nuevos métodos (ver Métodos de investigación a continuación) que nos ayudan a estudiar la percepción del habla, la espectroscopia de infrarrojo cercano se usa ampliamente en bebés. [28]

También se ha descubierto que, aunque la capacidad de los bebés para distinguir entre las diferentes propiedades fonéticas de varios idiomas comienza a declinar alrededor de los nueve meses, es posible revertir este proceso exponiéndolos a un nuevo idioma de manera suficiente. En un estudio de investigación realizado por Patricia K. Kuhl, Feng-Ming Tsao y Huei-Mei Liu, se descubrió que si un hablante nativo de chino mandarín les habla a los bebés e interactúan con ellos, pueden ser condicionados a conservar su capacidad para distinguir diferentes sonidos del habla dentro del mandarín que son muy diferentes de los sonidos del habla que se encuentran en el idioma inglés. De esta manera, se demuestra que, dadas las condiciones adecuadas, es posible prevenir la pérdida de la capacidad de los bebés para distinguir sonidos del habla en idiomas distintos de los que se encuentran en su lengua materna. [30]

Se ha investigado mucho sobre cómo los usuarios de una lengua perciben el habla extranjera (lo que se conoce como percepción del habla entre lenguas) o el habla de una segunda lengua (percepción del habla de una segunda lengua). Esta última se enmarca en el ámbito de la adquisición de una segunda lengua .

Los idiomas difieren en sus inventarios fonémicos. Naturalmente, esto crea dificultades cuando se habla de una lengua extranjera. Por ejemplo, si dos sonidos de una lengua extranjera se asimilan a una única categoría de lengua materna, será muy difícil discernir la diferencia entre ellos. Un ejemplo clásico de esta situación es la observación de que los estudiantes japoneses de inglés tendrán problemas para identificar o distinguir las consonantes líquidas inglesas /l/ y /r/ (véase Percepción de /r/ y /l/ en inglés por hablantes japoneses ). [31]

Best (1995) propuso un modelo de asimilación perceptiva que describe posibles patrones de asimilación de categorías entre lenguas y predice sus consecuencias. [32] Flege (1995) formuló un modelo de aprendizaje del habla que combina varias hipótesis sobre la adquisición del habla en una segunda lengua (L2) y que predice, en palabras simples, que un sonido de L2 que no sea demasiado similar a un sonido de una lengua materna (L1) será más fácil de adquirir que un sonido de L2 que sea relativamente similar a un sonido de L1 (porque será percibido como más obviamente "diferente" por el aprendiz). [33]

La investigación sobre cómo perciben el habla las personas con discapacidad auditiva o del lenguaje no solo tiene como objetivo descubrir posibles tratamientos, sino que también puede proporcionar información sobre los principios que subyacen a la percepción del habla sin discapacidad. [34] Dos áreas de investigación pueden servir como ejemplo:

La afasia afecta tanto a la expresión como a la recepción del lenguaje. Los dos tipos más comunes, la afasia expresiva y la afasia receptiva , afectan en cierta medida a la percepción del habla. La afasia expresiva provoca dificultades moderadas para la comprensión del lenguaje. El efecto de la afasia receptiva sobre la comprensión es mucho más grave. Se acepta que los afásicos sufren déficits perceptivos. Por lo general, no pueden distinguir por completo el lugar de la articulación y la sonorización. [35] En cuanto a otras características, las dificultades varían. Todavía no se ha demostrado si las habilidades de percepción del habla de bajo nivel se ven afectadas en los pacientes con afasia o si sus dificultades se deben únicamente a un deterioro de nivel superior. [35]

La implantación coclear restaura el acceso a la señal acústica en personas con pérdida auditiva neurosensorial. La información acústica transmitida por un implante suele ser suficiente para que los usuarios del implante reconozcan correctamente el habla de personas que conocen incluso sin pistas visuales. [36] Para los usuarios de implantes cocleares, es más difícil comprender hablantes y sonidos desconocidos. Las capacidades perceptivas de los niños que recibieron un implante después de los dos años son significativamente mejores que las de los que fueron implantados en la edad adulta. Se ha demostrado que varios factores influyen en el rendimiento perceptivo, específicamente: duración de la sordera antes de la implantación, edad de aparición de la sordera, edad en el momento de la implantación (tales efectos de la edad pueden estar relacionados con la hipótesis del período crítico ) y la duración del uso de un implante. Existen diferencias entre los niños con sordera congénita y adquirida. Los niños sordos postlinguales tienen mejores resultados que los sordos prelinguales y se adaptan a un implante coclear más rápido. [36] Tanto en los niños con implantes cocleares como en los que tienen audición normal, las vocales y el momento de inicio de la voz adquieren mayor importancia en el desarrollo antes que la capacidad de discriminar el lugar de la articulación. Varios meses después de la implantación, los niños con implantes cocleares pueden normalizar la percepción del habla.

Uno de los problemas fundamentales en el estudio del habla es cómo lidiar con el ruido. Esto se demuestra por la dificultad que tienen los sistemas de reconocimiento informático para reconocer el habla humana. Si bien pueden reconocer bien el habla si se entrenan con la voz de un hablante específico y en condiciones de silencio, estos sistemas a menudo funcionan mal en situaciones de escucha más realistas en las que los humanos entenderían el habla con relativa facilidad. Para emular los patrones de procesamiento que se mantendrían en el cerebro en condiciones normales, el conocimiento previo es un factor neuronal clave, ya que un historial de aprendizaje sólido puede anular hasta cierto punto los efectos de enmascaramiento extremos involucrados en la ausencia total de señales de habla continuas. [20]

La investigación sobre la relación entre la música y la cognición es un campo emergente relacionado con el estudio de la percepción del habla. Originalmente se teorizó que las señales neuronales de la música se procesaban en un "módulo" especializado en el hemisferio derecho del cerebro. Por el contrario, las señales neuronales del lenguaje debían ser procesadas por un "módulo" similar en el hemisferio izquierdo. [37] Sin embargo, utilizando tecnologías como las máquinas de fMRI, la investigación ha demostrado que dos regiones del cerebro tradicionalmente consideradas exclusivamente para procesar el habla, las áreas de Broca y de Wernicke, también se activan durante actividades musicales como escuchar una secuencia de acordes musicales. [37] Otros estudios, como uno realizado por Marques et al. en 2006 mostraron que los niños de 8 años que recibieron seis meses de entrenamiento musical mostraron un aumento tanto en su rendimiento de detección de tono como en sus medidas electrofisiológicas cuando se les hizo escuchar un idioma extranjero desconocido. [38]

Por el contrario, algunas investigaciones han revelado que, en lugar de que la música afecte a nuestra percepción del habla, nuestro habla nativa puede afectar a nuestra percepción de la música. Un ejemplo es la paradoja del tritono . La paradoja del tritono es cuando a un oyente se le presentan dos tonos generados por computadora (como C y F-Sharp) que están separados por media octava (o un tritono) y luego se le pide que determine si el tono de la secuencia es descendente o ascendente. Uno de estos estudios, realizado por la Sra. Diana Deutsch, encontró que la interpretación del oyente del tono ascendente o descendente estaba influenciada por el idioma o dialecto del oyente, mostrando variación entre los criados en el sur de Inglaterra y los de California o entre los de Vietnam y los de California cuyo idioma nativo era el inglés. [37] Un segundo estudio, realizado en 2006 en un grupo de hablantes de inglés y 3 grupos de estudiantes del este de Asia en la Universidad del Sur de California, descubrió que los hablantes de inglés que habían comenzado la formación musical a los 5 años o antes tenían un 8% de posibilidades de tener un oído perfecto. [37]

Casey O'Callaghan , en su artículo Experiencing Speech , analiza si "la experiencia perceptiva de escuchar el habla difiere en su carácter fenomenal" [39] en lo que respecta a la comprensión del idioma que se escucha. Sostiene que la experiencia de un individuo al escuchar un idioma que comprende, a diferencia de su experiencia al escuchar un idioma que no conoce, muestra una diferencia en las características fenomenales que define como "aspectos de cómo es una experiencia" [39] para un individuo.

Si a un sujeto monolingüe hablante nativo de inglés se le presenta un estímulo de habla en alemán, la cadena de fonemas aparecerá como meros sonidos y producirá una experiencia muy diferente a si se le presentara exactamente el mismo estímulo a un sujeto que habla alemán.

También examina cómo cambia la percepción del habla cuando se aprende un idioma. Si a un sujeto sin conocimientos de japonés se le presentara un estímulo de habla japonesa y luego se le dieran exactamente los mismos estímulos después de haberle enseñado japonés, ese mismo individuo tendría una experiencia extremadamente diferente .

Los métodos utilizados en la investigación de la percepción del habla se pueden dividir aproximadamente en tres grupos: métodos conductuales, computacionales y, más recientemente, neurofisiológicos.

Los experimentos de conducta se basan en el papel activo de un participante, es decir, se presentan estímulos a los sujetos y se les pide que tomen decisiones conscientes sobre ellos. Esto puede adoptar la forma de una prueba de identificación, una prueba de discriminación , una prueba de semejanza, etc. Este tipo de experimentos ayudan a proporcionar una descripción básica de cómo los oyentes perciben y categorizan los sonidos del habla.

La percepción del habla también se ha analizado a través del habla sinusoidal, una forma de habla sintética en la que la voz humana se sustituye por ondas sinusoidales que imitan las frecuencias y amplitudes presentes en el habla original. Cuando a los sujetos se les presenta por primera vez esta voz, la voz sinusoidal se interpreta como ruidos aleatorios. Pero cuando se les informa a los sujetos de que el estímulo es en realidad habla y se les dice lo que se está diciendo, "se produce un cambio distintivo, casi inmediato" [39] en la forma en que se percibe la voz sinusoidal.

El modelado computacional también se ha utilizado para simular cómo el cerebro puede procesar el habla para producir conductas que se observan. Los modelos informáticos se han utilizado para abordar varias cuestiones relacionadas con la percepción del habla, como la forma en que se procesa la propia señal sonora para extraer las señales acústicas utilizadas en el habla y la forma en que se utiliza la información del habla para procesos de nivel superior, como el reconocimiento de palabras. [40]

Los métodos neurofisiológicos se basan en la utilización de información procedente de procesos más directos y no necesariamente conscientes (preatentivos). A los sujetos se les presentan estímulos del habla en diferentes tipos de tareas y se miden las respuestas del cerebro. El cerebro en sí puede ser más sensible de lo que parece a través de las respuestas conductuales. Por ejemplo, el sujeto puede no mostrar sensibilidad a la diferencia entre dos sonidos del habla en una prueba de discriminación, pero las respuestas cerebrales pueden revelar sensibilidad a estas diferencias. [28] Los métodos utilizados para medir las respuestas neuronales al habla incluyen potenciales relacionados con eventos , magnetoencefalografía y espectroscopia de infrarrojo cercano . Una respuesta importante utilizada con potenciales relacionados con eventos es la negatividad de desajuste , que ocurre cuando los estímulos del habla son acústicamente diferentes de un estímulo que el sujeto escuchó previamente.

Los métodos neurofisiológicos se introdujeron en la investigación de la percepción del habla por varias razones:

Las respuestas conductuales pueden reflejar procesos conscientes tardíos y verse afectadas por otros sistemas como la ortografía, y por lo tanto pueden enmascarar la capacidad del hablante de reconocer sonidos basados en distribuciones acústicas de nivel inferior. [41]

Incluso los bebés pueden ser examinados sin necesidad de participar activamente en la prueba; esta característica es crucial en la investigación de los procesos de adquisición. La posibilidad de observar procesos auditivos de bajo nivel independientemente de los de nivel superior permite abordar cuestiones teóricas de larga data, como si los humanos poseen o no un módulo especializado para percibir el habla [42] [43] o si alguna invariancia acústica compleja (ver la falta de invariancia más arriba) subyace al reconocimiento de un sonido del habla. [44]

Algunos de los primeros trabajos en el estudio de cómo los humanos perciben los sonidos del habla fueron realizados por Alvin Liberman y sus colegas en Haskins Laboratories . [45] Usando un sintetizador de voz, construyeron sonidos del habla que variaban en el lugar de articulación a lo largo de un continuo desde /bɑ/ a /dɑ/ a /ɡɑ/ . Se pidió a los oyentes que identificaran qué sonido escuchaban y que discriminaran entre dos sonidos diferentes. Los resultados del experimento mostraron que los oyentes agruparon los sonidos en categorías discretas, aunque los sonidos que escuchaban variaban continuamente. Con base en estos resultados, propusieron la noción de percepción categórica como un mecanismo por el cual los humanos pueden identificar los sonidos del habla.

Investigaciones más recientes que utilizan diferentes tareas y métodos sugieren que los oyentes son muy sensibles a las diferencias acústicas dentro de una única categoría fonética, contrariamente a una explicación categórica estricta de la percepción del habla.

Para proporcionar una explicación teórica de los datos de percepción categórica , Liberman y sus colegas [46] elaboraron la teoría motora de la percepción del habla, donde "se suponía que la codificación articulatoria complicada se decodificaba en la percepción del habla mediante los mismos procesos que intervienen en la producción" [1] (esto se conoce como análisis por síntesis). Por ejemplo, la consonante inglesa /d/ puede variar en sus detalles acústicos en diferentes contextos fonéticos (véase más arriba), pero todas las /d/ tal como las percibe un oyente caen dentro de una categoría (oclusiva alveolar sonora) y eso se debe a que "las representaciones lingüísticas son segmentos fonéticos abstractos, canónicos o los gestos que subyacen a estos segmentos". [1] Al describir las unidades de percepción, Liberman abandonó más tarde los movimientos articulatorios y procedió a las órdenes neuronales a los articuladores [47] e incluso más tarde a los gestos articulatorios intencionados [48] , por lo que "la representación neuronal del enunciado que determina la producción del hablante es el objeto distal que percibe el oyente". [48] La teoría está estrechamente relacionada con la hipótesis de modularidad , que propone la existencia de un módulo de propósito especial, que se supone es innato y probablemente específico de los humanos.

La teoría ha sido criticada por no poder "ofrecer una explicación de cómo las señales acústicas se traducen en gestos intencionados" [49] por parte de los oyentes. Además, no está claro cómo se codifica/descodifica la información indicial (por ejemplo, la identidad del hablante) junto con la información lingüísticamente relevante.

Los modelos ejemplares de percepción del habla difieren de las cuatro teorías mencionadas anteriormente, que suponen que no hay conexión entre el reconocimiento de palabras y el de quien habla y que la variación entre quienes hablan es "ruido" que debe filtrarse.

Los enfoques basados en ejemplos sostienen que los oyentes almacenan información tanto para el reconocimiento de palabras como para el reconocimiento del hablante. Según esta teoría, se almacenan instancias particulares de sonidos del habla en la memoria de un oyente. En el proceso de percepción del habla, las instancias recordadas de, por ejemplo, una sílaba almacenada en la memoria del oyente se comparan con el estímulo entrante para que el estímulo pueda categorizarse. De manera similar, al reconocer a un hablante, se activan todos los rastros de memoria de los enunciados producidos por ese hablante y se determina la identidad del hablante. En apoyo de esta teoría hay varios experimentos informados por Johnson [13] que sugieren que nuestra identificación de señales es más precisa cuando estamos familiarizados con el hablante o cuando tenemos una representación visual de su género. Cuando el hablante es impredecible o el sexo se identifica incorrectamente, la tasa de error en la identificación de palabras es mucho mayor.

Los modelos ejemplares tienen que hacer frente a varias objeciones, dos de las cuales son (1) la capacidad de memoria insuficiente para almacenar cada enunciado jamás escuchado y, en relación con la capacidad de producir lo escuchado, (2) si también los propios gestos articulatorios del hablante se almacenan o se computan al producir enunciados que sonarían como recuerdos auditivos. [13] [49]

Kenneth N. Stevens propuso los puntos de referencia acústicos y las características distintivas como una relación entre las características fonológicas y las propiedades auditivas. Según este punto de vista, los oyentes inspeccionan la señal entrante en busca de los llamados puntos de referencia acústicos, que son eventos particulares en el espectro que llevan información sobre los gestos que los produjeron. Dado que estos gestos están limitados por las capacidades de los articuladores humanos y los oyentes son sensibles a sus correlatos auditivos, la falta de invariancia simplemente no existe en este modelo. Las propiedades acústicas de los puntos de referencia constituyen la base para establecer las características distintivas. Los conjuntos de ellos especifican de manera única segmentos fonéticos (fonemas, sílabas, palabras). [50]

En este modelo, se cree que la señal acústica entrante se procesa primero para determinar los llamados puntos de referencia, que son eventos espectrales especiales en la señal; por ejemplo, las vocales suelen estar marcadas por una frecuencia más alta del primer formante, las consonantes pueden especificarse como discontinuidades en la señal y tienen amplitudes más bajas en las regiones inferior y media del espectro. Estas características acústicas son resultado de la articulación. De hecho, se pueden utilizar movimientos articulatorios secundarios cuando se necesita mejorar los puntos de referencia debido a condiciones externas como el ruido. Stevens afirma que la coarticulación causa solo una variación limitada y, además, sistemática y, por lo tanto, predecible en la señal que el oyente puede manejar. Por lo tanto, dentro de este modelo, simplemente se afirma que no existe lo que se llama falta de invariancia.

Se analizan los puntos de referencia para determinar determinados eventos articulatorios (gestos) que están relacionados con ellos. En la siguiente etapa, se extraen pistas acústicas de la señal en las proximidades de los puntos de referencia mediante la medición mental de determinados parámetros como las frecuencias de los picos espectrales, las amplitudes en la región de baja frecuencia o el tiempo.

La siguiente etapa de procesamiento comprende la consolidación de las señales acústicas y la derivación de características distintivas. Se trata de categorías binarias relacionadas con la articulación (por ejemplo, [+/- agudo], [+/- posterior], [+/- labios redondeados] para las vocales; [+/- sonoro], [+/- lateral] o [+/- nasal] para las consonantes.

Los conjuntos de estas características identifican de forma única los segmentos del habla (fonemas, sílabas, palabras). Estos segmentos forman parte del léxico almacenado en la memoria del oyente. Sus unidades se activan en el proceso de acceso léxico y se asignan a la señal original para averiguar si coinciden. Si no, se realiza otro intento con un patrón candidato diferente. De este modo iterativo, los oyentes reconstruyen los eventos articulatorios que fueron necesarios para producir la señal de habla percibida. Por lo tanto, esto puede describirse como análisis por síntesis.

Esta teoría postula que el objeto distal de la percepción del habla son los gestos articulatorios que subyacen al habla. Los oyentes interpretan la señal del habla haciendo referencia a ellos. El modelo pertenece a los denominados análisis por síntesis.

La teoría de la lógica difusa de la percepción del habla desarrollada por Dominic Massaro [51] propone que las personas recuerdan los sonidos del habla de una manera probabilística o graduada. Sugiere que las personas recuerdan descripciones de las unidades perceptivas del lenguaje, llamadas prototipos. Dentro de cada prototipo pueden combinarse varias características. Sin embargo, las características no son simplemente binarias (verdaderas o falsas), existe un valor difuso que corresponde a la probabilidad de que un sonido pertenezca a una categoría particular del habla. Por lo tanto, cuando percibimos una señal de habla, nuestra decisión sobre lo que realmente escuchamos se basa en la bondad relativa de la coincidencia entre la información del estímulo y los valores de prototipos particulares. La decisión final se basa en múltiples características o fuentes de información, incluso información visual (esto explica el efecto McGurk ). [49] Los modelos informáticos de la teoría de la lógica difusa se han utilizado para demostrar que las predicciones de la teoría sobre cómo se categorizan los sonidos del habla corresponden al comportamiento de los oyentes humanos. [52]

La hipótesis del modo de habla es la idea de que la percepción del habla requiere el uso de un procesamiento mental especializado. [53] [54] La hipótesis del modo de habla es una rama de la teoría de la modularidad de Fodor (véase modularidad de la mente ). Utiliza un mecanismo de procesamiento vertical donde estímulos limitados son procesados por áreas especiales del cerebro que son específicas de los estímulos. [54]

Dos versiones de la hipótesis del modo de habla: [53]

Tres paradigmas experimentales importantes han evolucionado en la búsqueda de encontrar evidencia para la hipótesis del modo de habla. Estos son la escucha dicótica , la percepción categórica y la percepción dúplex . [53] A través de la investigación en estas categorías se ha encontrado que puede no haber un modo de habla específico sino uno para códigos auditivos que requieren un procesamiento auditivo complicado. También parece que la modularidad se aprende en los sistemas perceptivos. [53] A pesar de esto, la evidencia y la contraevidencia para la hipótesis del modo de habla aún no están claras y necesitan más investigación.

La teoría realista directa de la percepción del habla (principalmente asociada con Carol Fowler ) es una parte de la teoría más general del realismo directo , que postula que la percepción nos permite tener conciencia directa del mundo porque implica la recuperación directa de la fuente distal del evento que se percibe. Para la percepción del habla, la teoría afirma que los objetos de la percepción son movimientos reales del tracto vocal, o gestos, y no fonemas abstractos o (como en la teoría motora) eventos que son causalmente antecedentes de estos movimientos, es decir, gestos intencionados. Los oyentes perciben los gestos no por medio de un decodificador especializado (como en la teoría motora), sino porque la información en la señal acústica especifica los gestos que la forman. [55] Al afirmar que los gestos articulatorios reales que producen diferentes sonidos del habla son en sí mismos las unidades de la percepción del habla, la teoría pasa por alto el problema de la falta de invariancia.

{{cite encyclopedia}}: CS1 maint: varios nombres: lista de autores ( enlace ){{cite journal}}: CS1 maint: varios nombres: lista de autores ( enlace ){{cite journal}}: CS1 maint: varios nombres: lista de autores ( enlace ){{cite journal}}: CS1 maint: varios nombres: lista de autores ( enlace ){{cite journal}}: CS1 maint: varios nombres: lista de autores ( enlace ){{cite journal}}: CS1 maint: varios nombres: lista de autores ( enlace ){{cite conference}}: CS1 maint: varios nombres: lista de autores ( enlace ){{cite conference}}: CS1 maint: varios nombres: lista de autores ( enlace ){{cite journal}}: CS1 maint: varios nombres: lista de autores ( enlace ){{cite journal}}: CS1 maint: varios nombres: lista de autores ( enlace ){{cite conference}}: CS1 maint: varios nombres: lista de autores ( enlace )[ enlace muerto permanente ]{{cite journal}}: CS1 maint: varios nombres: lista de autores ( enlace ){{cite journal}}: CS1 maint: varios nombres: lista de autores ( enlace ){{cite journal}}: CS1 maint: varios nombres: lista de autores ( enlace )