La nueva economía keynesiana es una escuela de macroeconomía que se esfuerza por proporcionar fundamentos microeconómicos a la economía keynesiana . Se desarrolló en parte como respuesta a las críticas a la macroeconomía keynesiana por parte de los partidarios de la nueva macroeconomía clásica .

Dos supuestos principales definen el enfoque neokeynesiano de la macroeconomía. Al igual que el enfoque neoclásico, el análisis macroeconómico neokeynesiano suele suponer que los hogares y las empresas tienen expectativas racionales . Sin embargo, las dos escuelas difieren en que el análisis neokeynesiano suele suponer una variedad de fallos del mercado . En particular, los neokeynesianos suponen que existe una competencia imperfecta [1] en la fijación de precios y salarios para ayudar a explicar por qué los precios y los salarios pueden volverse " rígidos ", lo que significa que no se ajustan instantáneamente a los cambios en las condiciones económicas.

La rigidez de los salarios y los precios, y otras descripciones actuales de las fallas del mercado en los modelos neokeynesianos , implican que la economía puede no alcanzar el pleno empleo . Por lo tanto, los neokeynesianos sostienen que la estabilización macroeconómica por parte del gobierno (mediante la política fiscal ) y el banco central (mediante la política monetaria ) puede conducir a un resultado macroeconómico más eficiente que el que produciría una política de laissez faire .

El nuevo keynesianismo se convirtió en parte de la nueva síntesis neoclásica que incorporó partes tanto de éste como de la nueva macroeconomía clásica , y constituye la base teórica de la macroeconomía dominante en la actualidad. [2] [3] [4] [5]

La primera ola de la economía neokeynesiana se desarrolló a fines de la década de 1970. El primer modelo de información pegajosa fue desarrollado por Stanley Fischer en su artículo de 1977, Contratos a largo plazo, expectativas racionales y la regla de oferta monetaria óptima . [6] Adoptó un modelo de contrato "escalonado" o "superpuesto". Supongamos que hay dos sindicatos en la economía, que se turnan para elegir los salarios. Cuando es el turno de un sindicato, elige los salarios que establecerá para los siguientes dos períodos. Esto contrasta con el modelo de John B. Taylor donde el salario nominal es constante durante la vida del contrato, como se desarrolló posteriormente en sus dos artículos: uno en 1979, "Fijación de salarios escalonados en un modelo macro", [7] y otro en 1980, "Dinámica agregada y contratos escalonados". [8] Tanto el contrato de Taylor como el de Fischer comparten la característica de que sólo los sindicatos que fijan los salarios en el período actual utilizan la información más reciente: los salarios en la mitad de la economía todavía reflejan información antigua. El modelo de Taylor tenía salarios nominales rígidos además de la información rígida: los salarios nominales tenían que ser constantes durante la duración del contrato (dos períodos). Estas primeras teorías neokeynesianas se basaban en la idea básica de que, dados los salarios nominales fijos, una autoridad monetaria (el banco central) puede controlar la tasa de empleo. Dado que los salarios se fijan a una tasa nominal, la autoridad monetaria puede controlar el salario real (valores salariales ajustados a la inflación) modificando la oferta monetaria y, por lo tanto, afectar la tasa de empleo. [9]

En la década de 1980 se desarrolló el concepto clave de utilizar los costos de menú en un marco de competencia imperfecta para explicar la rigidez de los precios. [10] El concepto de un costo de suma global (costo de menú) para cambiar el precio fue introducido originalmente por Sheshinski y Weiss (1977) en su artículo que analizaba el efecto de la inflación en la frecuencia de los cambios de precios. [11] La idea de aplicarlo como una teoría general de la rigidez de los precios nominales fue propuesta simultáneamente por varios economistas en 1985-86. George Akerlof y Janet Yellen propusieron la idea de que debido a la racionalidad limitada, las empresas no querrán cambiar su precio a menos que el beneficio sea más que una pequeña cantidad. [12] [13] Esta racionalidad limitada conduce a la inercia en los precios y salarios nominales que puede llevar a que la producción fluctúe a precios y salarios nominales constantes. Gregory Mankiw tomó la idea del costo de menú y se centró en los efectos de bienestar de los cambios en la producción resultantes de precios rígidos . [14] Michael Parkin también propuso la idea. [15] Aunque el enfoque inicialmente se centró principalmente en la rigidez de los precios nominales, Olivier Blanchard y Nobuhiro Kiyotaki lo extendieron a los salarios y precios en su influyente artículo "Competencia monopolística y los efectos de la demanda agregada". [16] Huw Dixon y Claus Hansen demostraron que incluso si los costos de menú se aplicaran a un pequeño sector de la economía, esto influiría en el resto de la economía y conduciría a que los precios en el resto de la economía se volvieran menos sensibles a los cambios en la demanda. [17]

Aunque algunos estudios sugerían que los costos de menú son demasiado pequeños para tener un gran impacto agregado, Laurence M. Ball y David Romer demostraron en 1990 que las rigideces reales podían interactuar con las rigideces nominales para crear un desequilibrio significativo. [18] Las rigideces reales ocurren cuando una empresa es lenta para ajustar sus precios reales en respuesta a un entorno económico cambiante. Por ejemplo, una empresa puede enfrentar rigideces reales si tiene poder de mercado o si sus costos de insumos y salarios están fijados por un contrato. [19] Ball y Romer argumentaron que las rigideces reales en el mercado laboral mantienen altos los costos de una empresa, lo que hace que las empresas duden en reducir los precios y pierdan ingresos. El gasto creado por las rigideces reales combinado con el costo de menú de cambiar los precios hace que sea menos probable que la empresa reduzca los precios a un nivel de equilibrio del mercado. [20]

Incluso si los precios son perfectamente flexibles, la competencia imperfecta puede afectar la influencia de la política fiscal en términos del multiplicador. Huw Dixon y Gregory Mankiw desarrollaron independientemente modelos de equilibrio general simples que muestran que el multiplicador fiscal podría aumentar con el grado de competencia imperfecta en el mercado de producción. [21] [22] La razón de esto es que la competencia imperfecta en el mercado de producción tiende a reducir el salario real , lo que lleva a que el hogar sustituya el consumo por ocio . Cuando se aumenta el gasto gubernamental , el aumento correspondiente en la tributación de suma global hace que disminuyan tanto el ocio como el consumo (suponiendo que ambos son un bien normal). Cuanto mayor sea el grado de competencia imperfecta en el mercado de producción, menor será el salario real y, por lo tanto, más recaerá la reducción en el ocio (es decir, los hogares trabajan más) y menos en el consumo. Por lo tanto, el multiplicador fiscal es menor que uno, pero aumenta en el grado de competencia imperfecta en el mercado de producción. [23]

En 1983 Guillermo Calvo escribió "Precios escalonados en un marco de maximización de utilidad". [24] El artículo original fue escrito en un marco matemático de tiempo continuo , pero hoy en día se utiliza principalmente en su versión de tiempo discreto . El modelo de Calvo se ha convertido en la forma más común de modelar la rigidez nominal en los nuevos modelos keynesianos. Existe una probabilidad de que la empresa pueda restablecer su precio en cualquier período h (la tasa de riesgo ), o equivalentemente la probabilidad ( 1 − h ) de que el precio permanezca sin cambios en ese período (la tasa de supervivencia). La probabilidad h a veces se denomina "probabilidad de Calvo" en este contexto. En el modelo de Calvo, la característica crucial es que quien fija el precio no sabe cuánto tiempo se mantendrá vigente el precio nominal, en contraste con el modelo de Taylor, donde la duración del contrato se conoce ex ante .

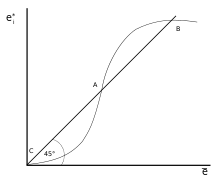

El fallo de coordinación fue otro importante concepto keynesiano nuevo desarrollado como otra posible explicación de las recesiones y el desempleo. [26] En las recesiones, una fábrica puede permanecer inactiva aunque haya gente dispuesta a trabajar en ella y gente dispuesta a comprar su producción si tuviera trabajo. En tal escenario, las crisis económicas parecen ser el resultado de un fallo de coordinación: la mano invisible no logra coordinar el flujo habitual y óptimo de producción y consumo. [27] El artículo de 1988 de Russell Cooper y Andrew John "Coordinating Coordination Failures in Keynesian Models" expresó una forma general de coordinación como modelos con múltiples equilibrios donde los agentes podrían coordinarse para mejorar (o al menos no dañar) cada una de sus respectivas situaciones. [25] [28] Cooper y John basaron su trabajo en modelos anteriores, incluido el modelo del coco de 1982 de Peter Diamond , que demostró un caso de fallo de coordinación que involucraba la teoría de búsqueda y emparejamiento . [29] En el modelo de Diamond, es más probable que los productores produzcan si ven a otros produciendo. El aumento de posibles socios comerciales aumenta la probabilidad de que un productor determinado encuentre a alguien con quien comerciar. Como en otros casos de falla de coordinación, el modelo de Diamond tiene múltiples equilibrios, y el bienestar de un agente depende de las decisiones de los demás. [30] El modelo de Diamond es un ejemplo de una " externalidad de mercado denso " que hace que los mercados funcionen mejor cuando más personas y empresas participan en ellos. [31] Otras fuentes potenciales de falla de coordinación incluyen profecías autocumplidas . Si una empresa anticipa una caída en la demanda, podría reducir la contratación. La falta de vacantes laborales podría preocupar a los trabajadores, quienes luego reducirían su consumo. Esta caída en la demanda cumple con las expectativas de la empresa, pero se debe enteramente a las propias acciones de la empresa.

Los nuevos keynesianos ofrecieron explicaciones para el fracaso del mercado laboral en equilibrarse. En un mercado walrasiano, los trabajadores desempleados pujan por salarios más bajos hasta que la demanda de trabajadores se encuentra con la oferta. [32] Si los mercados son walrasianos, las filas de los desempleados se limitarían a los trabajadores que hacen la transición de un trabajo a otro y a los trabajadores que eligen no trabajar porque los salarios son demasiado bajos para atraerlos. [33] Desarrollaron varias teorías para explicar por qué los mercados pueden dejar desempleados a los trabajadores dispuestos a trabajar. [34] La más importante de estas teorías fue la teoría de los salarios de eficiencia utilizada para explicar los efectos a largo plazo del desempleo previo , donde los aumentos a corto plazo del desempleo se vuelven permanentes y conducen a niveles más altos de desempleo en el largo plazo. [35]

En los modelos de salarios de eficiencia, los trabajadores reciben salarios que maximizan la productividad en lugar de equilibrar el mercado. [36] Por ejemplo, en los países en desarrollo, las empresas pueden pagar más que una tasa de mercado para garantizar que sus trabajadores puedan permitirse una nutrición suficiente para ser productivos. [37] Las empresas también pueden pagar salarios más altos para aumentar la lealtad y la moral, lo que posiblemente lleve a una mejor productividad. [38] Las empresas también pueden pagar salarios más altos que los del mercado para evitar la falta de trabajo. Los modelos de falta de trabajo fueron particularmente influyentes. [39] El artículo de 1984 de Carl Shapiro y Joseph Stiglitz "El desempleo de equilibrio como dispositivo de disciplina del trabajador" creó un modelo en el que los empleados tienden a evitar el trabajo a menos que las empresas puedan monitorear el esfuerzo del trabajador y amenazar a los empleados holgazanes con el desempleo. [40] [41] Si la economía está en pleno empleo, un holgazán despedido simplemente se muda a un nuevo trabajo. [42] Las empresas individuales pagan a sus trabajadores una prima sobre la tasa de mercado para garantizar que sus trabajadores prefieran trabajar y mantener su trabajo actual en lugar de faltar al trabajo y correr el riesgo de tener que mudarse a un nuevo trabajo. Como cada empresa paga salarios superiores a los que equilibran el mercado, el mercado laboral agregado no se equilibra, lo que crea un grupo de trabajadores desempleados y aumenta el costo de ser despedido. Los trabajadores no sólo corren el riesgo de recibir un salario menor, sino que corren el riesgo de quedar atrapados en el grupo de desempleados. Mantener los salarios por encima de los niveles de equilibrio del mercado crea un serio desincentivo para la elusión laboral que hace que los trabajadores sean más eficientes, aunque deja a algunos trabajadores dispuestos a trabajar sin empleo. [43]

A principios de los años 1990, los economistas comenzaron a combinar los elementos de la nueva economía keynesiana desarrollada en los años 1980 y antes con la teoría del ciclo económico real . Los modelos RBC eran dinámicos pero asumían una competencia perfecta; los nuevos modelos keynesianos eran principalmente estáticos pero se basaban en la competencia imperfecta. La nueva síntesis neoclásica esencialmente combinó los aspectos dinámicos de RBC con la competencia imperfecta y las rigideces nominales de los nuevos modelos keynesianos. Tack Yun fue uno de los primeros en hacer esto, en un modelo que utilizó el modelo de precios de Calvo . [44] Goodfriend y King propusieron una lista de cuatro elementos que son centrales para la nueva síntesis: optimización intertemporal, expectativas racionales, competencia imperfecta y ajuste costoso de precios (costos de menú). [45] [46] Goodfriend y King también encuentran que los modelos de consenso producen ciertas implicaciones de política: mientras que la política monetaria puede afectar la producción real en el corto plazo, pero no hay una disyuntiva a largo plazo: el dinero no es neutral en el corto plazo, pero sí lo es en el largo plazo. La inflación tiene efectos negativos en el bienestar. Es importante que los bancos centrales mantengan la credibilidad a través de políticas basadas en reglas, como la fijación de metas de inflación.

En 1993, [47] John B Taylor formuló la idea de una regla de Taylor , que es una aproximación de forma reducida de la respuesta de la tasa de interés nominal , tal como la establece el banco central , a los cambios en la inflación, la producción u otras condiciones económicas. En particular, la regla describe cómo, por cada aumento del uno por ciento en la inflación, el banco central tiende a aumentar la tasa de interés nominal en más de un punto porcentual. Este aspecto de la regla a menudo se denomina el principio de Taylor . Aunque dichas reglas proporcionan indicadores concisos y descriptivos de la política del banco central, en la práctica, no son consideradas explícitamente de manera proscriptiva por los bancos centrales al establecer las tasas nominales.

La versión original de la regla de Taylor describe cómo la tasa de interés nominal responde a las divergencias entre las tasas de inflación reales y las tasas de inflación objetivo y entre el producto interno bruto (PIB) real y el PIB potencial :

En esta ecuación, es la tasa de interés nominal de corto plazo objetivo (por ejemplo, la tasa de fondos federales en EE. UU., la tasa base del Banco de Inglaterra en el Reino Unido), es la tasa de inflación medida por el deflactor del PIB , es la tasa de inflación deseada, es la tasa de interés real de equilibrio asumida, es el logaritmo del PIB real, y es el logaritmo del producto potencial , determinado por una tendencia lineal.

La curva neokeynesiana de Phillips fue derivada originalmente por Roberts en 1995, [48] y desde entonces se ha utilizado en la mayoría de los modelos DSGE neokeynesianos de última generación. [49] La curva neokeynesiana de Phillips dice que la inflación de este período depende de la producción actual y de las expectativas de inflación del próximo período. La curva se deriva del modelo dinámico de precios de Calvo y en términos matemáticos es:

Las expectativas de inflación del período actual t sobre el período siguiente se incorporan como , donde es el factor de descuento. La constante captura la respuesta de la inflación a la producción y está determinada en gran medida por la probabilidad de cambio de precio en cualquier período, que es :

.

Cuanto menos rígidos sean los precios nominales (cuanto más alto sea ), mayor será el efecto de la producción sobre la inflación actual.

Las ideas desarrolladas en la década de 1990 se combinaron para desarrollar el nuevo equilibrio general estocástico dinámico keynesiano utilizado para analizar la política monetaria. Esto culminó en el nuevo modelo keynesiano de tres ecuaciones que se encuentra en la encuesta de Richard Clarida , Jordi Gali y Mark Gertler en el Journal of Economic Literature . [50] [51] Combina las dos ecuaciones de la curva de Phillips neokeynesiana y la regla de Taylor con la curva IS dinámica derivada de la ecuación de consumo dinámico óptimo (ecuación de Euler del hogar).

Estas tres ecuaciones formaban un modelo relativamente simple que podía utilizarse para el análisis teórico de cuestiones de política. Sin embargo, el modelo estaba demasiado simplificado en algunos aspectos (por ejemplo, no hay capital ni inversión). Además, no funciona bien empíricamente.

En el nuevo milenio se han producido varios avances en la nueva economía keynesiana.

Mientras que los modelos de la década de 1990 se centraban en precios rígidos en el mercado de producción, en 2000 Christopher Erceg, Dale Henderson y Andrew Levin adoptaron el modelo de Blanchard y Kiyotaki de mercados laborales sindicalizados combinándolo con el enfoque de precios de Calvo y lo introdujeron en un nuevo modelo DSGE keynesiano. [52]

Para tener modelos que funcionaran bien con los datos y pudieran usarse para simulaciones de políticas, se desarrollaron nuevos modelos keynesianos bastante complicados con varias características. Frank Smets y Rafael Wouters [53] [54] y también Lawrence J. Christiano , Martin Eichenbaum y Charles Evans [55] publicaron artículos seminales . Las características comunes de estos modelos incluían:

La idea de información pegajosa encontrada en el modelo de Fischer fue desarrollada posteriormente por Gregory Mankiw y Ricardo Reis . [56] Esto agregó una nueva característica al modelo de Fischer: hay una probabilidad fija de que un trabajador pueda replanificar sus salarios o precios cada período. Usando datos trimestrales, asumieron un valor del 25%: es decir, cada trimestre el 25% de las empresas/sindicatos elegidos aleatoriamente pueden planificar una trayectoria de precios actuales y futuros basados en la información actual. Así, si consideramos el período actual: el 25% de los precios se basarán en la última información disponible; el resto en la información que estaba disponible cuando pudieron replanificar su trayectoria de precios por última vez. Mankiw y Reis encontraron que el modelo de información pegajosa proporcionaba una buena forma de explicar la persistencia de la inflación.

Los modelos de información rígida no tienen rigidez nominal: las empresas o los sindicatos tienen libertad para elegir precios o salarios diferentes para cada período. Es la información la que es rígida, no los precios. Por lo tanto, cuando una empresa tiene suerte y puede replanificar sus precios actuales y futuros, elegirá una trayectoria de lo que cree que serán los precios óptimos ahora y en el futuro. En general, esto implicará establecer un precio diferente para cada período cubierto por el plan. Esto está en contradicción con la evidencia empírica sobre los precios. [57] [58] En la actualidad, existen muchos estudios sobre la rigidez de los precios en diferentes países: Estados Unidos, [59] la eurozona, [60] el Reino Unido [61] y otros. Todos estos estudios muestran que, si bien hay algunos sectores en los que los precios cambian con frecuencia, también hay otros sectores en los que los precios permanecen fijos a lo largo del tiempo. La falta de precios rígidos en el modelo de información rígida es incompatible con el comportamiento de los precios en la mayor parte de la economía. Esto ha llevado a intentos de formular un modelo de "doble rigidez" que combina información rígida con precios rígidos. [58] [62]

En la década de 2010 se desarrollaron modelos que incorporaban la heterogeneidad de los hogares en el marco neokeynesiano estándar, comúnmente denominados modelos "HANK" (nuevo keynesianismo de agente heterogéneo). Además de los precios rígidos, un modelo HANK típico presenta un riesgo de ingresos laborales idiosincrásicos no asegurables que da lugar a una distribución de la riqueza no degenerada. Los primeros modelos con estas dos características incluyen a Oh y Reis (2012), [63] McKay y Reis (2016) [64] y Guerrieri y Lorenzoni (2017). [65]

El nombre "modelo HANK" fue acuñado por Greg Kaplan , Benjamin Moll y Gianluca Violante en un artículo de 2018 [66] que además modela a los hogares como si acumularan dos tipos de activos, uno líquido y otro ilíquido. Esto se traduce en una rica heterogeneidad en la composición de la cartera entre los hogares. En particular, el modelo se ajusta a la evidencia empírica al presentar una gran proporción de hogares que poseen poca riqueza líquida: los hogares "al día". En consonancia con la evidencia empírica, [67] alrededor de dos tercios de estos hogares poseen cantidades no triviales de riqueza ilíquida, a pesar de poseer poca riqueza líquida. Estos hogares se conocen como hogares ricos al día, un término introducido en un estudio de 2014 sobre políticas de estímulo fiscal por Kaplan y Violante. [68]

La existencia de hogares ricos que viven al día en los modelos neokeynesianos es importante para los efectos de la política monetaria, porque el comportamiento de consumo de esos hogares es muy sensible a los cambios en el ingreso disponible, más que a las variaciones en la tasa de interés (es decir, el precio del consumo futuro en relación con el consumo actual). El corolario directo es que la política monetaria se transmite principalmente a través de efectos de equilibrio general que funcionan a través del ingreso laboral de los hogares, más que a través de la sustitución intertemporal, que es el principal canal de transmisión en los modelos neokeynesianos de agente representativo (RANK).

Esto tiene dos implicaciones principales para la política monetaria. En primer lugar, la política monetaria interactúa fuertemente con la política fiscal, debido a la falla de la equivalencia ricardiana debido a la presencia de hogares que viven al día. En particular, los cambios en la tasa de interés modifican la restricción presupuestaria del gobierno, y la respuesta fiscal a este cambio afecta el ingreso disponible de los hogares. En segundo lugar, los shocks monetarios agregados no son neutrales en términos distributivos, ya que afectan la rentabilidad del capital, que afecta de manera diferente a los hogares con diferentes niveles de riqueza y activos.

Los economistas neokeynesianos coinciden con los economistas neoclásicos en que, a largo plazo, se cumple la dicotomía clásica : los cambios en la oferta monetaria son neutrales . Sin embargo, como los precios son rígidos en el modelo neokeynesiano, un aumento en la oferta monetaria (o, equivalentemente, una disminución en la tasa de interés) sí aumenta la producción y reduce el desempleo en el corto plazo. Además, algunos modelos neokeynesianos confirman la no neutralidad del dinero en varias condiciones. [69] [70]

Sin embargo, los economistas neokeynesianos no abogan por el uso de una política monetaria expansiva para obtener ganancias a corto plazo en la producción y el empleo, ya que ello elevaría las expectativas inflacionarias y, por lo tanto, generaría problemas para el futuro. En cambio, abogan por el uso de la política monetaria para la estabilización . Es decir, no se recomienda aumentar repentinamente la oferta monetaria sólo para producir un auge económico temporal, ya que eliminar las mayores expectativas inflacionarias será imposible sin producir una recesión.

Sin embargo, cuando la economía se ve afectada por algún shock externo inesperado, puede ser una buena idea contrarrestar los efectos macroeconómicos del shock con una política monetaria. Esto es especialmente cierto si el shock inesperado es de tipo (como una caída en la confianza del consumidor) que tiende a reducir tanto la producción como la inflación; en ese caso, expandir la oferta monetaria (reducir las tasas de interés) ayuda a aumentar la producción y, al mismo tiempo, estabilizar la inflación y las expectativas inflacionarias.

Los estudios de política monetaria óptima en los modelos DSGE neokeynesianos se han centrado en las reglas de tipos de interés (especialmente las « reglas de Taylor »), que especifican cómo debería ajustar el banco central el tipo de interés nominal en respuesta a los cambios en la inflación y la producción. (Más precisamente, las reglas óptimas suelen reaccionar a los cambios en la brecha de producción , en lugar de a los cambios en la producción per se ). En algunos modelos DSGE neokeynesianos simples, resulta que estabilizar la inflación es suficiente, porque mantener una inflación perfectamente estable también estabiliza la producción y el empleo al máximo grado deseable. Blanchard y Galí han llamado a esta propiedad la «divina coincidencia». [71]

Sin embargo, también muestran que en los modelos con más de una imperfección del mercado (por ejemplo, fricciones en el ajuste del nivel de empleo, así como precios rígidos), ya no hay una "coincidencia divina", y en cambio hay una disyuntiva entre estabilizar la inflación y estabilizar el empleo. [72] Además, si bien algunos macroeconomistas creen que los modelos neokeynesianos están a punto de ser útiles para el asesoramiento sobre políticas cuantitativas trimestre a trimestre, existe desacuerdo. [73]

Alves (2014) [74] demostró que la coincidencia divina no se cumple necesariamente en la forma no lineal del modelo neokeynesiano estándar. Esta propiedad solo se cumpliría si la autoridad monetaria se propone mantener la tasa de inflación exactamente en el 0%. En cualquier otro objetivo deseado para la tasa de inflación, existe una disyuntiva endógena, incluso en ausencia de imperfecciones reales como salarios rígidos, y la coincidencia divina ya no se cumple.

A lo largo de los años, una serie de "nuevas" teorías macroeconómicas relacionadas con el keynesianismo o en contra de él han sido influyentes. [75] Después de la Segunda Guerra Mundial , Paul Samuelson utilizó el término síntesis neoclásica para referirse a la integración de la economía keynesiana con la economía neoclásica . La idea era que el gobierno y el banco central mantendrían un pleno empleo aproximado, de modo que se aplicaran las nociones neoclásicas , centradas en el axioma de la universalidad de la escasez . El modelo IS/LM de John Hicks fue central para la síntesis neoclásica.

Los trabajos posteriores de economistas como James Tobin y Franco Modigliani , que ponen más énfasis en los fundamentos microeconómicos del consumo y la inversión, se denominan a veces neokeynesianismo . A menudo se los contrasta con el poskeynesianismo de Paul Davidson , que enfatiza el papel de la incertidumbre fundamental en la vida económica, especialmente en lo que respecta a las cuestiones de la inversión privada fija .

El nuevo keynesianismo fue una respuesta a Robert Lucas y a la nueva escuela clásica . [76] Esa escuela criticó las inconsistencias del keynesianismo a la luz del concepto de " expectativas racionales ". Los nuevos clásicos combinaban un equilibrio único de equilibrio de mercado (en pleno empleo ) con expectativas racionales. Los nuevos keynesianos utilizaban "microfundamentos" para demostrar que la rigidez de los precios impide que los mercados se equilibren. Por lo tanto, el equilibrio basado en expectativas racionales no necesita ser único.

Mientras que la síntesis neoclásica esperaba que la política fiscal y monetaria mantendría el pleno empleo , los nuevos clásicos suponían que el ajuste de precios y salarios alcanzaría automáticamente esa situación en el corto plazo. Los nuevos keynesianos, por otra parte, consideraban que el pleno empleo se alcanzaba automáticamente sólo en el largo plazo, ya que los precios son "rígidos" en el corto plazo. Las políticas gubernamentales y de los bancos centrales son necesarias porque el "largo plazo" puede ser muy largo.

En última instancia, las diferencias entre la nueva macroeconomía clásica y la nueva economía keynesiana se resolvieron en la nueva síntesis neoclásica de la década de 1990, que forma la base de la economía dominante en la actualidad, [2] [3] [4] y el énfasis keynesiano en la importancia de la coordinación centralizada de las políticas macroeconómicas (por ejemplo, el estímulo monetario y fiscal), las instituciones económicas internacionales como el Banco Mundial y el Fondo Monetario Internacional (FMI), y el mantenimiento de un sistema comercial controlado se destacó durante la crisis financiera y económica mundial de 2008. Esto se ha reflejado en el trabajo de los economistas del FMI [77] y de Donald Markwell . [78]

{{cite journal}}: Requiere citar revista |journal=( ayuda ){{cite journal}}: Requiere citar revista |journal=( ayuda )