La localización de sonido 3D se refiere a una tecnología acústica que se utiliza para localizar la fuente de un sonido en un espacio tridimensional . La ubicación de la fuente suele estar determinada por la dirección de las ondas sonoras entrantes (ángulos horizontales y verticales) y la distancia entre la fuente y los sensores. Implica el diseño de la disposición estructural de los sensores y las técnicas de procesamiento de señales .

La mayoría de los mamíferos (incluidos los humanos) utilizan la audición binaural para localizar el sonido, comparando la información recibida de cada oído en un proceso complejo que implica una cantidad significativa de síntesis. Es difícil localizarlo mediante audición monoaural , especialmente en el espacio 3D .

La tecnología de localización de sonido se utiliza en algunos campos del audio y la acústica , como los audífonos , la vigilancia [1] y la navegación . Los sistemas de localización pasiva de sonido en tiempo real existentes se basan principalmente en el enfoque de diferencia de tiempo de llegada ( TDOA ), que limita la localización del sonido al espacio bidimensional , y no son prácticos en condiciones ruidosas.

Las aplicaciones de localización de fuentes de sonido incluyen separación de fuentes de sonido, seguimiento de fuentes de sonido y mejora del habla. El sonar utiliza técnicas de localización de fuentes de sonido para identificar la ubicación de un objetivo. La localización de sonido 3D también se utiliza para una interacción eficaz entre humanos y robots. Con la creciente demanda de audición robótica, se están explorando algunas aplicaciones de localización de sonido 3D, como la interfaz hombre-máquina, ayuda para discapacitados y aplicaciones militares. [2]

Las señales de localización [3] son funciones que ayudan a localizar el sonido. Las señales para la localización del sonido incluyen señales binaurales y monoaurales.

La primera pista que utiliza nuestra audición es la diferencia horaria interaural. El sonido de una fuente directamente delante o detrás de nosotros llegará simultáneamente a ambos oídos. Si la fuente se mueve hacia la izquierda o hacia la derecha, nuestros oídos captan el sonido de la misma fuente que llega a ambos oídos, pero con un cierto retraso. Otra forma de decirlo podría ser que los dos oídos captan diferentes fases de la misma señal. [4]

Existen muchos métodos diferentes de localización de sonido 3D. Por ejemplo:

Este enfoque utiliza ocho micrófonos combinados con un formador de haz dirigido mejorado por la transformación de fase ponderada de confiabilidad (RWPHAT). Los resultados finales se filtran a través de un filtro de partículas que rastrea las fuentes y evita direcciones falsas.

La motivación para utilizar este método es la basada en investigaciones previas. Este método se utiliza para el seguimiento y localización de múltiples fuentes de sonido, a pesar de que la banda sonora y la localización solo se aplican a una única fuente de sonido.

Maximizar la energía de salida de un formador de haz de retardo y suma para encontrar el valor máximo de la salida de un formador de haz dirigido en todas las direcciones posibles. Utilizando el método de transformación de fase ponderada por confiabilidad (RWPHAT), la energía de salida del formador de haz de suma y retardo del micrófono M es

Donde E indica la energía y K es una constante, la correlación cruzada de los pares de micrófonos está definida por la transformada de fase ponderada por confiabilidad:

el factor ponderado refleja la confiabilidad de cada componente de frecuencia y se define como la ganancia del filtro Wiener , donde es una estimación de una SNR anterior en el micrófono, en el marco de tiempo , para la frecuencia , calculada utilizando el enfoque dirigido por decisiones. [8]

Es la señal del micrófono y es el retraso de llegada de ese micrófono. El procedimiento más específico de este método es propuesto por Valin y Michaud [9]

La ventaja de este método es que detecta la dirección del sonido y deriva la distancia de las fuentes de sonido. El principal inconveniente del enfoque de formación de haces es la naturaleza imperfecta de la precisión y la capacidad de localización del sonido, en comparación con el enfoque de redes neuronales, que utiliza altavoces en movimiento.

Este método se relaciona con la técnica de localización de sonido en tiempo real utilizando una matriz de sensores vectoriales acústicos (AVS), que mide los tres componentes de la velocidad de las partículas acústicas, así como la presión del sonido, a diferencia de las matrices de sensores acústicos convencionales que solo utilizan la presión. información y retrasos en la propagación del campo acústico. Al explotar esta información adicional, las matrices AVS pueden mejorar significativamente la precisión de la localización de la fuente.

• Contiene tres sensores acústicos de velocidad de partículas colocados ortogonalmente (que se muestran como conjuntos X, Y y Z) y un micrófono acústico omnidireccional (O).

• Comúnmente utilizado tanto en el aire [10] como bajo el agua.

• Puede usarse en combinación con el proceso de calibración fuera de línea [11] para medir e interpolar la respuesta al impulso de los conjuntos X, Y, Z y O, para obtener su vector de dirección.

Primero se ventana una señal de sonido usando una ventana rectangular, luego cada señal de segmento resultante se crea como un marco. Se detectan 4 fotogramas paralelos a partir de la matriz XYZO y se utilizan para la estimación de DOA. Los 4 fotogramas se dividen en pequeños bloques de igual tamaño, luego se utilizan la ventana de Hamming y FFT para convertir cada bloque de un dominio de tiempo a un dominio de frecuencia. Entonces, la salida de este sistema está representada por un ángulo horizontal y un ángulo vertical de las fuentes de sonido que se encuentra mediante el pico en el espectro espacial 3D combinado.

Las ventajas de este conjunto, en comparación con los conjuntos de micrófonos anteriores, son que este dispositivo tiene un alto rendimiento incluso si la apertura es pequeña y puede localizar múltiples fuentes de sonido de banda ancha de baja y alta frecuencia simultáneamente. La aplicación de una matriz O puede hacer que haya más información acústica disponible, como la amplitud y la diferencia de tiempo. Lo más importante es que la matriz XYZO tiene un mejor rendimiento con un tamaño pequeño.

El AVS es un tipo de conjunto de micrófonos múltiples colocados, utiliza un enfoque de conjunto de micrófonos múltiples para estimar las direcciones del sonido mediante múltiples conjuntos y luego encuentra las ubicaciones utilizando información de reflexión, como dónde se detecta la dirección donde se cruzan diferentes conjuntos.

Los reflejos del sonido siempre ocurren en un entorno real y los conjuntos de micrófonos [12] no pueden evitar observar esos reflejos. Este enfoque de arreglos múltiples se probó utilizando arreglos fijos en el techo; el rendimiento del escenario móvil aún debe probarse.

La incertidumbre del ángulo (AU) se producirá al estimar la dirección, y la incertidumbre de la posición (PU) también se agravará al aumentar la distancia entre el conjunto y la fuente. Sabemos que:

Donde r es la distancia entre el centro del conjunto y la fuente y AU es el ángulo de incertidumbre. La medición se utiliza para juzgar si dos direcciones se cruzan en algún lugar o no. Distancia mínima entre dos líneas:

donde y son dos direcciones, son vectores paralelos a la dirección detectada y son la posición de las matrices.

Si

Se considera que dos líneas se cruzan. Cuando dos líneas se cruzan, podemos calcular la ubicación de la fuente de sonido usando lo siguiente:

es la estimación de la posición de la fuente de sonido, es la posición donde cada dirección cruza la línea con una distancia mínima y son los factores ponderados. Como factor de ponderación , determinamos el uso o desde la matriz hasta la línea con una distancia mínima.

Las técnicas basadas en escaneo son una herramienta poderosa para localizar y visualizar fuentes de sonido estacionarias en el tiempo, ya que solo requieren el uso de un único sensor y un sistema de seguimiento de posición. Un método popular para lograrlo es mediante el uso de un sensor vectorial acústico (AVS), también conocido como sonda de intensidad del sonido 3D, en combinación con un rastreador 3D.

El procedimiento de medición implica mover manualmente el sensor AVS alrededor de la fuente de sonido mientras se utiliza una cámara estéreo para extraer la posición instantánea del sensor en el espacio tridimensional. Luego, las señales grabadas se dividen en múltiples segmentos y se asignan a un conjunto de posiciones mediante un algoritmo de discretización espacial. Esto permite calcular una representación vectorial de las variaciones acústicas a través del campo sonoro, utilizando combinaciones de la presión del sonido y las tres velocidades ortogonales de las partículas acústicas.

Los resultados del análisis AVS se pueden presentar sobre un boceto 3D del objeto probado, proporcionando una representación visual de la distribución del sonido alrededor de una malla 3D del objeto o entorno. Esto puede resultar útil para localizar fuentes de sonido en diversos campos, como la acústica arquitectónica, el control de ruido y la ingeniería de audio, ya que permite una comprensión detallada de la distribución del sonido y sus interacciones con el entorno.

El aprendizaje auditivo binaural [5] es un método biónico . El sensor es una cabeza simulada de robot con 2 micrófonos sensores junto con el pabellón auricular artificial (reflector). El cabezal del robot tiene 2 ejes de rotación y puede girar horizontal y verticalmente. El reflector hace que el espectro cambie a un patrón determinado para la onda de sonido de ruido blanco entrante y este patrón se utiliza para indicar la localización vertical. La señal para la localización horizontal es ITD. El sistema utiliza un proceso de aprendizaje mediante redes neuronales girando el cabezal con una fuente de sonido de ruido blanco fija y analizando el espectro. Los experimentos muestran que el sistema puede identificar bien la dirección de la fuente en un cierto rango de ángulo de llegada. No puede identificar el sonido que sale del rango debido al patrón de espectro colapsado del reflector. La audición binaural utiliza sólo 2 micrófonos y es capaz de concentrarse en una fuente entre múltiples fuentes de ruido.

En la localización real del sonido, además de los dos pabellones auriculares, desempeñan un papel funcional la cabeza del robot y el torso. Esto funciona como filtrado lineal espacial y el filtrado siempre se cuantifica en términos de función de transferencia relacionada con la cabeza (HRTF). [14] HRTF también utiliza el sensor de cabeza robótica, que es el modelo de audición binaural. El HRTF se puede derivar en función de varias señales de localización. La localización de sonido con HRTF consiste en filtrar la señal de entrada con un filtro diseñado en base al HRTF. En lugar de utilizar redes neuronales, se utiliza una función de transferencia relacionada con la cabeza y la localización se basa en un método de correlación simple.

Ver más: Función de transferencia relacionada con la cabeza .

El método CSP [15] también se utiliza para el modelo binaural. La idea es que el ángulo de llegada se puede derivar a través del tiempo de retardo de llegada (TDOA) entre dos micrófonos, y el TDOA se puede estimar encontrando los coeficientes máximos de CSP. Los coeficientes CSP se derivan de:

Donde y son las señales que ingresan al micrófono y, respectivamente,

el retraso de llegada ( ), se pueden estimar mediante:

La dirección de la fuente de sonido es

Donde es la velocidad de propagación del sonido, es la frecuencia de muestreo y es la distancia con retardo de tiempo máximo entre 2 micrófonos.

El método CPS no requiere los datos de respuesta al impulso del sistema que necesita HRTF. También se utiliza un algoritmo de maximización de expectativas para localizar varias fuentes de sonido y reducir los errores de localización. El sistema es capaz de identificar varias fuentes de sonido en movimiento utilizando sólo dos micrófonos.

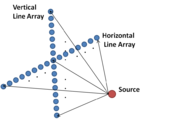

Para estimar la ubicación de una fuente en el espacio 3D, se pueden colocar dos conjuntos de sensores lineales horizontal y verticalmente. Un ejemplo es un line array 2D utilizado para la localización de fuentes submarinas. [16] Al procesar los datos de dos conjuntos utilizando el método de máxima verosimilitud , la dirección, el alcance y la profundidad de la fuente se pueden identificar simultáneamente. A diferencia del modelo de audición binaural, este método es similar al método de análisis espectral . El método se puede utilizar para localizar una fuente distante.

La rotación de la matriz de dos micrófonos (también conocida como matriz de bimicrófonos [17] ) conduce a una señal de diferencia de tiempo entre canales (ICTD) sinusoidal para una fuente de sonido estacionaria presente en un entorno 3D. El cambio de fase de la señal sinusoidal resultante se puede asignar directamente al ángulo de azimut de la fuente de sonido, y la amplitud de la señal ICTD se puede representar como una función del ángulo de elevación de la fuente de sonido y la distancia entre los dos micrófonos. [18] En el caso de múltiples fuentes, la señal ICTD tiene puntos de datos que forman múltiples formas de onda sinusoidales discontinuas. Se pueden aplicar técnicas de aprendizaje automático, como el consenso de muestras aleatorias (RANSAC) y la agrupación espacial de aplicaciones con ruido basada en densidad (DBSCAN), para identificar cambios de fase (asignación a acimutes) y amplitudes (asignación a elevaciones) de cada forma de onda sinusoidal discontinua en el Señal TICD. [19]

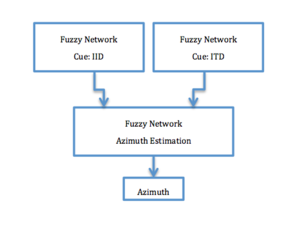

El sistema de localización de sonido del enfoque jerárquico difuso de redes neuronales artificiales se modeló a partir de la localización de sonido biológicamente binaural. Algunos animales primitivos con dos orejas y cerebros pequeños pueden percibir el espacio tridimensional y procesar sonidos, aunque el proceso no se comprende completamente. Algunos animales experimentan dificultades para localizar el sonido en 3D debido al tamaño pequeño de la cabeza. Además, la longitud de onda del sonido de comunicación puede ser mucho mayor que el diámetro de su cabeza, como es el caso de las ranas .

Basado en métodos anteriores de localización de sonido binaural, un sistema de red neuronal artificial difuso jerárquico combina métodos de localización de sonido de diferencia de tiempo interaural (basados en ITD) y diferencia de intensidad interaural (basados en IID) para una mayor precisión similar a la de los humanos. Se utilizaron redes neuronales artificiales difusas jerárquicas [20] con el objetivo de lograr la misma precisión de localización del sonido que los oídos humanos.

Los métodos de localización de sonido basados en IID o ITD tienen un problema principal llamado confusión frontal-posterior. [21] En esta localización sólida basada en un sistema de red neuronal jerárquica, para resolver este problema, se realiza una estimación IID con una estimación ITD. Este sistema se utilizó para sonidos de banda ancha y se implementará en escenarios no estacionarios.

Normalmente, la localización del sonido se realiza mediante el uso de dos (o más) micrófonos. Utilizando la diferencia de tiempos de llegada de un sonido a los dos micrófonos, se puede estimar matemáticamente la dirección de la fuente del sonido. Sin embargo, la precisión con la que un conjunto de micrófonos puede localizar un sonido (utilizando la diferencia de tiempo interaural ) está fundamentalmente limitada por el tamaño físico del conjunto. Si el conjunto es demasiado pequeño, entonces los micrófonos están demasiado espaciados entre sí para que todos graben esencialmente el mismo sonido (con el ITF cerca de cero), lo que hace extremadamente difícil estimar la orientación. Por lo tanto, no es raro que los conjuntos de micrófonos tengan una longitud que va desde decenas de centímetros (para aplicaciones de escritorio) hasta muchas decenas de metros (para localización submarina). Sin embargo, los conjuntos de micrófonos de este tamaño resultan poco prácticos para su uso en robots pequeños. Incluso para robots grandes, estos conjuntos de micrófonos pueden resultar complicados de montar y maniobrar. Por el contrario, la capacidad de localizar sonido usando un solo micrófono (que puede ser extremadamente pequeño) tiene el potencial de dispositivos de localización significativamente más compactos, así como de menor costo y potencia.

Una forma general de implementar la localización de sonido 3D es utilizar HRTF ( función de transferencia relacionada con la cabeza ). Primero, calcule los HRTF para la localización del sonido 3D formulando dos ecuaciones; uno representa la señal de una fuente de sonido determinada y el otro indica la señal de salida de los micrófonos de la cabeza del robot para el sonido transferido desde la fuente. Estos HRTF procesan los datos de entrada monoaurales y los resultados se emiten a través de auriculares estéreo. La desventaja de este método es que se necesitan muchas operaciones paramétricas para que todo el conjunto de filtros realice la localización del sonido 3D, lo que resulta en una alta complejidad computacional.

Una implementación basada en DSP de un enfoque de localización de sonido 3D en tiempo real con el uso de un DSP integrado puede reducir la complejidad computacional. Como se muestra en la figura, el procedimiento de implementación de este algoritmo en tiempo real se divide en tres fases: (i) División de frecuencia, ( ii) Localización de Sonido, y (iii) Mezcla. En el caso de la localización de sonido 3D para una fuente de sonido monoaural, los datos de entrada de audio se dividen en dos: canales izquierdo y derecho y los datos de entrada de audio en series temporales se procesan uno tras otro. [22]

Una característica distintiva de este enfoque es que la banda de frecuencia audible se divide en tres, de modo que se puede explotar un procedimiento distinto de localización de sonido 3D para cada una de las tres subbandas.

La localización monoaural es posible gracias a la estructura del pabellón auricular (oído externo), que modifica el sonido de una manera que depende de su ángulo de incidencia. Se adapta un enfoque de aprendizaje automático para la localización monoaural utilizando un solo micrófono y un “pabellón auricular artificial” (que distorsiona el sonido en función de la dirección). El enfoque modela la distribución típica de los sonidos naturales y artificiales, así como los cambios de los sonidos dependientes de la dirección inducidos por el pabellón auricular. [23] Los resultados experimentales también muestran que el algoritmo es capaz de localizar con bastante precisión una amplia gama de sonidos, como el habla humana, el ladrido de un perro, una cascada, un trueno, etc. A diferencia de los conjuntos de micrófonos, este enfoque también ofrece el potencial de dispositivos para la localización de sonido significativamente más compactos, así como de menor coste y potencia.