La inferencia causal es el proceso de determinar el efecto real e independiente de un fenómeno particular que es un componente de un sistema más grande. La principal diferencia entre la inferencia causal y la inferencia de asociación es que la inferencia causal analiza la respuesta de una variable de efecto cuando se cambia una causa de la variable de efecto. [1] [2] El estudio de por qué ocurren las cosas se llama etiología y se puede describir utilizando el lenguaje de la notación causal científica . Se dice que la inferencia causal proporciona la evidencia de la causalidad teorizada por el razonamiento causal .

La inferencia causal se estudia ampliamente en todas las ciencias. En las últimas décadas han proliferado varias innovaciones en el desarrollo e implementación de metodologías diseñadas para determinar la causalidad. La inferencia causal sigue siendo especialmente difícil cuando la experimentación es difícil o imposible, lo que es común en la mayoría de las ciencias.

Los métodos de inferencia causal son ampliamente aplicables en todo tipo de disciplinas científicas, y muchos métodos de inferencia causal que fueron diseñados para ciertas disciplinas han encontrado uso en otras disciplinas. Este artículo describe el proceso básico detrás de la inferencia causal y detalla algunas de las pruebas más convencionales utilizadas en diferentes disciplinas; sin embargo, esto no debe confundirse con una sugerencia de que estos métodos se aplican solo a esas disciplinas, sino simplemente que son los más comúnmente utilizados en esa disciplina.

La inferencia causal es difícil de realizar y existe un debate importante entre los científicos sobre la forma adecuada de determinar la causalidad. A pesar de otras innovaciones, sigue habiendo preocupaciones por la atribución errónea por parte de los científicos de resultados correlativos como causales, por el uso de metodologías incorrectas por parte de los científicos y por la manipulación deliberada por parte de los científicos de los resultados analíticos con el fin de obtener estimaciones estadísticamente significativas. Se plantea una preocupación particular en relación con el uso de modelos de regresión, especialmente los modelos de regresión lineal.

Inferir la causa de algo se ha descrito como:

La inferencia causal se lleva a cabo mediante el estudio de sistemas donde se sospecha que la medida de una variable afecta la medida de otra. La inferencia causal se lleva a cabo con respecto al método científico . El primer paso de la inferencia causal es formular una hipótesis nula falsable , que posteriormente se prueba con métodos estadísticos . La inferencia estadística frecuentista es el uso de métodos estadísticos para determinar la probabilidad de que los datos ocurran bajo la hipótesis nula por casualidad; la inferencia bayesiana se utiliza para determinar el efecto de una variable independiente. [5] La inferencia estadística se utiliza generalmente para determinar la diferencia entre las variaciones en los datos originales que son variación aleatoria o el efecto de un mecanismo causal bien especificado. En particular, la correlación no implica causalidad , por lo que el estudio de la causalidad se ocupa tanto del estudio de los mecanismos causales potenciales como de la variación entre los datos. [ cita requerida ] Un estándar de inferencia causal buscado con frecuencia es un experimento en el que el tratamiento se asigna aleatoriamente pero todos los demás factores de confusión se mantienen constantes. La mayoría de los esfuerzos en la inferencia causal están en el intento de replicar las condiciones experimentales.

Los estudios epidemiológicos emplean diferentes métodos epidemiológicos para recopilar y medir evidencia de factores de riesgo y efectos, y diferentes formas de medir la asociación entre ambos. Los resultados de una revisión de 2020 de métodos para la inferencia causal encontraron que el uso de la literatura existente para programas de capacitación clínica puede ser un desafío. Esto se debe a que los artículos publicados a menudo asumen una formación técnica avanzada, pueden estar escritos desde múltiples perspectivas estadísticas, epidemiológicas, informáticas o filosóficas, los enfoques metodológicos continúan expandiéndose rápidamente y muchos aspectos de la inferencia causal reciben una cobertura limitada. [6]

Los marcos comunes para la inferencia causal incluyen el modelo circular causal (componente-causa), el modelo causal estructural de Pearl ( diagrama causal + cálculo D ), el modelo de ecuaciones estructurales y el modelo causal de Rubin (potencial-resultado), que se utilizan a menudo en áreas como las ciencias sociales y la epidemiología. [7]

La verificación experimental de los mecanismos causales es posible mediante métodos experimentales. La motivación principal detrás de un experimento es mantener constantes otras variables experimentales mientras se manipula deliberadamente la variable de interés. Si el experimento produce efectos estadísticamente significativos como resultado de manipular únicamente la variable de tratamiento, hay motivos para creer que se puede atribuir un efecto causal a la variable de tratamiento, suponiendo que se hayan cumplido otros estándares para el diseño experimental.

La verificación cuasiexperimental de los mecanismos causales se lleva a cabo cuando no se dispone de métodos experimentales tradicionales. Esto puede deberse a los costos prohibitivos de realizar un experimento o a la inviabilidad inherente de realizar un experimento, especialmente si se trata de experimentos que se relacionan con sistemas grandes, como las economías de los sistemas electorales, o con tratamientos que se considera que presentan un peligro para el bienestar de los sujetos de prueba. Los cuasiexperimentos también pueden ocurrir cuando se retiene información por razones legales.

La epidemiología estudia los patrones de salud y enfermedad en poblaciones definidas de seres vivos con el fin de inferir causas y efectos. Una asociación entre una exposición a un factor de riesgo putativo y una enfermedad puede ser sugestiva de, pero no es equivalente a causalidad porque la correlación no implica causalidad . Históricamente, los postulados de Koch se han utilizado desde el siglo XIX para decidir si un microorganismo era la causa de una enfermedad. En el siglo XX los criterios de Bradford Hill , descritos en 1965 [8] se han utilizado para evaluar la causalidad de variables fuera de la microbiología, aunque incluso estos criterios no son formas exclusivas de determinar la causalidad.

En la epidemiología molecular los fenómenos que se estudian son a nivel de biología molecular , incluida la genética, donde los biomarcadores son evidencias de causa o efecto.

Una tendencia reciente [ ¿cuándo? ] es identificar evidencia de la influencia de la exposición en la patología molecular dentro de los tejidos o células enfermas, en el campo interdisciplinario emergente de la epidemiología patológica molecular (MPE). [ fuente de terceros necesaria ] Vincular la exposición a las firmas patológicas moleculares de la enfermedad puede ayudar a evaluar la causalidad. [ fuente de terceros necesaria ] Considerando la naturaleza inherente de la heterogeneidad de una enfermedad dada, el principio de enfermedad única, la fenotipificación y subtipificación de la enfermedad son tendencias en las ciencias biomédicas y de salud pública , ejemplificadas como la medicina personalizada y la medicina de precisión . [ fuente de terceros necesaria ]

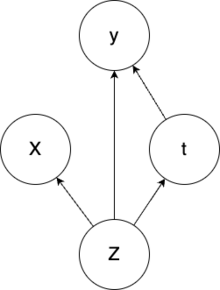

La inferencia causal también se ha utilizado para la estimación del efecto del tratamiento. Suponiendo un conjunto de síntomas observables del paciente ( X ) causados por un conjunto de causas ocultas ( Z ), podemos elegir dar o no un tratamiento t . El resultado de dar o no el tratamiento es la estimación del efecto y . Si no se garantiza que el tratamiento tenga un efecto positivo, entonces la decisión de si el tratamiento debe aplicarse o no depende en primer lugar del conocimiento experto que abarca las conexiones causales. Para enfermedades nuevas, este conocimiento experto puede no estar disponible. Como resultado, confiamos únicamente en los resultados del tratamiento pasado para tomar decisiones. Se puede utilizar un autocodificador variacional modificado para modelar el gráfico causal descrito anteriormente. [9] Si bien el escenario anterior podría modelarse sin el uso del factor de confusión oculto (Z), perderíamos la idea de que los síntomas de un paciente junto con otros factores impactan tanto en la asignación del tratamiento como en el resultado.

La inferencia causal es un concepto importante en el campo de la inteligencia artificial causal . La determinación de causa y efecto a partir de datos de observación conjuntos para dos variables independientes del tiempo, por ejemplo X e Y, se ha abordado utilizando la asimetría entre la evidencia de algún modelo en las direcciones X → Y e Y → X. Los enfoques principales se basan en modelos de teoría de la información algorítmica y modelos de ruido. [ cita requerida ]

Incorporar un término de ruido independiente en el modelo para comparar las evidencias de las dos direcciones.

A continuación se muestran algunos de los modelos de ruido para la hipótesis Y → X con el ruido E:

Los supuestos comunes en estos modelos son:

En un nivel intuitivo, la idea es que la factorización de la distribución conjunta P(Causa, Efecto) en P(Causa)*P(Efecto | Causa) normalmente produce modelos de menor complejidad total que la factorización en P(Efecto)*P(Causa | Efecto). Aunque la noción de "complejidad" es intuitivamente atractiva, no es obvio cómo debería definirse con precisión. [13] Una familia diferente de métodos intenta descubrir "huellas" causales a partir de grandes cantidades de datos etiquetados y permite la predicción de relaciones causales más flexibles. [14]

Las ciencias sociales en general han avanzado cada vez más hacia la inclusión de marcos cuantitativos para evaluar la causalidad. Gran parte de esto se ha descrito como un medio para proporcionar un mayor rigor a la metodología de las ciencias sociales. La ciencia política se vio significativamente influenciada por la publicación de Designing Social Inquiry , de Gary King, Robert Keohane y Sidney Verba, en 1994. King, Keohane y Verba recomiendan que los investigadores apliquen métodos tanto cuantitativos como cualitativos y adopten el lenguaje de la inferencia estadística para ser más claros acerca de sus temas de interés y unidades de análisis. [15] [16] Los defensores de los métodos cuantitativos también han adoptado cada vez más el marco de resultados potenciales , desarrollado por Donald Rubin , como un estándar para inferir la causalidad. [ cita requerida ]

Aunque gran parte del énfasis sigue estando en la inferencia estadística en el marco de resultados potenciales, los metodólogos de las ciencias sociales han desarrollado nuevas herramientas para realizar inferencias causales con métodos tanto cualitativos como cuantitativos, a veces llamados un enfoque de "métodos mixtos". [17] [18] Los defensores de diversos enfoques metodológicos argumentan que diferentes metodologías son más adecuadas para diferentes temas de estudio. El sociólogo Herbert Smith y los politólogos James Mahoney y Gary Goertz han citado la observación de Paul Holland, estadístico y autor del artículo de 1986 "Estadísticas e inferencia causal", de que la inferencia estadística es más apropiada para evaluar los "efectos de las causas" en lugar de las "causas de los efectos". [19] [20] Los metodólogos cualitativos han argumentado que los modelos formalizados de causalidad, incluido el rastreo de procesos y la teoría de conjuntos difusos , brindan oportunidades para inferir la causalidad a través de la identificación de factores críticos dentro de los estudios de caso o mediante un proceso de comparación entre varios estudios de caso. [16] Estas metodologías también son valiosas para temas en los que un número limitado de observaciones potenciales o la presencia de variables de confusión limitarían la aplicabilidad de la inferencia estadística. [ cita requerida ]

En escalas temporales más largas, los estudios de persistencia utilizan la inferencia causal para vincular eventos históricos con resultados políticos, económicos y sociales posteriores. [21]

En las ciencias económicas y políticas, la inferencia causal suele ser difícil debido a la complejidad de las realidades económicas y políticas del mundo real y a la incapacidad de recrear muchos fenómenos a gran escala en experimentos controlados. La inferencia causal en las ciencias económicas y políticas sigue mejorando en cuanto a metodología y rigor, debido al mayor nivel de tecnología disponible para los científicos sociales, el aumento del número de científicos sociales y de la investigación, y las mejoras en las metodologías de inferencia causal en todas las ciencias sociales. [22]

A pesar de las dificultades inherentes a la determinación de la causalidad en los sistemas económicos, existen varios métodos ampliamente empleados en esos campos.

Los economistas y politólogos pueden utilizar la teoría (que suele estudiarse en la econometría basada en la teoría) para estimar la magnitud de las relaciones supuestamente causales en los casos en que creen que existe una relación causal. [23] Los teóricos pueden presuponer un mecanismo que se cree que es causal y describir los efectos utilizando el análisis de datos para justificar la teoría propuesta. Por ejemplo, los teóricos pueden utilizar la lógica para construir un modelo, como teorizar que la lluvia causa fluctuaciones en la productividad económica pero que lo inverso no es cierto. [24] Sin embargo, el uso de afirmaciones puramente teóricas que no ofrecen ninguna perspectiva predictiva se ha denominado "precientífico" porque no hay capacidad para predecir el impacto de las supuestas propiedades causales. [5] Vale la pena reiterar que el análisis de regresión en las ciencias sociales no implica inherentemente causalidad, ya que muchos fenómenos pueden correlacionarse en el corto plazo o en conjuntos de datos particulares, pero no demostrar correlación en otros períodos de tiempo u otros conjuntos de datos. Por lo tanto, la atribución de causalidad a propiedades correlativas es prematura en ausencia de un mecanismo causal bien definido y razonado.

La técnica de variables instrumentales (IV) es un método de determinación de causalidad que implica la eliminación de una correlación entre una de las variables explicativas de un modelo y el término de error del modelo. Este método supone que si el término de error de un modelo se mueve de manera similar a la variación de otra variable, entonces el término de error del modelo es probablemente un efecto de la variación en esa variable explicativa. La eliminación de esta correlación mediante la introducción de una nueva variable instrumental reduce así el error presente en el modelo en su conjunto. [25]

La especificación de un modelo es el acto de seleccionar un modelo que se utilizará en el análisis de datos. Los científicos sociales (y, de hecho, todos los científicos) deben determinar el modelo correcto que se utilizará porque los distintos modelos son buenos para estimar diferentes relaciones. [26]

La especificación de modelos puede ser útil para determinar la causalidad que surge lentamente, donde los efectos de una acción en un período solo se sienten en un período posterior. Vale la pena recordar que las correlaciones solo miden si dos variables tienen varianza similar, no si se afectan entre sí en una dirección particular; por lo tanto, no se puede determinar la dirección de una relación causal basándose solo en correlaciones. Debido a que se cree que los actos causales preceden a los efectos causales, los científicos sociales pueden usar un modelo que busque específicamente el efecto de una variable sobre otra durante un período de tiempo. Esto lleva a usar las variables que representan fenómenos que ocurren antes como efectos del tratamiento, donde se usan pruebas econométricas para buscar cambios posteriores en los datos que se atribuyen al efecto de dichos efectos del tratamiento, donde una diferencia significativa en los resultados después de una diferencia significativa en los efectos del tratamiento puede indicar causalidad entre los efectos del tratamiento y los efectos medidos (por ejemplo, pruebas de causalidad de Granger). Estos estudios son ejemplos de análisis de series temporales . [27]

En el análisis de regresión se incluyen o no otras variables o regresores en las distintas implementaciones del mismo modelo para garantizar que las distintas fuentes de variación se puedan estudiar de forma más separada unas de otras. Se trata de una forma de análisis de sensibilidad: es el estudio de la sensibilidad de una implementación de un modelo a la adición de una o más variables nuevas. [28]

Una de las principales preocupaciones que motivan el uso del análisis de sensibilidad es la búsqueda de variables de confusión . Las variables de confusión son variables que tienen un gran impacto en los resultados de una prueba estadística, pero no son la variable que la inferencia causal intenta estudiar. Las variables de confusión pueden hacer que un regresor parezca significativo en una implementación, pero no en otra.

Otra razón para el uso del análisis de sensibilidad es detectar la multicolinealidad . La multicolinealidad es el fenómeno en el que la correlación entre dos variables explicativas es muy alta. Un alto nivel de correlación entre dos de estas variables puede afectar drásticamente el resultado de un análisis estadístico, donde pequeñas variaciones en datos altamente correlacionados pueden cambiar el efecto de una variable de una dirección positiva a una dirección negativa, o viceversa. Esta es una propiedad inherente de las pruebas de varianza. Determinar la multicolinealidad es útil en el análisis de sensibilidad porque la eliminación de variables altamente correlacionadas en diferentes implementaciones de modelos puede prevenir los cambios dramáticos en los resultados que resultan de la inclusión de tales variables. [29]

Sin embargo, la capacidad del análisis de sensibilidad para prevenir los efectos nocivos de la multicolinealidad tiene límites, especialmente en las ciencias sociales, donde los sistemas son complejos. Como teóricamente es imposible incluir o incluso medir todos los factores de confusión en un sistema suficientemente complejo, los modelos econométricos son susceptibles a la falacia de la causa común, en la que los efectos causales se atribuyen incorrectamente a la variable equivocada porque la variable correcta no fue captada en los datos originales. Este es un ejemplo de la falta de consideración de una variable latente . [30]

Recientemente, la metodología mejorada en la econometría basada en el diseño ha popularizado el uso de experimentos naturales y diseños de investigación cuasiexperimentales para estudiar los mecanismos causales que se cree que dichos experimentos identifican. [31]

A pesar de los avances en el desarrollo de metodologías utilizadas para determinar la causalidad, aún persisten importantes debilidades en la determinación de la causalidad, que pueden atribuirse tanto a la dificultad inherente de determinar relaciones causales en sistemas complejos como a casos de mala praxis científica.

Aparte de las dificultades de la inferencia causal, en algunos grandes grupos de científicos sociales existe la percepción de que un gran número de académicos de las ciencias sociales se dedican a una metodología no científica. En esos campos abundan las críticas a los economistas y científicos sociales por hacer pasar los estudios descriptivos por estudios causales. [5]

En las ciencias, especialmente en las ciencias sociales, existe la preocupación entre los académicos de que la mala praxis científica esté muy extendida. Como el estudio científico es un tema amplio, existen formas teóricamente ilimitadas de socavar una inferencia causal sin culpa del investigador. No obstante, sigue habiendo preocupación entre los científicos de que un gran número de investigadores no realizan deberes básicos o no practican métodos suficientemente diversos en la inferencia causal. [32] [22] [33] [ verificación fallida ] [34]

Un ejemplo destacado de una metodología no causal común es la suposición errónea de que las propiedades correlativas son propiedades causales. No hay causalidad inherente en los fenómenos que se correlacionan. Los modelos de regresión están diseñados para medir la varianza dentro de los datos en relación con un modelo teórico: no hay nada que sugiera que los datos que presentan altos niveles de covarianza tengan alguna relación significativa (a falta de un mecanismo causal propuesto con propiedades predictivas o una asignación aleatoria del tratamiento). Se ha afirmado que el uso de una metodología defectuosa es generalizado, y un ejemplo común de esa mala práctica es el uso excesivo de modelos correlativos, especialmente el uso excesivo de modelos de regresión y, en particular, los modelos de regresión lineal. [5] La presuposición de que dos fenómenos correlacionados están inherentemente relacionados es una falacia lógica conocida como correlación espuria . Algunos científicos sociales afirman que el uso generalizado de una metodología que atribuye causalidad a correlaciones espurias ha sido perjudicial para la integridad de las ciencias sociales, aunque se han observado mejoras derivadas de mejores metodologías. [31]

Un efecto potencial de los estudios científicos que erróneamente confunden correlación con causalidad es un aumento en el número de hallazgos científicos cuyos resultados no son reproducibles por terceros. Esta falta de reproducibilidad es una consecuencia lógica de los hallazgos que correlacionan sólo temporalmente y que se generalizan en exceso en mecanismos que no tienen una relación inherente, donde los nuevos datos no contienen las correlaciones idiosincrásicas previas de los datos originales. Los debates sobre el efecto de la mala praxis frente al efecto de las dificultades inherentes a la búsqueda de causalidad están en curso. [35] Los críticos de las metodologías ampliamente practicadas argumentan que los investigadores han recurrido a la manipulación estadística para publicar artículos que supuestamente demuestran evidencia de causalidad pero que en realidad son ejemplos de correlación espuria que se promociona como evidencia de causalidad: tales esfuerzos pueden denominarse P hacking . [36] Para evitar esto, algunos han defendido que los investigadores registren previamente sus diseños de investigación antes de llevar a cabo sus estudios para no enfatizar inadvertidamente un hallazgo no reproducible que no fue el tema inicial de la investigación pero que se encontró que era estadísticamente significativo durante el análisis de datos. [37]